Вы можете создать своего собственного агента всего за четыре шага! Новую платформу с открытым исходным кодом Академии ДАМО могут использовать и новички.

Теперь новички также могут создавать свои собственные умные тела!

Новинка от Академии Damo.AgentрамкаModelScope-Agent,Доступно напрямую и может быть настроено.

Например, планирование и составление графиков работы нескольких инструментов можно выполнять одновременно.

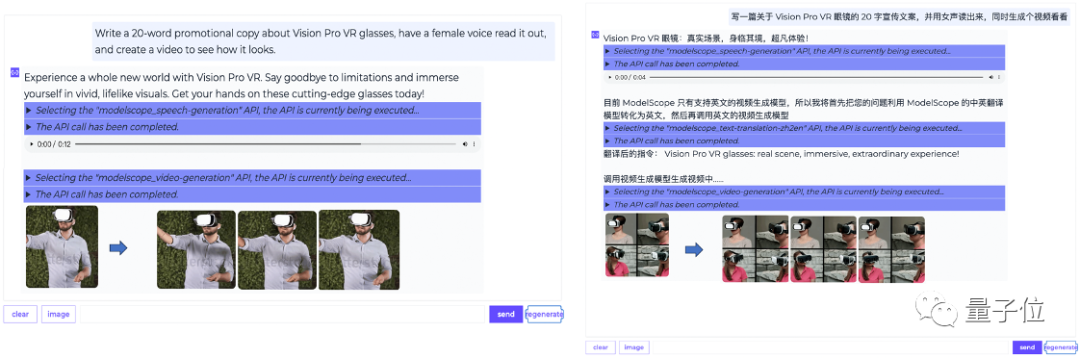

Напишите рекламный текст из 20 слов об очках Vision Pro VR, прочитайте его женским голосом и создайте видеоролик для просмотра.

Различные инструменты также могут сохраняться в нескольких разговорах.

Существует так много интегрированных инструментов, таких как НЛП, речь, видение, мультимодальные и другие модели, а также интегрированный поиск знаний по умолчанию, поиск API и другие решения.

Подробные руководства также представлены на GitHub. Давайте посмотрим, как это построить?

Создайте своего собственного агента за четыре шага

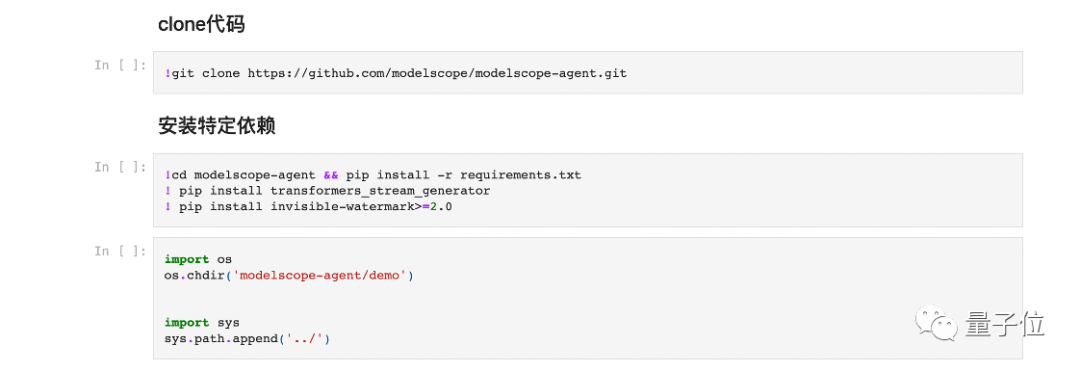

1. Сначала извлеките код ModelScope-Agent и установите связанные зависимости.

2. Настройте файл конфигурации, токен ModelScope и создайте механизм поиска инструментов API.

3. Запускается центральная большая модель.

4. Создание и использование агента основано на ранее созданной большой модели, списке инструментов, модулях поиска инструментов и памяти.

После сборки вы также можете зарегистрировать новые инструменты. На GitHub также есть съедобные руководства.

Разработчики могут обратиться к приведенным выше руководствам, чтобы легко создавать свои собственные агенты. ModelScope-Agent опирается на сообщество Moda и в будущем адаптируется к новым большим моделям с открытым исходным кодом и запускает больше приложений.

Например, агент по обслуживанию клиентов, агент личного помощника, агент истории, агент движения, мультиагент (мультимодальный агент) и т. д.

Как устроен каркас?

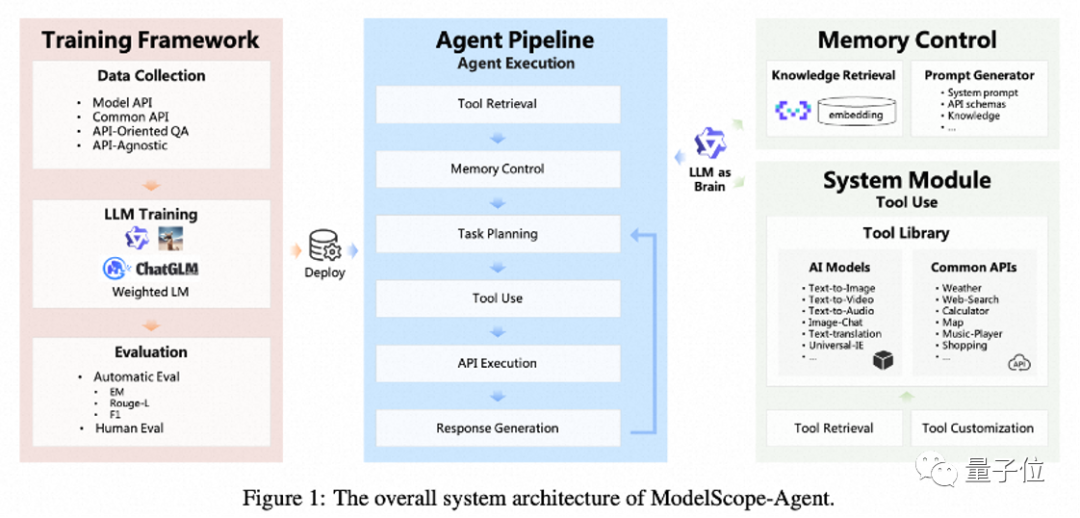

Будучи общей и настраиваемой структурой агента, ModelScope-Agent в основном имеет следующие функции:

- Настраиваемая и комплексная структура:Предлагает настраиваемые конструкции двигателей.,Охватывает такие функции, как сбор данных, извлечение инструментов, регистрация инструментов, управление хранением, обучение индивидуальной модели и практическое применение.,Может использоваться для быстрой реализации приложений в реальных сценариях.

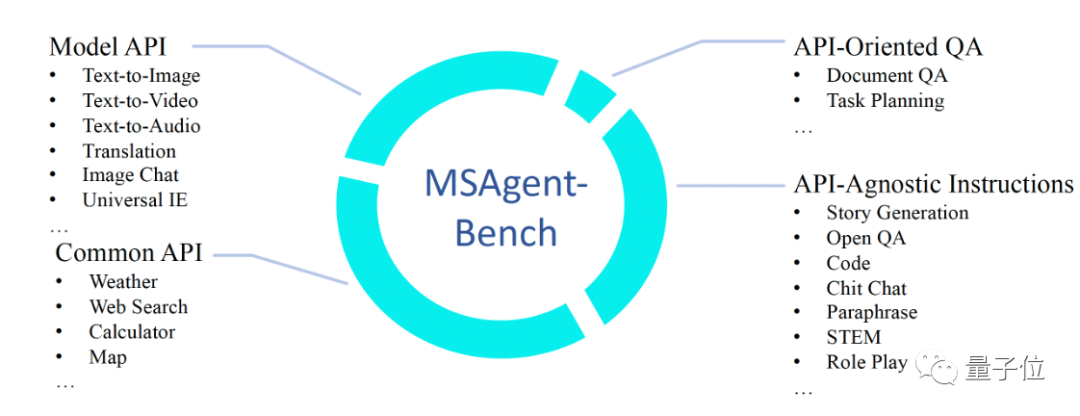

- LLM с открытым исходным кодом как основные компоненты:Поддерживается в ModelScope Несколько Открытый в сообществе исходный кодLLM для обучения Модели и Открытого исходный В коде имеется вспомогательный набор инструкций для инструментов на китайском и английском языках. MSAgent-Bench для улучшения Открытый исходный Кодбольшой Модель служит для планирования и диспетчеризации Центра агентов.

- Разнообразный и комплексный API, поддерживающий поиск по API.:реализованы унифицированно с МодельAPIи общие функцииAPIдля бесшовной интеграции,Открытый предоставляется по умолчанию. исходный решение для поиска кодAPI.

В основном он включает в себя эти модули, в основе которых лежат модели большого языка (LLM) с открытым исходным кодом, а также модули управления памятью, использования инструментов и другие модули.

LLM с открытым исходным кодом в основном отвечает за планирование задач, планирование и генерацию ответов; модуль управления памятью в основном включает в себя поиск знаний и управление подсказками (словами подсказок); модуль использования инструментов включает библиотеку инструментов, поиск инструментов и настройку инструментов;

По мере выполнения задачи он разбивает ее на более мелкие задачи и выполняет их одну за другой.

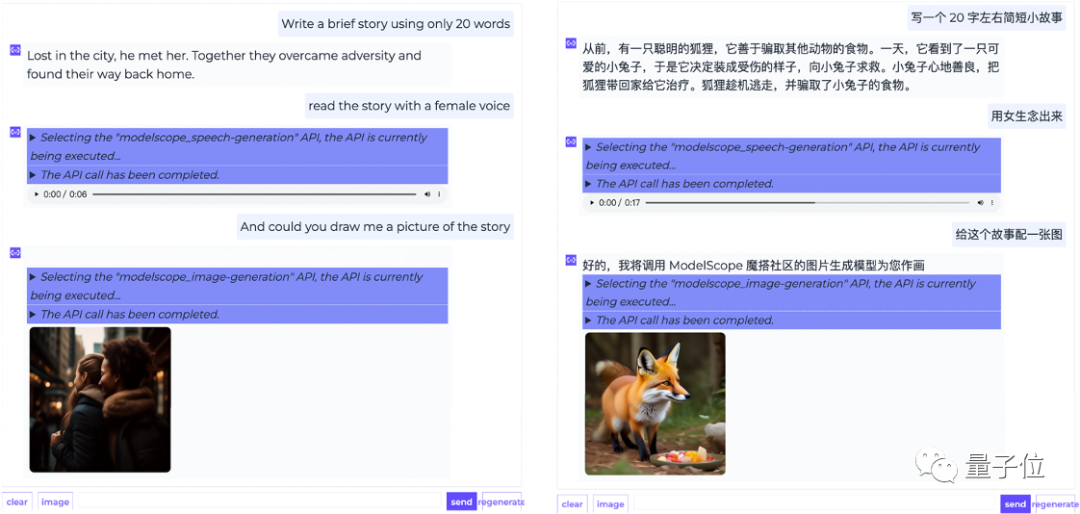

Возьмите, например, написание короткого рассказа, чтение его вслух женским голосом и сопровождение видео».

ModelScope-Agent отобразит весь процесс планирования задач. Сначала он находит соответствующие инструменты синтеза речи посредством поиска инструментов, а затем использует LLM с открытым исходным кодом для выполнения планирования.

Сначала генерируется история, затем вызывается соответствующая модель генерации речи, речь генерируется и зачитывается женским голосом и отображается пользователю. Наконец, вызывается модель генерации видео для генерации видео на основе сгенерированного. содержание рассказа.

Весь этот процесс не требует от пользователя настройки инструментов, которые, возможно, потребуется вызвать для текущего запроса.

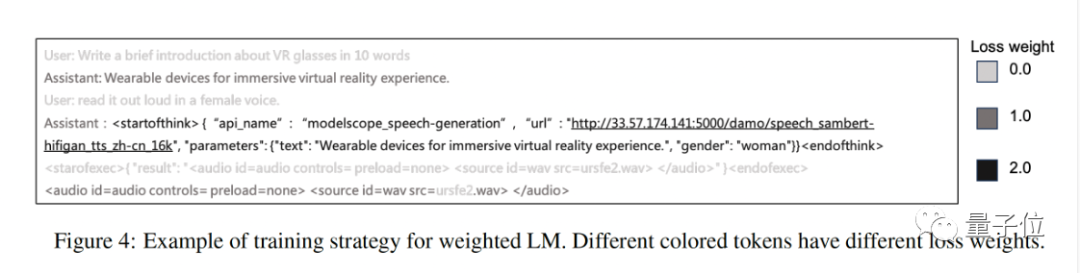

кроме,Они также предложили новыеинструмент Инструкция по точной настройке метода обучения:Weighted LM,Взвешивание потерь выполняется путем вызова некоторых токенов в инструкции инструмента.,продвигать Открытый исходный Кодбольшой Модельинструмент, возможность вызова команд.

На основе этого метода обучения и вспомогательных инструкций с открытым исходным кодом на китайском и английском языках вызывается набор данных MSAgent-Bench, а модель MSAgent-Qwen-7B оптимизируется и обучается на основе Qwen-7B. Соответствующие наборы данных и модели. открытый исходный код.

Бумажная ссылка: https://arxiv.org/abs/2309.00986 Ссылка на код: https://github.com/modelscope/modelscope-agent Адрес опыта ModelScope: https://modelscope.cn/studios/damo/ModelScopeGPT/summary

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами