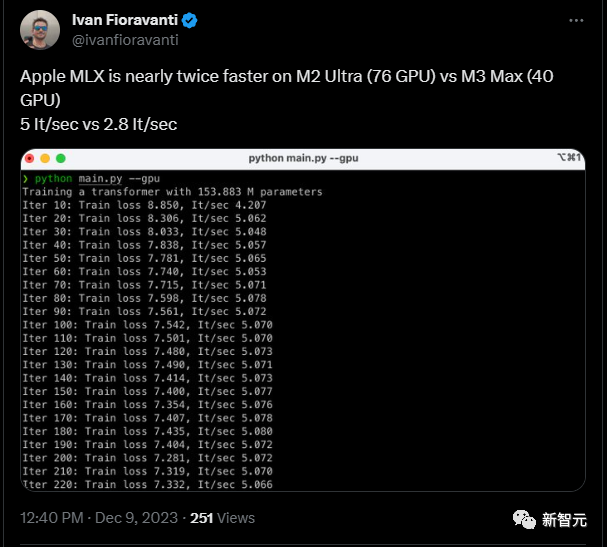

Версия CUDA для Apple уже здесь! Разработанный специально для собственного чипа, M3 Max может выполнять 2,8 итерации в секунду.

Монтажер: Минди

【Шин Джиген Введение】яблоко Новые выпуски распространяются наяблокочипизмашинное Платформа обучения MLX, MLX — это платформа массивов, подобная NumPy, предназначенная для упрощения работы исследователей, использующих аппаратное обеспечение Apple. ML Обучение и развертывание модели.

NVIDIA CUDA всегда доминировала в мире, делая свою власть в сфере искусственного интеллекта непоколебимой.

Многие люди надеются сломать этот ров, например, PyTorch, поддерживающий больше графических процессоров, Triton от OpenAI и т. д.

Недавно Apple выпустила платформу машинного обучения MLX специально для исследователей машинного обучения, использующих чипы Apple.

Авни Ханнун из команды машинного обучения Apple в X-note назвал это программное обеспечение «...эффективной средой машинного обучения, разработанной специально для чипов Apple».

MLX работает аналогично существующим платформам, таким как PyTorch, Jax и ArrayFire.

Однако MLX оптимизирован для чипов Apple. Исследователи, которые раньше испытывали затруднения при использовании графических процессоров M-chip для запуска моделей, наконец-то могут избавиться от этой проблемы!

В то же время MLX добавляет поддержку унифицированной модели памяти, что также означает, что массив находится в общей памяти и может выполнять операции с любым поддерживаемым типом устройства без выполнения копирования данных. Итак, как только другие продукты Apple также смогут запускать модели… вы этого с нетерпением ждете!

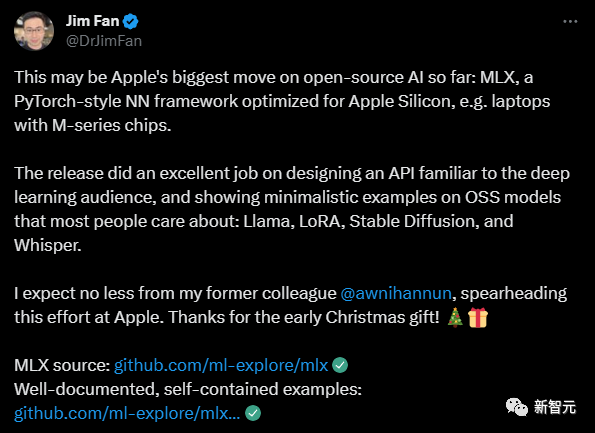

Джим Фан, старший научный сотрудник Nvidia, сказал, что это, возможно, самый большой шаг Apple в области искусственного интеллекта с открытым исходным кодом на сегодняшний день:

Что особенного в MLX

Давайте сначала посмотрим на скорость MLX:

Пользователь сети протестировал скорость MLX. В своем твите он сказал, что, используя платформу Apple MLX для скорости вычислений, M2 Ultra (76 графических процессоров) может достигать 5 итераций в секунду (It/sec), а M3 Max (40 графических процессоров). может достигать 2,8 итераций в секунду.

Эта скорость почти такая же, как у Pytorch.

Еще одна замечательная особенность MLX, как отметил Джим Фан, — это превосходно разработанный API.

Для разработчиков в области глубокого обучения начать работу практически ничего не стоит.

Это связано с тем, что дизайн MLX вдохновлен существующими платформами, такими как PyTorch, Jax и ArrayFire.

Исследовательская группа объясняет: «API Python очень похож на NumPy, за некоторыми исключениями. MLX также имеет полнофункциональный API C++, который полностью соответствует API Python».

Исследовательская группа добавила о цели разработки: «Среда разработана так, чтобы быть удобной для пользователя, оставаясь при этом эффективной при обучении и развертывании моделей. Наша цель — дать исследователям возможность легко расширять и улучшать MLX для быстрого изучения новых идей».

Помимо API, который упрощает начало работы, некоторые другие ключевые функции MLX включают в себя:

- Преобразования составных функций: MLX содержит преобразования составных функций для автоматического дифференцирования, автоматической векторизации и оптимизации вычислительных графов, что важно для оптимизации и ускорения машинного обучения. Процесс обучения модели обучения очень полезен.

- Отложенные вычисления: MLX поддерживает отложенные вычисления, и экземпляры массивов создаются только при необходимости.

- Построение динамического графа. Вычислительные графы в MLX строятся динамически. Изменение формы параметров функции не приводит к медленной компиляции, а отладка проста и интуитивно понятна. Это делает разработку и отладку моделей более гибкой и эффективной.

- Поддержка нескольких устройств: действия могут выполняться на любом поддерживаемом устройстве (в настоящее время поддерживаются процессор и графический процессор).

- Единая память. Существенным отличием MLX от других платформ является унифицированная модель памяти. В MLX массивы существуют в общей памяти, и операции с массивами MLX могут выполняться на любом поддерживаемом типе устройства без перемещения данных.

MLX Data

Помимо выпуска MLX, команда машинного обучения Apple также выпустила MLX Data. Это независимая от платформы MLX библиотека загрузки данных, которую можно использовать с PyTorch, Jax или MLX.

Данные MLX можно использовать для загрузки крупномасштабных наборов данных, а также использовать независимо для предварительной обработки данных для обучения машинному обучению.

Цель этой библиотеки — предоставить пользователям возможность использовать многопоточность для ускорения конвейеров обработки данных без необходимости использования сложных многопроцессных операций или написания кода на символьном языке. Это помогает повысить эффективность загрузки и предварительной обработки данных.

Пример отображения MLX

В настоящее время пользователи могут легко установить MLX через PyPI, выполнив следующую команду: pip install mlx.

Пользователям необходимо убедиться, что соблюдены следующие требования к установке:

- Используйте чипы серии M (чипы Apple)

- Используйте локальную версию Python не ниже 3.8.

- Версия MacOS должна быть не ниже 13.3.

Исследовательская группа также предоставила ряд примеров функций MLX, включая обучение языковой модели Transformer, крупномасштабную генерацию текста с использованием LLaMA, точную настройку с использованием LoRA, генерацию изображений с использованием стабильной диффузии и распознавание речи с использованием Whisper от OpenAI.

Подробности можно найти на Github: https://github.com/ml-explore/mlx-examples/tree/main.

Эти примеры также доказывают техническую мощь и инструменты компании в области обработки речи, генерации изображений и распознавания речи.

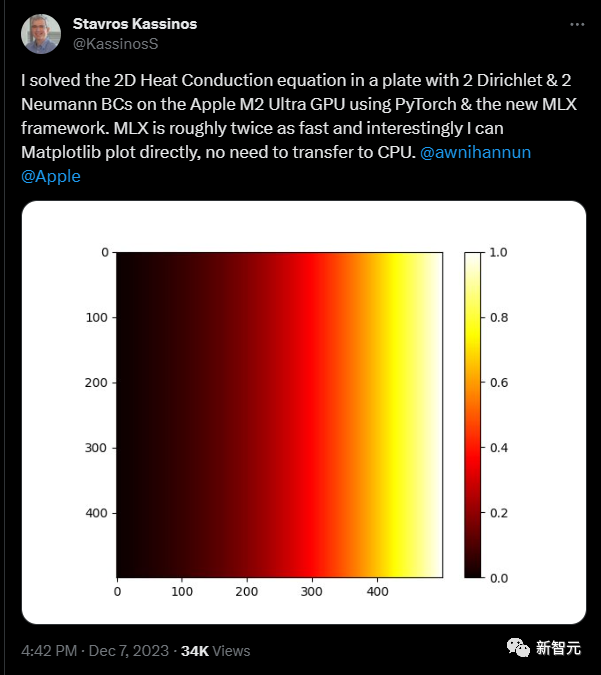

Другие разработчики также предприняли другие интересные попытки использовать MLX, например профессор из Университета Кипра, который успешно решил двумерную теплопроводность на плате графического процессора Apple M2 Ultra с использованием PyTorch и новой задачи MLX Equation с двумя Дирихле. и два граничных условия Неймана.

Интересно, что MLX примерно в два раза быстрее, чем раньше, и его можно строить напрямую с помощью Matplotlib без передачи данных на ЦП.

Взгляд на видение Apple в области искусственного интеллекта от MLX

Инклюзивное машинное обучение

Исследовательская группа неоднократно подчеркивала, что «MLX разработан исследователями машинного обучения для исследователей машинного обучения». Это показывает, что Apple осознает необходимость разработки открытой, простой в использовании среды разработки для машинного обучения, чтобы способствовать дальнейшему развитию. это поле.

чиповая технология

Потому что процессоры Apple теперь используются во всех ее продуктах, включая Mac, iPhone и iPad. Такой подход с использованием графических процессоров, центральных процессоров и (возможно, в какой-то момент) нейронных механизмов на этих чипах может привести к выполнению моделей машинного обучения на устройстве. Его производительность может превосходить производительность других процессоров, по крайней мере, для периферийных устройств.

Важность инструментов разработки

Apple явно решила сосредоточиться на предоставлении исследователям машинного обучения лучших инструментов, включая мощный M3 Mac, для построения моделей. Теперь они делают еще один шаг вперед и надеются воплотить этот фокус в ориентированные на человека инструменты искусственного интеллекта, которые будут доступны обычным пользователям.

В целом, Apple надеется предложить машинное обучение и искусственный интеллект более широкому кругу пользователей, предоставляя мощные инструменты и преимущества в производительности на различных устройствах.

Эта война в индустрии искусственного интеллекта только началась.

Ссылки:

https://www.computerworld.com/article/3711408/apple-launches-mlx-machine-learning-framework-for-apple-silicon.html

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами