В чем разница между моделями Cat Head Tiger Gemma и Gemini?

Кошачья голова Тигра 🐯 Чем отличаются модели Gemma и Gemini?

Резюме 📘

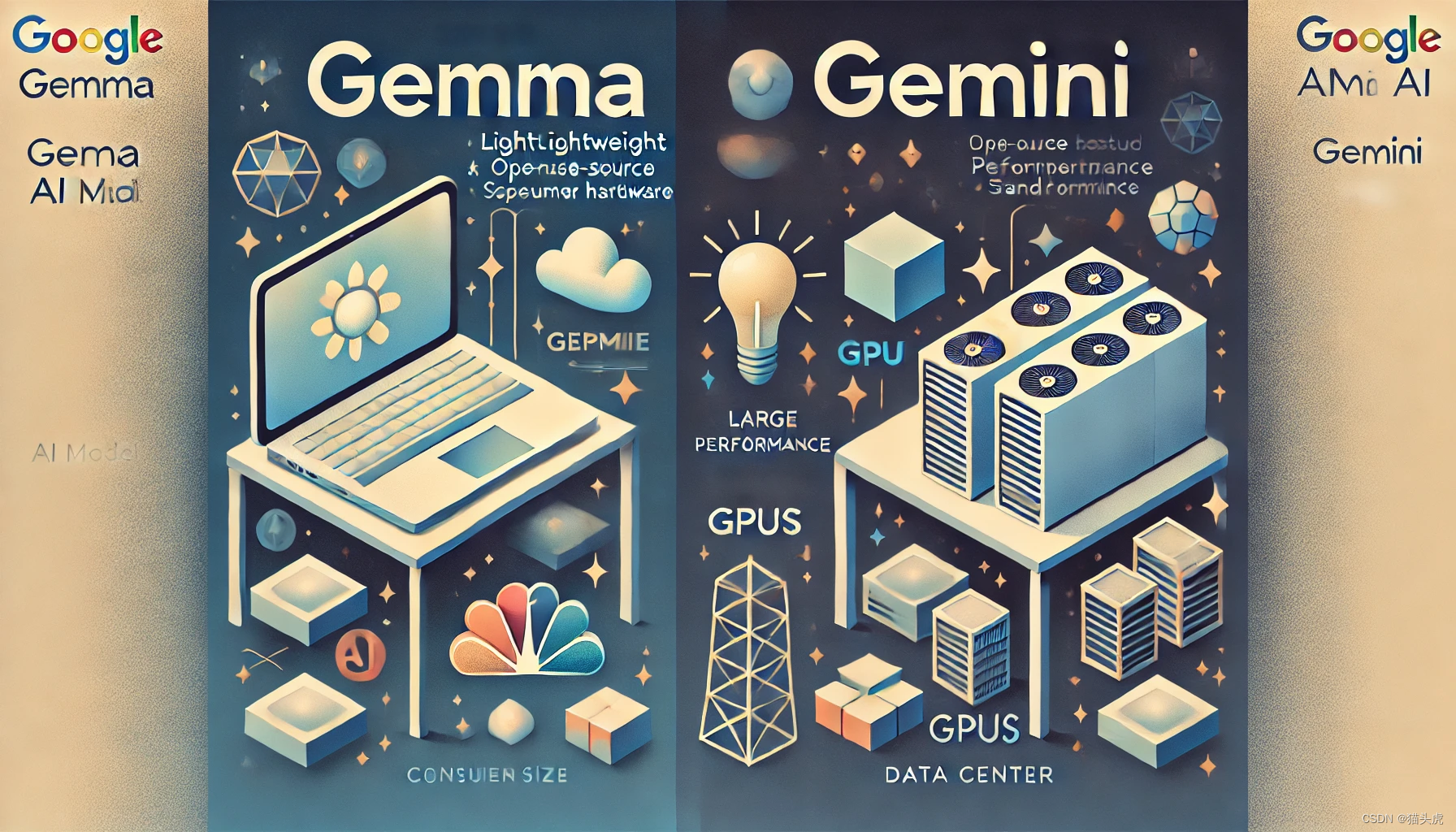

В этой статье мы подробно рассмотрим Gemma и Gemini, две модели искусственного интеллекта, разработанные Google. Мы сравним размеры их параметров, требования к вычислительным ресурсам и сложность интеграции, чтобы помочь вам понять основные различия между ними. Независимо от того, являетесь ли вы новичком в области искусственного интеллекта или экспертом в области технологий, эта статья может дать вам исчерпывающие и простые для понимания знания. Ключевые слова: Джемма, Близнецы, модель искусственного интеллекта, Google, параметры, вычислительные ресурсы, сложность интеграции.

введение

В последние годы технологии искусственного интеллекта быстро развиваются, и одна за другой появляются различные модели ИИ. Будучи лидером отрасли, Google запустил ряд известных моделей искусственного интеллекта, наиболее представительными из которых являются модели Gemini и Gemma. В этой статье представлен подробный сравнительный анализ, который поможет вам понять уникальные особенности и сценарии применения этих двух моделей.

текст

1. Обзор модели

🌟 Модель Близнецы

Gemini — это набор передовых моделей искусственного интеллекта, предназначенных для решения высокопроизводительных задач и широко используемых во флагманском сервисе искусственного интеллекта Google. Эти модели обычно очень велики, содержат до 1,56 триллиона параметров и требуют мощных вычислительных ресурсов.

🌟 Модель Джемма

Gemma, напротив, представляет собой легкий набор моделей искусственного интеллекта с открытым исходным кодом, разработанный специально для разработчиков. Модель Gemma имеет меньшие параметры и в основном доступна в двух версиях: 2B и 7B, которые подходят для работы на оборудовании потребительского уровня.

2. Сравнение шкалы параметров

Масштаб параметров модели Gemini: последняя модель Gemini Ultra имеет 1,56 триллиона параметров, а модель Gemini 1.5 Pro поддерживает контекстные окна до одного миллиона токенов в некоторых тестах [24 † источник].

Масштаб параметров модели Gemma: Модель Gemma меньше по размеру и в основном поставляется в двух версиях: 2B и 7B, которые подходят для работы в средах с низким уровнем ресурсов [21 † источник] [22 † источник].

3. Требования к вычислительным ресурсам

💻 Модель Близнецы

Из-за большого размера и сложной архитектуры модели Gemini часто требуют специального оборудования для центров обработки данных, такого как большие кластеры графических процессоров или TPU [24 † источник].

💻 Модель Джеммы

Модель Gemma разработана для эффективной работы на оборудовании потребительского уровня, таком как ноутбуки или стандартные рабочие станции, без аппаратной поддержки крупных центров обработки данных [21 † источник] [ 22 † источник ].

4. Сложность интеграции

🚀 Модель Близнецы

Интеграция относительно сложна и осуществляется в основном через Google Cloud Vertex AI и специализированные API, что требует высоких технических требований и инвестиций в ресурсы [21 † источник] [24 † источник].

🚀 Модель Джеммы

Модель Gemma имеет открытый исходный код, и разработчики могут легко получить к ней доступ и использовать ее на нескольких платформах (таких как Hugging Face, Kaggle, NVIDIA NeMo и т. д.). Интеграция относительно проста и поддерживает несколько платформ искусственного интеллекта, таких как PyTorch, TensorFlow и JAX, что позволяет разработчикам быстро развертывать и настраивать в различных средах [22 † источник] [ 23 † источник ] [ 25 † источник ].

5. Примеры кода

# Пример: использование объятий Библиотека трансформеров Face загружает модель Gemma

from transformers import pipeline

import torch

pipe = pipeline(

"text-generation",

model="google/gemma-7b-it",

model_kwargs={"torch_dtype": torch.bfloat16},

device="cuda",

)

messages = [

{"role": "user", "content": "What are the main differences between Gemma and Gemini models?"},

]

outputs = pipe(

messages,

max_new_tokens=256,

do_sample=True,

temperature=0.7,

top_k=50,

top_p=0.95

)

print(outputs[0]["generated_text"])6. Часто задаваемые вопросы

Вопрос 1: Для каких сценариев применения подходит модель Gemma?

A1: Благодаря своей легкой конструкции модель Gemma очень подходит разработчикам для быстрой разработки и развертывания на оборудовании потребительского уровня, а также подходит для различных задач языковой обработки, таких как ответы на вопросы, обобщение и рассуждение.

Вопрос 2: Как интегрировать модель Джеммы в мой проект?

A2: Вы можете использовать Hugging Face, Kaggle, NVIDIA NeMo и другие платформы в сочетании с платформой PyTorch, TensorFlow или JAX, чтобы легко интегрировать модель Gemma в свой проект.

краткое содержание

Благодаря сравнительному анализу в этой статье мы понимаем основные различия между моделями Gemma и Gemini с точки зрения масштаба параметров, требований к вычислительным ресурсам и сложности интеграции. Будучи облегченным вариантом с открытым исходным кодом, модель Gemma предоставляет разработчикам более удобный опыт, а модель Gemini подходит для крупномасштабных задач, требующих высокопроизводительных вычислительных ресурсов.

Ссылки

Подвести итог

Независимо от того, являетесь ли вы новичком или опытным разработчиком, поняв различия между моделями Gemma и Gemini, вы сможете лучше выбрать модель ИИ, подходящую вашему проекту. Мы надеемся, что в будущем Google представит больше инноваций и прорывов в этих двух модельных сериях, что придаст новый импульс развитию технологий искусственного интеллекта.

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами