Углубленный анализ PyTorch Autograd: от принципа к практике

В этой статье подробно рассматривается PyTorch середина Autograd из основных принципов функциональности. Из основных понятий Тензор и Autograd от взаимодействия, к графику расчета, к построению, к управлению, к обратному распространению ошибки, к расчету градиента, к деталям и, наконец, рассмотрены Autograd расширенные функции. Следуйте за TechLead и делитесь всесторонними знаниями об искусственном интеллекте. Автор имеет более чем 10-летний опыт работы в области архитектуры интернет-сервисов, опыт исследований и разработок продуктов искусственного интеллекта, а также опыт управления командой. Он имеет степень магистра Университета Тунцзи в Университете Фудань, член Лаборатории интеллекта роботов Фудань, старший архитектор, сертифицированный Alibaba Cloud. , специалист по управлению проектами, а также занимается исследованиями и разработками продуктов искусственного интеллекта с доходом в сотни миллионов человек.

1. Пайторч и автоматическое дифференцирование Автоград

дифференцирование (Автоматическое Дифференциация, сокращение Autograd) даглубокое обучение Одна из основных технологий в области научных вычислений. Он не только играет жизненно важную роль в процессе обучения нейронной сети середина.,возвращатьсясуществовать Различныйпроектинаучные вопросыиз Численное решениесерединаиграет ключевую роль。

1.1 Основные принципы автоматического дифференцирования

существоватьматематикасередина,Дифференциальный да А метод расчета локальной скорости изменения функции,широко используется в физике、проект、Экономика и другие области. Автоматическая дифференциация использует компьютерные программы для автоматического расчета производных функций или градиента с помощью методов.

Ключом к автоматическому дифференцированию является разложение сложных функций на ряд комбинаций простых функций, а затем применение правила цепочки (Chain Правило) для вывода. Этот процесс отличается от численного дифференцирования (использовать аппроксимацию конечных разностей) и символического дифференцирования (выполнения символьного вывода).,Он может точно рассчитать производные,В то же время это позволяет избежать проблемы расширения символического дифференциального выражения и потери точности числового дифференциала.

import torch

# Пример: Простое автоматическое дифференцирование

x = torch.tensor(2.0, requires_grad=True)

y = x ** 2 + 3 * x + 1

y.backward()

# Печать градиента

print(x.grad) # Выход должен быть 2*x + 3 существовать x=2 время из стоимости, то есть 7

1.2 Применение автоматической дифференциации в глубоком обучении

существоватьглубокое обучениесередина,обучать нейронную сетьизосновнойдаоптимизация Функция потерь,То есть настроить параметры сети, чтобы минимизировать потери.。Этот процесс требует расчета Функция потерьотносительно Параметры сетиизградиент,автоматическое дифференцированиесуществоватьздесьиграть ключевую роль。

с простымизмодель линейной регрессиидляпример,Модель с целью найти набор параметров,Сделайте прогнозы модели как можно ближе к фактическим данным. существует этот процесссередина,автоматическое дифференцирование帮助我们有效地вычислить Функция потерь О параметрахизградиент,Затем параметры обновляются методом градиентного спуска.

# Пример: расчет градиента серединаиз линейной регрессии

x_data = torch.tensor([1.0, 2.0, 3.0])

y_data = torch.tensor([2.0, 4.0, 6.0])

# Параметры модели

weight = torch.tensor([1.0], requires_grad=True)

# прямое распространение

def forward(x):

return x * weight

# Функция потерь

def loss(x, y):

y_pred = forward(x)

return (y_pred - y) ** 2

# Рассчитать градиент

l = loss(x_data, y_data)

l.backward()

print(weight.grad) # Печать градиента

1.3 Важность и влияние автоматической дифференциации

Внедрение технологии автоматического дифференцирования существенно упрощает процесс расчета градиента.,Позволяет исследователям сосредоточиться на разработке и обучении моделей.,Вместо того, чтобы вручную рассчитывать сложные производные. Такое быстрое развитие существующего глубокого обучения сыграло свою роль в разжигании пламени.,Особенно при обучении больших нейронных сетей.

также,Автоматическая дифференциация также показывает свой большой потенциал в сфере существования неглубокого обучения.,пример如существоватьфизическое моделирование、финансыпроекти Биоинформатика и другие областиизприложение。

2. Основной механизм PyTorch Autograd

PyTorch Autograd — мощный инструмент.,Это позволяет исследователям и инженерам эффективно рассчитывать производные с минимальным ручным вмешательством. Понимание его основной механики не только поможет вам лучше использовать этот инструмент.,Это также помогает разработчикам избежать распространенных ошибок.,Повышайте производительность и эффективность модели.

2.1 Взаимодействие Тензора и Автограда

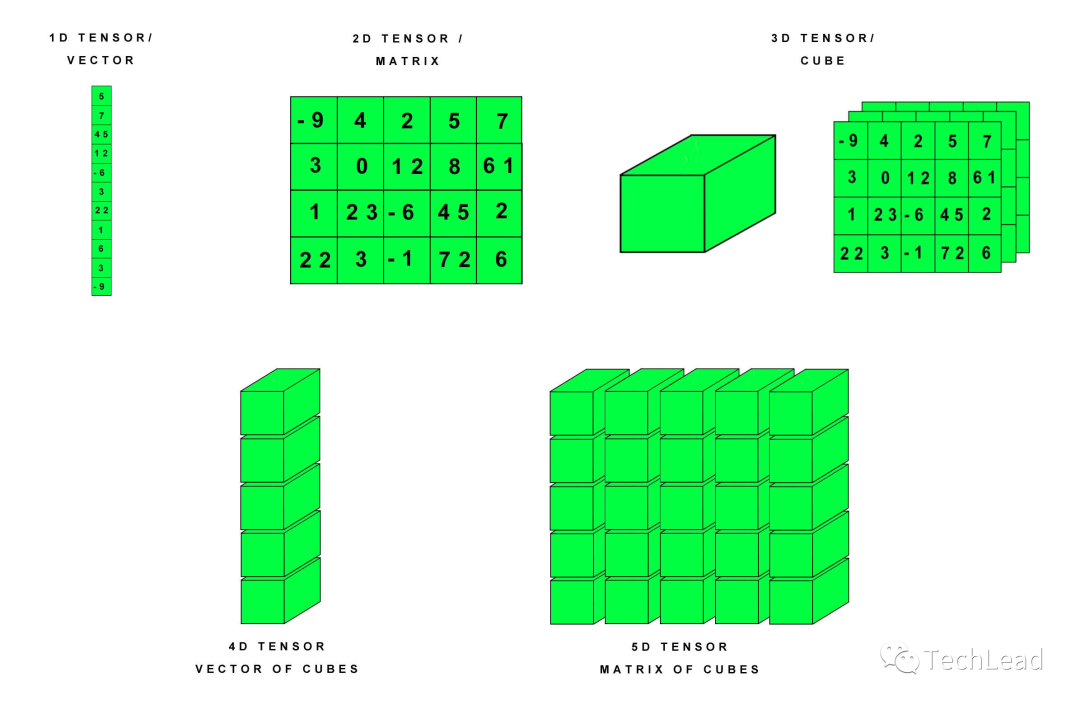

существовать PyTorch середина,Tensor является краеугольным камнем построения нейронных сетей, и Autograd Это ключ к реализации обучения нейронной сети. учиться Tensor и Autograd Как работать вместе, эффективно для глубокого понимания использовать PyTorch Ключевой.

Тензор: ядро PyTorch

Tensor существовать PyTorch середина похожа на NumPy массив, но у них есть дополнительная сверхсила - могут существовать Autograd системасерединаавтоматический Рассчитать градиент。

- Tensor из Атрибуты: каждый Tensor У каждого есть один

requires_gradсвойство. Если установлено значениеTrueКогда, PyTorch буду отслеживатьсуществовать该 Tensor начальствоиз Все операции,并автоматический Рассчитать градиент。

Autograd: двигатель автоматического дифференцирования

Autograd — это механизм автоматического дифференцирования PyTorch, отвечающий за отслеживание операций, важных для расчета градиентов.

- График расчета: существоватьпозади,Autograd Отслеживайте операции, строя вычислительный граф. Этот граф представляет собой ориентированный ациклический граф (DAG), который записывает создание конечного результата. Tensor Все задействованные операции.

Tensor и Autograd работают вместе

Когда выполняется работа с тензором и генерируется новый тензор, PyTorch автоматически создает узел вычислительного графа, представляющий операцию.

Пример: Отслеживание простых операций

import torch

# Создайте Тензор, настройки requires_grad=True отслеживать связанные с ним операции

x = torch.tensor([2.0], requires_grad=True)

# выполнить операцию

y = x * x

# Проверять y из grad_fn свойство

print(y.grad_fn) # Это показывает y С помощью какой операции можно получить выход?

Вот y получается в результате операции умножения. PyTorch Эта операция автоматически отслеживается и включается в вычислительный график.

Обратное распространение ошибкии Расчет градиента

Когда мы сравниваем результат Tensor вызов .backward() метод, Пай Торч 会автоматический Рассчитать градиент и сохранить его существование каждый Tensor из .grad свойствосередина。

# Обратное распространение ошибки,Рассчитать градиент

y.backward()

# Проверять x изградиент

print(x.grad) # должно быть выведено 4.0 потому что dy/dx = 2 * x,существовать x=2 Значение времени 4

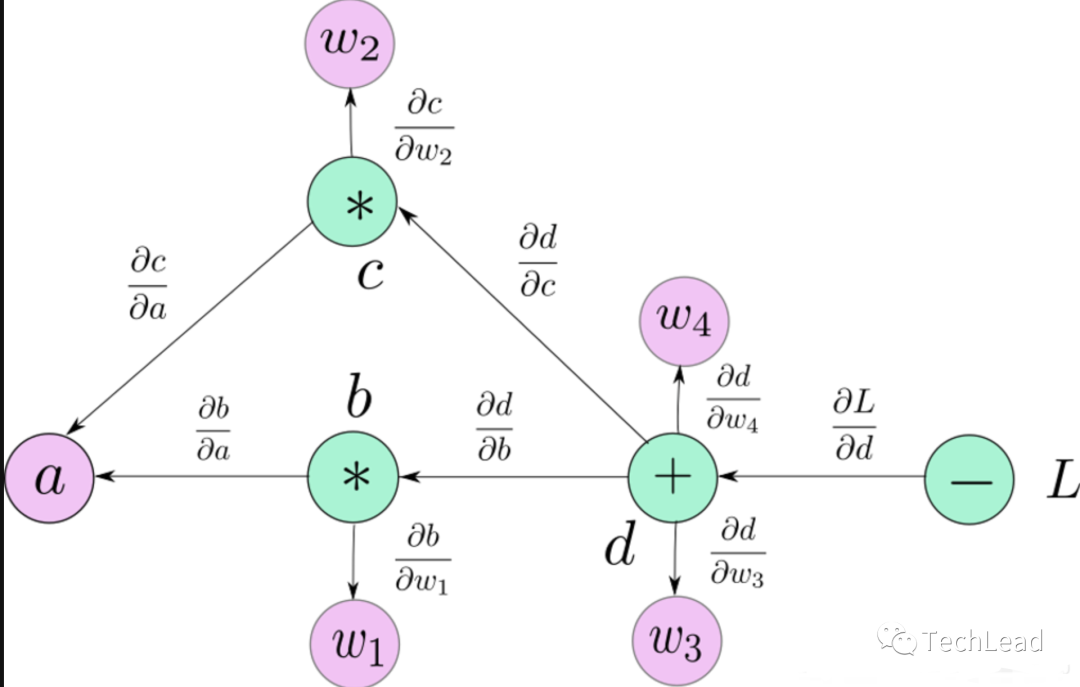

2.2 Построение и управление вычислительными графами

существоватьглубокое обучениесередина, понимание вычислительного графа в построении и управлении, чтобы понять автоматическое дифференцирование и процесс обучения нейронной сети из ключа. PyTorch использоватьграфик динамических расчетов,Это одна из его основных особенностей,Обеспечивает большую гибкость и интуитивность.

Основные понятия вычислительных графов

Вычислительный граф - это метод графического представления.,Используется для описания взаимосвязи между операциями с данными (тензорными) (такими как сложение, умножение). существует PyTorch середина, когда бы то ни было Tensor Во время работы,Metropolis Создание представляет собой операцию из узла,И операция ввода и вывода Tensor Подключена.

- Узел:представляет данныеиздействовать,Например, сложение и умножение.

- Край:представляет данные流,Это Тензор.

Характеристики графов динамических вычислений

PyTorch из вычислительного графика дадинамический,То есть диаграмма из сборки возникает при запуске. Это означает, что график строится в реальном времени по мере выполнения кода.,Каждая итерация может создавать новый граф.

示пример:Динамическая графикаизсоздавать

import torch

x = torch.tensor(1.0, requires_grad=True)

y = torch.tensor(2.0, requires_grad=True)

# Простое управление

z = x * y

# На данный момент сформирован график расчета, середина которого z Да x и y Получить из посредством операции умножения

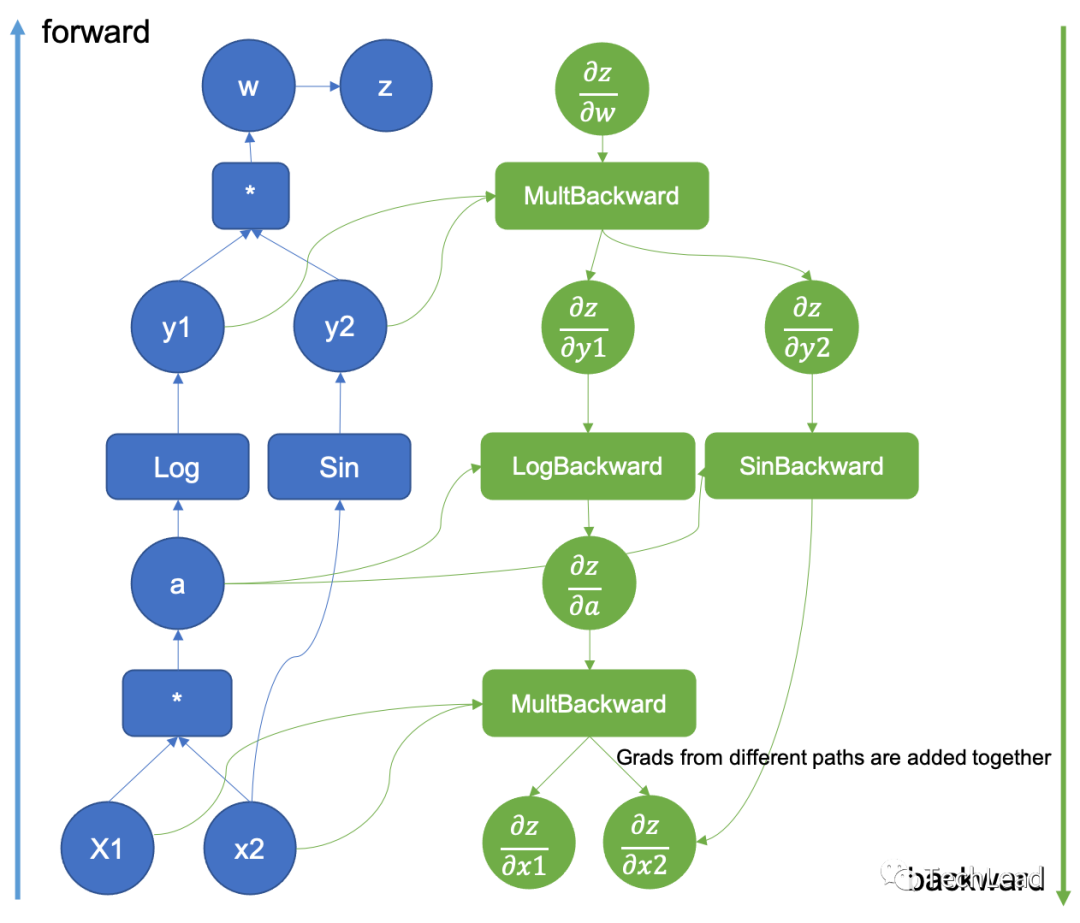

Обратное распространение ошибки и вычислительные графы

существоватьглубокое обучениеиз Обучающий процесс середина, обратное распространение да осуществляется через вычислительный граф. Когда вызов .backward() метод, Пай Торч начну с этого момента,Обратное распространение ошибки по графу,вычислитькаждыйузелизградиент。

Пример: процесс обратного распространения ошибки

# Продолжая приведенный выше пример

z.backward()

# Проверятьградиент

print(x.grad) # dz/dx,существовать x=1, y=2 время должно быть 2

print(y.grad) # dz/dy,существовать x=1, y=2 время должно быть 1

Управление вычислительными графами

существуют практическое применение середина, важные аспекты оптимизации памяти и вычислительной эффективности управления вычислительными графами.

Четкое изображение:По умолчанию,существоватьвызов .backward() После этого PyTorch График расчета будет очищен автоматически. Это означает, что каждый .backward() вызов — это независимый процесс вычислений. Это помогает экономить память для задач, включающих несколько итераций.

Отключить отслеживание градиента:существоватьв некоторых случаях,Например, существуют оценка модели или фаза вывода.,ненужный Рассчитать градиент。использовать torch.no_grad() Вычисления градиента можно временно отключить, тем самым повышая эффективность вычислений и уменьшая объем памяти.

with torch.no_grad():

# существования Все расчеты в этом блоке не будут отслеживать градиенты.

y = x * 2

# здесь y из grad_fn для None

2.3 Детали обратного распространения ошибки и расчета градиента

Обратное распространение ошибкидаглубокое обучениесередина используется для обучения нейронных сетей на основе основного алгоритма. существовать PyTorch середина, этот процесс зависит от Autograd система Приходитьавтоматический Рассчитать градиент。понимать Обратное распространение ошибкии Расчет градиентаиздетальдаключевойиз,Это не только помогает нам лучше понять, как нейронные сети обучаются.,Это также может помочь нам в более эффективном проектировании и отладке моделей.

Основы обратного распространения ошибки

Обратное распространение ошибкиалгоритмизглазиздавычислить Функция потерьотносительно Параметры сетиизградиент。существовать PyTorch середина,Обычно это делается черезсуществовать Функция потерьначальствовызов .backward() реализация метода.

- Правило цепочки: Обратное распространение ibНа основе правила цепочки,Используется для вычисления производной сложной функции. существуют Вычислительный графсередина,Переход назад от выхода ко входу,Умножьте производную по пути из.

PyTorch реализация обратного распространения ошибки

Следующее простое из PyTorch 示пример,Объяснил Обратное распространение ошибкиизосновной процесс:

import torch

# создавать Tensor

x = torch.tensor(1.0, requires_grad=True)

w = torch.tensor(2.0, requires_grad=True)

b = torch.tensor(3.0, requires_grad=True)

# Построить простую из линейной функции

y = w * x + b

# Рассчитать потери

loss = y - 5

# Обратное распространение ошибки

loss.backward()

# Проверьте градиент

print(x.grad) # dy/dx

print(w.grad) # dy/dw

print(b.grad) # dy/db

существоватьэтот个пример子середина,loss.backward() вызов触发了整个вычислить图из Обратное распространение ошибкипроцесс,вычислить了 loss относительно x、w и b изградиент。

накопление градиента

существовать PyTorch середина, по умолчанию градиент накапливается из. Это значит существовать каждый раз, когда вызов .backward() час,Градиент будет добавлен к предыдущему значению.,Вместо этого заменяется да.

- Градиентная очистка: существующиесамые тренировочные схемысередина,Нам нужен существованиекаждый, прежде чем повторять шаги Четкий градиент,以防止градиент累积影响当前步骤изградиентвычислить。

# Четкий градиент

x.grad.zero_()

w.grad.zero_()

b.grad.zero_()

# вперед сноваи Обратное распространение ошибки

y = w * x + b

loss = y - 5

loss.backward()

# Проверьте градиент

print(x.grad) # dy/dx

print(w.grad) # dy/dw

print(b.grad) # dy/db

градиент высокого уровня

PyTorch Также поддерживает градиент высокого расчет уровней, то есть снова дифференцировать сам градиент. Это существование очень полезно для некоторых продвинутых алгоритмов оптимизации и второй производной из приложений середина.

# давать возможностьградиент высокого уровнявычислить

z = y * y

z.backward(create_graph=True)

# Вычислить вторую производную

x_grad = x.grad

x_grad2 = torch.autograd.grad(outputs=x_grad, inputs=x)[0]

print(x_grad2) # d^2y/dx^2

3. Полное решение функций Autograd.

Система PyTorch Autograd предоставляет ряд мощных функций.,сделай это глубокое обучение Автоматическая дифференциация серединаиз Важный инструмент. Эти функции не только повышают гибкость и эффективность программирования, но также делают возможной сложную оптимизацию и вычисления.

Динамический график

Система PyTorch серединаиз Autograd основана на динамических графах вычислений. Это означает, что вычислительный граф существования создается динамически каждый раз при его выполнении.,По сравнению со статическими изображениями,Это обеспечивает большую гибкость.

Пример: динамическая графика из адаптивности

import torch

x = torch.tensor(1.0, requires_grad=True)

if x > 0:

y = x * 2

else:

y = x / 2

y.backward()

Этот код показывает PyTorch из Функции динамического графика. в соответствии с x изценить,Путь расчета можно изменить,Этот существующий статический кадр изображения серединада трудно калибровать.

Индивидуальная функция автоматической дифференциации

PyTorch Разрешить пользователям наследовать через torch.autograd.Function Приходитьсоздавать Настроитьизавтоматическое дифференцированиефункция,этотдлясложный или особенныйизвпереди Обратное распространение ошибки дает возможность。

示пример:Индивидуальная функция автоматической дифференциации

class MyReLU(torch.autograd.Function):

@staticmethod

def forward(ctx, input):

ctx.save_for_backward(input)

return input.clamp(min=0)

@staticmethod

def backward(ctx, grad_output):

input, = ctx.saved_tensors

grad_input = grad_output.clone()

grad_input[input < 0] = 0

return grad_input

x = torch.tensor([-1.0, 1.0, 2.0], requires_grad=True)

y = MyReLU.apply(x)

y.backward(torch.tensor([1.0, 1.0, 1.0]))

print(x.grad) # Выходной градиент

В этом примере показано, как определить пользовательское ReLU Функция и расчет ее градиента.

requires_grad и no_grad

существовать PyTorch середина,requires_grad Атрибут используется для указания того, является ли определенный Tensor изградиент。torch.no_grad() Контекстный менеджер используется для временного отключения построения всех вычислительных графов.

Пример: использовать requires_grad и no_grad

x = torch.tensor([1.0, 2.0, 3.0], requires_grad=True)

with torch.no_grad():

y = x * 2 # существоватьздесь Не буду отслеживать y изградиентвычислить

z = x * 3

z.backward(torch.tensor([1.0, 1.0, 1.0]))

print(x.grad) # только z изградиент被вычислить

существоватьэтот个пример子середина,y извычислить不会影响градиент,потому чтодляэтосуществовать torch.no_grad() 块середина。

Оптимизация производительности и управление памятью

PyTorch из Autograd системавозвращаться包括了针对Оптимизация производительности и управление памятьюизхарактеристика,Например, контрольные точки градиента (используются для уменьшения использования памяти) и отложенное выполнение (используется для оптимизации производительности).

Пример: Контрольная точка градиента

использовать torch.utils.checkpoint Чтобы уменьшить использование памяти в больших сетях.

import torch.utils.checkpoint as checkpoint

def run_fn(x):

return x * 2

x = torch.tensor([1.0, 2.0, 3.0], requires_grad=True)

y = checkpoint.checkpoint(run_fn, x)

y.backward(torch.tensor([1.0, 1.0, 1.0]))

В этом примере показано, как использовать контрольные точки градиента для оптимизации памяти.

Следуйте за TechLead и делитесь всесторонними знаниями об искусственном интеллекте. Автор имеет более чем 10-летний опыт работы в области архитектуры интернет-сервисов, опыт исследований и разработок продуктов искусственного интеллекта, а также опыт управления командой. Он имеет степень магистра Университета Тунцзи в Университете Фудань, член Лаборатории интеллекта роботов Фудань, старший архитектор, сертифицированный Alibaba Cloud. , специалист по управлению проектами, а также занимается исследованиями и разработками продуктов искусственного интеллекта с доходом в сотни миллионов человек.

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами