ЦВПР 2024 | Круто! ! Последний обзор модели диффузии-диффузии! 100+ статей, 40+ направлений исследований!

1. Улучшение модели диффузии.

1、Accelerating Diffusion Sampling with Optimized Time Steps

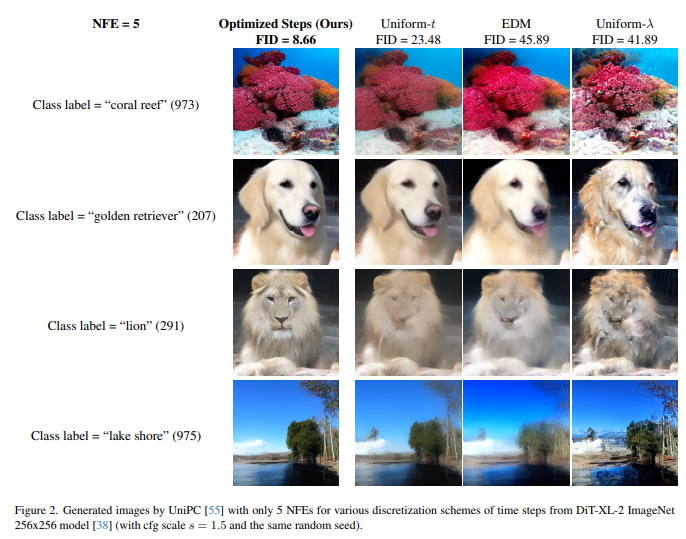

Диффузионно-вероятностные модели (DPM) показали замечательную эффективность при создании изображений с высоким разрешением, но их эффективность выборки все еще нуждается в повышении, поскольку обычно требуется большое количество шагов выборки. Последние достижения в применении решателей ОДУ более высокого порядка к DPM позволяют генерировать высококачественные изображения с меньшим количеством шагов выборки. Однако большинство методов выборки по-прежнему используют одинаковые временные шаги, что неоптимально при использовании небольшого количества шагов.

Чтобы решить эту проблему, предлагается общая структура для разработки задачи оптимизации, которая ищет более подходящий временной шаг для конкретного численного решателя ОДУ в DPM. Целью этой задачи оптимизации является минимизация расстояния между фундаментальным решением и соответствующим численным решением. Эффективное решение этой задачи оптимизации занимает не более 15 секунд.

Обширные эксперименты с DPM в пиксельном и скрытом пространстве, безусловной и условной выборке показывают, что в сочетании с современным методом выборки UniPC в сочетании с равномерным временным шагом для таких данных, как CIFAR-10. и ImageNet Set, согласно оценке FID, оптимизация временного шага значительно повышает производительность генерации изображений.

2、DistriFusion: Distributed Parallel Inference for High-Resolution Diffusion Models

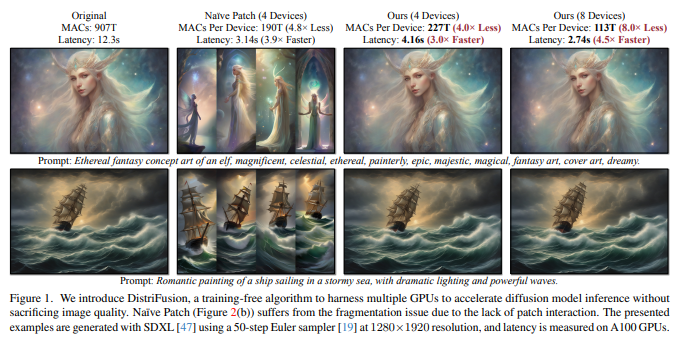

Создание изображений высокого разрешения с использованием диффузионных моделей требует больших вычислительных затрат, что приводит к неприемлемой задержке для интерактивных приложений. DistriFusion предлагается решить эту проблему, используя параллелизм между несколькими графическими процессорами. Метод разделяет входные данные модели на несколько патчей и назначает каждый графическому процессору. Однако простая реализация этого алгоритма нарушит взаимодействие между патчами и приведет к потере точности, а учет этого взаимодействия приведет к огромным накладным расходам на связь.

Чтобы решить эту дилемму, наблюдается большое сходство между входными данными соседних этапов диффузии и предлагается параллелизм патчей смещения, который использует последовательный характер процесса диффузии путем повторного использования предварительно вычисленной карты признаков предыдущего временного шага, поскольку текущий шаг обеспечивает контекст . Таким образом, методы поддерживают асинхронную связь и могут передаваться по конвейеру посредством вычислений. Обширные эксперименты показывают, что этот метод можно применить к последнему Stable Diffusion XL без потери качества и добиться ускорения до 6,1 раз по сравнению с устройством NVIDIA A100. Исходный код уже открыт по адресу: https://github.com/mit-han-lab/distrifuser.

3、Balancing Act: Distribution-Guided Debiasing in Diffusion Models

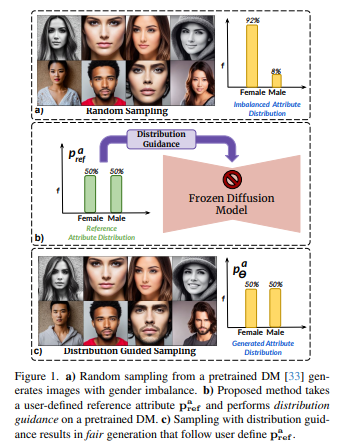

Модели диффузии (DM) отражают смещение, присутствующее в наборе обучающих данных. Особое беспокойство вызывает случай с лицами, когда DM отдают предпочтение определенным демографическим группам перед другими (например, женщины перед мужчинами). В этой работе предлагается метод устранения смещения DM, не полагаясь на дополнительные данные или переобучение модели.

В частности, предлагается метод управления распределением, который заставляет сгенерированное изображение следовать заданному распределению атрибутов. Для достижения этой цели скрытые функции шумоподавления UNet созданы с использованием богатой семантики групп населения, и эти функции можно использовать для управления созданием debias. Обучите предиктор распределения атрибутов (ADP), небольшой многоуровневый персептрон, который сопоставляет скрытые функции с распределениями атрибутов. ADP обучается с использованием псевдометок, созданных существующими классификаторами атрибутов. Введенные Руководство по распределению и ADP обеспечивают справедливое производство.

Этот метод уменьшает смещение по одному/множеству атрибутов и обеспечивает значительно лучшую базовую производительность, чем предыдущие методы, с точки зрения моделей безусловного и текстового распространения. Кроме того, предлагается следующая задача по обучению классификатора справедливых атрибутов путем генерации данных, которые перебалансируют обучающий набор.

4、Few-shot Learner Parameterization by Diffusion Time-steps

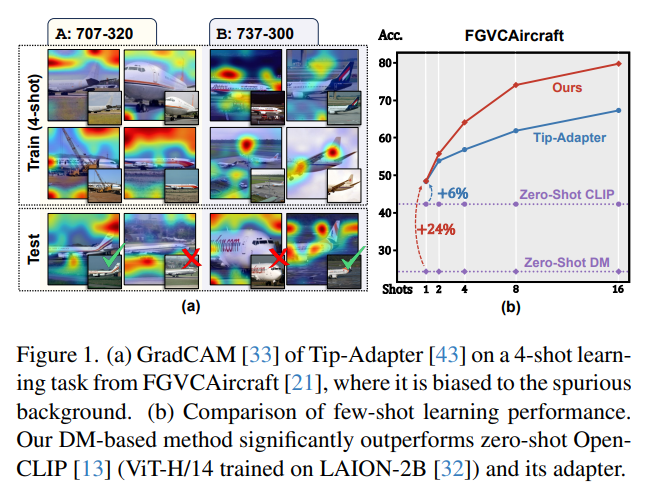

Даже при использовании больших мультимодальных базовых моделей обучение в несколько этапов остается сложной задачей. Без соответствующего индуктивного смещения трудно сохранить тонкие атрибуты класса, удаляя при этом заметные визуальные атрибуты, не имеющие отношения к метке класса.

Было обнаружено, что временные шаги модели диффузии (DM) могут изолировать тонкие атрибуты класса, т. Е. Поскольку прямая диффузия добавляет шум к изображению на каждом временном шаге, тонкие атрибуты часто теряются на более ранних временных шагах, чем существенные атрибуты. На основании этого предлагается обучающийся алгоритм с несколькими шагами по времени (TiF). Адаптеры низкого ранга для конкретного класса обучены для DM с текстовым условием, чтобы компенсировать недостающие атрибуты, позволяя точно реконструировать исходное изображение из зашумленного изображения с учетом подсказок. Таким образом, на меньших временных шагах адаптеры и подсказки по сути представляют собой параметризации с лишь тонкими свойствами класса. Для тестового изображения эту параметризацию можно использовать для извлечения только тонких атрибутов класса для классификации. При выполнении различных мелкодетализированных и настраиваемых задач обучения, состоящих из нескольких шагов, учащийся TiF значительно превосходит OpenCLIP и его адаптеры по производительности.

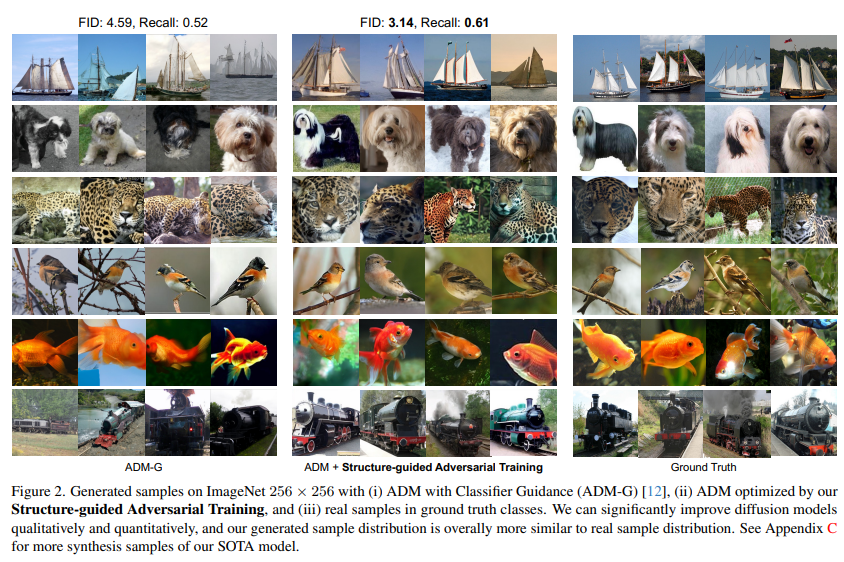

5、Structure-Guided Adversarial Training of Diffusion Models

Модели диффузии продемонстрировали превосходную эффективность в различных генеративных приложениях. Существующие модели в основном сосредоточены на моделировании распределения данных посредством минимизации взвешенных потерь, но их обучение в основном делает упор на оптимизацию на уровне экземпляра, игнорируя ценную структурную информацию в каждом мини-пакете данных.

Чтобы устранить это ограничение, введен метод состязательного обучения диффузионных моделей (SADM), ориентированный на структуру. Заставляет модель изучать структуру многообразия между выборками в каждом обучающем пакете. Чтобы гарантировать, что модель отражает реальную структуру многообразия в распределении данных, предлагается новый дискриминатор структуры, позволяющий различать реальную структуру многообразия и сгенерированную структуру многообразия, играя в игру с генератором диффузии посредством состязательного обучения.

SADM значительно улучшает существующие диффузионные преобразователи, превосходя существующие методы на 12 наборах данных в задачах генерации изображений и междоменной точной настройки для генерации изображений с учетом классов с разрешениями 256×256 и 512×512. Новые записи FID составляют 1,58 и 2,11 соответственно. .

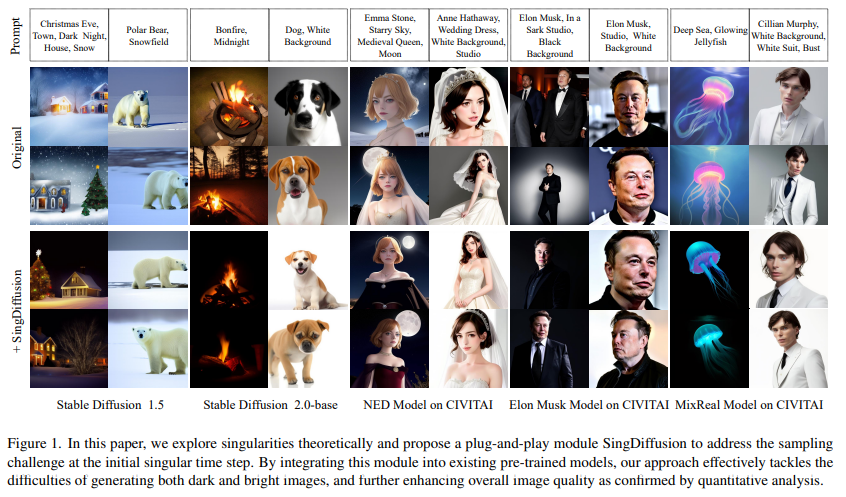

6、Tackling the Singularities at the Endpoints of Time Intervals in Diffusion Models

Большинство моделей диффузии предполагают, что обратный процесс подчиняется распределению Гаусса. Однако это приближение не было строго проверено в особых точках (t=0 и t=1), особенно в сингулярностях. Неправильное обращение с этими точками может вызвать проблемы со средней яркостью в приложениях и ограничить создание изображений с чрезмерной яркостью или глубокой темнотой.

В данной статье рассматривается этот вопрос с теоретической и практической точки зрения. Во-первых, устанавливается граница погрешности аппроксимации обратного процесса и демонстрируются его гауссовы характеристики на сингулярных шагах по времени. На основе этого теоретического понимания подтверждается, что особая точка при t=1 может быть устранена условно, тогда как особая точка при t=0 является внутренним свойством. На основе этих важных выводов предлагается новый метод plug-and-play SingDiffusion для обработки выборки начальных сингулярных временных шагов, который может не только эффективно решить проблему средней яркости без дополнительного обучения, но и улучшить возможности их генерации, тем самым достигая значительно более низкий показатель FID. https://github.com/PangzeCheung/SingDiffusion

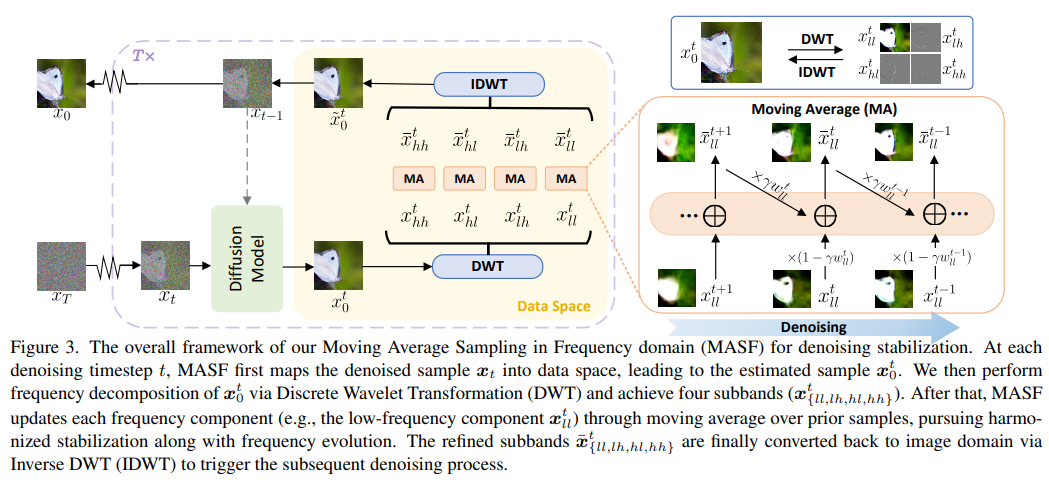

7、Boosting Diffusion Models with Moving Average Sampling in Frequency Domain

Модели диффузии в основном полагаются на текущую выборку для шумоподавления следующей выборки, что может привести к нестабильности. В этой статье итеративный процесс шумоподавления интерпретируется как оптимизация модели и используется механизм скользящего среднего для агрегирования всех предыдущих выборок. Вместо того, чтобы просто применять скользящее среднее к выборкам с шумоподавлением на разных временных шагах, выборки с шумоподавлением сначала сопоставляются с пространством данных, а затем выполняется скользящее среднее, чтобы избежать сдвигов распределения между временными шагами.

Поскольку диффузионная модель восстанавливает детали от низкочастотных компонентов к высокочастотным компонентам, выборка далее разбивается на различные частотные компоненты и скользящее среднее выполняется для каждого компонента отдельно. Полный метод называется «Выборка скользящего среднего в частотной области (MASF)». MASF можно легко интегрировать в основные предварительно обученные диффузионные модели и планы отбора проб. Обширные эксперименты с моделями безусловной и условной диффузии показывают, что MASF демонстрирует превосходную производительность по сравнению с базовыми моделями практически без дополнительных затрат на сложность.

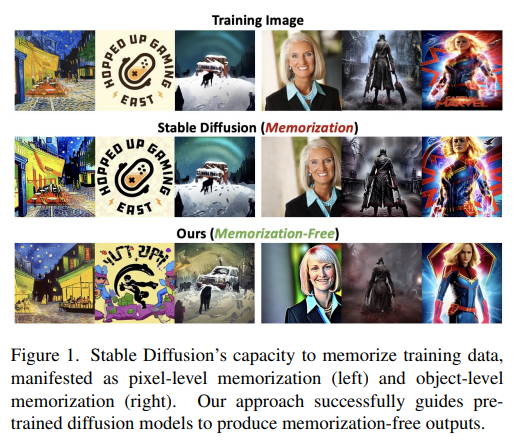

8、Towards Memorization-Free Diffusion Models

Предварительно обученные диффузионные модели и их результаты широко и легко доступны благодаря их превосходной способности синтезировать высококачественные изображения и их открытому исходному коду. Пользователи могут столкнуться с риском судебных разбирательств в процессе вывода, поскольку модели имеют тенденцию запоминать и копировать данные обучения.

Чтобы решить эту проблему, представлена новая структура под названием «Руководство по борьбе с запоминанием (AMG)», которая использует три целевые стратегии управления памятью для борьбы с повторением изображений и подписей, а также с высокоспецифичными пользовательскими подсказками и другими основными причинами запоминания. Таким образом, AMG обеспечивает вывод без использования памяти, сохраняя при этом высокое качество изображения и выравнивание текста, используя синергию своих методов наведения, каждый из которых незаменим в своей области.

AMG также имеет инновационную систему автоматического обнаружения для обнаружения потенциальных воспоминаний на каждом этапе процесса вывода, что позволяет выборочно применять стратегии управления с минимальным вмешательством в исходный процесс выборки, чтобы сохранить полезность выходных данных. Применяйте AMG для различных задач генерации предварительно обученной вероятностной модели диффузии шумоподавления (DDPM) и стабильной диффузии. Результаты экспериментов показывают, что AMG является первым методом, позволяющим успешно устранить все экземпляры памяти с незначительным или незначительным влиянием на качество изображения и выравнивание текста, о чем свидетельствуют оценки FID и CLIP.

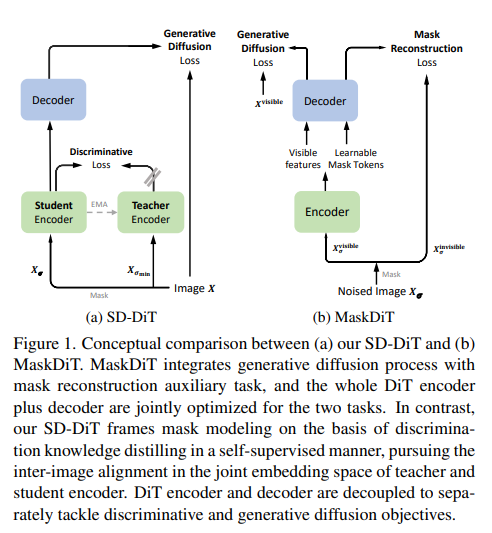

9、SD-DiT: Unleashing the Power of Self-supervised Discrimination in Diffusion Transformer

Диффузионный преобразователь (DiT) стал тенденцией в создании изображений. Учитывая чрезвычайно медленную конвергенцию типичного DiT, недавние прорывы были обусловлены стратегиями маскировки, которые повышают эффективность обучения за счет дополнительного обучения контексту внутри изображения. Однако стратегия маски по-прежнему имеет два ограничения: (а) различия в выводах обучения и (б) неоднозначная связь между реконструкцией маски и процессами генеративной диффузии, что приводит к неоптимальному обучению DiT.

Эта работа устраняет эти ограничения, раскрывая дискриминационные знания с самоконтролем для облегчения обучения DiT. Технически говоря, DiT построен по принципу «учитель-ученик». Дискриминантные пары учитель-ученик строятся на основе диффузного шума по одному и тому же вероятностному потоку обыкновенного дифференциального уравнения (PF-ODE). Вместо применения потерь реконструкции маски к кодеру и декодеру DiT, кодер и декодер DiT разъединяются для раздельной обработки дискриминативных и генеративных целей. В частности, новая дискриминационная потеря предназначена для поощрения выравнивания изображений в самоконтролируемом пространстве встраивания путем кодирования дискриминационных пар с использованием кодеров DiT учащихся и учителей. После этого выборки студентов подаются в студенческий декодер DiT для выполнения типичной задачи генеративного распространения. С набором данных ImageNet проводятся обширные эксперименты, и этот метод обеспечивает конкурентоспособный баланс между стоимостью обучения и генерационной мощностью.

2. Управляемая диаграмма Винсента.

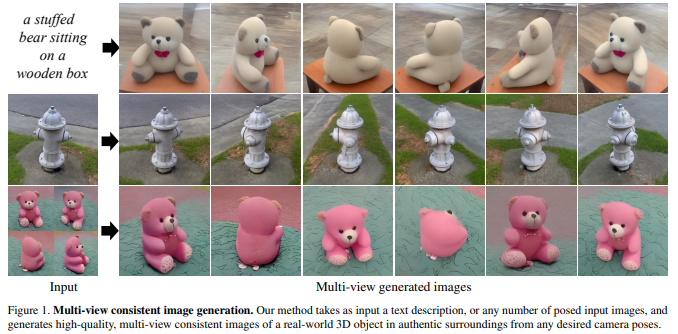

10、ViewDiff: 3D-Consistent Image Generation with Text-to-Image Models

Генерации 3D-ресурсов уделяется много внимания, вдохновленное недавним успехом создания 2D-контента с текстовым управлением. Существующие методы преобразования текста в 3D используют предварительно обученные модели диффузии текста в изображение для решения проблем оптимизации или точной настройки. синтетические данные, что часто приводит к созданию нефотореалистичных 3D-объектов без фона.

В этой статье предлагается использовать предварительно обученную модель преобразования текста в изображение в качестве априорной и научиться генерировать многовидовые изображения из одного процесса шумоподавления на реальных данных. В частности, объемный 3D-рендеринг и межкадровые уровни внимания интегрированы в каждый блок существующей модели преобразования текста в изображение. Кроме того, авторегрессионная генерация предназначена для визуализации более согласованных трехмерных изображений с любой точки зрения. Модель обучена с использованием набора данных реальных объектов и продемонстрировала свою способность генерировать экземпляры с различными высококачественными формами и текстурами.

Полученные результаты являются последовательными и имеют хорошее визуальное качество по сравнению с существующими методами (снижение FID на 30% и снижение KID на 37%). https://lukashoel.github.io/ViewDiff/

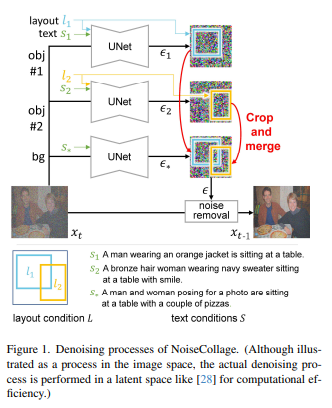

11、NoiseCollage: A Layout-Aware Text-to-Image Diffusion Model Based on Noise Cropping and Merging

Генерация текста в изображение с учетом макета — это задача создания многообъектных изображений, которые отражают условия макета и условия текста. Текущие модели распространения текста в изображения с учетом макета по-прежнему страдают от некоторых проблем, включая несоответствие между текстом и условиями макета и снижение качества генерируемых изображений.

В этой статье для решения этих проблем предлагается новая модель диффузии текста в изображение с учетом макета, называемая NoiseCollage. В процессе шумоподавления NoiseCollage независимо оценивает шум каждого объекта, затем обрезает и объединяет их в один шум. Эта операция помогает избежать несоответствия условий, другими словами, она помещает нужный объект в нужное место.

Результаты качественной и количественной оценки показывают, что NoiseCollage превосходит по производительности некоторые современные модели. Также было показано, что NoiseCollage можно интегрировать с ControlNet, используя края, эскизы и скелеты поз в качестве дополнительных условий. Результаты экспериментов показывают, что эта интеграция может повысить точность компоновки ControlNet. https://github.com/univ-esuty/noisecollage

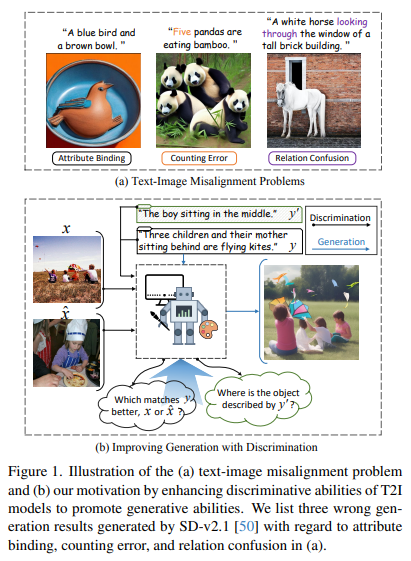

12、Discriminative Probing and Tuning for Text-to-Image Generation

Несмотря на достижения в области генерации текста в изображение, предыдущие методы часто страдают от проблем несовпадения текста и изображения, таких как путаница отношений в сгенерированных изображениях. Существующие решения включают операции перекрестного внимания для лучшего понимания комбинаций или интеграцию больших языковых моделей для улучшения планирования помещений. Однако возможности выравнивания, присущие моделям T2I, все еще недостаточны.

Рассматривая связь между генеративным и дискриминативным моделированием, мы предполагаем, что дискриминационная способность моделей T2I может отражать их возможности выравнивания текста и изображения во время генеративного процесса. Ввиду этого рекомендуется повысить различительную способность моделей T2I для достижения более точного выравнивания текста и изображения при генерации.

Предлагается дискриминационный адаптер, основанный на модели T2I, для изучения их дискриминационных возможностей в двух репрезентативных задачах и использования дискриминационной точной настройки для улучшения калибровки текста и изображения. Преимущество дискриминационного адаптера заключается в том, что механизм самокорректировки может использовать дискриминантный градиент для лучшего согласования сгенерированного изображения с текстовыми подсказками во время вывода.

Комплексная оценка трех эталонных наборов данных (включая сценарии распределения и выхода из распределения) демонстрирует превосходную генеративную эффективность метода. В то же время он обеспечивает самые современные дискриминационные характеристики при решении двух дискриминационных задач по сравнению с другими генеративными моделями. https://github.com/LgQu/DPT-T2I

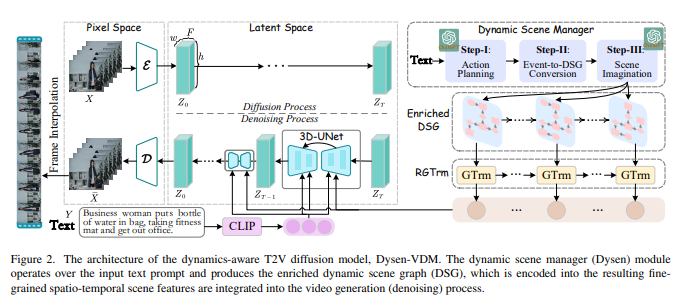

13、Dysen-VDM: Empowering Dynamics-aware Text-to-Video Diffusion with LLMs

Синтез текста в видео (T2V) привлекает все большее внимание в научных кругах, где новая диффузионная модель (DM) оказалась более эффективной по производительности, чем предыдущие методы. Хотя существующие современные DM хорошо справляются с созданием видео высокого разрешения, они все еще имеют значительные ограничения при моделировании сложной временной динамики (например, неупорядоченное движение, грубое видеодвижение).

В этой работе изучаются методы улучшения восприятия DM динамики видео для генерации высококачественного T2V. Вдохновленный человеческой интуицией, разработан новый модуль динамического менеджера сцен (называемый Dysen), включающий (шаг 1) извлечение ключевых действий в соответствующем временном порядке из входного текста (шаг 2) преобразование плана действий в граф динамической сцены (DSG). представление и (шаг 3) обогатить сцену в DSG, чтобы предоставить достаточные и разумные детали. Используя существующие мощные LLM (такие как ChatGPT) для контекстного обучения, Dysen достигает (почти) динамического временного понимания на человеческом уровне. Наконец, видео DSG с богатой детализацией боевых сцен кодируется в мелкозернистые пространственно-временные функции и интегрируется в базовый T2V DM для генерации видео.

Эксперименты с популярным набором данных T2V показывают, что Dysen-VDM неизменно превосходит предыдущие методы, имея значительные преимущества, особенно в сложных боевых сценах.

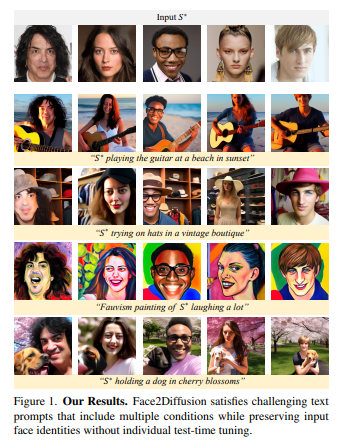

14、Face2Diffusion for Fast and Editable Face Personalization

Персонализация лиц направлена на вставку конкретных лиц с изображений в предварительно обученный текст в модели распространения изображений. Однако предыдущие методы по-прежнему имеют проблемы с сохранением сходства идентичности и редактируемости, поскольку они подходят для обучающих выборок.

В этой статье предлагается метод Face2Diffusion (F2D) для легко редактируемой персонализации лица. Основная идея F2D — удалить из процесса обучения информацию, не имеющую отношения к личности, чтобы предотвратить проблемы переобучения и улучшить редактируемость закодированных лиц. F2D содержит следующие три новых компонента: 1) Многомасштабный кодировщик идентификационных данных обеспечивает четкое разделение идентификационных функций, сохраняя при этом преимущества многомасштабной информации, тем самым улучшая разнообразие поз камеры. 2) Управление выражением лица отделяет выражение лица от личности, улучшая управляемость выражения лица. 3) Регуляризация шумоподавления на основе категорий побуждает модель научиться шумоподавлять лица, тем самым улучшая текстовое выравнивание фона.

Обширные эксперименты с набором данных FaceForensics++ и различными подсказками показывают, что этот метод обеспечивает лучший баланс между идентичностью и точностью текста по сравнению с предыдущими современными методами. https://github.com/mapooon/Face2Diffusion

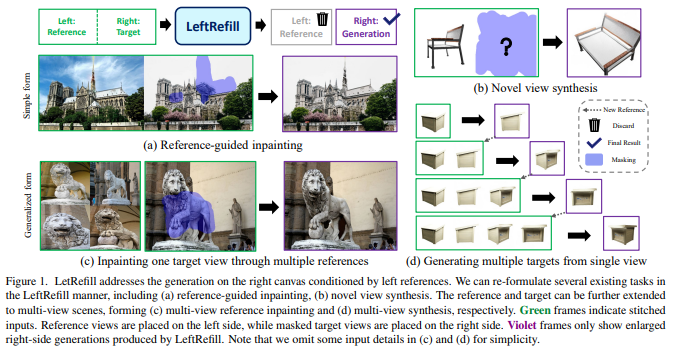

15、LeftRefill: Filling Right Canvas based on Left Reference through Generalized Text-to-Image Diffusion Model

В этой статье предлагается LeftRefill, новый метод, который эффективно использует большие модели диффузии текста в изображение (T2I) для синтеза изображений на основе ссылок. Как следует из названия, LeftRefill объединяет эталонное представление и целевое представление по горизонтали в качестве общего ввода. Эталонное изображение занимает левую сторону, а целевой холст — правую. Затем LeftRefill рисует целевой холст справа на основе левой ссылки и конкретных инструкций по задаче. Эта форма задачи похожа на восстановление контекста, похожее на то, что сделал бы человек-художник.

Эта новая форма эффективно изучает структурные и текстурные соответствия между эталоном и целью без необходимости использования дополнительных кодировщиков изображений или адаптеров. Информация о задачах и представлениях вводится через модуль перекрестного внимания в модели T2I, а эталонная возможность множественного представления дополнительно демонстрируется через переработанный модуль собственного внимания. Это позволяет LeftRefill выполнять согласованную генерацию в качестве общей модели без необходимости тонкой настройки или модификации модели во время тестирования. Таким образом, LeftRefill можно рассматривать как простую и унифицированную структуру для решения проблемы синтеза по ссылкам.

Например, LeftRefill используется для решения двух различных задач: восстановления на основе эталонов и синтеза новой перспективы на основе предварительно обученной модели StableDiffusion. https://github.com/ewrfcas/LeftRefill

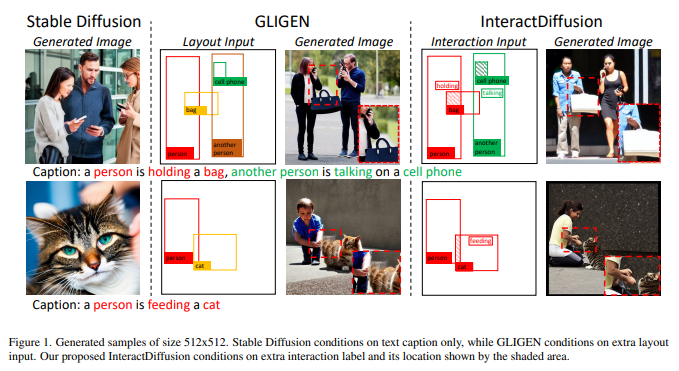

16、InteractDiffusion: Interaction Control in Text-to-Image Diffusion Models

Крупномасштабная модель диффузии изображения в текст (T2I) демонстрирует способность генерировать связные изображения на основе текстовых описаний, обеспечивая широкий спектр приложений для создания контента. Несмотря на то, что существует некоторый контроль над такими аспектами, как положение объекта, поза и контуры изображения, все еще существует пробел в управлении взаимодействием между объектами в сгенерированном контенте. Управление взаимодействием между объектами в сгенерированных изображениях может привести к значимым приложениям, таким как создание реалистичных сцен с интерактивными персонажами.

В этой работе изучается проблема согласования моделей диффузии T2I с информацией о взаимодействии человека и объекта (HOI), которая состоит из троичных меток (человек, действие, объект) и соответствующих ограничивающих рамок. Предлагается модель управления взаимодействием под названием InteractDiffusion, которая расширяет существующую предварительно обученную модель диффузии T2I, чтобы обеспечить лучший условный контроль взаимодействий. В частности, информация HOI токенизируется, и взаимосвязь между ними изучается посредством интерактивного внедрения. Уровень условного самообслуживания, который обучает токены HOI визуальным токенам, обучается для лучшего кондиционирования существующих моделей диффузии T2I.

Модель обладает способностью контролировать взаимодействие и положение и намного превосходит существующие базовые модели по показателям обнаружения HOI, а также по более высокой точности FID и KID. https://jiuntian.github.io/interactdiffusion/

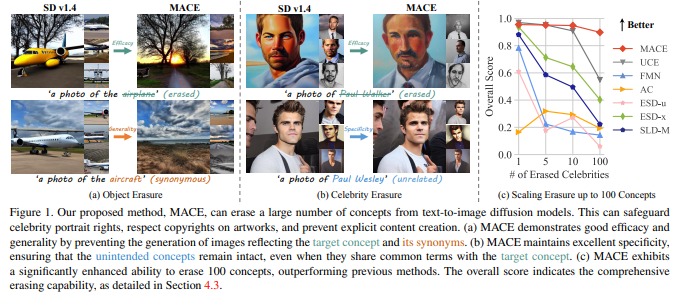

17、MACE: Mass Concept Erasure in Diffusion Models

Быстрое распространение крупномасштабных моделей распространения текста в изображения вызвало растущую обеспокоенность по поводу их потенциального неправильного использования для создания вредного или вводящего в заблуждение контента. В этом документе предлагается структура тонкой настройки под названием MACE для задачи стирания концепции MASS (MACE). Эта задача предназначена для предотвращения создания моделью изображений с нежелательными концепциями при появлении соответствующего запроса. Существующие методы исключения понятий обычно позволяют обрабатывать менее пяти понятий, при этом трудно найти баланс между устранением синонимов понятий (широта) и сохранением нерелевантных понятий (специфичность). Напротив, MACE изменил ситуацию, успешно расширив объем исключения до 100 концепций и добившись эффективного баланса между общностью и конкретикой. Это достигается за счет использования уточнения перекрестного внимания в закрытой форме и тонкой настройки LoRA, совместно исключая информацию из нежелательных концепций.

Более того, MACE объединяет несколько LoRA без взаимного вмешательства. MACE тщательно оценивается по четырем различным задачам: устранение объектов, устранение знаменитостей, устранение явного контента и устранение художественного стиля. Результаты показывают, что MACE превосходит предыдущие методы во всех задачах оценки. https://github.com/Shilin-LU/MACE

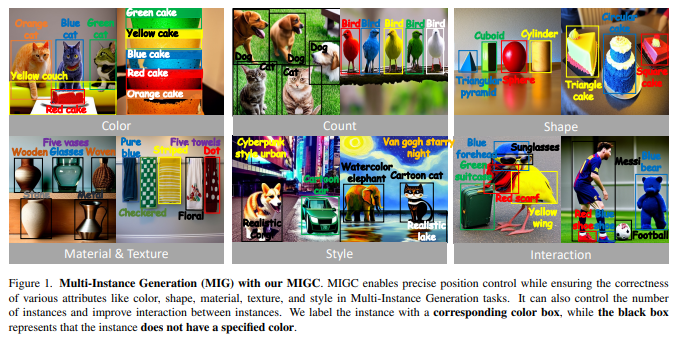

18、MIGC: Multi-Instance Generation Controller for Text-to-Image Synthesis

предложить задачу создания нескольких экземпляров (MIG) для одновременного создания нескольких экземпляров с разнообразным управлением в одном изображении. Учитывая предопределенный набор координат и соответствующие им описания, задача состоит в том, чтобы гарантировать, что сгенерированные экземпляры расположены точно в указанных местах и чтобы все свойства экземпляров соответствовали соответствующим описаниям. Это расширяет сферу текущих исследований генерации единичных экземпляров, поднимая их до более разнообразного и практического измерения.

Вдохновленный идеей «разделяй и властвуй», для решения задач MIG представлен инновационный подход под названием Multiple Instance Generation Controller (MIGC). Сначала задача MIG разбивается на несколько подзадач, каждая из которых предполагает затенение одного экземпляра. Для обеспечения точной раскраски каждого экземпляра введен механизм расширенного внимания. Наконец, все цветные экземпляры объединяются, предоставляя необходимую информацию (SD) для точного создания стабильного распространения между несколькими экземплярами. Для оценки эффективности генеративной модели при выполнении задачи MIG предоставляются тест COCO-MIG и процесс оценки.

Обширные эксперименты проводятся с предлагаемым тестом COCO-MIG, а также с различными широко используемыми тестами. Результаты оценки демонстрируют отличные возможности управления моделью с точки зрения количества, местоположения, атрибутов и взаимодействий. https://migcproject.github.io/

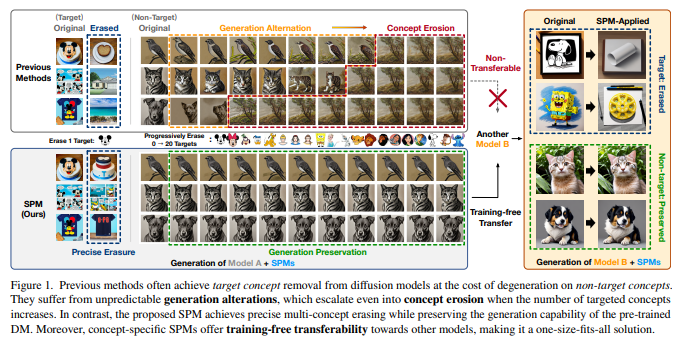

19、One-dimensional Adapter to Rule Them All: Concepts, Diffusion Models and Erasing Applications

Широкое использование коммерческих моделей диффузии и моделей распространения с открытым исходным кодом (DM) при преобразовании текста в изображение привело к снижению рисков и предотвращению нежелательного поведения. Все существующие в академическом сообществе методы исключения концепций основаны на полной настройке параметров или на основе спецификаций, в результате чего наблюдаются следующие проблемы: 1) Изменения генерации в направлении эрозии: дрейф параметров в процессе целевого исключения приведет к изменения в процессе генерации и потенциальная деформация даже в той или иной степени разрушат другие концепции, что более очевидно в случае исключения нескольких концепций. 2) Невозможность переноса и неэффективное развертывание: устранение предыдущей концепции, специфичной для модели, препятствует гибкому сочетанию; концепции и бесплатное использование других моделей. Перенос, в результате чего стоимость развертывания растет линейно по мере увеличения количества сценариев развертывания.

Чтобы добиться неинтрузивного, точного, настраиваемого и переносимого исключения, структура исключения построена на 1D-адаптере, позволяющем одновременно исключать несколько концепций из большинства DM в нескольких сценариях применения исключения. Концепция. Полупроницаемые структуры вводятся в любую твёрдую ткань в виде мембраны (СПМ), чтобы научиться целенаправленному устранению и эффективно смягчить изменения и явления эрозии с помощью новой стратегии тонкой настройки скрытого закрепления. После получения SPM можно гибко комбинировать и вставлять в другие DM без специальной доводки, а также своевременно и эффективно адаптировать к различным сценариям. В процессе генерации механизм активации транспорта динамически регулирует проницаемость каждого СЗМ в ответ на различные входные сигналы, еще больше сводя к минимуму влияние на другие концепции.

Количественные и качественные результаты примерно по 40 концепциям, 7 DM и 4 приложениям по исключению демонстрируют превосходные возможности SPM по исключению. https://lyumengyao.github.io/projects/spm

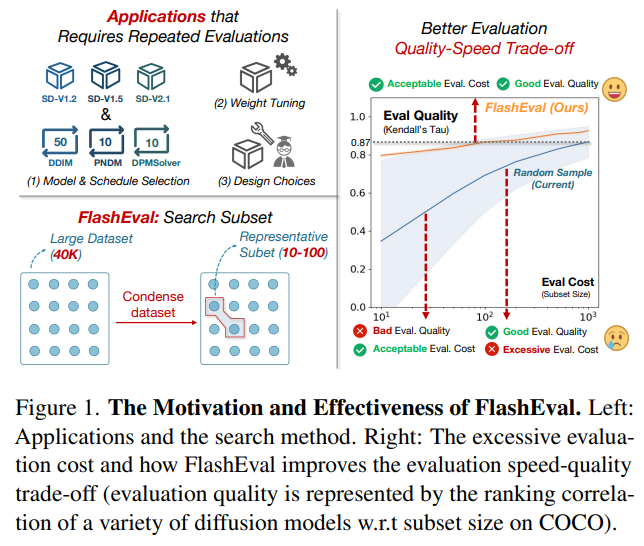

20、FlashEval: Towards Fast and Accurate Evaluation of Text-to-image Diffusion Generative Models

В последние годы был достигнут значительный прогресс в разработке генеративных моделей преобразования текста в изображение. Оценка качества создаваемых моделей является одним из важных этапов процесса разработки. Процесс оценки может потребовать значительных вычислительных ресурсов, что делает нецелесообразным проведение необходимой регулярной оценки производительности модели (например, мониторинг прогресса обучения). Поэтому стремятся повысить эффективность оценки путем выбора репрезентативного подмножества набора данных текстового изображения.

В этой статье систематически изучаются варианты дизайна, включая критерии выбора (особенности текстуры или метрики на основе изображений) и степень детализации выбора (уровень сигнала или уровень набора). Обнаружив, что выводы из предыдущей работы по выбору подмножества обучающих данных не применимы к этой проблеме, был предложен FlashEval, алгоритм итеративного поиска, предназначенный для оценки выбора данных. Продемонстрируйте эффективность FlashEval при ранжировании моделей диффузии с различными конфигурациями, включая архитектуру, уровень квантования и сэмплер, в наборах данных COCO и DiffusionDB. Подмножество из 50 элементов, в котором осуществляется поиск, обеспечивает качество оценки, сравнимое с подмножеством из 500 элементов, выбранным случайным образом для аннотаций COCO на невидимых моделях, что приводит к десятикратному ускорению оценки. Сжатые подмножества этих часто используемых наборов данных будут выпущены, чтобы облегчить разработку и оценку алгоритмов распространения, а FlashEval будет открыт с открытым исходным кодом в качестве инструмента для сжатия будущих наборов данных.

3. Миграция стилей

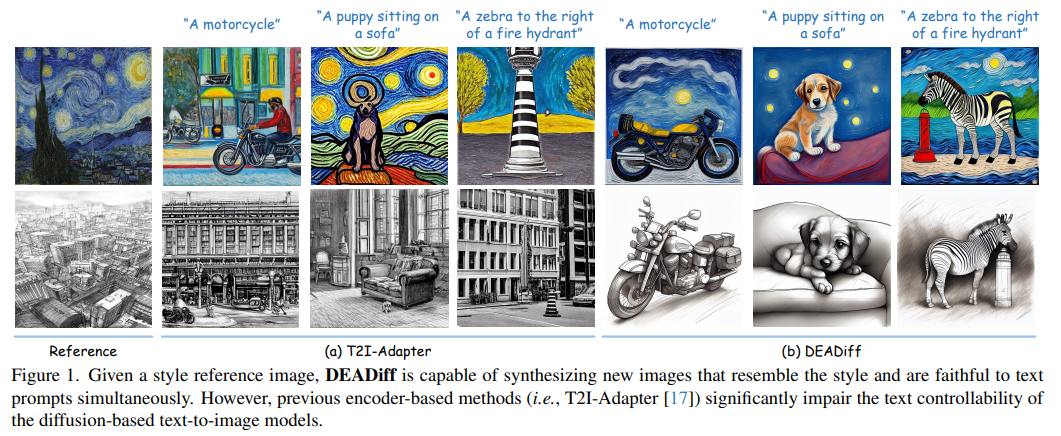

21、DEADiff: An Efficient Stylization Diffusion Model with Disentangled Representations

Модели, основанные на диффузии текста в изображение, имеют большой потенциал в передаче эталонных стилей. Однако современные методы, основанные на кодировании, существенно ухудшают управляемость текста моделями преобразования текста в изображение при передаче стилей. В данной статье DEADiff предлагает решить эту проблему, приняв следующие две стратегии: 1) Механизм разделения стиля и семантики эталонного изображения. Представление разделенного объекта сначала извлекается с помощью Q-Formers на основе различных текстовых описаний. Затем они вводятся во взаимоисключающие подмножества слоя перекрестного внимания для достижения лучшего разложения. 2) Нереконструктивный метод обучения. Q-Formers обучается с использованием пар изображений вместо идентичных целей, где эталонное изображение и реальное изображение имеют одинаковый стиль или семантику.

Показано, что DEADiff достигает наилучших результатов в визуальной стилизации и показывает лучший баланс между управляемостью текста и стилистическим сходством с эталонными изображениями как количественно, так и качественно. https://tianhao-qi.github.io/DEADiff/

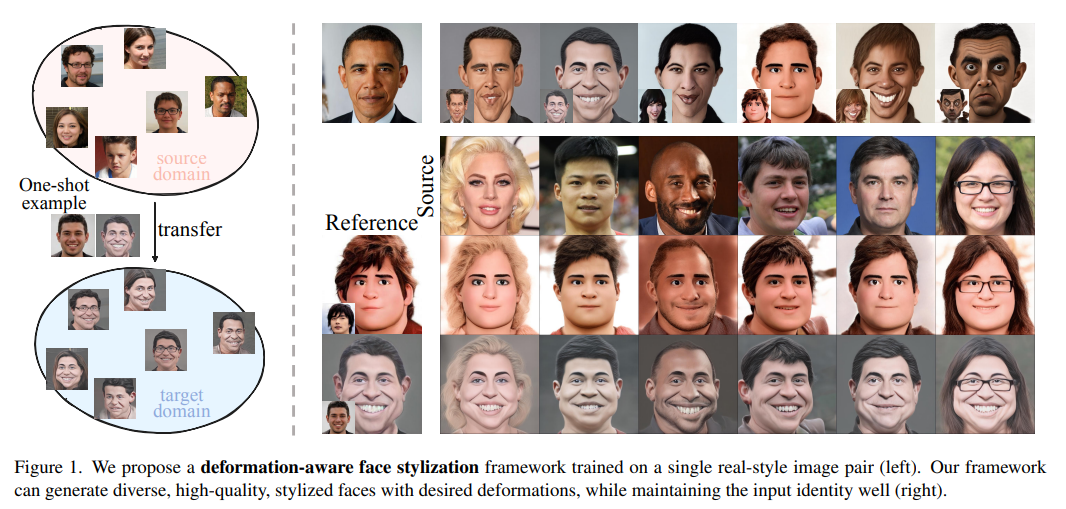

22、Deformable One-shot Face Stylization via DINO Semantic Guidance

В данной статье рассматривается проблема стилизации лица One-shot, уделяя особое внимание как внешнему виду, так и структуре. Изучение стилизации лица с учетом деформации, которая отличается от традиционных эталонных стилей с одним изображением. Суть метода заключается в использовании визуального преобразователя с самоконтролем, в частности DINO-ViT, для создания мощного и последовательного представления структуры лица, охватывающего как реальные, так и стилизованные поля. Процесс стилизации сначала реализуется путем интеграции пространственного преобразователя (STN) путем адаптации генератора StyleGAN к состоянию с учетом деформации. Затем, руководствуясь семантикой DINO, вводятся два инновационных ограничения для точной настройки генератора: i) потери при деформации направления, которые корректируют вектор направления в пространстве DINO; ii) относительная структурная согласованность, основанная на самоподобии; Токены DINO Ограничения для обеспечения разнообразия генерации. Кроме того, используется смешение стилей, чтобы генерация цветов соответствовала эталонному изображению, уменьшая несогласованные соответствия.

Этот метод обеспечивает лучшую деформируемость при однократной стилизации лица и достигает значительной эффективности примерно за 10 минут точной настройки. Обширные качественные и количественные сравнения демонстрируют превосходство нашего подхода в стилизации лица. https://github.com/zichongc/DoesFS

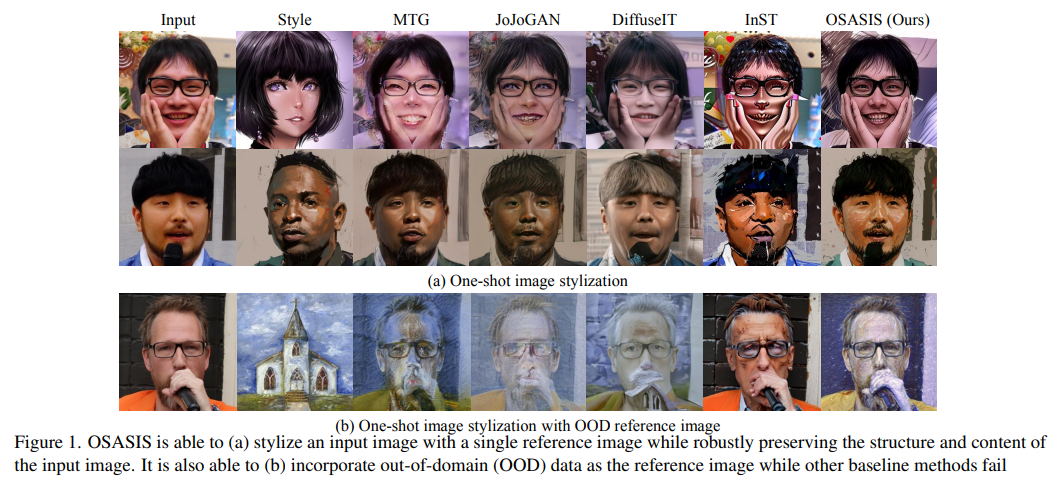

23、One-Shot Structure-Aware Stylized Image Synthesis

Хотя модели на основе GAN успешно справляются с задачами стилизации изображений, им часто сложно сохранить структурную целостность при стилизации различных входных изображений. В последнее время для стилизации изображений используются диффузионные модели, но они по-прежнему не способны поддерживать исходное качество входного изображения.

В этой статье предлагается OSASIS: новый метод стилизации One-Shot, обеспечивающий надежность, сохраняющую структуру. Мы демонстрируем, что OSASIS может эффективно отделить семантику и структуру изображения, позволяя контролировать уровень содержания и стиля в заданных входных данных. Применяйте OSASIS к различным экспериментальным настройкам, включая стилизацию с использованием эталонных изображений вне домена и стилизацию с использованием текстовых операций. Результаты показывают, что OSASIS хорошо работает в качестве метода стилизации, особенно для входных изображений, редко встречающихся при обучении, что представляет собой многообещающее решение для стилизации диффузионной модели.

4. Создание портрета

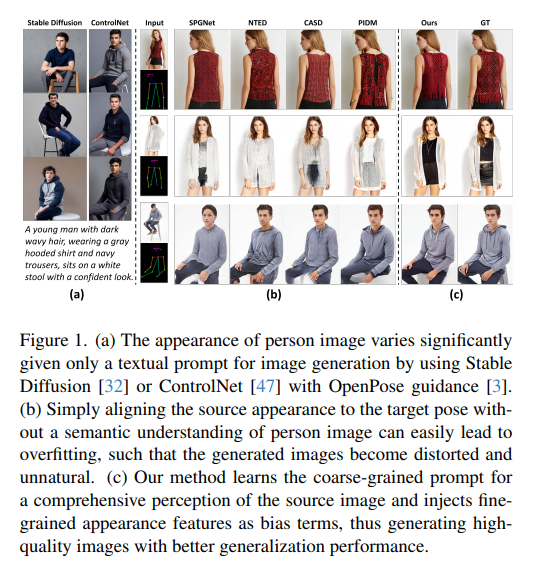

24、Coarse-to-Fine Latent Diffusion for Pose-Guided Person Image Synthesis

Модели диффузии использовались при синтезе изображений человека с учетом позы. Однако существующие методы только выравнивают внешний вид человека с целевой позой. Из-за отсутствия высокого уровня семантического понимания исходного изображения человека могут возникнуть проблемы с переподгонкой.

В этой статье предлагается новый метод синтеза изображений человека с учетом позы — латентная диффузия от грубого к мелкому (CFLD). Парадигма обучения, основанная исключительно на изображениях, разработана для управления процессом генерации предварительно обученной модели распространения текста в изображение при отсутствии пар изображение-текст и текстовых подсказок. Разработайте декодер улучшения восприятия, который постепенно уточняет набор обучаемых запросов и извлекает семантическое понимание изображений людей в виде крупнозернистых сигналов. Это позволяет разделить детализированный внешний вид и обеспечить контроль информации на разных этапах, избегая тем самым потенциальных проблем переобучения.

Для создания более реалистичных деталей текстуры предлагается гибридный модуль детального внимания, который кодирует многомасштабные мелкозернистые особенности внешнего вида в термины смещения для улучшения крупнозернистых сигналов. Количественные и качественные эксперименты на бенчмарке DeepFashion демонстрируют превосходство метода над существующими методиками с точки зрения PGPIS. https://github.com/YanzuoLu/CFLD

25、High-fidelity Person-centric Subject-to-Image Synthesis

Методы создания целевых предметных изображений сталкиваются с серьезными проблемами при создании личностно-ориентированных изображений. Причина в том, что они изучают семантическую сцену и генерацию персонажей путем точной настройки общей предварительной тренировки, которая включает в себя неустранимые дисбалансы обучения. Для создания реалистичных персонажей требуется достаточная настройка предварительно обученных моделей, что неизбежно приводит к тому, что модели забывают богатые априорные семантические сцены и подгоняют генерацию сцены под обучающие данные. Более того, даже после достаточной тонкой настройки эти методы по-прежнему не могут генерировать персонажей с высокой точностью, поскольку совместное изучение сцены и генерации персонажей также приводит к компромиссам в качестве.

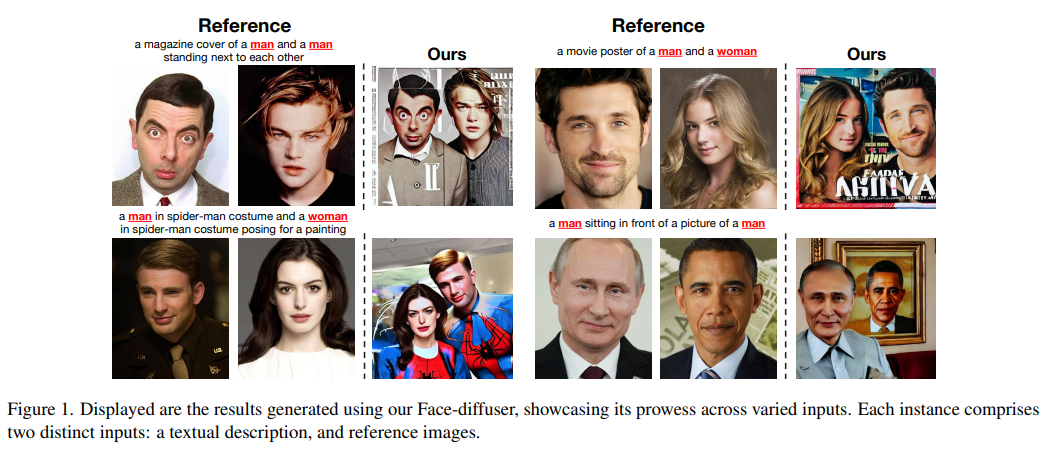

В этой статье предлагается Face-diffuser, эффективный конвейер совместной генерации, позволяющий устранить вышеупомянутый дисбаланс обучения и компромиссы в качестве. В частности, для генерации сцен и персонажей сначала разрабатываются две специализированные предварительно обученные модели диффузии, а именно модель диффузии, управляемая текстом (TDM) и модель диффузии с расширенным субъектом (SDM). Процесс выборки разделен на три последовательных этапа, а именно построение семантической сцены, слияние агента и сцены и улучшение агента. Первый и заключительный этапы выполняются TDM и SDM соответственно. Этап слияния субъекта и сцены реализован с помощью нового и эффективного механизма, а именно адаптивного слияния шума на основе значимости (SNF). В частности, он основан на основном наблюдении этой статьи о том, что существует тесная связь между независимыми от классификатора ответными указаниями и значимостью сгенерированных изображений. На каждом временном этапе SNF использует уникальные сильные стороны каждой модели и автоматически выполняет пространственное смешивание двух шумов прогнозирования модели таким образом, чтобы адаптироваться к значимости, и все это можно легко интегрировать в процесс выборки DDIM.

Эксперименты подтверждают превосходный эффект Face-diffuser при создании высококачественных изображений человека. https://github.com/CodeGoat24/Face-diffuser

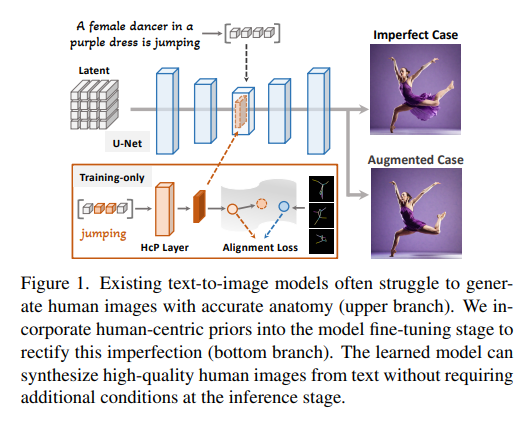

26、Towards Effective Usage of Human-Centric Priors in Diffusion Models for Text-based Human Image Generation

Традиционные модели диффузии текста в изображение с трудом создают точные изображения людей, например, неестественные позы или непропорциональные конечности. Существующие методы в основном решают эту проблему путем добавления дополнительных изображений или телесно-центрированных априорных данных (таких как карты позы или глубины) на этапе точной настройки модели. В этой статье исследуется интеграция этих телесно-центрированных априорных данных непосредственно на этапе точной настройки модели, что устраняет необходимость в дополнительных условиях на этапе вывода.

Эта идея реализуется путем введения потери выравнивания центра человека для улучшения информации, связанной с человеком, из текстовых подсказок на картах перекрестного внимания. Чтобы обеспечить богатство семантических деталей и точность структуры человеческого тела в процессе тонкой настройки, вводятся масштабные и пошаговые ограничения на основе углубленного анализа уровня перекрестного внимания.

Результаты экспериментов показывают, что этот метод позволил значительно улучшить создание высококачественных изображений персонажей на основе подсказок, написанных пользователями. https://hcplayercvpr2024.github.io/

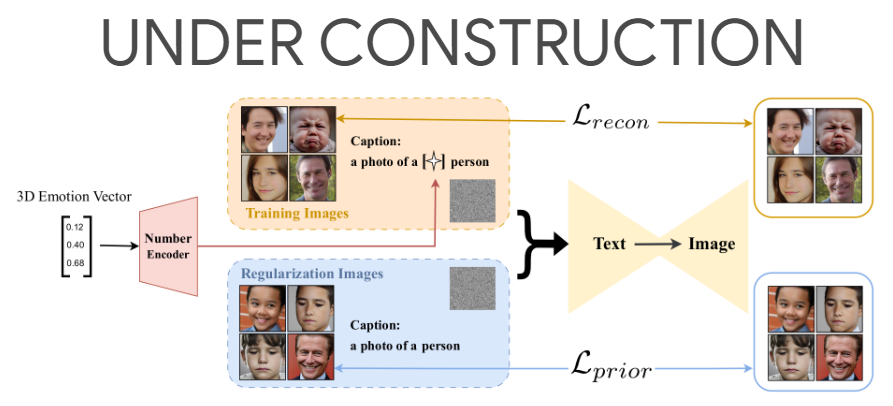

27、A Unified and Interpretable Emotion Representation and Expression Generation

Эмоции, такие как счастье, печаль и страх, легко понять и обозначить. Эмоции часто бывают сложными, например, счастливое удивление, и их можно сопоставить с единицами действия (ЕД), используемыми для выражения эмоций. Эмоции непрерывны и представлены моделью валентности возбуждения (AV). Для лучшего представления и понимания эмоций предполагается объединить эти четыре модальности, а именно классическую, составную, AU и AV. Однако это объединение остается неизвестным.

В этой работе предлагается интерпретируемая и унифицированная модель эмоций под названием C2A2. Также был разработан метод использования меток неунифицированных моделей для аннотирования новых унифицированных моделей. Наконец, модель диффузии, обусловленная текстом, модифицируется для понимания непрерывных цифр, а затем используется единая модель эмоций для генерации непрерывных выражений.

Количественные и качественные эксперименты показывают, что создаваемые изображения богаты и передают тонкие выражения. Эта работа позволяет более детально генерировать выражения в сочетании с другими текстовыми данными и в то же время предоставляет новое пространство для обозначения эмоций. https://emotion-diffusion.github.io/

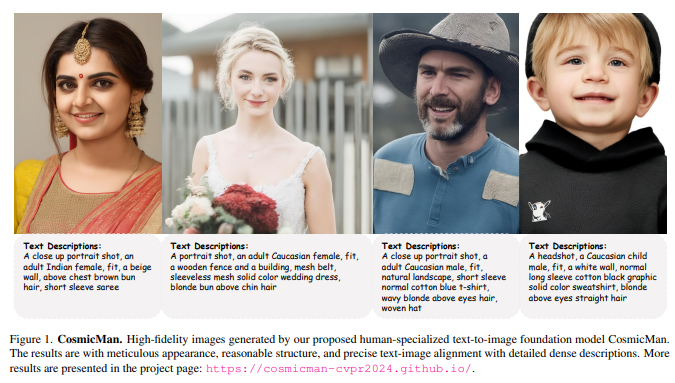

28、CosmicMan: A Text-to-Image Foundation Model for Humans

Мы предлагаем CosmicMan, базовую модель преобразования текста в изображение для создания высококачественных изображений человека. В отличие от текущих базовых моделей, которые привязаны к качеству изображения человеческого тела и несовпадению текста и изображения, CosmicMan способен генерировать реалистичные изображения человеческого тела с детальным внешним видом, рациональной структурой и точным выравниванием текста и изображения, а также предоставлять подробные и плотные описания. Ключом к CosmicMan являются новые размышления и взгляды на данные и модели:

(1) Обнаружение высококачественных данных и масштабируемых процессов генерации данных имеют решающее значение для конечных результатов моделей обучения. Поэтому предлагается новая парадигма генерации данных — «Аннотировать кого угодно» — как непрерывный процесс генерации данных для создания высококачественных данных посредством экономичного аннотирования. На основе этого был создан набор данных CosmicMan-HQ 1.0, который содержит 6 миллионов высококачественных реальных изображений человеческого тела со средним разрешением 1488×1255 и снабжен точными текстовыми аннотациями из 115 миллионов атрибутов, охватывающих разные уровни.

(2) Базовая модель преобразования текста в изображение, специально разработанная для создания изображений человеческого тела, должна быть практичной, легко интегрируемой в последующие задачи и в то же время эффективной для создания высококачественных изображений человеческого тела. Поэтому предлагается моделировать взаимосвязь между плотным текстовым описанием и пикселями изображения в разложенном виде, а также предлагается структура обучения «Разложение-перефокусировка внимания (Смелость)». Он плавно разлагает функции перекрестного внимания в существующих моделях диффузии текста в изображение и обеспечивает настройку фокуса внимания без добавления дополнительных модулей. С помощью Daring мы показываем, что явная дискретизация непрерывного текстового пространства на несколько основных групп, соответствующих структуре человеческого тела, является ключом к легкому решению проблем смещения. https://cosmicman-cvpr2024.github.io/

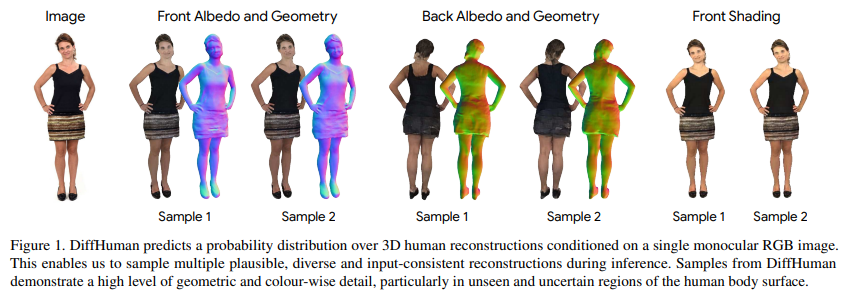

29、DiffHuman: Probabilistic Photorealistic 3D Reconstruction of Humans

Мы предлагаем DiffHuman — метод реалистичной реконструкции человеческого тела по одному RGB-изображению. Эта проблема по своей сути неразрешима, и большинство методов являются детерминистическими и выдают единственное решение, что часто приводит к появлению невидимых или неопределенных областей с отсутствием геометрических деталей и размытием. DiffHuman прогнозирует распределение вероятностей при условии 3D-реконструкции на основе входного 2D-изображения, которое может отбирать несколько подробных 3D-персонажей, соответствующих входному изображению.

DiffHuman реализован как модель условной диффузии для шумоподавления 2D-наблюдений с выравниванием по пикселям и выборки 3D-персонажей путем итеративного шумоподавления 2D-рендеринга прогнозируемых 3D-представлений. Кроме того, введена нейронная сеть-генератор, позволяющая значительно сократить время работы (ускорение в 55 раз), тем самым реализуя новую структуру диффузии с двумя ветвями.

Результаты экспериментов показывают, что DiffHuman способен выдавать разнообразные и подробные результаты реконструкции невидимых или неопределенных частей тела человека на входном изображении, при этом конкурируя с современными методами реконструкции видимых поверхностей.

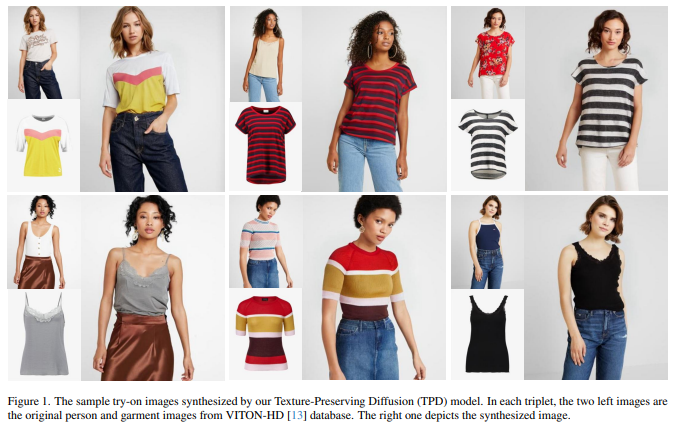

30、Texture-Preserving Diffusion Models for High-Fidelity Virtual Try-On

Виртуальная примерка изображений становится все более важной для онлайн-шоппинга. Цель состоит в том, чтобы синтезировать образ указанного человека в указанной одежде. Методы, основанные на моделях диффузии, в последнее время стали популярными благодаря их превосходной эффективности в задачах синтеза изображений. Однако эти методы обычно используют дополнительные кодеры изображений и полагаются на передачу текстуры с одежды на изображения человека через механизмы внимания, что влияет на эффективность и точность подгонки.

Для решения этих проблем предлагается модель диффузии с сохранением текстуры (TPD) для виртуальной примерки, чтобы повысить точность результатов без введения дополнительного кодировщика изображений. Итак, внесите свой вклад двумя способами. Во-первых, изображения человека в маске и эталонной одежды объединяются по пространственному измерению, а выходное изображение UNet с шумоподавлением генеративной модели используется в качестве входных данных. Это позволяет исходному слою самообслуживания в модели диффузии добиться эффективной и точной передачи текстуры. Во-вторых, предлагается метод, основанный на диффузии, для прогнозирования точной ремонтной маски на основе портретных и эталонных изображений одежды, чтобы еще больше повысить надежность результатов примерки. Кроме того, предсказание маски и синтез изображений интегрированы в компактную модель.

Результаты экспериментов показывают, что метод можно применять для решения различных задач по подгонке, таких как подгонка одежды к персонажам и подгонка между персонажами, и значительно превосходит существующие методы в популярных базах данных VITON, VITON-HD.

5. Супер оценка изображения

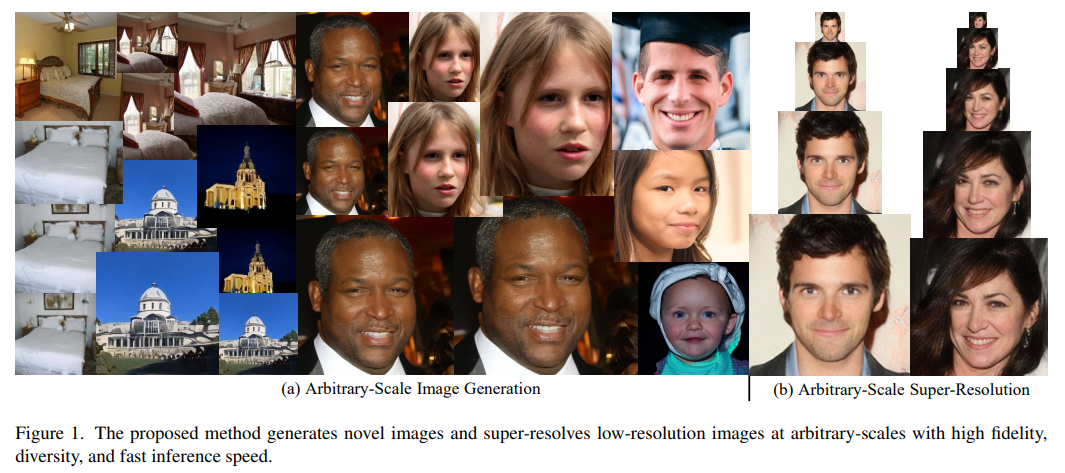

31、Arbitrary-Scale Image Generation and Upsampling using Latent Diffusion Model and Implicit Neural Decoder

Суперразрешение (SR) и генерация изображений являются важными задачами компьютерного зрения и широко применяются в реальных приложениях. Однако большинство существующих методов генерируют изображения только с фиксированным увеличением и склонны к чрезмерному сглаживанию и артефактам. Кроме того, существуют недостатки в разнообразии выходных изображений и согласованности в разных масштабах. В большинстве связанных работ неявные нейронные представления (INR) применяются к моделям шумоподавления диффузии для получения разнообразных и высококачественных результатов СР при непрерывном разрешении. Поскольку модель работает в пространстве изображений, для создания изображений с более высоким разрешением требуется больше памяти и времени вывода, и она не может поддерживать согласованность в зависимости от масштаба.

В этой статье предлагается новый конвейер для сверхразрешения входных изображений в произвольных масштабах или создания новых изображений из случайного шума. Метод состоит из предварительно обученного автокодировщика, модели скрытой диффузии и неявного нейронного декодера, а также их стратегий обучения. Этот метод использует процесс диффузии в скрытом пространстве и, следовательно, эффективен и остается согласованным с пространством выходного изображения, декодируемым MLP, в любом масштабе. Более конкретно, декодер произвольного масштаба объединяется предварительно обученным симметричным декодером без повышения дискретизации автокодировщика и локальной неявной функцией изображения (LIIF). Совместное изучение скрытых процессов диффузии посредством шумоподавления и потерь выравнивания. Ошибки в выходном изображении распространяются обратно через фиксированный декодер для улучшения качества вывода.

Благодаря обширным экспериментам с использованием нескольких общедоступных тестов для решения двух задач, включая сверхразрешение изображений и генерацию новых изображений в произвольных масштабах, этот метод превосходит аналогичные методы по таким показателям, как качество изображения, разнообразие и согласованность масштаба. Это значительно лучше, чем аналогичные предыдущие методы с точки зрения скорости вывода и использования памяти.

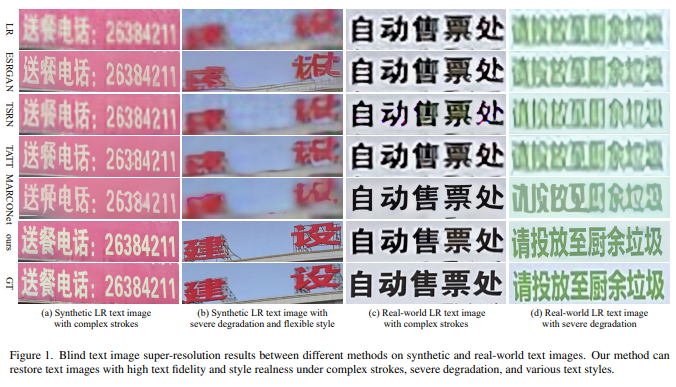

32、Diffusion-based Blind Text Image Super-Resolution

Восстановление испорченных текстовых изображений с низким разрешением — сложная задача, особенно при работе с текстовыми изображениями на китайском языке со сложными штрихами и серьезной деградацией в реалистичных сложных ситуациях. Гарантия точности текста и аутентичности стиля очень важна для высококачественного текстового изображения со сверхвысоким разрешением. В последнее время диффузионные модели добились успеха в синтезе и восстановлении естественных изображений благодаря своим мощным возможностям моделирования распределения данных и возможностям генерации данных.

В этой работе предлагается метод восстановления текстовых изображений, основанный на модели распространения изображений (IDM), который может восстанавливать текстовые изображения с реалистичными стилями. Для диффузионных моделей они подходят не только для моделирования распределения реальных изображений, но и для изучения распределения текста. Поскольку априоры текста очень важны для обеспечения правильности восстановленной текстовой структуры на основе существующих произведений искусства, для распознавания текста также предлагается модель распространения текста (TDM), которая может помочь IDM генерировать текстовые изображения с правильной структурой. Также предлагается мультимодальный гибридный модуль (MoM), позволяющий этим двум моделям диффузии взаимодействовать друг с другом на всех этапах диффузии.

Обширные эксперименты на синтетических и реальных наборах данных показывают, что сверхразрешение изображений слепого текста на основе диффузии (DiffTSR) может одновременно восстанавливать текстовые изображения с более точной текстовой структурой и более реалистичным внешним видом.

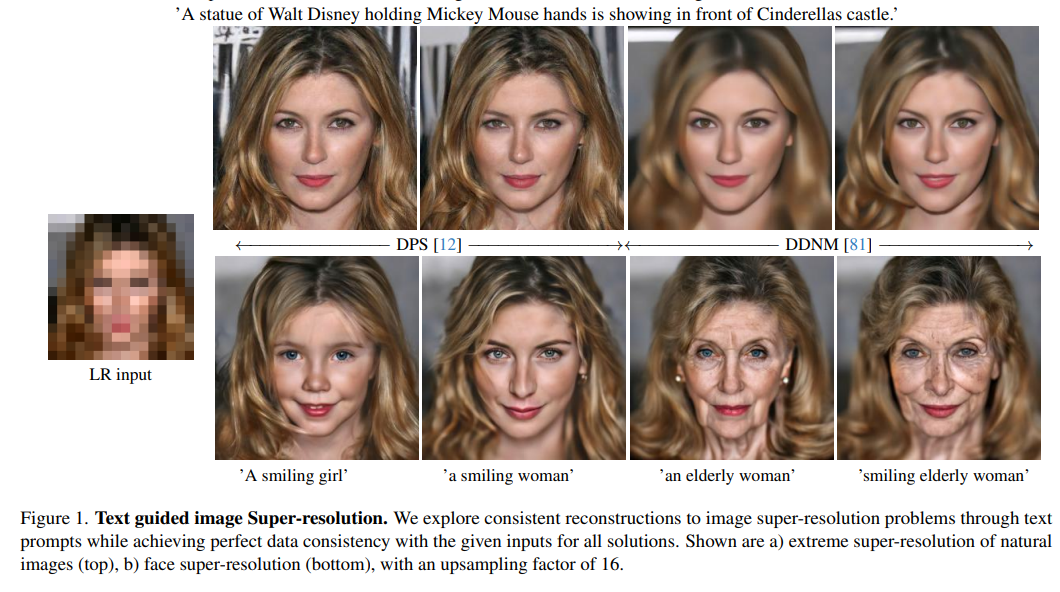

33、Text-guided Explorable Image Super-resolution

В этой статье рассматривается проблема создания решений сверхразрешения для изображений в открытой области с нулевым кадром и текстовым управлением. Цель состоит в том, чтобы позволить пользователям исследовать различные семантически точные реконструкции, которые остаются совместимыми с входными данными с низким разрешением, без явного обучения этим конкретным ухудшениям.

Предлагаются два метода суперразрешения с нулевым управлением текстом: один заключается в изменении процесса генерации модели диффузии текста в изображение (T2I) для обеспечения согласованности с входными данными с низким разрешением, а другой заключается в включении языкового руководства. в метод диффузионного восстановления с нулевым выстрелом. Мы показываем, что эти методы дают разнообразные решения, которые соответствуют семантическому значению, обеспечиваемому текстовыми подсказками, и поддерживают согласованность данных с ухудшенными входными данными. Оценивается производительность предложенного базового метода для задач с экстремальным сверхвысоким разрешением и демонстрируются преимущества с точки зрения качества восстановления, разнообразия и возможности исследования решения.

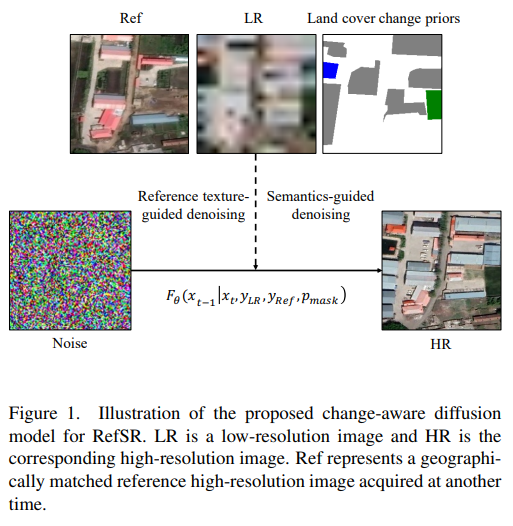

34、Building Bridges across Spatial and Temporal Resolutions: Reference-Based Super-Resolution via Change Priors and Conditional Diffusion Model

Сверхразрешение на основе эталонов (RefSR) может построить мост между пространственным и временным разрешением изображений дистанционного зондирования. Однако существующие методы RefSR ограничены точностью реконструкции контента и эффективностью передачи текстур при больших масштабных факторах. Модели условной диффузии открывают новые возможности для создания реалистичных изображений с высоким разрешением, но эффективное использование эталонных изображений в этих моделях остается областью для дальнейших исследований. Кроме того, точность содержания трудно гарантировать в тех областях, где нет соответствующей справочной информации.

Для решения этих проблем предлагается диффузионная модель с учетом изменений под названием Ref-Diff для RefSR, которая использует априорные изменения земного покрова для явного управления процессом шумоподавления. В частности, априорные значения вводятся в модель шумоподавления, чтобы улучшить использование справочной информации в неизмененных регионах и стандартизировать реконструкцию семантически релевантного контента в измененных регионах. Благодаря этому мощному руководству процессы шумоподавления на основе семантики и шумоподавления на основе эталонной текстуры разделены, что повышает производительность модели.

Эксперименты показывают, что предлагаемый метод обладает превосходной эффективностью и надежностью как в количественных, так и в качественных оценках по сравнению с современными методами RefSR. https://github.com/dongrunmin/RefDiff

6. Восстановление изображения

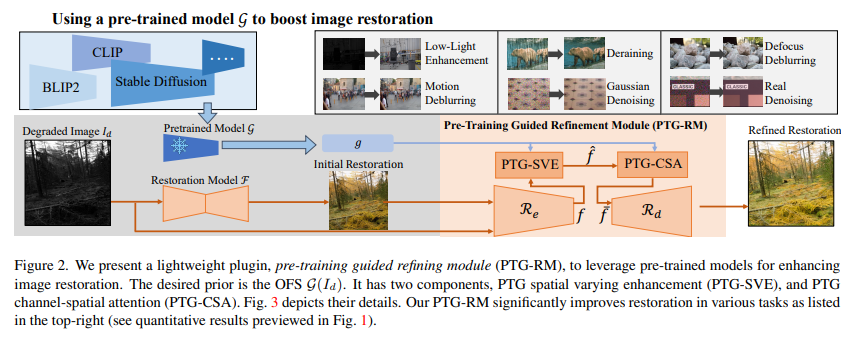

35、Boosting Image Restoration via Priors from Pre-trained Models

Предварительно обученные модели с использованием крупномасштабных обучающих данных, представленных CLIP и стабильной диффузией, демонстрируют значительную эффективность в понимании и создании изображений на основе языковых описаний. Однако их потенциал в задачах низкого уровня, таких как восстановление изображений, относительно недостаточно изучен. В этой статье рассматриваются эти модели для улучшения восстановления изображений.

Поскольку готовые функции (OSF) предварительно обученной модели не могут быть напрямую использованы для восстановления изображений, для обучения предлагается дополнительный облегченный модуль — Pre-Train-Guided Refinement Module (PTG-RM). улучшение результатов восстановления целевой сети восстановления посредством OSF. PTG-RM состоит из двух компонентов: пространственно-изменяющегося улучшения с предварительным обучением (PTG-SVE) и пространственно-пространственного внимания с предварительным обучением (PTG). PTG-SVE обеспечивает оптимальные нейронные манипуляции на коротких и дальних дистанциях, а PTG-CSA усиливает внимание к пространственным каналам, связанное с восстановлением.

Эксперименты доказали, что PTG-RM благодаря своему компактному объему (менее 1M параметров) эффективно повышает эффективность восстановления различных моделей при выполнении различных задач, включая улучшение качества при слабом освещении, удаление дождя, устранение размытия и шумоподавление.

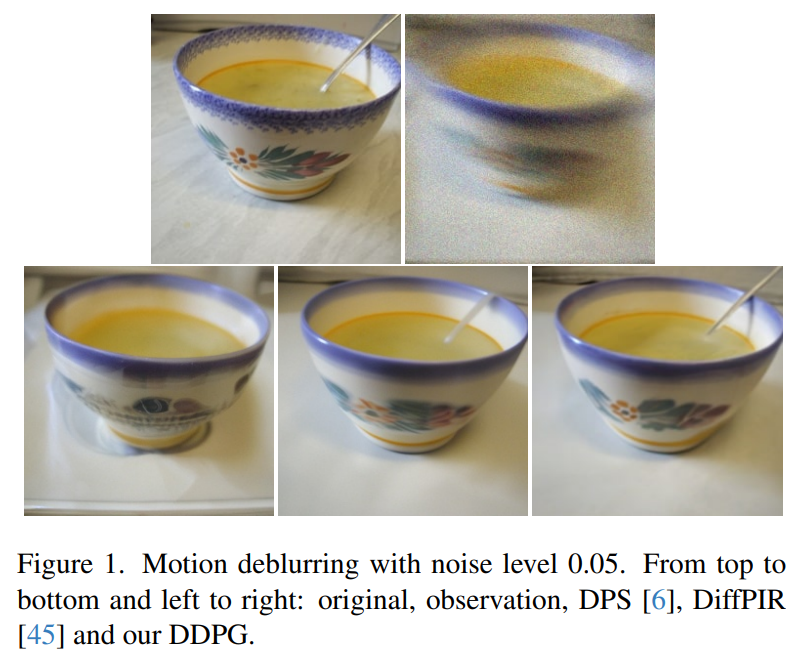

36、Image Restoration by Denoising Diffusion Models with Iteratively Preconditioned Guidance

Обучение глубоких нейронных сетей стало распространенным методом решения задач восстановления изображений. Альтернативой обучению сети, «специфичной для конкретной задачи» для каждой модели, является использование предварительно обученных глубоких шумоподавителей, чтобы вводить только априорные значения сигналов в итеративный алгоритм без дополнительного обучения. В последнее время варианты этого подхода, основанные на выборке, стали популярными с появлением генеративных моделей, основанных на диффузии/оценке.

В этом документе предлагается новый метод начальной загрузки, основанный на предварительной обработке, который может переходить от начальной загрузки на основе BP к начальной начальной загрузке на основе наименьших квадратов в процессе восстановления. Предлагаемый метод устойчив к шуму и его проще реализовать, чем альтернативные методы (например, не требует SVD или обширных итераций). Он применяется к схемам оптимизации и схемам, основанным на выборке, и демонстрируются его преимущества перед существующими методами устранения размытия изображения и сверхразрешения.

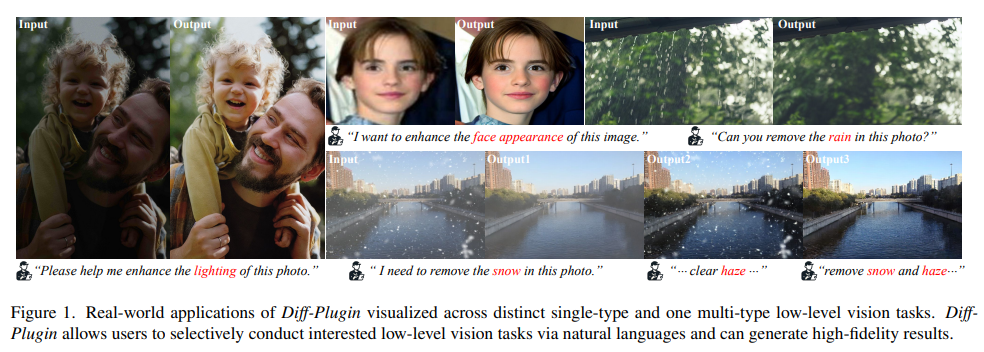

37、Diff-Plugin: Revitalizing Details for Diffusion-based Low-level Tasks

Замечательный прогресс в моделях диффузии, обученных на крупномасштабных наборах данных. Однако из-за стохастичности процесса распространения им часто сложно справиться с различными низкоуровневыми задачами, требующими сохранения деталей. Чтобы преодолеть это ограничение, мы предлагаем новую структуру Diff-Plugin, которая позволяет одной предварительно обученной модели диффузии генерировать высокоточные результаты в различных задачах низкого уровня.

В частности, впервые предлагается облегченный модуль Task-Plugin, который использует двухветвевую конструкцию для предоставления предварительных знаний по конкретной задаче для управления сохранением содержимого изображения в процессе распространения. Затем предлагается селектор плагинов, который может автоматически выбирать различные плагины задач в соответствии с текстовыми инструкциями, позволяя пользователям выполнять редактирование изображений нескольких задач низкого уровня с помощью инструкций на естественном языке.

Обширные экспериментальные результаты по восьми задачам низкоуровневого зрения показывают, что Diff-Plugin превосходит существующие методы в реальных сценариях. Эксперименты по абляции подтвердили стабильность, возможность планирования и надежные возможности обучения Diff-Plugin при различных размерах наборов данных. https://yuhaoliu7456.github.io/Diff-Plugin/

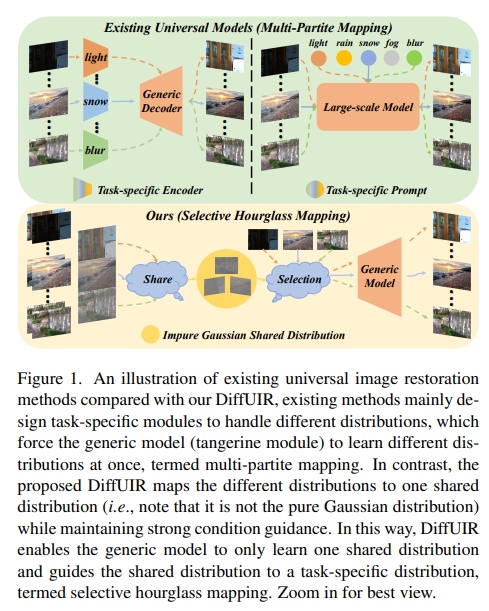

38、Selective Hourglass Mapping for Universal Image Restoration Based on Diffusion Model

Общее восстановление изображений — практическая и многообещающая задача компьютерного зрения, имеющая практическое применение. Основная задача этой задачи — одновременно обрабатывать различные распределения деградации. Существующие методы в основном используют условия, специфичные для конкретной задачи (например, сигналы), чтобы направить модель на индивидуальное изучение различных распределений, что называется многочастным сопоставлением. Однако этот подход не подходит для общего обучения моделей, поскольку он игнорирует общую информацию между различными задачами.

В этой работе предлагается усовершенствованная стратегия выборочного картирования песочных часов под названием DiffUIR, основанная на модели диффузии. У DiffUIR есть два новых соображения. Во-первых, обеспечьте модели мощное условное руководство, чтобы получить точное направление генерации диффузионной модели (селективность). Что еще более важно, DiffUIR умело интегрирует гибкий термин общего распределения (SDT) в алгоритм распространения, постепенно отображая различные распределения в общее распределение. В обратном процессе, в сочетании с SDT и мощным условным руководством, DiffUIR итеративно направляет общее распределение к распределению для конкретной задачи (песочные часы) с высоким качеством изображения.

Изменяя только стратегию картографии, достигается высочайшая производительность при выполнении пяти задач восстановления изображений, 22 эталонных наборов данных с универсальной настройкой и настройкой генерализации с нулевым выстрелом. Удивительно, но отличные характеристики достигаются только с помощью облегченной модели (всего 0,89М). https://github.com/iSEE-Laboratory/DiffUIR

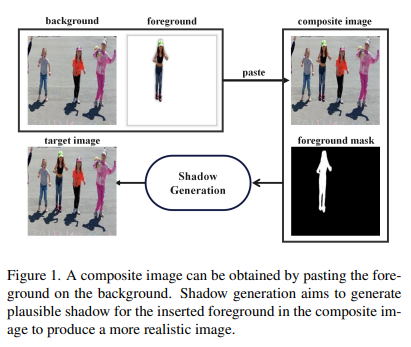

39、Shadow Generation for Composite Image Using Diffusion Model

В области композиции изображений создание реалистичных теней для вставленного переднего плана остается огромной проблемой. В предыдущих исследованиях были разработаны модели, основанные на преобразованиях между изображениями, которые обучаются на парах обучающих данных. Однако они сталкиваются с трудностями при создании теней точной формы и интенсивности из-за нехватки данных и сложности самой задачи.

В этой статье используется базовая модель с богатыми предварительными знаниями об изображениях естественных теней. В частности, сначала под задачу адаптируется ControlNet, а затем предлагается модуль модуляции интенсивности для увеличения интенсивности теней. Кроме того, был использован новый конвейер сбора данных для расширения небольшого набора данных DESOBA до DESOBAv2. Экспериментальные результаты на наборах данных DESOBA и DESOBAv2, а также реальные синтетические изображения показывают, что модель обладает более сильными возможностями в задаче генерации теней. https://github.com/bcmi/Object-Shadow-Generation-Dataset-DESOBAv2

7. Отслеживание цели

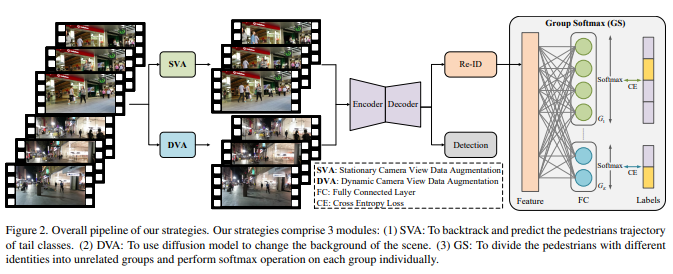

40、Delving into the Trajectory Long-tail Distribution for Muti-object Tracking

Отслеживание нескольких объектов (MOT) является ключевой областью в области компьютерного зрения и имеет широкое применение. Текущие исследования сосредоточены на разработке алгоритмов отслеживания и совершенствовании методов постобработки. Однако глубоких исследований характеристик самих данных отслеживания не хватает.

В этом исследовании впервые изучается структура распределения данных отслеживания и обнаруживается, что в существующем наборе данных MOT существует очевидная проблема распределения с длинным хвостом. Установлено, что существует существенный дисбаланс в распределении различных пешеходов, который получил название «длиннохвостое распределение пешеходных траекторий». Для решения этой проблемы предлагается стратегия, специально разработанная для смягчения последствий такого распределения. В частности, предлагаются две стратегии увеличения данных, включая увеличение статических данных обзора камеры (SVA) и динамическое увеличение данных обзора камеры (DVA) для состояний точки обзора, а также модуль Group Softmax (GS) для Re-ID. SVA предназначен для отслеживания и прогнозирования траекторий пешеходов для хвостовых категорий, в то время как DVA использует модель диффузии для изменения фона сцены. GS делит пешеходов на несвязанные группы и выполняет операцию softmax для каждой группы.

Эту стратегию можно интегрировать во многие существующие системы отслеживания, и эксперименты подтверждают эффективность метода в снижении влияния распределений с длинным хвостом на производительность отслеживания с несколькими целями. https://github.com/chen-si-jia/Trajectory-Long-tail-Distribution-for-MOT

8. Обнаружение цели

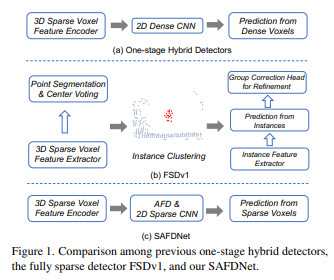

41、SAFDNet: A Simple and Effective Network for Fully Sparse 3D Object Detection

Обнаружение трехмерных объектов на основе LiDAR играет ключевую роль в автономном вождении. Существующие высокопроизводительные детекторы 3D-объектов обычно создают плотные карты объектов в магистральной сети и в головке прогнозирования. Однако по мере увеличения дальности обнаружения вычислительные затраты, связанные с плотными картами объектов, увеличиваются квадратично, что затрудняет расширение этих моделей для обнаружения на больших расстояниях. В некоторых недавних исследованиях предпринимались попытки создать полностью разреженные детекторы для решения этой проблемы, однако полученные модели либо полагаются на сложные многоступенчатые конвейеры, либо работают плохо.

В этой статье предлагается SAFDNet, которая является простой и эффективной и предназначена для обнаружения полностью разреженных трехмерных объектов. В SAFDNet стратегия адаптивного распространения функций предназначена для решения проблемы потери центральных функций. Обширные эксперименты с наборами данных Waymo Open, nuScenes и Argoverse2 доказывают, что SAFDNet работает немного лучше, чем предыдущий SOTA, на первых двух наборах данных, но лучше работает на последнем наборе данных с характеристиками обнаружения на больших расстояниях, проверка. Эффективность SAFDNet в сценариях, требующих больших расстояний. обнаружение.

В Argoverse2 SAFDNet в 2,1 раза быстрее, чем предыдущий лучший гибридный детектор HEDNet, и улучшает mAP на 2,1% по сравнению с предыдущим лучшим разреженным детектором FSDv2, который в 1,3 раза быстрее. https://github.com/zhanggang001/HEDNet

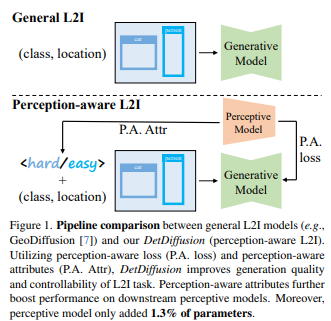

42、DetDiffusion: Synergizing Generative and Perceptive Models for Enhanced Data Generation and Perception

Современные модели восприятия в значительной степени полагаются на ресурсоемкие наборы данных и поэтому требуют инновационных решений. Используя последние достижения в области диффузионных моделей и синтетических данных, синтетические данные облегчают последующие задачи, создавая различные входные помеченные изображения. Хотя предыдущие методы решали проблему генеративных и перцептивных моделей отдельно, DetDiffusion является первым, кто интегрировал аспекты перцептивной модели для генерации достоверных данных.

Чтобы улучшить возможности генерации изображений в модели восприятия, вводятся потери восприятия (потери PA) для улучшения качества и управляемости за счет сегментации. Чтобы улучшить производительность конкретной модели восприятия, метод настраивает увеличение данных путем извлечения и использования атрибутов восприятия (P.A. Attr). Экспериментальные результаты задачи обнаружения объектов подчеркивают превосходную производительность DetDiffusion при генерации на основе макета, что значительно повышает производительность последующего обнаружения.

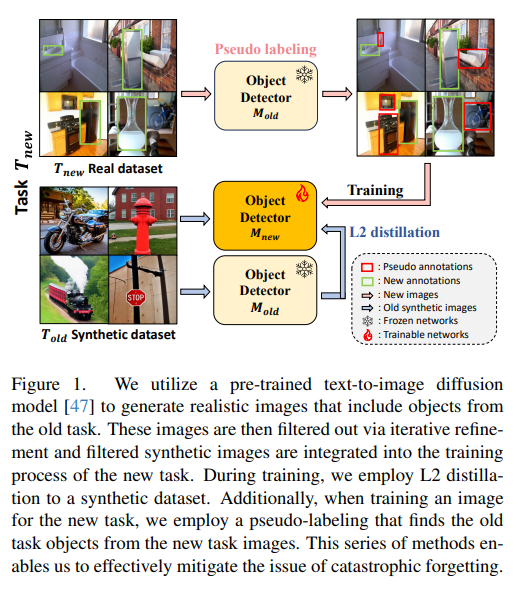

43、SDDGR: Stable Diffusion-based Deep Generative Replay for Class Incremental Object Detection

В области поэтапного обучения (CIL) генеративное воспроизведение стало методом облегчения катастрофического забывания и привлекает все больше и больше внимания по мере совершенствования генеративных моделей. Однако его применение при обнаружении дополнительных объектов по категориям (CIOD) сильно ограничено, главным образом из-за сложности сценариев, включающих несколько меток.

В этой статье предлагается новый метод CIOD, называемый стабильным диффузионным глубоким генеративным воспроизведением (SDDGR). В этом методе используется генеративная модель, основанная на диффузии, в сочетании с предварительно обученной сетью преобразования текста в диффузию для создания реалистичных и разнообразных синтетических изображений. SDDGR использует стратегию итеративной оптимизации для создания высококачественных образцов старых категорий. Кроме того, используется технология дистилляции знаний L2 для улучшения сохранения предыдущих знаний в синтезированных изображениях. Кроме того, метод включает псевдомаркировку старых объектов в новых изображениях задач, чтобы предотвратить их ошибочную классификацию как фоновые элементы.

Обширные эксперименты на наборе данных COCO 2017 показывают, что SDDGR значительно превосходит существующие алгоритмы в различных сценариях CIOD и выходит на новый технический уровень.

9. Обнаружение ключевых точек

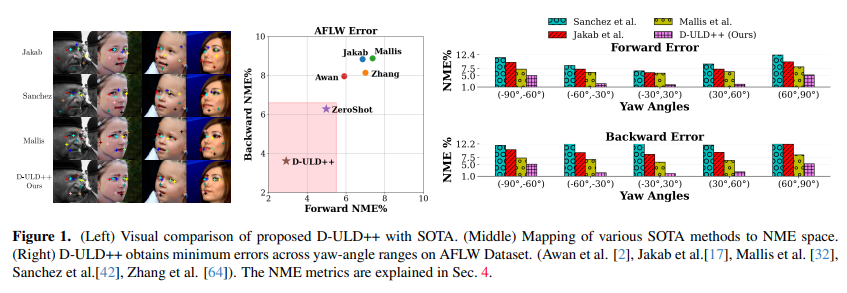

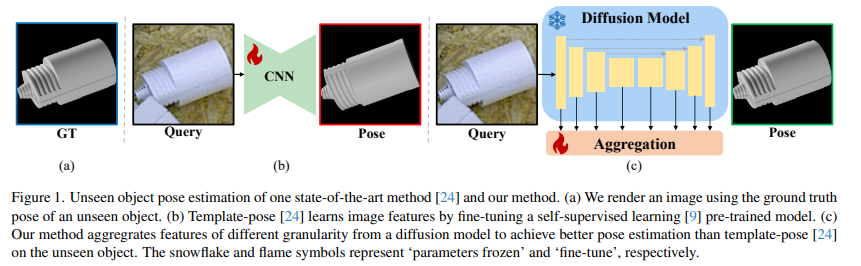

44、Pose-Guided Self-Training with Two-Stage Clustering for Unsupervised Landmark Discovery

Неконтролируемое обнаружение ориентиров (ULD) — сложная задача компьютерного зрения. Чтобы использовать потенциал моделей диффузии в задачах ULD, во-первых, предлагается базовая линия ULD с нулевым выстрелом, основанная на простой кластеризации случайных расположений пикселей, которая обеспечивает лучшие результаты, чем существующие методы ULD, за счет сопоставления ближайших соседей. Во-вторых, на основе нулевой производительности алгоритм ULD на основе диффузионных признаков разрабатывается посредством самообучения и кластеризации, что значительно превосходит предыдущие методы. В-третьих, представлена новая задача агента, основанная на генерации скрытых кодов положения, и предложен двухэтапный механизм кластеризации для облегчения эффективной генерации псевдометок, тем самым значительно улучшая производительность.

В целом, этот метод неизменно превосходит существующие современные методы в четырех сложных тестах (AFLW, MAFL, CatHeads и LS3D).

10. Обнаружение дипфейков

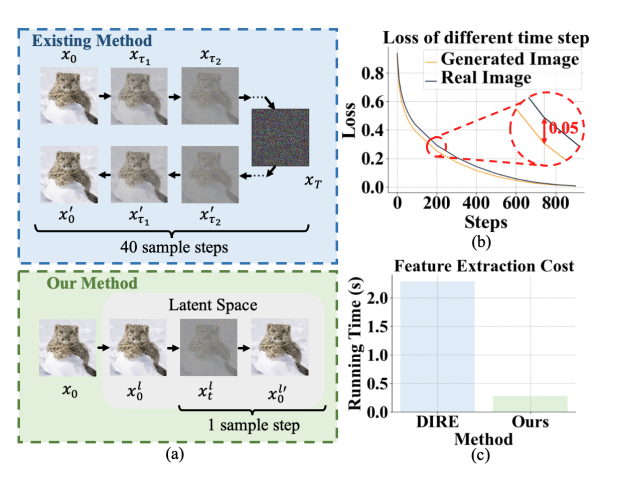

45、Latent Reconstruction Error Based Method for Diffusion-Generated Image Detection

Модели диффузии значительно улучшают качество генерации изображений, что затрудняет различие между реальными и сгенерированными изображениями. Однако это развитие также вызывает серьезные проблемы конфиденциальности и безопасности. Чтобы решить эту проблему, для обнаружения сгенерированных изображений предлагается новый метод оптимизации функций с учетом ошибок реконструкции скрытых переменных (скрытая функция REfinement с ошибками REconstruction, LaRE2).

Предлагается скрытая ошибка реконструкции (LaRE), функция скрытого пространства, основанная на ошибке реконструкции, для генерации обнаружения изображения. LaRE превосходит существующие методы по эффективности извлечения признаков, сохраняя при этом ключевые признаки, необходимые для того, чтобы отличить настоящие изображения от поддельных. Для использования LaRE предлагается метод с модулем оптимизации функций с учетом ошибок (EGRE), который управляет оптимизацией функций изображения с помощью LaRE для повышения различимости функций.

EGRE использует механизм выравнивания и последующего уточнения, который может эффективно уточнять характеристики изображения с пространственной и канальной точки зрения для генеративного обнаружения изображений. Обширные эксперименты с крупномасштабным тестом GenImage демонстрируют превосходство LaRE2, превосходя лучшие методы SoTA на 8 различных генераторах изображений со средним значением ACC/AP, достигающим 11,9%/12,1%. LaRE также превосходит существующие методы по стоимости извлечения признаков и работает в 8 раз быстрее.

11. Обнаружение аномалий

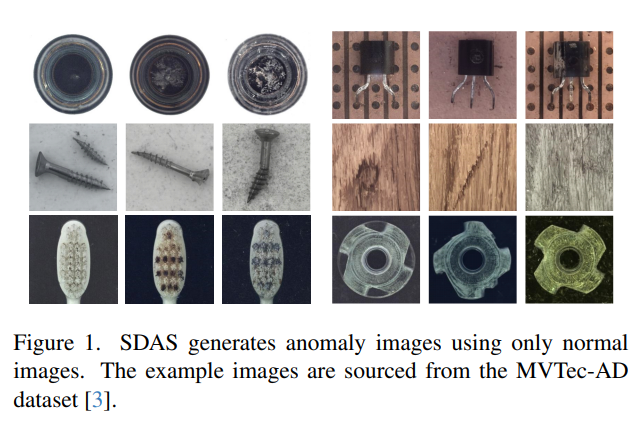

46、RealNet: A Feature Selection Network with Realistic Synthetic Anomaly for Anomaly Detection

Методы самостоятельной реконструкции объектов показывают многообещающий прогресс в обнаружении и локализации аномалий на промышленных изображениях. Эти методы по-прежнему сталкиваются с проблемами при синтезе реалистичных и разнообразных выборок аномалий и устранении избыточности функций и систематической ошибки предварительно обученных функций.

В этой работе предлагается RealNet, сеть реконструкции объектов с реалистичными синтетическими аномалиями и адаптивным выбором функций. Он содержит три ключевых нововведения: во-первых, он предлагает синтез диффузионных аномалий с контролируемой интенсивностью (SDAS), стратегию синтеза, основанную на процессе диффузии, которая может генерировать образцы с различной интенсивностью аномалий, имитируя распределение реальных образцов аномалий. Во-вторых, разрабатывается метод выбора признаков с учетом аномалий (AFS) — метод выбора репрезентативных и различительных предварительно обученных подмножеств признаков для повышения производительности обнаружения аномалий при одновременном контроле вычислительных затрат. В-третьих, представлен выбор остатков реконструкции (RRS) — стратегия, которая адаптивно выбирает дискриминационные остатки для всестороннего выявления аномальных областей на нескольких уровнях детализации.

RealNet оценивается на четырех эталонных наборах данных, и результаты показывают улучшения как в AUROC изображения, так и в пиксельном AUROC по сравнению с современными методами. https://github.com/cnulab/RealNet

12. Вырез/сегментация

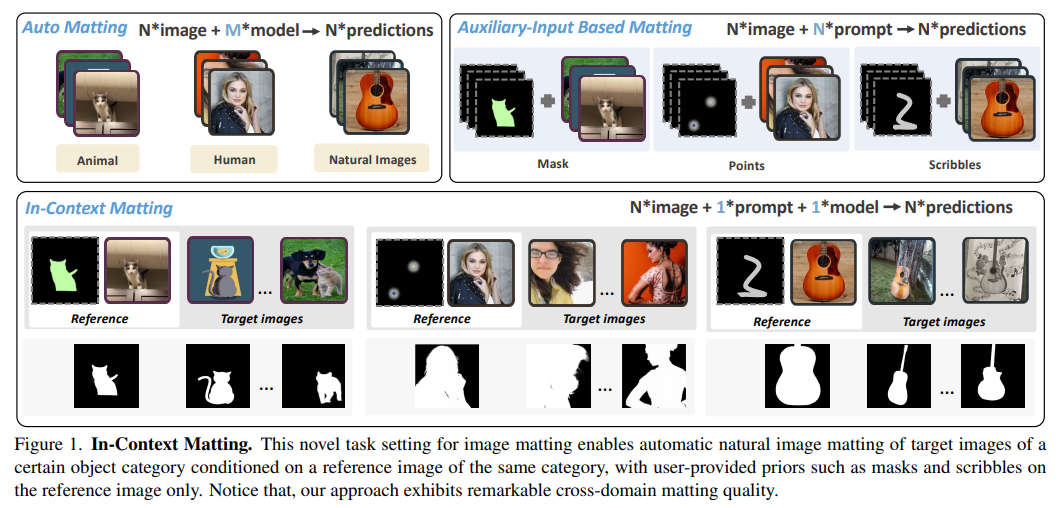

47、In-Context Matting

Предложите In-Context Matting — новую постановку задач по матированию изображений. Учитывая определенное эталонное изображение переднего плана и управляемые априорные значения, такие как точки, граффити и маски, контекстное сопоставление позволяет автоматически оценивать альфа-канал для пакета целевых изображений с одной и той же категорией переднего плана без дополнительных вспомогательных входных данных. Этот параметр хорошо работает при матировании на основе вспомогательных входных данных и обеспечивает хороший баланс между простотой использования автоматического матирования.

Чтобы решить проблему точного сопоставления переднего плана, введена IconMatting — модель контекстного матирования, построенная на предварительно обученной модели диффузии текста в изображение. Вводя внутреннее и внешнее сопоставление по сходству, IconMatting может полностью использовать ссылочный контекст для создания точных целевых альфа-подложек. Для сравнения этой задачи также представлен новый набор тестовых данных ICM-57, включающий 57 наборов реальных изображений. https://github.com/tiny-smart/in-context-matting/tree/master

13. Сжатие изображения

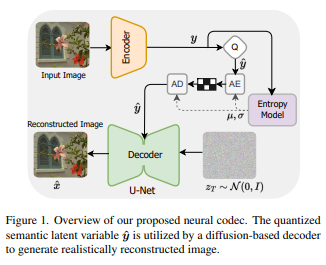

48、Laplacian-guided Entropy Model in Neural Codec with Blur-dissipated Synthesis

Замена гауссовых декодеров моделями условной диффузии может повысить качество восприятия реконструированных изображений при нейронном сжатии изображений, но отсутствие индуктивного смещения в данных изображения ограничивает их способность достигать современных уровней восприятия.

Чтобы устранить это ограничение, на стороне декодера используется модель неизотропной диффузии. Модель накладывает индуктивный сдвиг на различение частотного содержания, тем самым облегчая генерацию высококачественных изображений. Он также оснащен новой энтропийной моделью, которая ускоряет этап энтропийного декодирования за счет использования корреляций пространственных каналов в скрытом пространстве для точного моделирования распределения вероятностей скрытого представления. Эта энтропийная модель на основе каналов использует локальный и глобальный пространственный контекст внутри каждого блока канала. Глобальный пространственный контекст построен на основе Transformer и специально используется для задач сжатия изображений. Разработанный преобразователь использует кодирование положения в форме Лапласа, а его обучаемые параметры адаптивно настраиваются в соответствии с каждым кластером каналов.

Эксперименты показывают, что эта структура способна обеспечить лучшее качество восприятия и что предлагаемая энтропийная модель приводит к значительной экономии битрейта.

14. Понимание видео

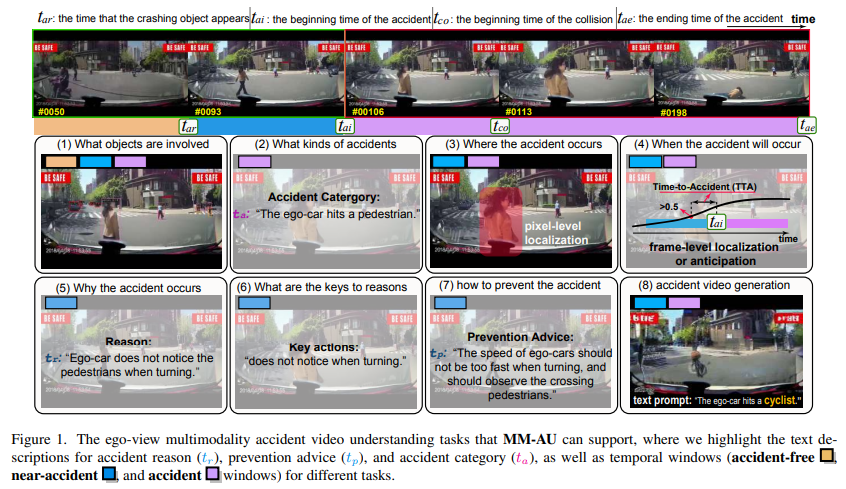

49、Abductive Ego-View Accident Video Understanding for Safe Driving Perception

Предлагается новый набор данных для мультимодального понимания видео происшествий MM-AU (Понимание мультимодального видео происшествий). MM-AU содержит 11 727 видео происшествий с эго-видом в естественных сценах, каждое из которых снабжено текстовым описанием, синхронизированным по времени. Аннотировано более 2,23 миллиона кадров объектов и 58 650 пар видео причин происшествий, охватывающих 58 категорий происшествий. MM-AU поддерживает различные задачи по анализу аварий, особенно понимание причинно-следственных цепочек аварий для безопасного вождения посредством мультимодального распространения видео.

С использованием MM-AU предлагается система понимания видео с абдуктивными авариями для восприятия безопасного вождения (AdVersa-SD). AdVersa-SD — метод объектно-центрической диффузии видео (OAVD), основанный на модели CLIP. Модель включает в себя изучение контрастных потерь взаимодействия между нормальными, предаварийными и аварийными кадрами и соответствующими текстовыми описаниями, такими как причины аварий, рекомендации по предотвращению и категории аварий. OAVD обеспечивает изучение причинно-следственных связей при создании видео, одновременно фиксируя содержимое фона исходного кадра при создании видео, чтобы найти основные причинно-следственные цепочки определенных происшествий.

Эксперименты демонстрируют возможности вывода AdVersa-SD и преимущества OAVD перед современными диффузионными моделями. Кроме того, были тщательно проверены обнаружение объектов и реагирование на причины происшествий, поскольку AdVersa-SD полагается на точную информацию об объектах и причинах происшествий. http://www.lotvsmmau.net/

15. Генерация видео

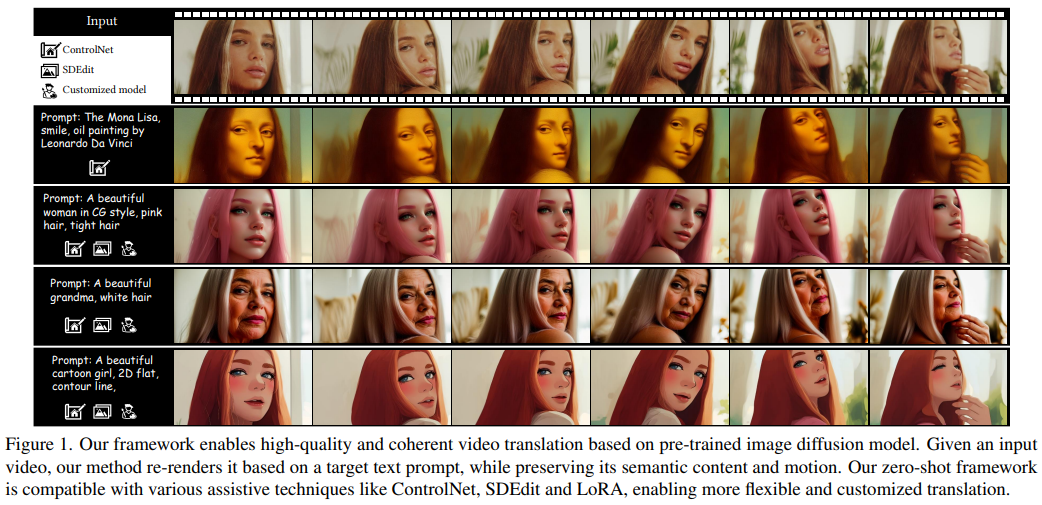

50、FRESCO: Spatial-Temporal Correspondence for Zero-Shot Video Translation

Модели диффузии текста в изображение вдохновляют на исследование их потенциальных приложений в видеосфере. Методы нулевого кадра расширяют модели диффузии изображений на видеообласть, не требуя обучения модели. Последние методы в основном сосредоточены на включении межкадрового соответствия в механизмы внимания. Однако мягкие ограничения, определяющие, на чем следует сосредоточиться на действительных функциях, иногда могут быть недостаточными, что приводит к временным несоответствиям.

В этой статье предлагается FRESCO, которая сочетает внутрикадровую и межкадровую корреспонденцию для установления более мощных пространственно-временных ограничений. Это улучшение гарантирует, что между кадрами сохраняются согласованные переходы с семантически схожим содержимым. Помимо управления вниманием, метод также включает явное обновление функций для достижения высокой пространственно-временной согласованности с входным видео, тем самым значительно улучшая визуальную связность сгенерированного видео.

Эксперименты демонстрируют эффективность предлагаемой структуры в создании высококачественных связных видеороликов, что обеспечивает значительные улучшения по сравнению с существующими методами нулевого кадра.

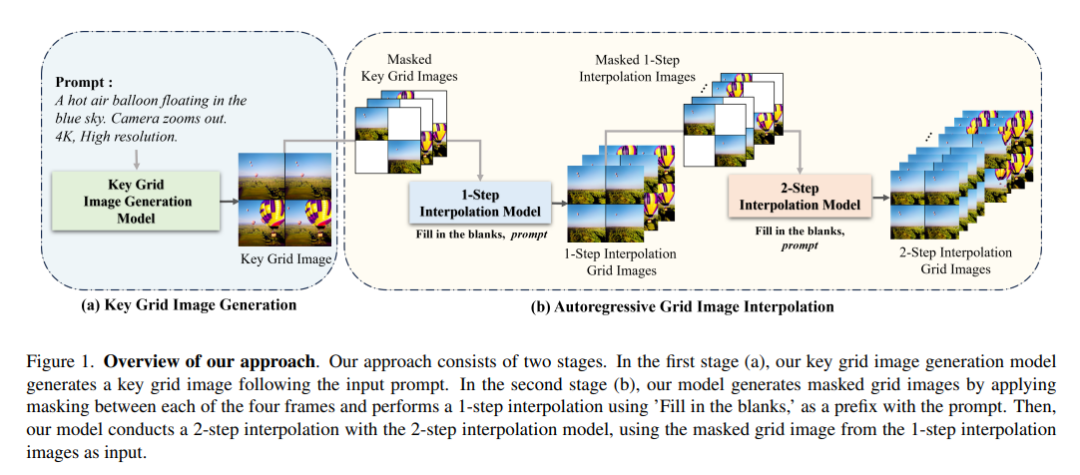

51、Grid Diffusion Models for Text-to-Video Generation

Создание видео из текста является более сложной задачей, чем создание изображений из текста, поскольку для этого требуются большие наборы данных и более высокие вычислительные затраты. Большинство существующих методов генерации видео используют 3D-архитектуру U-Net или авторегрессионную генерацию, учитывающую временное измерение. По сравнению с генерацией текста в изображение, эти методы требуют больших наборов данных и ограничены с точки зрения вычислительных затрат.

Для решения этих проблем предлагается простой и эффективный новый метод генерации текста в видео, который не учитывает временное измерение в архитектуре и требует большого набора парных данных «текст-видео». Высококачественное видео можно генерировать, используя фиксированный объем памяти графического процессора, независимо от количества кадров, представляя видео в виде изображения сетки. Кроме того, поскольку этот метод уменьшает размерность видео до размерности изображения, к видео можно применять различные методы на основе изображений, такие как манипулирование видео с помощью текста из манипулирования изображением. Этот метод превосходит существующие методы как в количественных, так и в качественных оценках, демонстрируя, что модель подходит для практической генерации видео.

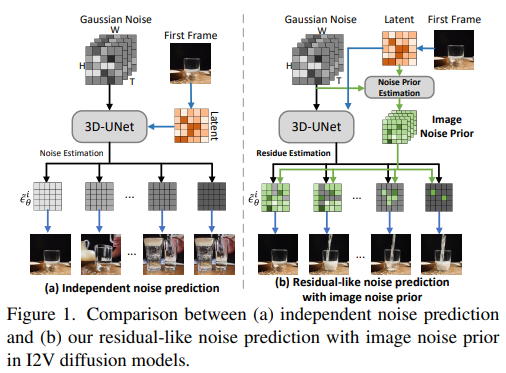

52、TRIP: Temporal Residual Learning with Image Noise Prior for Image-to-Video Diffusion Models

Применение моделей диффузии для преобразования статических изображений в динамические (т. е. генерация изображения в видео) является нетривиальной задачей. Трудность заключается в том, что процесс распространения сгенерированных последовательных кадров анимации должен не только поддерживать соответствие данному изображению, но также обеспечивать временную когерентность между соседними кадрами.

Чтобы облегчить эту проблему, предлагается TRIP, новый метод, основанный на парадигме диффузии изображения в видео, основанной на априорном уровне шума изображения. Априорный шум изображения получается из статических изображений посредством одноэтапного процесса обратной диффузии на основе статических изображений и скрытых видеокодов с шумом. Затем TRIP выполняет двухпроходную схему, аналогичную остаточной для прогнозирования шума: 1) кратчайший путь напрямую использует шум изображения в качестве эталонного шума для каждого кадра, чтобы улучшить согласованность между первым кадром и последующими кадрами; 2) остаточный; В разностных путях используется 3D-UNet для изучения скрытых кодов зашумленных видео и неподвижных изображений, чтобы обеспечить возможность межкадрового реляционного анализа, тем самым уменьшая остаточный шум, полученный для каждого кадра. Кроме того, опорный шум и остаточный шум каждого кадра динамически объединяются с помощью механизма внимания для окончательного создания видео.

Обширные эксперименты с наборами данных WebVid-10M, DTDB и MSRVTT демонстрируют эффективность TRIP для создания изображения в видео. https://trip-i2v.github.io/TRIP/

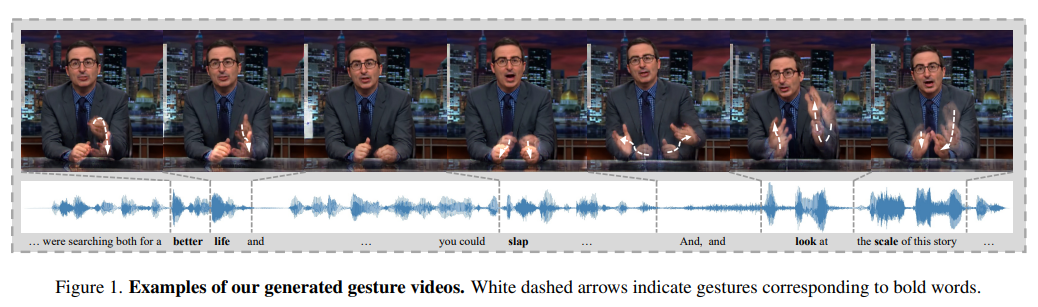

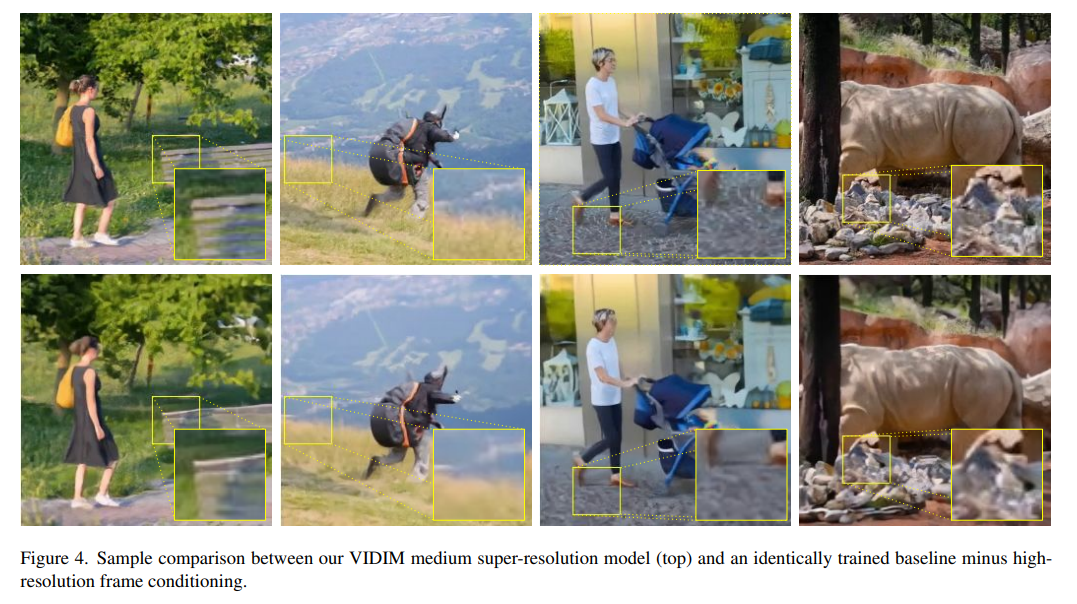

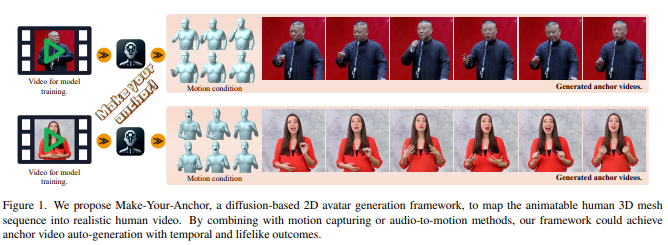

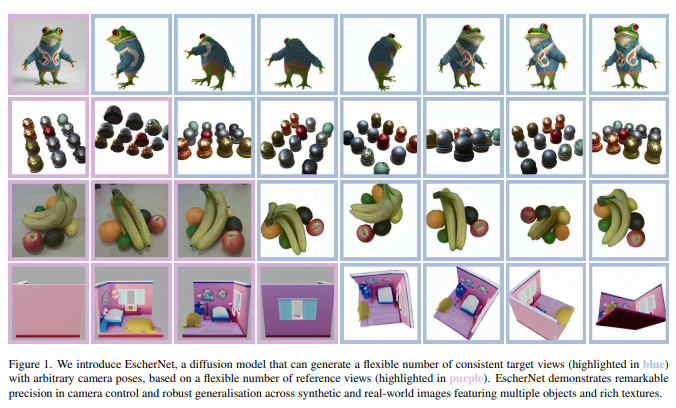

53、Co-Speech Gesture Video Generation via Motion-Decoupled Diffusion Model