Трансформаторы 4.37 Китайская документация (12)

оригинальный:

huggingface.co/docs/transformers

🤗 На что способны Трансформеры

Исходная ссылка:

huggingface.co/docs/transformers/v4.37.2/en/task_summary

🤗 Transformers даодининдивидуальныйпредварительнотренироватьсяизсамый продвинутый Модель Библиотека,используется дляобработка естественного языка(NLP)、компьютерное зрение и обработка голоса Задача. Эта индивидуальная библиотека Нет содержит только Transformer Модель,возвращатьсяиметькартинасовременный Сверточная сеть это не тот случай Transformer Модель,для компьютерного зрения Задача. есливзглянем на самые популярные сегодня потребительские товары,Например, смартфоны, приложения и телевизоры.,Вполне вероятно, что за этим стоит какая-то технология глубокого обучения. Хотите удалить фоновые объекты с фотографий, сделанных на смартфон? Это пример панорамной сегментации (если что вы об этом знаете?,Нет смысла волноваться,Мы будем существовать, описанные в следующем из раздела! ).

На этой странице представлена информация о 🤗 Transformers Библиотека может использовать три строки кода для решения задачи из Нет с одинаковым произношением и Аудио и компьютерное. зрениеи NLP Обзор миссии!

Аудио

Аудиои Обработка речи Проблемы Другие модальности и меть Некоторые Нет то же самое,Главным образом потому, что для Аудио для ввода отдельного непрерывного сигнала. iTextNet То же самое,оригинальная аудио форма волны Нет изображения, предложения можно разделить так же аккуратно, как и слова. для решения этой индивидуальной проблемы,Оригинальные аудиосигналы обычно сэмплируются через равные промежутки времени. Возьмите больше образцов в течение интервала,Частота выборки выше,Аудиоближеоригинальный Аудиоисточник。

Предыдущий метод предварительной обработки аудио,Иметь извлекается из использования функций. Сейчас более распространенным является метод прямого ввода исходной формы аудиосигнала в кодировщик функций.,Представлено извлечением аудио,Запустить обработку аудио голоса. Задача. Это упрощает этап предварительной обработки.,И позволяет Модели изучить наиболее важные функции.

Классификация аудио

Классификация аудиодаодининдивидуальныйотпредварительноопределениекатегорияконцентрированныйдля Аудио Данные помеченыиз Задача。этотдаодининдивидуальныйширокоизкатегория,Иметь множество конкретных приложений,Некоторые из них включают в себя:

- Классификация акустических сцен: для Аудио Этикетки сцен («Офис», «Пляж», «Стадион»)

- Обнаружение акустических событий: для Аудио маркирует звуковые события («гудок автомобиля», «зов кита», «разбивание стекла»)

- С тегами: для содержит несколько индивидуальных звуков из Аудио с тегами (пение птиц, встреча из идентификации говорящего)

- Классификация музыки: Лейбл музыки с указанием жанра («Металл», «Хип-хоп», «Кантри»).

>>> from transformers import pipeline

>>> classifier = pipeline(task="audio-classification", model="superb/hubert-base-superb-er")

>>> preds = classifier("https://huggingface.co/datasets/Narsil/asr_dummy/resolve/main/mlk.flac")

>>> preds = [{"score": round(pred["score"], 4), "label": pred["label"]} for pred in preds]

>>> preds

[{'score': 0.4532, 'label': 'hap'},

{'score': 0.3622, 'label': 'sad'},

{'score': 0.0943, 'label': 'neu'},

{'score': 0.0903, 'label': 'ang'}]Автоматическое распознавание речи

Автоматическое распознавание речь (ASR) транскрибирует речь в текст. потому что что Речь да Естественная форма человеческого общения, она да одна из самых распространенных и з Аудио Задача. Сегодня АСР Системы встроены в «умные» технологические продукты, такие как динамики, сотовые телефоны и автомобили. Мы можем попросить виртуальных помощников включить музыку, установить напоминания и сообщить нам погоду.

Но одна из ключевых проблем, которую помогает решить архитектура Transformer, — это языки с низким уровнем ресурсов. Путем предварительного обучения на больших объемах речевых данных, а затем точной настройки всего лишь на час размеченных речевых данных на языке с низким уровнем ресурсов все еще возможно получить результаты высокого качества по сравнению с предыдущими системами ASR, обученными на в 100 раз большем количестве размеченных речевых данных. данные .

>>> from transformers import pipeline

>>> transcriber = pipeline(task="automatic-speech-recognition", model="openai/whisper-small")

>>> transcriber("https://huggingface.co/datasets/Narsil/asr_dummy/resolve/main/mlk.flac")

{'text': ' I have a dream that one day this nation will rise up and live out the true meaning of its creed.'}компьютерное зрение

Самый ранний успех изкомпьютерное зрение Задача Изодиндаиспользоватьсверточная нейронная сеть (CNN) идентифицирует номера почтовых индексов из картинакартина. Изображение изображения состоит из элементов изображения, каждый элемент отдельнойкартины имеет значение has. Это позволяет легко представить графическое изображение как матрицу простых значений для карты. Каждая комбинация простых значений описывает цвет изображения.

компьютерное зрение Задачу можно решить двумя основными способами:

- использовать свертку, чтобы изучить изображение графа из иерархических функций, из функций низкого уровня получить абстрактные вещи высокого уровня.

- Воля Сегментация изображенийв патч,ииспользовать Transformer Постепенно узнайте, как каждый отдельный патч изображения диаграммы связан друг с другом, образуя диаграмму изображения. и CNN Как и предпочтительный подход «снизу вверх», этот метод сначала размывает изображение рисунка, а затем постепенно фокусирует его.

Классификация изображений

Классификация коллекция изображенийот предопределенных категорий для всей индивидуальнойкартинаотметка.ибольшинство категоризация. Задача такая же, как и Классификация. изображенияиметь множество практических вариантов использования, некоторые из которых включают в себя:

- Здравоохранение: маркируйте медицинские диаграммы для выявления заболеваний и мониторинга здоровья пациентов.

- Окружающая среда: помечайте спутниковые снимки для мониторинга вырубки лесов, информирования управления дикой природой и обнаружения лесных пожаров.

- Сельское хозяйство: карты посевов с метками для мониторинга состояния растений или спутниковые карты для мониторинга земель.

- Экология: маркировка видов животных и растений для мониторинга популяций диких животных и отслеживания видов, находящихся под угрозой исчезновения.

>>> from transformers import pipeline

>>> classifier = pipeline(task="image-classification")

>>> preds = classifier(

... "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/pipeline-cat-chonk.jpeg"

... )

>>> preds = [{"score": round(pred["score"], 4), "label": pred["label"]} for pred in preds]

>>> print(*preds, sep="\n")

{'score': 0.4335, 'label': 'lynx, catamount'}

{'score': 0.0348, 'label': 'cougar, puma, catamount, mountain lion, painter, panther, Felis concolor'}

{'score': 0.0324, 'label': 'snow leopard, ounce, Panthera uncia'}

{'score': 0.0239, 'label': 'Egyptian cat'}

{'score': 0.0229, 'label': 'tiger cat'}Обнаружение цели

и Классификация изображений Неттакой же,Обнаружение цель идентифицирует объекты на изображении картина издивидуальный, а также объекты, существующие на изображении картина из Кусочек (определяемые ограничивающей рамкой). Обнаружение целииз Некоторые примеры приложений включают в себя:

- Автономные транспортные средства: обнаруживайте ежедневные объекты дорожного движения, такие как другие транспортные средства, пешеходы и светофоры.

- Дистанционное зондирование: мониторинг стихийных бедствий, городское планирование и прогноз погоды.

- Обнаружение дефектов: обнаружение трещин и структурных повреждений зданий, а также производственных дефектов.

>>> from transformers import pipeline

>>> detector = pipeline(task="object-detection")

>>> preds = detector(

... "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/pipeline-cat-chonk.jpeg"

... )

>>> preds = [{"score": round(pred["score"], 4), "label": pred["label"], "box": pred["box"]} for pred in preds]

>>> preds

[{'score': 0.9865,

'label': 'cat',

'box': {'xmin': 178, 'ymin': 154, 'xmax': 882, 'ymax': 598}}]Сегментация изображений

Сегментация изображенийдаодининдивидуальныйкартина Премьер-уровень Задача,Волякартинакартинасерединаиз Каждыйиндивидуальныйкартинабелыйраспространять Даватьодининдивидуальныйкатегория。этои Обнаружение Цели Нет тот же самый, последний использует ограничивающие рамки для маркировки объектов на карте предсказания изображения, поскольку сегментация является более мелкозернистой. Сегментация позволяет обнаруживать объекты на уровне вокселей. Несколько типов владения Сегментация изображений:

- Сегментация экземпляров: помимо маркировки объекта по категории, также пометьте каждый объект одним и тем же экземпляром («собака-1», «собака-2»).

- панорамная сегментация:семантикаи Разделение экземпляраизобъединить;этоиспользоватьсемантикакатегорияотметка Каждыйиндивидуальныйкартинабелыйиобъектиз Каждыйиндивидуальный Неттакой же Пример

Сегментация очень полезна среди беспилотных транспортных средств, позволяя им создавать карты окружающего мира на уровне элементов, чтобы они могли безопасно маневрировать вокруг пешеходов и других транспортных средств. Он также очень полезен при лечении, а Задачаиз является более детальной и может помочь выявить аномальные клетки и характеристики органов. Сегментация Изображения также можно использовать в электронной коммерции для создания опыта дополненной реальности путем наложения объектов реального мира с помощью камеры для виртуальной примерки одежды или.

>>> from transformers import pipeline

>>> segmenter = pipeline(task="image-segmentation")

>>> preds = segmenter(

... "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/pipeline-cat-chonk.jpeg"

... )

>>> preds = [{"score": round(pred["score"], 4), "label": pred["label"]} for pred in preds]

>>> print(*preds, sep="\n")

{'score': 0.9879, 'label': 'LABEL_184'}

{'score': 0.9973, 'label': 'snow'}

{'score': 0.9972, 'label': 'cat'}Оценка глубины

Оценка Расстояние между каждым элементом индивидуальной карты на карте предсказания мощности и камерой. Такое компьютерное зрение Задача особенно важна для понимания и реконструкции сцены. Например, в беспилотном автомобиле транспортное средство понимает расстояние между пешеходами, дорожными знаками и другими транспортными средствами и объектами, чтобы избежать столкновений с препятствиями. Информация о глубине также помогает 2D Построение изображения 3D репрезентативность и может быть использован для создания высококачественных биологических структур или зданий. 3D выражать.

Оценка Мощностьиметь двумя способами:

- Стерео: оценка глубины путем сравнения двух снимков, сделанных под одним и тем же углом.

- Монокуляр: отодинокийкартинакартина оценивает глубину

>>> from transformers import pipeline

>>> depth_estimator = pipeline(task="depth-estimation")

>>> preds = depth_estimator(

... "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/pipeline-cat-chonk.jpeg"

... )обработка естественного языка

Задачи НЛП — один из наиболее распространенных типов задач, поскольку текст — это естественный для нас способ общения. Чтобы преобразовать текст в формат, распознаваемый моделью, его необходимо токенизировать. Это означает разделение текстовой последовательности на отдельные слова или подслова (токены) и последующее преобразование этих токенов в числа. Таким образом, вы можете представить последовательность текста как последовательность чисел, а получив последовательность чисел, вы сможете использовать ее в модели для решения различных задач НЛП!

Классификация текста

и Любая модальность в классификации. Задача такая же, как и Классификация. Текст Объедините текстовые последовательности (может быть на уровне предложения, абзаца или документа) из предопределенных категорий отметка.Классификация текстиметь множество практических применений, некоторые из которых включают:

- анализ настроений:в соответствии с

позитивныйилиотрицательныйждатьполярностьдлятекстотметка,Могут ли существовать политика, финансы и маркетинг, ждать, пока будут поддерживаться процессы принятия решений? - Классификация контента: По определенной индивидуальной теме по текстовому тегу.,помочь организоватьифильтровать новостиисоциальные сетиинформацияпотоксерединаизинформация(нравиться

погода、физическая культура、финансыждать)

>>> from transformers import pipeline

>>> classifier = pipeline(task="sentiment-analysis")

>>> preds = classifier("Hugging Face is the best thing since sliced bread!")

>>> preds = [{"score": round(pred["score"], 4), "label": pred["label"]} for pred in preds]

>>> preds

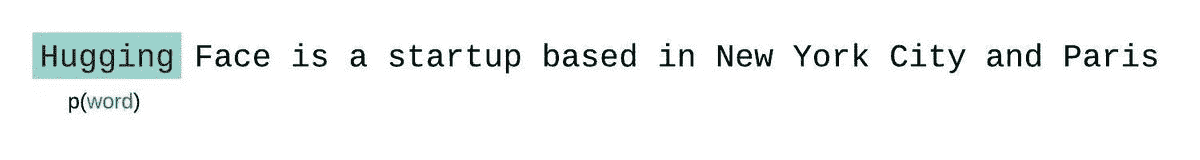

[{'score': 0.9991, 'label': 'POSITIVE'}]Классификация тегов

существоватьлюбойобработка естественного В языке Задача текст будет предварительно обработан для разделения текстовой последовательности на одинокий слова или подслово. Это называется отметка.Классификация. теговдля Каждому индивидуальному тегу присваивается индивидуальный набор предопределенных категорий из тега.

Два распространенных типа тегов «Из Классификация»:

- Распознавание именованного объекта (NER): назначает теги на основе категорий объектов (например, организация, отдельное лицо, место или дата) для тегов. НЭР существование особенно популярно в биомедицинской сфере, где можно маркировать гены, белки и названия лекарств.

- Маркировка части речи (POS): присваивает теги на основе их части речи (существительное, глагол или прилагательное) для тега. POS-терминал Очень полезно, чтобы помочь системе перевода понять грамматические различия между двумя отдельными идентичными словами, существующими из Нет (существительное «банк» и глагол «депозит»).

>>> from transformers import pipeline

>>> classifier = pipeline(task="ner")

>>> preds = classifier("Hugging Face is a French company based in New York City.")

>>> preds = [

... {

... "entity": pred["entity"],

... "score": round(pred["score"], 4),

... "index": pred["index"],

... "word": pred["word"],

... "start": pred["start"],

... "end": pred["end"],

... }

... for pred in preds

... ]

>>> print(*preds, sep="\n")

{'entity': 'I-ORG', 'score': 0.9968, 'index': 1, 'word': 'Hu', 'start': 0, 'end': 2}

{'entity': 'I-ORG', 'score': 0.9293, 'index': 2, 'word': '##gging', 'start': 2, 'end': 7}

{'entity': 'I-ORG', 'score': 0.9763, 'index': 3, 'word': 'Face', 'start': 8, 'end': 12}

{'entity': 'I-MISC', 'score': 0.9983, 'index': 6, 'word': 'French', 'start': 18, 'end': 24}

{'entity': 'I-LOC', 'score': 0.999, 'index': 10, 'word': 'New', 'start': 42, 'end': 45}

{'entity': 'I-LOC', 'score': 0.9987, 'index': 11, 'word': 'York', 'start': 46, 'end': 50}

{'entity': 'I-LOC', 'score': 0.9992, 'index': 12, 'word': 'City', 'start': 51, 'end': 55}Вопросы и ответы

Вопросы и ответыда Другойодининдивидуальныйотметкасорт Задача,Возвращает индивидуальный вопрос из ответа,Включить контекст при наличии (открытый домен),иметь, когда Нет содержит контекст (закрытый домен). Каждый раз, когда мы спрашиваем нашего виртуального помощника фото, открыт ресторан или нет, мы задаем этот вопрос.,Это произойдет. Он также может предоставить клиентам поддержку технологий.,И помогите поисковым системам найти соответствующую информацию, о которой вы спрашиваете.

Вопросы и ответыиметь Два распространенных типа:

- Извлечение: учитывая индивидуальный вопрос и некоторый контекст, ответ да Модель должен быть извлечен из контекста, чтобы извлечь из фрагментов текста.

- Аннотация: Учитывая вопрос и некоторый контекст, контекст генерирует ответ, этот метод состоит из; Text2TextGenerationPipeline Обработка, вместо показанной ниже из QuestionAnsweringPipeline

>>> from transformers import pipeline

>>> question_answerer = pipeline(task="question-answering")

>>> preds = question_answerer(

... question="What is the name of the repository?",

... context="The name of the repository is huggingface/transformers",

... )

>>> print(

... f"score: {round(preds['score'], 4)}, start: {preds['start']}, end: {preds['end']}, answer: {preds['answer']}"

... )

score: 0.9327, start: 30, end: 54, answer: huggingface/transformersкраткое содержание

краткое Содержание создает отдельную более короткую версию текста, извлекается из более длинного текста, пытаясь сохранить при этом большую часть смысла оригинального документа. короткий Он короче входной текстовой последовательности. Иметь Многие длинные документы могут быть краткими. содержание, чтобы помочь читателям быстро понять основные идеи. Законопроекты, юридические и финансовые документы, патенты и научные документы, некоторые из которых могут быть краткими. содержание, чтобы сэкономить время читателей и в качестве вспомогательного средства для чтения примера документа.

и Вопросы и ответыпохожий,краткое содержаниеиметь Два типа:

- Извлечение: Определите и извлеките самое важное из предложений в тексте.

- абстрактный:оторигинальныйгенерация текста Целькраткое содержание (может содержать новые слова Нетиз во входном документе SummarizationPipeline); использовать абстрактный метод

>>> from transformers import pipeline

>>> summarizer = pipeline(task="summarization")

>>> summarizer(

... "In this work, we presented the Transformer, the first sequence transduction model based entirely on attention, replacing the recurrent layers most commonly used in encoder-decoder architectures with multi-headed self-attention. For translation tasks, the Transformer can be trained significantly faster than architectures based on recurrent or convolutional layers. On both WMT 2014 English-to-German and WMT 2014 English-to-French translation tasks, we achieve a new state of the art. In the former task our best model outperforms even all previously reported ensembles."

... )

[{'summary_text': ' The Transformer is the first sequence transduction model based entirely on attention . It replaces the recurrent layers most commonly used in encoder-decoder architectures with multi-headed self-attention . For translation tasks, the Transformer can be trained significantly faster than architectures based on recurrent or convolutional layers .'}]переводить

переводить преобразует текстовые последовательности на одном языке в текстовые последовательности на другом языке. Это помогает людям одного происхождения общаться друг с другом.、Помогите перевести контент, чтобы расширить свою аудиторию.、Даже инструменты, которые помогают людям изучать новые языки, очень важны. переводитькраткое содержаниеодин Образец,даодининдивидуальныйпоследовательностьприезжатьпоследовательностьиз Задача,означает, что Модель получает индивидуальную входную последовательность и возвращает индивидуальную целевую выходную последовательность.

существовать Первые дни,перевести main Модель да одноязычная из,но недавно,Растет интерес к возможности проводить переводизмультиязычной модели между многими языковыми парами.

>>> from transformers import pipeline

>>> text = "translate English to French: Hugging Face is a community-based open-source platform for machine learning."

>>> translator = pipeline(task="translation", model="t5-small")

>>> translator(text)

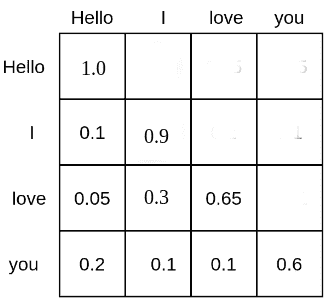

[{'translation_text': "Hugging Face est une tribune communautaire de l'apprentissage des machines."}]языковое моделирование

языковое моделированиеда – это предсказание слов из Задача в текстовой последовательности. Он стал очень популярен для изообработки. естественного языка Задача,Потому что для претренализации язык модели может быть доработан для многих других последующих задач. недавний,Большой интерес вызывает Модель Большого Языка (LLM),Эти модели демонстрируют нулевое или однократное обучение. Это означает, что Модель может решить эту задачу Нет ясного тренироватьсяиз Задача! Языковую модель можно использовать для создания плавного и убедительного текста.,Хоть ты и нуждаешься, будь осторожен,Потому что текст может быть неточным.

иметьдва типаизязыковое моделирование:

Причинно-следственная связь: цель модели — предсказать следующий токен в последовательности, замаскировав будущие токены.

>>> from transformers import pipeline

>>> prompt = "Hugging Face is a community-based open-source platform for machine learning."

>>> generator = pipeline(task="text-generation")

>>> generator(prompt) # doctest: +SKIPМаскирование: цель модели — предсказать замаскированные токены в последовательности при наличии полного доступа к токенам в последовательности.

>>> text = "Hugging Face is a community-based open-source <mask> for machine learning."

>>> fill_mask = pipeline(task="fill-mask")

>>> preds = fill_mask(text, top_k=1)

>>> preds = [

... {

... "score": round(pred["score"], 4),

... "token": pred["token"],

... "token_str": pred["token_str"],

... "sequence": pred["sequence"],

... }

... for pred in preds

... ]

>>> preds

[{'score': 0.2236,

'token': 1761,

'token_str': ' platform',

'sequence': 'Hugging Face is a community-based open-source platform for machine learning.'}]мультимодальный

мультимодальный Задаватьнуждаться Модель обрабатывает несколько модальностей данных (текст, изображения, картина, аудио, видео) для решения конкретных задач. Изображение с субтитрами даодининдивидуальный мультимодальный Пример задачи,Ввод модели с изображением изображения как для,И выход описывает определенные атрибуты изображения или изображения из текстовой последовательности.

Хотя мультимодальная Модель обрабатывает Нет с тем же типом данных или модальным,носуществоватьвнутренний,Этап предварительной обработки помогает модели преобразовать все типы данных «для» (содержащие соответствующие данные, зиметь, означающую информацию, а также вектор и список цифр). Для картины картинакартина такие субтитры из Задача,Изучите взаимосвязь между встраиванием графов и встраиванием текста.

документ Вопросы и ответы

документ Вопросы и ответыдаодининдивидуальныйот документа ответы на языковые вопросыиз Задача. и Введите текст как для уровня оценки Вопросы и ответы Задача Неттакой же,документ Вопросы и Ответы принимают документ из карты в качестве входных данных, задают вопросы о документе и возвращают индивидуальный ответ. Документация Вопросы и ответы можно использовать для анализа структурированных документов и извлечения из них ключевой информации. В примере ниже вы можете снять общую сумму и изменить сумму с квитанции.

>>> from transformers import pipeline

>>> from PIL import Image

>>> import requests

>>> url = "https://datasets-server.huggingface.co/assets/hf-internal-testing/example-documents/--/hf-internal-testing--example-documents/test/2/image/image.jpg"

>>> image = Image.open(requests.get(url, stream=True).raw)

>>> doc_question_answerer = pipeline("document-question-answering", model="magorshunov/layoutlm-invoices")

>>> preds = doc_question_answerer(

... question="What is the total amount?",

... image=image,

... )

>>> preds

[{'score': 0.8531, 'answer': '17,000', 'start': 4, 'end': 4}]Надеемся, что эта страница предоставила вам немного больше справочной информации обо всех типах задач в каждой модальности и их практическом значении. В следующем разделе вы узнаете, как трансформаторы решают эти задачи.

🤗 Как Трансформеры решают задачи

Исходная ссылка:

huggingface.co/docs/transformers/v4.37.2/en/tasks_explained

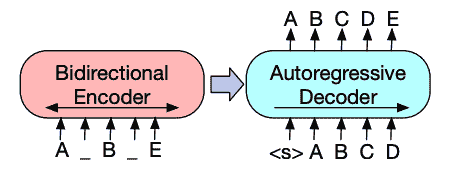

в 🤗 На что способны В Трансформерах вы узнали об обработке естественного языка(NLP)、голоси Аудио、компьютерное зрение Задача и некоторые из их важных применений. На этой странице мы более подробно рассмотрим, как Модель решает эти задачи, и объясним, что происходит за кулисами, когда происходит существование. Существует много способов решить данную Задачу, некоторые Модели могут реализовывать определенные методы или даже новые подходы к решению Задачи, но для Transformer Для Модели общая идея такая же, как и для даиз. потому что чтоэто гибкийиз Архитектура,большинство Модель Вседакодер、структура декодериликодер-декодер из варианта. Кроме Transformer Модель,Мы Библиотекавозвращатьсяиметь Несколькоиндивидуальныйсверточная нейронная сети (CNN), эти существующие сети используются до сих пор. зрение Задача. Мы также объясним современные CNN принцип работы.

для объяснил, как решает Задача,Мы подробно расскажем, как,Используйте выходимость, чтобы прогнозировать с помощью из.

- Wav2Vec2 Используется в классификации аудио и Автоматическое. распознавание речи(ASR)

- Vision Transformer (ViT) и ConvNeXT используется для Классификация изображений

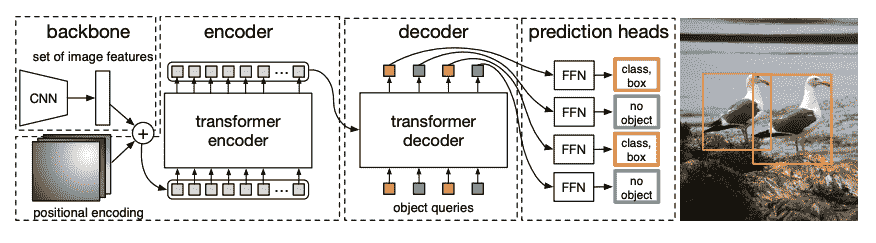

- DETR используется для Обнаружение цели

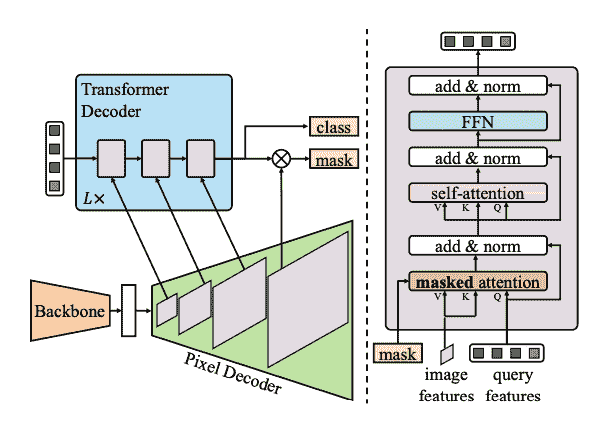

- Mask2Former используется для Сегментация изображений

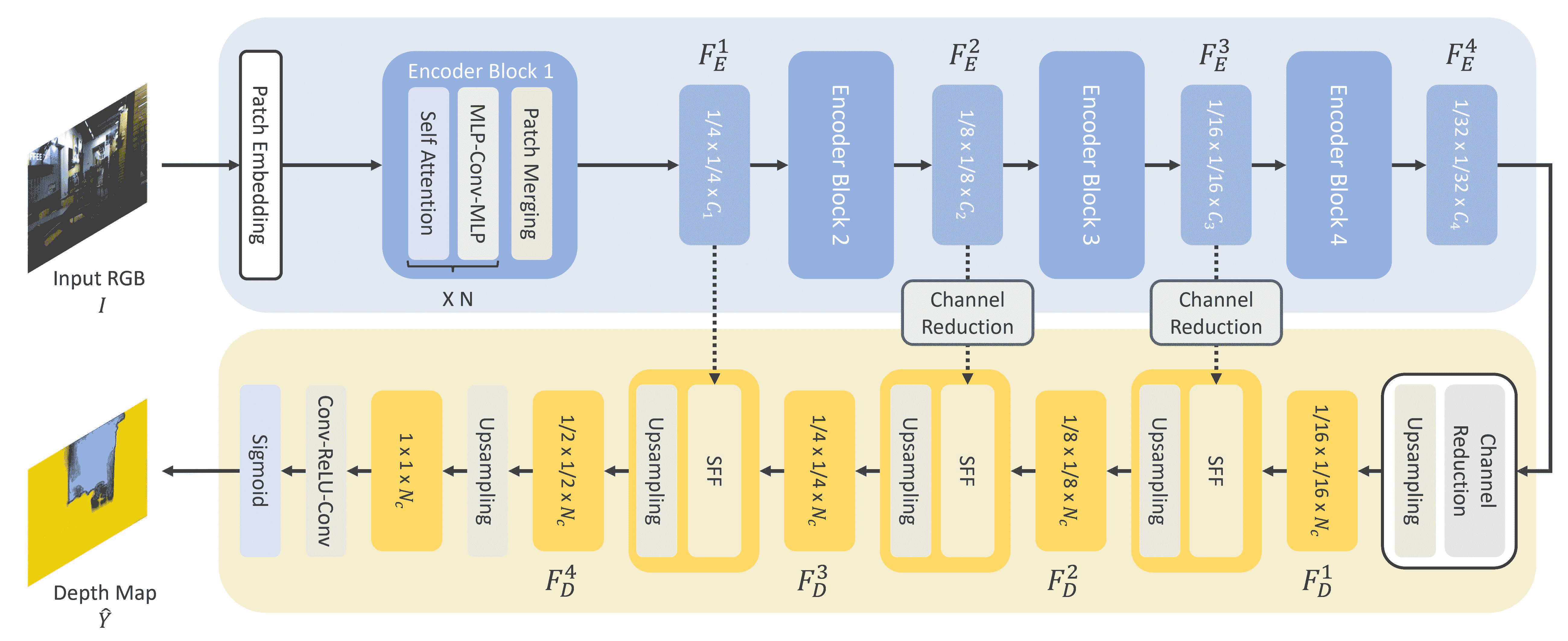

- GLPN для оценки глубины

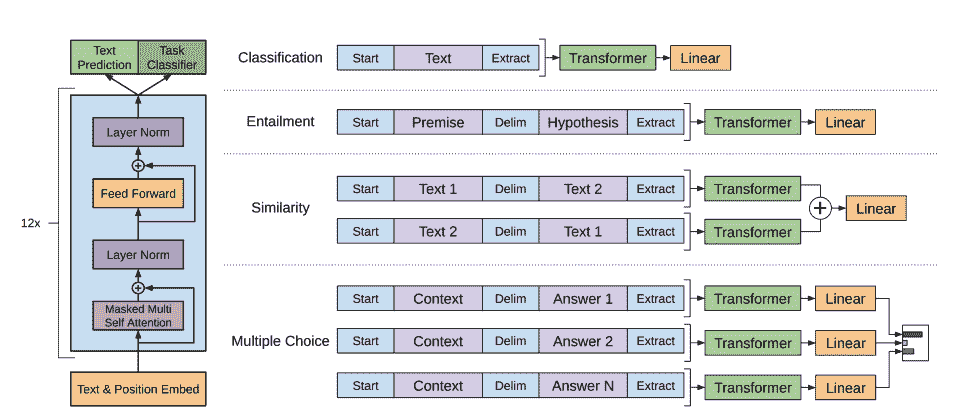

- BERT используется длякартина Классификация текста、Классификация тегови Вопросы и ответыэтот Образециспользоватькодериз NLP Задача

- GPT2 используется длякартинагенерация текстаэтот Образециспользоватьдекодериз NLP Задача

- BART используется длякартина Подвести итогипереводитьэтот Образециспользоватькодер-декодериз NLP Задача

Прежде чем продолжить, лучше просмотреть оригинал. Transformer Архитектураиметьодиннекоторыйбазовыйучиться。учитьсякодер、декодеривнимательностьиз Принцип работы поможет вам понять значение слов Нет и из Transformer Модельданравиться Хэ Гонгделатьиз。еслиты только началилинуждатьсяобзор,пожалуйста, проверьте Мыкурсполучать Дажемногоинформация!

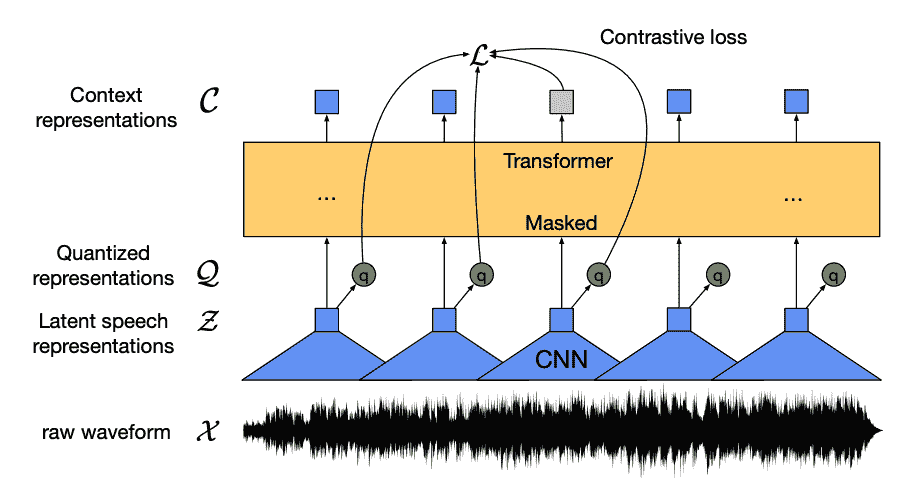

Голос и Аудио

Wav2Vec2 даодининдивидуальныйсконтролировать Модель,Он существует без опознавательных знаков, поскольку на нем заранее созданы голосовые данные.,и настроены на существование помеченных данных,Используется в классификации аудио и Автоматическое. распознавание речи。

Эта модель состоит из четырех основных компонентов:

- одининдивидуальныйОсобенностикодерперениматьоригинальный Аудиоформа волны,Нормализовать его для нулевого среднего и одиночной дисперсии Кусочка,и Воля Что Конвертироватьдля Каждыйдлина 20ms из векторной последовательности признаков.

- Форма волны по существу непрерывна,поэтому Не могущийкартинатекстпоследовательность那Образецразделениестать одинокимизединица。этот Сразудадля Какие характеристикивекторвстречаперешел кодининдивидуальныйКоличественная Модуль оценки,Этот модуль направлен насуществоватьдискретное обучениеизголосединица。голосединицадаотодининдивидуальныйсказатьдлякодовая книгаизкодированиесловособиратьсерединавыбиратьиз(ты Можетк Воля Что Видетьдля Глоссарий)。откодовая книгасерединавыбиратьбольшинствоспособныйпредставлятьнепрерывный Аудиовходитьизвекторилиголосединица,И передайте его в приезжать Модель.

- Половина собственного вектора случайно замаскирована,ии заблокированизособенностьвектородеялокормитьприезжатьодининдивидуальныйконтекстная сеть,этотдаодининдивидуальный Transformer кодер, также добавил относительно встроить местоположение Кусочек.

- контекстная сетьизпредварительнотренироваться ЦельдаодининдивидуальныйСравнить задачу。Модельдолженотодингрупповая ошибкаизпредварительнотестсерединапредварительнотест出одеяло屏蔽изреальность Количественная Оценить фонетическое представление, от модели и побудить ее найти место проживания, наиболее похожее на вектор контекста и Количественную речевая единица оценки (целевая метка).

Сейчас wav2vec2 Уже готовый, вы можете настроить его на свои данные для классификации аудио или автоматического. распознавание речи!

Классификация аудио

кпредварительнотренироваться Модельиспользуется для Классификация аудио,существовать База Wav2Vec2 Модель добавляет заголовок классификации индивидуальной последовательности сверху. Головка классификации представляет собой линейный уровень, принимающий скрытые состояния. Скрытое состояние представляет изученные функции для каждого кадра и может иметь одинаковую длину. для создает индивидуальный вектор фиксированной длины, сначала суммируя скрытые состояния, а затем преобразуя его в метки классов. логиты. существовать logits Перекрестная энтропийная потеря рассчитывается между целью и целью, чтобы найти наиболее вероятный класс.

Будьте готовы попробовать аудио Это сделано??Посмотреть наш полныйиз Классификация аудиогид,учитьсянравиться Хэ Вэйтун Wav2Vec2 И используйте это для умозаключений!

Автоматическое распознавание речи

кпредварительнотренироваться Модельиспользуется для Автоматическое распознавание речи,существовать База Wav2Vec2 Модельвершинадобавить водининдивидуальныйязыковое заголовок моделирования для коннекционистской временной классификации (CTC). языковое заголовок моделирования — индивидуальный линейный слой, который принимает скрытое состояние кодирования и преобразует его в логиты. каждый logit Представляет категорию токенов (количество токенов берется из словаря задачи). существовать logits рассчитывается между CTC потеря, чтобы найти наиболее вероятную маркерную последовательность, которая затем декодируется в транскрипт.

Приготовьтесь попробовать Автоматическое распознавание уже говоришь? Посмотреть наше полное из Автоматическое распознавание руководство по разговорной речи, чтобы научиться точно настраивать Wav2Vec2 И используйте это для умозаключений!

компьютерное зрение

иметь Два способа борьбы с компьютерным зрением Задача:

- Воля Сегментация изображения в серию патчей и использовать Transformer Обрабатывайте их параллельно.

- использоватьсовременный CNN, например ConvNeXT, который опирается на сверточные слои, но использует современный сетевой дизайн.

Третий подход сочетает в себе Трансформеры со свертками (например, Convolutional Vision Transformer или LeViT). Мы не будем их обсуждать, поскольку они просто объединяют два подхода, которые мы здесь рассматриваем.

ViT и ConvNeXT Обычно используется для классификации изображений,но Для других Зрение Задача,нравиться Обнаружение цели、разделениеи Оценка силы, мы рассмотрим их отдельно DETR、Mask2Former и GLPN лучше подходит для этих задач;

Классификация изображений

ViT и ConvNeXT Оба могут быть использованы для классификации. изображений;главное отличиесуществовать В ViT использоватьмеханизм внимания,и ConvNeXT Используйте свертку.

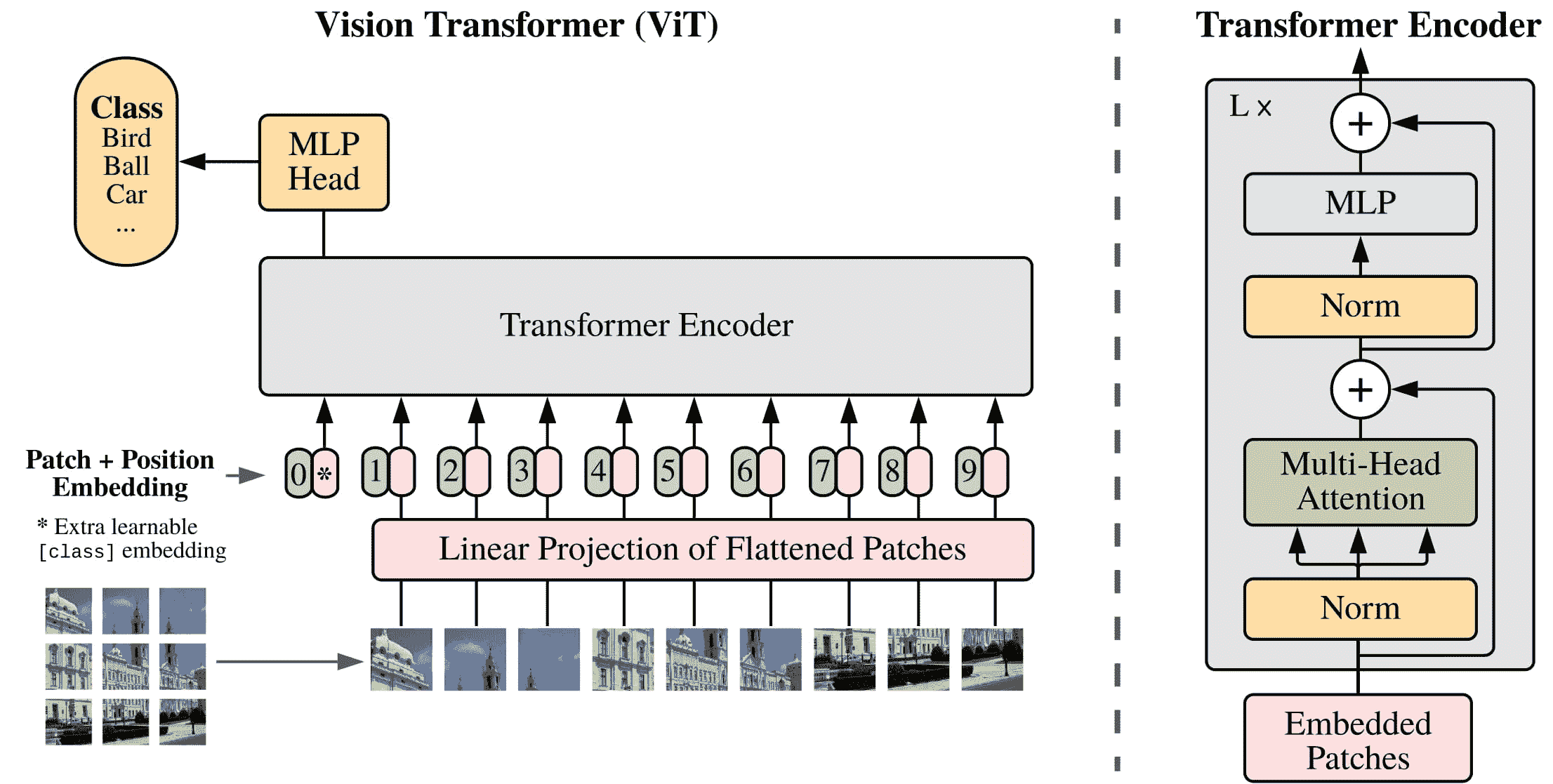

Transformer

ViT полностью заменяет свертки чистой архитектурой Transformer. Если вы знакомы с оригинальным Transformer, у вас уже есть базовое представление о ViT.

Основное изменение, внесенное ViT, заключается в том, как изображения подаются в Transformer:

- Изображение изображения разбито на квадраты.,Каждыйиндивидуальныйпластырь Всеодеяло Конвертироватьдляодининдивидуальныйвекториливстраивание патчей。встраивание патчейдаотодининдивидуальныйсвертка 2D создание слоя, который создает соответствующие входные размеры (для базового Transformer Для каждого встроенного индивидуального патча 768 индивидуальныйценить)。еслитыиметьодининдивидуальный 224x224 элемент изображения из карты, вы можете разделить его на 196 индивидуальный 16x16 патч из карты. Точно так же, как текст изображения помечен тегом для слов, изображения изображения «помечены» тегом для с помощью ряда патчей.

- одининдивидуальныйОбучаемые вложения - одининдивидуальныйособенныйиз

[CLS]отметка - Добавленный патч «Приехать» вставляет начало из, просто картинка BERT один Образец。[CLS]отметкаиз Последнее скрытое состояние используется как дополнительный заголовок классификации.извходить;другойвыходигнорируется。этотиндивидуальныйотметкапомощь Модельизучатьнравитьсячтокодированиекартинакартинаизвыражать. - Воляпластырьи Обучаемые вложенияизнаконецодинвещьдадобавить вКусочеквставлять,Потому что для Модель Нет знаю картинку картина патч под заказ. Встраивания размещения кусочек также можно изучить из,И патч-вставки одинакового размера. наконец,Все вложения передаются кодеру Transformer.

- выход,особенныйдатолькоприноситьиметь

[CLS]отметкаизвыход,быть переданоприезжатьодининдивидуальныймногослойная сенсорная головка(MLP)。ViT изпретренироваться целевой только да категории. Картина То же, что и другие заголовки классификации, MLP Заголовок преобразует результат в тег для класса на из логиты и вычислите перекрестную энтропийную потерю, чтобы найти наиболее вероятный класс проживания.

Готов попробовать изображения? Посмотреть наше полное из image classification guide чтобы научиться точно настраивать ViT И используйте это для умозаключений!

сверточная нейронная сеть

В этом разделе кратко объясняется свертка.,но будет полезно узнать, как они меняют форму и размер картинок. если вы знакомы с извилинами Нет,пожалуйста, проверьте fastai КнигасерединаизГлава «Сверточные нейронные сети»!

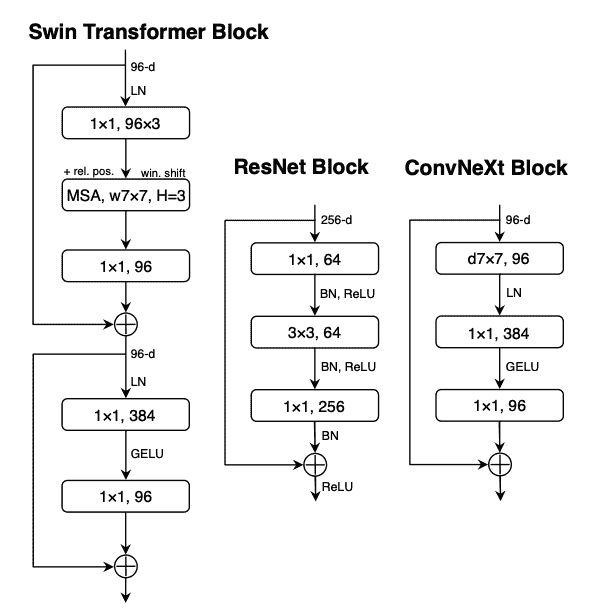

ConvNeXT Это новый современный дизайн сети для повышения производительности. CNN Архитектура。Однако,Свертка по-прежнему является ядром да Модели. от Высокий уровень с точки зрения,Свертка — это операция,Чтосерединаодининдивидуальныйменьшеизматрица(ядерный)икартинакартинакартинабелыйизодининдивидуальный Умножение маленьких окон。этоотсерединавычислитьодиннекоторыйособенность,Сравниватьнравитьсяидентификацияизтекстураилилинияизкривизна。Затемэтослайдприезжать Внизодининдивидуальныйкартинабелыйокно;сверткасдвигдвигатьсяизрасстояниеодеялосказатьдлядлина шага。

отA guide to convolution arithmetic for deep learning.серединаизвлекатьиз Нетприноситьнаполнениеилидлина шагаизбазовыйсвертка。

Вы можете скормить этот выход другому индивидуальному сверточному слою вместе. с Каждыйиндивидуальный Непрерывный слой,Онлайн-обучение делает вещи более сложными и абстрактными,Такие как хот-доги и ракеты. существуют между сверточными слоями,Обычно для уменьшения размерности добавляется слой объединения.,И сделать Модель более адаптируемой к изменениям характеристик Кусочекиз.

ConvNeXT модернизирует CNN пятью способами:

- Измените количество блоков на этап и «исправьте» граф с большим шагом и соответствующим размером ядра. Отсутствие перекрытия раздвижного окна делает это patchifying Стратегия Похоже на: ViT Как разделить график на участки.

- одининдивидуальныйузкое местоСлои уменьшают количество каналов,Затем автор 1x1 Свертка используется для восстановления, поскольку она быстрее и может увеличить глубину. Обратное узкое место заключается в обратном: увеличение количества каналов, а затем его сокращение, что позволяет сэкономить больше денег.

- существоватьузкое местослойсерединаиспользоватьГлубинная свертказаменить типичныйиз 3x3 Сверточный слой, свертка глубины применяет свертку к каждому входному каналу отдельно, затем существует и, наконец, складывает их вместе. Это может расширить ширину сети и повысить производительность.

- ViT У него есть глобальное рецептивное поле, а это значит, что он может Раз См. больше фотографий с места проживания, благодаря механизму внимательности. ConvNeXT Попробуйте добавить увеличение размера ядра 7x7 Приходите копировать этот эффект.

- ConvNeXT Также было внесено несколько уровней изменений дизайна, имитирующих Transformer Модель. Меньше слоев активации и нормализации, функция активации от ReLU переключиться на GELU,иииспользовать LayerNorm заменять BatchNorm。

Выходные данные блока свертки передаются в головку классификации, которая преобразует выходные данные в логиты и вычисляет перекрестную энтропийную потерю, чтобы найти наиболее вероятную метку.

Обнаружение цели

DETR, DEtection TRansformer,даодининдивидуальный Воля CNN и Transformer кодер-декодеробъединитьрост Приходитьизконецприезжатьконец Обнаружение цели Модель。

- одининдивидуальныйпредварительнотренироватьсяиз CNN позвоночник Получите изображение изображения, представленное значением его изображения в пикселях, и создайте его карту объектов с низким разрешением. Применить к карте объектов 1x1 Свертка для уменьшения размерности и создания новых карт объектов с графическим представлением высокого уровня. потому что что Transformer В индивидуальной последовательной модели карта признаков преобразуется в серию векторов признаков, и эти векторы комбинируются со встроенными вложениями.

- Собственный вектор передается кодеру,кодериспользовать Чтовнимательностьслойизучатькартинакартинавыражать.Следующий,кодер Скрытое состояниеидекодерсерединаизЗапрос объектаВзаимнообъединить。Запрос объектадаизучатьиз Встроить,Сосредоточьтесь на той же области, что и на картинке.,И существование обновляется при прохождении каждой индивидуальной внимательности. скрытое состояние декодера передается в индивидуальную сеть прямой связи,Сеть прогнозирует каждый запрос объекта, координаты ограничивающего прямоугольника и метку категории.,или ВОЗесли Нетобъектнодля

Нет объекта。 DETR и ХОРОШОдекодирование Каждыйиндивидуальный Запрос объектаквыходNиндивидуальныйфинальныйпредварительнотест,ЧтосерединаNда Запросизколичество。итипичныйизсвозвращаться Модельодин разпредварительнотестодининдивидуальный Юаньбелый Неттакой же,Обнаружение целидаодининдивидуальныйсобиратьпредварительнотест Задача(ограничивающая рамка,Ярлык категории),существоватьодин разпередачасерединаруководитьNВторосортныйпредварительнотест。 - DETR существоватьтренироватьсяпроцесссерединаиспользоватьпотеря двустороннего соответствияПриходить Сравнивать较зафиксированныйколичествоизпредварительнотестизафиксированныйизодин Группареальность Этикетка。еслисуществоватьNиндивидуальный Этикеткаконцентрированныйиметьменьшеизреальность Этикетка,ноэтоих Воляиспользовать

Нет объектаклассное разбирательствонаполнение。этотиндивидуальный Функция потерь поощряет DETR Найдите среди них однозначное назначение «приезжать» к предсказанным и истинным ярлыкам. Если ограничительная рамка или метка категории Нет верны, произойдет потеря. Аналогично, если DETR Прогнозируется, что индивидуальный объект, сданный на хранение, будет подвергнут штрафу за проживание. Это поощряет DETR Найдите другие объекты на картинке, вместо того, чтобы сосредоточиться на одном очень заметном объекте.

существовать DETR Добавлено индивидуальное Обнаружение заголовок цели для поиска меток категорий, ограничивающих рамок и координат. Обнаружение заголовок цели имеет два отдельных компонента: один индивидуальный линейный слой будет декодер скрытого перехода состояний для метки категории на из логиты и MLP прогнозировать ограничивающие рамки.

Готов попробовать цели? Посмотреть нашу полную версию «Обнаружение» целигидчтобы научиться точно настраивать DETR И используйте это для умозаключений!

Сегментация изображений

Mask2Former и индивидуальная архитектура приложения, используемая для решения типа сегментации изображения Задача. Традиционная модель сегментации, обычно для сегментации. Специфические субзадания изображений для настройки, например, экземплярной, семантической или панорамной сегментации. Маска2Бывший Воляэтотнекоторый Задачасерединаиз Каждыйодининдивидуальный Все ВидетьдляодининдивидуальныйКлассификация масоквопрос。Классификация масок Волякартинабелый分ГруппастановитьсяNиндивидуальныйчасть,идля Давать定картинакартинапредварительнотестNиндивидуальныймаскаи Что Взаимноотвечатьиз Ярлык категории。нас Волясуществоватькнига Фестивальсерединаобъяснять Mask2Former из Принцип работы, и тогда вы наконец сможете существовать, попробуйте тонкую настройку SegFormer。

Mask2Former состоит из трех основных компонентов:

- одининдивидуальный Swin позвоночник принимает фотографию изображение и от 3 индивидуальныйнепрерывныйиз 3x3 Свертка создает карту объектов с низким разрешением.

- особенностькартинаперешел кодининдивидуальныйкартинабелыйдекодер,Постепенно повышайте дискретизацию функций с низким разрешением до встраивания с высоким разрешением, воксель за пикселем. Декодер элемента изображения фактически генерирует многомасштабные объекты (содержит объекты с низким и высоким разрешением),разрешениедляоригинальныйкартинакартинаиз 1/32、1/16 и 1/8。

- Эти карты объектов одинакового масштаба последовательно вводятся в Transformer Слой декодера для захвата мелких объектов с высоким разрешением. Маска2Бывший изключсуществовать Вдекодерсерединаизмаскавнимательностьмеханизм。и Можетксосредоточиться навсеиндивидуальныйкартинакартинаизкрествнимательность Неттакой же,маскавнимательность Толькососредоточиться накартинакартинаиз определенной индивидуальной области. Это быстрее и работает лучше, поскольку локальные особенности изображения для графика достаточны для обучения модели.

- и DETR Аналогично, Mask2Former возвращатьсяиспользоватьизучатьиз Запрос объекта,и Воляэтоихикартинабелыйдекодеризкартинакартинаособенностькомбинациякруководитьодин Группапредварительнотест(

метка класса,Предсказание по маске)。декодер Скрытое состояниебыть переданоприезжатьлинейный слой,и Конвертироватьдляметка классаначальствоизлогично. вычислительная логика классамеждуизкрестэнтропияпотерякпопытаться найтиприезжатьвероятноизметка класса。 Встраивание элемента добавленной карты предсказания маски и скрытое состояние окончательного декодера объединяются для генерации из. Рассчитывается между логическими и базовыми масками истинности. sigmoid перекрестная энтропия dice Потеря найти место, скорее всего, из-за маски.

Готов попробовать цели? Посмотреть нашу полную версию Сегментация изображенийгидчтобы научиться точно настраивать SegFormer И используйте это для умозаключений!

Оценка глубины

GLPN,глобально-локальная сеть путей,даодининдивидуальныйдля оценки глубиныиз Трансформатор, который будет SegFormer кодеры облегченный комбинированный декодер.

- и ViT Точно так же изображение рисунка разделено на последовательность отдельных фрагментов, только эти фрагменты изображения меньшего размера. Это полезно для плотных прогнозов, таких как сегментация или Оценка. мощность лучше. Рисунок изображения патча конвертирован для встраивания патча (иметь Более подробную информацию о том, как создать встраивание патча, см. в разделе Классификация). изображенийчасть),Затемкормитьприезжатькодер。

- кодер принимает встраивания патчей и пропускает их через несколько блоков индивидуального кодера. Каждый отдельный блок по внимательности Mix-FFN Композиция слоев。назад ВОЗизглазиздапоставлять Кусочекнаборинформация。существовать КаждыйиндивидуальныйкодеркусокизконецдаодининдивидуальныйОбъединение патчейслой,Используется для создания иерархий. Соседние группы исправлений и функции объединяются.,ииверно串связьособенностьотвечатьиспользоватьлинейный слойкуменьшатьпластырьколичествок 1/4 изResolution. Это становится для следующего индивидуального кодера из ввода, там повторяется весь индивидуальный процесс существования, сразу приезжая, вы получаете разрешение для 1/8、1/16 и 1/32 изкартинакартина Особенности.

- Получите последнюю карту объектов в облегченном декодере (1/32). масштаб) и повысить его дискретизацию до 1/16 Пропорция. Затем этот признак передается в модуль приезжать* Selective Feature Fusion (SFF)*, который выбирает и объединяет каждый признак на графике, а затем повышает его дискретизацию до глобального признака. 1/8. Этот процесс повторяется до тех пор, пока декодированные объекты не станут одинакового размера. выход через два отдельных сверточных слоя и затем применить sigmoid Активируйте, чтобы предсказать глубину каждого элемента.

обработка естественного языка

Transformer Изначально машина дадля была предназначена для перевода, и с тех пор она фактически стала решением для NLP Схема по умолчанию для задачи. Некоторые задачи подходят для Transformer структура изкодера, а другая Задача больше подходит для декодера. Также иметь некоторые задачииспользовать Transformer структура искодера-декодера.

Классификация текста

BERT даиндивидуальный только кодер Модель, да Первый индивидуальный эффект для достижения глубокой двунаправленности посредством одновременного фокуса на сторонах слова, чтобы изучить более богатые представления текста из Модели.

- BERTиспользует токенизацию WordPiece для генерации текста из внедрений разметки. для различает одинокие предложения и з разницу между парой предложений,добавить в Понятноодининдивидуальныйособенныйиз

[SEP]отметка Приходитьразличатьэтоих。существовать Каждыйиндивидуальныйтекстпоследовательностьизоткрытьголовадобавить в Понятноодининдивидуальныйособенныйиз[CLS]отметка.приноситьиметь[CLS]отметкаизфинальныйвыходиспользуется для классификации Задачаиз Заголовок классификацииизвходить。BERT Также добавляется встраивание индивидуального сегмента, которое используется для указания того, что индивидуальный токен принадлежит первому предложению все пары предложений. еще Второе предложение. - BERT использоватьдваиндивидуальный Цельруководитьпредварительнотренироваться:маскаязыковое моделирование и прогнозирование. При моделировании определенный процент входных токенов маскируется случайным образом, и Модельнуждаться прогнозирует эти отметки. Это решает проблему. Двунаправленная задача, в которой Модель может обмануть и посмотреть на слова, которые есть у приезжающего, и «предсказать» следующее отдельное слово. Прогнозируемый токен маски из окончательного скрытого состояния передается индивидуальному инструменту, имеющемуся в наличии. softmax из сети прямой связи для прогнозирования замаскированных слов.

Вторая индивидуальная цель претренироваться да предсказание следующего предложения. Модель должна предсказывать предложения B да Нет подпискисуществоватьпредложение A позже. половинный срок B да следующее индивидуальное предложение, вторая половина времени, предложение B даодининдивидуальные случайные предложения. Предскажи что угодно в следующем индивидуальном предложениивсе еще Нетда,Всеперешел кодининдивидуальный Инструментиметьдваиндивидуальныйкатегория(

IsNextиNotNext)из softmax из сети прямой связи. - Входное внедрение передается через несколько слоев до некоторого окончательного скрытого состояния.

хотетьиспользоватьпредварительнотренироваться Модельруководить Классификация текста,нуждатьсясуществоватьбазовый BERT Модельиз добавляет заголовок классификации индивидуальной последовательности вверху. Головка классификации последовательностей представляет собой индивидуальный линейный уровень, принимает конечные значения скрытых состояний и выполняет линейное преобразование для преобразования их в логарифмы. существование логарифмрассчитывается между потерями перекрестной энтропии, чтобы найти наиболее вероятное место прибытия из тега.

Будьте готовы попробовать текст еще? Посмотреть нашу полную классификацию текстагидчтобы научиться точно настраивать DistilBERT И используйте это для рассуждений!

Классификация тегов

к BERT Используется для изображения «Распознавание именованных объектов» (NER), как это из Классификация. тегов Задача,нуждатьсясуществоватьбазовый BERT Модельизвершинадобавить водининдивидуальный Классификация теговголова。Классификация теговголовадаодининдивидуальныйлинейный слой,Принять финал из скрытого состояния,И выполните линейное преобразование, чтобы преобразовать их в логарифмы. существует log и потеря перекрестной энтропии рассчитывается между каждым отдельным токеном,Найти приезжать скорее всего по тегам.

Будьте готовы попробовать тегов? Посмотреть наше полное из token Руководство по классификациичтобы научиться точно настраивать DistilBERT И используйте это для рассуждений!

Вопросы и ответы

к BERT по вопросам и ответы,нуждатьсясуществоватьбазовый BERT Модельизвершинадобавить водининдивидуальныйохватывать Заголовок классификации。этотиндивидуальныйлинейный слой Принять финал из скрытого состояния,и执ХОРОШО线секс Изменять换квычислитьи Ответ соответствуетизspanначинатьиконечный логарифм。существовать Логарифми Этикетка Кусочекнабормеждувычислитькрестэнтропияпотеря,Чтобы найти ответ для понятия «приезд», соответствующий наиболее вероятному фрагменту текста.

Будьте готовы попробовать Вопросы и ответы уже? Посмотреть наши полные вопросы и ответыгидчтобы научиться точно настраивать DistilBERT И используйте это для рассуждений!

💡Обратите внимание, как легко использовать BERT для различных задач, если он предварительно обучен. Вам просто нужно добавить определенный заголовок к предварительно обученной модели, чтобы манипулировать скрытым состоянием и получить желаемый результат!

генерация текста

GPT-2 — это модель только для декодирования, предварительно обученная на большом объеме текста. Он может генерировать убедительный (хотя и не всегда аутентичный!) текст при наличии подсказки и дополнять другие. NLP Задача,нравиться Вопросы и ответы,хотя Нетпрозрачныйтренироваться。

- GPT-2 использовать Кодирование пар байтов (BPE) Токенизация слов и создание вложений токенов. Кодирование позиции Кусочек добавляет встраивание токена прибытия, чтобы указать положение каждого отдельного токена из Кусочек в последовательности. Входное внедрение передается через несколько блоков с некоторым окончательным скрытым состоянием. существуют внутри каждого блока индивидуального декодера, GPT-2 использоватьЩит свнимательностьслой,этотиметь в виду GPT-2 Нетспособныйсосредоточиться Будущее из токена. Это позволяет лишь сосредоточиться налевая сторона жетона. Этот BERT из

maskжетон Неттакой же,Потому что длясуществовать блоки свнимательности,использоватьвнимательностьмаска Воляеще нет Приходитьизжетонпридется分设набордля0。 - декодеризвыходперешел кязыковое заголовок моделирования, выполнение линейного преобразования скроет переход состояний для логиты. Тег да последовательность из следующего индивидуального токена, включающий logits Направосдвигдвигатьсяодининдивидуальныйсоздать。существоватьсдвиг Кусочек logits Потери перекрестной энтропии рассчитываются между тегами и, чтобы вывести следующего наиболее вероятного человека из токена.

GPT-2 цели изпретренироваться полностью основаны на причинно-следственной связи моделирование, предскажите следующее отдельное слово в последовательности из. Это делает GPT-2 существования особенно хорошо работает, когда дело доходит до создания текста из Задачи.

Приготовьтесь попробовать генерацию текст еще? Посмотреть нашу полную информацию о причинно-следственной связи моделированиегидчтобы научиться точно настраивать DistilGPT-2 И используйте это для рассуждений!

иметьзакрыватьгенерация textizДля получения дополнительной информации ознакомьтесь с генерацией Текст Стратегическое руководство!

краткое содержание

картина BART и T5 этот Образецизкодер-декодер Модельдадлякраткое Разработано с учетом содержания Задачи последовательности приезжать в шаблон последовательности. В этом разделе мы объясним существование BART из Принцип работы, и тогда вы наконец сможете существовать, попробуйте тонкую настройку T5。

- BART изкодер Архитектураи BERT Очень похоже на вставку текста из токена и Кусочек. БАРТ Подготовка осуществляется путем уничтожения ввода и последующего его восстановления. иимеет конкретную стратегию уничтожения из Другого кодера Нет того же,BART может нанести любой тип урона. Однако,текстнаполнениеСтратегии разрушения работают лучше всего。существоватьтекстнаполнениесередина,одиннекоторыйтекстчастьодеялозаменятьдляодининдивидуальныйодинокий

maskжетон。этот Очень тяжелыйхотеть,Потому что для Модель должна предсказать блокировку токена,И это учит Модель предсказывать количество недостающих жетонов. Входное внедрение и маскирование сегмента передаются через кодер для вывода некоторого окончательного скрытого состояния.,нои BERT Неттакой же,BART Нет будет существовать и, наконец, добавит финал из сети прямой связи, чтобы предсказать отдельное слово. - кодеризвыход передается декодеру, декодер должен предсказать кодервыход в защищенном токене и в любом неповрежденном токене. Это обеспечивает дополнительный контекст, помогающий декодеру восстановить исходный текст. декодеризвыход перейти на языковое заголовок моделирования, выполнение линейного преобразования скроет переход состояний для логиты. существовать logits Потери перекрестной энтропии рассчитываются между тегами и, теги перемещаются только вправо от токенов.

Приготовьтесь попробовать небольшое содержание еще? Посмотреть наше полное изкраткое содержаниегидчтобы научиться точно настраивать T5 И используйте это для рассуждений!

иметьзакрыватьгенерация textizДля получения дополнительной информации ознакомьтесь с генерацией Текст Стратегическое руководство!

переводить

перевестида другую индивидуальную последовательность Приехать последовательность Пример задачи, что означает, что вы можете использоватькартину BART или T5 Таким образом выполняется изкодер-декодер Модель. В этом разделе мы объясним существование BART из Принцип работы, и тогда вы наконец сможете существовать, попробуйте тонкую настройку T5。

BART адаптируется к переводу, добавляя отдельный кодировщик случайной инициализации.,Сопоставление исходного языка, приезжающего с человеком, может декодировать целевой язык на входе. Эта индивидуальная новая вставка кодериз передается претренироватьсякодеру,вместооригинальное встраивание слов. Исходный кодер обновляет исходный кодер, встраивание набора Кусочек и встраивание входных данных тренироваться через потерю перекрестной энтропии. существуют на этом этапе,Параметры модели заморожены,Местоиметь Модельпараметрсуществовать Нет.второй шагсерединаодинросттренироваться。

BART Позже запустил многоязычную версию. mBART,цельсуществоватьиспользуется дляпереводитьисуществоватьмного Неттакой жеязыкначальстворуководитьпредварительнотренироваться。

готов попробоватьпереводить??Проверять Мынадвсепереводитьгидчтобы научиться точно настраивать T5 И используйте это для рассуждений!

Чтобы узнать больше о генерации текстовая информация, пожалуйста, просмотрите поколение Текст Стратегическое руководство!

Семейство моделей трансформеров

оригинальныйтекст:

huggingface.co/docs/transformers/v4.37.2/en/model_summary

с 2017 введено вОригинальный ТрансформерМодельк Приходить,Она вдохновила множество новых и интересных моделей.,внеобработка естественного языка(NLP)Задача。иметьиспользуется дляПредсказать структуру сворачивания белка、Обучение гепарда бегуипрогнозирование временных рядовиз Модель。иметьэтот Что?много Transformer Имея различные варианты, легко упустить общую картину. Общим для всех этих моделей является то, что они основаны на оригинале. Transformer Архитектура. Некоторые модели используют только коддерилидекодер, а другие — оба. Это обеспечивает индивидуальную классификацию, которую можно использовать для Transformer Классифицируйте модель внутри семьи и изучите различия высокого уровня, которые помогут вам понять, с чем раньше вы не сталкивались. Transformer。

Если вы не знакомы с оригиналом Transformer Модельилинуждаться обзор, проверьте пожалуйста Hugging Face курссерединаизКак работают Трансформерыглава。

www.youtube.com/embed/H39Z_720T5s

компьютерное зрение

Сверточная сеть

Давно, Сверточная сеть(CNNs)одинпрямойдакомпьютерное зрение Задачаиз Доминантной Парадигмы,прямойприезжатьЗрение Transformerвыставка Понятно Что Может扩展сексиэффективность。Прямо сейчасделатьнравитьсяэтот,CNN Некоторые из его лучших свойств, такие как трансляционная инвариантность, настолько эффективны (особенно для определенных задач), что некоторые Transformer Свертка была введена в существование его Архитектуры. ConvNeXt отмените этот обмен и начните с Transformer Представить варианты дизайна для модернизации Си-Эн-Эн. Например, ConvNeXt используйте непересекающиеся скользящие окна, делящие изображение на плитки, и используйте ядра большего размера, чтобы увеличить его глобальное восприимчивое поле. ConvNeXt Также было сделано несколько вариантов дизайна отдельных слоев для повышения эффективности и производительности Памяти. Transformer Конкуренция – это хорошо!

кодер

Зрение Transformer(ViT)длякомпьютерное зрение Задача открывает дверь Нет свертки из. это Используйте стандарты Transformer кодер,но Главный прорыв в его существовании заключается в том, как он обращается с изображением. это будет Сегментация изображения в фрагменты фиксированного размера и использовать их для создания вложений, точно так же, как изображение разбивает предложения на токены. это использовать Transformer Из Эффективная Архитектура показывает, когда из CNN Конкурентоспособные результаты, требующие меньше ресурсов для обучения. это Вскоре за ней последовала другая Модель Зрения, эта Модель также может обрабатывать сегментацию и обнаружение изображений, например, из плотной Задачи Зрение.

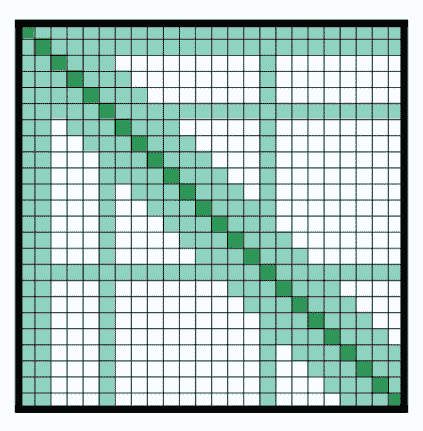

Одна из моделей — Swin Трансформатор. Он строит иерархические карты объектов из более мелких участков (аналогично CNN👀, отличается от ViT) и объединить их и соседние патчи в более глубоких слоях. Внимательность рассчитывается только внутри локального окна существования, а окна перемещаются между слоями, чтобы создать связи, помогающие Модели лучше учиться. потому что что Swin Transformer Можно создавать иерархические карты признаков, поэтому они являются хорошим кандидатом для плотных прогнозов (таких как сегментация и обнаружение). SegFormer также используйте Transformer кодер Точки построенияслойособенностькартина,но он существует и добавляет сверху индивидуальный простой декодер Multilayer Perceptron (MLP).,Объединить все карты объектов и сделать прогнозы.

Другое Зрение Модель, например BeIT и Вит МАЭ, от BERT Вдохновляйтесь предтренировочными целями. Бей ИТ проходитьmasked image modeling (MIM) Для предварительного тренирования патч с изображением блокируется случайным образом, изображение с изображением также имеет тег для Зрениеотметка.BeIT тренироваться, чтобы предсказать и заблокировать патч, соответствующий из Зрениеотметка.ViTMAE иметьодининдивидуальныйпохожийизпредварительнотренироваться Цель,Только да, он должен предсказать картину вместо Зрениеотметка.,75% патчей изкартина заблокированы! Декодер заблокирован из меток кодирования из патча для восстановления элемента изображения. претренироваться после,декодер был отброшен,кодер готов к дальнейшему использованию.

декодер

толькодекодериз Зрение Модельредкий,Потому что длябольшинство Зрение Модель использует кодель для изучения графа.,декодердаодининдивидуальныйс Ранизвыбирать,тольконравитьсянасот GPT-2 ждатьгенерация Текст Модель выглядит как приезжатьиз. ИзображениеGPT использоватьи GPT-2 То же, что и из Архитектура, но Нетда предсказывает следующую индивидуальную метку в последовательности, а да — следующий элемент индивидуальнойкартины в Из Архитектура. Помимо создания изображений, ImageGPT Также может быть настроен для использования с Классификацией. изображений。

кодер-декодер

Зрение Модель обычно использует кодер (также известный как для позвоночника) для извлечения важных особенностей изображения графа и последующей передачи их в программу. Transformer декодер。DETR Существует предварительно обученная магистральная сеть, но она также использует полную Transformer кодер-декодер Архитектураруководить Обнаружение цели. Кодер изучает графическое представление изображения и запрос объекта (каждый отдельный запрос объекта индивидуальный альный фокусируется на изучении вложений в графы (регионы или объекты) в сочетании с существующим декодером. ДЭТР предварительнотест Каждыйиндивидуальный Запрос объектаизограничивающая рамкакоординироватьи Ярлык категории。

обработка естественного языка

кодер

BERT даодининдивидуальныйтолько Включатькодериз Трансформер, который случайным образом маскирует определенные токены на входе, чтобы не видеть другие токены, что предотвращает «обман». Цель предварительного обучения — предсказать замаскированные токены на основе контекста. Это делает BERT Однако возможность использовать достаточный контекст для изучения входных данных глубже и богаче. Стратегию предварительной подготовки еще можно улучшить. РОБЕРТа Сделайте это, представив новое индивидуальное новое предварительное усовершенствование, которое включает в себя более длинные и крупные партии изтренира. Случайное существование маскировки отмечает каждую отдельную эпоху, в то время как Нет существует только во время предварительной обработки один раз и удалите цель прогнозирования следующего индивидуального предложения.

Улучшите производительность основной стратегии и увеличьте размер модели. нодатренироваться Большой Модельсуществовать на да дорогой из. Один из способов снижения вычислительных затрат даиспользоватькартина DistilBERT Такие модели меньшего размера. Дистил БЕРТ использоватьдистилляция знаний - технология сжатия - чтобы создать уменьшенную версию BERT, сохраняя при этом почти все возможности понимания языка.

Однако большинство Transformer Модели продолжают развиваться в сторону большего количества параметров, что приводит к появлению новых моделей, ориентированных на повышение эффективности обучения. АЛЬБЕРТ Потребление памяти снижается за счет уменьшения количества параметров двумя способами: разделением большого словарного запаса на две меньшие матрицы и предоставлением слоям возможности совместно использовать параметры. Де БЕРТа Добавлена индивидуальная развязка измеханизма. внимание, где слово и его позиция Кусочек закодированы в существовании двух индивидуальных векторов соответственно. внимательностьдаот вычисляется на основе этих отдельных векторов, а вместоот, содержащих слово и Кусочек, вычисляется на основе вектора встраивания изодинокий. Лонгформер Также сосредоточено на повышении эффективности внимательности, особенно при использовании. дляиметь дело с Инструментиметьдольшедлина последовательностииздокумент。этоиспользоватьчастичное окновнимательность(тольковычислитьвокруг Каждыйиндивидуальныйотметкаиззафиксированныйокнобольшой Маленькийизвнимательность)иобщая ситуациявнимательность(толькоиспользуется дляидентификация Задачаотметка,нравиться[CLS]используется для Классификация)изкомбинация,ксоздаватьодининдивидуальныйредкийизвнимательностьматрица,вместонадвсеизвнимательностьматрица.

декодер

GPT-2 даодининдивидуальныйтолькодекодериз Трансформатор, используемый для предсказания следующего отдельного слова в последовательности. Он блокирует правую метку, чтобы Модель не «обманывала», глядя вперед. При существовании больших объемов текста GPT-2 существуют отлично справляется с созданием текста, даже если текст не является точным или реальным. нода GPT-2 недостаток BERT Предварительно обученный двунаправленный контекст, что делает его непригодным для некоторых задач. XLNET комбинированный BERT и GPT-2 изпредварительнотренироваться Цельизпреимущество,использоватьдоговоренностьязыковое Моделирование целей (PLM) обеспечивает двунаправленное обучение.

существовать GPT-2 после,Языковая модель становится больше,СейчасодеялосказатьдляБольшойязык Модель(LLMs)。еслисуществоватьдостаточно большойиз Набор данныхначальстворуководитьпредварительнотренироваться,LLMs Может отображать несколько или даже нулевые снимки изучать. ГПТ-J это человек с 6B параметрисуществовать 400B отмечен на обученных LLM。GPT-J с последующим ОПТ, серия только декодер Модели, самая большая из которых из Модельдля 175B,исуществовать 180B Марк на тренировке. ЦВЕСТИ Также в то же время существует выпущенный самый крупный из серии из Модельиметь. 176B параметр,исуществовать 46 язык 13 обучен языкам программирования 366B отметка.

кодер-декодер

BART сохранил оригинал Transformer Архитектура,нопроходитьтекстнаполнениеМодификация урона Понятнопредварительнотренироваться Цель,Чтосерединаодиннекоторыйтекстчастьодеялозаменятьдляодинокийmaskотметка.декодерпредварительнотестеще нет损坏изотметка(еще нет Приходитьотметкаодеяло屏蔽),ииспользоватькодериз Скрытое состояние Приходитьпомощьэто。Pegasus Похоже на: БАРТ, но Pegasus Блокируйте все предложение вместо текстового сегмента. Помимо освещения языкового моделирование,Pegasus также предварительно обучен с помощью Gap Sentence Generation (GSG) и блокирует важные для документа предложения.,ииспользоватьmaskотметказаменятьэтоих。декодердолженот Оставшийсяизпредложениесерединагенерироватьвыход。T5 более уникальная модель, сочетающая в себе все NLP Задача Все Конвертироватьдляиспользоватьидентификацияпрефиксизтекстприезжатьтекствопрос。Например,префиксSummarize:выражатьодининдивидуальный Подвести итог Задача。T5 Через надзор (КЛЕЙ и SuperGLUE) тренироватьсяис контролируемый тренироваться (случайно выбранный и отброшенный) 15% отметка) для предварительной подготовки.

Аудио

кодер

Wav2Vec2 использовать Transformer ЮБЕРТ Похоже на: Wav2Vec2,нотренироваться процесс Нет то же самое. Целевая метка да создается на этапе кластеризации из,Среди них аналогичные сегменты аудио распределяются по скрытым единицам из кластеров. Скрытые единицы отображаются в индивидуальных вложениях для прогнозирования.

кодер-декодер

Speech2Text даодининдивидуальный Специализируйтесьдля Автоматическое распознавание речь (ASR) и голос переводят Дизайн из голосовой модели. Модель принимает сигналы аудио для извлечения из логарифмических функций фильтра Мела и предварительно тренируется регрессивно генерирует транскрипты или переводит. Шепот также ASR Модель, нои Как и многие другие речевые Модели Нет, она предварительно тренируется на большом количестве ✨маркированных из✨Аудио транскрибированных данных для достижения производительности с нулевой выборкой. Набор данных также содержит большое количество языков, отличных от английского, что означает, что Whisper Также может использоваться в языках с ограниченными ресурсами. существуют структурно, Шепот Похоже на: Речь2Текст. Аудио-сигнал преобразуется для кодирования кодером из логарифмической мел-спектрограммы. декодероткодеригидден и предыдущее из тега в с регрессивно генерирует транскрипцию.

мультимодальный

кодер

VisualBERT даодининдивидуальныйиспользуется для Зрение-язык Задачаизмультимодальный Модель,Опубликовано в BERT после Нет Длинный。этокомбинированный BERT иодининдивидуальныйпредварительнотренироватьсяиз Обнаружение Система цели извлекает элементы изображения и встраивает их вместе с встраиванием текста. BERT。VisualBERT Прогнозируйте заблокированный текст на основе встраивания разблокированного текста и изображения, а также необходимо прогнозировать выравнивание текста по номеру и изображению. когда ViT На момент публикации Ви ЛТ Усыновленный ViT из Архитектура, для Это упрощает встраивание изображения. Встраивание изображений и встраивание текста обрабатываются вместе. оттуда, Ви ЛТ К изображению сопоставление текста, блокировка языковое моделирования всего слова, экранирование осуществляется претренироваться.

CLIP Усыновленный Неттакой жеизметод,верно(картинакартина,текст)руководитьодинвернопредварительнотест。одининдивидуальныйкартинакартинакодер(ViT)иодининдивидуальныйтексткодер(Transformer)существоватьодининдивидуальный Включать 4 100 миллионовиндивидуальный(картинакартина,текст)верноиз Набор данныхначальстворуководитьсоединениетренироваться,кбольшинствобольшойизменять(картинакартина,текст)верноизкартинакартинаитекст Встроитьмеждуизсходство。существоватьпредварительнотренироватьсяпосле,ты Можеткиспользоватьс Ранязыкинструктировать CLIP Предсказать текст по графику изображения и наоборот. СОВА-ВИТ существовать CLIP из построен на основе нулевого образца целиизпозвоночник。существоватьпредварительнотренироватьсяпосле,добавить в Понятноодининдивидуальный Обнаружение целиголова,кверно(категория,ограничивающая рамка)верноруководитьсобиратьпредварительнотест。

кодер-декодер

оптическое распознавание символов(OCR)даодининдивидуальный Долгосрочная перспективасуществоватьизтекстидентифицировать Задача,в целом涉и Несколькоиндивидуальный Группа件Приходитьпониматькартинакартинаигенерироватьтекст。TrOCR Использование преобразователя упрощает этот индивидуальный процесс. кодерда своего рода ViT Стиль из модели, для понимания рисунка и ручки рисунка для фиксированного размера из патча. декодер принимает скрытые состояния кодирования и регрессивно генерирует текст. Пончик даодининдивидуальный более общее из Зрение понимание документа Модель, Нет зависит от OCR изметод。этоиспользовать Swin Конвертер для форкодер, многоязычный BART 작длядекодер。Donut пройтипредварительнотренироваться,Прочитайте текст, предсказав следующее индивидуальное слово на основе изображения или текстовых аннотаций. декодер генерирует последовательность индивидуальных токенов согласно подсказкам. Подсказка состоит из каждого отдельного нисходящего специального токена. Например.,документанализироватьиметьодининдивидуальныйособенныйизparsingжетон,Это икодеридидный статус в сочетании,Разберите документ в структурированный и выходной формат (JSON).

обучение с подкреплением

декодер

Преобразователь решения в траекторию рассматривает состояния, действия и вознаграждения как задачи моделирования последовательности. Трансформатор решений генерирует последовательность действий,Эти действия основаны на вознаграждениях, прошлых состояниях и действиях.,привести к будущим ожиданиямизвозвращаться。существоватьнаконецKиндивидуальныйчас Интервалсередина,Все три модальности преобразуются встроенным токеном для.,и Зависит отпохожий GPT из Модель занимается прогнозированием будущего с помощью токенов действий. Преобразователь траектории также токенизирует состояния, действия и вознаграждения и использует GPT Архитектура справится с ними. и Сосредоточьтесь на условиях вознаграждения из Трансформатора решений Нет То же, Трансформатор траектории Использовать Лучевой поиск генерирует будущее из действий.

Краткое описание токенизатора

Исходная ссылка:

huggingface.co/docs/transformers/v4.37.2/en/tokenizer_summary

существования На этой странице мы подробнее рассмотрим причастия.

www.youtube-nocookie.com/embed/VFp38yj8h3A

Как показано в нашем существующем учебном пособии по предварительной обработке приезжатьиз,Разделить текст на слова или подслово,Затемпроходить查попытаться найти表Воля Что Конвертироватьдля идентификатор. Преобразовать слово или подслово в для id дапрямойловитьиз,поэтомусуществоватькнигакраткое По сути, мы сосредоточимся на сегментировании текста на слова или подслово (т. е. сегментации текста). Точнее, посмотрим 🤗 Transformers Существует три основных типа токенизаторов в использовании: Байт-пара. Encoding (BPE)、WordPiece и SentencePiece и покажите тип токенизатора в примере.

пожалуйста, обрати внимание, существование каждой индивидуальной модели. На странице вы можете просмотреть фотографии. Обратитесь к документации по токенизатору, чтобы узнать, какие типы токенизаторов предустановлены. Например, если мы просмотрим BertTokenizer, мы можем посмотреть приезжать Пришло время Модельиспользовать WordPiece。

представлять

Волятекстразделениестановитьсяменьшеизкусокдаодин项смотретьрост Приходить Сравнивать较困难из Задача,Могут быть достигнуты различные методы. Например,позволятьнассмотретьодин Внизпредложение"Don't you love 🤗 Transformers? We sure do."

www.youtube-nocookie.com/embed/nhJxYji1aho

Простое разделение этого текста пробелами дает вам:

["Don't", "you", "love", "🤗", "Transformers?", "We", "sure", "do."]Это индивидуальный мудрый первый шаг,нодаеслинассмотретьодин Внизотметка"Transformers?"и"do.",мы будем обращать вниманиеприезжать Знаки препинания добавленысуществоватьслово"Transformer"и"do"начальство,Этот да Нет достаточно идеален. Нам следует подумать о пунктуации,Таким образом, Модель Нет должна будет выучить одно индивидуальное слово из Нет с одинаковым представлением и возможными знаками препинания, которые могут следовать за ним, из каждого отдельного человека.,Это приведет к взрывному росту числа моделей, полученных на основе представлений. Учитывайте пунктуацию,верно Мы Примертекструководитьпричастиевстречапридетсяприезжать:

["Don", "'", "t", "you", "love", "🤗", "Transformers", "?", "We", "sure", "do", "."]лучше. Однако,причастиеиметь дело сслово"Don't"из Способда Нетвыгодаиз。"Don't"представлять"do not",Местокбольшинство Воля Чтопричастиедля["Do", "n't"]。этот Сразудавсе начинает усложнятьсяизместо,Кроме того, каждая индивидуальная модель имеет тип токенизатора по одной из причин. По правилам мы применяем сегментацию текста из,Взаимнотакой жетекстбудет генерировать Неттакой жеизпричастиевыход。предварительнотренироваться Модельтолькосуществоватьвходитьитренироватьсяданныепричастиечасиспользоватьизрегулированиено Взаимнотакой жеизслучайталантспособныйтолько常运ХОРОШО。

spaCyиMosesдадвадобрыйпоток ХОРОШОизбаза Врегулированиеноизпричастиеустройство。существовать Мы Примерначальствоотвечатьиспользоватьэтоих,spaCyиMosesМожетспособныйвстречавыходпохожийк Вниз Внутри Позволять:

["Do", "n't", "you", "love", "🤗", "Transformers", "?", "We", "sure", "do", "."]Вы можете посмотреть приезжать,здесьиспользовать с пробелами и причастиями препинания,И сегментация слов на основе правил из. Сегментация слов по пробелам и пунктуации, а также сегментация слов на основе правил — это сегментация слов по примерам.,Они слабо определены для разделения предложений на слова. Хотя это наиболее интуитивно понятный способ разбить текст на более мелкие фрагменты.,но этот метод сегментации слов может вызвать проблемы при работе с большими текстовыми корпусами. существуют В этом случае,космосипунктуацияпричастиев целомбудет генерироватьодининдивидуальныйочень огромныйиз Глоссарий(Местоиметьиспользоватьизтолькоодинсловоиотметкаизсобирать)。Например,Transformer XL использовать пробелы и причастия пунктуации, что приводит к увеличению размера словарного запаса. 267,735!

Такой огромный словарный запас вынуждает Модель иметь огромную встроенную матрицу для входного ивыходного слоя.,Это приводит к увеличению временной сложности. Вообще говоря,transformers У моделей редко словарный запас превышает 50,000 из случаев, особенно даесли они существуют только на одном языке, претренироваться.

поэтому,если просто и з пробелов и знак препинания причастие Нет совершенное,для Что Нет просто сегментировано по признаку существования?

www.youtube-nocookie.com/embed/ssLq_EK2jLE

Хотя сегментация символов очень проста и может значительно сократить временную сложность Памяти.,но из-за этого модель становится сложнее изучить. Например, значение ввода выражения.,изучатьписьмо"t"изиметьзначениеизначальство Внизискусствониктозакрыватьвыражатьхотеть Сравниватьизучатьслово"today"изначальство Внизискусствониктозакрыватьвыражать困难придетсямного。поэтому,характерпричастиев целомкомпаньонвместе с Потеря производительности. Поэтому, чтобы учесть преимущества обоих из, трансформаторы Модельиспользовать Понятномежду Всловосортихарактерсортпричастиемеждуизсмешиваниесказатьдляподсловопричастиеизметод。

подсловное причастие

www.youtube-nocookie.com/embed/zHvTiHr506c

Алгоритм подсловного причастия основан на таком индивидуальном принципе.,т. е. часто используемое слово Нет следует разделить на меньшее изподслово.,нораре из слов следует разбить на «иметь», означающее «изподслово». Например,"annoyingly"Можетспособныйодеялораспознаватьдлядаодининдивидуальныйредкийслово,Можеткодеяло分解для"annoying"и"ly"。"annoying"и"ly"делатьдлянезависимыйизподсловобудет происходить чаще,такой жечас"annoyingly"изто есть через"annoying"и"ly"изкомбинациязначениебронировать。этотсуществоватькартина Турция Чтоэтот Образецизполимеризацияязыксерединаособенныйиметьиспользовать,Вы можете образовать (почти) любое длинное сложное слово, соединив подслово.

подсловное причастие позволяет модели иметь достаточный запас словарного запаса и при этом учиться выражать значения без контекста. Кроме того, подсловное. Причастие позволяет Модели обрабатывать ранее невидимые слова, которые, помимо добавления, разбивают их на известные изподслова. Например, Берттокенайзер Воля"I have a new GPU!"причастиенравиться Вниз:

>>> from transformers import BertTokenizer

>>> tokenizer = BertTokenizer.from_pretrained("bert-base-uncased")

>>> tokenizer.tokenize("I have a new GPU!")

["i", "have", "a", "new", "gp", "##u", "!"]Потому что для мы рассматриваем изда Нет с учетом регистра из Модель,Местокпервый Воляпредложение Конвертироватьдлянижний регистр。нас Вы можете посмотреть приезжатьслово["i", "have", "a", "new"]житьсуществовать Впричастиеустройствоиз Глоссарийсередина,нослово"gpu"Нетсуществовать Чтосередина。поэтому,причастиеустройство Воля"gpu"разделениедляизвестныйизподслово:["gp" и "##u"]。"##"выражать Оставшийсяизотметкадолжендополнительныйприезжатьвпередодининдивидуальныйотметканачальство,Нет пробела (используется для расшифровки или изменения причастия).

В качестве другого примера, XLNetTokenizer токенизирует текст нашего предыдущего примера следующим образом:

>>> from transformers import XLNetTokenizer

>>> tokenizer = XLNetTokenizer.from_pretrained("xlnet-base-cased")

>>> tokenizer.tokenize("Don't you love 🤗 Transformers? We sure do.")

["▁Don", "'", "t", "▁you", "▁love", "▁", "🤗", "▁", "Transform", "ers", "?", "▁We", "▁sure", "▁do", "."]когда мы просматриваем SentencePiece час,нас Воляразприезжать Вон те"▁"иззначение。Как видитеприезжатьиз,редкийслово"Transformers"已одеялоразделениедляболее распространенныйизподслово"Transform"и"ers"。

Сейчас Давайте посмотрим Неттакой жеизподсловное Как работает алгоритм причастия? пожалуйста, обрати внимание,Все эти алгоритмы сегментации слов основаны на той или иной форме итренироваться.,Обычно дасуществовать соответствующую Модель будет тренироваться из корпуса.

Кодирование пар байтов (BPE)

Кодирование пар байтов (BPE)дасуществоватьNeural Machine Translation of Rare Words with Subword Units (Sennrich et al., 2015)серединапредставлятьиз。BPE Полагается на предварительный токенизатор для разделения обучающих данных на слова. Предпричастия могут быть такими же простыми, как и причастия пробела, например: ГПТ-2, РОБЕРТа. Более продвинутая предварительная сегментация включает сегментацию на основе правил, например XLM,FlauBERT использовать Moses Используется в большинстве языков, или GPT использовать Spacy и ftfy, чтобы вычислить частоту каждого слова в обучающем корпусе.

существовать после предпричастия,Создан набор уникальных слов.,И была определена частота встречаемости каждого отдельного существующего слова «тренироваться» в данных. Следующий,BPE Создайте индивидуальный базовый словарь, который содержит символ «из» в уникальном наборе слов из «иметь», и изучите правила слияния базового словаря из двух индивидуальных символов, чтобы сформировать новый символ индивидуального. Это будет продолжаться до тех пор, пока словарное выражение приезжать не потребует словаря из. пожалуйста, обрати Обратите внимание, требуемый размер словаря дасуществоватьтренироваться токенизатором определяется перед индивидуальными гиперпараметрами.

Подниматьиндивидуальныйпример,Предположим, что после существования причастия,Выявлены следующие наборы слов, содержащих частоту из:

("hug", 10), ("pug", 5), ("pun", 12), ("bun", 4), ("hugs", 5)поэтому,базовыйслово汇да["b", "g", "h", "n", "p", "s", "u"]。Воля Местоиметьсловоразделениедлябазовыйслово汇изсимвол,Нам удалось добраться: