Технология распределенной обработки данных и машинного обучения на основе Spark [Shangjin Xiaocaizhu Big Data]

Маленький мотивированный новичок, специализирующийся на разработке программного обеспечения в Шэньянском технологическом университете. Он любит программировать и постоянно выдает полезную информацию.

Большие данные стали важным ресурсом и проблемой в современном обществе. Поскольку масштаб данных продолжает расти, ключевым вопросом становится то, как эффективно обрабатывать и анализировать эти данные. В этой статье будет представлена технология распределенной обработки данных и машинного обучения на основе Apache Spark, а также показано, как использовать Spark для обработки крупномасштабных наборов данных и выполнения сложных задач машинного обучения. Мы подробно обсудим основные концепции, архитектуру и модель программирования Spark, а также предоставим пример кода, иллюстрирующий его применение в области больших данных.

1. Введение

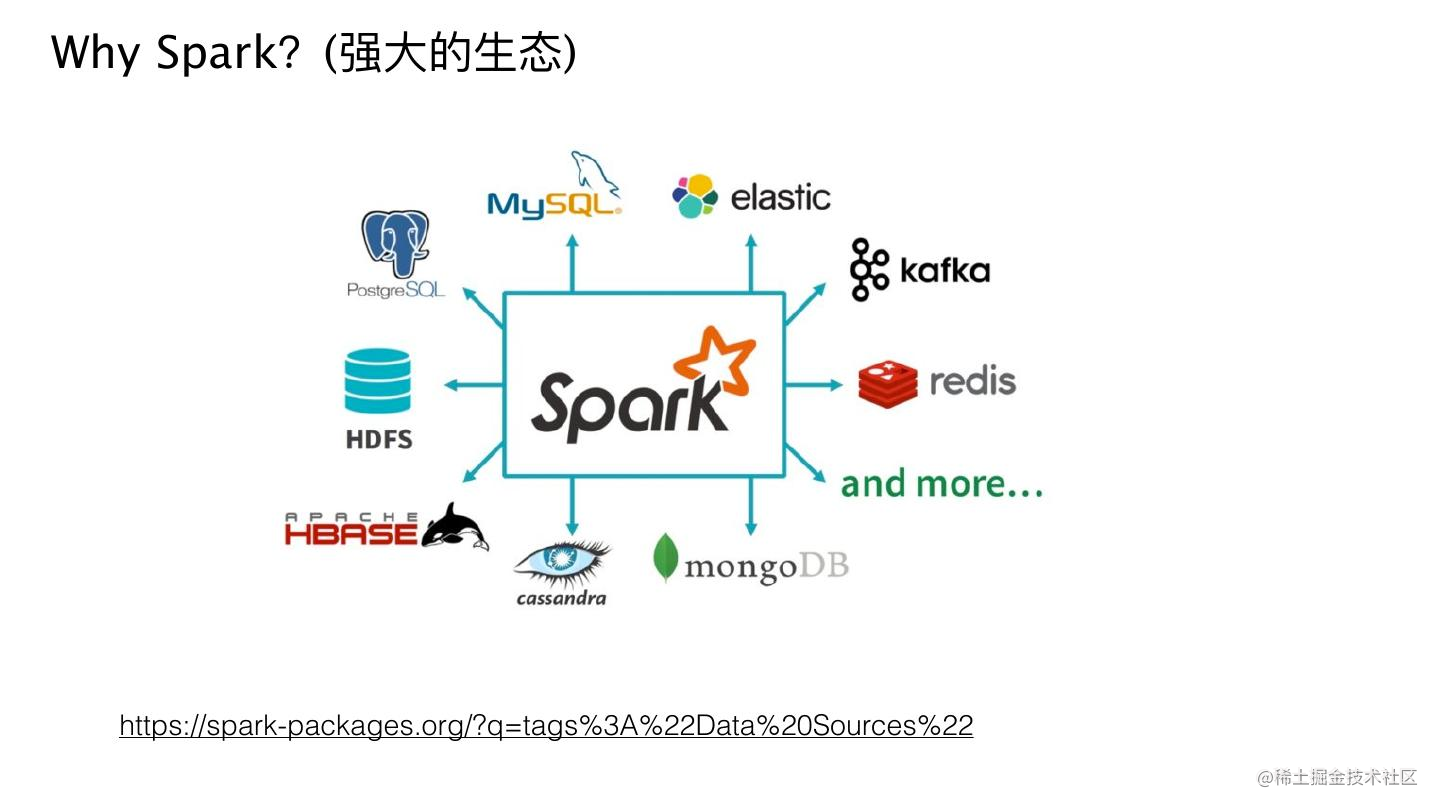

За последние несколько лет технологии больших данных добились огромного прогресса. Традиционные инструменты и методы обработки данных больше не способны обрабатывать растущий объем и сложность данных. В этом случае появились платформы распределенных вычислений, такие как Apache Spark. Spark предоставляет эффективный и масштабируемый способ обработки и анализа крупномасштабных наборов данных и поддерживает широкий спектр задач обработки данных и алгоритмов машинного обучения.

2. Базовые концепции и архитектура Spark

Spark — это платформа распределенных вычислений на основе памяти, которая гибко обрабатывает данные и выполняет вычисления в памяти, тем самым значительно повышая скорость обработки. Основная концепция Spark — отказоустойчивый распределенный набор данных (сокращенно RDD). RDD — это неизменяемая коллекция распределенных объектов, с которыми можно работать параллельно и выполнять распределенные вычисления на нескольких узлах.

Архитектура Spark в основном состоит из драйверов, менеджеров кластеров и исполнителей. Драйверы отвечают за распределение задач между исполнителями, которые выполняют фактические вычислительные задачи на узлах кластера. Менеджер кластера отвечает за управление распределением ресурсов и планирование задач всего кластера.

3. Модель программирования Spark

Spark предоставляет множество интерфейсов программирования, включая Scala, Java, Python и R. Среди них Scala является основным языком разработки Spark и имеет наиболее полную функциональную поддержку. Модель программирования Spark в основном вращается вокруг RDD, который обрабатывает и вычисляет данные посредством ряда преобразований и операций действия.

Операции преобразования относятся к операциям, которые генерируют новые СДР на основе существующих СДР, такие как отображение, фильтрация и сокращение. Действие относится к операциям, которые запускают вычисления и возвращают результаты, такие как подсчет, сбор, сохранение и т. д.

Вот пример кода, использующего Spark для обработки данных:

import org.apache.spark._

import org.apache.spark.rdd.RDD

val conf = new SparkConf().setAppName("WordCount")

val sc = new SparkContext(conf)

val inputRDD: RDD[String] = sc.textFile("input.txt")

val wordsRDD: RDD[String] = inputRDD.flatMap(line => line.split(" "))

val wordCountRDD: RDD[(String, Int)] = wordsRDD.map(word => (word, 1)).reduceByKey(_ + _)

wordCountRDD.saveAsTextFile("output.txt")

sc.stop()Приведенный выше код реализует простую задачу подсчета частоты слов. первый,проходитьtextFileметод загружает входной текстовый файл какRDD。Затем,использоватьflatMapМетод разбивает каждую строку на слова,и сгенерируйте новый RDD. Следующий,проходитьmapиreduceByKeyМетод подсчета количества вхождений каждого слова。наконец,использоватьsaveAsTextFileМетод сохраняет результаты в выходной файл。

4. Применение Spark в машинном обучении

Помимо обработки данных, Spark также широко используется в сфере машинного обучения. Spark предоставляет библиотеку машинного обучения под названием MLlib, которая содержит множество распространенных алгоритмов и инструментов машинного обучения. MLlib поддерживает распределенную обработку данных и обучение моделей, а также может обрабатывать крупномасштабные наборы данных.

Вот пример кода для использования Spark для задачи классификации:

import org.apache.spark._

import org.apache.spark.ml.classification.{LogisticRegression, LogisticRegressionModel}

import org.apache.spark.ml.feature.{VectorAssembler, StringIndexer}

import org.apache.spark.sql.{SparkSession, DataFrame}

val spark = SparkSession.builder().appName("SparkML").getOrCreate()

val data: DataFrame = spark.read.format("csv").option("header", "true").load("data.csv")

val labelIndexer = new StringIndexer().setInputCol("label").setOutputCol("indexedLabel").fit(data)

val assembler = new VectorAssembler().setInputCols(Array("feature1", "feature2", "feature3")).setOutputCol("features")

val dataset = assembler.transform(labelIndexer.transform(data))

val lr = new LogisticRegression().setMaxIter(10).setRegParam(0.01)

val model: LogisticRegressionModel = lr.fit(dataset)

val testSet: DataFrame = spark.read.format("csv").option("header", "true").load("test.csv")

val testDataset = assembler.transform(labelIndexer.transform(testSet))

val predictions = model.transform(testDataset)

predictions.show()

spark.stop()В приведенном выше коде используется библиотека MLlib Spark для создания классификатора логистической регрессии. первый,проходитьcsvФормат для загрузки набора обучающих данных,Выполните индексацию меток и преобразование векторов объектов. Затем,использоватьLogisticRegressionМодель логистической регрессии определения класса,ипроходитьfitМетоды обучения модели。Следующий,Загрузить набор тестовых данных,Выполнить преобразование вектора признаков,И делать прогнозы с помощью обученной модели. наконец,Выведите результаты прогноза.

5. Распределенные данные Spark

Технологии распределенной обработки данных и машинного обучения на базе Spark играют важную роль в сфере больших данных. Он способен обрабатывать крупномасштабные наборы данных и выполнять сложный анализ данных и задачи машинного обучения. В этой статье представлены основные концепции, архитектура и модель программирования Spark, а также приведен пример кода для демонстрации его применения на практике.

Благодаря постоянному развитию и инновациям в области больших данных, Spark как мощный инструмент продолжит играть важную роль в области больших данных. Знание технологии и модели программирования Spark предоставит больше возможностей и проблем для специалистов по обработке данных и инженеров.

6. Преимущества и проблемы Spark

Будучи мощной платформой распределенных вычислений, Spark имеет множество преимуществ в области больших данных, но также сталкивается с некоторыми проблемами.

6.1 Преимущества

- высокая производительность:SparkИспользуйте вычисления в памятиии行处理изхарактеристика,Он может обеспечить высокую скорость вычислений при обработке крупномасштабных данных. По сравнению с традиционными методами чтения и записи диска,SparkВычислительная мощность в памяти значительно ускоряется Обработка данные и скорость анализа.

- Простота использования:SparkОбеспечивает простой и последовательный интерфейс программирования.,Предоставьте разработчикам возможность быстро приступить к работе. Используете ли вы Scala, Java, Python или R,Оба могут легко писать приложения Spark.

- Масштабируемость:Sparkизраспределенный Архитектура позволяетсуществовать Добавьте больше в кластериз Вычислительные ресурсы,справиться с растущим размером данных. Он может автоматически обрабатывать разделение данных и параллельные вычисления.,Это обеспечивает горизонтальное расширение.

- Универсальность:Кроме Обработка данных, Spark также предоставляет множество машинных функции обучения, графовых вычислений и потоковой обработки. Это делает Spark универсальным большим платформа обработки данных, которая может удовлетворить различные типы обработки. данныхнуждаться。

6.2 Проблемы

- Управление памятью:потому чтоSparkМногоиспользоватьпамять для ускорения вычислений,Поэтому эффективное управление памятью становится испытанием. Правильно установите параметры выделения памяти и настройки.,Ключевой задачей является полное использование доступных ресурсов и предотвращение переполнения памяти.

- Перекос данных:существоватьраспределенныйсреда,Перекос данные — часто задаваемый вопрос. Когда объем данных для некоторых ключей намного превышает объем данных для других ключей, это может привести к дисбалансу задач и снижению производительности. Решить Перекос данных необходимо принять соответствующие стратегии, такие как перераспределение данных, выборка и агрегирование и т. д.

- Отладка и устранение неполадок:существоватьраспределенныйв системе,Отладка и устранение неполадок становится сложнее. Поскольку задачи Spark выполняются на нескольких узлах,Обнаружение и решение проблемы может потребовать дополнительных усилий. Правильные инструменты ведения журналов, мониторинга и отладки имеют решающее значение для эффективного устранения неполадок.

- кривая обучения:для начинающих,Освоение концепций и модели программирования Spark может потребовать некоторого опыта. Знаком с такими понятиями, как RDD, операции преобразования и операции действий.,и правильное использование API и инструментов Spark.,Это требует некоторого времени и практики.

7. Заключение

В этой статье представлена технология распределенной обработки данных и машинного обучения на основе Spark. Spark предоставляет эффективный и масштабируемый способ обработки крупномасштабных наборов данных и поддерживает сложные задачи обработки данных и алгоритмы машинного обучения. Посредством демонстрации примера кода мы покажем, как использовать Spark для задач обработки данных и машинного обучения. В области больших данных освоение технологии и модели программирования Spark станет ценным навыком.

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами