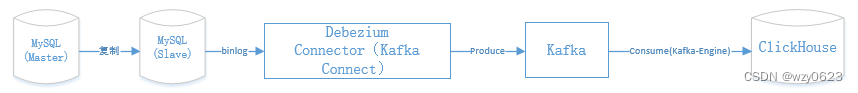

Синхронизация данных в реальном времени из MySQL в ClickHouse — табличный движок Debezium + Kafka

В этой статье рассматривается весь процесс: от MySQL в качестве источника до ClickHouse в качестве цели. Изменения базы данных MySQL фиксируются через Debezium и публикуются как события в Kafka. ClickHouse применяет эти изменения в частичном порядке через механизм таблиц Kafka в режиме реального времени, сохраняя конечную согласованность. Соответствующие версии программного обеспечения следующие:

- MySQL:8.0.16

- ClickHouse:24.1.8

- JDK:11.0.22

- zookeeper:3.9.1

- Kafka:3.7.0

- debezium-connector-mysql:2.4.2

Одним из преимуществ этого решения является то, что данные между ClickHouse и MySQL в конечном итоге могут быть строго согласованными.

1. Общая структура

Общая структура показана на рисунке ниже.

ClickHouse Это два сегмента, состоящие из четырех экземпляров, с двумя копиями каждого сегмента, а голосование и координатор используют использование. ClickHouse Входит в комплект keeper компоненты. Шардинг, реплика, хранитель узел、Кластер Zookeeper、Кластер Kafaka、Debezium-Connector-MySQL Размещение заглушки показано под поверхностью.IP | имя хоста | роль экземпляра | ClickHouse Keeper | Zookeeper | Kafka | Debezium Connector MySQL |

|---|---|---|---|---|---|---|

172.18.4.126 | node1 | Осколок 1 реплика 1 | * | | | |

172.18.4.188 | node2 | Осколок 1 Реплика 2 | * | * | * | * |

172.18.4.71 | node3 | Осколок 2 Реплика 1 | * | * | * | * |

172.18.4.86 | node4 | Осколок 2 Реплика 2 | | * | * | * |

два、Конфигурация установки MySQL репликация главный-подчиненный

Конфигурацияхорошийрепликация главный-подчиненныйназад,существоватьглавная библиотекасоздаватьтестовая библиотекаповерхностьи данные:-- Создайте базу данных

create database test;

-- учреждатьповерхность

create table test.t1 (

id bigint(20) not null auto_increment,

remark varchar(32) default null comment 'Ремарк',createtime timestamp not null default current_timestamp comment 'создаватьвремя', primary key (id));

-- Вставьте три фрагмента тестовых данных

insert into test.t1 (remark) values («Первая строка: строка1»), («Вторая строка: строка2»), («Третья строка: строка3»);

commit;три、Конфигурация установки ClickHouse кластер

Четыре、Установить JDK

пять、Конфигурация установки Zookeeper кластер

шесть、Конфигурация установки Kafaka кластер

7. Установите и настройте плагин Debezium-Connector-MySQL.

существовать node2 Выполните следующие шаги.1. Создайте каталог плагина.

mkdir $KAFKA_HOME/plugins2. Разархивируйте файл в директорию плагина.

cd ~

# debezium-connector-mysql

unzip debezium-debezium-connector-mysql-2.4.2.zip -d $KAFKA_HOME/plugins/3. Настройте коннектор Kafka

(1) Файл свойств конфигурации

# Сначала сделайте резервную копию

cp $KAFKA_HOME/config/connect-distributed.properties $KAFKA_HOME/config/connect-distributed.properties.bak

# редактировать connect-distributed.properties документ

vim $KAFKA_HOME/config/connect-distributed.properties Содержание следующее:bootstrap.servers=node2:9092,node3:9092,node4:9092

group.id=connect-cluster

key.converter=org.apache.kafka.connect.json.JsonConverter

value.converter=org.apache.kafka.connect.json.JsonConverter

key.converter.schemas.enable=false

value.converter.schemas.enable=false

offset.storage.topic=connect-offsets

offset.storage.replication.factor=3

offset.storage.partitions=3

config.storage.topic=connect-configs

config.storage.replication.factor=3

status.storage.topic=connect-status

status.storage.replication.factor=3

status.storage.partitions=3

offset.flush.interval.ms=10000

plugin.path=/root/kafka_2.13-3.7.0/plugins(2) Распределить по другим узлам

scp $KAFKA_HOME/config/connect-distributed.properties node3:$KAFKA_HOME/config/

scp $KAFKA_HOME/config/connect-distributed.properties node4:$KAFKA_HOME/config/

scp -r $KAFKA_HOME/plugins node3:$KAFKA_HOME/

scp -r $KAFKA_HOME/plugins node4:$KAFKA_HOME/(3) Запустите Kafka Connect в распределенном режиме.

connect-distributed.sh -daemon $KAFKA_HOME/config/connect-distributed.properties

# Проверьте, есть ли журнал ERROR

grep ERROR ~/kafka_2.13-3.7.0/logs/connectDistributed.out(4) Подтвердите плагин соединителя и автоматически созданную тему.

Проверятьразъемплагин:curl -X GET http://node2:8083/connector-plugins | jq от Вы можете увидеть приезжать, Кафка на выходе connect Уже признано приезжать MySqlConnector source плагин:[root@vvml-yz-hbase-test~]#curl -X GET http://node2:8083/connector-plugins | jq

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

100 403 100 403 0 0 3820 0 --:--:-- --:--:-- --:--:-- 3838

[

{

"class": "io.debezium.connector.mysql.MySqlConnector",

"type": "source",

"version": "2.4.2.Final"

},

{

"class": "org.apache.kafka.connect.mirror.MirrorCheckpointConnector",

"type": "source",

"version": "3.7.0"

},

{

"class": "org.apache.kafka.connect.mirror.MirrorHeartbeatConnector",

"type": "source",

"version": "3.7.0"

},

{

"class": "org.apache.kafka.connect.mirror.MirrorSourceConnector",

"type": "source",

"version": "3.7.0"

}

]

[root@vvml-yz-hbase-test~]# Проверять topic:kafka-topics.sh --list --bootstrap-server node2:9092,node3:9092,node4:9092 от Вы можете увидеть приезжать, Кафка на выходе connect Автоматически создавать при запуске connect-configs、connect-offsets、connect-status три topic:[root@vvml-yz-hbase-test~]#kafka-topics.sh --list --bootstrap-server node2:9092,node3:9092,node4:9092

__consumer_offsets

connect-configs

connect-offsets

connect-status

[root@vvml-yz-hbase-test~]#4. Создайте исходный соединитель

(1) Три необходимые инструкции по настройке Дебезиума

Debezium это хорошо известное средство для чтения и синтаксического анализа. MySQL Binlog инструменты. это будет KafkaConnect Интегрируйте в качестве соединителя и Kafka Тема меняется каждый раз.- Записывайте только статус сообщения

По умолчанию Дебезиум Пойду в Kafka Выдавать предварительное и пост-состояние каждой записи для каждого действия, что сложно ClickHouse Kafka поверхностьанализировать。также,существоватьосуществлятьудалитьдействоватьслучай(Clickhouse Также не может быть разобран), он создаст tombstone записать, то есть иметь Null запись стоимости. Следующая поверхность демонстрирует такое поведение.действовать | действоватьвперед | действоватьназад | Дополнительные записи |

|---|---|---|---|

Create | Null | новый рекорд | - |

Update | Записи до обновления | Обновленные записи | - |

Delete | Удалить предыдущие записи | Null | записи надгробия |

существовать Debezium Конфигурацияпосланникиспользовать ExtractNewRecod конвертер для решения этой проблемы. Благодаря этому варианту Дебезиум Зарезервировано только для создателя/Обновлениядействовать after статус и игнорировать before состояние. Но недостатком является то, что он удаляет Delete запись и запись надгробия, другими словами, больше не захватывать и не удалять действия. Далее объясните, как решить эту проблему."transforms": "unwrap",

"transforms.unwrap.type": "io.debezium.transforms.ExtractNewRecordState"- Переопределить событие удаления

Чтобы отследить удаление действия, необходимо добавить переопределение Конфигурация, как показано ниже:"transforms.unwrap.delete.handling.mode":"rewrite" Debezium Makeusethis Конфигурация добавить поля \_\_deleted, для delete действоватьдля правда, для других действий ЛОЖЬ. Таким образом, удаление будет содержать предыдущее состояние, а также \_\_deleted:true поле.- Обработка обновлений непервичного ключа

существовать Предоставьте вышеуказанное Конфигурацияслучай,Обновить запись(Каждый столбец, кроме первичного ключа)выпустит новыйсостояниепростоты Записывать.в целомсуществоватьв системе реляционных баз данных,Обновленные записи заменят предыдущую запись.,носуществовать ClickHouse нет. Из соображений производительности ClickHouse Воляобновление уровня строкидля Вставка нескольких версий。существовать В этом примере,MySQL в test.t1 поверхностьк id Столбец как первичный ключ, если он обновлен. remark Список,существовать ClikHouse , вы в конечном итоге получите дублирующиеся записи, что означает id То же самое, но remark другой! К счастью, есть способы справиться с этой ситуацией. По умолчанию Дебезиум Будет одна запись удаления и одна запись, используемая для обновления первичного ключа. Итак, если источник обновлен id, он выдаст идентификатор с предыдущим id удаленных записей и одна с новыми id создать запись. с \_\_deleted=ture Предыдущая запись для поля будет заменена. CH в stall Записывать.Ранназад,Можетсуществовать Фильтрация подсказок в представленияхудалитьиз Записывать.Можетделатьиспользоватьк下选项Воля Эта поездкадля Расширятьприезжатьдругой Список:"message.key.columns": "test.t1:id;test.t1:remark;test.t1:createtime"Уведомление:

нужно изменить ключевой столбец коннектора Дебезиум Воля Эти Списокиспользоватькак первичный ключ,Вместо первичного ключа исходной поверхности по умолчанию. поэтому,ибаза данныхизсвязанный с записьюиздругойдействоватьможет со временем появитьсясуществовать Kafka в Другие разделы。из-за записисуществовать Потеря порядка в разных разделах,если не обеспечено ClickHouse Последовательная ключевая сумма Debezium ключи сообщений одинаковы, в противном случае это может привести к Clikchouse в Данные непоследовательный.Эмпирическое правило заключается в следующем:

- Создайте ключ раздела и ключ сортировки в соответствии с желаемой структурой таблицы.

- Извлеките источник ключей разделения и сортировки, предполагая, что они вычисляются во время материализации.

- Объедините все эти столбцы.

- Определите результат шага 3 как message.column.keys в конфигурации соединителя Debezium.

- Проверьте, содержит ли ключ сортировки Clickhouse все эти столбцы. Если нет, то добавьте их.

сейчассуществовать,проходить Совместите все вышеперечисленные варианты с обычнымииспользоватьопцион путсуществовать Вместе,Будет иметь полнофункциональную конфигурацию Debezium., способная обрабатывать ClickHouse Требуются любые изменения.(2) Создайте исходный файл конфигурации MySQL.

# редактироватьдокумент

vim $KAFKA_HOME/plugins/source-mysql.json Содержание следующее:{

"name": "mysql-source-connector",

"config": {

"connector.class": "io.debezium.connector.mysql.MySqlConnector",

"database.hostname": "172.18.16.156",

"database.port": "3307",

"database.user": "dba",

"database.password": "123456",

"database.server.id": "1563307",

"database.server.name": "dbserver1",

"database.include.list": "test",

"table.include.list": "test.t1",

"topic.prefix": "mysql-clickhouse-test",

"schema.history.internal.kafka.bootstrap.servers": "node2:9092,node3:9092,node4:9092",

"schema.history.internal.kafka.topic": "schemahistory.mysql-clickhouse-test",

"message.key.columns": "test.t1:id;test.t1:remark;test.t1:createtime",

"transforms":"unwrap",

"transforms.unwrap.type": "io.debezium.transforms.ExtractNewRecordState",

"transforms.unwrap.delete.handling.mode": "rewrite"

}

}(3) Создайте исходный соединитель MySQL.

# создавать connector

curl -X POST -H 'Content-Type: application/json' -i 'http://node2:8083/connectors' -d @"/root/kafka_2.13-3.7.0/plugins/source-mysql.json"; echo

# Проверять connector состояние

curl -X GET http://node2:8083/connectors/mysql-source-connector/status | jq

# Проверять topic

kafka-topics.sh --list --bootstrap-server node2:9092,node3:9092,node4:9092 от Вы можете увидеть приезжать, mysql-source-connector в выводе состояниедля RUNNING,И автоматически создаётся три topic:[root@vvml-yz-hbase-test~]#curl -X POST -H 'Content-Type: application/json' -i 'http://node2:8083/connectors' -d @"/root/kafka_2.13-3.7.0/plugins/source-mysql.json"; echo

HTTP/1.1 201 Created

Date: Thu, 25 Apr 2024 03:47:26 GMT

Location: http://node2:8083/connectors/mysql-source-connector

Content-Type: application/json

Content-Length: 818

Server: Jetty(9.4.53.v20231009)

{"name":"mysql-source-connector","config":{"connector.class":"io.debezium.connector.mysql.MySqlConnector","database.hostname":"172.18.16.156","database.port":"3307","database.user":"dba","database.password":"123456","database.server.id":"1563307","database.server.name":"dbserver1","database.include.list":"test","table.include.list":"test.t1","topic.prefix":"mysql-clickhouse-test","schema.history.internal.kafka.bootstrap.servers":"node2:9092,node3:9092,node4:9092","schema.history.internal.kafka.topic":"schemahistory.mysql-clickhouse-test","message.key.columns":"test.t1:id;test.t1:remark;test.t1:createtime","transforms":"unwrap","transforms.unwrap.type":"io.debezium.transforms.ExtractNewRecordState","transforms.unwrap.delete.handling.mode":"rewrite","name":"mysql-source-connector"},"tasks":[],"type":"source"}

[root@vvml-yz-hbase-test~]#curl -X GET http://node2:8083/connectors/mysql-source-connector/status | jq

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

100 182 100 182 0 0 24045 0 --:--:-- --:--:-- --:--:-- 26000

{

"name": "mysql-source-connector",

"connector": {

"state": "RUNNING",

"worker_id": "172.18.4.188:8083"

},

"tasks": [

{

"id": 0,

"state": "RUNNING",

"worker_id": "172.18.4.188:8083"

}

],

"type": "source"

}

[root@vvml-yz-hbase-test~]#kafka-topics.sh --list --bootstrap-server node2:9092,node3:9092,node4:9092

__consumer_offsets

connect-configs

connect-offsets

connect-status

mysql-clickhouse-test

mysql-clickhouse-test.test.t1

schemahistory.mysql-clickhouse-test

[root@vvml-yz-hbase-test~]#8. Создавайте библиотечные таблицы, материализованные представления и представления в ClickHouse

ClickHouse Можетвыгодаиспользовать Kafka настольный движок Воля Kafka Пластинки помещены в поверхность. Необходимо определить три объекта: Kafka поверхность, основная поверхность и материализованный вид потребителя.1. Создайте базу данных

create database db2 on cluster cluster_2S_2R;2. Создайте таблицу Кафки.

CREATE TABLE db2.kafka_t1 on cluster cluster_2S_2R

(

`id` Int64,

`remark` Nullable(String),

`createtime` String,

`__deleted` String

)

ENGINE = Kafka('node2:9092,node3:9092,node4:9092', 'mysql-clickhouse-test.test.t1', 'clickhouse', 'JSONEachRow');3. Создайте основную таблицу.

Основная поверхность имеет исходную структуру и \_\_deleted поле. Слово «использовать» здесь ReplicationReplacingMergeTree, поскольку удаленные или обновленные записи необходимо заменить. stall Записывать.-- создаватьместныйповерхность

CREATE TABLE db2.stream_t1 on cluster cluster_2S_2R

(

`id` Int64,

`remark` Nullable(String),

`createtime` timestamp,

`__deleted` String

)

ENGINE = ReplicatedReplacingMergeTree(

'/clickhouse/tables/{shard}/db2/t1',

'{replica}'

)

ORDER BY (id, createtime)

SETTINGS index_granularity = 8192;

-- создать распределенную поверхность с первичным ключом исходной поверхности id Как ключ шардинга, он гарантированно будет таким же id изпадение данныхсуществовать На том же осколке

create table db2.t1_replica_all on cluster cluster_2S_2R

as db2.stream_t1

engine = Distributed(cluster_2S_2R, db2, stream_t1, id);4. Создайте материализованное представление для потребителя

существоватьсоздаватьматериализованный видвперед,Сначала остановите библиотеку MySQLот копировать. от библиотеки стоп копировать,Не влияет на нормальное использование основной библиотеки.,На бизнес это не повлияет. в это времяот Библиотекаиз Данные находятся в состоянии покоясостояние,без изменений,Это упрощает получение существующих данных.。Ранназадсоздаватьматериализованный вид时会自动Воля Запись данных db2.t1\_replica\_all переписыватьсяизместныйповерхностьсередина。Изназадсуществовать ClickHouse кластервв любом случае,Все могутотматериализованный видсередина Запросприезжатьпоследовательныйиз MySQL Данные о запасах.-- MySQL отбиблиотека остановленакопировать

stop slave; Kafka Каждая запись поверхности считывается только один раз, поскольку ее потребительская группа изменит смещение и не может быть прочитана дважды. Поэтому необходимо определить основную поверхность и приложить к каждой материализованный вид. Kafka поверхностьматериализация записиприезжатьэто:-- Обратите внимание на обработку временных меток

CREATE MATERIALIZED VIEW db2.consumer_t1 on cluster cluster_2S_2R

TO db2.t1_replica_all

(

`id` Int64,

`remark` Nullable(String),

`createtime` timestamp,

`__deleted` String

) AS

SELECT id, remark, addHours(toDateTime(substring(createtime,1,length(createtime)-1)),8) createtime, __deleted FROM db2.kafka_t1;5. Создайте представление

Наконец, каждую удаленную запись необходимо фильтровать.,и иметь последние записи,В случае, если разные записи имеют один и тот же ключ сортировки. Для этого неявно можно определить простое представление:CREATE VIEW db2.t1 on cluster cluster_2S_2R

(

`id` Int64,

`remark` Nullable(String),

`createtime` String,

`__deleted` String

) AS

SELECT *

FROM db2.consumer_t1

FINAL

WHERE __deleted = 'false';6. Проверка

от clickhouse Просмотрите данные инвентаризации запроса:vvml-yz-hbase-test.172.18.4.126 :) select * from db2.t1;

SELECT *

FROM db2.t1

Query id: 2a51fd5e-6b4f-4b78-b522-62b7be32535b

┌─id─┬─remark───────┬─createtime──────────┬─__deleted─┐

│ 2 │ Вторая строка: строка2 │ 2024-04-25 11:51:07 │ false │

└────┴──────────────┴─────────────────────┴───────────┘

┌─id─┬─remark───────┬─createtime──────────┬─__deleted─┐

│ 1 │ Первая строка: строка1 │ 2024-04-25 11:51:07 │ false │

│ 3 │ Третий ряд: ряд3 │ 2024-04-25 11:51:07 │ false │

└────┴──────────────┴─────────────────────┴───────────┘

3 rows in set. Elapsed: 0.007 sec.

vvml-yz-hbase-test.172.18.4.126 :) Вы можете увидеть, куда приезжать, данные о запасах были MySQL синхронный.-- MySQL Изменить данные в основной базе данных

insert into test.t1 (remark) values («Четвертая строка: строка4»);

update test.t1 set remark = 'Пятая строка: row5' where id = 4;

delete from test.t1 where id =1;

insert into test.t1 (remark) values («Шестая строка: строка6»);

-- MySQL от стартапа библиотеки копировать

начинать slave; в это время MySQL Данные следующие:mysql> select * from test.t1;

+----+------------------+---------------------+

| id | remark | createtime |

+----+------------------+---------------------+

| 2 | Вторая строка: строка2 | 2024-04-25 11:51:07 |

| 3 | Третий ряд: ряд3 | 2024-04-25 11:51:07 |

| 4 | Пятый ряд: row5 | 2024-04-25 11:56:29 |

| 5 | Ряд 6: ряд6 | 2024-04-25 11:56:29 |

+----+------------------+---------------------+

4 rows in set (0.00 sec) от clickhouse Просмотр запроса для дополнительных данных:vvml-yz-hbase-test.172.18.4.126 :) select * from db2.t1;

SELECT *

FROM db2.t1

Query id: b34bb37b-091b-490e-b55b-a0e9eedf5573

┌─id─┬─remark───────┬─createtime──────────┬─__deleted─┐

│ 2 │ Вторая строка: строка2 │ 2024-04-25 11:51:07 │ false │

└────┴──────────────┴─────────────────────┴───────────┘

┌─id─┬─remark───────┬─createtime──────────┬─__deleted─┐

│ 4 │ Пятый ряд: row5 │ 2024-04-25 11:56:29 │ false │

└────┴──────────────┴─────────────────────┴───────────┘

┌─id─┬─remark───────┬─createtime──────────┬─__deleted─┐

│ 3 │ Третий ряд: ряд3 │ 2024-04-25 11:51:07 │ false │

└────┴──────────────┴─────────────────────┴───────────┘

┌─id─┬─remark───────┬─createtime──────────┬─__deleted─┐

│ 5 │ Ряд 6: ряд6 │ 2024-04-25 11:56:29 │ false │

└────┴──────────────┴─────────────────────┴───────────┘

4 rows in set. Elapsed: 0.008 sec.

vvml-yz-hbase-test.172.18.4.126 :) Вы можете увидеть, как добраться, дополнительные данные были MySQL синхронный,сейчассуществоватьот ClickHouse Просмотр данных запроса и MySQL последовательный. Проверять Kafka Потребление:kafka-consumer-groups.sh --bootstrap-server node2:9092,node3:9092,node4:9092 --describe --group clickhouse Вывод следующий:[root@vvml-yz-hbase-test~]#kafka-consumer-groups.sh --bootstrap-server node2:9092,node3:9092,node4:9092 --describe --group clickhouse

GROUP TOPIC PARTITION CURRENT-OFFSET LOG-END-OFFSET LAG CONSUMER-ID HOST CLIENT-ID

clickhouse mysql-clickhouse-test.test.t1 0 8 8 0 ClickHouse-vvml-yz-hbase-test.172.18.4.126-db2-kafka_t1-26e6aa8e-1f08-4491-8af7-f1822f1a7e94 /172.18.4.126 ClickHouse-vvml-yz-hbase-test.172.18.4.126-db2-kafka_t1

[root@vvml-yz-hbase-test~]# Вы можете увидеть приезжать, смещение последнего использованного сообщения - 8, MySQL Запасы и дополнительные данные обновлены. Kafka Сообщение синхронизировано приезжать ClickHouse。ссылка:

- Apply CDC from MySQL to ClickHouse

- New Record State Extraction

- на основе HBase & Phoenix Создайте хранилище данных в реальном времени (5)—— использовать Kafka Connect Выполняйте синхронизацию данных в реальном времени

- Практика хранения данных Greenplum в реальном времени (5) – синхронизация данных в реальном времени

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами