SiMBA: модель прогнозирования на основе Mamba для изображений и многомерных временных рядов

Это новая статья, опубликованная 26 марта. Исследователи Microsoft упростили архитектуру на основе мамбы, применили ее как к изображениям, так и к временным рядам и добились хороших результатов.

Разработка языковых моделей меняется от больших языковых моделей (LLM) к малым языковым моделям (SLM). Ядром llm и slm являются преобразователи, которые являются строительными блоками llm и slm. Хотя трансформаторы продемонстрировали превосходную производительность во всех областях благодаря своим сетям внимания, внимание страдает от ряда проблем, включая низкое индуктивное смещение и квадратичную сложность с длиной входной последовательности.

Модели пространства состояний (SSM) менее эффективны при моделировании информационно-емких данных, особенно в таких областях, как компьютерное зрение, и сталкиваются с проблемами в дискретных сценариях, таких как геномные данные. Чтобы решить проблему, заключающуюся в том, что типичным моделям в пространстве состояний трудно эффективно обрабатывать длинные последовательности, недавно была предложена технология выборочного моделирования последовательностей в пространстве состояний Mamba. Однако у Mamba есть проблемы со стабильностью. При распространении на большие сети с наборами данных компьютерного зрения потери при обучении не сходятся.

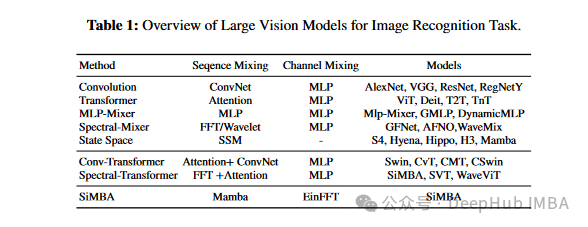

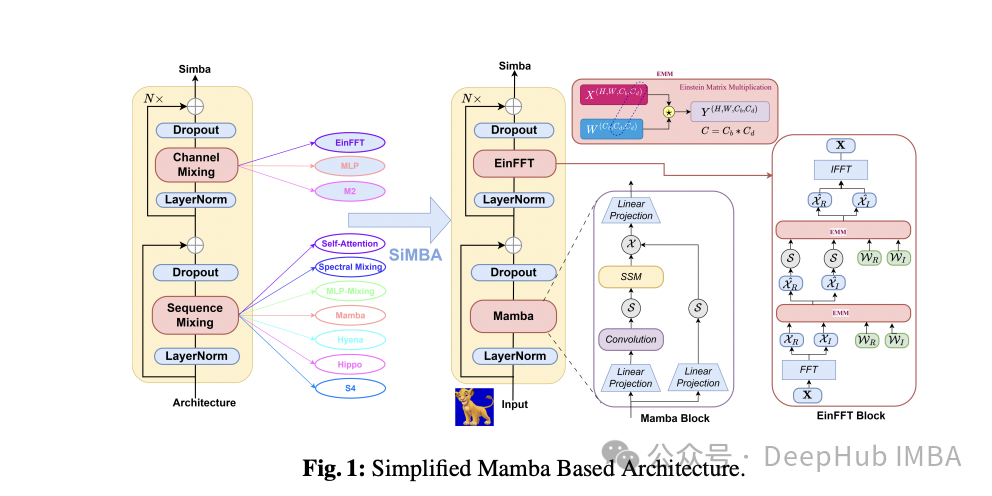

Исследователи из Microsoft представили SiMBA, новую архитектуру, которая использует EinFFT для моделирования каналов. Архитектура SiMBA использует Mamba для моделирования последовательностей и представляет EinFFT как новую технологию моделирования каналов. Эффективно решает проблемы нестабильности, наблюдаемые в Mamba при масштабировании на крупные сети. В этом подходе выделяются различные модели, основанные на сверточных моделях, моделях преобразователей, смесителях MLP, моделях спектральных смесителей и методах пространства состояний. В статье также представлены гибридные модели, сочетающие свертки с преобразователями или спектральные методы.

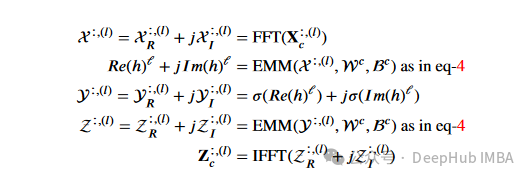

Смешение каналов SiMBA состоит из трех основных компонентов: спектрального преобразования, сети стробирования спектра с использованием умножения матрицы Эйнштейна и обратного спектрального преобразования. EinFFT использует смешивание каналов в частотной области, применяя умножение матрицы Эйнштейна к комплексному представлению. Это позволяет извлекать ключевые закономерности данных с улучшенной глобальной видимостью и концентрацией энергии. Mamba в сочетании с MLP для микширования каналов может компенсировать разрыв в производительности в небольших сетях, но те же проблемы со стабильностью могут возникнуть и в крупномасштабных сетях. В сочетании с EinFFT Мамба решает проблему стабильности малых и больших сетей.

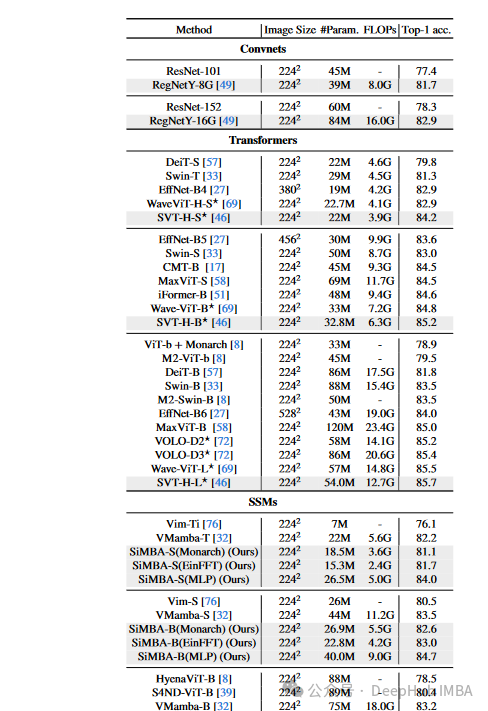

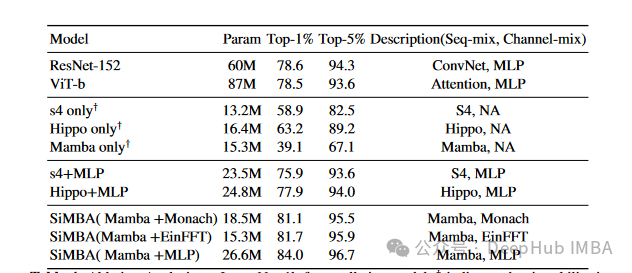

Оценка набора данных ImageNet 1K показывает, что выдающаяся производительность SiMBA достигает точности Top-1 84,0%, превосходя по производительности хорошо известные сверточные сети и преобразователи.

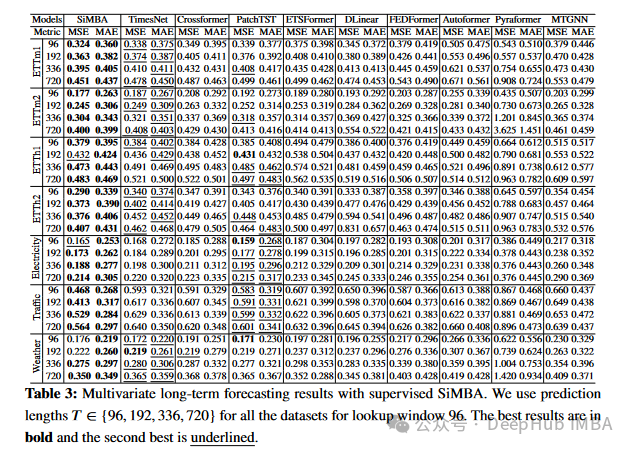

Он также демонстрирует сильные способности в долгосрочном прогнозировании с множеством переменных с использованием окна 96 запроса прогнозирования для всех наборов данных длиной 𝑇ε{96,192,336,720}.

Оценка производительности показывает превосходство SiMBA над современными моделями по различным показателям, включая среднеквадратическую ошибку (MSE) и среднюю абсолютную ошибку (MAE). Следующие результаты основаны на окне поиска размером 96 для всех наборов данных, включая новейшие методы обработки временных рядов, такие как FourierGNN, CrossGNN, TiDE, SciNet, FreTS, PatchTST.

Внедрение архитектуры SiMBA от Microsoft знаменует собой значительный прогресс в области визуального анализа и анализа временных рядов. SiMBA решает проблему стабильности, обеспечивая при этом отличную производительность по различным показателям, предоставляя беспрецедентные возможности для обработки сложных задач с данными и применяя одну модель для распознавания изображений и временных рядов. Это исследование по-прежнему очень интересно. Кроме того, официальный код очень краток, его можно загрузить и воспроизвести напрямую.

Бумажный адрес:

https://arxiv.org/abs/2403.15360

Официальный код:

https://github.com/badripatro/Simba

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами