Рекомендации по чтению и написанию ES в Spark

В этой статье представлены два способа чтения и записи ES в локальном режиме Spark.

Spark RDD читает и записывает ES

Spark Streaming записывает в ES

Экологическая подготовка

Elaticsearch-7.14.2

Spark-3.2.1

jdk-1.8

зависимость maven

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.qcloud.abi</groupId>

<artifactId>esspark</artifactId>

<version>1.0-SNAPSHOT</version>

<dependencies>

<dependency>

<groupId>com.fasterxml.jackson.core</groupId>

<artifactId>jackson-annotations</artifactId>

<version>2.14.2</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>3.2.1</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming_2.12</artifactId>

<version>3.2.1</version>

</dependency>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>2.12.8</version>

</dependency>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-reflect</artifactId>

<version>2.12.8</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-sql_2.12</artifactId>

<version>3.2.1</version>

</dependency>

<dependency>

<groupId>org.elasticsearch</groupId>

<artifactId>elasticsearch-spark-30_2.12</artifactId>

<version>7.14.2</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-network-common_2.11</artifactId>

<version>2.4.5</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-assembly-plugin</artifactId>

<configuration>

<archive>

<manifest>

<!--Укажите расположение файла записи-->

<mainClass>com.xx.TestMain</mainClass>

</manifest>

</archive>

<descriptorRefs>

<descriptorRef>

jar-with-dependencies

</descriptorRef>

</descriptorRefs>

</configuration>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<configuration>

<source>8</source>

<target>8</target>

</configuration>

</plugin>

</plugins>

</build>

</project>Spark RDD читает ES

public class ReadES {

public static void main(String[] args) {

SparkConf conf = new SparkConf().setAppName("readEs").setMaster("local[2]")

.set("es.nodes", "https://es-jnycbqnd.public.tencentelasticsearch.com")

.set("es.port", "9200")

.set("es.net.http.auth.user", "elastic")

.set("es.net.http.auth.pass", "passwd")

.set("es.nodes.wan.only", "true")

.set("es.nodes.discovery","false")

.set("es.input.use.sliced.partitions","false")

.set("es.resource", "spark_write")

.set("es.scroll.size","500");

JavaSparkContext sc = new JavaSparkContext(conf);

JavaPairRDD<String, Map<String, Object>> rdd = JavaEsSpark.esRDD(sc);

for ( Map<String, Object> item : rdd.values().collect()) {

System.out.println(item);

}

sc.stop();

}

}Чтение и запись Spark ES также поддерживает формат JSON.

//Читать напрямую

JavaPairRDD<String, Map<String, Object>> rdd = JavaEsSpark.esRDD(sc);

//Вложенный формат данных ES

{test={data=39.0, feature1=1.39, feature2=0.78, feature3=-0.83}}

//Выбираем формат JSON

JavaPairRDD<String, String> rdd = JavaEsSpark.esJsonRDD(sc);

//формат данных JSON

{"test":{"data":50.0,"feature1":1.5,"feature2":1.0,"feature3":-0.5}}Spark RDD пишет ES

public class SparkWriteEs {

public static void main(String[] args) {

//Запись данных в ES в режиме RDD

SparkConf conf = new SparkConf().setAppName("my-app").setMaster("local[2]")

.set("es.nodes", "https://es-jnycbqnd.public.tencentelasticsearch.com")

.set("es.port", "9200")

.set("es.net.http.auth.user", "elastic")

.set("es.net.http.auth.pass", "passwd")

.set("es.nodes.wan.only", "true")

.set("es.resource", "spark_write/_doc")

.set("es.nodes.discovery","false")

.set("es.input.use.sliced.partitions","false")

.set("es.scroll.size","500");

JavaSparkContext sc = new JavaSparkContext(conf);

Map<String, ?> logs = ImmutableMap.of("yesyes", "255.255.255.254",

"request", "POST /write/using_spark_rdd HTTP/1.1",

"status", 200,"size", 802,

"@timestamp", 895435190);

List<Map<String, ?>> list = ImmutableList.of(logs);

JavaRDD<Map<String, ?>> javaRDD = sc.parallelize(list);

JavaEsSpark.saveToEs(javaRDD, "spark_write/_doc");

sc.stop();

}

}Spark Streaming потребляет данные Kafka и записывает их в ES.

public class RealTime_Data {

public static void main(String[] args) throws Exception {

String master = "local[2]";

SparkConf conf = new SparkConf().setMaster(master).setAppName("StreamingTest")

.set("spark.es.nodes", "43.139.24.126")//Укажите адрес es

.set("spark.es.port", "9200")

.set("spark.es.nodes.wan.only","true");//Укажите порт es

//Указываем 5 секунд для получения данных Kafka

JavaStreamingContext jssc = new JavaStreamingContext(conf, Durations.seconds(5));

jssc.sparkContext().setLogLevel("WARN");

String brokers = "43.139.24.126:9092";

String groupId = "kafka";//идентификатор группы потребителей

String topics = "test";//topic

Set<String> topicsSet = new HashSet<>(Arrays.asList(topics.split(",")));

Map<String, Object> kafkaParams = new HashMap<>();

kafkaParams.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, brokers);

kafkaParams.put(ConsumerConfig.GROUP_ID_CONFIG, groupId);

kafkaParams.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class);

kafkaParams.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class);

//Получаем данные в течение 1 секунды и конвертируем их в rddstream

JavaInputDStream<ConsumerRecord<String, String>> messages = KafkaUtils.createDirectStream(jssc,

LocationStrategies.PreferConsistent(), ConsumerStrategies.Subscribe(topicsSet, kafkaParams));

//Получаем значение в каждом сообщении

JavaDStream<String> lines = messages.map(record -> record.value());

//Запишите его в формате, который можно будет вставить в Elasticsearch

JavaDStream<String> out = lines.map(str -> "{\"test\":"+str+"}");

//Печать

out.print();

//Запись в Elasticsearch

JavaEsSparkStreaming.saveJsonToEs(out, "/spark/doc");

//Начинаем трансляцию

jssc.start();

// Подождите, пока производитель отправит данные

jssc.awaitTermination();

jssc.stop();

}

}Вы также можете написать напрямуюESИли привести указанную структуру данныхMap<String,String>

JavaEsSparkStreaming.saveToEs(JavaDStream , "<resource>");

JavaEsSparkStreaming.saveToEsWithMeta(JavaDStream, "spark/docs", Map<String,String>());- Описание параметра

параметр | иллюстрировать |

|---|---|

es.nodes | Адрес доступа Elasticsearch |

es.port | Номер порта доступа ES 9200 |

es.net.http.auth.user | Имя пользователя ES |

es.net.http.auth.pass | Пароль пользователя ES |

es.nodes.wan.only | Следует ли выполнять прослушивание узла |

es.nodes.discovery | Отключить ли обнаружение узлов |

es.index.auto.create | Автоматически создавать индексный переключатель |

es.resource | Укажите индекс и тип для чтения и записи. |

es.mapping.names | Сопоставление имени поля таблицы и индексного поля Elasticsearch |

es.input.use.sliced.partitions | Включить ли раздел слайса |

Запускать локально

Пакет

Измените общедоступный IP-адрес в коде на внутренний IP-адрес и выберите maven. assembly pluginруководить Пакет,Загрузите пакет jar с зависимостями в EMR.,Запустите «ЧитатьES»

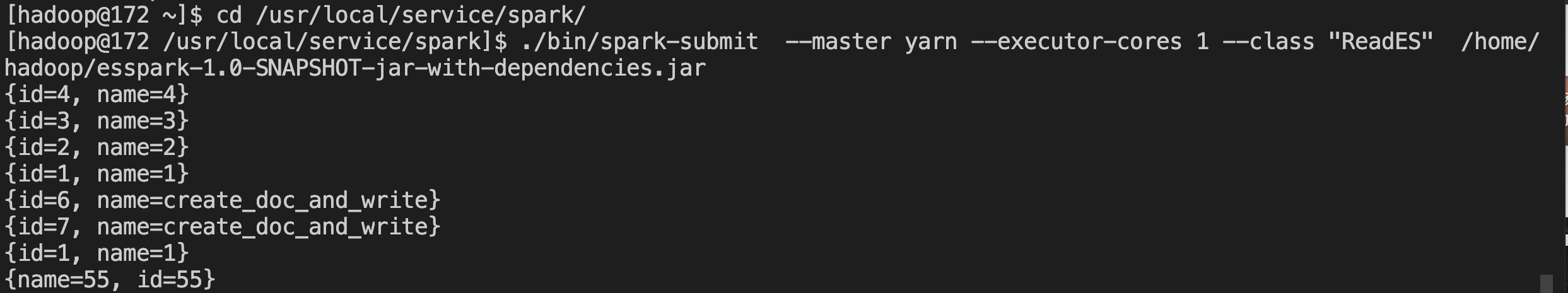

su - hadoop

cd /usr/local/service/spark

./bin/spark-submit --master yarn --executor-cores 1 --class "ReadES" /home/hadoop/esspark-1.0-SNAPSHOT-jar-with-dependencies.jar

Запустите «SparkWriteEs»

./bin/spark-submit --master yarn --executor-cores 1 --class "SparkWriteEs" /home/hadoop/esspark-1.0-SNAPSHOT-jar-with-dependencies.jarЗапросить данные по кибане

GET SparkWriteEs/_search

Краткое описание проблемы

1. После загрузки проекта Пакета появилось сообщение об ошибке, что класс не найден.

Exception in thread "main" java.lang.NoClassDefFoundError: org/elasticsearch/spark/rdd/api/java/JavaEsSpark...анализировать

Это показывает, что зависимости ESspark отсутствуют. Иллюстрировать это потому, что пакет не добавляет зависимости, что приводит к ошибкам при выполнении кода.

Решение

Используйте пакет сборки для загрузки зависимых пакетов jar.

2. Проблемы с подключением возникают при прямом доступе клиента

Cannot detect ES version - typically this happens if the network/Elasticsearch cluster is not accessible or when targeting a WAN/Cloud instance without the proper setting 'es.nodes.wan.only'...анализировать:

Доступ к общедоступному сетевому адресу ES возможен напрямую.,Параметр имени пользователя и пароля заполнен.,Проблем с заполнением параметра «es.nodes.wan.only» нет, но проблема с соединением с ES все еще существует.,Индексы не создаются,Возможно, проблема связана с версией конфигурации или пакета зависимостей.

Решение

Проблема с конфигурацией параметра ES.resource, тип Правильный пример: «spark_write/_doc» не заполнен

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами