Разработка полноценного приложения для отслеживания взгляда — версия Python

На данный момент есть несколько вариантов, ниже:

1. Электродное отслеживание глаз. Эта технология измеряет движения глаз, помещая электроды вокруг глазных яблок. Он может обеспечить очень высокую точность и разрешение, но требует контакта с глазным яблоком, поэтому не подходит для длительного использования или приложений, требующих бесконтактных измерений.

2. Инфракрасное отслеживание глаз. Эта технология использует инфракрасные камеры для наблюдения за положением и движением глаз. Поскольку он не требует контакта с глазным яблоком, он идеально подходит для длительного использования и применений, требующих бесконтактного измерения. Его точность и разрешение обычно ниже, чем у электродного отслеживания глаз.

3. Магнитно-резонансное отслеживание глаз. Эта технология использует магнитно-резонансную томографию для измерения положения и движения глазных яблок. Он обеспечивает очень высокое пространственное разрешение, но низкое временное разрешение, что делает его менее подходящим для изучения процессов быстрого движения глаз.

4. Носимое отслеживание глаз. В этой технологии используются небольшие датчики или камеры, которые можно разместить на очках или шлемах и носить с собой, что делает ее подходящей для сценариев мобильных приложений. Но из-за ограничений по размеру и весу носимых устройств их точность и разрешение часто ниже.

5. Отслеживание сетчатки: эта технология использует изображения сетчатки для отслеживания положения и движения глазных яблок. Он может обеспечить очень высокую точность и разрешение, но может использоваться только в определенных экспериментальных условиях, например, при наблюдении одного точечного источника света в темноте.

Для книги, которую я сейчас читаю, я все еще использую визуальное решение для ее реализации:

1. Извлечение признаков: выберите подходящие признаки для описания формы, цвета, текстуры и другой информации о глазах.

Например, каскадный детектор Хаара можно использовать для извлечения особенностей контура глаз, а модель распределения цвета можно использовать для извлечения особенностей цвета глазных яблок. Этот шаг в основном традиционный

2. Обнаружение объектов. Используйте технологии машинного обучения или компьютерного зрения для определения положения и направления глаз.

Поскольку прямое обнаружение цели является неточным, реальность слишком сложна. Каскадные классификаторы или машины опорных векторов (SVM) могут использоваться для определения положения и ориентации глаз, а сверточные нейронные сети (CNN) могут использоваться для классификации типов движений глаз.

3. Отслеживание и оценка: на основе результатов обнаружения используйте алгоритмы отслеживания и оценки для отслеживания положения и траектории движения глаз. Начните отслеживание на основе захвата и продолжайте захват. Используйте фильтр Калмана или фильтр частиц для оценки положения и скорости глаза или используйте алгоритм оптического потока для оценки движения глаз.

4. Анализ данных. Выполните анализ и визуализацию данных на основе результатов отслеживания глаз. Можно рассчитать такие статистические данные, как местоположение точки фиксации, продолжительность и количество фиксаций, или визуализировать данные отслеживания глаз с помощью тепловых карт и графиков траекторий. Об этом я тоже хочу написать в этот раз.

Наша главная цель здесь — напрямую обеспечить рентабельность инвестиций для снижения вычислительной мощности.

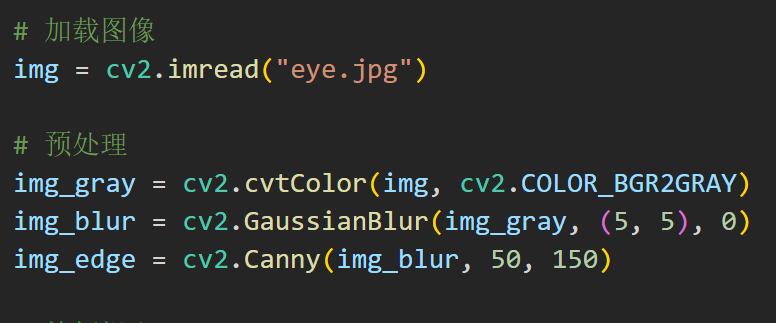

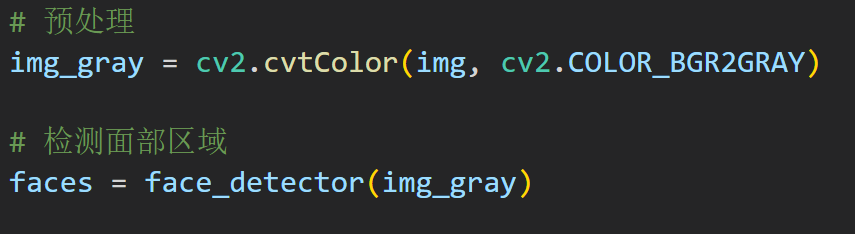

На этапе предварительной обработки сглаживание по Гауссу и обнаружение краев используются для улучшения характеристик изображения.

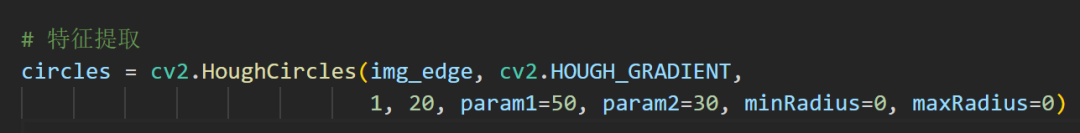

На этапе извлечения признаков круговое преобразование Хафа используется для обнаружения круговых областей.

параметр

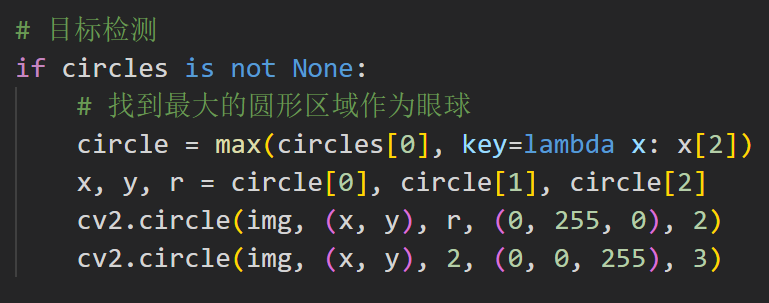

На этапе обнаружения объекта найдите самую большую круглую область, например глазное яблоко, и отметьте ее на изображении.

Это так легко, ребята!

Но эта программа слишком проста, ей просто нужны какие-то функции или что-то в этом роде, что немного глупо. На этот раз измените библиотеку:

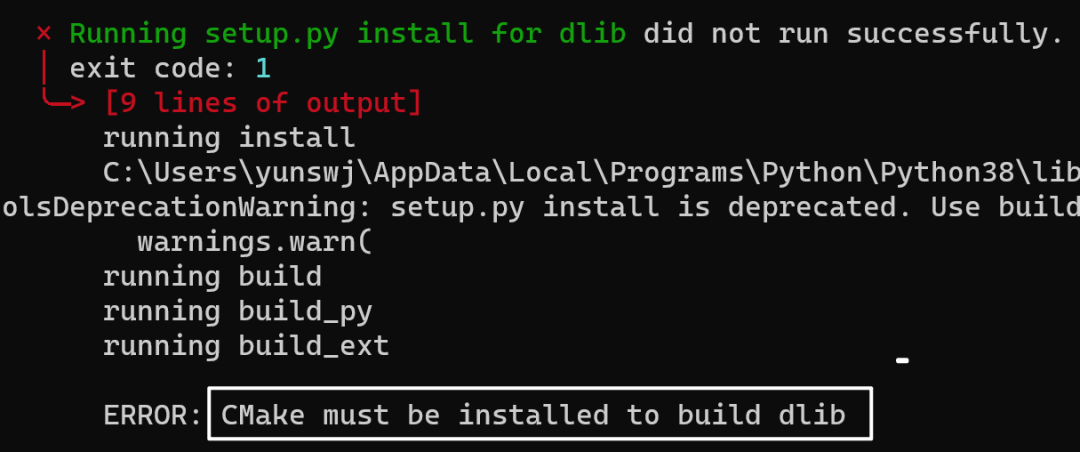

Dlib — это библиотека машинного обучения, написанная на C++, которая предоставляет алгоритмы обнаружения лиц, определения ключевых точек, оценки позы и других задач, включая алгоритмы отслеживания глаз. Dlib также предоставляет интерфейс Python, и вы можете использовать алгоритм Dlib для реализации отслеживания глаз в Python.

dlib предоставляет метод для сопоставления данных изображения лица со 128-мерным пространственным вектором. Если два изображения принадлежат одному и тому же человеку, то пространственные векторы, отображаемые двумя изображениями, будут очень близки, в противном случае они будут очень далекими. Таким образом, вы можете определить, являются ли они одним и тем же человеком, извлекая изображения и сопоставляя их со 128-мерным пространственным вектором, а затем измеряя, достаточно ли мало их евклидово расстояние. Мне не нужны люди, мне нужны только глаза.

В прошлый раз я почувствовал, что CMake раздражает глаз, и удалил его.

Не знаю, сколько еще буду ждать, но я съела апельсин.

python.exe -m pip install --upgrade pipОбновите его

Установка прошла успешно

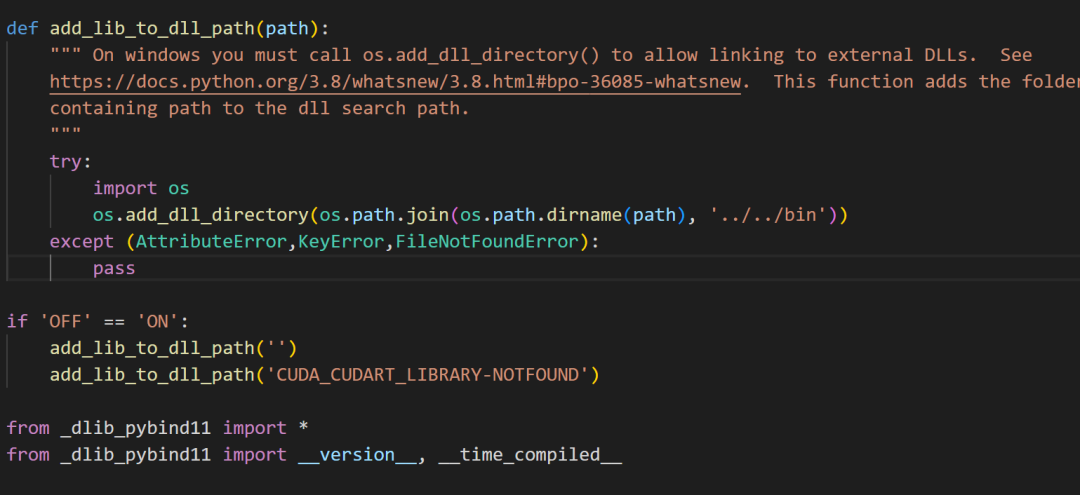

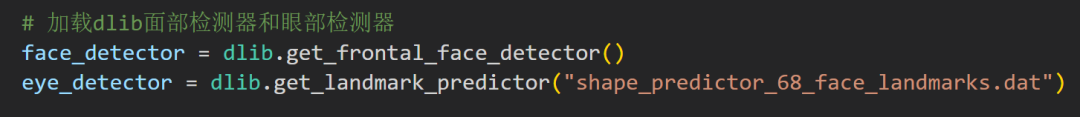

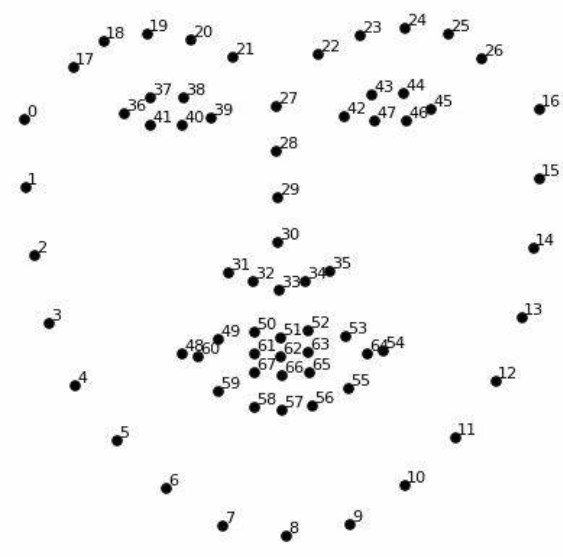

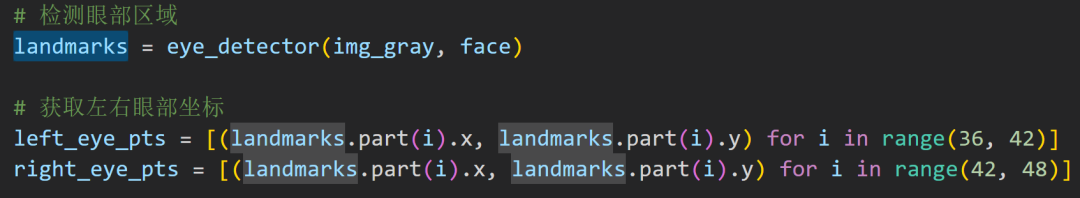

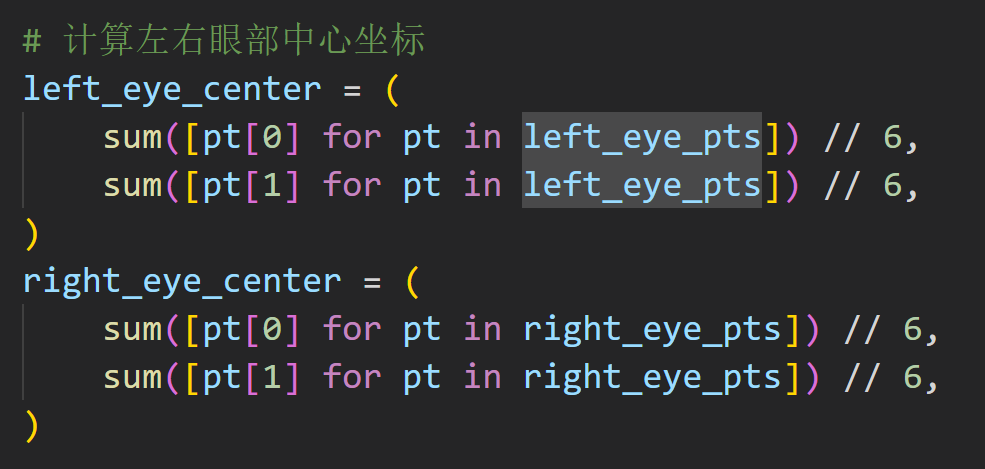

Это файл данных внутри, 68 ключевых моментов

Сначала ищите свое лицо, затем глаза, это разумно!

Просто прокрутите вниз до цвета и выполните поиск напрямую.

Библиотека dlib предоставляет две функции для обнаружения лиц.

Первый из них — линейный детектор лиц SVM HOG+, а второй — детектор лиц MMOD CNN с глубоким обучением.

В любом случае, просто посмотрите на область на лице:

Эти коды предназначены для определения положения глаз

Просто будьте в пределах досягаемости

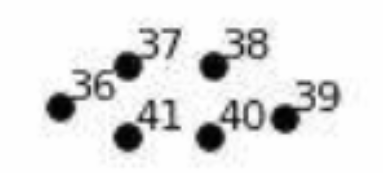

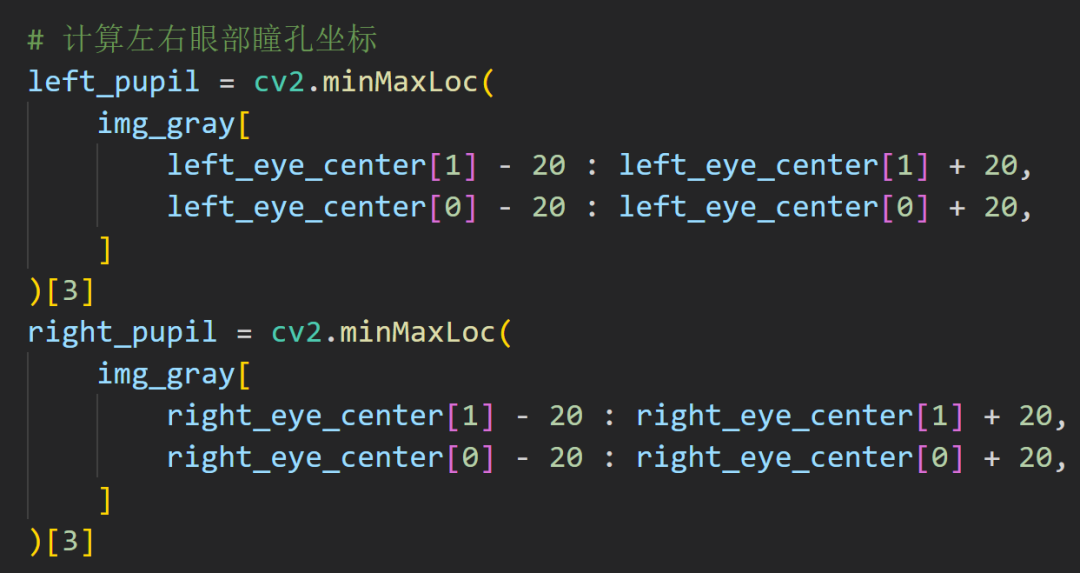

Расчет с координатами крайних значений

Потом далее дайте координаты зрачка

Между 2,0 ~ 8,0 мм

Размер зрачка относится к диаметру круглого отверстия в центре радужной оболочки.,На это влияют такие факторы, как свет, возраст, раса, статус рефракции, расстояние до цели и эмоции.,Нормальный диапазон: Между 2,0 ~ 8,0 мм. Зрачки сужаются при ярком свете,расширяться во тьме,Это нормальная физиологическая реакция человеческого организма. Непостоянный размер зрачков или аномальная реакция на свет могут быть признаком заболевания мозга или глаз.

Позвольте мне проверить вас. Как бы вы написали в этой ситуации?

Сначала поместите большой круг на внешнее кольцо.

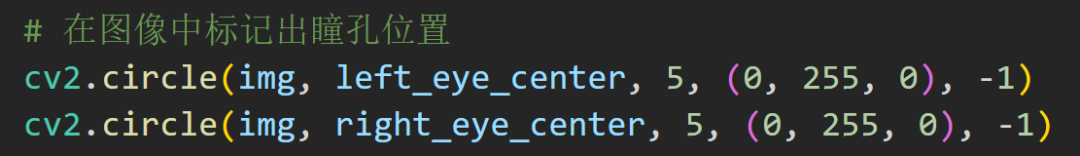

Повторная обработка учеников

В большинстве случаев нам необходимо обнаружить в режиме реального времени:

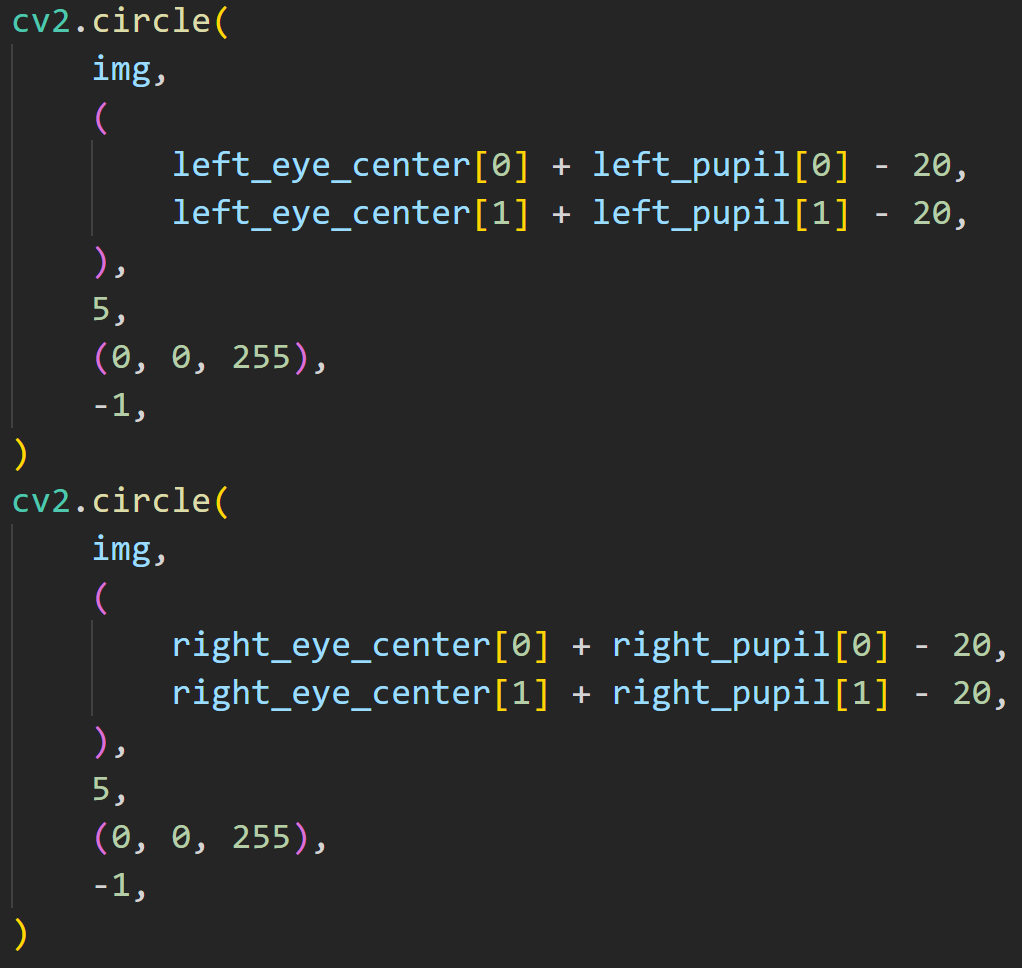

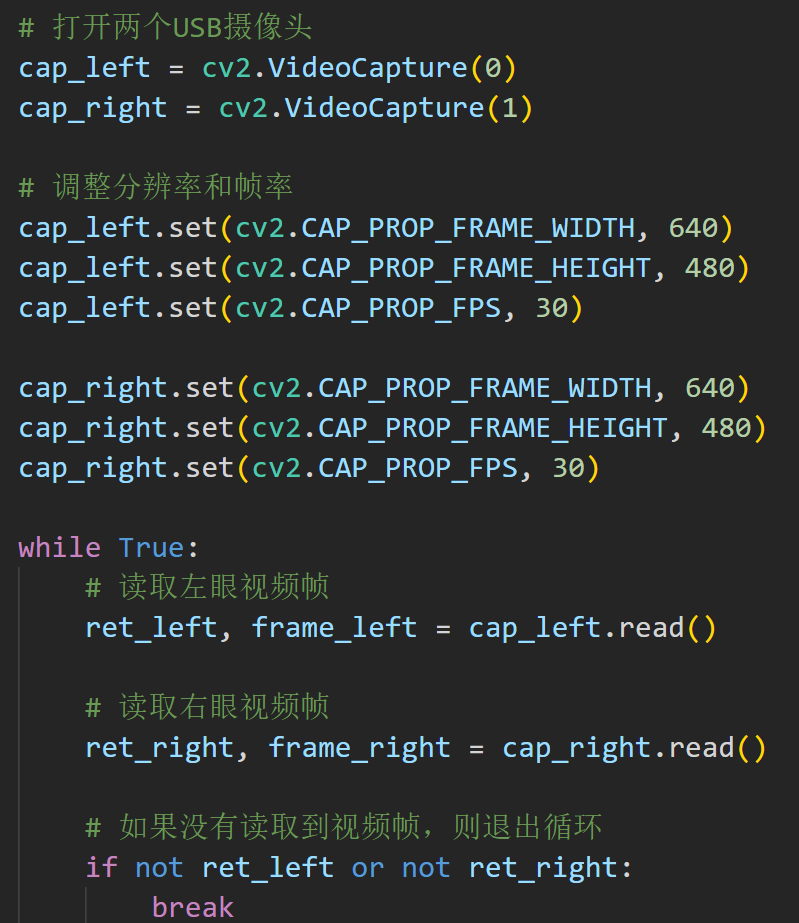

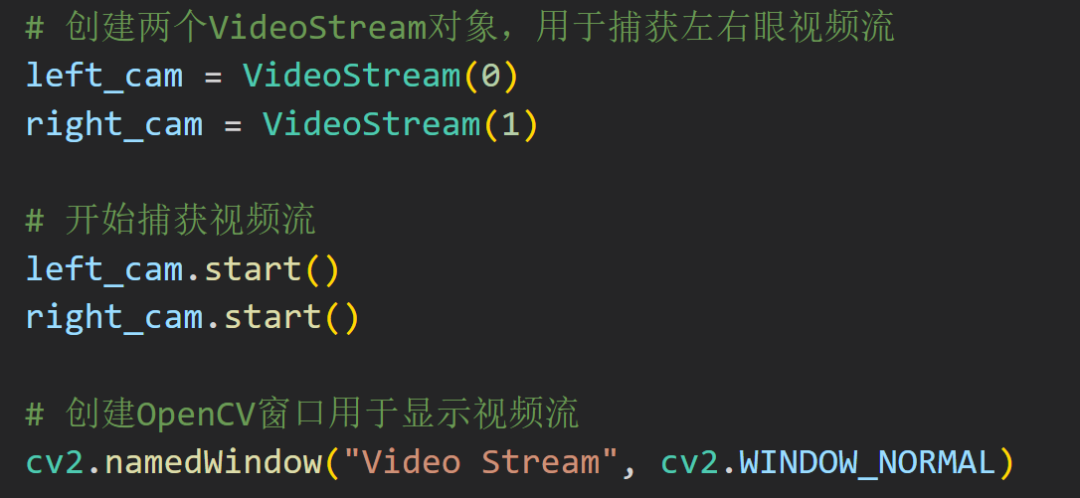

Вот фрагмент кода, снятый с камеры

Родовой код невозможно потерять

Более практичными являются две камеры для фиксации движений глаз:

Это немного неуклюже писать, но я изложу это позже.

Теперь всплывают два поля для вывода изображения, поторопитесь, иначе оно будет выглядеть не очень хорошо! Давайте выстроим его рядышком!

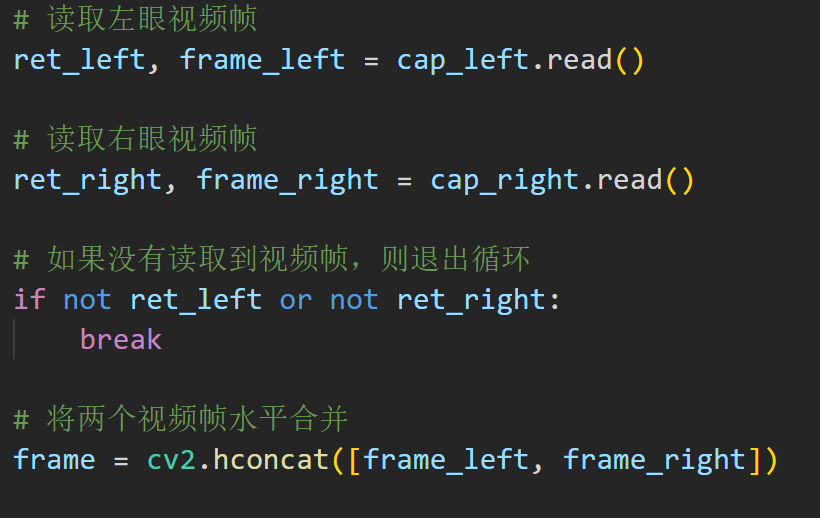

Используйте функцию cv2.hconcat() в OpenCV для объединения двух видеокадров по горизонтали и используйте функцию cv2.imshow() для отображения объединенных видеокадров.

Это очень просто. Фактически, это объединенная группа видео, расположенная горизонтально. Однако существует проблема с процессом обработки. Сначала ее необходимо обрабатывать индивидуально, а затем объединять результаты.

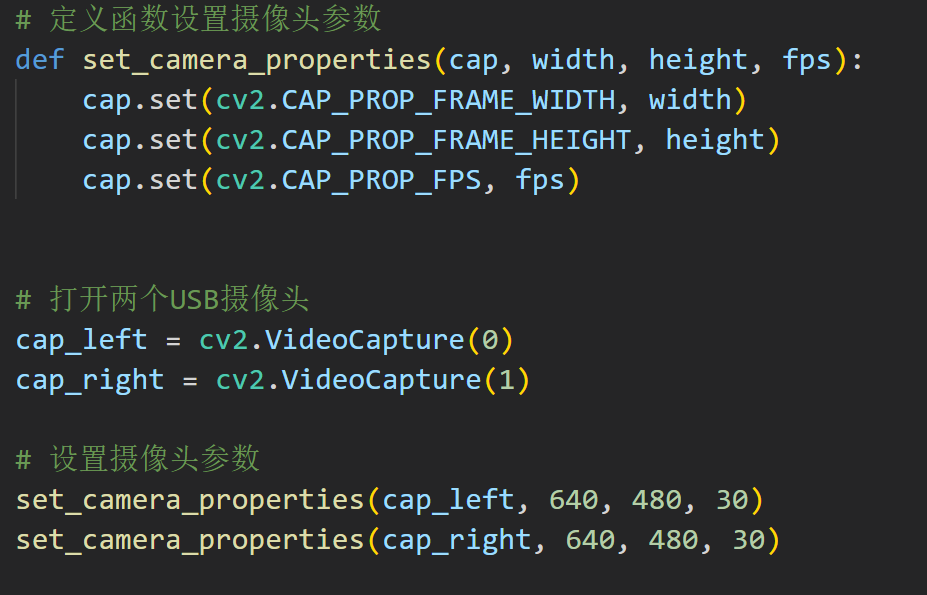

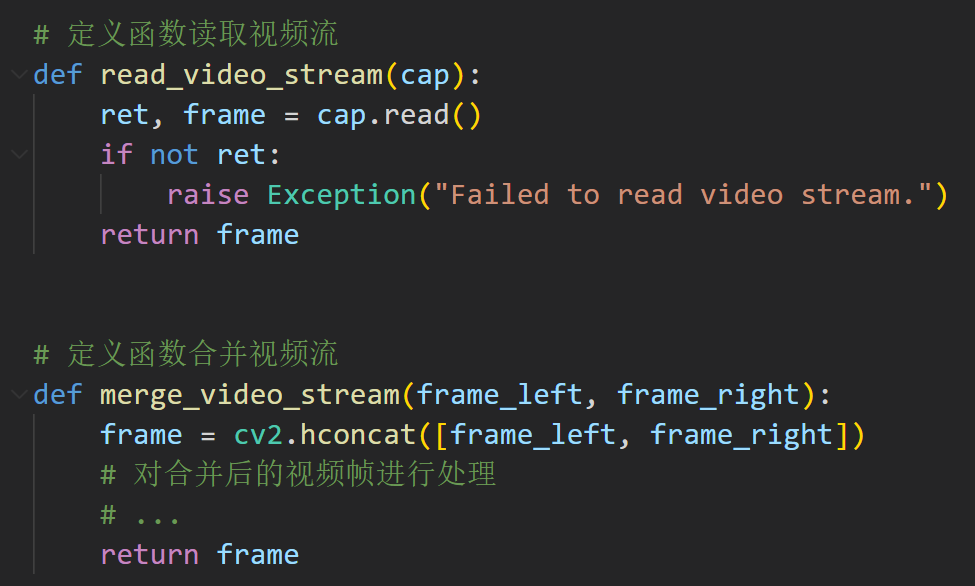

Он упакован! (Немного глупо~)

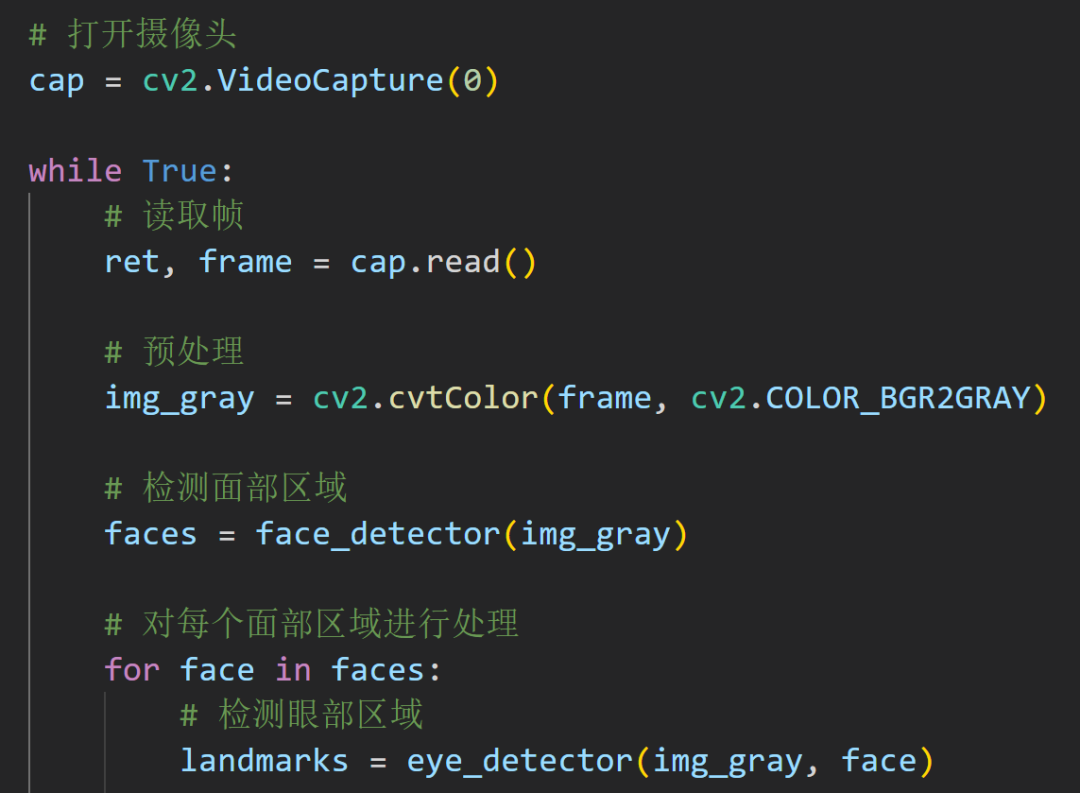

Продолжайте упаковывать и обращайте внимание на видеопоток.

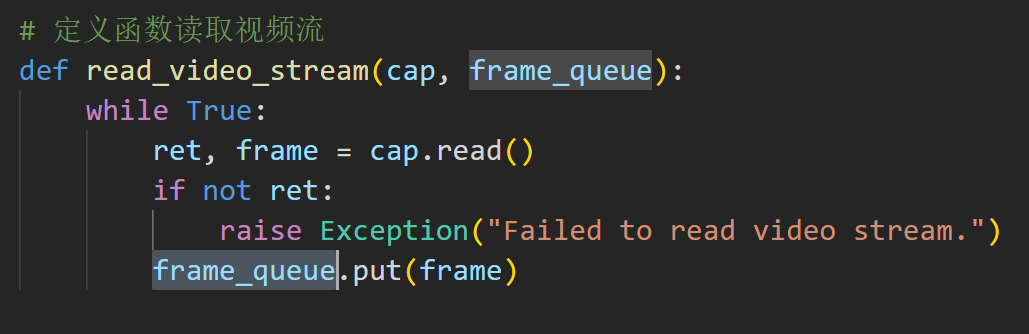

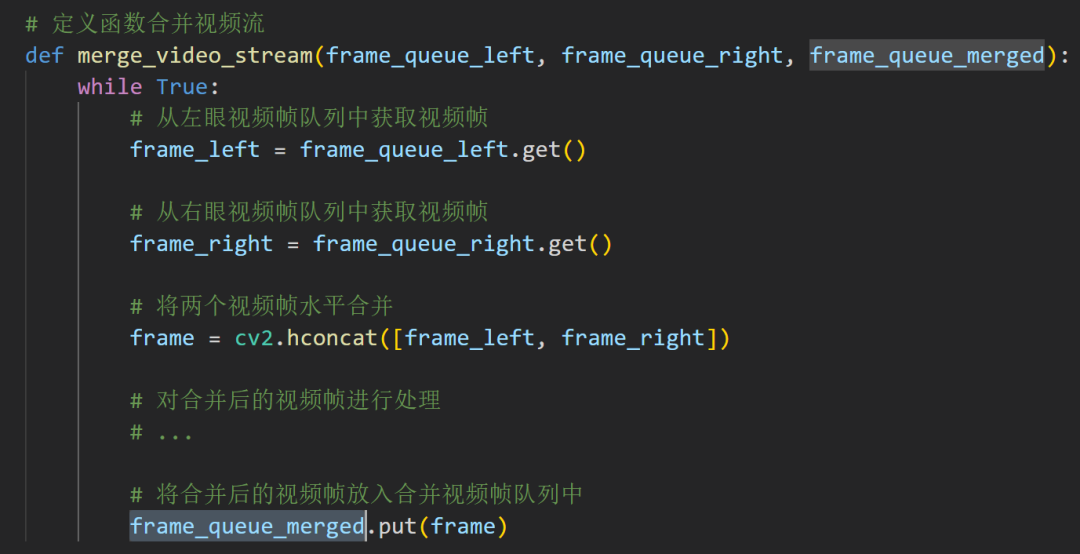

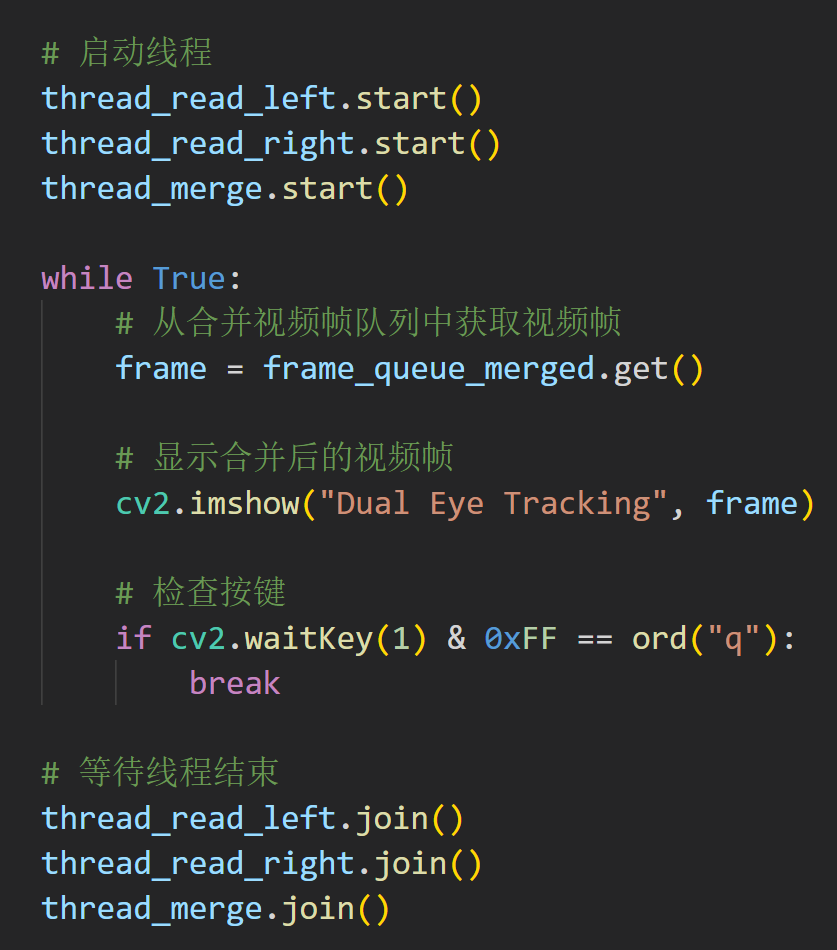

Что касается инженерных проблем, приведенный выше код по-прежнему слишком медленный. Позвольте мне добавить немного многопоточного волшебства!

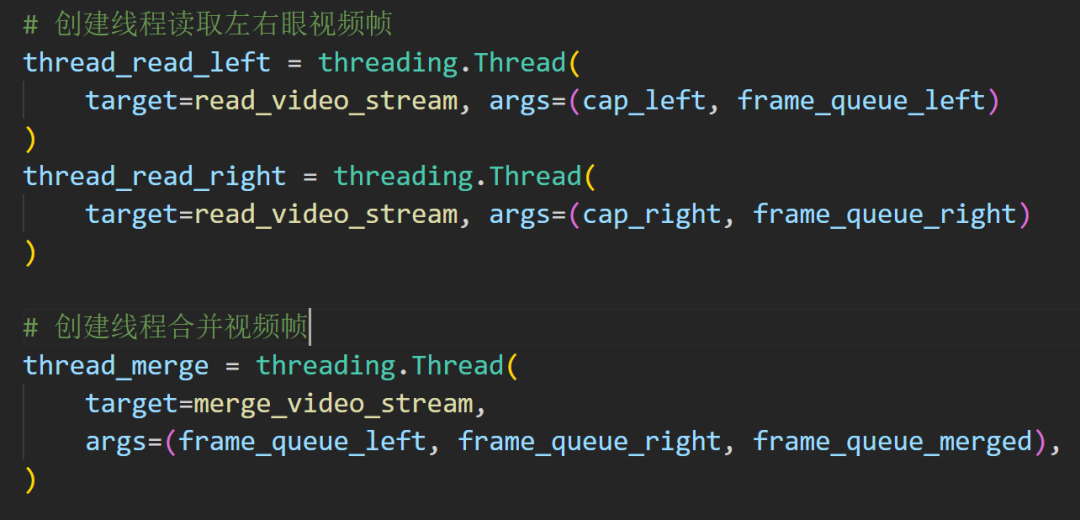

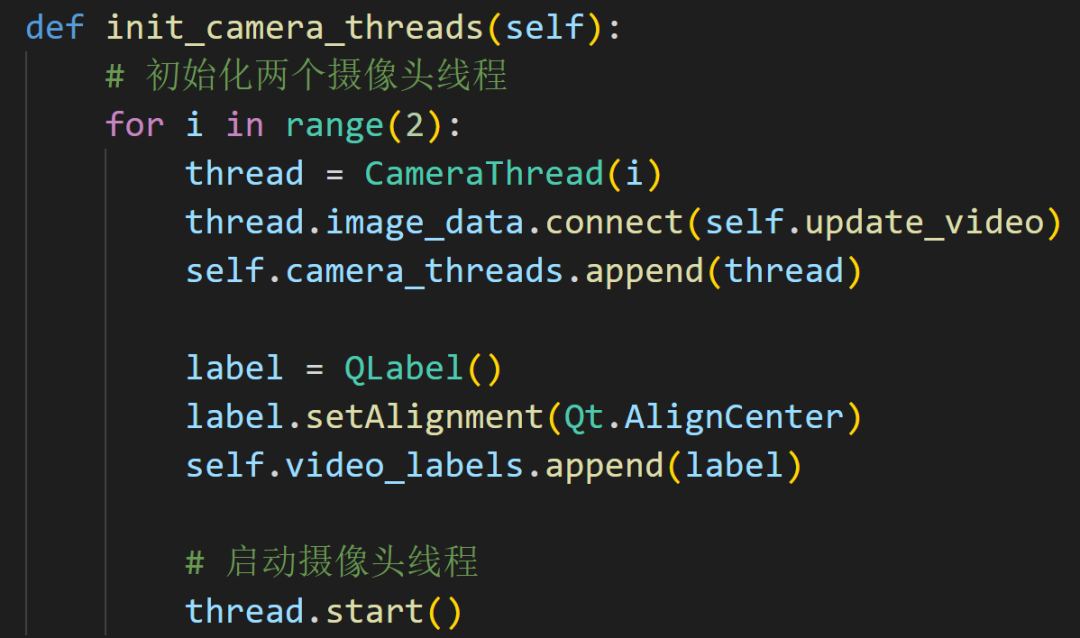

Создайте два потока для обработки чтения и объединения видеокадров левого и правого глаза соответственно:

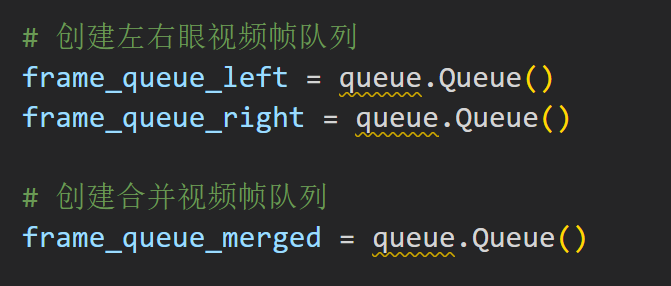

Очередь, несомненно, является наиболее подходящей структурой данных.

То же самое справедливо и для функции слияния, поскольку способ обработки изображений подходит для очередей.

Это установлено заранее

стандартный процесс

Это начало потока, а затем цикл непрерывного слияния.

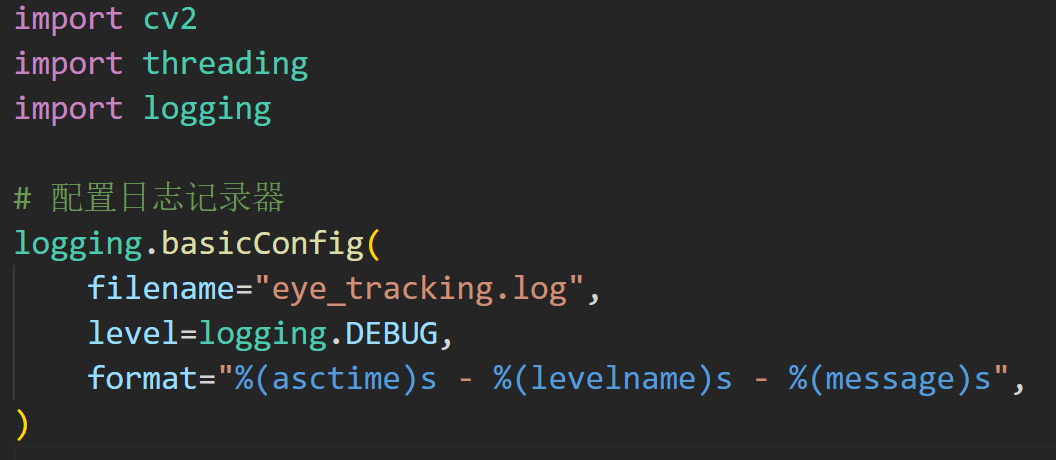

Вы также можете добавить функцию журнала и просто написать ее прямо вверху.

Текущая программа совсем не претенциозна. Было бы лучше, если бы вы добавили какой-нибудь текст или что-то в этом роде!

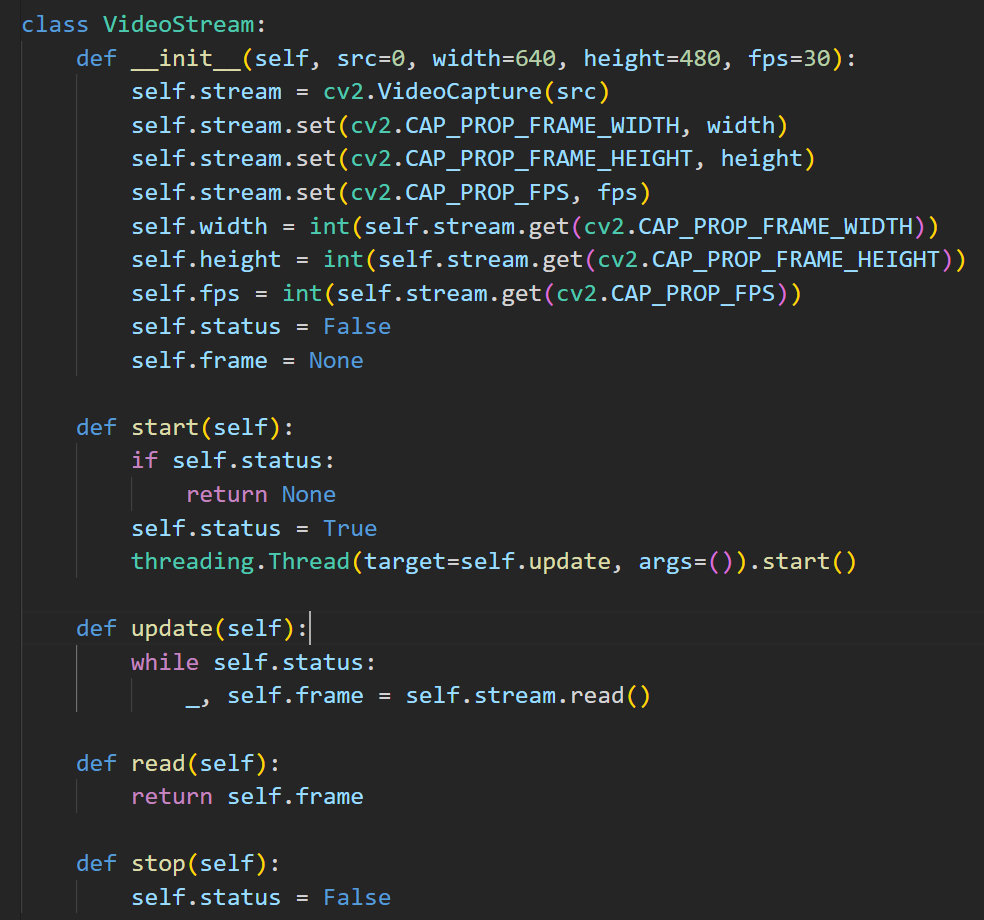

Видеопоток необходимо инкапсулировать в класс, а затем сделать еще и многопоточным.

При вызове ниже это код создания экземпляра

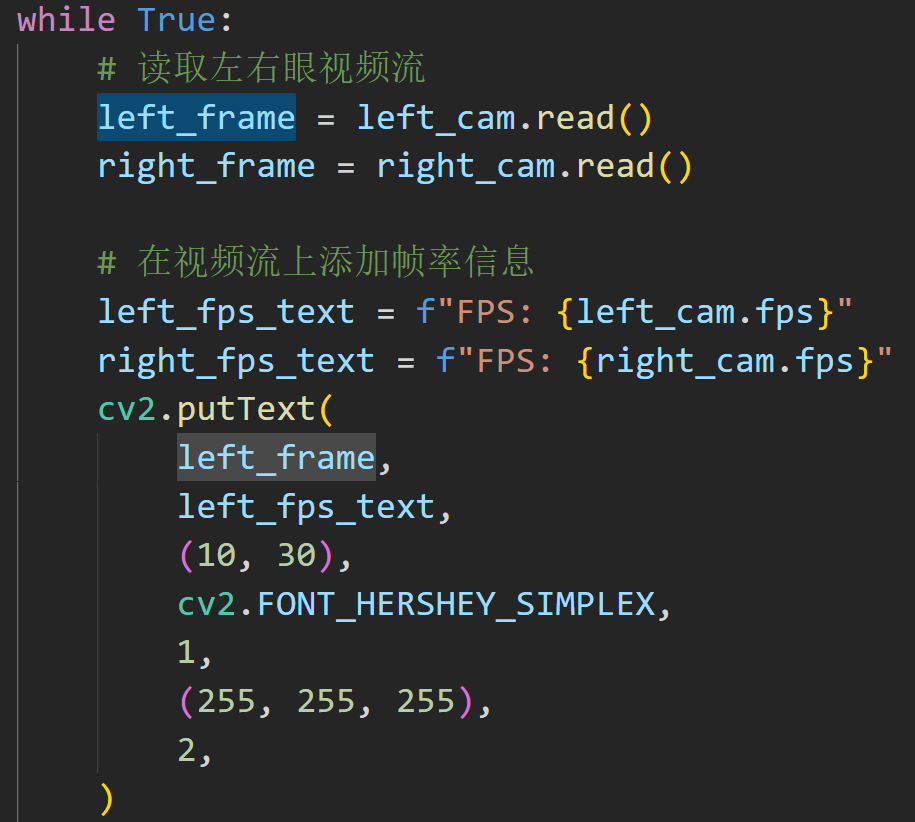

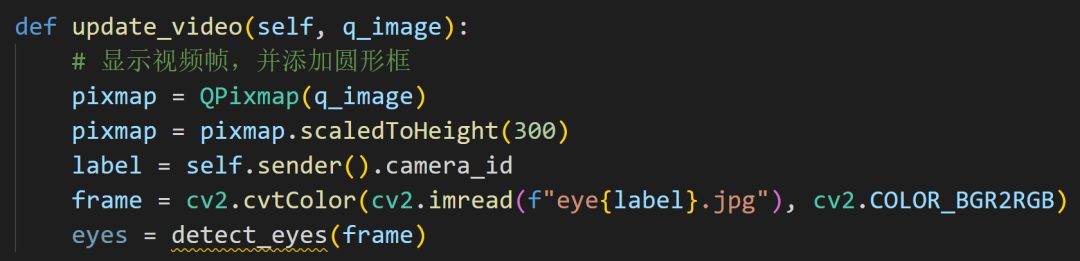

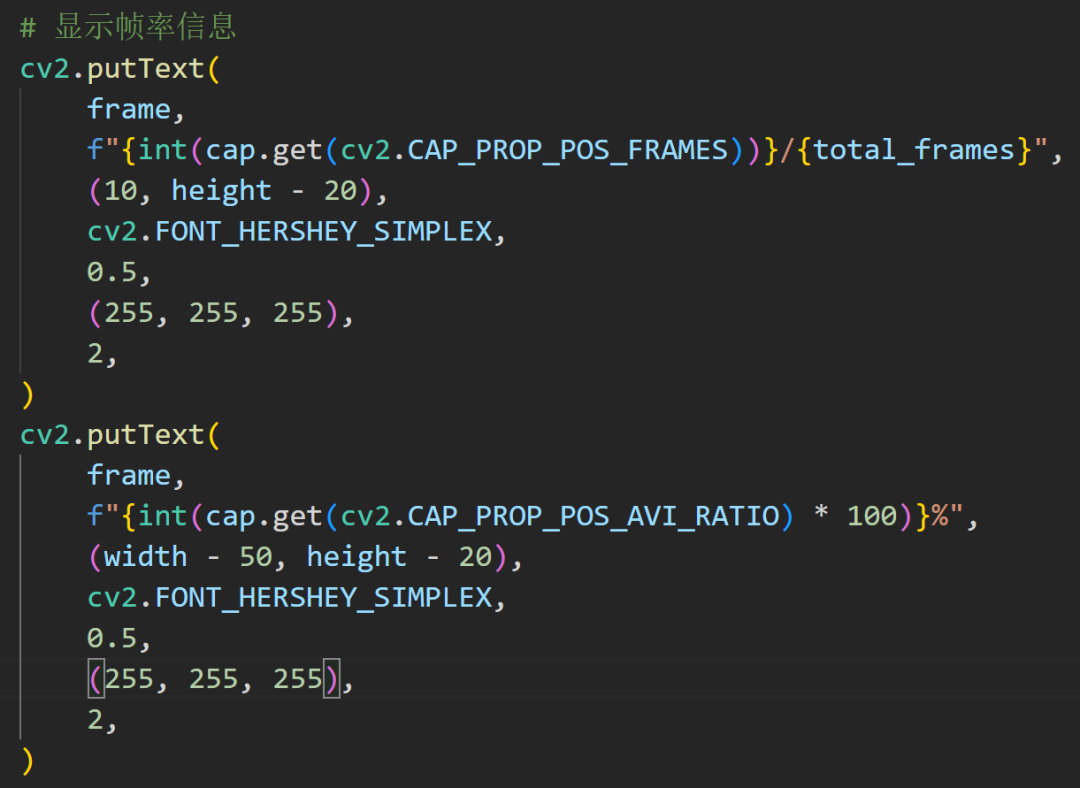

Вот наложение информации о FPS для левого глаза.

В коде функция putText используется для добавления информации о частоте кадров в верхний левый угол видеокадра. Среди них cv2.FONT_HERSHEY_SIMPLEX определяет тип шрифта, 1 определяет размер шрифта, (255, 255, 255) определяет цвет шрифта, а 2 определяет ширину линии шрифта.

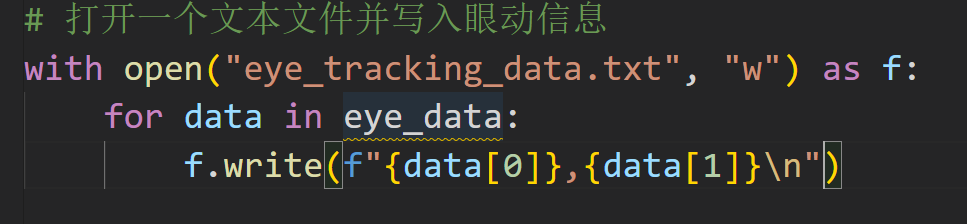

С одной стороны, отображение — это визуализация, с другой стороны, нам необходимо сохранить конкретные данные о движении глаз для постобработки. Вы можете добавить в программу функцию для извлечения информации о координатах круглого прямоугольника и сохранения ее в файл.

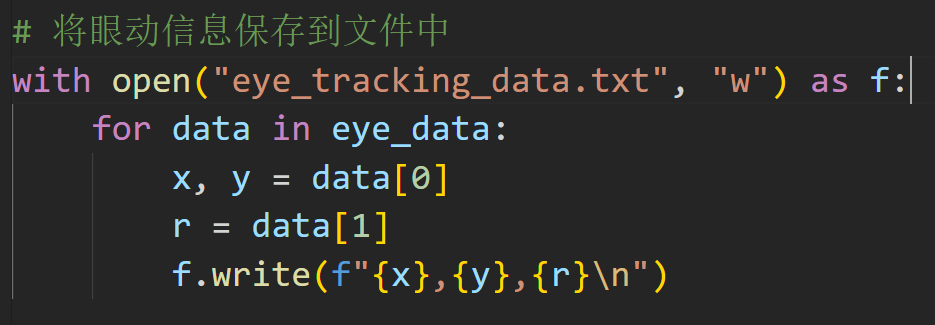

Это простая версия

Eye_data — это список, содержащий информацию о движении глаз, каждый элемент представляет собой кортеж, представляющий координаты глаза. В цикле записывайте каждый элемент в файл, разделяя каждую координату запятой и добавляя символ новой строки после конца каждой строки.

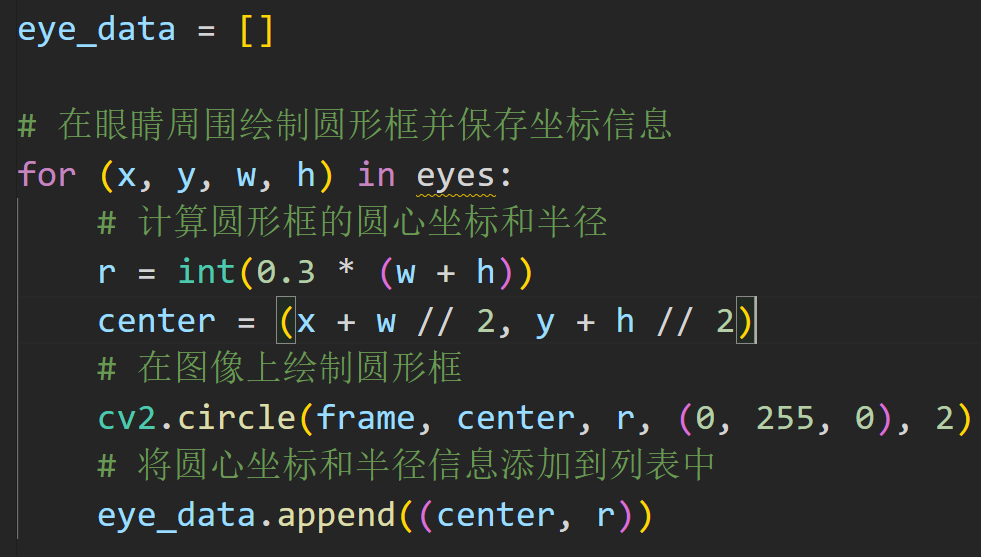

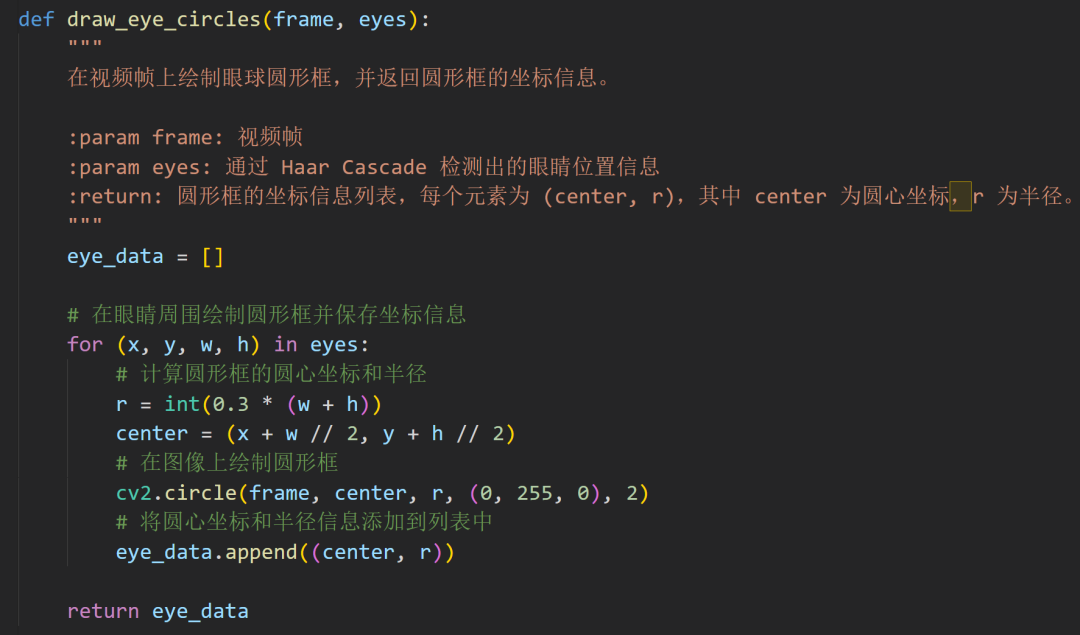

Предполагая, что радиус круглой рамки равен r, а координаты центра — (x, y), вы можете использовать функцию круга в OpenCV для рисования круглой рамки. При рисовании круглой рамки одновременно сохраните координаты центра и информацию о радиусе в списке:

Каждый раз, когда рисуется круглая рамка, координаты центра и информация о радиусе добавляются в список Eye_data. Наконец, информацию в Eye_data можно сохранить в текстовый файл:

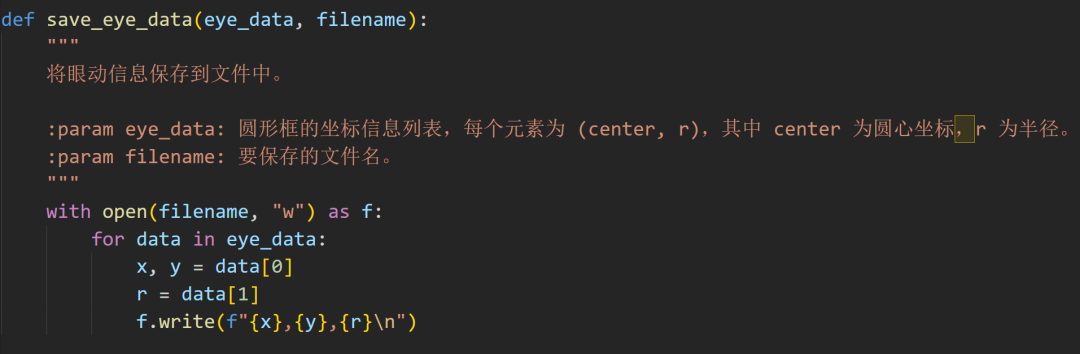

Теперь это более полная функция

Позвольте мне еще раз инкапсулировать это:

Нарисуйте круглую рамку глазного яблока на видеокадре и верните информацию о координатах круглого кадра.

Это функция, которая сохраняет информацию

На данный момент реализовано довольно много функций, давайте теперь напишем графический интерфейс!

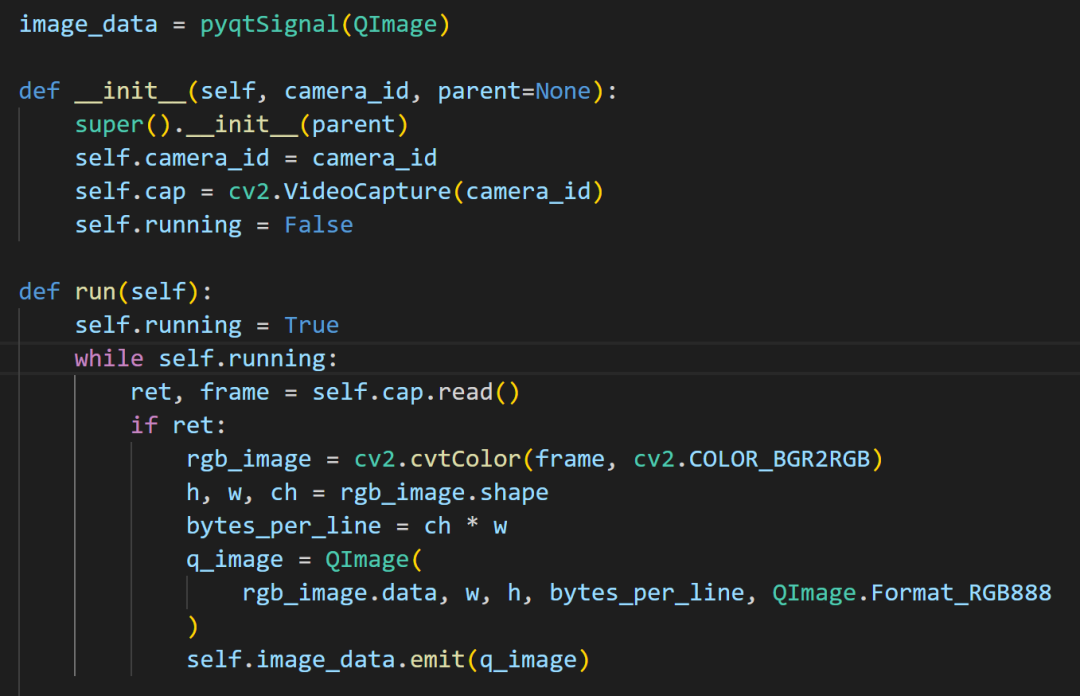

Всего две нити

Инициализация заключается в захвате потока, а цвет преобразуется в функции run.

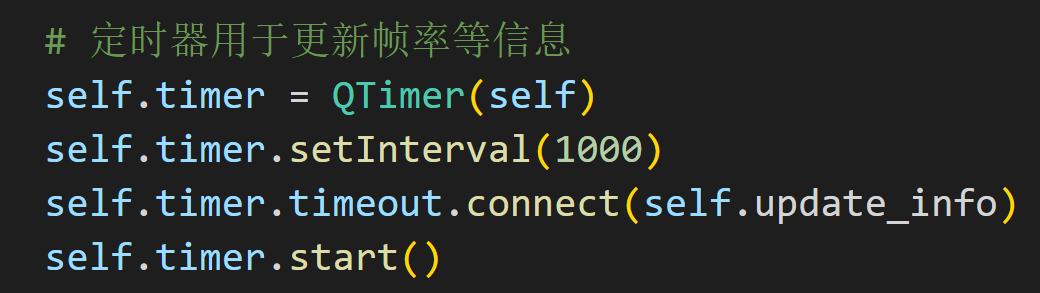

Используйте таймер для обновления информации о частоте кадров

Это просто

Все относительно просто, не так ли?

Я разместил полный код на Github.

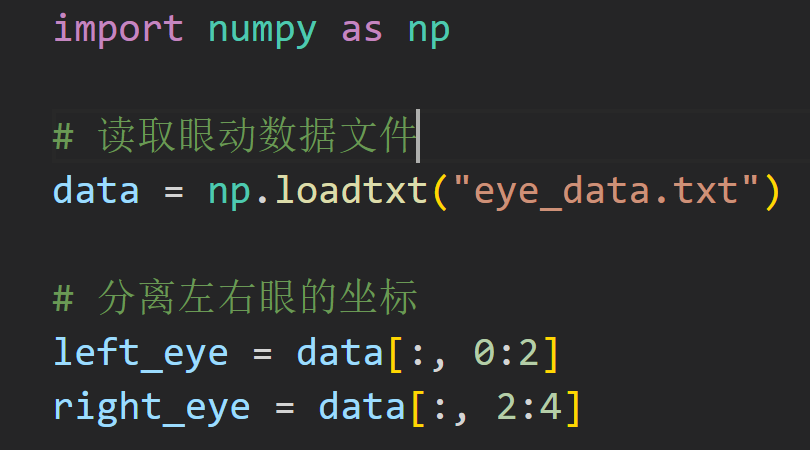

Мы получили сохраненные данные и захотели отобразить их снова. Предположим, что файл данных о движении глаз представляет собой текстовый файл, и каждая строка содержит два числа, представляющие координаты левого и правого глаза соответственно.

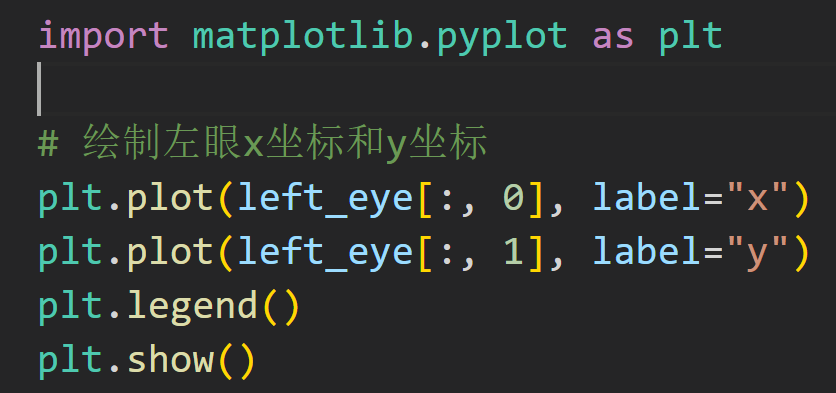

Используйте функцию построения в библиотеке matplotlib, чтобы построить координаты левого и правого глаза. Вот простой пример кода, который отображает координаты x и y левого глаза:

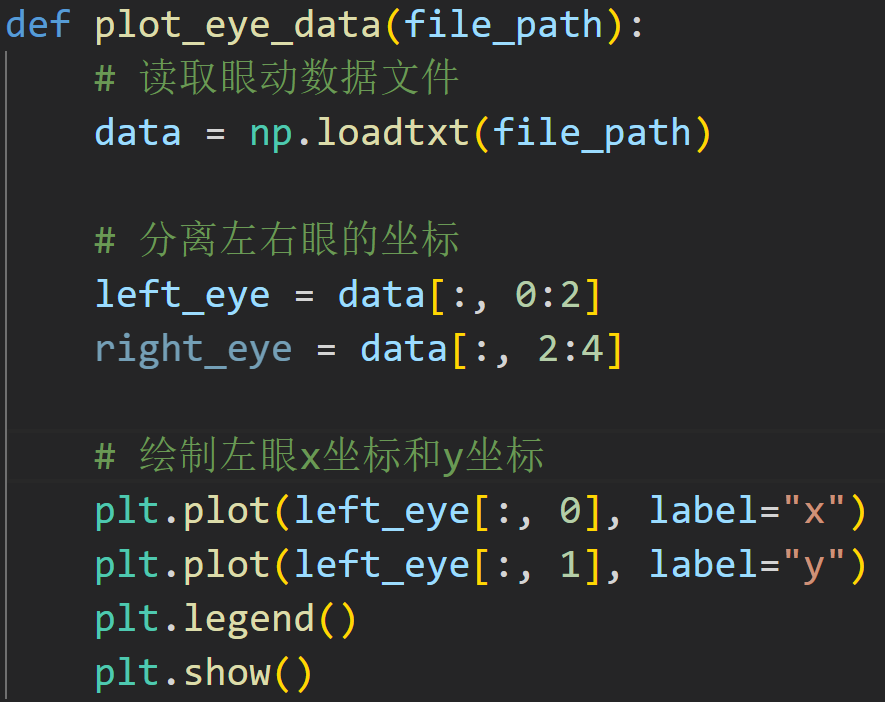

Давайте инкапсулируем это

ХОРОШО!

Давайте реализуем еще одну функцию!

Во время воспроизведения щелкните мышью, чтобы захватить воспроизводимые в данный момент данные, и отметьте отметку времени на изображении.

Программу следует написать так:

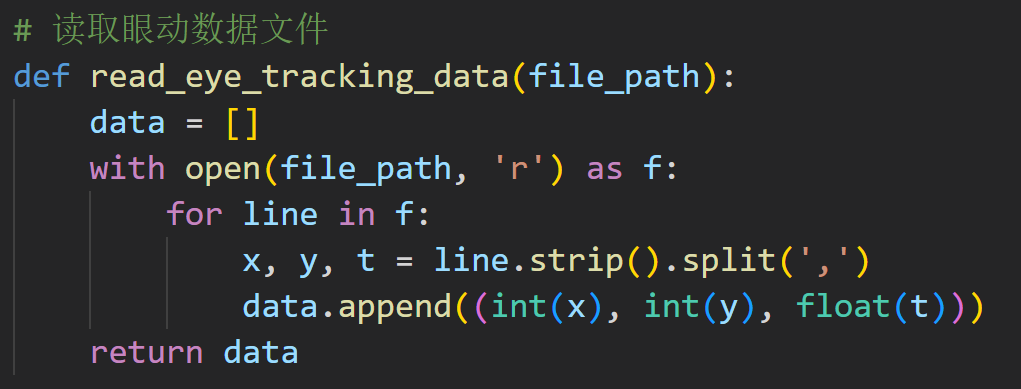

1. Считайте текстовый файл данных о движении глаз и сохраните данные в списке.

2. Откройте видеофайл и прочитайте первый кадр.

3. Отобразите первый кадр изображения в окне.

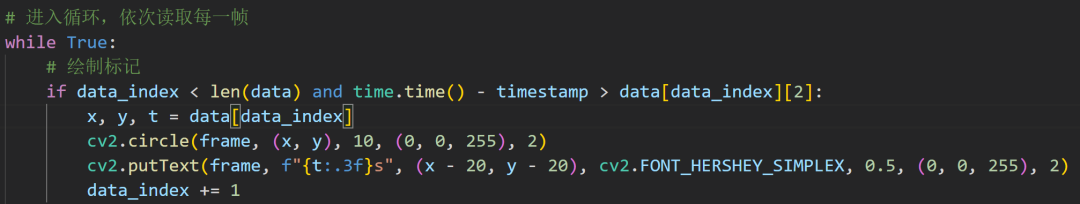

4. Войдите в цикл и последовательно прочитайте все данные в списке данных о движении глаз.

5. Когда пользователь нажимает мышь, запишите текущую временную метку и нарисуйте на изображении кружок или другую метку, чтобы отметить текущую временную метку.

6. Отобразите отмеченное изображение в окне.

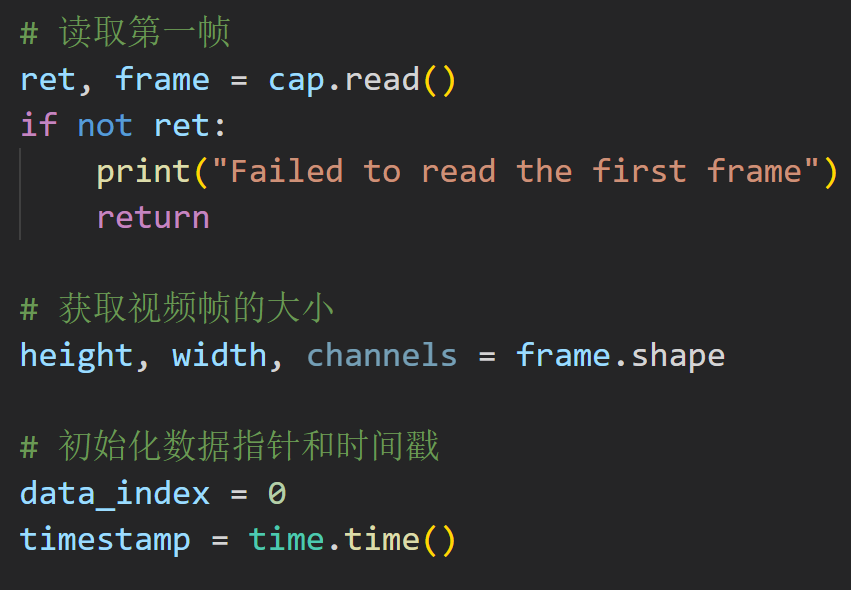

читать

Следующие функции нельзя написать отдельно, поэтому здесь они написаны вместе.

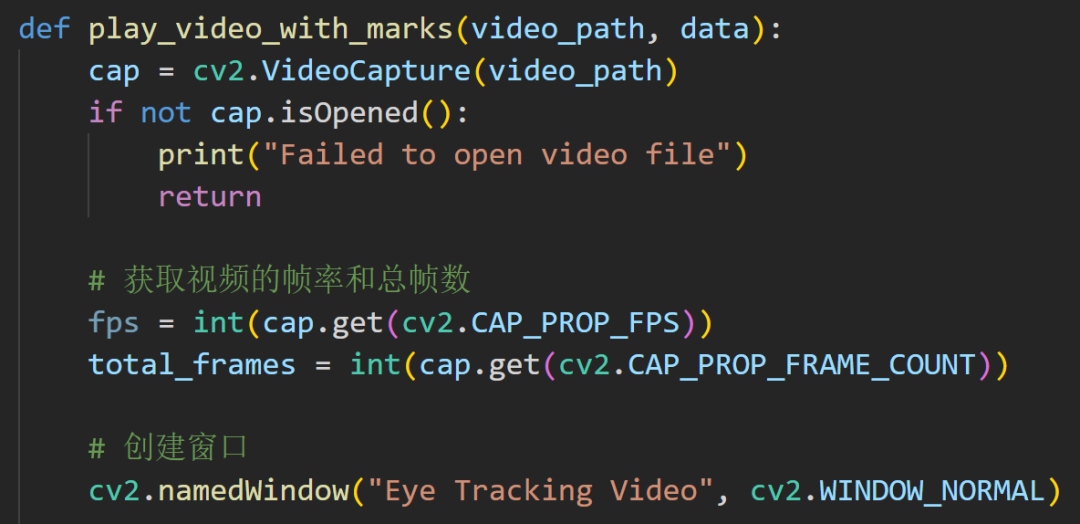

Первыйчитатьвидеорамка,Затем просто получите частоту кадров,Создать окно

Вы можете это понять?

Это знак рисования

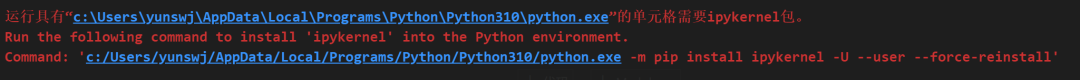

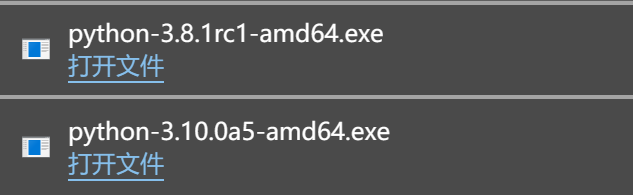

Я давно не пользовался Python, а потом он сломался. VSCode выкинул на улицу. Я плакал до смерти и не знал, что делать.

Не могу решить это

Просто переустановите его!

Эй, эй, я этого не заметил.

c:/Users/yunswj/AppData/Local/Programs/Python/Python310/python.exe -m

pip install ipykernel -U --user --force-reinstallpip install opencv-pythonhttps://cmake.org/download/import cv2

import threading

class VideoStream:

def __init__(self, src=0, width=640, height=480, fps=30):

self.stream = cv2.VideoCapture(src)

self.stream.set(cv2.CAP_PROP_FRAME_WIDTH, width)

self.stream.set(cv2.CAP_PROP_FRAME_HEIGHT, height)

self.stream.set(cv2.CAP_PROP_FPS, fps)

self.width = int(self.stream.get(cv2.CAP_PROP_FRAME_WIDTH))

self.height = int(self.stream.get(cv2.CAP_PROP_FRAME_HEIGHT))

self.fps = int(self.stream.get(cv2.CAP_PROP_FPS))

self.status = False

self.frame = None

def start(self):

if self.status:

return None

self.status = True

threading.Thread(target=self.update, args=()).start()

def update(self):

while self.status:

_, self.frame = self.stream.read()

def read(self):

return self.frame

def stop(self):

self.status = False

def main():

# Создайте два объекта VideoStream для захвата потоков левого и правого глаза.

left_cam = VideoStream(0)

right_cam = VideoStream(1)

# Начните захватывать видеопотоки

left_cam.start()

right_cam.start()

# Создайте окно OpenCV для отображения потока.

cv2.namedWindow("Video Stream", cv2.WINDOW_NORMAL)

while True:

# читатьлевый и правый глазавидеопоток left_frame = left_cam.read()

right_frame = right_cam.read()

# Добавить информацию о частоте кадров в видеопоток

left_fps_text = f"FPS: {left_cam.fps}"

right_fps_text = f"FPS: {right_cam.fps}"

cv2.putText(

left_frame,

left_fps_text,

(10, 30),

cv2.FONT_HERSHEY_SIMPLEX,

1,

(255, 255, 255),

2,

)

cv2.putText(

right_frame,

right_fps_text,

(10, 30),

cv2.FONT_HERSHEY_SIMPLEX,

1,

(255, 255, 255),

2,

)

# Объединение потоков левого и правого глаза и отображение

merged_frame = cv2.hconcat([left_frame, right_frame])

cv2.imshow("Video Stream", merged_frame)

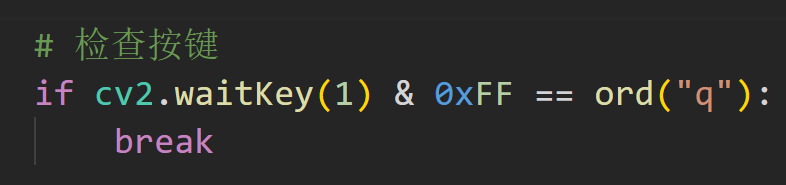

# Нажмите клавишу «q», чтобы выйти

if cv2.waitKey(1) & 0xFF == ord("q"):

break

# Остановить захват видеопотока

left_cam.stop()

right_cam.stop()

# Закройте окно OpenCV.

cv2.destroyAllWindows()

if __name__ == "__main__":

main()

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами