Практический бой | Реализация определения скорости транспортного средства на основе YOLOv8 и OpenCV (подробные шаги + код)

Визуальная/изображительная информация, доставленная в кратчайшие сроки!

Введение

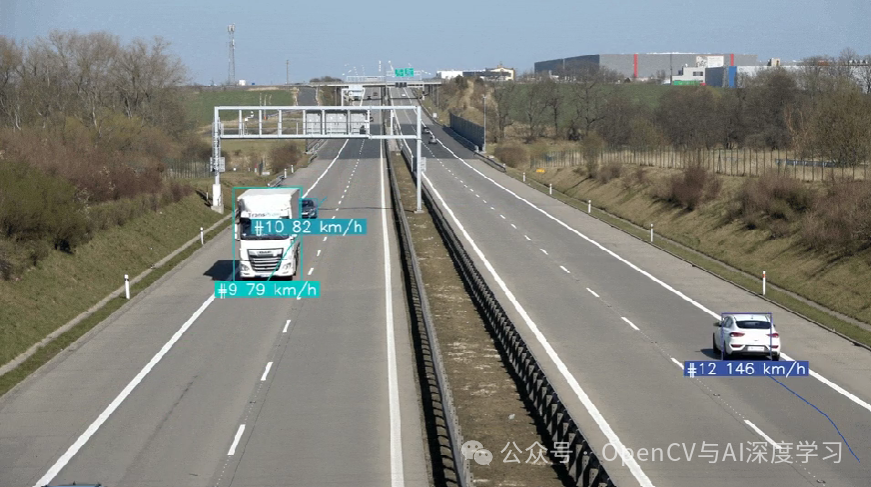

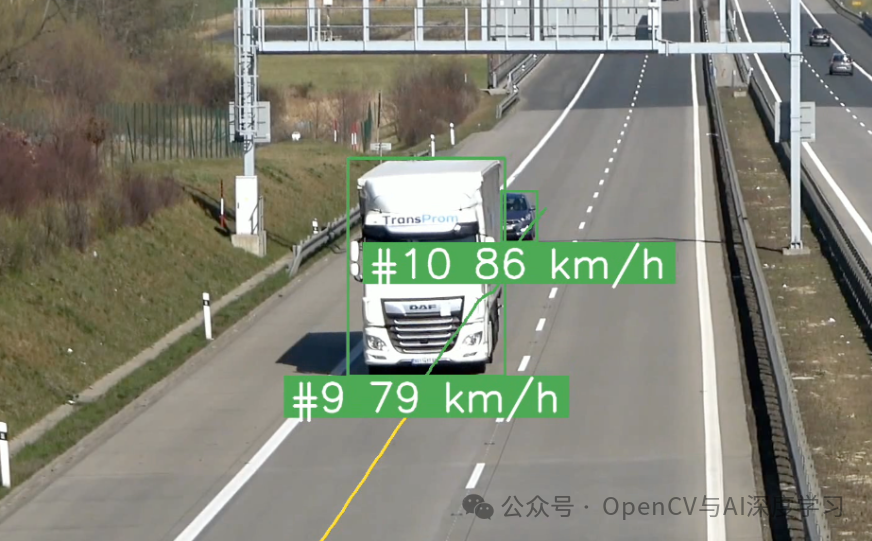

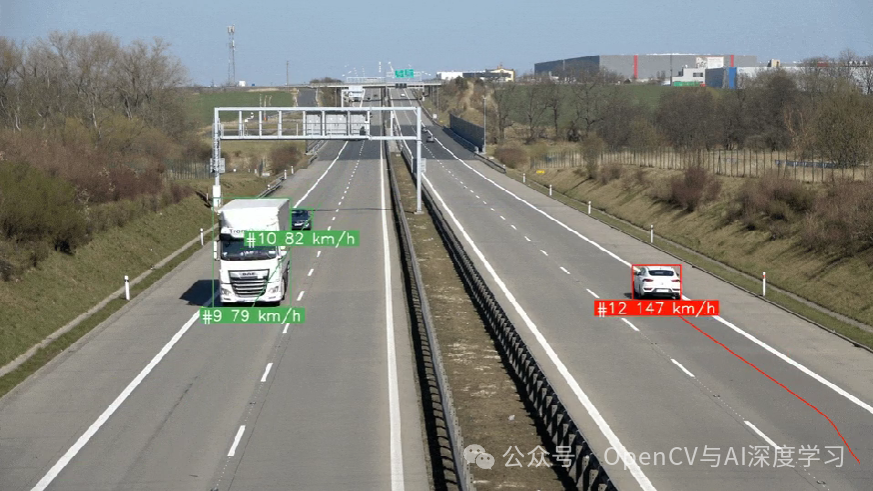

В этой статье в основном рассказывается, как использовать YOLOv8+BYTETrack+OpenCV для расчета скорости автомобиля (подробные шаги + код).

Предисловие

Вы когда-нибудь задумывались, как использовать компьютерное зрение для оценки скорости автомобиля? В этом уроке мы рассмотрим весь процесс: от обнаружения объектов до отслеживания и оценки скорости.

Реализация настоящей статьи в основном включает в себя следующие три основных этапа:,Они естьОбнаружение объектов, отслеживание объектов и оценка скорости,Ниже мы представим шаги реализации один за другим.

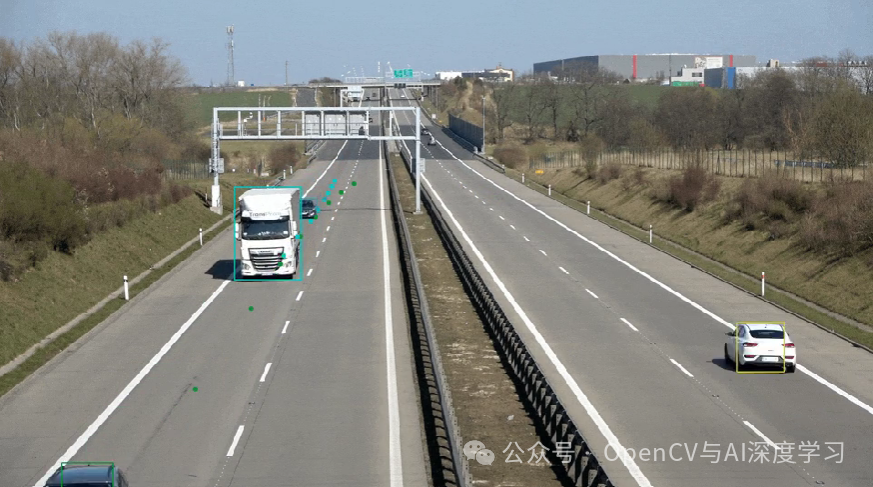

Обнаружение транспортных средств

Чтобы выполнить обнаружение объектов на видео, нам нужно перебрать кадры видео и запустить нашу модель обнаружения на каждом кадре. Вывод предоставляет доступ к предварительно обученной модели обнаружения объектов, мы используем модель yolov8x-640. Соответствующий код и документацию можно найти по ссылке:

https://github.com/roboflow/inference?ref=blog.roboflow.com

https://inference.roboflow.com/?ref=blog.roboflow.comimport supervision as sv

from inference.models.utils import get_roboflow_model

model = get_roboflow_model(‘yolov8x-640’)

frame_generator = sv.get_video_frames_generator(‘vehicles.mp4’)

bounding_box_annotator = sv.BoundingBoxAnnotator()

for frame in frame_generator:

results = model.infer(frame)[0]

detections = sv.Detections.from_inference(results)

annotated_frame = trace_annotator.annotate(

scene=frame.copy(), detections=detections)

Конечно, вы также можете заменить его на Ultralytics YOLOv8, YOLO-NAS или любую другую модель. Вам нужно изменить несколько строк в своем коде, и тогда все готово.

import supervision as sv

from ultralytics import YOLO

model = YOLO("yolov8x.pt")

frame_generator = sv.get_video_frames_generator(‘vehicles.mp4’)

bounding_box_annotator = sv.BoundingBoxAnnotator()

for frame in frame_generator:

result = model(frame)[0]

detections = sv.Detections.from_ultralytics(result)

annotated_frame = trace_annotator.annotate(

scene=frame.copy(), detections=detections)отслеживание транспортных средств

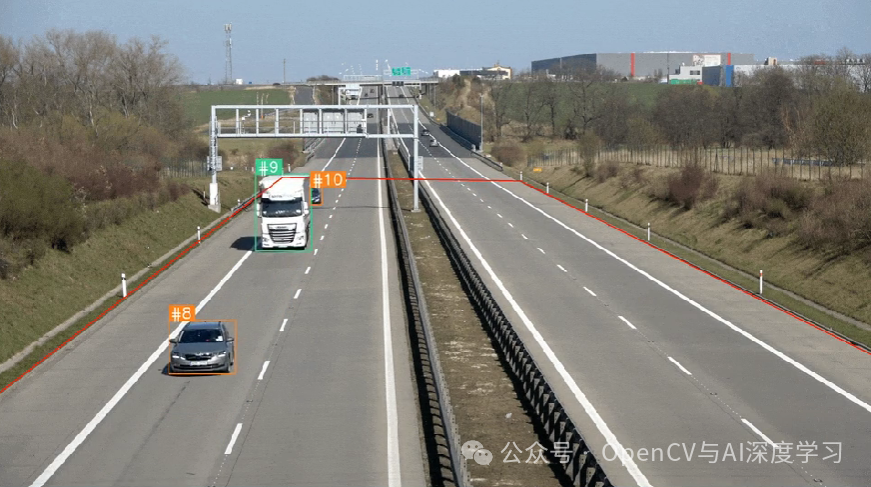

Обнаружения объекта недостаточно для оценки скорости. Чтобы рассчитать расстояние, пройденное каждым транспортным средством, нам необходимо иметь возможность отслеживать их. Для этого мы используем BYTETrack, доступный в пакете Supervision pip.

...

# initialize tracker

byte_track = sv.ByteTrack()

...

for frame in frame_generator:

results = model.infer(frame)[0]

detections = sv.Detections.from_inference(results)

# plug the tracker into an existing detection pipeline

detections = byte_track.update_with_detections(detections=detections)

...Если вы хотите узнать больше об интеграции BYTETrack в ваш проект обнаружения объектов, посетите страницу документации Supervision. Там вы найдете комплексный пример, показывающий, как это сделать, используя различные модели обнаружения.

https://supervision.roboflow.com/how_to/track_objects/?ref=blog.roboflow.com

Расчет скорости автомобиля

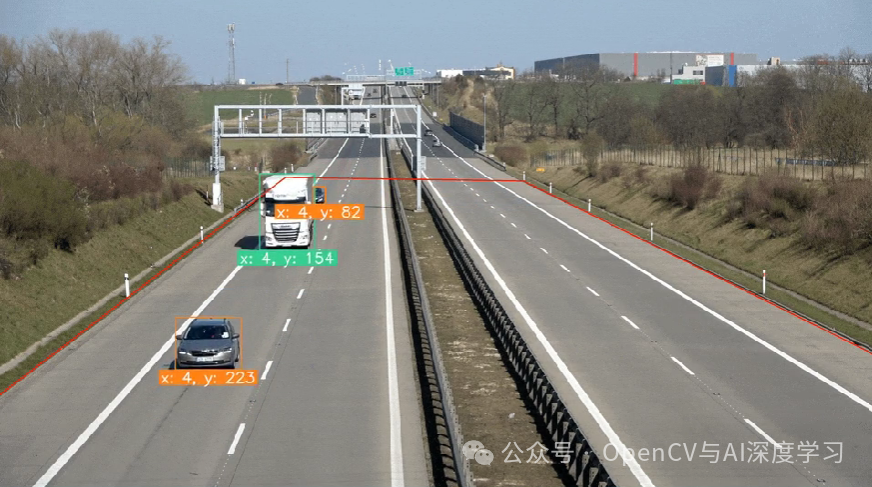

Давайте рассмотрим простой метод оценки расстояния на основе количества пикселей, на которое перемещается ограничивающая рамка.

Когда вы используете точки, чтобы каждую секунду запоминать положение каждой машины, происходит вот что. Даже если автомобиль движется с постоянной скоростью, расстояние в пикселях, которое он преодолевает, меняется. Чем дальше от камеры, тем меньше пройденное расстояние.

Поэтому нам сложно вычислить скорость, используя исходные координаты изображения. Нам нужен способ преобразования координат на изображении в фактические координаты на дороге, тем самым устраняя искажения, связанные с перспективой. К счастью, мы можем сделать это, используя OpenCV и немного математики.

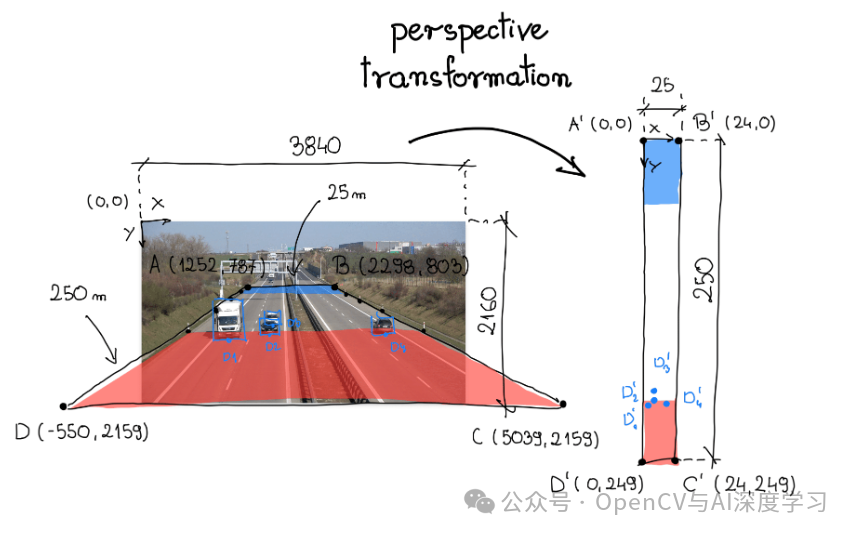

Математика изменения перспективы

Чтобы преобразовать перспективу, нам нужна матрица преобразования, которую мы определяем с помощью функции getPerspectiveTransform в OpenCV. Эта функция принимает два параметра: исходную область интереса и целевую область интереса. На визуализации ниже эти области обозначены ABCD и A'-B'-C'-D' соответственно.

При анализе одного кадра видео мы выбрали участок дороги в качестве исходного региона интереса. На обочинах магистралей обычно располагаются вертикальные столбы – указатели, расположенные через равные промежутки. В данном случае 50 метров. Область интереса охватывает всю ширину дороги и участок, соединяющий шесть упомянутых выше колонн.

В нашем случае мы имеем дело с шоссе. Исследования Google Maps показывают, что территория, окружающая интересующую область источника, имеет ширину примерно 25 метров и длину 250 метров. Мы используем эту информацию для определения вершин соответствующего четырехугольника, закрепляя новую систему координат в верхнем левом углу.

Наконец, мы реорганизуем координаты вершин A-B-C-D и A'-B'-C'-D' в двумерные матрицы SOURCE и TARGET соответственно, где каждая строка матрицы содержит координаты точки.

SOURCE = np.array([

[1252, 787],

[2298, 803],

[5039, 2159],

[-550, 2159]

])

TARGET = np.array([

[0, 0],

[24, 0],

[24, 249],

[0, 249],

])изменение перспективы

Чтобы использовать матрицы источника и назначения, мы создаем класс ViewTransformer. Этот класс использует функцию OpenCV getPerspectiveTransform для вычисления матрицы преобразования. Метод Transform_points применяет эту матрицу для преобразования координат изображения в координаты реального мира.

class ViewTransformer:

def __init__(self, source: np.ndarray, target: np.ndarray) -> None:

source = source.astype(np.float32)

target = target.astype(np.float32)

self.m = cv2.getPerspectiveTransform(source, target)

def transform_points(self, points: np.ndarray) -> np.ndarray:

if points.size == 0:

return points

reshaped_points = points.reshape(-1, 1, 2).astype(np.float32)

transformed_points = cv2.perspectiveTransform(

reshaped_points, self.m)

return transformed_points.reshape(-1, 2)

view_transformer = ViewTransformer(source=SOURCE, target=TARGET)

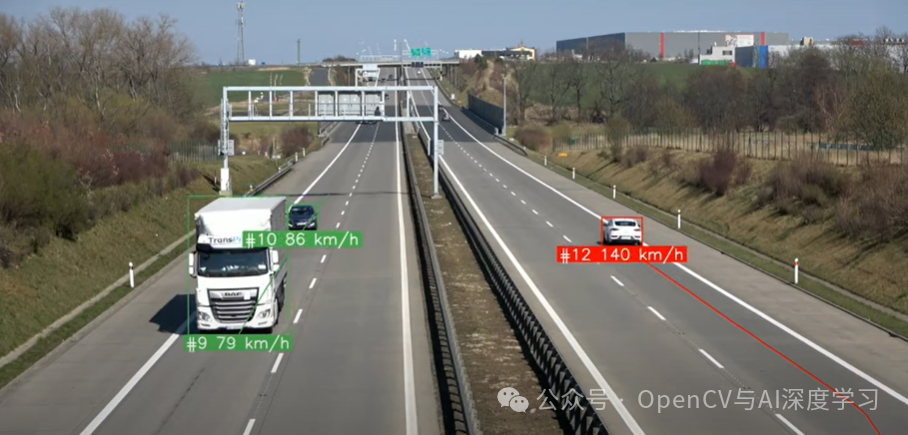

Расчет скорости с помощью компьютерного зрения

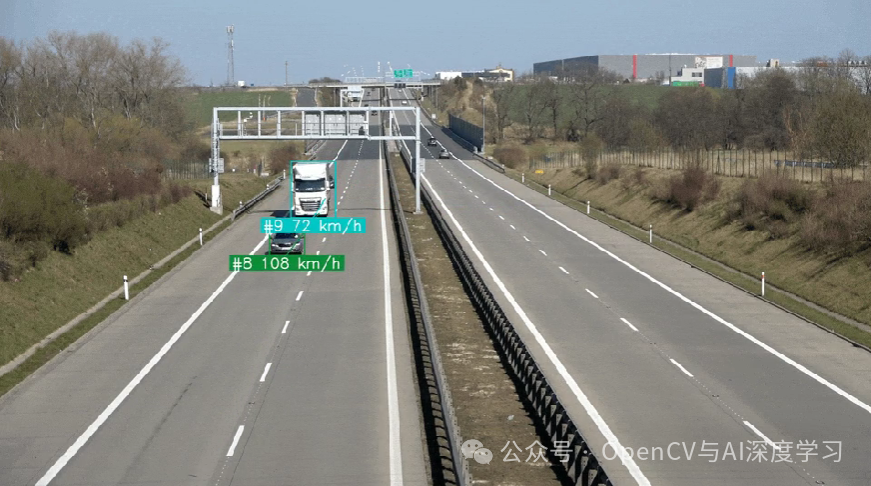

Теперь у нас есть детекторы, трекеры и логика преобразования перспективы. Пришло время рассчитать скорость. В принципе все просто: пройденное расстояние разделить на время, необходимое для прохождения этого расстояния. Однако эта задача имеет свои сложности.

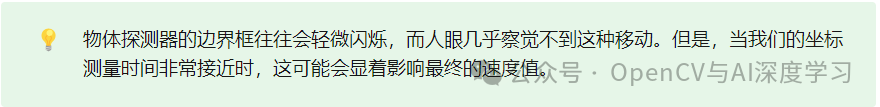

В одном случае мы можем вычислить скорость каждого кадра: вычислить расстояние, пройденное между двумя видеокадрами, и разделить его на обратную величину FPS, которая в моем случае равна 1/25. К сожалению, такой подход может привести к очень нестабильным и нереалистичным значениям скорости.

Чтобы этого не произошло, мы усредняем полученные значения в течение одной секунды. Таким образом, расстояние, пройденное автомобилем, значительно больше, чем перемещение маленькой коробочки, вызванное мерцанием, и наши измерения скорости гораздо ближе к реальности.

...

video_info = sv.VideoInfo.from_video_path('vehicles.mp4')

# initialize the dictionary that we will use to store the coordinates

coordinates = defaultdict(lambda: deque(maxlen=video_info.fps))

for frame in frame_generator:

result = model(frame)[0]

detections = sv.Detections.from_ultralytics(result)

detections = byte_track.update_with_detections(detections=detections)

points = detections.get_anchors_coordinates(

anchor=sv.Position.BOTTOM_CENTER)

# plug the view transformer into an existing detection pipeline

points = view_transformer.transform_points(points=points).astype(int)

# store the transformed coordinates

for tracker_id, [_, y] in zip(detections.tracker_id, points):

coordinates[tracker_id].append(y)

for tracker_id in detections.tracker_id:

# wait to have enough data

if len(coordinates[tracker_id]) > video_info.fps / 2:

# calculate the speed

coordinate_start = coordinates[tracker_id][-1]

coordinate_end = coordinates[tracker_id][0]

distance = abs(coordinate_start - coordinate_end)

time = len(coordinates[tracker_id]) / video_info.fps

speed = distance / time * 3.6

...

Скрытая сложность оценки скорости

Существует множество других факторов, которые следует учитывать при построении реальной системы оценки скорости транспортного средства. Давайте кратко обсудим некоторые из них.

Закрытые и обрезанные прямоугольники. Стабильность прямоугольника является ключевым фактором, влияющим на качество оценки скорости. Когда одна машина временно закрывает другую, небольшое изменение размера коробки может привести к значительному изменению расчетного значения скорости.

Установите фиксированную точку отсчета:В этом случае,Мы используем нижний центр ограничивающей рамки в качестве контрольной точки. это возможно,Потому что погодные условия в видео хорошие – солнечно,Дождя не было. Однако,Легко представить ситуации, когда найти это будет гораздо сложнее.

Уклон дороги:В этом случае,Предположим, что дорога идеально гладкая. фактически,Это случается редко. Чтобы свести к минимуму влияние наклона,Приходится ограничиваться относительно ровными участками дороги,Или включите уклон в расчет.

—THE END—

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами