Понимание воплощенного интеллекта в одной статье: методы, прогресс и проблемы

Шен Маченг Автор Клуба Джижи

С точки зрения непрофессионала, воплощенный интеллект относится к изучению того, как интеллектуальные агенты с объектами в окружающей среде (например, роботы в реальной или смоделированной среде, которые могут напрямую физически взаимодействовать с окружающей средой) приобретают когнитивные способности и учатся посредством взаимодействия с окружающей средой. освоить новые навыки и новые знания как подобласть искусственного интеллекта.

Проблемы, с которыми сталкиваются основные методы обучения встроенному интеллекту

В рамках парадигмы глубокого обучения исследования воплощенного интеллекта в основном фокусируются на имитационном обучении. Обучение) и обучение с подкреплением (Reinforcement Learning, RL) 两大块。имитационное обучениеСобирая наборы данных о траекториях для конкретных задач и используя глубокие нейронные сети для соответствия состоянию.(state)или наблюдение(observation,Например, первое перспективное изображение), отображение временного ряда действий (действий) для достижения обучения навыкам.,Вообще говоря, затраты на сбор данных выше。обучение с подкреплениемЭто позволяет агенту напрямую взаимодействовать с окружающей средой.,Оптимизируйте заранее определенную функцию вознаграждения, связанную с конкретной задачей во время взаимодействия. (reward function) Вообще говоря, чтобы освоить новые навыки, разработка функции вознаграждения требует повторных итераций, а эффективность обучения с подкреплением (sample-efficiency) Это будет гораздо ниже, чем имитационное обучение.

Ранние исследования разведки выявили стратегии, которые позволяют агентам учиться (политика) Крайне сложно обобщать задачи, даже если они очень похожи на данные обучения.,Например, стратегия, полученная на обучающем наборе «Толкнуть объект из середины стола в правый верхний угол», не может быть напрямую использована для решения задачи «Толкнуть объект из середины стола в правый нижний угол». угол".,Интуитивная причина этого заключается в том, что верхний правый угол и нижний правый угол таблицы не совпадают на уровне изображения.,Нейронная сеть не имеет данных, чтобы узнать взаимосвязь между этими двумя“На более абстрактном уровне это похоже на”。поэтомуБольшой проблемой является комбинаторный взрыв количества задач:Вполне возможно, что если вам нужно научиться100способы работы100объектноподобный объект, которого нужно достичь100конкретное состояние,Затем вам нужно определить 100x100x100=миллион разных задач.,Для обучения многозадачности необходимо собрать соответствующие данные.

Недавний прорыв: предварительная тренировка по языковым задачам

Предоставляет возможности комбинаторного/систематического обобщения.

Трудность этого комбинаторного взрыва заключалась в том, что потенциальное решение было найдено только в 2021 году в некоторых ранних научных работах. Интуитивно говоря, принцип состоит в том, чтобы осознать, что эти задачи не являются независимыми друг от друга, а связаны друг с другом в композиционной форме, и существует некий «изоморфизм» в форме этой композиционной корреляции с ее естественным языковым описанием. .

Лу и др. 21 [1] обнаружили, что Трансформер, предварительно обученный языковым задачам, на самом деле достиг значительно лучших результатов, чем прямое обучение, после точной настройки ряда, казалось бы, несвязанных задач (зрение, сворачивание белков, численные расчеты). Этот результат предполагает, что в языковых задачах существует некоторая структура, общая для многих других категорий задач. Эрик Джанг и др. [2] использовали встраивание языка в качестве встраивания задач для изучения стратегий многозадачности робота в рамках многозадачного обучения, демонстрируя возможность обобщения с нулевым выстрелом: любая часть данных в обучающем наборе робота никогда не включалась. «бутылка» и «лоток» одновременно, а также он не обучен задаче «поставить бутылку в лоток», но может обобщить решение этой задачи с нулевыми образцами в тестовом наборе. Этот результат показывает, что с помощью этого метода обучения модель усвоила абстрактное понятие, такое как «помещение А в Б», которое на самом деле совпадает с композиционностью языка: нам нужен только ограниченный словарный запас и грамматические структуры для выполнения неограниченного количества видов. возможные выражения бесконечны именно потому, что всякое сочетание словарного запаса и грамматических структур разными способами может быть определено как новое понятие.

Недавняя большая модель воплощенного интеллекта (базовая модель) на самом деле получила дальнейшее развитие в этом направлении. Например, RT-X[3] компании Google Deepmind использует Transformer, предварительно обученный на крупномасштабных наборах речевых данных, и ViT, предварительно обученный на визуальных задачах, в качестве основы для выполнения множества воплощенных морфологических задач. Точная настройка набора данных открывает эту возможность. к нулевой выборке и систематическому обобщению [4] на новые задачи, что в определенной степени смягчает проблему дороговизны воплощенного сбора разведывательных данных.

Современные встроенные интеллектуальные системы

Принципиальные отличия от универсального воплощенного разума

Стоит отметить, что хотя RT-X показывает результаты работы над различными формами роботов, это достигается за счет большего количества инженерных средств. В частности, модель выводит только траекторию конечного исполнительного органа робота (концевого исполнительного механизма). движение промежуточной соединительной оси получается в виде замкнутого решения за счет обратной кинематики. По сути, этот метод означает, что конкретная форма робота была искусственно абстрагирована, и модели не нужно заботиться о конкретной форме. Ограничением является то, что модель не может гибко использовать части тела робота, такие как люди и животные. Например, для выполнения задачи рассмотрим задачу «взять бутылку». Человек может схватить ее пальцами, схватить ладонями или даже взять бутылку, согнув ладони и руки под углом. Такого рода познание и гибкое применение онтологии — это то, чего не может достичь нынешний воплощенный интеллект.

С другой стороны, большинство задач, решаемых в настоящее время воплощенными агентами, находятся в среде, где визуальным фоном является настольный сценарий (настольный сценарий), который на самом деле значительно упрощает требования к зрительно-когнитивным способностям. Фактическое обучение. Полученная стратегия не может. быть непосредственно использовано в сложных неструктурированных фоновых средах. Причина в том, что нынешнее обучение с самоконтролем еще не способно освоить структурированное представление мира и не обладает достаточными интеллектуальными способностями к распознаванию, что также является одним из. ключевые факторы для достижения воплощенного общего интеллекта. В то же время, по сравнению со способностью людей и животных самостоятельно осваивать новые навыки, нет никаких доказательств того, что современные методы, основанные на имитационном обучении, могут посредством крупномасштабного предварительного обучения (в отличие от вышеупомянутое обобщение с нулевым выстрелом. В отличие от новых задач, здесь упор делается на новые навыки. Например, «поднять бутылку» и «поднять чашку» — это две разные задачи, но используются одни и те же навыки).

Напротив, методы обучения с подкреплением, имитируя требования курируемых данных для имитации обучения, не требуют искусственного создания сложных наборов данных для изучения стратегий. Вместо этого им нужно только взаимодействовать с окружающей средой и изучать стратегии онлайн, оптимизируя политику вознаграждения. обучение). Обучение с подкреплением (особенно безмодельное RL) не может напрямую получить информацию о градиенте динамики окружающей среды, поэтому его выборочная эффективность часто на несколько порядков ниже, чем имитационное обучение. Для стратегий обучения, которые действуют в физической среде, такой неэффективный метод обучения является. нереально. Вообще говоря, есть два решения:

- Один из них — создать симулятор, аналогичный реальной среде, использовать большой объем данных для изучения политики в симуляторе, а затем выполнить обобщение с нулевым выстрелом или точную онлайн-настройку в реальной среде (например, [5, 6] );

- Другое решение — изучить модель окружающей среды и использовать изученную модель для генерации обучающих данных (например, [7, 8, 9]), что значительно снижает потребность в данных о реальной среде. Основываясь на этой идее, Филипп Ву и др. соавт. [9] продемонстрировали, что собака-робот может научиться ходить и противостоять внешнему вмешательству всего за 1 час взаимодействия с реальным физическим миром.

Однако в настоящее время нет доказательств того, что у агентов, обученных на основе методов обучения с подкреплением, могут появиться когнитивные способности к решаемым ими задачам и средам. Например, обучение на основе метода [9] требует частой искусственной смены положения механической собаки. Поскольку функция вознаграждения механической собаки только побуждает ее двигаться вперед, она будет постоянно бросаться вперед, даже если столкнется со стеной.

Все эти результаты намекают на некоторые фундаментальные проблемы в реализации общего воплощенного интеллекта на основе текущей парадигмы глубокого обучения:

1) Текущая система обучения по-прежнему является, по сути, системой с разомкнутым циклом и требует вмешательства человеческого интеллекта (например, целевого сбора большего количества и более качественных данных на основе результатов обучения, корректировки распределения вероятностей данных, многократной итеративной оптимизации вознаграждения). функция и т. д.) для достижения замкнутого цикла,использоватьYann По словам Лекуна, нынешняя система машинного обучения Интеллект, и то, что необходимо для достижения универсального воплощенного разума, является автономным. Intelligence [10];

2) Современные методы еще не обладают способностью изучать структурированные представления и абстракции (или модели мира) о мире на основе естественных модальностей.,относительно,С младенчества люди и животные учатся с помощью естественных механизмов, таких как зрение.,Учитесь на сигналах, непосредственно полученных из внешнего мира, таких как слух), и понимайте структуру и функционирование физического мира на основе интуиции (интуитивная физика [11]), ключ к реализации всеобщего воплощения интеллекта.

Проблемы с постановкой задач,

Здравый смысл, естественные абстракции и модели мира

Из-за отсутствия способности изучать иерархические абстракции о мире.,Создание систем обучения с использованием современных методов сталкивается с очень сложной практической проблемой.:Проблемы с назначением задач [12] (ее суть также является своего рода проблемой выравнивания), с точки зрения непрофессионала, это означает, что чрезвычайно сложно обучить модель точному выполнению задачи, которую хотят от нее выполнить инженеры-люди.

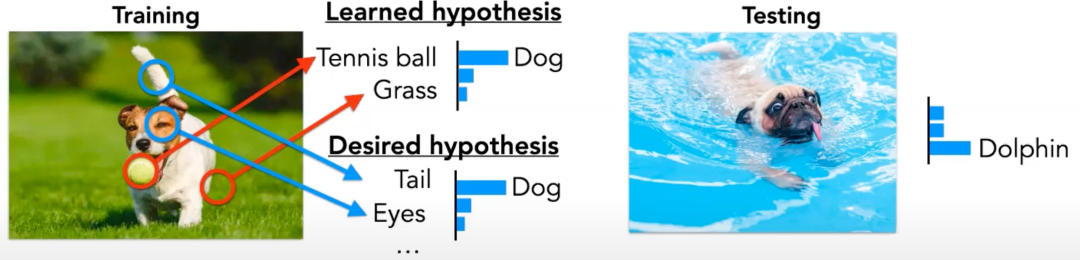

Например, если вы хотите обучить модель распознаванию изображений, модель обучается оптимизировать перекрестную энтропию своих выходных данных и меток изображений в определенном наборе данных, поэтому задача фактически неявно определяется набором данных, который значит возникает огромная задача: чтобы конкретизировать задачу, нам нужно предоставить огромный объем информации. На этом проблема не заканчивается. Например, как показано на рисунке 1, модель использовала неверный метод (путем обнаружения теннисных мячей и травы) на тренировочном наборе, чтобы получить правильную классификацию (щенок), поэтому она не прошла тест. набор (из-за обнаружения теннисных мячей и травы на фоне бассейна) неправильно классифицировал щенка как дельфина.

Рисунок 1. Алгоритм классификации изображений, основанный на контролируемом обучении, оптимизирует функцию потерь обучения на тестовом наборе (показано слева). Результатом является классификация, основанная на корреляции между признаками и метками изображений. Следовательно, на тестовом наборе (показано на рисунке). правильно) ) неправильно классифицировал щенка как дельфина из-за обнаруженного фона в бассейне (взято из MIT EI Seminar-Pulkit Agrawal-The Task Specification Problem,https://www.youtube.com/watch?v=2el3GdwS1mg&t=1962s&ab_channel=MITEmbodiedIntelligence)。

Так в чем же здесь принципиальный вопрос? Почему люди могут легко попросить другого человека что-то сделать (через естественный язык, используя лишь несколько фрагментов информации),Но приказать машине что-то сделать чрезвычайно трудоемко.?Я думаю, это потому, чтоСуществует разница между задачей, которую мы хотим, чтобы машина решила, и нашим математическим описанием задачи:получить изображение Классификация Пример,Задача, которую мы на самом деле хотим решить от машины, может заключаться в том, чтобы «классифицировать эти изображения наиболее естественным для человека способом».,вместо“Найдите метод, который лучше всего подходит для этих меток изображений.”。Так что же такое“То, что люди думают, является наиболее естественным способом”Шерстяная ткань?Вероятно, мы об этом и говоримздравый смысл(common смысле), например, когда мы классифицируем изображения, мы будем рассматривать только предмет изображения (глядя на щенка, а не на фон за ним), и мы будем различать разные объекты, ища признаки с причинно-следственными связями (поскольку они имеют причинно-следственные связи). хвосты и глаза) щенок), мы знаем отношения между предметами (например, хвост собаки — часть щенка) и так далее.

Кроме того, что такое здравый смысл? Откуда появился человеческий здравый смысл? Почему разные люди (даже представители цивилизаций, никогда не контактировавших друг с другом) обладают схожим здравым смыслом (поэтому люди могут использовать язык для общения)), и даже люди? и животные могут в определенной степени общаться, используя язык тела (включая язык тела). Я думаю, причина этого в том, что и люди, и животные обладают схожим набором естественных абстракций для познания мира. abstraction [13],Гипотеза естественной абстракции утверждает, что в нашем мире существуют некоторые стабильные низкоразмерные структуры.),Таким образом, они могут изучить схожие иерархические абстракции. Конец нижнего уровня этого набора иерархических абстракций обычно является относительно многомерным.,Распределенное непрерывное представление, которое трудно выразить непосредственно на языке, и его высокоуровневая часть обычно является низкомерной;,Представление с определенной семантической информацией после абстрактного сжатия вверху представляет собой дискретное символическое представление с четкой семантикой. в вычислениях,От низкого уровня к высокому соответствует непрерывный градиент режимов обработки информации между Системой 1 и Системой 2 в когнитивной науке.,издравый смысл соответствует структуре связей между уровнями и между различными частями слоя в этой иерархической абстрактной системе.Именно потому, что разные люди и животные могут выучить схожие абстрактные и связанные структуры.,Необходимо лишь конкретизировать задачу через дискретное символическое представление высшего уровня как носителя передачи информации.,Всю информацию о задачах низкого уровня не нужно указывать напрямую.,Вместо этого получатель информации использует метод, аналогичный байесовскому выводу (байесовский вывод), основанный на информации высокого уровня и его собственной абстрактной системе.

поэтому,Я думаю, что ключевой вопрос в реализации универсального воплощенного интеллекта заключается в том, как позволить системам машинного обучения изучать иерархические абстракции о мире (или моделях мира, когнитивных картах) на основе естественных модальностей (таких как зрение, слух, ниже мы будем называть это миром); модель для краткости).为什么这么说Шерстяная ткань?Я думаю, что есть как минимум следующие причины:

(1) Модель мира вполне может объединить восприятие и познание в рамках одной структуры.

существовать Современные встроенные интеллектуальные системысередина,Кажется, что переход от восприятия к познанию осуществляется с помощью относительно независимых модулей.,Например, трехмерная геометрическая информация об окружающей среде, такая как карты глубины, может быть получена с помощью методов, основанных на SLAM, или результаты глубокого обучения, содержащие семантическую информацию, такую как обнаружение цели, могут быть получены с помощью методов, основанных на глубоком обучении;,Классификация,Сегментация и т. д., а затем обработка результатов с помощью рукописных правил или более традиционных технологий ИИ для приобретения определенных когнитивных способностей;,Например, понимание сцены и так далее. Этот модульный подход сталкивается с большими проблемами в соединении между модулями.,Это одна из причин, почему технологию автономного вождения высокого уровня трудно реализовать.

По сути, я понимаю, что фундаментальная проблема заключается в том, что восприятие и познание представляют собой два конца одного и того же непрерывного спектра, неделимого целого. Чтобы идеально решить проблему восприятия, необходимо задействовать познание, и наоборот, а познавательные способности не являются таковыми. возникает из воздуха, поэтому разумным подходом является не прямое проектирование когнитивных модулей в интеллектуальные системы, а оптимизация задач восприятия более низкого уровня в рамках той же структуры, чтобы когнитивные способности могли проявиться естественным путем. Кажется, что вставать — это тоже то, как. люди и животные учатся понимать мир.

(2) Модель мира позволяет агентам делать долгосрочные прогнозы и планы на будущее с помощью вычислений.

Когда мы прогнозируем и планируем события, находящиеся далеко во времени и пространстве, мы часто делаем иерархические абстракции и используем относительно грубые концептуальные представления. Например, планируя поездку за границу, мы сначала рассматриваем, через какие города мы проедем. чем разбить его на направления из определенного места Как добраться от здания к зданию в другом городе. Эта способность планировать на соответствующем грубом уровне позволяет нам эффективно находить высокооптимизированное решение, используя ограниченные вычислительные ресурсы, что имеет решающее значение для долгосрочного планирования во времени и пространстве.

Майкл Левин, биолог развития из Университета Тафтса, предложил концепцию когнитивного светового конуса для измерения когнитивных способностей агентов, полагая, что агенты могут измерять, моделировать и влиять на события во времени, а пространственные границы определяют когнитивные пределы агента. . Например, люди будут заботиться о событиях и изучать их еще на зарождении Вселенной и даже на границе нынешнего горизонта Вселенной, включая события, временные и пространственные масштабы которых намного меньше/больше, чем их собственные физиологические процессы. (например, взаимодействие элементарных частиц, эволюция галактик и т. д.), поэтому люди обладают сильной способностью понимать и преобразовывать мир. Напротив, интеллектуальный агент более низкого уровня, такой как инфузория или клетка, может заботиться только о мелкомасштабных событиях, таких как градиент концентрации раствора вокруг него, и не требует высоких когнитивных способностей.

(3) Модель мира содержит причинно-следственные связи между событиями (особая абстракция времени), позволяющая агенту выполнять контрфактические рассуждения и эффективно и автоматически осваивать новые знания и навыки.

Навыки обучения людей и животных имеют гораздо более высокую эффективность выборки, чем современные системы искусственного интеллекта. Одной из важных причин должно быть то, что мы можем понять соответствие между поведением и результатами (т. е. причинно-следственную связь) с помощью мировых моделей. Поэтому, когда мы надеемся достичь определенного результата (выполнить определенную задачу), мы легко можем спланировать примерную траекторию поведения, даже если никогда раньше этого не делали. Когда мы повторяем задачу, мы продолжим делать контрфактические рассуждения, чтобы подумать, какие промежуточные шаги можно было бы сделать лучше. Этот циклический процесс — это процесс, в котором мы изучаем новые навыки.

В рамках машинного/статистического обучения

Как изучить модель мира

Тогда основной вопрос становится:Как создать систему машинного обучения, которая сможет учиться на естественных моделях мира?И следует отметить, что,Такая система обучения должна бытьautonomous интеллект, а не помощь, как сейчас требуется в результате частого вмешательства человека intelligence [10] (Если требуется сбор людей, куратор набор данных и неоднократно корректировать распределение данных для обеспечения его разнообразия); с другой стороны, предлагаемый метод обучения должен быть практичным и осуществимым, и одним из важных показателей является вычислительная осуществимость. управляемость), потому что на самом деле легко предложить некоторые методы, которые не имеют практической осуществимости для достижения воплощенного общего интеллекта, такие как точное моделирование эволюции Вселенной по законам физики и ожидание появления разумных существ, таких как человек, или пытаться использовать неисчислимые величины в качестве целей оптимизации (например, Колмогоров complexity)。

Чтобы ответить на этот вопрос, с точки зрения машинного/статистического обучения, можно рассмотреть четыре аспекта:

(1) Архитектура нейронной сети

Мозг — это динамическая система с памятью и обратными связями, которая всегда прогнозирует сенсорные сигналы и корректирует свои прогнозы. Эта иерархическая архитектура прогнозирующего кодирования (предсказывающее кодирование) связывает восприятие и познание. Вся информация о мире, которую мы можем воспринимать с первой точки зрения, — это поток информации, существующий в состоянии мозга. Напротив, сегодняшние основные архитектуры искусственных нейронных сетей являются прямыми, без потока обратной связи по состоянию или информации. Эта архитектура вряд ли сможет кодировать информацию о состоянии, которая представляет мир. Недавнее исследование [14] показывает, что способность преобразователя к контекстному обучению причинно связана с объемом его памяти (или, что эквивалентно, размером промежуточного состояния) во время прямого прохода, а не с количеством параметров модели. Это открытие показывает, что объем памяти играет решающую роль в возникновении общих способностей к обучению, а то, как эффективно построить архитектуру нейронной сети с памятью и обратными связями, является нерешенной проблемой, и ее природа чрезвычайно сложна. 15] (т.е. как измерить влияние определенного изменения в текущий момент на результаты в определенный момент в будущем, в контексте обучения нейронной сети соответствует тому, как вывести значение определенной целевой функции в будущем для настроить параметры нейронных сетей. В настоящее время наиболее распространенным алгоритмом обратного распространения ошибки в глубоком обучении является механизм присвоения кредитов).

При освоении нового навыка мозг динамически генерирует сигналы вознаграждения, которые способствуют формированию и укреплению нейронных цепей, специфичных для конкретной задачи. Напротив, современные системы машинного обучения полагаются на информацию, содержащуюся в наборах данных или функциях вознаграждения, разработанных инженерами, и пока не способны генерировать данные, выходящие за рамки распределения данных посредством самоитерации. Я думаю, что это в некотором смысле отражает текущую ситуацию. Система пока не смогла реализовать способность разумных агентов уменьшать информационную энтропию за счет интеграции и обработки информации, аналогично способности живых организмов уменьшать свою термодинамическую энтропию за счет поглощения энергии.

С точки зрения сложных динамических систем, нисходящая причинно-следственная связь, проявляемая мозгом (то есть когнитивные процессы относительно высокого уровня, в свою очередь, влияют на нейронную активность относительно низкого уровня), является общей чертой некоторых сложных динамических систем. различные масштабы, такие как клетки, человеческое тело, компании и человеческие общества, среди других. Эти системы часто содержат несколько уровней циклов обратной связи, в которых компоненты, обладающие полномочиями на каждом уровне, участвуют в решении соответствующих проблем, подвергаясь при этом влиянию и ограничениям со стороны более низких и более высоких уровней. Например, в компании низовые сотрудники отвечают за решение задач на низовом уровне и управляются управленческими сотрудниками. Управленческие сотрудники также управляются высшим руководством. Каждый уровень должен заботиться только о проблемах своего уровня, и они объединяются, образуя единое целое. с независимым принятием решений и адаптивностью. Майкл Левин называет эту архитектуру многомасштабной. competency [16],И отметил, что эта архитектура эффективно позволяет избежать микроуправления компонентами нижнего уровня компонентами верхнего уровня.,Сделайте всю систему более эффективной с вычислительной точки зрения.,Также более устойчивый и прочный。Поэтому я думаю, что обратная связь существует в разных масштабах. цикл) может быть автономным Решающее значение имеет появление интеллекта, которого нет в нынешней системе.

(2) Правила обучения

В приведенном выше обсуждении также упоминалось, что современные нейронные сети обычно используют архитектуры с прямой связью не потому, что мы не хотим использовать архитектуры нейронных сетей с многоуровневыми циклами обратной связи и состояниями, а потому, что мы не знаем, как эффективно их обучать. архитектура. Даже до того, как Хинтон и другие ученые предложили обратное распространение ошибки в 1986 году, никто не знал, как эффективно обучать многослойные нейронные сети прямого распространения. В то время основным методом все еще было послойное обучение, но эффективность этого метода локального обучения была намного ниже. обратному распространению ошибки.

Поэтому закономерный вопрос:Какие правила обучения использует мозг?Данные нейробиологии и биологии,Мозг вряд ли будет выполнять обратное распространение ошибки,Zador Anthony et. Al. [15] полагают, что мозг использует гибкие рекурсивные структуры и механизмы для эффективного решения временных проблем в режиме онлайн. credit проблема назначения, но конкретный механизм и принципы не совсем понятны. Однако множество данных показывает, что механизм обучения мозга, скорее всего, будет локальным. Преимущество локального механизма обучения состоит в том, что ему не требуется синхронизировать глобальную информацию и он более устойчив к шуму (мозг — это физическая система). Нахарро Э. и Ризи С. показывают, что локальное правило Хебба можно выучить. Правило), чтобы позволить случайно инициализированной сети непрерывно самоорганизовать свои веса в течение ее жизненного цикла, чтобы агенты с разными формами могли научиться ходить, и в то же время морфологические повреждения, не встречающиеся в процессе обучения (например, удаление нескольких Одноногие роботы в тесте на одну ногу) прочные.

Похоже, это указывает на то, что локальные правила обучения должны решить некоторые существенные различия в обучении между современными системами ИИ и естественным интеллектом:

1) Фазы обучения и вывода отделены друг от друга. В процессе обучения веса обновляются посредством обратного распространения стохастического градиентного спуска (SGD), хотя на этапе вывода они обычно остаются неизменными;

2) Методы, основанные на статистическом обучении, обычно предполагают, что распределение среды является стационарным (например, обучение проводится на случайно перетасованном закрытом наборе данных), чему практически невозможно удовлетворить для естественного потока данных;

3) Современные методы обучения не могут обеспечить непрерывное обучение на протяжении всей жизни для нестатических сред/распределения задач, но сталкиваются с проблемой катастрофического забывания. Для общего воплощенного интеллекта решающее значение имеет способность продолжать обучение, поскольку мир постоянно развивается. Только постоянно изменяя свое внутреннее состояние для адаптации к меняющейся среде, общий интеллектуальный агент может обеспечить универсальность своих возможностей. Представьте себе, что мы хотим, чтобы общий интеллект решал проблемы, с которыми люди столкнутся через пять лет. Очевидно, что сейчас у нас нет возможности собирать данные, связанные с этой задачей. Только предоставив ему мета-способность к обучению, мы можем гарантировать это. Новые задачи появятся только в будущем, поэтому стоит изучить биологическую пластичность и временное присвоение кредитов. Эти механизмы могут быть более эффективными в достижении непрерывного онлайн-обучения, необходимого для адаптации воплощенного интеллекта. меняющийся мир.

(3) Целевая функция

Если предположить, что изучение модели мира можно свести к оптимизации целевой функции, какой может быть эта целевая функция? Основатель Deepmind, технический директор Шейн Легг и его наставник Маркус Хаттер предположили, что в пассивной среде (это означает, что агент не может напрямую предпринимать действия для вмешательства в окружающую среду) универсальным показателем интеллекта является способность предсказывать будущее [17]. Йи Ма, Дорис Цао и Хынг-Юнг Шум предположили, что цель обучения — найти закономерности и закономерности в данных, которые можно формализовать как оптимизацию информационной метрики, называемой скоростью искажения. Сущность оптимизации этой цели заключается в сжатии информации и Разреженность представления особенно впечатляет тем, что метод оптимизации искажения скорости путем градиентного спуска может естественным образом привести к архитектуре, аналогичной ResNet/Transformer [18]. В определенной степени всю историю науки о человеке можно также рассматривать как сжатие (нахождение закономерностей) и предсказание (на основе найденных закономерностей). Фактически, существует эквивалентность между прогнозированием и сжатием. Подробности можно найти в [19].

Однако прогнозирование/сжатие само по себе не гарантирует изучение модели мира, поскольку активное получение информации о мире посредством взаимодействия с окружающей средой является важным процессом для изучения модели мира. Кроме того, универсальный человекоподобный агент должен иметь возможность автономно приобретать новые навыки и знания, такие как ходьба, разговор, манипулирование объектами, проведение мысленных экспериментов и даже изобретение математических и физических теорий. Существует ли универсальная цель, которая позволяет проявиться такому поведению? Принцип свободной энергии (FEP), предложенный Карлом Фристоном, кажется многообещающим кандидатом для достижения этой цели [20]. Принцип свободной энергии объединяет действие и восприятие в рамках активного восприятия. Минимизируя вариационную свободную энергию, он побуждает агентов активно получать информацию для изучения моделей мира, чтобы уменьшить свои неожиданности в будущих наблюдениях. В отличие от обучения с подкреплением, в рамках активного восприятия агенту не нужны внешние вознаграждения, связанные с выполнением задачи, что позволяет избежать трудностей, возникающих при искусственном проектировании функций вознаграждения. Однако применение FEP на практике столкнется с теми же проблемами, что и вариационный вывод: трудно найти подходящее семейство параметризованных функций, которые могли бы выражать сложные распределения вероятностей и были бы управляемы с помощью вычислений.

Что касается решения вычислительной возможности распределения многомерных данных, такие ученые, как Ян Лекун и Йошуа Бенджио, предприняли множество попыток. Например, Янн отметил в [10], что для многомерных данных статистика, превышающая второй порядок, практически нецелесообразна с вычислительной точки зрения, основная проблема в изучении распределений вероятностей заключается в том, как эффективно после расчета коэффициента нормализации (статистической суммы) , мозг не может изучить распределение всех многомерных данных. На основании этого он предложил модель, основанную на энергии. модели), то есть не параметризация распределения вероятностей напрямую, а параметризация функции, не требующей нормализации для выражения совместимости между данными (интуитивно говоря, она заключается в описании того, какие ситуации могут возникнуть, какие ситуации вряд ли возникнут, и какие ситуации практически невозможны).

По сравнению с FEP, более осуществимым методом является изучение модели мира посредством состязательного обучения.нравитьсяHerrmann V、Kirsch Л и Шмидхубер Джей разработал алгоритм, который позволяет вести состязательную игру между нейронной сетью, называемой моделью мира, и нейронной сетью, называемой контроллером. Внутренней наградой контроллера может быть получение информации от модели мира, прогресс сжатия алгоритма или правильность решения более абстрактных задач. с вычислимыми ответами и т. д. Они показывают, что обучение возможно посредством самостоятельно изобретенных мысленных экспериментов, кодирующих веса нейронной сети. [двадцать один]. Кроме того, исследования Ма, Цао и Шума показали, что [18], используя сжатие информации в качестве целевой функции, и может эффективно избежать нейронного коллапса посредством игры с нулевой суммой в замкнутом цикле между сетью датчика (кодировщика) и сетью контроллера (декодера). [22], это большая проблема, с которой сталкивается традиционное (само)контролируемое обучение. Все эти результаты указывают на то, что сжатие, получение информации и некооперативные игры могут быть очень общими целями/механизмами и способствовать появлению общего интеллекта и заслуживают дальнейшего исследования масштабируемых вычислительных методов для моделирования и оптимизации этих целевых функций.

(4) Данные/окружающая среда

Данные и среда, в которой обучаются агенты, также играют ключевую роль в формировании общего интеллекта. В настоящее время основной подход заключается в разделении моделей сбора данных и обучения, и мы также увидели, что это имеет ограничения для сложных практических задач. Например, автономные транспортные средства должны достигать человеческих характеристик в различных дорожных условиях и планах дорог. навыков, легко обнаружить, что обучение на фиксированном наборе данных невозможно. Вместо этого необходимо постоянно использовать изученную в данный момент стратегию вождения для сбора новых данных и использовать новые данные для дальнейшего обновления стратегии вождения для достижения обратная связь замкнутого цикла. На самом деле, вождение человека похоже. различные дорожные условия, в этом процессе мозг полагается на когнитивную способность непрерывно генерировать новые нейронные цепи для решения специализированных задач, поэтому мы можем чувствовать, что будем более сосредоточены, когда дорожные условия изменятся (задействуется внимание системы 2). , и через некоторое время мы больше не будем. Необходимость вмешательства внимания постепенно становится легче (сформировались специализированные нейронные цепи).

Более того, я считаю, что фундаментальная проблема моделей обучения/(обучения с подкреплением) на фиксированных наборах данных и обучения агентов в закрытой среде заключается в том, что агентам часто не требуется осваивать мета-способность обучения (то есть соответствующую вышеупомянутая способность человека адаптироваться к новым ситуациям) может решить задачу, то естественно, что агент не научится этой метаспособности. Кстати, Эван Хубингер и др. [23] предложили концепцию меза-оптимизатора и считали, что явление меза-оптимизации существует в системах машинного обучения (здесь стоит отметить, что меза-оптимизация и метаоптимизация — два похожих, но разных понятия, последняя относится к Оптимизировать сам алгоритм оптимизации на более высоком уровне), то есть базовый оптимизатор (базовый optimizer),Часто это относится к алгоритмам оптимизации, основанным на градиентном спуске и обратном распространении ошибки.,МожетЕго можно использовать для оптимизации нейронной сети, а оптимизированная нейронная сеть сама станет оптимизатором (обученный оптимизатор/меза-оптимизатор).

Например, преобразователь, обученный работе с крупномасштабными данными, появится в контексте способность учиться [24] и обнаружили, что появление этой способности причинно связано с разнообразием задач в наборе данных. Эта способность сама по себе эквивалентна некоторой оптимизации обучения. [25]. Так как же понять это возникающее явление? Эван Хубингер и др. [23]предоставить мнение:Когда характеристики среды задачи включают разнообразие, множественное ветвление и включают новые ситуации или экземпляры задач, меза-оптимизатору легче появиться.这是什么原因Шерстяная ткань?Может以这样理解:Когда в среде задачи отсутствуют вышеуказанные характеристики,Большинство оптимизаций политики (политика оптимизация) может быть полностью завершена базовым оптимизатором для достижения очень хороших результатов. Изученная стратегия, по сути, представляет собой очень хорошо скорректированный эвристический метод, немного похожий на то, как мастер выполняет повторяющуюся задачу, не задумываясь и, наоборот, полагаясь исключительно на опыт. , если среда выполнения задачи чрезвычайно изменчива и Когда задача чрезвычайно сложна, просто полагаться на опыт не получится. Например, если вы хотите обучить агента, способного решать вопросы олимпиады по математике, вопросы постоянно меняются. Невозможно правильно ответить на каждый новый вопрос, основываясь на прошлом опыте. Тогда только тогда, когда сам мета-Оптимизатор также имеет возможности оптимизации для решения этой ситуации.

Еще два примера: 1) Если мы хотим обучить агента, способного ходить по лабиринту, форма лабиринта постоянно меняется, и практически невозможно решить его, изучая сопоставление переменных состояния с действиями (аналогично тому, как полагаться на на интуиции), но на самом деле алгоритм для решения любой задачи лабиринта требует всего лишь нескольких строк логики кода (например, поиск в ширину), поэтому лучшим решением является изучение такого алгоритма онлайн-оптимизации для решения этой задачи прохождения лабиринта. 2) Мы Окружающая среда на Земле постоянно меняется. Как базовый оптимизатор, естественная эволюция не может напрямую оптимизировать организм, который может решить любую проблему, потому что решение любой проблемы также включает в себя решение проблем, которые, возможно, потребуется решить в будущем. бесконечен, поэтому естественная эволюция в конечном итоге оптимизировала общий интеллект/меза-оптимизаторы, такие как люди и животные, которые могут адаптироваться к изменяющейся среде посредством непрерывного обучения. Подобную точку зрения можно также использовать для объяснения общих возможностей GPT по решению задач. Модель GPT обучается на наборах языковых данных уровня Интернета. Чтобы иметь возможность уменьшить функцию потерь на таком разнообразном обучающем наборе, необходимо. Вероятно, модель, аналогичная модели -Context Learning, способна оптимизировать онлайн-обучение.

более внимательно,Я думаю, что среда, подходящая для появления общего интеллекта, должна, по крайней мере, обладать характеристиками открытости и нестационарности. Например, в мире, в котором мы живем, постоянно возникают новые сложности.относительно,Подавляющее большинство текущих сред обучения с подкреплением ограничены.,Как и в отдельной игре, всегда есть время пройти уровень.,После прохождения уровня нет дальнейшей мотивации или необходимости учиться и адаптироваться к новой среде.,Тогда, естественно, нет необходимости в возникновении адаптивных и общеобучающих способностей.

Подвести итог

В этой статье представлены методы (обучение с имитацией и обучение с подкреплением), используемые в исследованиях воплощенного интеллекта, основанные на современной технологии глубокого обучения, и проблемы, с которыми они сталкиваются, а также анализируется прогресс, достигнутый недавними работами, основанными на базовых моделях, на пути к универсальному воплощенному интеллекту. его ограничения. На этой основе мы обсуждаем фундаментальную проблему, с которой столкнется обучение воплощенных интеллектуальных систем с использованием текущего метода (проблема спецификации задачи) и ее основную причину (отсутствие структурированной иерархической абстракции, модели мира), и демонстрируем, что модель мира важна для реализации. Критичность воплощенного общего интеллекта. Наконец, возможные будущие направления улучшения текущей парадигмы глубокого обучения обсуждаются с учетом этих четырех аспектов: 1) архитектура нейронной сети, 2) правила обучения, 3) целевая функция и 4) обучающие данные/среда, чтобы обеспечить воплощенный интеллект. Способность изучать модели мира и проявлять общие способности к обучению.

(Благодарности: я хотел бы поблагодарить доктора Юэ Ютао, Сюй Боуэна и Фэн Жуйяна за их комментарии к этой статье)

Справочные источники:

[1] Lu, Kevin, et al. "Pretrained transformers as universal computation engines." arXiv preprint arXiv:2103.05247 1 (2021).

[2] Jang, Eric, et al. "Bc-z: Zero-shot task generalization with robotic imitation learning." Conference on Robot Learning. PMLR, 2022.

[3] Padalkar, Abhishek, et al. "Open x-embodiment: Robotic learning datasets and rt-x models." arXiv preprint arXiv:2310.08864 (2023).

[4] Bahdanau, Dzmitry, et al. "Systematic generalization: what is required and can it be learned?." arXiv preprint arXiv:1811.12889 (2018).

[5] Akkaya, Ilge, et al. "Solving rubik's cube with a robot hand." arXiv preprint arXiv:1910.07113 (2019).

[6] Zhuang, Ziwen, et al. "Robot parkour learning." arXiv preprint arXiv:2309.05665 (2023).

[7] Ha, David, and Jürgen Schmidhuber. "World models." arXiv preprint arXiv:1803.10122 (2018).

[8] Hafner, Danijar, et al. "Dream to control: Learning behaviors by latent imagination." arXiv preprint arXiv:1912.01603 (2019).

[9] Wu, Philipp, et al. "Daydreamer: World models for physical robot learning." Conference on Robot Learning. PMLR, 2023.

[10] LeCun, Yann. "A path towards autonomous machine intelligence version 0.9. 2, 2022-06-27." Open Review 62.1 (2022).

[11] Piloto, Luis S., et al. "Intuitive physics learning in a deep-learning model inspired by developmental psychology." Nature human behaviour 6.9 (2022): 1257-1267.

[12] Agrawal, Pulkit. "The task specification problem." Conference on Robot Learning. PMLR, 2022.

[13] https://www.lesswrong.com/posts/gvzW46Z3BsaZsLc25/natural-abstractions-key-claims-theorems-and-critiques-1

[14] Kirsch, Louis, et al. "General-purpose in-context learning by meta-learning transformers." arXiv preprint arXiv:2212.04458 (2022).

[15] Zador, Anthony, et al. "Catalyzing next-generation artificial intelligence through neuroai." Nature communications 14.1 (2023): 1597.

[16] Bongard, Joshua, and Michael Levin. "There’s plenty of room right here: Biological systems as evolved, overloaded, multi-scale machines." Biomimetics 8.1 (2023): 110.

[17] Legg, Shane, and Marcus Hutter. "Universal intelligence: A definition of machine intelligence." Minds and machines 17 (2007): 391-444.

[18] Ma, Yi, Doris Tsao, and Heung-Yeung Shum. "On the principles of parsimony and self-consistency for the emergence of intelligence." Frontiers of Information Technology & Electronic Engineering 23.9 (2022): 1298-1323.

[19] Grünwald, Peter. "Minimum description length tutorial." Advances in minimum description length: Theory and applications 5 (2005): 1-80.

[20] Friston, Karl. "The free-energy principle: a unified brain theory?." Nature reviews neuroscience 11.2 (2010): 127-138.

[21] Herrmann, Vincent, Louis Kirsch, and Jürgen Schmidhuber. "Learning One Abstract Bit at a Time Through Self-Invented Experiments Encoded as Neural Networks." International Workshop on Active Inference. Cham: Springer Nature Switzerland, 2023.

[22] Kothapalli, Vignesh, Ebrahim Rasromani, and Vasudev Awatramani. "Neural collapse: A review on modelling principles and generalization." arXiv preprint arXiv:2206.04041 (2022).

[23] Hubinger, Evan, et al. "Risks from learned optimization in advanced machine learning systems." arXiv preprint arXiv:1906.01820 (2019).

[24] Kirsch, Louis, et al. "General-purpose in-context learning by meta-learning transformers." arXiv preprint arXiv:2212.04458 (2022).

[25] Akyürek, Ekin, et al. "What learning algorithm is in-context learning? investigations with linear models." arXiv preprint arXiv:2211.15661 (2022).

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами