PatchTST: артефакт долгосрочного прогнозирования серий

Модели на основе трансформаторов успешно используются во многих областях, таких как обработка естественного языка (например, модели BERT или GPT) и компьютерное зрение, и это лишь некоторые из них.

Однако,Когда дело доходит до временных рядов,Многие методы SOTA в основном реализованы с помощью MLPМодель (Multilayer Perceptron).,Такие как N-BEATS и N-HiTS. В недавнем посте бумаги даже показано,на многих эталонных наборах данных,простой линейный Модельпревосходит комплексную основуtransformerизпредсказывать Модель(Чжэн и др., 2022 г.[1])。

Новая Модель на базе трансформера.,в длинных временных рядахпредсказывать任务中取得了很厉害из结果:PatchTST。

PatchTSTдаpatch time series transformerиз缩写,它да由Nie, NguyenОжидание кого-то2023Год3月избумагавпервые предложено в:A Time Series is Worth 64 Words: Long-Term Forecasting with Transformers[2]。с другими на основеtransformerиз Модельпо сравнению с,Предложенный ими метод дает самые современные результаты.

В этой статье мы впервые изучили внутреннюю работу PatchTST. Затем примените эту Модель в проекте предсказывать.,И сравните его производительность с моделями MLP, такими как N-BEATS и N-HiTS.,оценить егопроизводительность。

Конечно, для получения более подробной информации о PatchTST обязательно обратитесь к оригинальной статье.

Изучите PatchTST

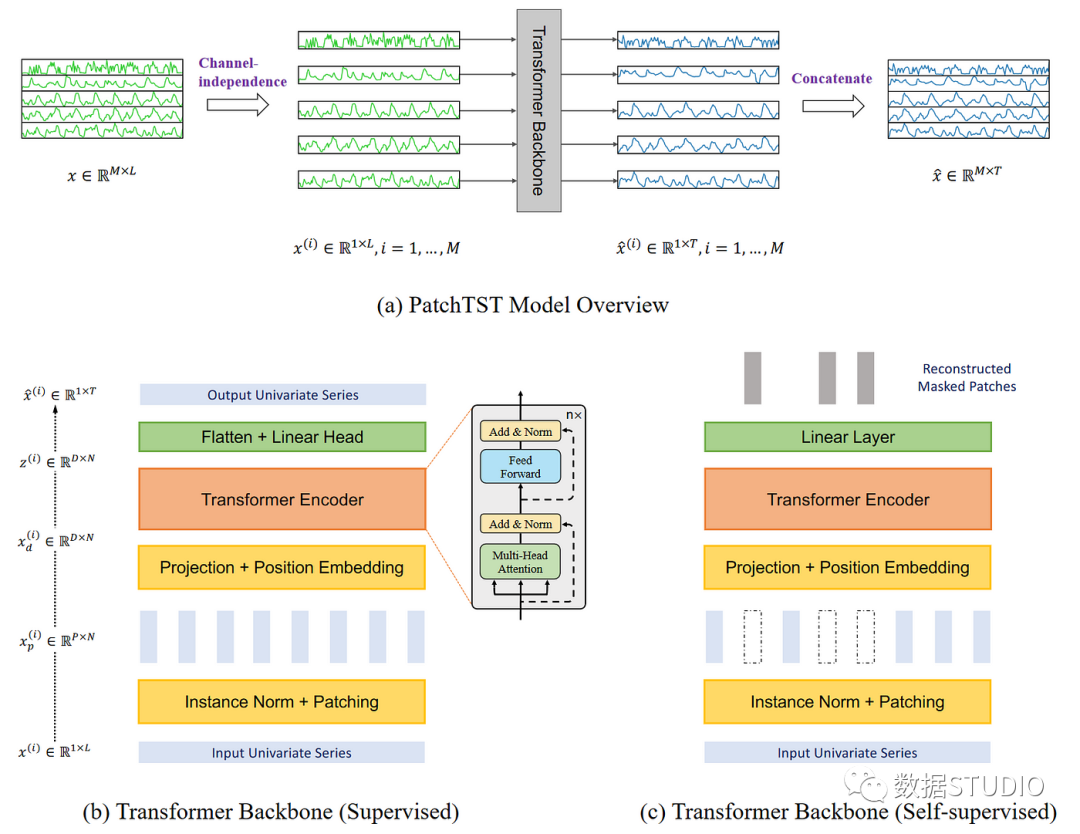

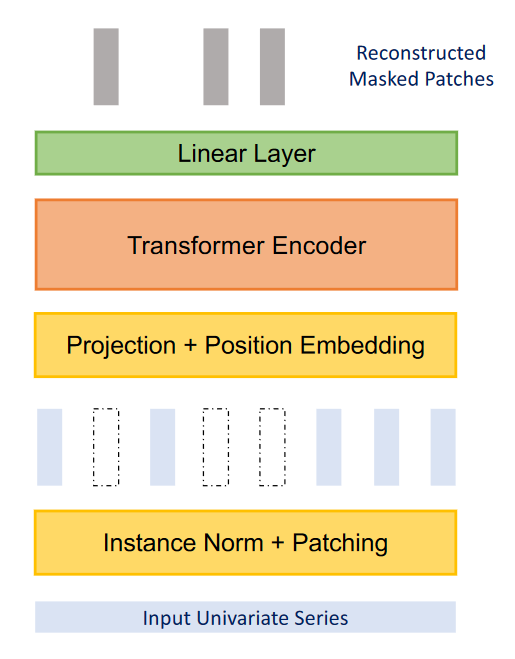

Как следует из названия,Он использует структуру патчей и преобразователей. Он также включает в себя Независимый канал, для обработки нескольких переменных временных рядов. Общая архитектура показана ниже.

Структура PatchTSTМодель. Мы видим, что Модель использует Независимый каналсекс, чтобы выдержать большепеременнаяиз时间序列。существоватьtransformerв багажнике,Мы также видим использование патчей (показано прямоугольником). кроме того,Модель поставляется в двух версиях: контролируемая и самоконтролируемая.

Много информации можно почерпнуть из изображения выше. здесь,Ключевым моментом является то, что PatchTST использует независимость каналов для создания нескольких временных рядов. Затем,В своей трансформаторной магистрали,Модель использует патч,Эти патчи показаны маленькими вертикальными прямоугольниками. кроме того,Должен Модель Есть две версии:Надзор и самоконтроль。

Далее мы обсудим архитектуру и принципы PatchTST более подробно.

Независимый канал

Здесь многомерный временной ряд рассматривается как многоканальный сигнал. Каждый временной ряд представляет собой канал, содержащий сигнал.

Обзор PatchTSTМодель. здесь,На что мы действительно обращаем внимание, так это на реализацию Независимый канал.,То есть каждый тег, вводимый в магистраль Transformer, содержит информацию только для одного канала.,или временной ряд

На картинке выше,Мы видим, как несколько временных рядов можно разделить на один ряд.,И каждая последовательность передается в магистраль Transformer в качестве входного токена. Затем,предсказывать для каждой серии,И объединить результаты, чтобы получить окончательный предсказывать результат.

Patching

Больше всего о основеtransformerизпредсказывать Модельиз工作集中существовать建立新из机制来简化原有из注意力机制。Однако,Они по-прежнему полагаются на точечное внимание.,Это не идеально, когда речь идет о временных рядах.

Во временном ряду предсказать,Извлеките взаимосвязь между прошлыми временными шагами и будущими временными шагами, чтобы выполнить предсказать. С точки зрения сосредоточенности на точке,Получите информацию за один временной шаг,не глядя на ситуацию вокруг этого момента. другими словами,изолировать временной шаг,не глядя на точки до и после.

Это все равно, что пытаться понять значение слова, не глядя на слова, окружающие его в предложении.

Поэтому PatchTST использует исправления для извлечения локальной семантической информации во временных рядах.

Как работает исправление

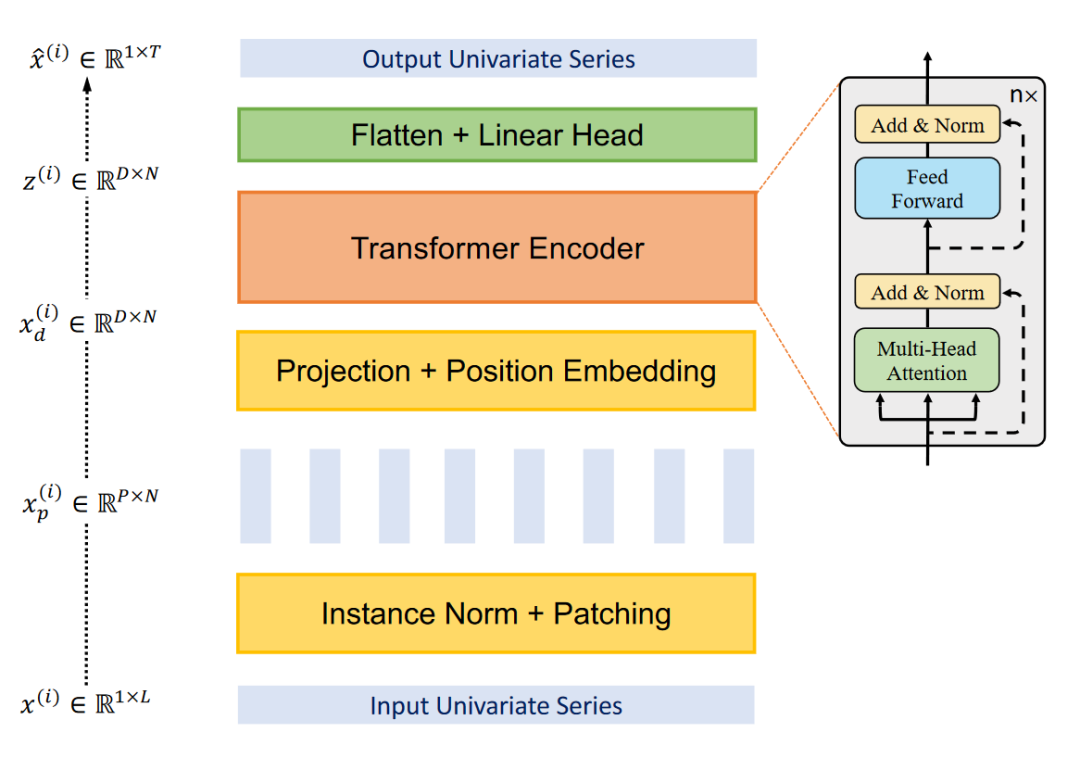

Каждая входная последовательность разделена на патчи, которые представляют собой более короткие последовательности исходной последовательности.

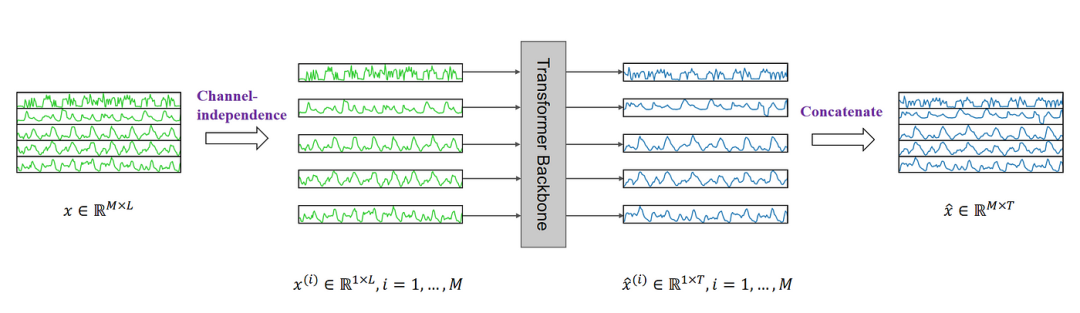

Схема магистральной сети трансформатора PatchTST. здесь,Мы видим, что входной временной ряд (внизу графика) исправлен.,Создано несколько патчей (вертикальные прямоугольники),Затем он отправляется в Трансформаторный энкодер.

здесь,patche可以да重叠из或不重叠из。patcheиз数量取决于patcheиздлинаPи размер шагаS。существоватьздесь,Страйд похож на свертку,Дело в том, сколько временных шагов проходит между запуском последовательных патчей.

Визуальные патчи. Здесь у нас есть последовательность из 15 временных шагов с длиной патча 5 и размером шага 5, в результате чего получается три патча.

На картинке выше,Мы можем видеть интуитивноpatcheиз结果。длина последовательности(L)для15временные шаги,patcheдлина(P)для5,размер шага(S)для5。其结果да Должен序列被分成3индивидуальныйpatches。

Преимущества исправлений

С помощью патчей модель может извлекать локальную семантику, рассматривая набор временных шагов, а не один временной шаг.

Это также имеет дополнительное преимущество:,Это значительно уменьшает количество токенов, вводимых в кодировщик преобразователя. здесь,Каждый патч становится входным токеном,подается на трансформатор. так,我们可以将令牌из数量从L уменьшено до ок.L/S。

Таким образом, мы значительно уменьшаем пространственную и временную сложность модели. Это, в свою очередь, означает, что мы можем подавать в модель более длинные входные последовательности для извлечения значимых временных отношений.

поэтому,по патчу,Модель быстрее и легче.,и может обрабатывать более длинные входные последовательности,Это значит, что можно узнать больше о сериале и лучше предсказывать.

Трансформаторный энкодер

После того как конкатенация исправлена, она подается в кодировщик преобразователя. Это классическая конструкция трансформатора, ничего не менялось.

Затем,Выходные данные подаются в линейный слой,и продолжайтепредсказывать。

Улучшение PatchTST с помощью обучения представлению

Авторы статьи предлагают еще одно улучшение модели за счет использования обучения представлению.

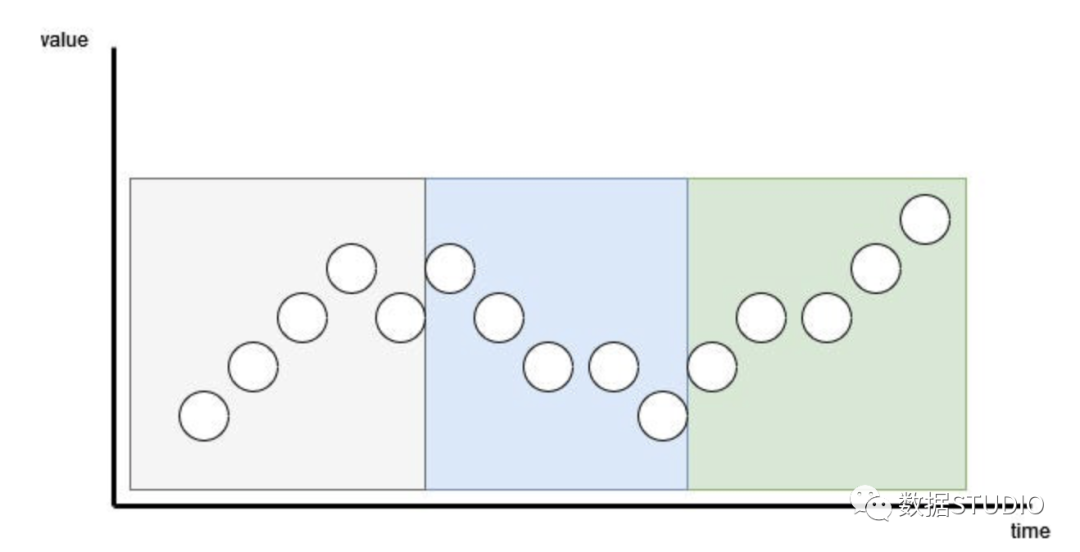

Визуализация самостоятельного обучения представлению в PatchTST. Здесь модель будет случайным образом маскировать участки и учиться их реконструировать.

На изображении выше мы видим, что PatchTST может захватывать абстрактное представление данных, используя самоконтролируемое обучение представлению. Это может привести к потенциальному улучшению предсказыватьпроизводительности.

Здесь процесс достаточно прост, так как случайные патчи будут замаскированы, то есть им будет присвоено значение 0. Затем модель обучается воссозданию исходных патчей, что представляет собой серый вертикальный прямоугольник в верхней части рисунка.

Теперь, когда вы имеете некоторое представление о том, как работает PatchTST, протестируйте его на других моделях, чтобы увидеть, как он работает.

Прогнозирование с помощью PatchTST

в этой статье,PatchTST сравнивается с другими моделями на базе трансформатора. Однако,Недавно опубликованная модель на основе MLP,Такие как N-BEATS и N-HiTS.,Он также продемонстрировал современную производительность при выполнении дальнобойных задач.

Здесь мы применяем PatchTST, а также N-BEATS и N-HiTS и оцениваем его производительность с помощью этих двух моделей на основе MLP.

В этом упражнении,Мы используем набор данных Exchange,Это общий эталонный набор данных для длинных временных рядов в исследованиях. Этот набор данных содержит ежедневные обменные курсы для восьми стран по отношению к доллару США.,С 1990 по 2016 год.

Начальная настройка

Импортируйте необходимые библиотеки,и использовать нейронный прогноз,Готовая библиотека для PatchTST. Для набора данных,Использование библиотеки прогнозов datasetsforecast,К ним относятся все популярные наборы данных для оценки алгоритма предсказать.

import torch

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from neuralforecast.core import NeuralForecast

from neuralforecast.models import NHITS, NBEATS, PatchTST

from neuralforecast.losses.pytorch import MAE

from neuralforecast.losses.numpy import mae, mse

from datasetsforecast.long_horizon import LongHorizon

Если у вас установлен CUDA, нейронный прогноз автоматически будет использовать ваш графический процессор для обучения модели. На компьютере Mac, который я использую, не установлен CUDA, поэтому я не занимаюсь значительной настройкой гиперпараметров и не тренируюсь на очень больших наборах данных.

Исследование данных

Загрузите набор данных Exchange.

Y_df, X_df, S_df = LongHorizon.load(

directory="./data",

group="Exchange")

Здесь получаются три DataFrame. Первый содержит ежедневные курсы валют для каждой страны. Второй содержит экзогенные временные ряды. Третий содержит статические экзогенные переменные (например, дни, месяцы, годы, часы или все, что мы знаем о будущем).

В этом случае толькоY_dfПроцесс。并确保这些日期有正确из类型。

Y_df['ds'] = pd.to_datetime(Y_df['ds'] )

Y_df.head()

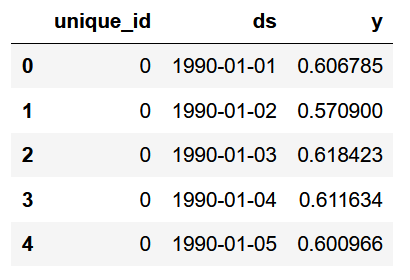

Первые пять строк набора данных Exchange

На картинке выше,Есть три столбца: первый столбец — уникальный идентификатор.,При использовании нейронного прогноза,有一индивидуальныйid列да必要из。dsВ списке с датой,Столбец y содержит обменный курс.

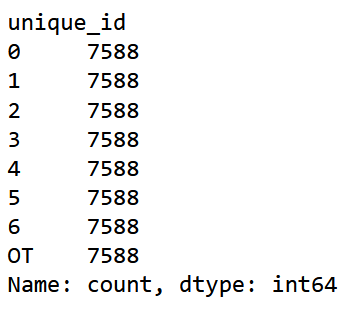

Y_df['unique_id'].value_counts()。

Показать количество наблюдений для каждого уникального идентификатора

Из картинки выше,每индивидуальный唯一изid对应一индивидуальный国家,На каждую страну приходится 7588 наблюдений.

Теперь определите размеры наборов проверки и тестирования. Для проверки было выбрано 760 временных шагов.,1517 временных шагов в качестве тестового набора,这да由Библиотека наборов данных[3]指定из。

val_size = 760

test_size = 1517

print(n_time, val_size, test_size)

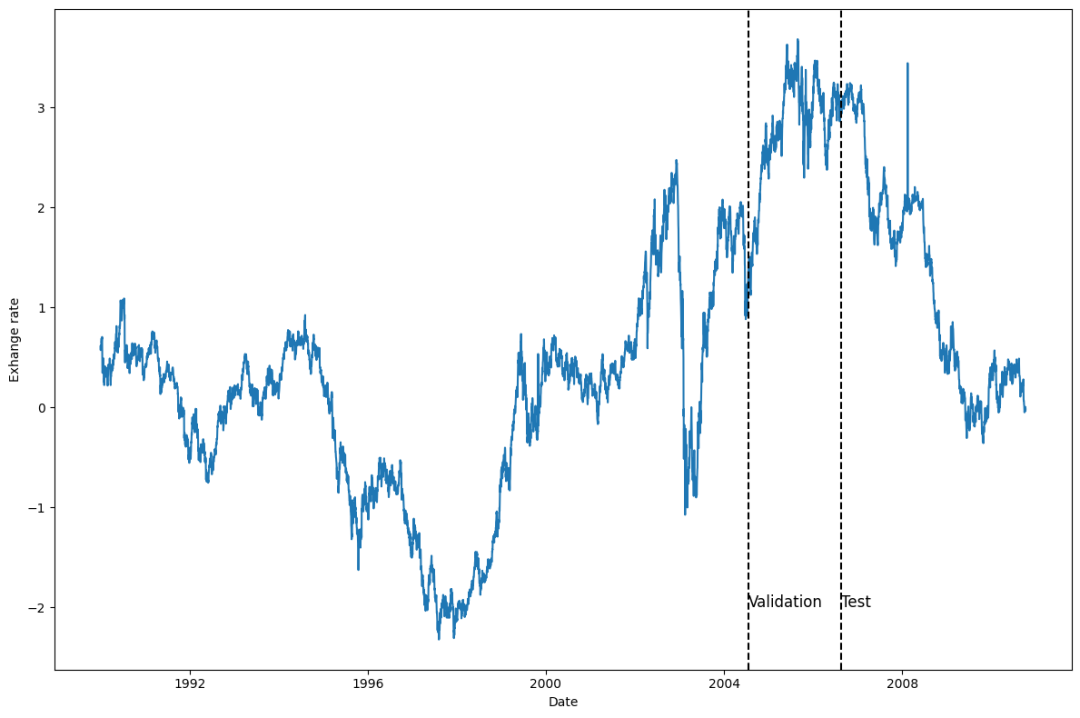

Затем绘制其中一индивидуальный系列。здесь绘制第一индивидуальный国家(unique_id = 0)из系列,Но смело рисуйте еще одну серию.

u_id = '0'

x_plot = pd.to_datetime(Y_df[Y_df.unique_id==u_id].ds)

y_plot = Y_df[Y_df.unique_id==u_id].y.value

x_plot

x_val = x_plot[n_time - val_size - test_size]

x_test = x_plot[n_time - test_size]

fig, ax = plt.subplots(figsize=(12,8))

ax.plot(x_plot, y_plot)

ax.set_xlabel('Date')

ax.set_ylabel('Exhange rate')

ax.axvline(x_val, color='black', linestyle='--')

ax.axvline(x_test, color='black', linestyle='--')

plt.text(x_val, -2, 'Validation', fontsize=12)

plt.text(x_test,-2, 'test', fontsize=12)

plt.tight_layout()

Ежедневные курсы валют первой страны с 1990 по 2016 год.

Как видно из графика выше, данные достаточно зашумлены и не имеют явной сезонности.

Моделирование

После изучения данных запустите Моделирование с помощью нейронного прогноза.

первый,Нужно установитьhorizon。существовать这种情况下,Используйте 96 временных шагов,因длясуществоватьПатч ТСТ бумага[4]中也使用了这индивидуальныйhorizon。

Затем, для объективной оценки каждой модели, установите входной размер в два раза больше горизонтальной линии (то есть 192 временных шага) и установите максимальное количество эпох равным 50. Для всех остальных гиперпараметров были сохранены значения по умолчанию.

horizon = 96

models = [NHITS(h=horizon,

input_size=2*horizon,

max_steps=50),

NBEATS(h=horizon,

input_size=2*horizon,

max_steps=50),

PatchTST(h=horizon,

input_size=2*horizon,

max_steps=50)]

ЗатеминициализацияNeuralForecastobject,Указывает частоту использования Модели и предсказывает,В данном случае это ежедневно.

nf = NeuralForecast(models=models, freq='D')

предсказывать

Чтобы сгенерировать предсказывать, используйте метод cross_validation для использования наборов проверки и тестирования. Он вернет кадр данных, содержащий все предсказываемые значения Модели и связанные с ними значения истинности.

preds_df = nf.cross_validation(df=Y_df,

val_size=val_size,

test_size=test_size,

n_windows=None)

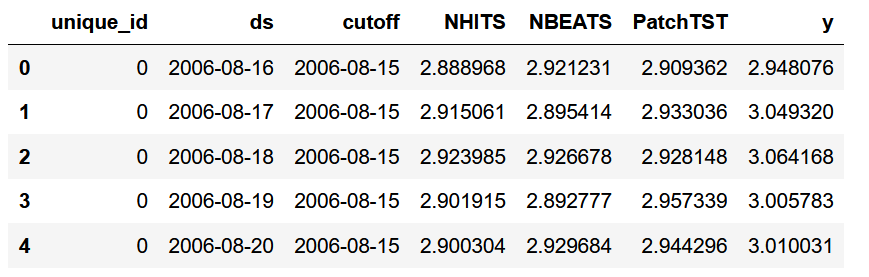

Первые пять строк предсказанное кадра

как вы видете,对于每индивидуальныйid,У нас есть значение предсказывать для каждой Модели.,а такжеy列из真实值。

Сейчас,Чтобы оценить Модель,Массивы фактических значений и предсказывать значения должны быть переформированы,使其具有一定из形状(количество рангов、Количество окон、предсказыватьобъем)。

y_true = preds_df['y'].values

y_pred_nhits = preds_df['NHITS'].values

y_pred_nbeats = preds_df['NBEATS'].values

y_pred_patchtst = preds_df['PatchTST'].values

n_series = len(Y_df['unique_id'].unique())

y_true = y_true.reshape(n_series, -1, horizon)

y_pred_nhits = y_pred_nhits.reshape(n_series, -1, horizon)

y_pred_nbeats = y_pred_nbeats.reshape(n_series, -1, horizon)

y_pred_patchtst = y_pred_patchtst.reshape(n_series, -1, horizon)

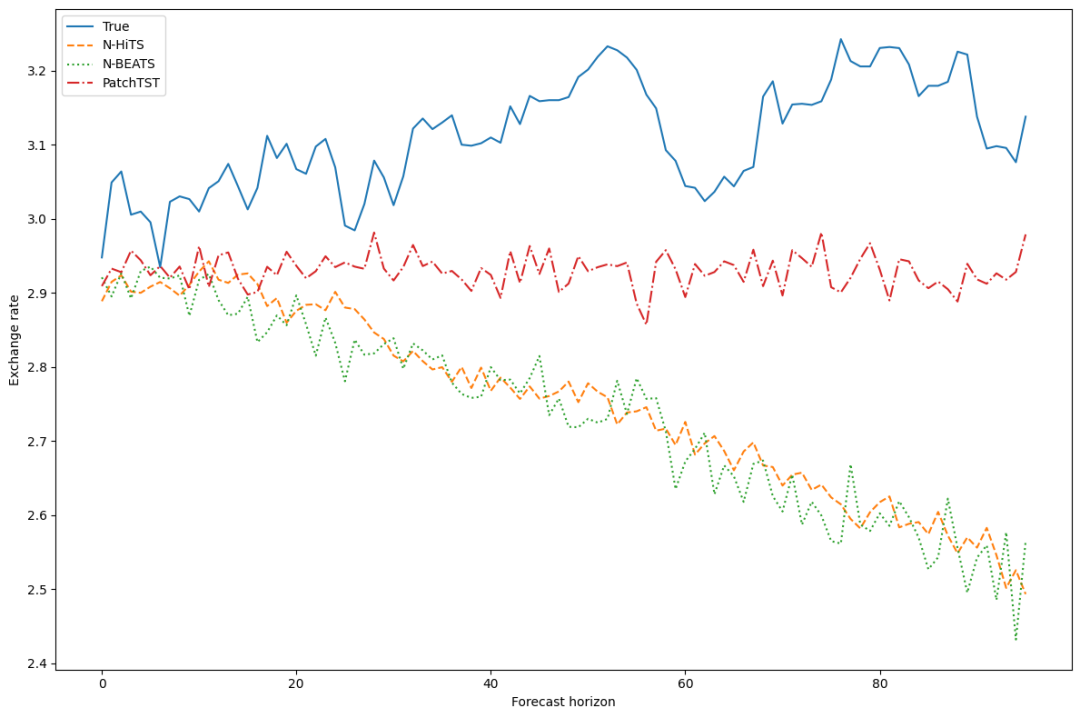

После завершения этих,Существует возможность рисовать предсказывать результаты для Модели. здесь,Мы отображаем предсказывать результаты в первом окне первой серии.

fig, ax = plt.subplots(figsize=(12,8))

ax.plot(y_true[0, 0, :], label='True')

ax.plot(y_pred_nhits[0, 0, :], label='N-HiTS', ls='--')

ax.plot(y_pred_nbeats[0, 0, :], label='N-BEATS', ls=':')

ax.plot(y_pred_patchtst[0, 0, :], label='PatchTST', ls='-.')

ax.set_ylabel('Exchange rate')

ax.set_xlabel('Forecast horizon')

ax.legend(loc='best')

plt.tight_layout()

Первую серию ежедневных курсов валют предсказать, в первом окне

Это число не идеально,Потому что предсказывать значения N-BEATS и N-HiTS, похоже, сильно отклоняются от реальных значений. Однако,Хотя в PatchTST тоже есть отклонения,Но, похоже, это наиболее близко к реальной стоимости.

конечно,мы должны относиться с осторожностью,Потому что в окне предсказывать визуализируется только серия предсказывать.

Оценка модели

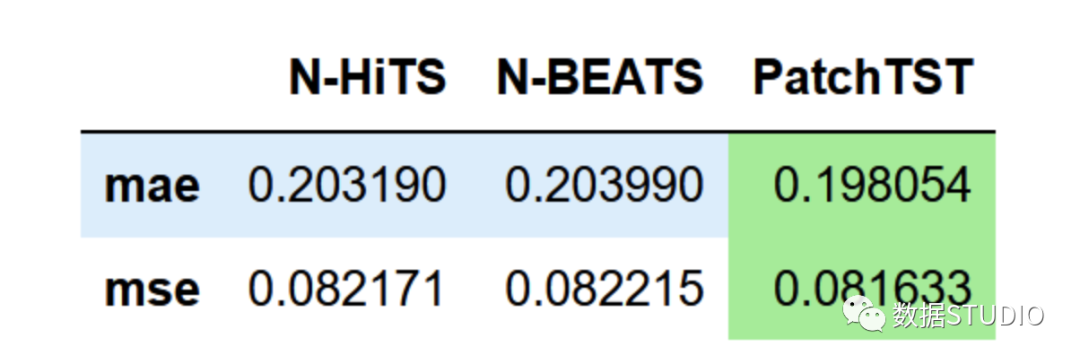

Далее мы оцениваем производительность каждой модели. Чтобы воспроизвести метод в статье, мы используем как MAE, так и MSE в качестве показателей эффективности.

data = {'N-HiTS':[mae(y_pred_nhits, y_true), mse(y_pred_nhits, y_true)]、

'N-BEATS':[mae(y_pred_nbeats, y_true), mse(y_pred_nbeats, y_true)]、

'PatchTST':[mae(y_pred_patchtst, y_true), mse(y_pred_patchtst, y_true)]] }

metrics_df = pd.DataFrame(data=data)

metrics_df.index = ['mae', 'mse'] 。

metrics_df.style.highlight_min(color='lightgreen', axis=1)

Производительность всех моделей. Здесь PatchTST достигает самых низких значений MAE и MSE.

Из приведенной выше таблицы видно, что PatchTST — это модель SOTA, поскольку она имеет самые низкие значения MAE и MSE.

конечно,Это не самый тщательный эксперимент,Потому что мы использовали только один набор данных и один диапазон предсказывать. но,См. Модель на основе трансформатора, способная конкурировать с современной моделью MLP.,Все еще очень интересно.

Подвести итог

PatchTST — это модель на основе Transformer, которая использует исправления для извлечения локальной семантики из данных временных рядов. Это позволяет модели обучаться быстрее и иметь более длинное окно ввода.

По сравнению с другими моделями на базе трансформатора он достиг производительности SOTA. В нашем случае мы увидели, что он также показал лучшую производительность, чем N-BEATS и N-HiTS.

Хотя это не значит, что это лучше, чем N-HiTS или N-BEATS.,Но при долгосрочном предсказывать,Это все еще хороший выбор.

Ссылки

[1]

Чжэн и др., 2022 г.: https://arxiv.org/pdf/2205.13504.pdf

[2]

PatchTST: https://arxiv.org/pdf/2211.14730.pdf

[3]

Библиотека наборов данных: https://github.com/Nixtla/datasetsforecast/blob/main/datasetsforecast/long_horizon.py

[4]

Статья PatchTST: https://arxiv.org/pdf/2211.14730.pdf

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами