Ollama — это лаконичная и простая в использовании локальная среда запуска больших моделей. Большие модели можно запускать локально с помощью всего одной команды.

Что такое Оллама:

Ollama — это инструмент обслуживания крупномасштабных языковых моделей с открытым исходным кодом, который помогает пользователям быстро запускать большие модели локально. С помощью простых инструкций по установке пользователи могут выполнить команду для локального запуска крупномасштабных языковых моделей с открытым исходным кодом, таких как Llama2. Эта платформа упрощает процесс развертывания и управления LLM в контейнерах Docker, позволяя пользователям быстро запускать большие языковые модели локально.

Оллама объединяет веса модели, конфигурацию и данные в пакет, определяемый как файл модели. Он оптимизирует детали настройки и конфигурации, включая использование графического процессора.

Преимущества Олламы:

①Простота в использовании: Ollama предоставляет простой API, поэтому даже неопытные пользователи могут легко его использовать. Кроме того, он также предоставляет интерфейс чата, аналогичный ChatGPT, позволяющий пользователям общаться в чате и напрямую взаимодействовать с моделью без разработки.

②Легкость: код Олламы краток и ясен и занимает мало ресурсов во время выполнения. Это позволяет ему эффективно работать локально и не требует обширных вычислительных ресурсов.

③Расширяемость: Ollama поддерживает несколько архитектур моделей и может быть расширена для поддержки новых моделей. Он также поддерживает горячую загрузку файлов моделей и может переключаться между различными моделями без перезапуска, что делает его очень гибким и универсальным.

④Предварительно созданная библиотека моделей: Ollama предоставляет предварительно созданную библиотеку моделей, которую можно использовать для различных задач, таких как генерация текста, перевод, вопросы и ответы и т. д. Это делает локальное выполнение больших языковых моделей намного проще и удобнее.

Начинайте быстро

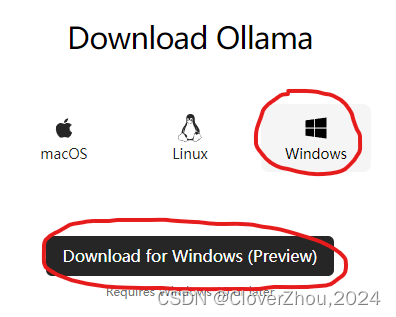

1. Загрузите установочный файл Ollama.

Посетите https://ollama.com/download, выберите Windows и нажмите «Загрузить для Windows (предварительная версия)», чтобы загрузить.

2. Установите Олламу

Дважды щелкните загруженный файл «OllamaSetup.exe», чтобы установить его.

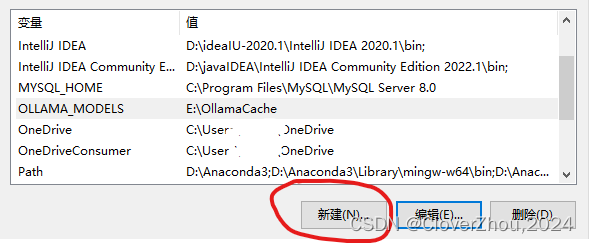

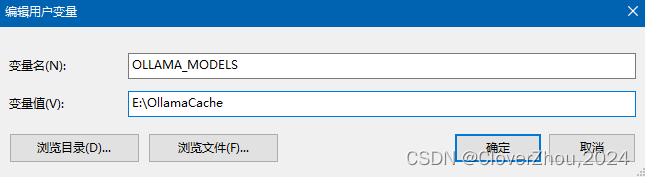

3. Переменные среды

Модель, скачанная Олламой, по умолчанию сохраняется на диске C.

Настоятельно рекомендуется изменить путь по умолчанию, который можно изменить, создав новую переменную среды OLLAMA_MODELS.

OLLAMA_MODELS E:\OllamaCache

После успешной настройки перезагрузите компьютер, чтобы изменения вступили в силу.

4. Использование Олламы

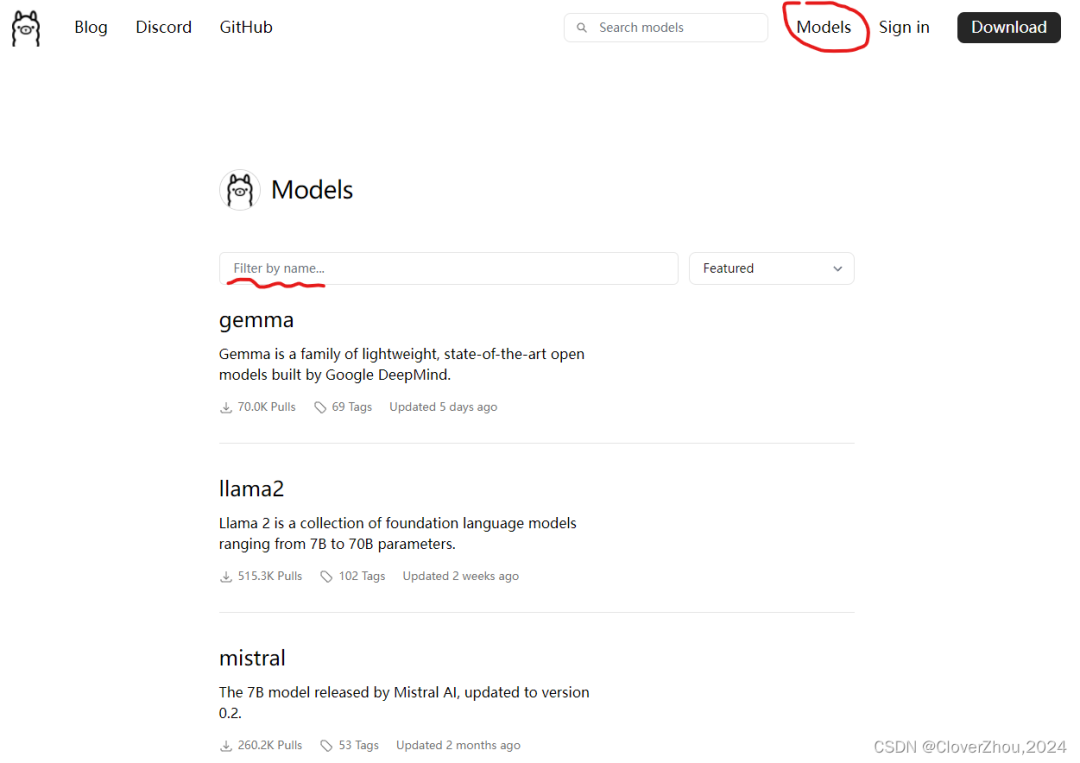

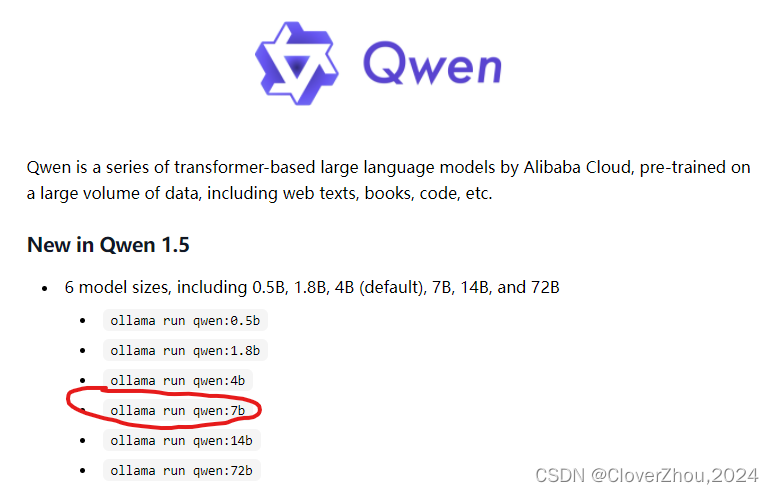

Посетите https://ollama.com/library и найдите модель, которую вам нужно использовать, основную модель.

Не забудьте сначала запустить Ollma и убедиться, что Ollma находится на панели задач.

Давайте возьмем в качестве примера qwen-7b и выберем для запуска модель 7b.

Скопируйте команду из красного поля выше и запустите ее в cmd или PowerShell (рекомендуется cmd).

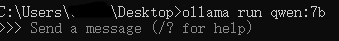

ollama run qwen:7b

Подождите, пока модель загрузится и загрузится. В настоящее время первая скорость загрузки 95% высокая, а скорость от 99% до 100% медленнее. Когда появится сообщение «Отправить сообщение», вы можете начать использовать модель.

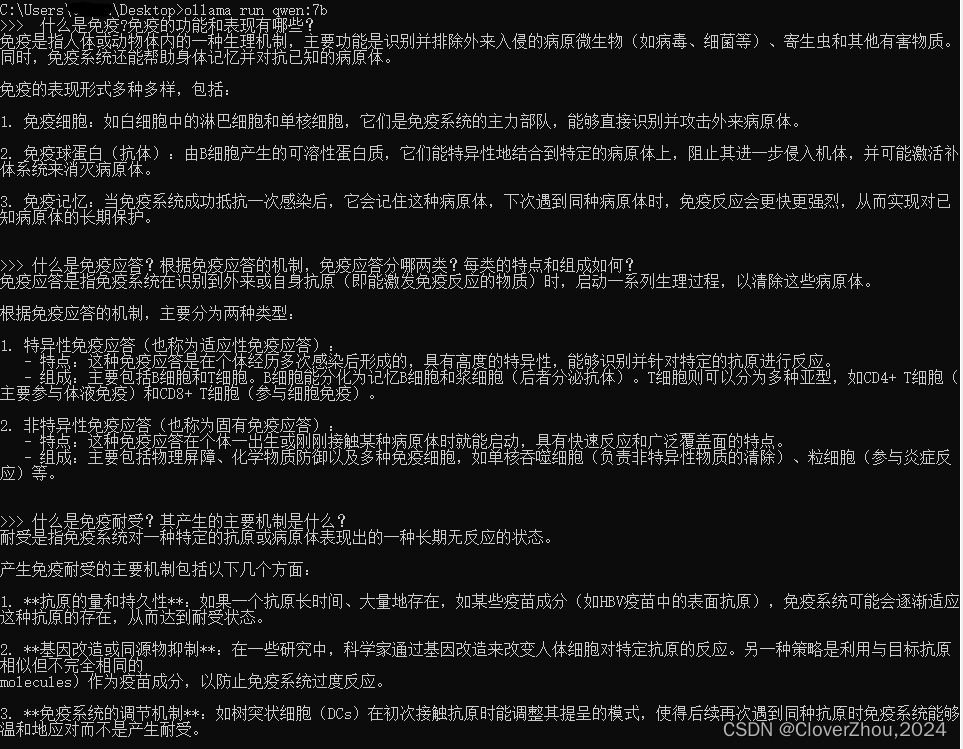

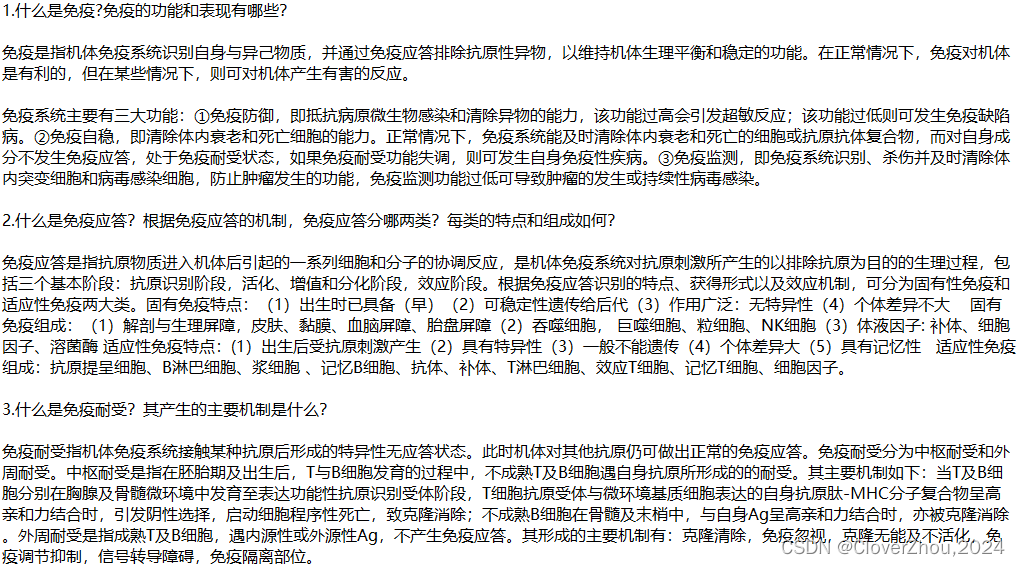

рендеринг qwen-7b:

ollama run qwen:7b

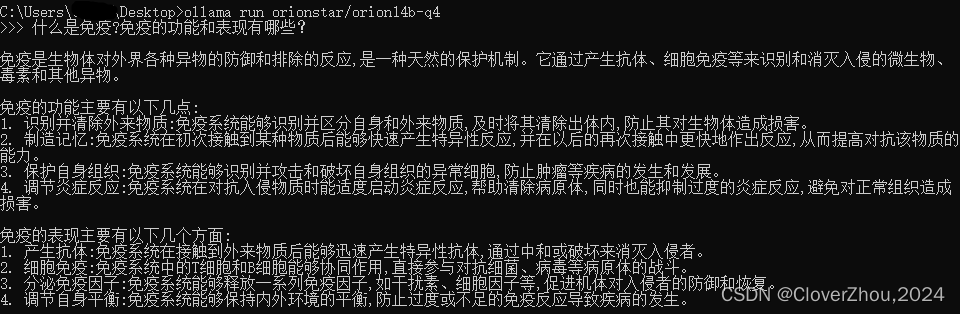

рендеры orion14b-q4:

ollama run orionstar/orion14b-q4

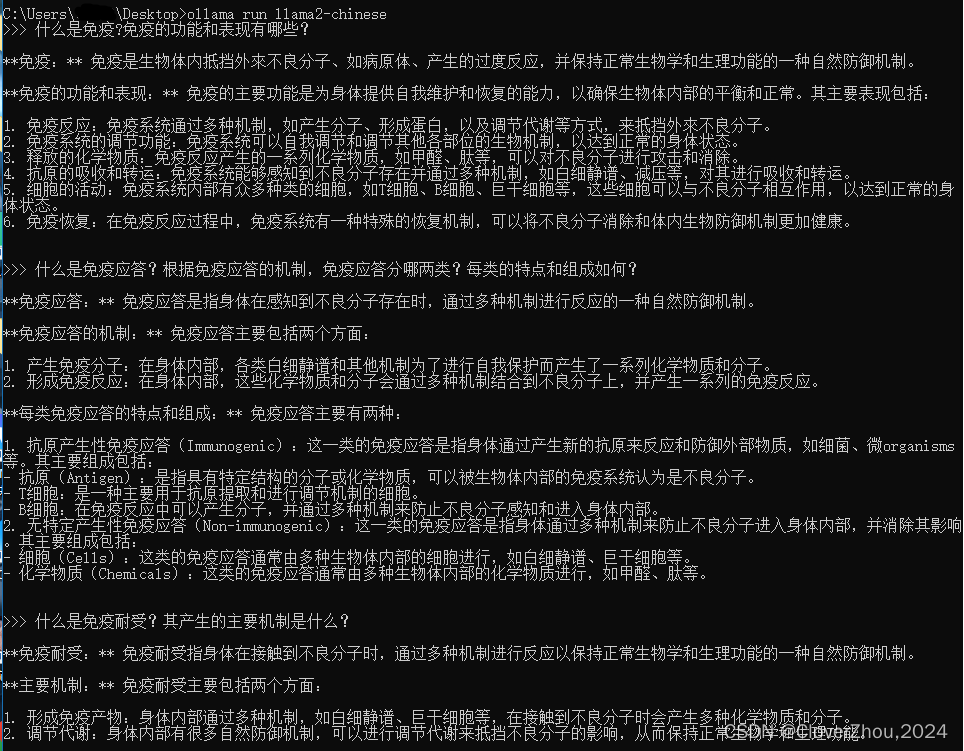

llama2-китайские рендеры:

ollama run llama2-chinese

Вопросы и ответы собраны в Интернете:

5. Используйте снова

Убедившись, что Оллама работает правильно, Введите рабочий код в cmd и можете использовать его напрямую, без скачивания и установки (модель успешно установлена на шаге 4) нравиться:

ollama run llama2-chineseЯ использую 8 ГБ-2070super, 16 ГБ памяти, i7-10700K. Работает qwen-7b и llama2-chinese довольно гладко.

Наденьте оболочку

Если вы чувствуете, что использовать командную строку непросто, у Ollama есть ряд периферийных инструментов, включая веб-страницы, рабочие столы, терминалы и другие интерактивные интерфейсы, а также множество плагинов и расширений.

Причина, по которой Ollama может быстро сформировать такую богатую экосистему, заключается в том, что с самого начала проекта у нее есть четкая позиция: позволить большему количеству людей запускать большие модели локально самым простым и быстрым способом. Таким образом, Ollama не просто инкапсулирует llama.cpp, но одновременно упаковывает множество параметров и соответствующих моделей; таким образом, Ollama примерно соответствует краткому инструменту командной строки и стабильному серверному API. Это обеспечивает большое удобство для последующих приложений и расширения.

Что касается графического интерфейса Ollama, существует множество вариантов в зависимости от предпочтений:

Веб-версия: Ollama WebUI имеет интерфейс, наиболее близкий к ChatGPT, и богатейшие функциональные возможности, его необходимо развертывать с помощью Docker;

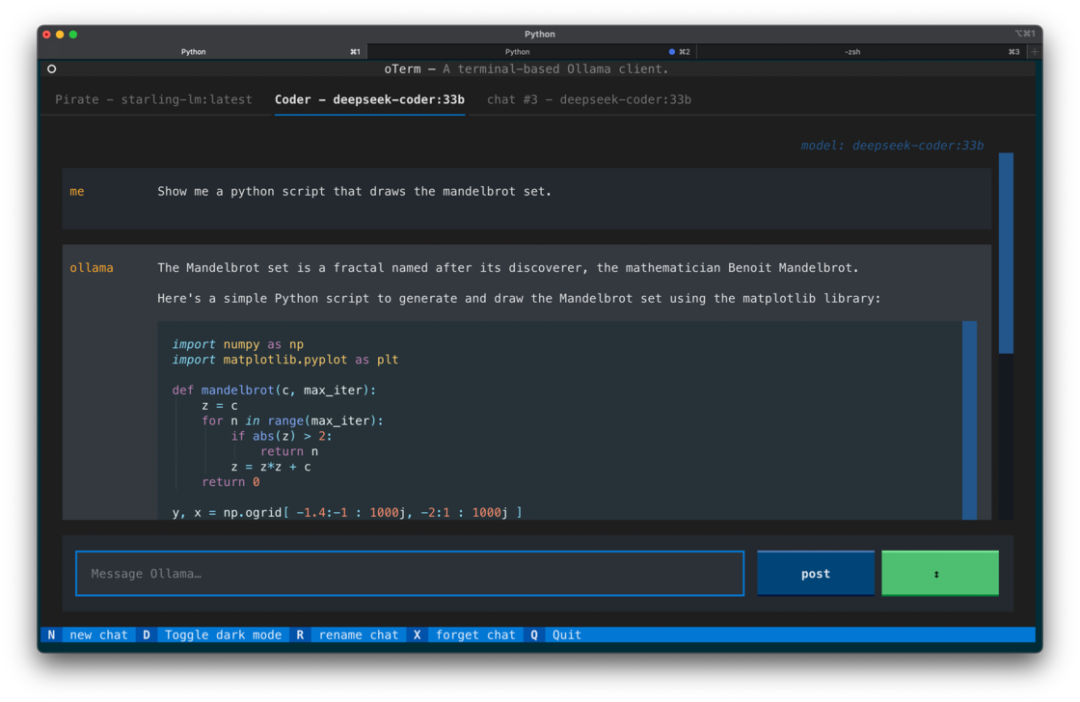

Терминал TUI Версия: отерм Обеспечивает полные функции и поддержку сочетаний клавиш, используйте brew или pip Установить;

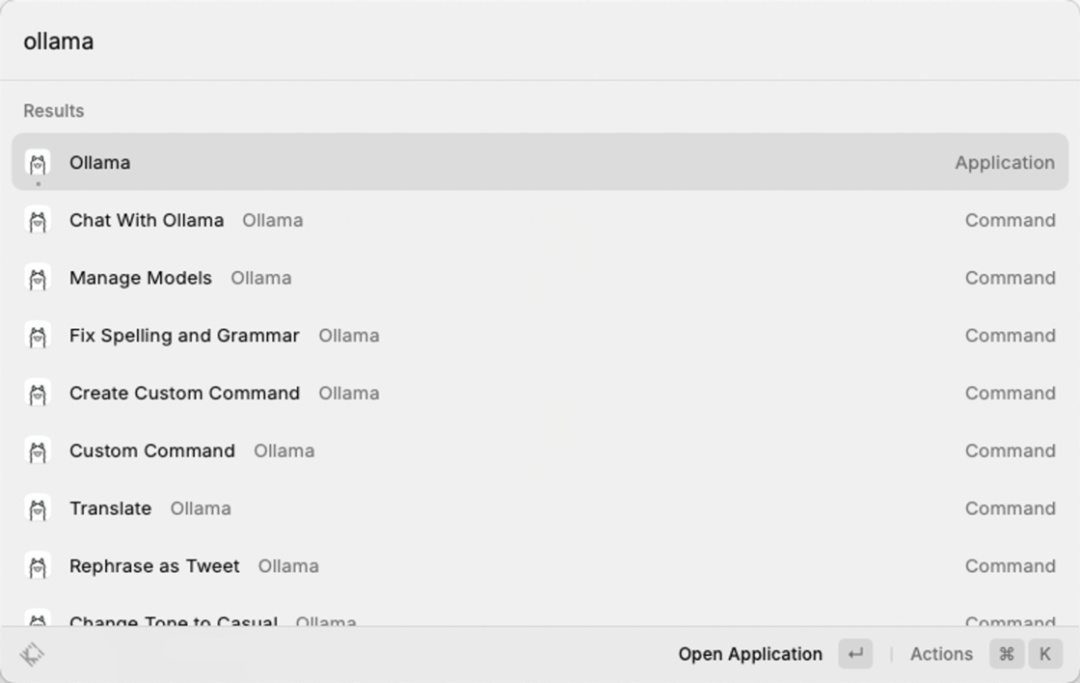

Raycast Плагин: т.е. Raycast Оллама, лично я этим пользуюсь чаще всего Ollama внешний интерфейс Пользовательский интерфейс, который наследует Raycast Преимущество из заключается в том, что вы можете напрямую вызвать команду после выбора оператора или скопировать для удобства работы. И как значение ок. 8 долларов США/месяц Raycast AI Альтернатива Рейкасту Ollama Осуществленный Raycast AI большинство функций и с Ollama и итерация моделей с открытым исходным кодом, которые также будут поддерживать мультимодальность и т. д. Raycast AI Неподдерживаемые функции имеют неограниченный потенциал.

Кроме того, есть еще интересные приложения, такие как Ollamac — нативное приложение для macOS, написанное на Swift, и Obsidian Ollama, похожее на Notion AI, и его можно выбирать по мере необходимости.

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами