Обычные компьютеры также могут работать с большими моделями, и вы можете получить личного помощника с искусственным интеллектом за три шага | Руководство для новичков по локальному развертыванию LLaMA-3

“ Запустите на своем компьютере мощный помощник с искусственным интеллектом. Он не только обладает превосходными возможностями, но и скрывает все секреты на вашем жестком диске. Интересно, как это достигается? Двигайте руками, и вы сможете выполнить излокальное LLaMA-3 за три минуты. развертывание!”

01、LLaMA-3

Недавно я экспериментировал с проектом улучшенной генерации (RAG). Я хотел попробовать перейти на более мощную модель, чтобы посмотреть, улучшится ли эффект. Я попробовал построить большую частную модель локально в качестве базовой модели. На этот раз я попробую LLama3. В следующий раз возьмем модель Qwen2 от Alibaba Tongyi Qianwen.

Еще в апреле Meta выпустила с открытым исходным кодом LLaMA-3 (Large Language Model Meta AI 3), которая превзошла передовые аналогичные модели в отрасли в нескольких ключевых тестах производительности. Она достигла общего лидерства в таких задачах, как генерация кода, и была способна выполнять сложные задачи. рассуждение, способность лучше следовать инструкциям, способность визуализировать идеи и решать многие тонкие проблемы.

Основные моменты:

- На основе более чем 15T token обучение, эквивалентное Llama 2 данныенабориз 7 более чем в два раза;

- Поддерживает длинный текст размером 8 КБ, а улучшенный токенизатор имеет словарь из 128 КБ токенов для повышения производительности;

- Самые современные показатели по широкому спектру важных показателей;

- Новые категории возможностей, включая расширенные возможности рассуждения и кодирования;

- Новые версии инструментов доверия и безопасности с Llama Guard 2, Code Shield и CyberSec Eval 2.

02. Установите Олламу

Ollama Это инструмент с открытым исходным кодом для запуска и управления большими языковыми моделями (LLM) в локальной среде. Он предоставляет разработчикам, исследователям и энтузиастам эффективную и простую в использовании платформу для быстрого экспериментирования, управления и развертывания новейших больших языковых моделей.

Технические особенности и преимущества:

- локальное развертывание:Ollama Позволяет пользователям локально запускать и запускать различные большие языки Model, такие как Llama 2、CodeLLaMA、Falcon и Mistral ждать. Это не только снижает порог использования большого языка Модельиз, но также повышает конфиденциальность и безопасность данных.

- Богатая библиотека моделей:Ollama Предоставляет предварительно созданную библиотеку из Модель для множества популярных моделей из больших языков, включая Qwen2、Llama3、Phi3 и Gemma2 ждать. Эти инструменты можно легко интегрировать в различные приложения для удовлетворения потребностей различных сценариев.

- Простой в использовании интерфейс:Ollama предоставляет что-то вроде OpenAI из API Интерфейс и интерфейс чата удобны для использования пользователями. Кроме того, это также утверждение основано на командной Режим строкаиз запускает множество больших языков Модели и обеспечивает соответствующие Python и JS SDK для простой реализации Chatbot UI。

- Настраиваемость:Ollama Иметь высокую степень настраиваемости, позволяющую пользователям создавать и запускать собственные модели языков.

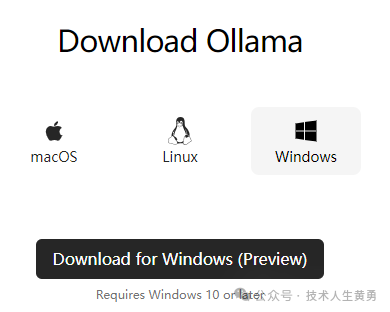

- Кроссплатформенная поддержка:Ollama поддерживать macOS、Linux и Windows (предварительная версия) и доступен на Docker Быстрая развертка. Это значительно повышает его применимость и гибкость.

Среда установки: Обычный настольный компьютер Lenovo, без графического процессора. Процесс установки не требует научного доступа в Интернет.

Официальный адрес загрузки Ollama: https://ollama.com/download. Выбирайте разные версии в зависимости от вашей операционной системы.

На Github также есть версия Docker: https://github.com/ollama/ollama.

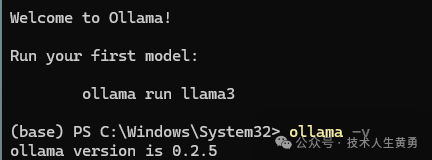

После завершения установки проверьте версию и убедитесь, что установка прошла успешно.

ollama -v

03. Загрузите модель

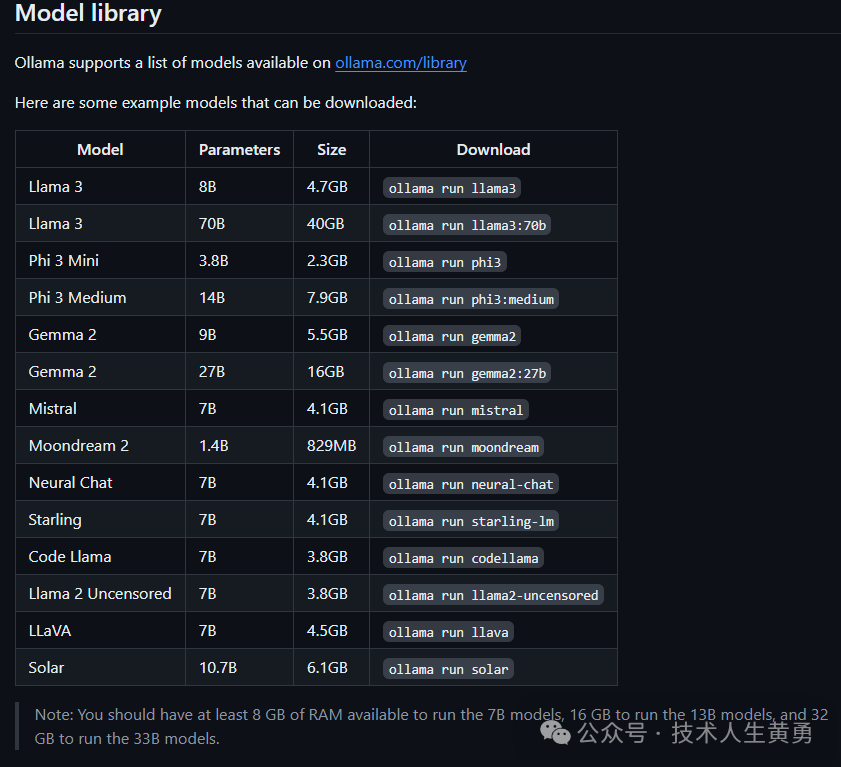

После завершения установки вы можете напрямую загрузить многие встроенные модели с открытым исходным кодом. Ниже приведены названия некоторых встроенных моделей.

Требования к памяти: не менее 8 ГБ доступной памяти для работы модели 7B, 16 ГБ для работы модели 13B и 32 ГБ для работы модели 33B.

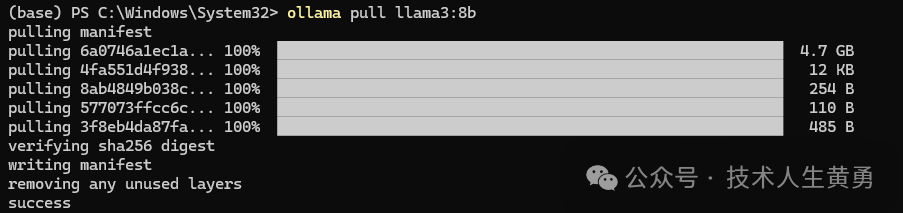

Загрузите llama3:8b. Перед двоеточием указано название модели, а модель после двоеточия — это также размер параметра модели.

ollama pull llama3:8b

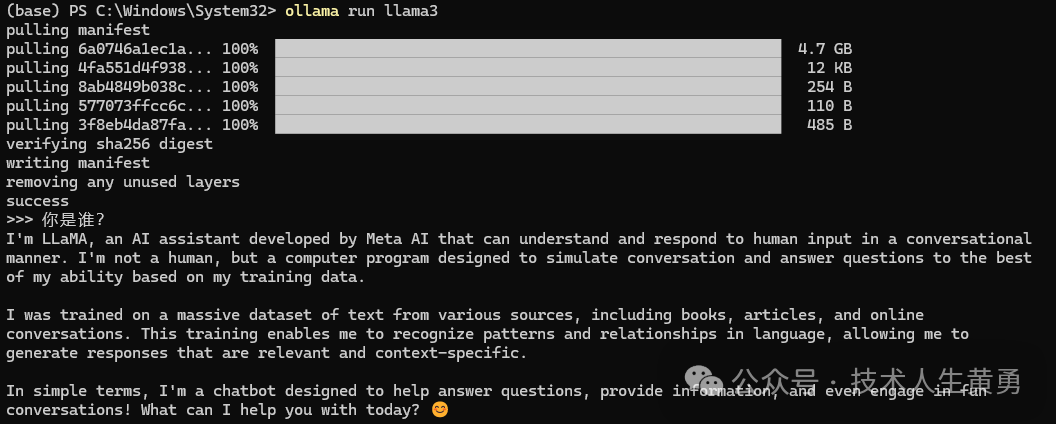

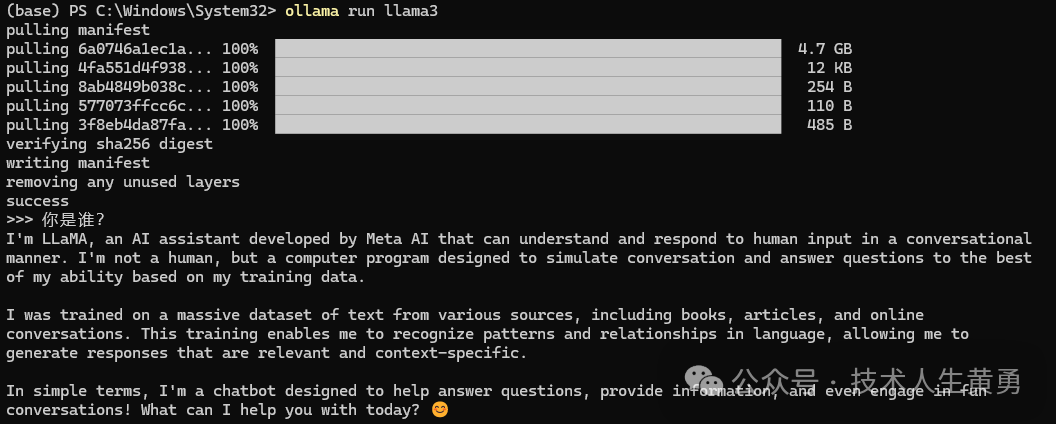

Запустите модель:

ollama run llam3

Поскольку иностранные модели по умолчанию отвечают на английском языке, вы можете указать модель, которая будет отвечать на китайском языке.

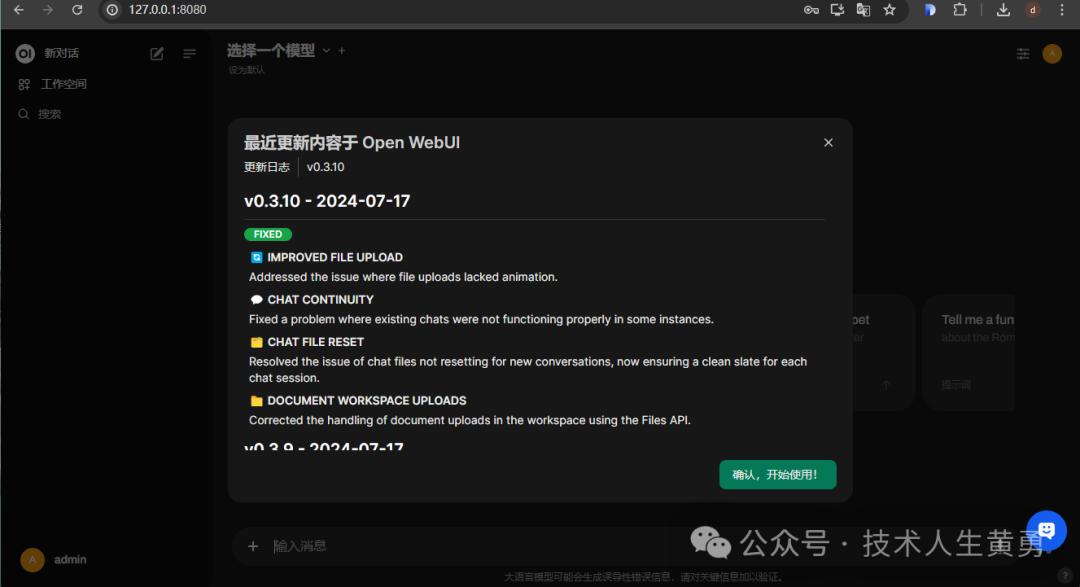

Очевидно, неудобно использовать командную строку. Мы используем Docker, чтобы предоставить большой модели диалоговый веб-интерфейс. Используйте следующую команду для запуска Open WebUI. Будьте осторожны, изменяя локальный путь к open-webui-data. Предварительное условие: служба Docker сначала устанавливается локально.

docker run -p 8080:8080 -e OLLAMA_BASE_URL=http://host.docker.internal:11434 --name open-webui --restart always -v open-webui-data:/DATA/ ghcr.io/open-webui/open-webui:mainПосле долгого процесса получения образа отображается интерфейс запуска.

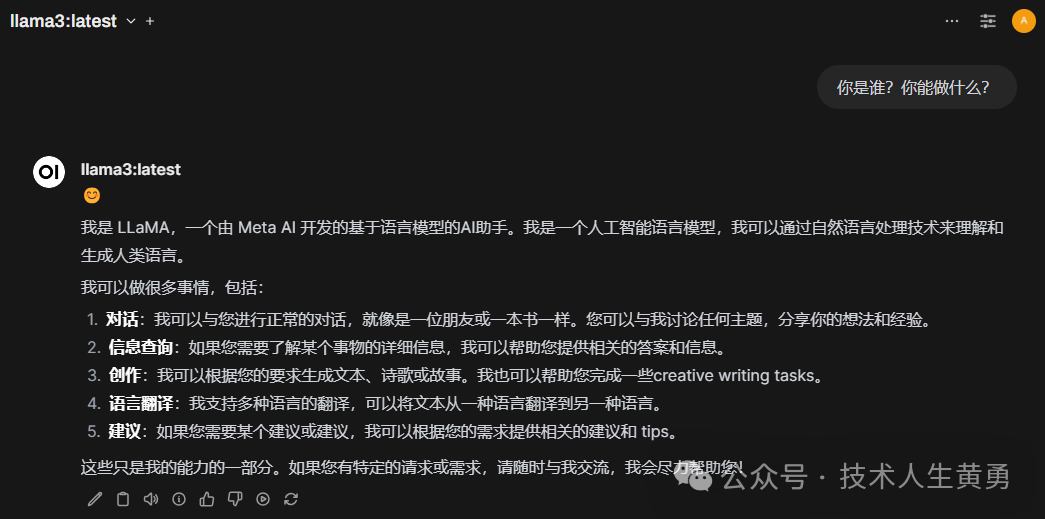

Введите http://127.0.0.1:8080 в адресную строку браузера. При первом посещении необходимо зарегистрироваться. После входа в систему вы увидите интерфейс чата, аналогичный Chat-GPT. тот, который мы только что скачали, находится в верхнем левом углу. llama3:latest.

Задание одного и того же вопроса на китайском языке через веб-интерфейс избавляет от необходимости указывать большую модель для ответа на китайском языке, например взаимодействие с командной строкой.

Предоставляет услуги API для создания разговоров.

Целью создания локальной модели является использование в проекте, поэтому нам также нужен API, созданный с помощью диалога, аналогичного OpenAI. Перед его использованием нажмите «Настройки» — «Учетная запись», чтобы сгенерировать ключ API. Вы можете использовать этот ключ для вызова API.

Команда проверки скручивания из командной строки:

$ curl -X POST -H "Авторизация: ключ API носителя" -H "Тип контента: application/json" http://localhost:8080/ollama/api/generate -d '{"model":"llama3-cn :latest","stream":false,"prompt":"Кто ты? Что ты умеешь"}'

Скорость создания диалогов немного медленнее. Во время самого теста вы можете видеть, как слова появляются одно за другим. Чтобы начать отвечать на приведенные выше вопросы, требуется около 1–2 секунд, и, по оценкам, это займет около 10 секунд. завершить ответ.

На данный момент у нас есть большая модель, которая не требует аппаратных ресурсов графического процессора. Содержимое разговора, данные документа и т. д. хранятся локально и принадлежат нашей частной модели.

---

Ранее рекомендовалось:

Инструкции по использованию большой модели посевов в холодном районе Бэйдахуан

Vector | График: первый график Ant с открытым исходным кодом Интерпретация проекта структуры RAG

Рекомендуйте FinGLM, проект крупной модели с открытым исходным кодом для финансового анализа.

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами