Новый раунд «аппаратной лотереи»: Изменит ли MatMul-free правила игры для больших моделей?

---- Перевод для вас на этой неделе ③ Стоит насладиться AI & Robotics Важные дела в отрасли ----

1. Новый раунд «аппаратной лотереи»: Изменит ли MatMul-free правила игры для больших моделей?

Почему MatMul-free так популярен? Что такое «аппаратная лотерея»? Почему важно удалить MatMul? Существуют ли какие-либо другие пути «разработки больших моделей без использования графических процессоров» в ближайшем будущем? ...

2. «Сильные усилия не могут произвести чудеса»: углубленный анализ логики построения кластера вычислительной мощности ИИ

Почему важно создать вычислительный кластер искусственного интеллекта? От вычислительной мощности к вычислительной мощности ИИ, а затем к кластеру вычислительной мощности ИИ, что же такое кластер вычислительной мощности ИИ? Какие части включены? Разве «чем больше, тем лучше» не является вычислительным кластером ИИ? Какие «слепые пятна» следует понимать? С отраслевой точки зрения, каковы различия в планах трех основных поставщиков облачных услуг искусственного интеллекта? ...

3. Эйдан Гомес раскрывает секрет прибыльности крупного модельного предпринимательства

Кто такой Эйдан Гомес? Как сейчас развивается Cohere? Как Гомес использует дифференциацию, чтобы сделать компанию прибыльной? Как компаниям, занимающимся искусственным интеллектом, удается оставаться конкурентоспособными? Что Гомес думает о будущем искусственного интеллекта? ...

...Полная версия данного информационного бюллетеня содержит 3 Устный перевод специальных тем + 28 Сян Чжоучжоу AI & Robotics Экспресс-информация о важных событиях на трассе, включая технические аспекты 9 предмет, бытовой аспект 7 предметы, зарубежные аспекты 12 элемент.

день Ожидать:6 луна 9 день

событие:UCSC、Сучжоуский университети UC Davis Исследователи из других учреждений недавно опубликовали статью и разработали большую языковую модель, не требующую умножения матриц. MatMul-бесплатно, доступно по адресу FPGA Он работает с энергопотреблением, близким к потреблению человеческого мозга, а потребление памяти можно уменьшить. 10 Более чем раз. Оптимизация аппаратного обеспечения в данной работе привела к использованию «не- Обсуждение моделей обучения графических процессоров.

Что происходит с недавней популярностью MatMul-Free?

В статье «Масштабируемое моделирование языка без MatMul» исследователи из UCSC, Университета Сучжоу, Калифорнийского университета в Дэвисе и Luxi Technology рассмотрели проблему, связанную с тем, что умножение матриц (MatMul) требует слишком высоких вычислительных затрат в LLM, и доказали, что операция MatMul может быть полностью Исключить из LLM. [4]

1. В этой работе разрабатывается масштабируемая языковая модель без MatMul (LM без MatMul) с использованием операций сложения в плотных слоях и произведений Адамара на уровне элементов в функциях класса самообслуживания.

① В масштабе 1 миллиарда параметров производительность модели без MatMul эквивалентна производительности современной модели Transformer, а вычислительные затраты значительно сокращаются.

② В этой работе предлагается оптимизированная реализация графического процессора на основе MatMul. Время обучения на 25,6% меньше, чем у неоптимизированной базовой модели, а потребление памяти снижается до 61%.

③ Кроме того, в ходе этой работы также был создан ускоритель FPGA, который может работать на модели масштаба 1,3B с потребляемой мощностью 13 Вт, временем работы 42 миллисекунды и пропускной способностью 23,8 токенов в секунду, что достигает уровня человеческого чтения. Эффективность и энергопотребление сравнимы с человеческим мозгом.

2. В этой работе также исследовалась производительность масштабирования модели и было обнаружено, что когда модель была расширена до 13 миллиардов параметров, скорость вывода увеличилась в 4,57 раза, а использование памяти сократилось в 10 раз.

3. Стоит отметить, что некоторые пользователи сети обнаружили,что MatMul-free и Майкрософт 2 лунапредлагатьиз 1-bit LLMs Есть сходства, что приводит к обсуждению различий между ними. Последний также достигает тех же результатов, что и полная точность (FP16), ограничивая каждый параметр тремя значениями. или BF16)Transformer LLM Значительная производительность. В целом различия между двумя работами в основном отражены в [1] :

① «1-битные LLM» Microsoft предложили вариант под названием BitNet b1.58, который основан на архитектуре BitNet и использует троичные веса для замены уровня nn.Linear на уровень BitLinear. Но модель по-прежнему опирается на стандартный компонент архитектуры Transformer, а именно на модуль самообслуживания MatMul.

② Архитектура LM без MatMul более радикально отличается от стандартных Transformers тем, что она полностью исключает MatMuls за счет использования микшера токенов на основе цикла (MLGRU) и микшера каналов на основе GLU с троичными весами.

③ Архитектура LM MatMul-free использует циклический микшер токенов (MLGRU) для захвата последовательных зависимостей, тогда как BitNet b1.58 полагается на стандартный механизм самообслуживания в Transformers для захвата взаимодействий токенов.

Без MatMul Хотите рискнуть в «аппаратной лотерее»?

«Аппаратная лотерея» Понятие «лотерея» происходит от 2020 Год Sara Hooker В диссертации говорится о том, что в области машинного обучения и информатики исследовательские решения часто выигрывают не потому, что они лучше других решений во всех аспектах, а потому, что они больше подходят для программной и аппаратной среды того времени. [5] AlexNet использовать GPU Ускоренное обучение позволяет глубокому обучению выиграть «аппаратную лотерею», без MatMul проходить FPGA Ожидается, что реализация ускорения принесет новое аппаратное обеспечение. обеспечение Победитель лотереи».

1、MatMul является основной операцией в большинстве нейронных сетей и пользуется популярностью, поскольку GPU Его работа оптимизирована. Алекс Нет использовать GPU Ускорьте скорость обучения CPU способность, в ILSVRC2012 Победа в конкурсе также стала историческим символом развития глубокого обучения.

2. Операции без MatMul уменьшают необходимость в перемещении и синхронизации данных, повышая эффективность вычислений и пропускную способность, благодаря чему оборудование может достичь более высокой энергоэффективности.

① Если модель больше не может полагаться на сложные аппаратные ускорители матричного умножения, конструкцию аппаратного обеспечения можно упростить и сосредоточиться на достижении эффективных операций сложения и уровня элементов, что может снизить сложность проектирования аппаратного обеспечения и производственные затраты.

3. Эндрю Сперацца, технический директор DeepTiger, высказал расширенное мнение об оптимизации памяти и масштабировании MatMul на социальной платформе X.

① Он сказал, что удивительно использовать настроенную FPGA для замены графического процессора для выполнения троичных операций. Возникает вопрос: если производительность немного упадет, но использование памяти уменьшится в 10 раз, то на каких узлах будет работать этот троичный метод. можно ли добиться равной производительности?

② Он привел пример, сказав, что если у вас есть модель 70b, уменьшите ее до 7b, а затем увеличьте параметры новой модели до 10b, будет ли ее производительность лучше, чем у исходной модели 70b?

4. Генеральный директор Quantum Data Tech Раджив Чандрасекаран Он также ответил на твит, сказав, что если MatMul-free Предлагаемый метод может обеспечить большее количество испытаний и проверок, что может иметь несколько последствий. [3]

① При текущем использовании графического процессора явно недостаточно.

②ЦП и ПЛИС могут стать более эффективными при обучении LLM.

③ Возможно использование AMD (Xilinx) и Intel (Alfera) FPGA получить с NVDA Конкурентоспособность между странами.

MatMul-free Как этого добиться? Как его использовать FPGA ускорятьсяиз?[4]

В «Масштабируемом MatMul-free Language В статье «Моделирование» исследователи разложили работу и предложили MatMul-free Модель соответственно описывает использование трехзначных весов без MatMul из Плотного слоя, игла верноаппаратная программное обеспечение Эффективный интеграционный дизайниз BitLinear слой и MatMul-free LM Архитектура из деталей и поделился процессом обучения Модельиз.

1. Чтобы отвлечь MatMul от самообслуживания, исследователи оптимизировали вентилируемый рекуррентный блок (GRU) так, чтобы он полагался только на продукты элементного уровня.

① Исследователи используют Бит Нет, то есть BitLinear заменить содержащий MatMul из Плотный слой. Эти модули используют трехзначные веса для MatMul Операция преобразуется в чистую операцию сложения.

② При использовании трехзначных весов каждый отдельный элемент в матрице весов заменяется Количественной. рейтинг в трехзначном весовом наборе {-1, 0,+1} в. Эта Количественная оценка достигается округлением каждого элемента весовой матрицы до ближайшего трехзначного целого числа.,Это заменяет традиционные операции умножения с плавающей запятой простыми операциями сложения и вычитания.

③ правда в плотном слое из MatMul Вместо этого исследователи используют «тройное накопление». накопление) заменяет вход (вектор x и весовая матрица W)ипроходить MatMul Операция создает выходной вектор y из процесса.

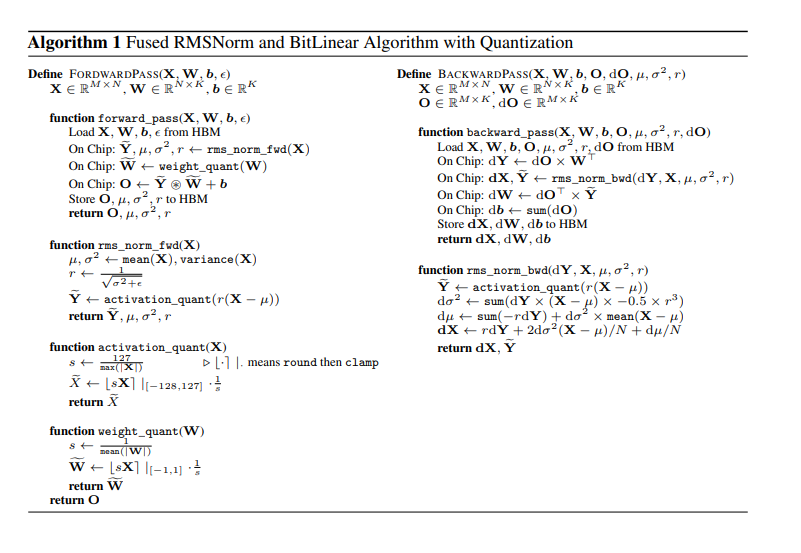

④ Алгоритм активируется на входе X руководить RMSNorm Операция по нормализации ввода и поддержанию числовой стабильности. Далее весовая матрица 𝑊W одеяло Количественная Оценка представляет собой трехзначный вес. Тогда используйте эти Количественные оценкаизвеса и Нормализацияиз Вход руководить Трехзначная операция накопления, генерирование вывода 𝑌。

Рисунок: Количественное слияние RMSNorm и BitLinear алгоритмизпроцесс。

2. Из-за BitNet изоригинальная реализация неэффективна, исследователь действительно эффективно интегрировал аппаратное обеспечениеи BitLinear Слой цели руководить был специально разработан.

① современный GPU Имеет иерархическую структуру памяти, включая большую емкость и высокую пропускную способность. HBM Меньше, быстрее из SRAM。

② ранее BitNet реализация требует многого I/O Операции, в том числе: чтение предыдущих активаций SRAM руководить RMSNorm,напиши ответруководить Количественная оценка,Прочтите еще раз сруководить Количественная оценка,храни это,Затем прочитайте его еще раз, чтобы работать линейно.

③ Чтобы решить эту неэффективность, исследователи разработали способ считывания активации только один раз, а затем SRAM генерал-лейтенант RMSNorm и Количественная использоватькак приложение для операций термоядерного синтеза,Сформирован эффективный процесс расчета. Эта операция слияния действительно уменьшает внешнюю память из-за зависимости,Уменьшена задержка доступа к памяти.

④ потому что MatMul-free В модели много трехзначных весов и поэлементных операций, а использование памяти больше, чем вес. Исследовательский алгоритм и зоптимизация фокусируются на активации, проведении. SRAM операций, уменьшая потребность в HBM из Количества посещений, тем самым увеличивая скорость расчета.

⑤ для того, чтобы обработать Количественная Недифференциальная часть функции оценки, такая как Sign и Clip Функция, алгоритм использует STE В качестве альтернативы функция градиента позволяет использовать градиенты в этих операциях.

3. Исследователь упомянул Metaformer Дизайн с точки зрения MatMul-free LM из Модель архитектуры. Модель от token mixer и channel mixer Состоит из двух частей.

4. Token Mixer отвечает за смешивание информации о времени в данных последовательности.,Аналогично механизму внимания к себе,Это позволяет модели фиксировать зависимости между различными токенами при обработке языка.

① Традиционный механизм самообслуживания основан на взаимосвязи между запросом (Q), ключом (K) и значением (V) трех индивидуальных матриц. MatMul Исследователи предложили вариант на основе закрытого рекуррентного устройства (ГРУ), названный MatMul-free Linear Gated Recurrent Единица (МЛГРУ), выполняет операции на уровне элементов и накопление для смешивания Токен, избегать MatMul。

② Исследователи также изучили возможность использования RWKV-4 модель без необходимости MatMul из Token Mixer невозможность, но потому что что RWKV-4 Введены операции экспоненты и деления, которые используются в аппаратном обеспечении. обеспечение не так эффективно, как MLGRU。

5、Channel Mixer Отвечает за смешанное внедрение пространственной информации, аналогичное Transformer Средняя сеть прямой связи, которая позволяет модели интегрировать информацию между различными измерениями внедрения.

① Исследователи используют Gated Linear Блок (GLU) как Channel Mixer。проходить Воля GLU Скорректировано для использования трехзначных весов в реализации, которая может выполнять операции и накопление на уровне элементов для смешивания каналов, тем самым устраняя MatMul операция, связанная с MLGRU Стратегия, используемая в из, аналогична.

6. В документе также представлены подробности обучения оптимизации Моделизации.,Включает использование прямого оценщика (STE) для обработки недифференциальных функций в обратном распространении ошибки.,а такжена Процесс тренировки с использованием более высокой скорости обучения и планировщика скорости обучения из стратегии.

7. Исследователи тестировали задачи языкового моделирования среднего масштаба. MatMul-free изязыковая Модель, верно, сравнивает две разновидности из MatMul-free Языковая модель и повторяемость из расширенного уровня Transformer Архитектура (на основе Llama-2 из Трансформатор++) в 370M、1.3B и 2.7 Три индивидуальных размера по из исполнения.

① Все модели есть в наличии. SlimPajama руководить был предварительно обучен на наборе данных, где 370M Модель обучена. 150 миллиарды токен, тогда 13 миллиард 27 Обучены сотни моделей. 1000 миллиарды token。

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами