LSTM все еще может победить его! Новейшая архитектура xLSTM: усовершенствованный преобразователь Nuchao и модель пространства состояний (SSM).

введение

LSTM (Long Short-Term Memory) впервые возникла в 1990-х годах и внесла важный вклад в развитие искусственного интеллекта. Однако с появлением технологии Transformer LSTM постепенно исчез из поля зрения людей. Итак, если мы расширим LSTM до миллиардов параметров и воспользуемся технологией LLM, чтобы преодолеть ограничения LSTM, как далеко сможет зайти LSTM в языковом моделировании?

На основании этого вопроса,Автор статьи предлагаетxLSTM-архитектура,По сравнению с современной моделью трансформатора и пространства состояний (SSM),Значительные улучшения были достигнуты как в производительности, так и в масштабируемости.。LSTM приветствует вторую весну?

https://arxiv.org/pdf/2405.04517

Предыстория

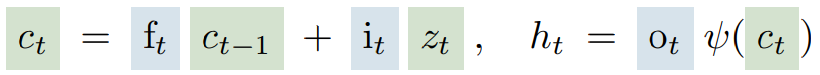

Основная концепция долговременной краткосрочной памяти (LSTM) и ее важная роль в глубоком обучении. LSTM — это особый тип рекуррентной нейронной сети (Recurrent Neural Network, RNN), который решает проблему исчезновения градиента в традиционной RNN путем введения CEC вращения с постоянной ошибкой (Constant Error Rotation Carousel, CEC) и механизма стробирования (Gating).

ЦИК – это клеточное государство

(зеленый) путем добавления входного вентиля

управляющий вход

Для выполнения обновлений этот процесс регулируется сигмовидной решеткой (обычно обозначенной синим цветом), чтобы обновления были скромными. входные ворота

определяет приток новой информации и ворота забывания

Решите, сохранить или забыть старую информацию. выходные ворота

Управляет выводом блока памяти, то есть скрытым состоянием

, который определяет, как состояние устройства влияет на следующий вывод сети. через функцию активации

(обычно это функция гиперболического тангенса tanh), состояние единицы нормализуется или сжимается до меньшего диапазона для поддержания числовой стабильности.

Сеть долгосрочной краткосрочной памяти (LSTM) добилась замечательных успехов во многих областях с момента ее предложения в 1990-х годах, и до появления модели Transformer (2017) она была доминирующей технологией для задач последовательности, таких как генерация текста. LSTM продемонстрировал свои мощные возможности в различных задачах обработки последовательностей, включая генерацию текста, симуляцию рукописного ввода, построчный перевод, оценку компьютерных программ, генерацию субтитров изображений, генерацию исходного кода, моделирование стока осадков, гидрологическую модель предупреждения о наводнениях и т. д.

Особенно в области обучения с подкреплением LSTM имеет отличную производительность, например, модель OpenAI Five в Dota 2 и модель магнитного контроллера ядерного синтеза. Причина, по которой LSTM хорошо справляется с этими задачами, связана с его способностью к абстрактному обучению и способностью эффективно извлекать и хранить семантическую информацию. Например, с помощью LSTM можно наблюдать активность числовых, синтаксических, лингвистических и эмоциональных нейронов. Несмотря на преимущества моделей Transformer с точки зрения масштабирования и параллельной обработки, LSTM по-прежнему играют роль во многих важных приложениях и продолжают демонстрировать свою проверенную временем ценность.

Хотя сеть долговременной краткосрочной памяти (LSTM) добилась больших успехов в обработке данных последовательностей.,Но они сталкиваются с тремя основными ограничениями. первый,LSTMПри решении задачи поиска ближайшего соседаСложность пересмотра решений по хранению,Это ограничивает его способность динамически обновлять информацию. Во-вторых,LSTM имеет ограниченную емкость хранилища.,Это приводит к его плохой производительности при решении задач прогнозирования редких маркеров.,Потому что информация должна быть сжата в состояния скалярных единиц. наконец,Поскольку связь между скрытыми состояниями,В LSTM отсутствует возможность параллельной обработки.,Это влияет на его эффективность при крупномасштабной обработке данных.

Чтобы преодолеть эти ограничения, в статье предлагается модель xLSTM, в которой представлены новые технологии, такие как экспоненциальное вентилирование и матричная память, чтобы улучшить производительность LSTM и сделать ее сопоставимой с передовыми технологиями, такими как Transformer, в таких задачах, как языковое моделирование.

xLSTM

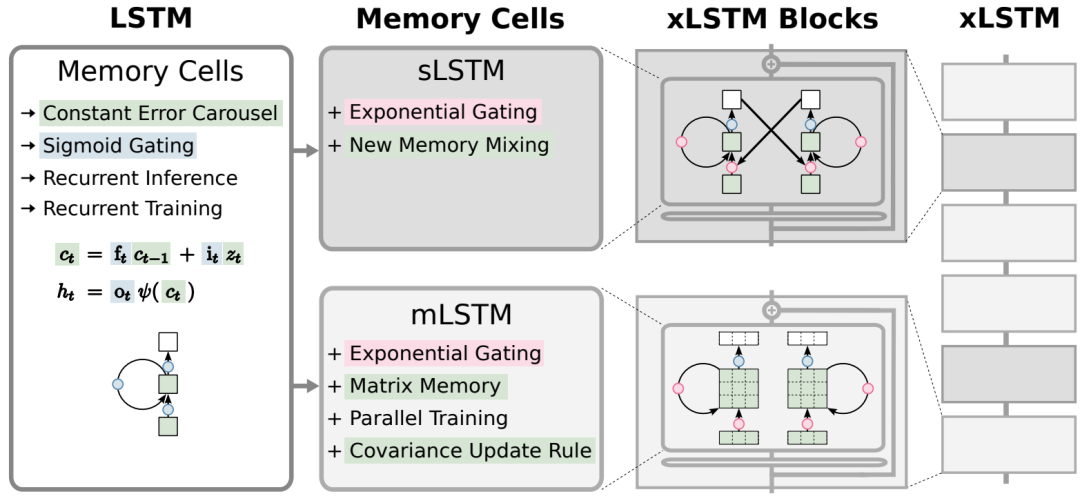

xLSTM (расширенная длинная краткосрочная память) — это расширение традиционного LSTM, целью которого является устранение некоторых ограничений, с которыми сталкивается LSTM при обработке больших моделей, как показано на следующем рисунке:

xLSTM расширяет возможности LSTM, вводя два основных улучшения: 1) введение экспоненциального вентилирования; 2) введение новых структур памяти;

「1) Экспоненциальное стробирование Gating)」:это правильноLSTMУсовершенствование традиционного механизма ворот в Китае.,Позволяет модели более эффективно обновлять свое внутреннее состояние. Экспоненциальное стробирование за счет введения соответствующих методов нормализации и стабилизации.,Позволяет LSTM лучше обрабатывать поток информации.,Особенно в сценариях, где решения по хранению необходимо пересмотреть.

«2) Новая структура памяти»:xLSTMПредставлены два новых блока памяти.,Они есть:「sLSTM、mLSTM」

- 「sLSTM(Scalar LSTM)」:Имеет скалярную память и механизм обновления.,и новая технология смешивания памяти. sLSTM гибридизируется за счет введения нескольких головок и памяти внутри каждой головки.,но не между головами,Это обеспечивает новый способ смешивания памяти.

- 「mLSTM(Matrix LSTM)」:Использование матричной памяти и ковариации(covariance)Обновить правила,Полностью параллелизуемый. mLSTM увеличивает емкость хранилища за счет матричного умножения,Устраняет ограничения LSTM при обработке прогнозов редких маркеров. Оба новых блока памяти расширяют возможности LSTM за счет экспоненциального стробирования. также,mLSTM отказывается от смешивания памяти,Это обеспечивает параллельную обработку,в то время как sLSTM сохраняет перемешивание памяти,Но с появлением головы появился новый способ запоминания микса.

Архитектура xLSTM за счет интеграции этих новых вариантов (sLSTM, mLSTM) в модуль остаточного блока.,Блок xLSTM формируется,Эти блоки затем конструируются остаточным способом в полную xLSTM-архитектуру.。Этот вид Архитектура Не только улучшает производительность,Он также имеет преимущества перед существующими Трансформаторами и Моделью пространства состояний с точки зрения масштаба.

Результаты эксперимента

Следующая таблица находится в длинном формате Range Результаты теста Arena эксперимента,предназначен для оценкиСпособность модели обрабатывать длинные последовательности。можно найтиxLSTMОтличная производительность во всех тестовых заданиях,Он показывает свою эффективность при решении проблем с длинным контекстом.

В таблице ниже показано,В наборе данных SlimPajama (300B),другой МодельразмерxLSTMс другими Модельв наборе проверкиСравнение недоумения и производительности последующих задач。можно найтиxLSTM在другой Модельменьше размера,Наименьшее недоумение на проверочном наборе,Продемонстрированы его преимущества в задачах моделирования языка.

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами