llama3&open-webuiБыстро внедрить построение локальной модели

Предисловие

В последнее время в работе и жизни часто используют искусственный интеллект для повышения эффективности. Самое полезное — написать некоторые инструменты. Даже если написание неудовлетворительное, его можно быстро поддержать небольшой корректировкой и некоторыми командами, иногда они есть. будут забыты, если они не будут использоваться в течение длительного времени. Иногда кажется, что очень эффективно иметь модель искусственного интеллекта для предоставления подсказок;

Подготовка

Собственные параметры

оллама скачать

Адрес загрузки: https://ollama.com/

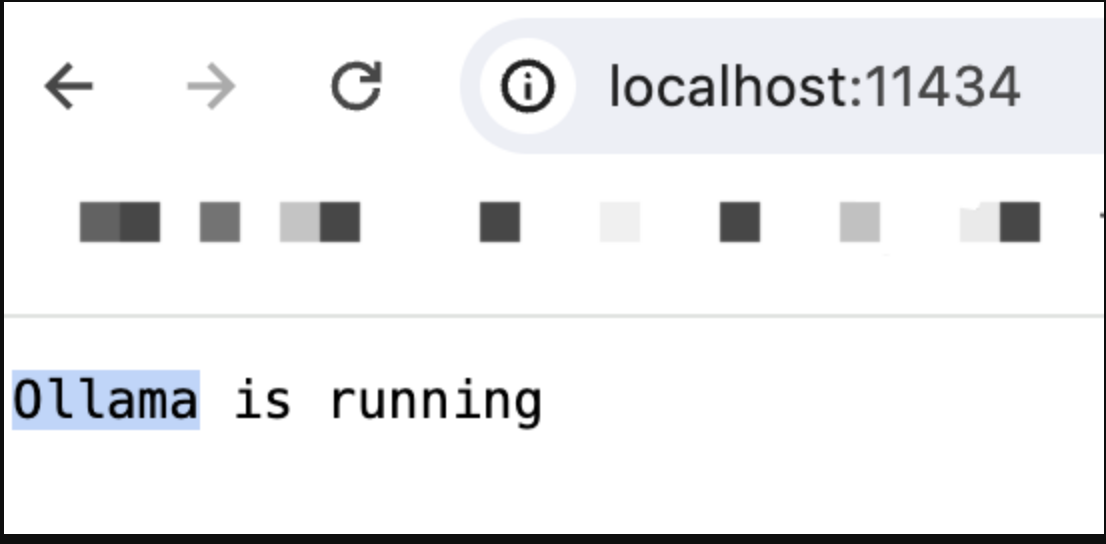

После загрузки просто выполните следующий шаг, не раздумывая. После завершения посетите http://localhost:11434/.

Если вы успешно получили доступ и видите работу, это означает, что операция прошла успешно.

загрузка рабочего стола докера

Адрес загрузки: https://www.docker.com/products/docker-desktop/.

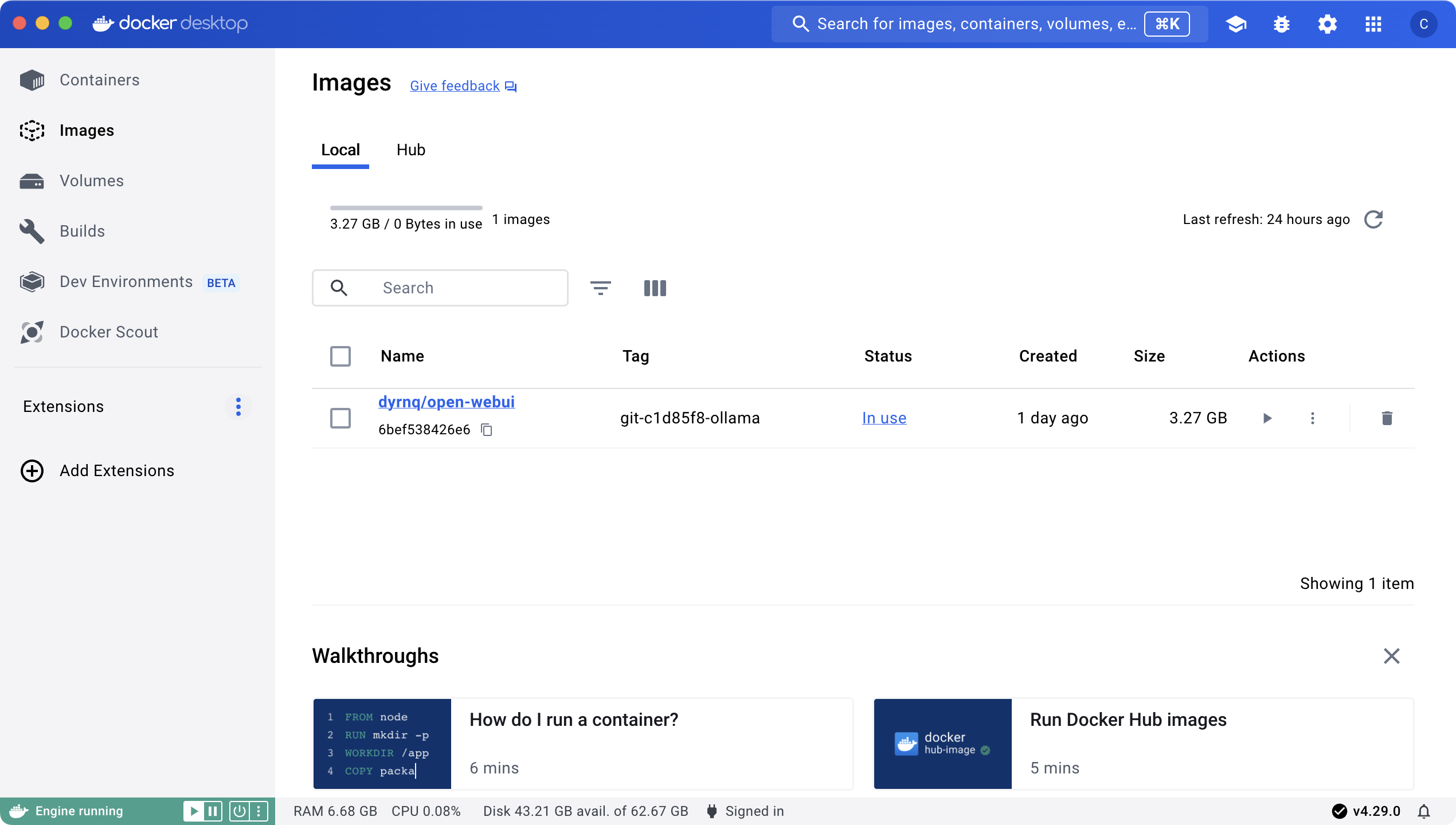

После завершения загрузки запустите операцию и вы увидите следующий интерфейс

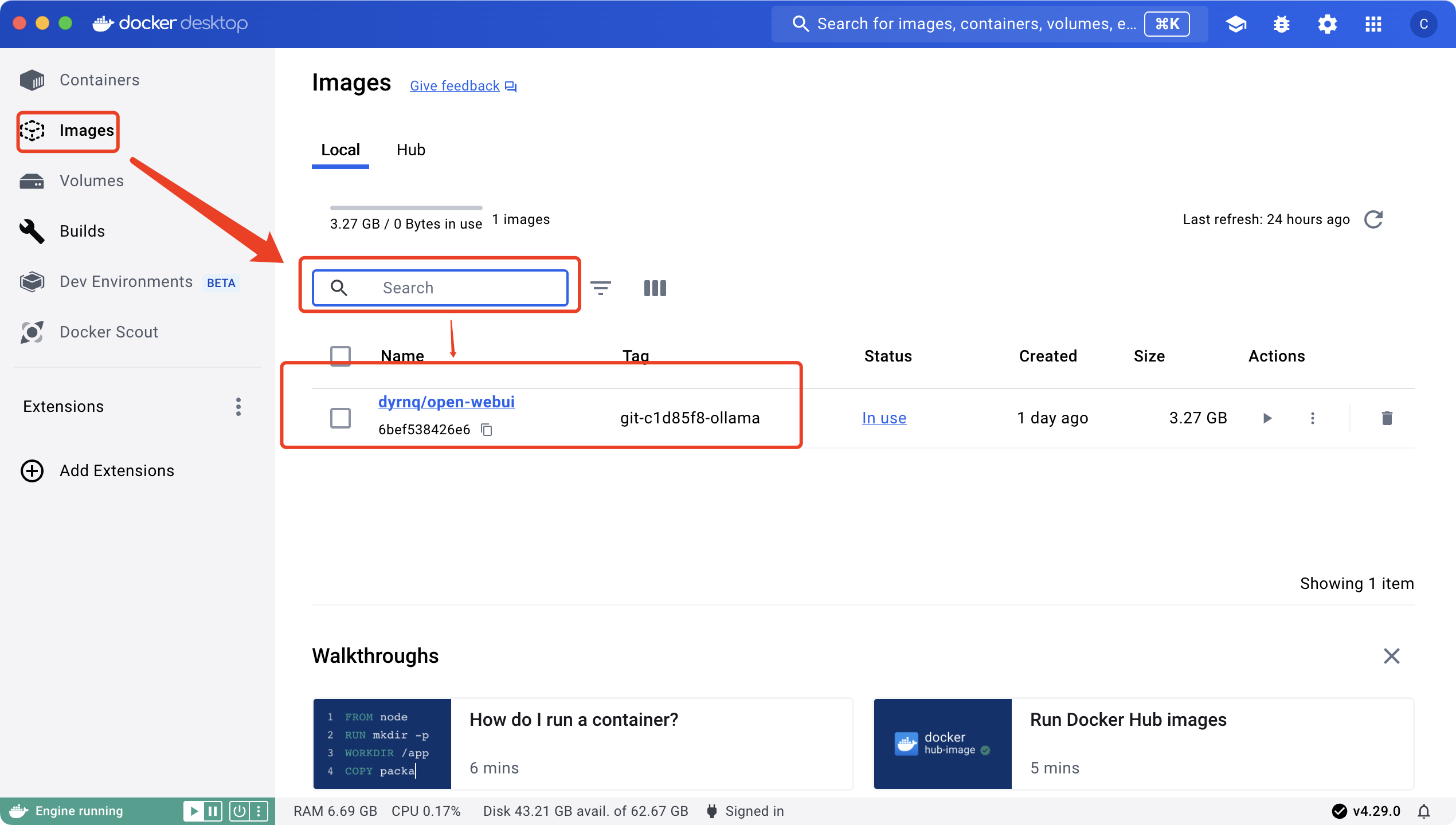

Найдите в строке поиска тег open-webui: просто найдите версию ollama, просто следуйте безмозглым шагам на моей картинке.

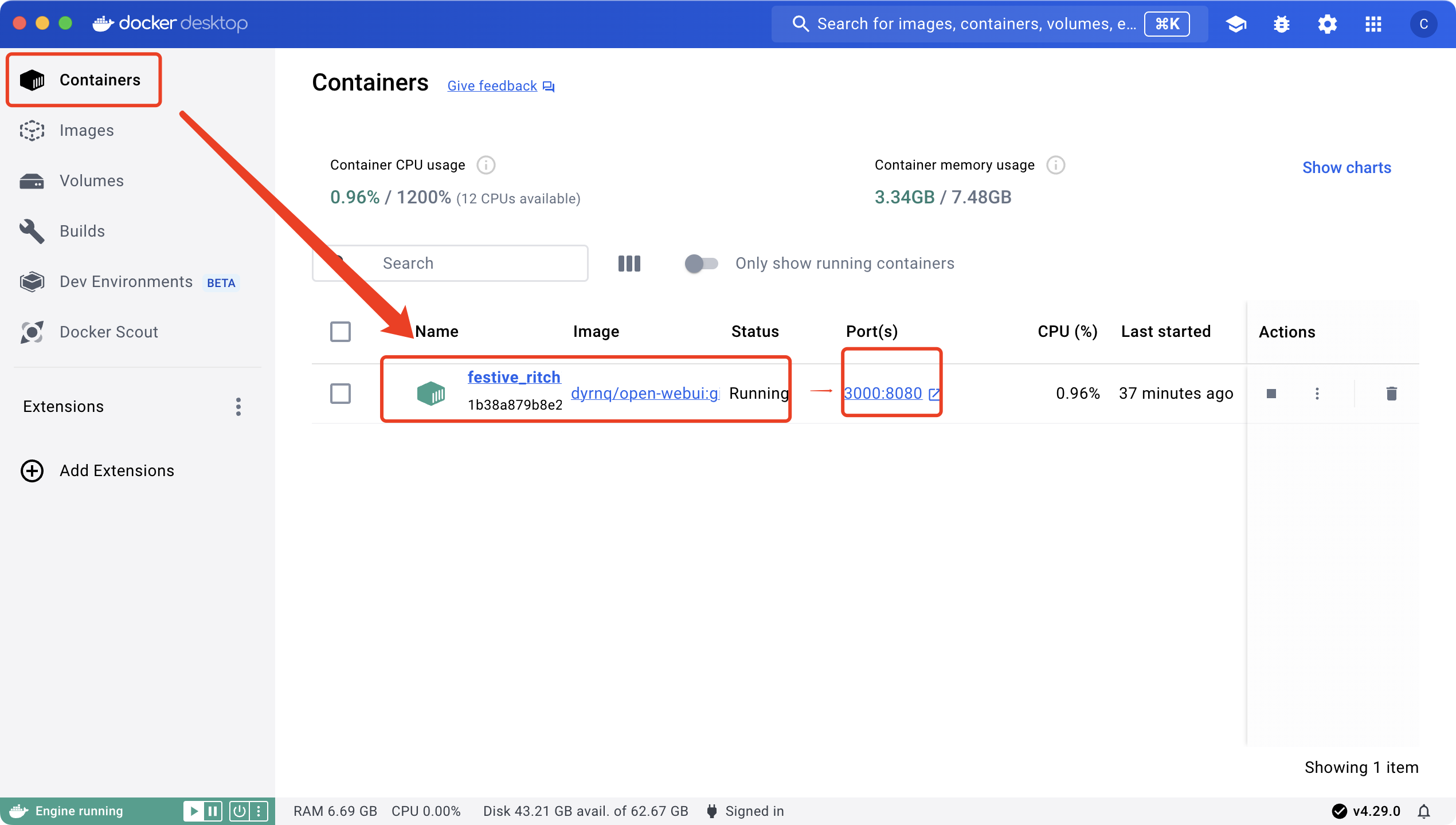

После установки образа можно запустить контейнер

Другие параметры я не изменял. Я просто сопоставил порт во время запуска. После успешного запуска контейнера вы можете получить доступ к указанному порту 3000: http://localhost:3000/.

На данный момент Подготовка практически завершила большую часть работы.,Но это место по-прежнему всего лишь пустая оболочка,Вы не можете начать вопросы и ответы без модели

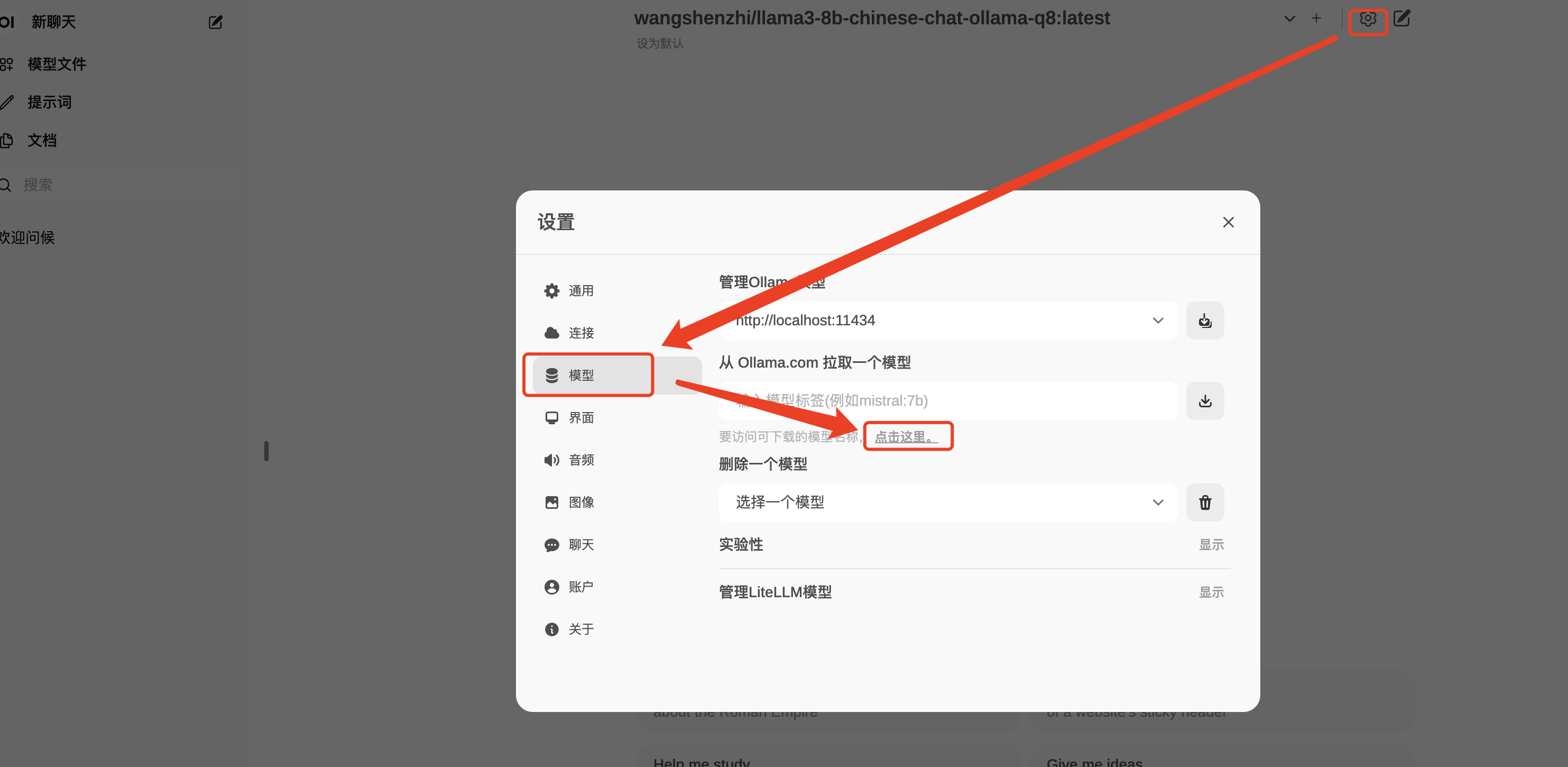

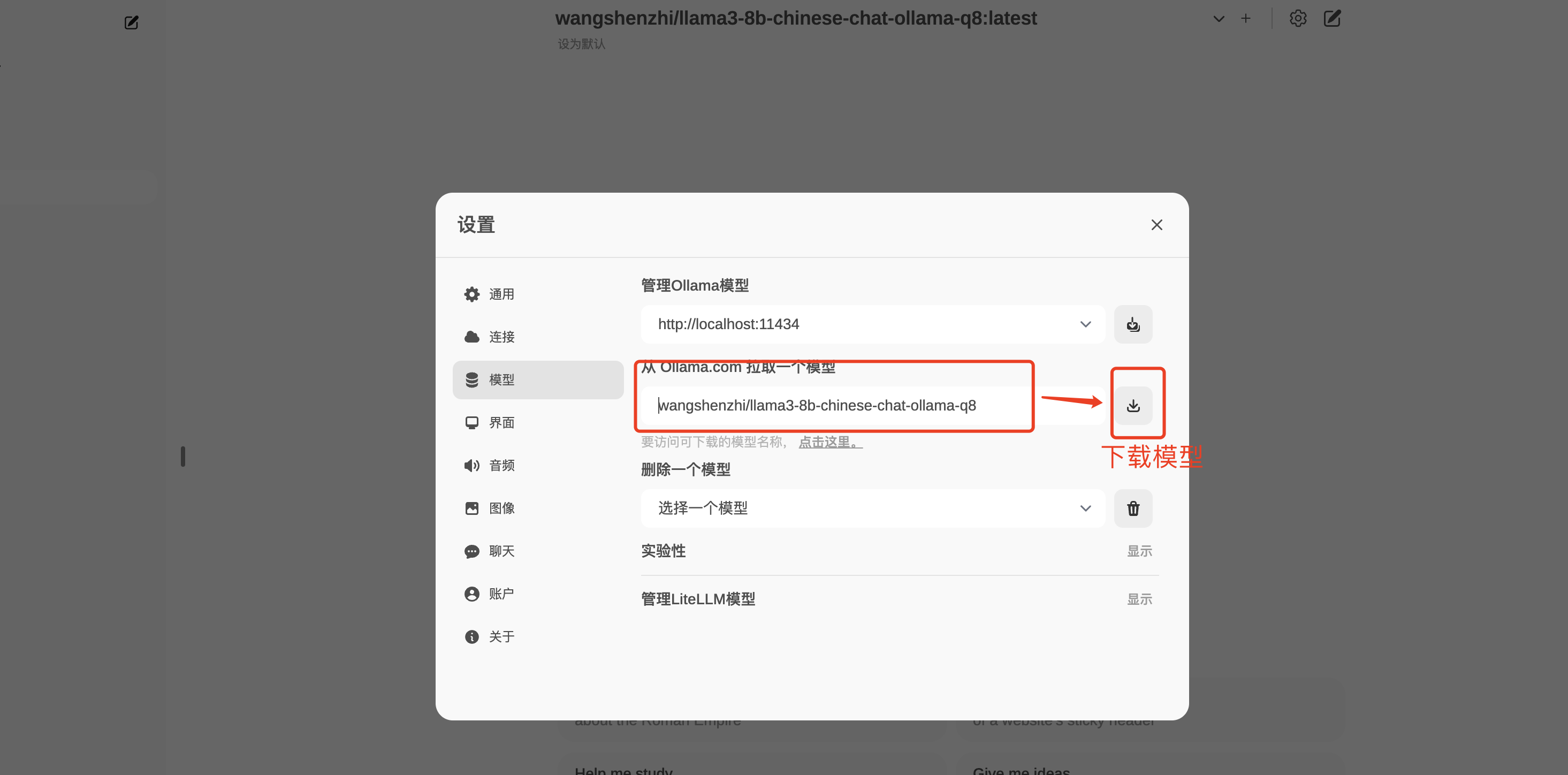

Загрузка модели

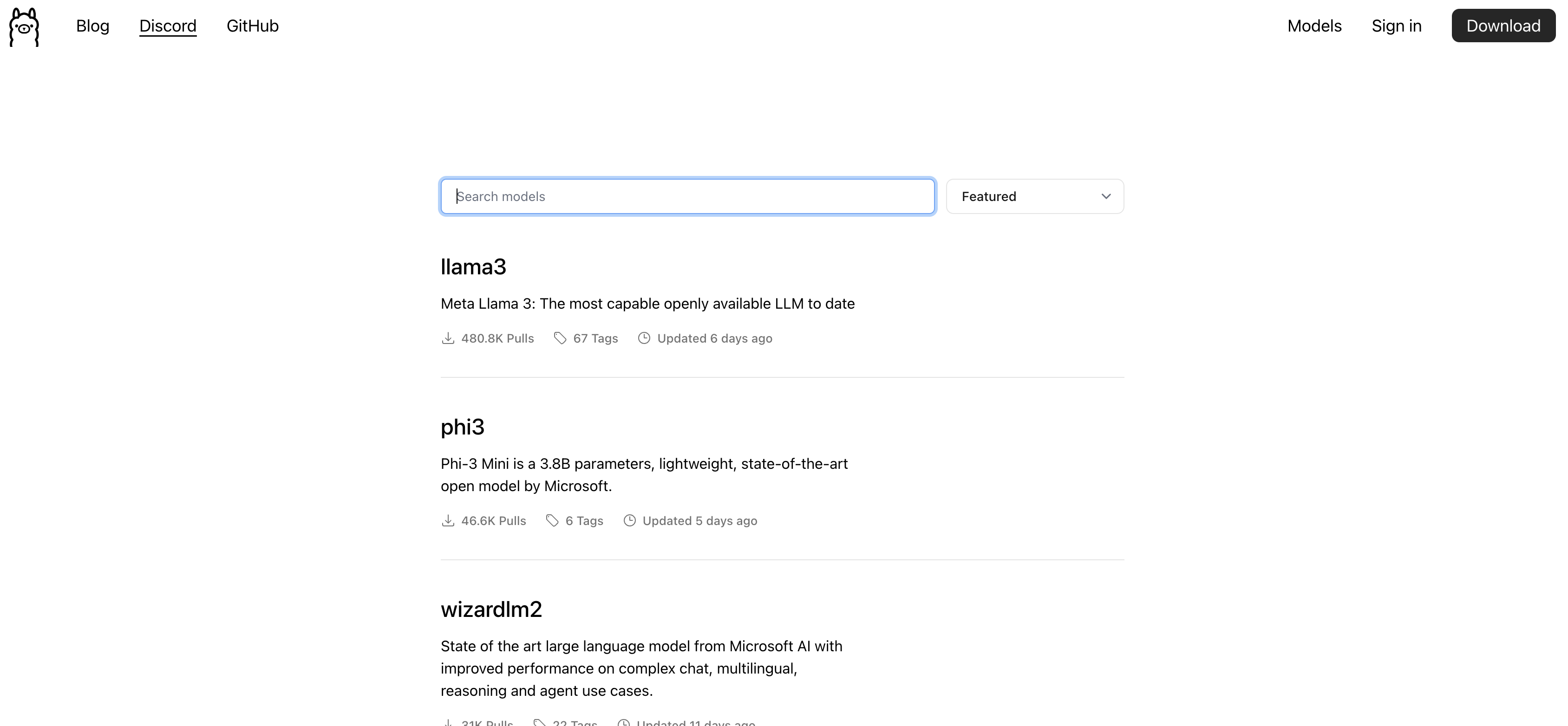

ollama предоставляет много Загрузка моделей

Вы можете найти много полезных моделей, нажав здесь

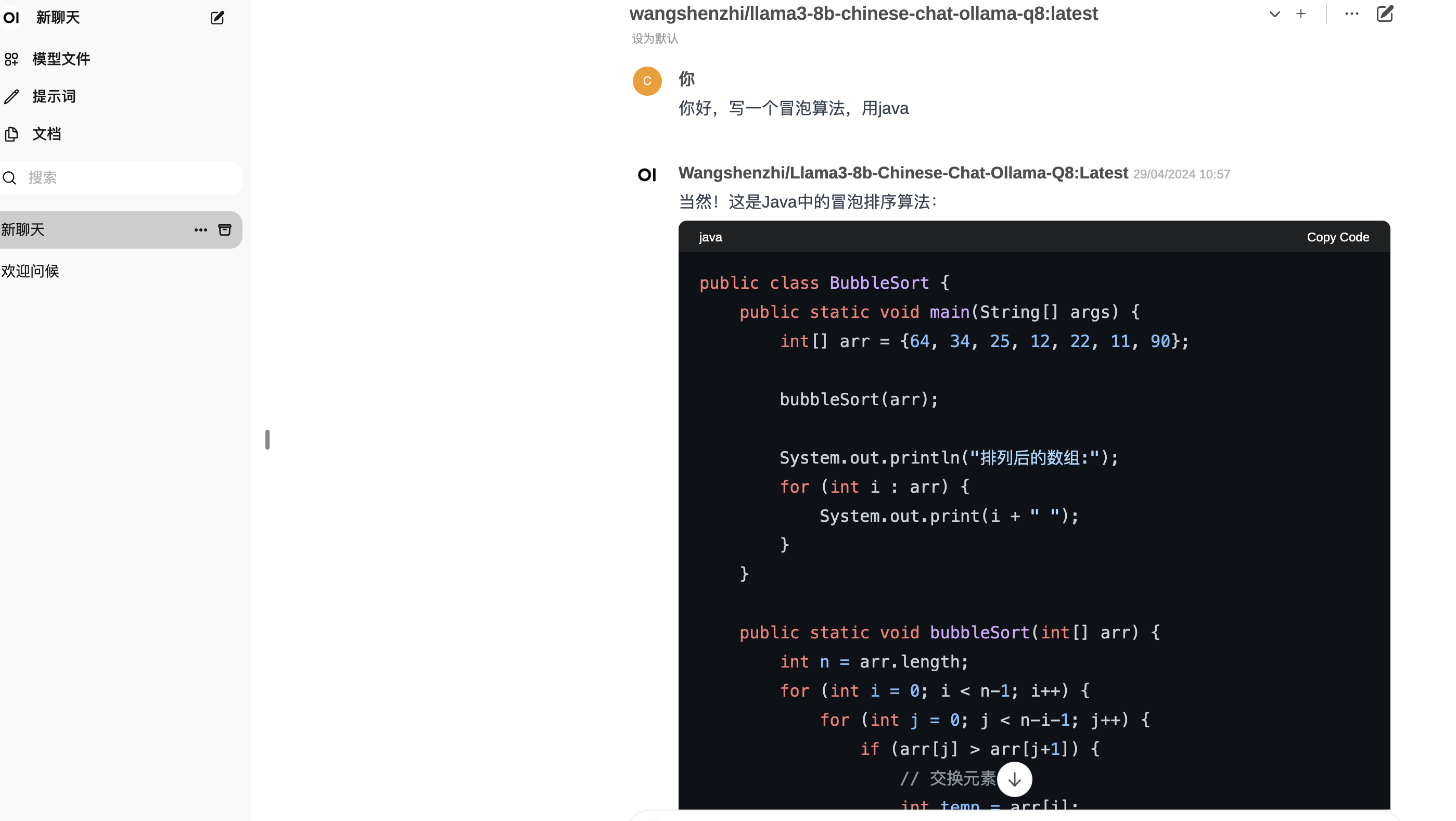

Вы можете найти нужную модель теста, но новая llama3 не очень хорошо поддерживает китайский язык, поэтому вы можете искать напрямую.

llama3-8b-chinese-chat-ollama-q8

Эта модель представляет собой китайскую доработанную модель llama3, относительно дружелюбную к китайцам.

Как правило, для небольших моделей требуется несколько гигабайт, и загрузка займет некоторое время. После завершения загрузки вы можете начать использовать его на домашней странице webui;

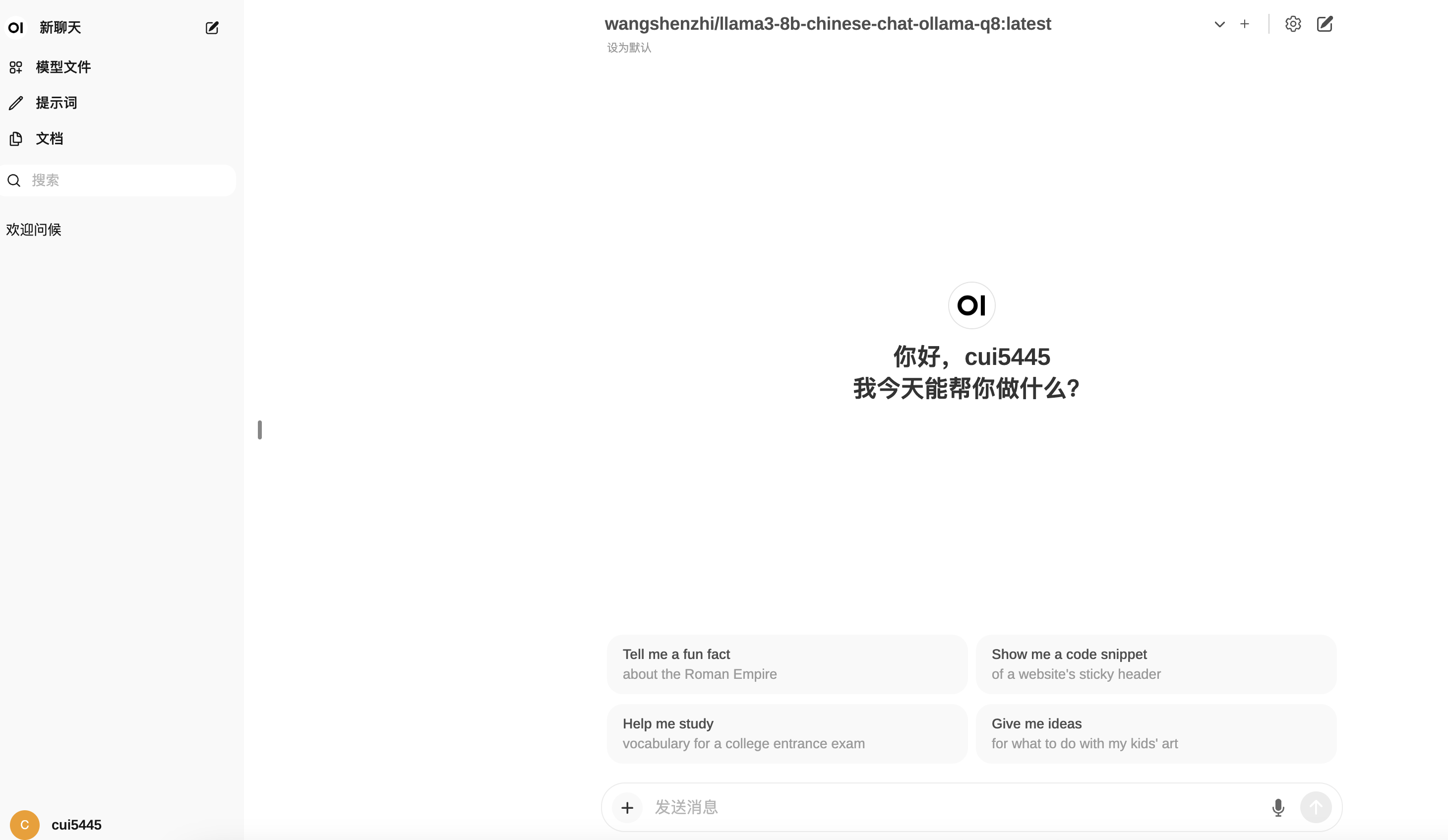

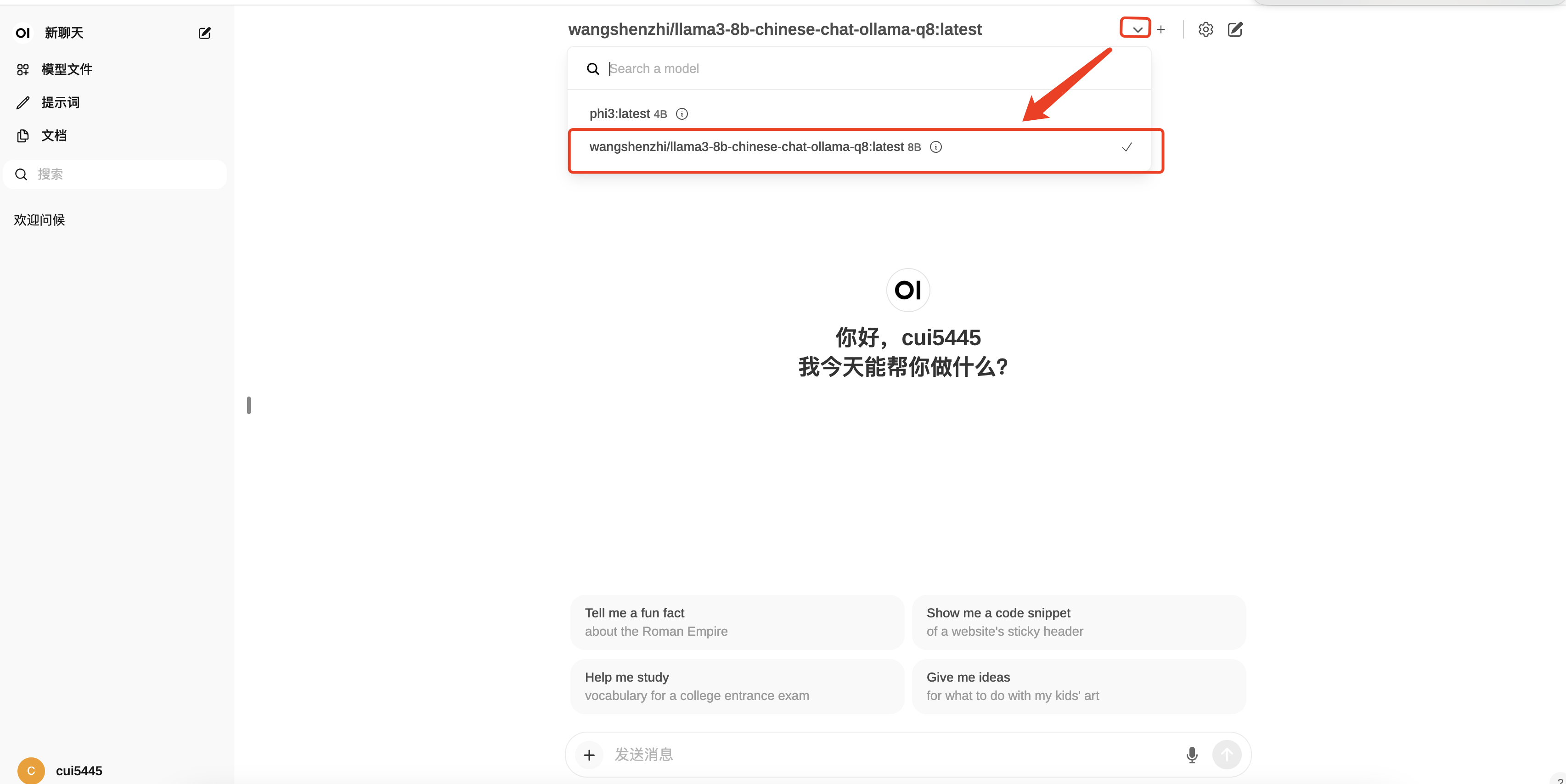

Использование локальной модели

Вы можете видеть, что в раскрывающемся списке на главной странице вы можете выбрать загруженную нами модель.

Запустите локальное тестирование модели, и вы сможете использовать ее в автономном режиме после отключения от Интернета. Не нужно беспокоиться об утечке информации. Однако, как правило, ее можно запускать только на персональных компьютерах, а скорость относительно низкая. любопытство. Надо еще запустить в производство. Нужна хорошая машина. Также можно скачать несколько мини-моделей с более высокой скоростью отклика для тестирования.

Как использовать вызовы интерфейса

Выше показан пример совместного использования open-webui и Ollama;

Ollama также предоставляет прямой вызов интерфейса для облегчения вторичной разработки:

curl http://localhost:11434/api/generate -d '{

"model": "phi3",

"prompt":"Здравствуйте, напишите пузырь"

}'Подвести итог

Построение локальной модели может в основном удовлетворить ваши повседневные рабочие потребности, но скорость относительно медленная, но преимущество в том, что ее можно использовать бесплатно. Если у компании есть потребности в интерфейсе, ее можно расширить и использовать.

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами