Как запустить большую модель ИИ локально

На дворе уже 2024 год, но, похоже, популярность больших моделей ИИ не уменьшилась. Различные генеративные большие модели ИИ, такие как ChatGPT, появляются бесконечным потоком. В результате различные веб-сайты и небольшие программы могут поддерживать большие модели ИИ. , вы когда-нибудь задумывались о том, чтобы создать собственную большую модель ИИ?

Сегодня я поделюсь с вами Как запустить большую модель ИИ локально,После простой установки его можно использовать даже без подключения к Интернету. Суть его заключается в загрузке обученной модели ИИ на локальный сервер.,Затем позвоните через конкретного клиента,Чтобы добиться эффекта от использования больших моделей ИИ локально,Не так много сказать,Начните делиться.

Конечно, сначала нам нужно представить сегодняшнего главного героя.ollama, Это фреймворк, специально используемый для запуска больших языковых моделей. Его также можно назвать инструментом. Его описание на официальном сайте состоит только из одного предложения: «Получить». up and running with largelanguage модели.» (Начните использовать большие языковые модели).

Официальный адрес сайта:https://ollama.com/

GithubСклад с открытым исходным кодом:https://github.com/ollama/ollama

Скачать адрес:https://ollama.com/download

Для локального запуска большой модели необходимо выполнить четыре шага:

- Установить олламу

- Скачать модель

- Запустите модель

- Подключиться к веб-клиенту

Давайте начнем:

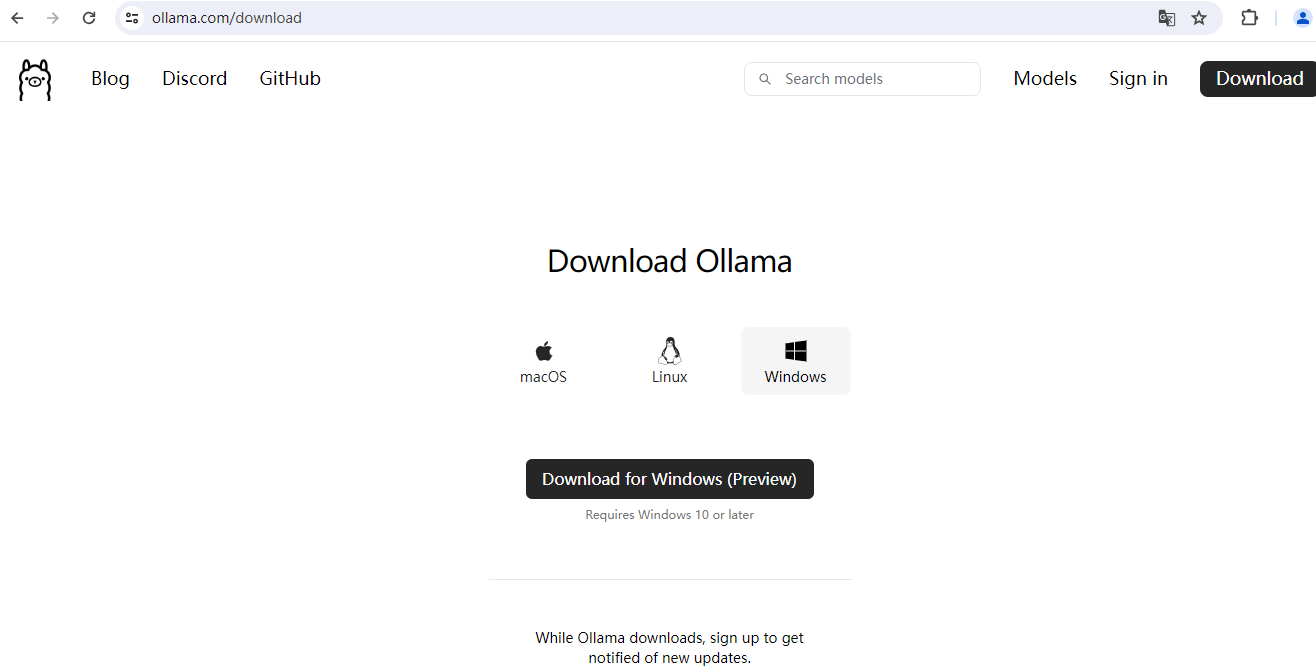

(1) Загрузите и установите клиент ollama.

Адрес страницы загрузки:

Установите операционную систему, которую вы сейчас используете, выборочно загрузите ее, а затем установите надежным способом:

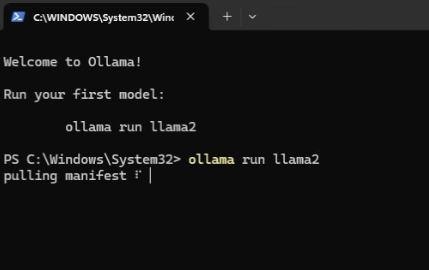

(2) Установите подходящие большие модели.

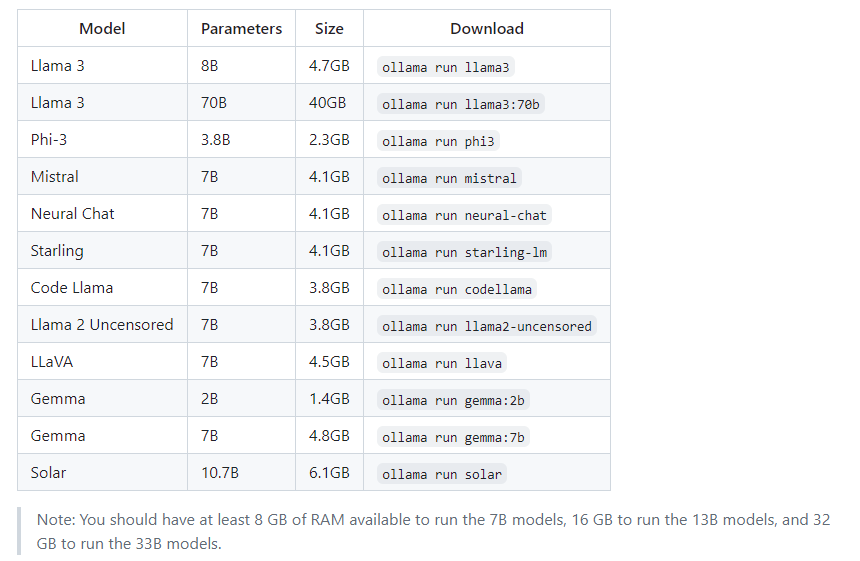

Сначала мы следуем инструкциям по установке модели llama2. Конечно, README в репозитории Github также поддерживает другие модели. Кратко объясняется количество параметров и размер модели.

Ниже приведено объяснение, которое переводится как:

У вас должно быть не менее 8 ГБ памяти для запуска большой модели 7B, 16 ГБ памяти для большой модели 13B и 32 ГБ памяти для большой модели 33B.

(3) Запуск больших моделей

Сначала задаем ему вопрос через терминал: Знаете ли вы язык Go?

Затем он ответит вам в виде потокового вывода. Так называемый потоковый формат на самом деле означает ответ вам медленно и слово за словом, как при разговоре с человеком.

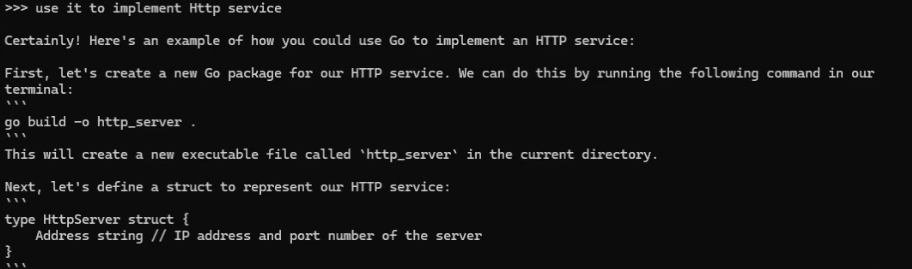

Затем мы попробовали его способность понимать контекст и сказали ему: используйте его для реализации службы Http.

Он напрямую использует язык Go для реализации службы HTTP. Кажется, он обладает естественными возможностями понимания контекста.

(4) Установите веб-клиент

ollama помог нам собрать в сообществе инструменты, которые можно использовать в качестве клиентов. Я не буду их здесь демонстрировать. Вы можете установить документацию, соответствующую каждому складу, чтобы установить и использовать их.

Это здесь, и я дам вам небольшой совет. Локальный запуск больших моделей потребляет много ресурсов процессора и видеокарты. Если конфигурация компьютера относительно плохая, работа может быть не очень хорошей и работать долго. также может иметь определенные последствия для компьютера. Вы можете попробовать умеренно ~.

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами