K-Radar: 4D-радарное обнаружение объектов для автономного вождения в любых погодных условиях

Статья: К-Радар: 4D радарное обнаружение объектов для автономного вождения в различных погодных условиях

Актеры: Дон Хи Пэк, Сын Хён Конг, Кевин Тирта Виджая

Редактор: Облако точек PCL

Код: https://github.com/kaist-avelab/k-radar

Добро пожаловать на нашу планету знаний, получайте документы в формате PDF и пересылайте их своим друзьям. Статья предназначена только для академического обмена. Если есть какие-либо нарушения, свяжитесь с нами и удалите статью.

Публичный аккаунт предназначен для обработки облаков точек.,SLAM,3D видение,Обмен полезным контентом, связанным с высокоточными изображениями земли и другими областями.,Приветствую всех желающих присоединиться,Если интересно, обращайтесьdianyunpcl@163.com。В случае нарушения прав или копирования обращайтесь в WeChat Cloudpoint9527.

краткое содержание

В отличие от камер RGB, использующих диапазон видимого света (384–769 ТГц), и лидара, использующего инфракрасный диапазон (361–331 ТГц), радар миллиметрового диапазона использует относительно более длинный радиочастотный диапазон (77–81 ГГц), что делает его легче работать в плохую погоду. Получите мощные возможности измерения в данных условиях. К сожалению, существующие наборы данных миллиметровых радаров содержат лишь относительно мало образцов по сравнению с существующими наборами данных камер и лидаров. Это может препятствовать разработке передовых методов глубокого обучения на основе данных для зондирования на основе радаров миллиметрового диапазона. Кроме того, большинство существующих наборов данных радаров миллиметрового диапазона предоставляют только данные 3D-тензора радара (3DRT), содержащие измерения мощности по доплеровскому измерению, дальности и азимуту. Поскольку информация об угле наклона отсутствует, оценка трехмерной ограничивающей рамки объекта с помощью 3DRT является сложной задачей. В этой работе мы представляем KAIST-Radar (K-Radar), новый крупномасштабный набор данных для обнаружения объектов и эталонный тест, содержащий 35 тыс. кадров данных 4D-радарного тензора (4DRT), который включает измерения мощности доппа в Le, дальности, азимуте и размерах шага. с аннотированными метками в 3D-ограничительной рамке. K-Radar учитывает суровые условия вождения, такие как неблагоприятная погода (туман, дождь и снег) на различных дорожных конструкциях (городские, пригородные дороги, переулки и автомагистрали). В дополнение к 4DRT мы также предоставляем вспомогательные измерения с помощью тщательно откалиброванного лидара высокого разрешения, окружающих стереокамер и RTK-GPS. Мы также предоставляем базовые нейронные сети (базовые NN) для обнаружения объектов на основе 4DRT и демонстрируем важность информации о высоте для обнаружения трехмерных объектов. Сравнивая базовую NN с нейронной сетью на основе лидара с аналогичной структурой, мы демонстрируем, что 4D-радар является более мощным датчиком в неблагоприятных погодных условиях. Весь код доступен по адресу https://github.com/kaist-avelab/k-radar.

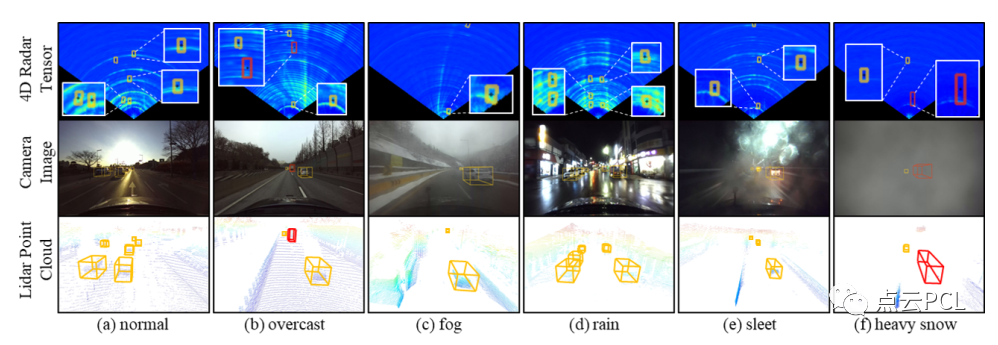

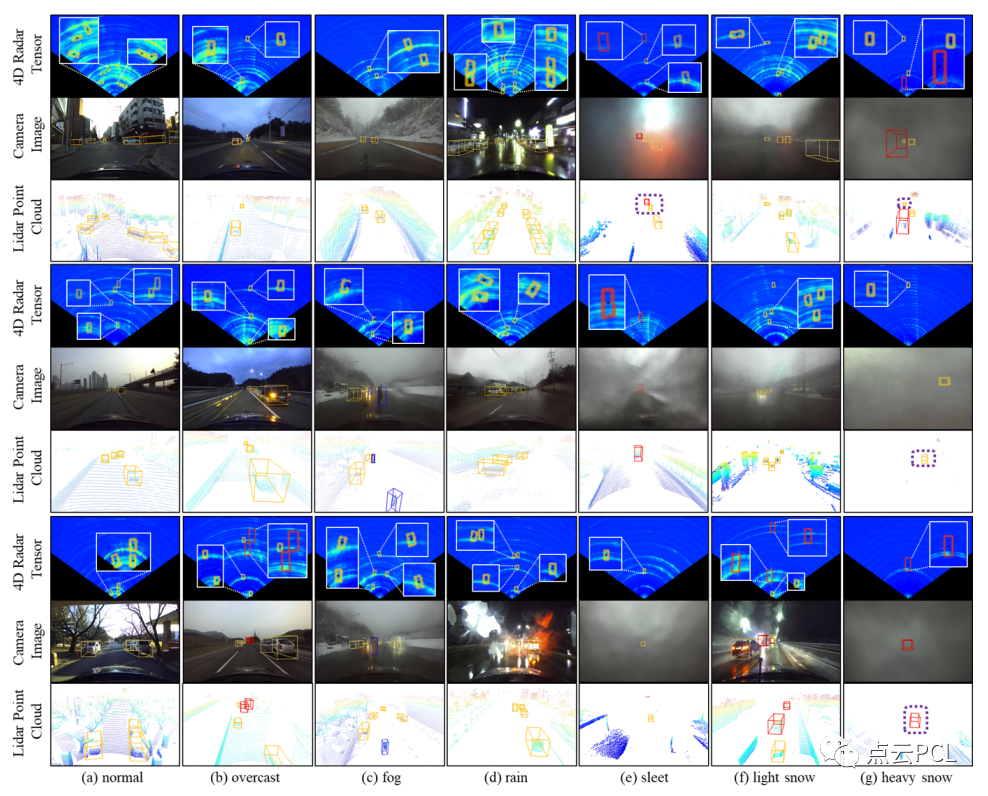

Рисунок 2: Примеры наборов данных K-Radar при различных погодных условиях. В каждом столбце показаны (1) 4DRT, (2) изображения с камеры переднего обзора и (3) облака точек лидара (LPC) при различных погодных условиях. 4DRT представлены в двумерной (BEV) декартовой системе координат. В этом примере желтые и красные ограничивающие рамки обозначают категории легковых автомобилей и автобусов или грузовиков соответственно.

Основные вклады

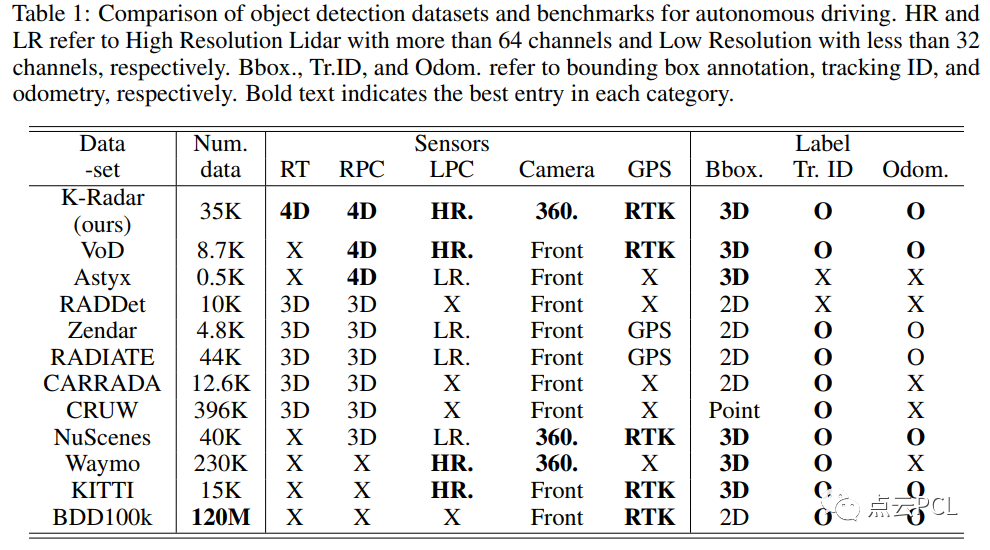

Глубоким нейронным сетям обычно требуется большое количество обучающих выборок, собранных из различных условий, чтобы они могли достичь замечательных результатов с отличной производительностью обобщения. В области автономного вождения существует множество наборов данных для обнаружения объектов, которые предоставляют крупномасштабные данные с различных модальностей датчиков, как показано в таблице 1.

Чтобы продемонстрировать необходимость модуля восприятия на основе 4DRT, мы предлагаем базовую нейронную сеть (Baseline NN) для обнаружения трехмерных объектов, которая напрямую использует 4DRT в качестве входных данных. Благодаря экспериментальным результатам на K-Radar мы наблюдаем, что базовая NN на основе 4DRT превосходит сеть на основе лидара в задачах обнаружения трехмерных объектов, особенно в суровых погодных условиях. Мы также показываем, что базовая NN на основе 4DRT, использующая информацию о высоте, значительно превосходит сеть, использующую только информацию BEV. Кроме того, мы выпустили полные наборы инструментов разработки (devkits), включающие: (1) код обучения/оценки нейронных сетей на основе 4DRT, (2) инструменты калибровки/калибровки и (3) инструменты для ускорения исследований в области 4DRT. Инструменты визуализации. В целом наш вклад заключается в следующем:

- Предлагается новый набор данных и эталонный тест на основе 4DRT.,то есть К-Радар,Для 3D-инспекции объектов. Насколько нам известно,K-Radar — это первый крупномасштабный набор тестов на основе 4DRT с разнообразным и сложным освещением, временем и погодными условиями. С помощью тщательно аннотированных трехмерных ограничивающих меток и мультимодальных датчиков.,K-Radar также может использоваться для других задач автономного вождения.,Например, отслеживание целей и одометр.

- Предложена базовая NN для обнаружения 3D-объектов напрямую: используйте 4DRT в качестве входных данных.,И подтвердил важность информации о высоте 4DRT для обнаружения трехмерных объектов. Также продемонстрирована надежность восприятия на основе 4DRT в автономном вождении.,Особенно в плохих погодных условиях.

- Предоставляются комплекты для разработки, в том числе: (1) для нейронной системы на базе 4DRT. Обучение/оценка сети, (2) калибровка/калибровка и (3) инструменты визуализации для ускорения автономного управления на базе 4DRT. вождение Перцептивные исследования.

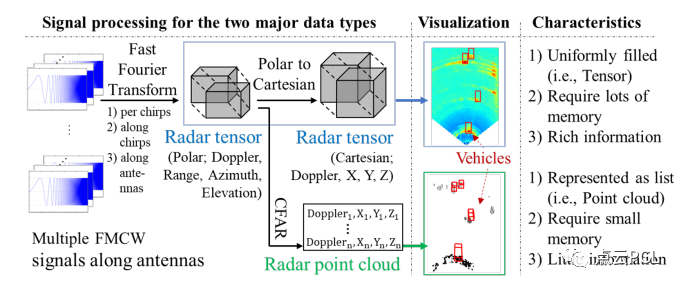

Рисунок 1: Обзор обработки радиолокационного сигнала FMCW и визуализация двух основных типов данных (т. е. радиолокационного тензора (RT) и радарного облака точек (RPC)).

Обзор контента

Здесь описаны конфигурация датчика, процесс сбора данных и распределение данных, используемые для построения набора данных K-Radar. Затем объясняется структура данных 4DRT, а также процесс визуализации, калибровки и аннотирования. Наконец, демонстрируется базовая сеть обнаружения трехмерных объектов, которая может напрямую использовать 4DRT в качестве входных данных.

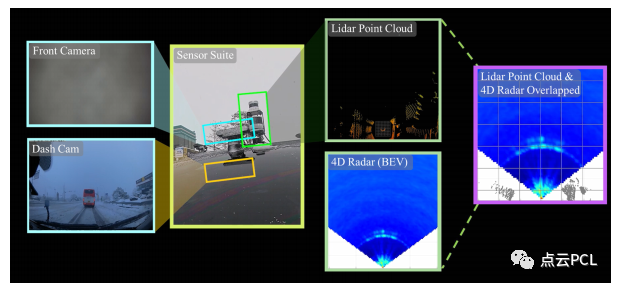

Характеристики датчика K-Radar

Для сбора данных в суровых погодных условиях мы установили пять водонепроницаемых датчиков, соответствующих стандартам IP66 и настроенных, как показано на рисунке 3. Во-первых, на передней решетке автомобиля устанавливается 4D-радар для предотвращения явления многолучевости, вызванного капотом или крышей автомобиля. Во-вторых, 64-канальный лидар дальнего действия и 128-канальный лидар высокого разрешения расположены в центре крыши на разной высоте (рис. 3-(а)). Лидар дальнего действия используется для точной маркировки объектов на различных расстояниях, а лидар высокого разрешения обеспечивает плотную информацию с широким (т. е. 44,5 градуса) вертикальным полем зрения (FOV). Третьи стереокамеры установлены на передней, задней, левой и правой сторонах автомобиля соответственно, создавая тем самым четыре стереоскопических изображения RGB, охватывающих 360-градусное поле зрения, углы которого основаны на перспективе собственного автомобиля. Наконец, антенна RTK-GPS и два датчика IMU устанавливаются на задней стороне автомобиля для достижения точного определения положения автомобиля.

Рисунок 3: Набор датчиков K-Radar и система координат каждого датчика. (а) показывает состояние датчика после движения по сильному снегопаду в течение 5 минут. По мере движения автомобиля вперед перед датчиком скапливается снег, покрывающий поверхности объектива передней камеры, лидара и радара, как показано на (а). Поэтому в сильный снегопад фронтальные камеры и лидар не могут получить большую часть информации об окружающей среде. Напротив, радарные датчики очень устойчивы к суровым погодным условиям, поскольку излучаемые волны могут проходить сквозь капли дождя и снежинки. Эта диаграмма подчеркивает важность радара в неблагоприятных погодных условиях, особенно при сильном снегопаде, а также необходимость размещения датчика и дополнительной конструкции при учете неблагоприятных погодных условий (например, установка дворника перед лидаром). (б) показано место установки каждого датчика и система координат каждого датчика.

Сбор и распространение данных

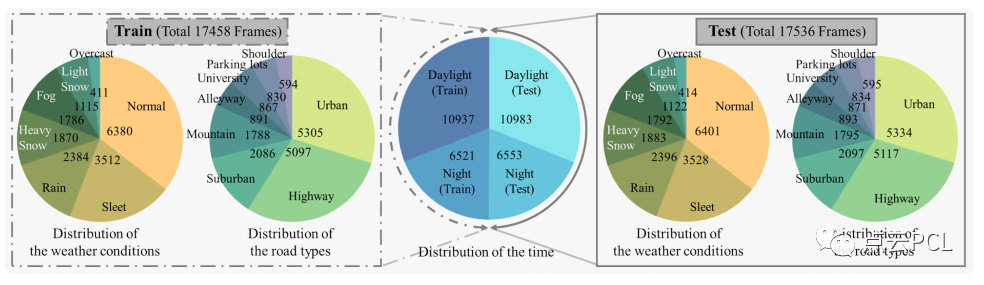

Большая часть данных в суровых погодных условиях была собрана в провинции Канвондо в Южной Корее, где наблюдается самый сильный снегопад в стране. С другой стороны, кадры в городских условиях в основном собирались в Тэджоне, Южная Корея. В процессе сбора данных было получено 35 тыс. кадров данных, содержащих измерения мультимодальных датчиков, образующих набор данных K-Radar. Кроме того, набор данных разделен на обучающий набор и тестовый набор, чтобы обеспечить сбалансированное появление каждого условия в обоих наборах, как показано на рисунке 4.

Рисунок 4: Распределение данных по времени сбора (ночь/день), погодным условиям и типу дороги. Центральная круговая диаграмма показывает распределение данных по времени сбора, а левая и правая круговые диаграммы показывают распределение обучающих и тестовых наборов по погодным условиям и типам дорог соответственно. На внешнем крае каждой круговой диаграммы мы показываем время сбора данных, погодные условия и тип дороги, а во внутренней части — количество кадров в каждом распределении.

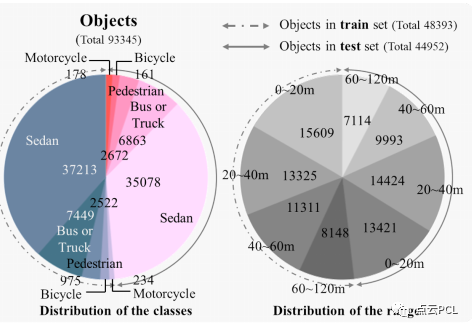

Всего в наборе данных K-Radar имеется 93,3 тыс. объектов (легковые автомобили, автобусы или грузовые автомобили, пешеходы, велосипеды и мотоциклы), движущихся в продольном радиусе 120 метров и боковом радиусе 80 метров от собственного транспортного средства с 3D-ограничением. этикетки на коробках. Обратите внимание, что аннотируются только те объекты, которые появляются на положительной продольной оси, т. е. перед автомобилем-эго. На рисунке 5 мы показываем распределение категорий объектов и расстояний в наборе данных K-Radar. Большинство объектов расположены в пределах 60 метров от автомобиля, при этом 10–15 тыс. объектов появляются в каждой категории расстояний 0–20 м, 20–40 м и 40–60 м, а 10–15 тыс. объектов появляются в категориях расстояний, превышающих 60 м. Объекты размером 7K отображаются в категории «Расстояние». Таким образом, K-Radar можно использовать для оценки производительности сетей обнаружения 3D-объектов на различных расстояниях.

Рисунок 5: Распределение категорий объектов и расстояний до транспортных средств в группе обучения/тестирования, предоставленное набором данных K-Radar. Название класса объекта и расстояние до автомобиля указывается вне сектора, а количество объектов в каждом распределении указывается внутри сектора.

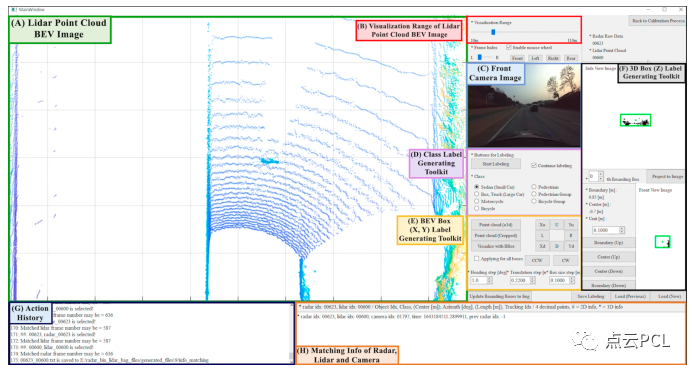

Визуализация данных, калибровка и процесс аннотирования

В отличие от 3D-тензора радара (3DRT), которому не хватает информации о высоте, 4D-тензор радара (4DRT) представляет собой плотный тензор данных, содержащий измерения мощности в четырех измерениях: доплеровском, дальности, азимуте и тангаже. Однако дополнительные измерения плотных данных могут создавать проблемы при визуализации разреженных данных, таких как облака точек, с помощью 4DRT (см. Рисунок 2). Чтобы решить эту проблему, мы визуализируем 4DRT как двумерную тепловую карту в декартовой системе координат посредством эвристической обработки, как показано на рисунке 6-(a), так что вид сверху (BEV-2D), вид спереди ( FV-2D) и вид сбоку (SV-2D) создавали 2D-визуализацию тепловой карты. В совокупности мы называем эти 2D-тепловые карты BFS-2D.

Рисунок 6: (а) Процесс визуализации 4DRT и (б) Результаты визуализации 4DRT.

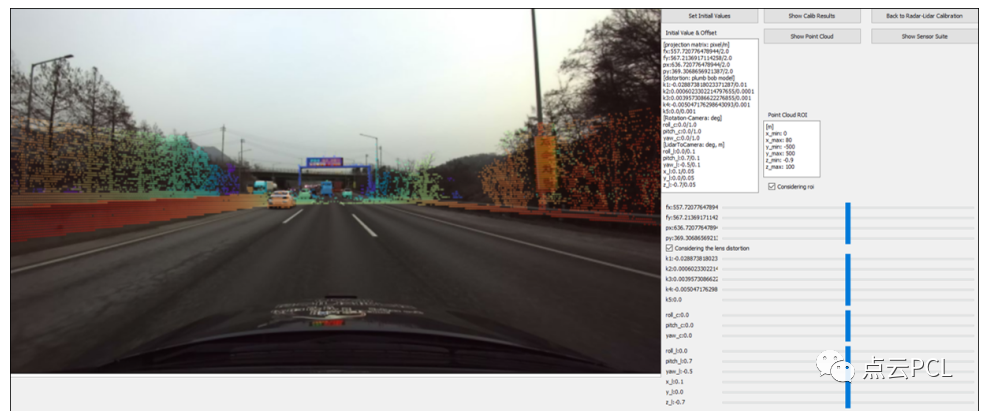

С помощью BEV-2D мы можем визуально проверить устойчивость 4D-радара к неблагоприятным погодным условиям, как показано на рисунке 2. Как упоминалось ранее, результаты измерений камеры и лидара могут ухудшиться в неблагоприятных погодных условиях, таких как дождь, мокрый снег и снег. На рисунке 2-(e, f) мы показываем ситуацию, когда лидарные измерения удаленных объектов теряются в условиях сильного снегопада. Однако BEV-2D от 4DRT четко показывает объекты с высокими измерениями мощности по краям ограничивающей рамки объекта. Даже при использовании BFS-2D аннотаторам-человекам по-прежнему сложно определить форму объекта, появляющегося в кадре, и точно аннотировать соответствующую ограничивающую трехмерную рамку. Поэтому мы создали инструмент для создания трехмерных аннотаций ограничивающей рамки в LPC, где форму объекта легче определить. Кроме того, мы используем BEV-2D, чтобы помочь аннотаторам выполнять аннотацию в ситуациях, когда лидарные измерения теряются из-за неблагоприятных погодных условий. Мы также предоставляем инструмент для покадровой калибровки BEV-2D и LPC, который преобразует трехмерные метки ограничивающих рамок в полях координат лидара в поля координат радара 4D. Инструмент калибровки поддерживает разрешение 1 см на пиксель с максимальной ошибкой 0,5. см. Кроме того, вводится ряд процессов для точного получения параметров калибровки между лидаром и камерой. Процесс калибровки между лидаром и камерой обеспечивает точное проецирование трехмерных ограничивающих рамок и LPC на изображения с камеры, что имеет решающее значение для исследования слияния мультимодальных датчиков и может использоваться для создания плотной глубины для исследования монокулярной оценки глубины.

Базовые NN K-Radar

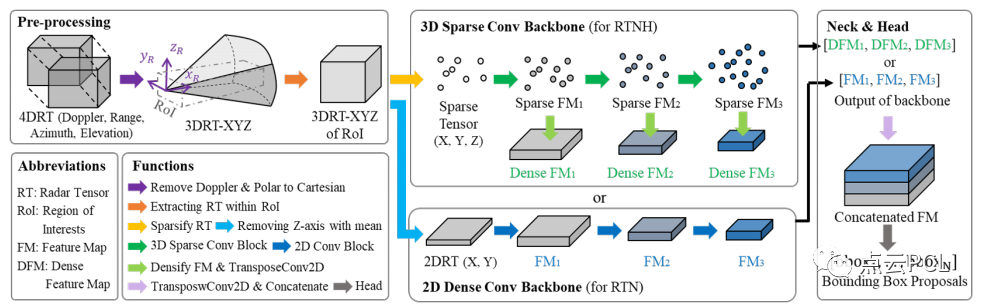

Мы предоставляем две базовые нейронные сети, чтобы продемонстрировать важность информации о высоте при обнаружении трехмерных объектов:

(1) Радарная тензорная сеть с высотой (RTNH), которая использует разреженную трехмерную CNN для извлечения карт объектов (FM) из RT для использования информации о высоте;

(2) Радарная тензорная сеть без высоты (RTN), которая использует 2D CNN для извлечения FM из RT и не использует информацию о высоте.

Рисунок 7: Две базовые нейронные сети, используемые для проверки эффективности обнаружения 3D-объектов на основе 4DRT.

Как показано на рисунке 7, и RTNH, и RTN содержат предварительную обработку, туловище, шею и голову. Предварительная обработка преобразует 4DRT из полярных координат в декартовы и извлекает 3DRT-XYZ в интересующей области (RoI). Обратите внимание, что мы уменьшаем размерность, усредняя по доплеровскому измерению. Затем магистраль извлекает FM, содержащие важные функции для прогнозирования ограничивающего прямоугольника. Основа RTNH и RTN построена с использованием 3D Sparse Conv Backbone (3D-SCB) и 2D Dense Conv Backbone (2D-DCB) соответственно. 3D-SCB использует разреженные трехмерные свертки для кодирования трехмерной пространственной информации (X, Y, Z) в окончательную FM. Мы решили использовать разреженные свертки на разреженных RT (верхние 10% измерений мощности в RT), поскольку плотные свертки на необработанных RT требуют большого объема памяти и вычислений, что не подходит для приложений автономного вождения в реальном времени. В отличие от 3D-SCB, 2D-DCB использует 2D-свертку, поэтому конечный FM содержит только 2D-пространственную информацию (X, Y). Таким образом, окончательный FM, созданный 3D-SCB, содержит 3D-информацию (с высотой), тогда как окончательный FM, созданный 2D-DCB, содержит только 2D-информацию (без высоты).

эксперимент

Мы демонстрируем надежность восприятия автономного вождения на основе 4D-радарного тензора (4DRT) в различных погодных условиях, чтобы сравнить производительность обнаружения 3D-объектов между базовой нейронной сетью (NN) и NN на основе лидара с аналогичной структурой. Мы также обсуждаем важность информации о высоте, сравнивая производительность обнаружения трехмерных объектов между базовой NN с трехмерной разреженной сверточной основой (RTNH) и базовой NN с двумерной плотной сверточной основой (RTN).

Настройки эксперимента и Детали реализации измерений

Использование PyTorch 1.11.0 RTX3090 на машине с Baseline NNиPointPillars, реализованной на графическом процессоре Ubuntu. Мы устанавливаем размер пакета равным 4,И было проведено 11 раундов обучения сети с использованием оптимизатора Адама со скоростью обучения 0,001. пожалуйста, обрати внимание,Устанавливаем целью обнаружения класс автомобиля,Этот класс имеет наибольшее количество выборок в наборе данных K-Radar. В эксперименте используется метрика средней точности (AP) широкоиспользования, основанная на пересечении через объединение (IOU), которая используется для оценки производительности обнаружения трехмерных объектов.

Сравнение RTN и RTNH

Сравнение эффективности обнаружения между RTNH и RTN показано в таблице 3. Мы можем наблюдать, что RTNH улучшает AP3D и APBEV на 7,32% и 7,72% соответственно по сравнению с RTN. RTNH значительно превосходит RTN как в AP3D, так и в APBEV, что указывает на то, что информация о высоте, доступная в 4DRT, очень важна для обнаружения трехмерных объектов.

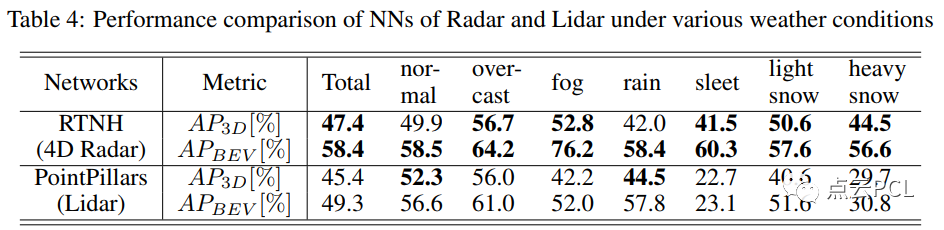

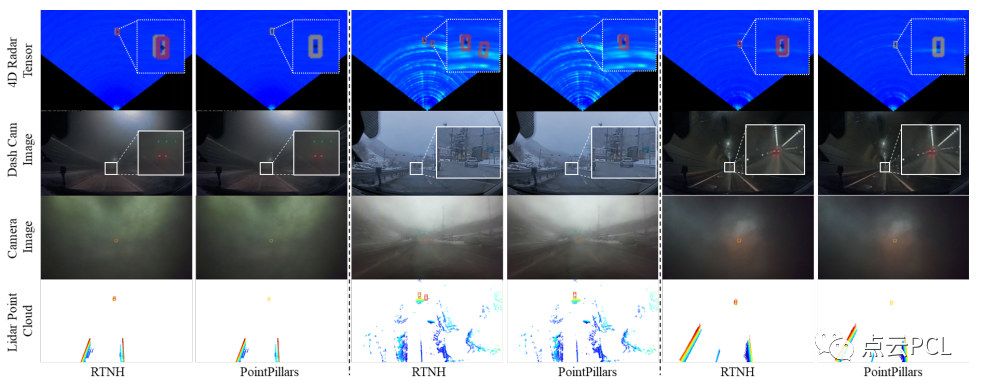

Сравнение RTNH и PointPillars

В таблице 4 показано сравнение производительности обнаружения между RTNH и PointPillars, лидарной сетью обнаружения с одинаковой структурой. По сравнению с обычными условиями производительность BEV и 3D-обнаружения лидарной сети упала на 33,5% и 29,6% или 25,8% и 22,6% соответственно в условиях гололеда или сильного снегопада. Напротив, характеристики обнаружения RTNH на основе 4D-радара практически не изменяются в плохую погоду, а характеристики BEV и 3D-обнаружения целей в условиях мокрого снега или сильного снегопада лучше или аналогичны нормальным условиям. Эти результаты демонстрируют надежность восприятия 4D-радара в суровых погодных условиях.

Другие рисунки

Рисунок 8: Дополнительные образцы набора данных K-Radar при различных погодных условиях. (1) В трех прямоугольниках показаны изображения 4DRT, камеры переднего обзора и облака точек лидара (LPC) для трех различных дорожных условий при одинаковых погодных условиях. В этом примере желтая, красная и синяя ограничивающие рамки обозначают автомобили, автобусы или грузовики и пешеходов соответственно. Объекты, для которых все измерения LPC были потеряны из-за суровых погодных условий, отмечены фиолетовыми пунктирными линиями.

Рис. 9. Фрагмент видеоклипа, показывающий динамику измерений каждого датчика во время движения по сильному снегопаду.

Рис. 11. Видеоклип, показывающий процесс аннотирования.

Рисунок 17: Программа с графическим интерфейсом для точной настройки параметров калибровки между лидаром и камерой.

Рисунок 22: Результаты 3D-обнаружения целей RTNH (4DRT) и точечных столбов (LPC) в погодных условиях с осадками. Слева направо идет ледяной дождь, небольшой снег и сильный снег. Мы используем желтые и красные рамки для обозначения истинной истины и предсказаний соответственно.

Подвести итог

В этой статье представлен набор данных и тест для обнаружения 3D-целей на основе тензора 4D-радара (4DRT).,то есть К-Радар。K-Radarданныенабор Включать35,000 кадров 4DRT, LPC, камеры объемного звучания, как и данные иRTK-IMU, эти данные были собраны в разное время и в разных погодных условиях. К-Радар предлагает 93,300расстояние до120Пять категорий рисаобъектиз3DМетка ограничивающей рамкииотслеживатьID。Для проверки на основе4D雷达из目标检测из稳健性,представилиспользовать4DRT作为输入из基线нейронная сеть. Результаты демонстрируют важность информации о высоте, недоступной в обычных тензорах 3D-радара (3DRT), а также надежность 4D-радара в неблагоприятных погодных условиях. Хотя основное внимание в этой работе уделяется трехмерному обнаружению целей на основе 4DRT, K-Radar также может использоваться для отслеживания целей на основе 4DRT, SLAM и различных других задач восприятия. Поэтому есть надежда, что K-Radar сможет ускорить работу «Автономного» на базе 4DRT. вождение Исследование в области восприятия.

ресурс

Совместное использование автономного вождения и позиционирования

Обнаружение движущихся объектов на основе оптического потока при автономном вождении

Калибровка внешних параметров камеры на основе семантической сегментации

Обзор методов автономного позиционирования транспортных средств в условиях высоких скоростей

Patchwork++: быстрый и надежный метод сегментации земли на основе облаков точек.

PaGO-LOAM: наземная оптимизированная лидарная одометрия

Мультимодальный метод обнаружения и фильтрации края дороги

Платформа для одновременной калибровки, позиционирования и картографирования нескольких лидаров.

Извлечение, картографирование и долгосрочное позиционирование стержней в динамичной городской среде.

Коррекция искажений движения лидара непериодического сканирования

Быстрая и тесно связанная разреженная прямая радиолокационная инерционно-визуальная одометрия

3D-обнаружение транспортных средств на основе камер и лидара низкого разрешения

Базовое введение в начало работы с ROS2

Автоматическая калибровка твердотельных лидаров и систем камер

Решение для позиционирования датчиков с помощью лидара+GPS+IMU+колесного спидометра

Больше статей можно посмотреть:Краткое изложение статей по истории обучения облакам точек

Обмен, связанный с SLAM и AR

Введение в принципы TOF-камеры

Введение в времяпролетную камеру глубины TOF

Оптимизированное решение F-LOAM с открытым исходным кодом: на основе оптимизированного SC-F-LOAM.

[Быстрое чтение статьи] AVP-SLAM: Семантический SLAM в автоматических парковочных системах

[Краткое чтение статей об облаках точек] StructSLAM: SLAM структурированных линейных объектов

Часто используемые 3D-камеры глубины

Обзор и оценка алгоритма монокулярной визуальной инерциальной навигации SLAM для AR-оборудования

Обзор SLAM (4) Laser and Vision Fusion SLAM

Система Semantic SLAM для реконструкции в реальном времени от Kimera

Легко расширяемая платформа SLAM — OpenVSLAM

Введение в метод SLAM на основе камеры «рыбий глаз».

Если в приведенном выше содержании есть какие-либо ошибки, пожалуйста, оставьте комментарий. Исправления и обмен приветствуются. Если есть какие-либо нарушения, пожалуйста, свяжитесь с нами, чтобы удалить их.

Как и друзья, которые поделились этим!

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами