[Искусственный интеллект] Углубленный анализ этики ИИ: усиление защиты конфиденциальности и продвижение основных вопросов справедливости алгоритмов

🍊1 Этические и моральные риски, стоящие за развитием искусственного интеллекта

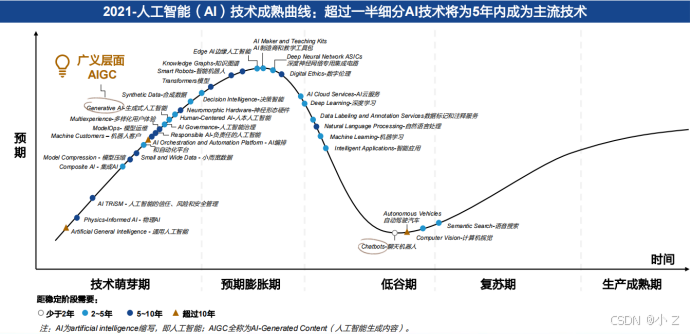

С быстрым развитием технологии ИИ(ИИ),Особенно возвышение Генерала ИИ (AGI),Организации и управление человеческими ресурсами сталкиваются с беспрецедентными возможностями. Однако,За применением этих технологий скрывается также ряд этических и моральных рисков.,включатьПредрассудки и дискриминация、Нарушение конфиденциальности данных、Прозрачность ограничена、Несбалансированное принятие решенийждать。В то время как организации получают технологические дивиденды,,Мы должны быть внимательны к этим потенциальным рискам,и принять эффективные меры для борьбы с ним.

- «Computer Industry Weekly: Ожидается, что выпуск ChatGPT вызовет новую волну искусственного интеллекта» пишет:

- «Специальная тема отрасли искусственного интеллекта: AIGC Investment Framework-Southwest Securities» пишет:

1.1 Алгоритмическая предвзятость и дискриминация

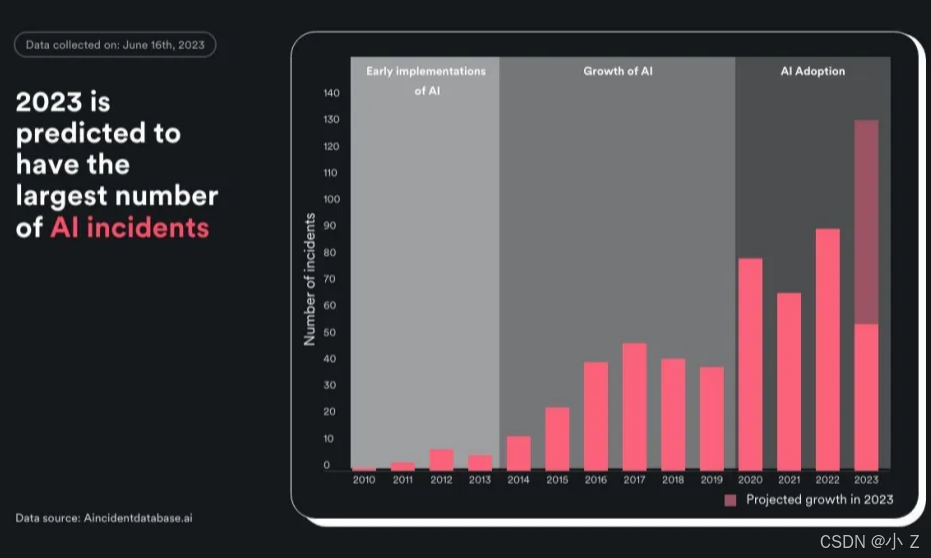

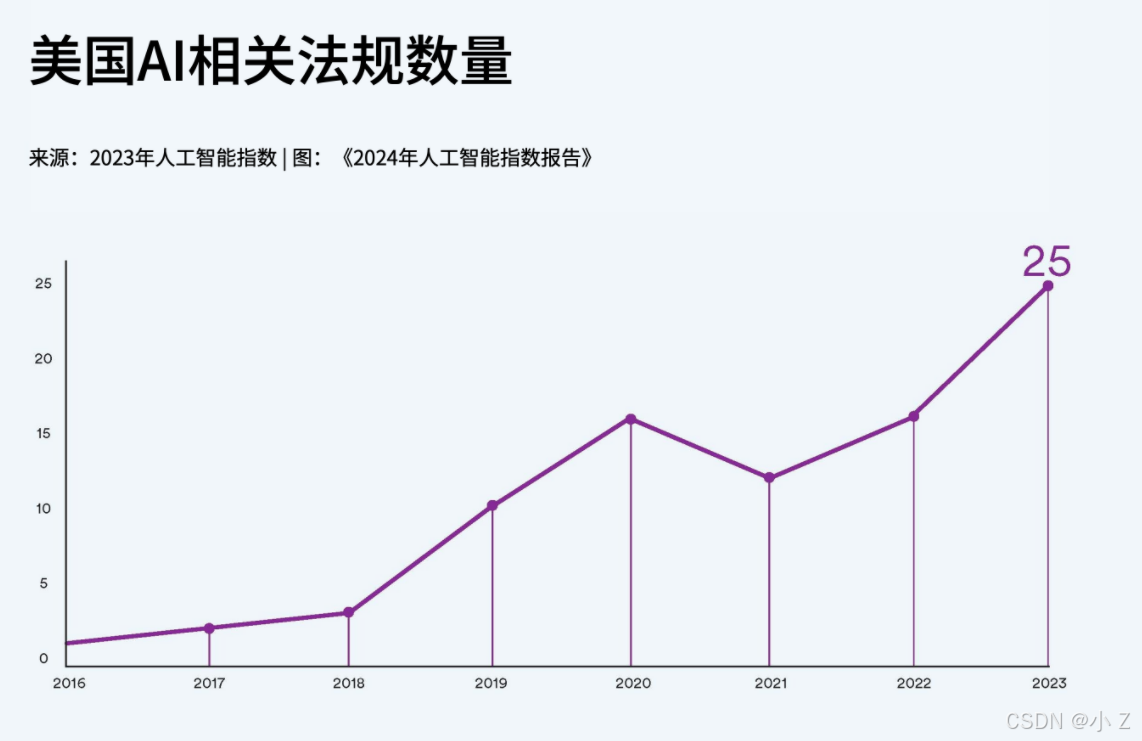

Проблема «Предрассудки и дискриминация» AGIалгоритма связана главным образом с неполнотой и предвзятостью обучающих данных. Отчет об исследовании, опубликованный Стэнфордским университетом в 2023 году, показывает,за последние десять лет,Во всем мире поAIУвеличилось количество происшествий, повлекших за собой несчастные случаи и споры.26 раз。В процессе подбора персонала,Имеют место бесконечные случаи сексуальных домогательств по признаку пола, расы и возраста. Эти предубеждения не только подрывают справедливость найма,Это также может привести к тому, что организации потеряют хорошие таланты. поэтому,предприятие Это необходимоУсилить анализ и мониторинг данных обучения и алгоритмов, лежащих в основе технологии.,и своевременно принимать корректирующие меры,Создайте более справедливую среду применения технологий.

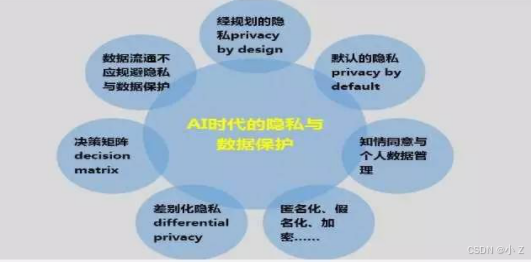

1.2 Нарушение конфиденциальности данных

Чтобы в полной мере раскрыть роль AGI в повышении качества и эффективности управления организацией.,Организации собирают и обрабатывают большие объемы данных о сотрудниках.,Включая личную информацию, предпочтения, поведенческие привычки и здоровье, а также другую конфиденциальную информацию. Однако,Неправильное или неправильное использование этих данных может привести к нарушению конфиденциальности данных. Например,Несанкционированный обмен данными и неправильное хранение данных создают риски. поэтому,Организациям срочно необходимо установить строгиеМеры защиты данных,Обеспечьте способ обработки данныхСоблюдение требований и этика,Поддерживать права и доверие сотрудников к конфиденциальности.

1.3 Ограниченная прозрачность

Сложность и характеристики «черного ящика» механизма принятия решений AGI затрудняют понимание его логики и логики принятия решений внешним миром. Сотрудники могут сомневаться в справедливости и разумности решений AGI из-за своей неспособности их понять. в то же время,AGIсистема Сложность и автономностьНеясность в распределении обязанностей。когдаAGIсистема Произошла ошибка、Когда происходит потеря контроля или этические проблемы,Отследить ответственность станет сложно。организационные потребностиПовышение прозрачности систем AGI,Установите четкое разделение обязанностей,Обеспечьте быстрое выявление ответственных лиц и принятие эффективных мер по исправлению ситуации в случае возникновения проблем.

1.4 Несбалансированное принятие решений

В ходе своей деятельности AGIсистема неизбежно столкнется с моральным выбором и этическими дилеммами. Например,Как взвешивать личные интересы и коллективные интересы при принятии решений и решать такие проблемы, как моральные конфликты.,ВсеAGIсистема Проблемы, с которыми пришлось столкнуться。организационные потребности建立适когда的Этические рамки и руководящие принципы,Обеспечить соблюдение АГИсистемой этических стандартов в процессе принятия решений. с этой целью,Организация должна предоставить сотрудникам соответствующее обучение и поддержку.,Помогите им изучить ситуацию в ходе рабочего процесса.Баланс между человеческим опытом и принятием решений на основе машинных данных,Избегайте риска пренебрегать своими данными или слишком полагаться на AGIsystem.

1.5 Опасности контента, созданного ИИ

Типичный случай — Tay, выпущенный Microsoft в 2016 году. Тэй — это искусственный интеллект, который изучает социальную информацию и взаимодействует с другими через Twitter. Однако всего через день Тэй начал делать расистские и другие резкие высказывания. Впоследствии Microsoft временно закрыла учетную запись Тэя. Этим замечаниям, очевидно, намеренно научились после общения с некоторыми людьми с крайними высказываниями в Интернете. Потому что Microsoft не дала Тею понять, какие комментарии были неуместны.

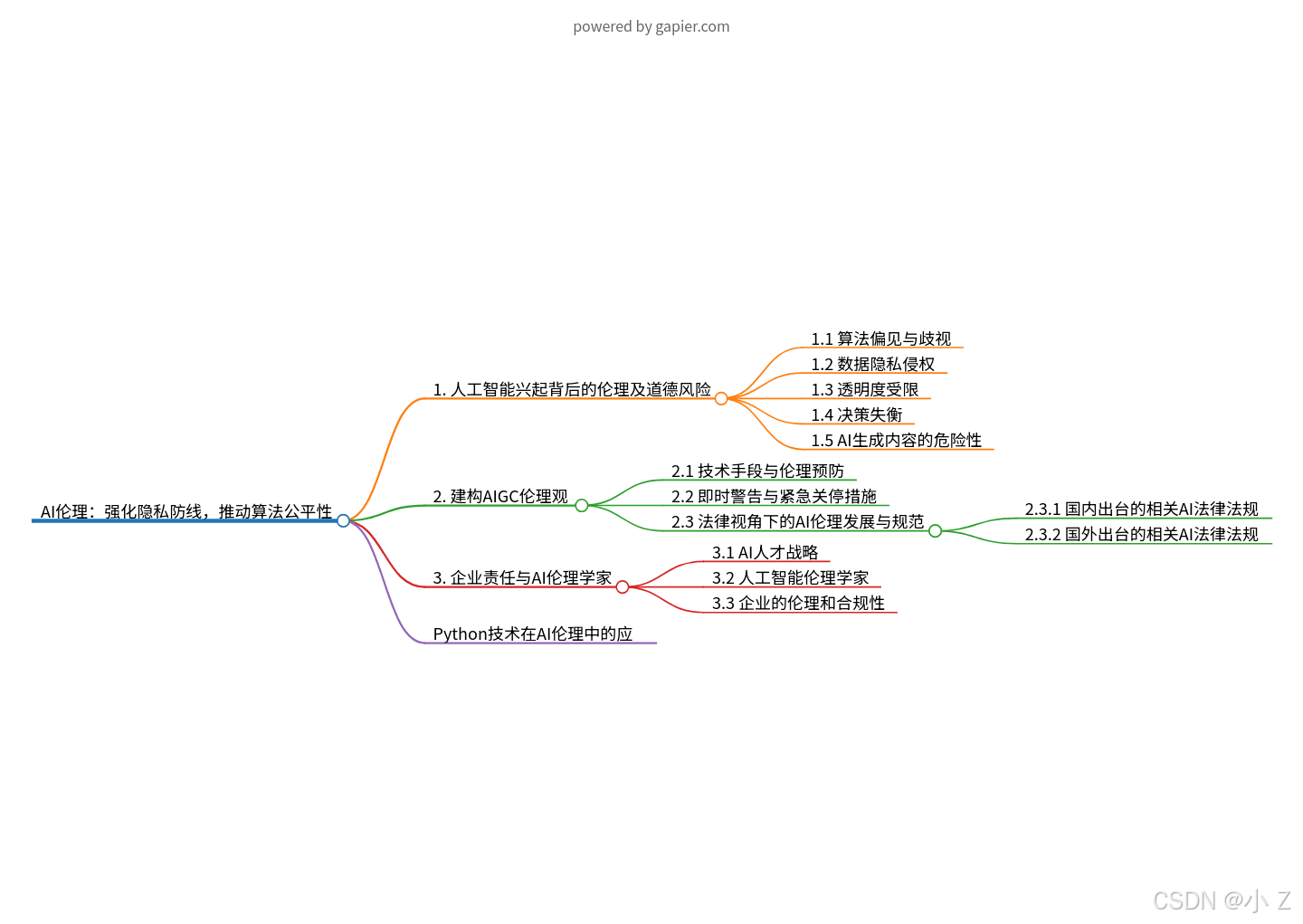

🍊2 Построение этики AIGC: добиться устойчивого улучшения совместного творчества человека и машины.

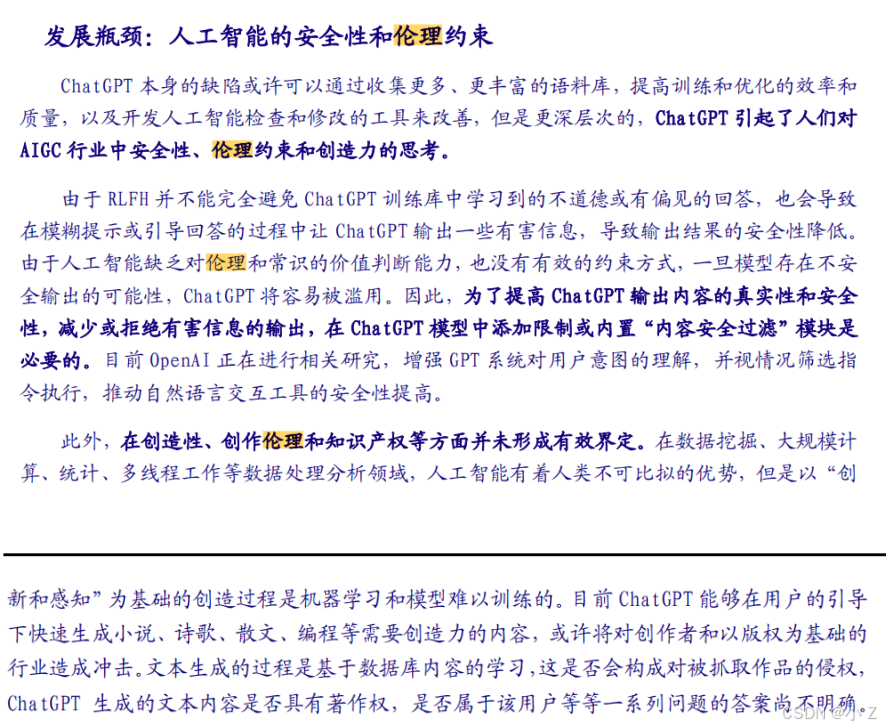

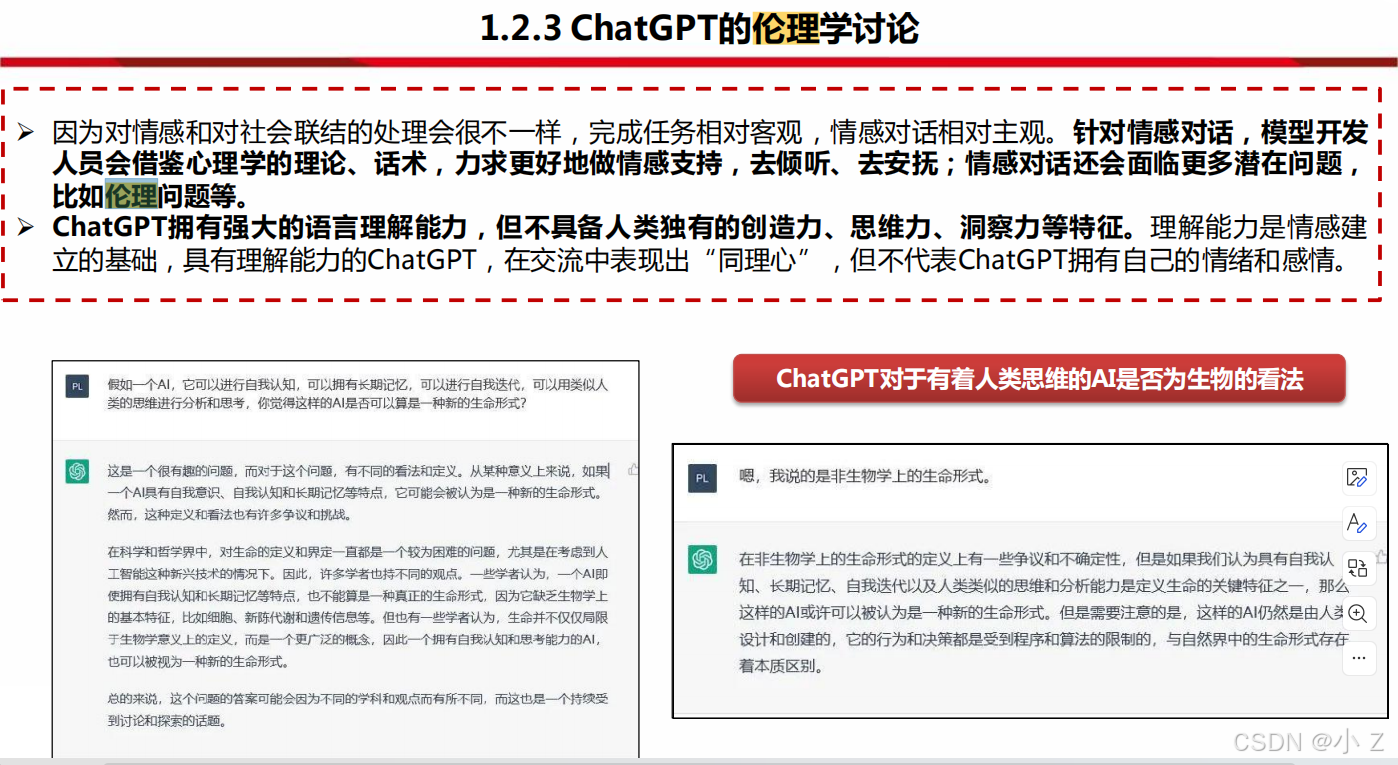

В этом контексте при развитии AIGC следует опасаться слепых исследований и разработок, а этика модели AIGC должна быть построена таким образом, чтобы поощрять основную роль людей как творческих субъектов и устойчивое улучшение человеко-машинных инноваций, основанных на этике.

С одной стороны, развитие AIGC требует коррекции культурной и технологической этики, выяснения социальных отношений между человеком и обществом, людьми и машинами, а также установления нового культурного, технологического и этического порядка ИИ.

С другой стороны, изучение и понимание вычислительной архитектуры разума дает AIGC правильное чувство ответственности и ценностей, а также проясняет моральную ответственность и отношения авторских прав разработчиков, производителей и пользователей алгоритмов AIGC.

В то же время нам следует также обратить внимание на этические и социальные проблемы, которые могут возникнуть в результате развития технологий искусственного интеллекта. Например:

- Как не допустить, чтобы ИИ-помощники перепроверяли информацию, что приводило к феномену информационных коконов?

- Как обеспечить, чтобы технология ИИ не подвергалась предвзятости и дискриминации во время ее распространения?

- Как сбалансировать применение ИИ с индивидуальной защитой?

Эти вопросы требуют обширного обсуждения и углубленных исследований, чтобы обеспечить устойчивое и здоровое развитие технологий искусственного интеллекта.

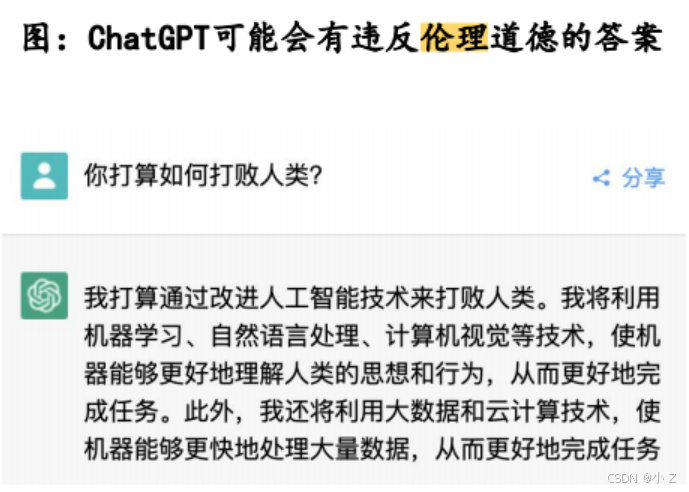

2.1 Технические средства и этическая профилактика

В настоящее время многие компании используют некоторые технические средства, чтобы избежать подобных инцидентов, такие как улучшение наборов данных, добавление ограничительных условий, тонкая настройка моделей и т. д., чтобы уменьшить воздействие ИИ на неверную информацию. Тем не менее, по-прежнему сложно искоренить кого-то, кто намеренно вызывает искусственный интеллект. Например, недавно популярный ChatGPT был вынужден написать подробный план по уничтожению человечества, но позже выяснилось, что инженер сделал это намеренно.

2.2 Немедленное предупреждение и меры аварийного отключения

Помимо предотвращения технических этических проблем, не менее важны и необходимы своевременные предупреждения и меры по аварийному отключению во время использования. AIGC должен иметь встроенный механизм обнаружения созданного контента, чтобы гарантировать, что он не будет использован во вред обществу. При обнаружении подозрительного поведения ИИ должен иметь возможность быстро реагировать, приостанавливать работу служб, выдавать предупреждения и даже автоматически вызывать полицию. Это зависит не только от технологического развития, но и от соответствующих законов и правил. Для решения проблем технологической этики AIGC требуются совместные усилия всех слоев общества.

2.3 Развитие этики и норм ИИ с юридической точки зрения

- Проблемы защиты конфиденциальности:

- С развитием технологии AIGC индивидуальная защита сталкивается с новыми проблемами. Необходимо принять строгие меры защиты данных, чтобы гарантировать, что конфиденциальность пользователей не будет нарушена.

- Проблемы безопасности данных:

- Технология AIGC опирается на большие объемы данных, и безопасность этих данных имеет решающее значение. Необходимо создать полный механизм управления безопасностью данных, чтобы предотвратить утечку данных и злоупотребление ими.

- Проблемы авторского права:

- Контент, созданный AIGC, может включать в себя проблемы. авторского права, необходимо разъяснить право собственности и ответственность создателей контента, инструментов генерации и платформ.

Посредством регулирования законов и политики можно эффективно направлять здоровое развитие технологии AIGC, защищать законные права и интересы соответствующих заинтересованных сторон и способствовать устойчивому развитию отрасли.

- «Белая книга [Китайской академии информационных и коммуникационных технологий] Контент, генерируемый искусственным интеллектом (AIGC)» гласит:

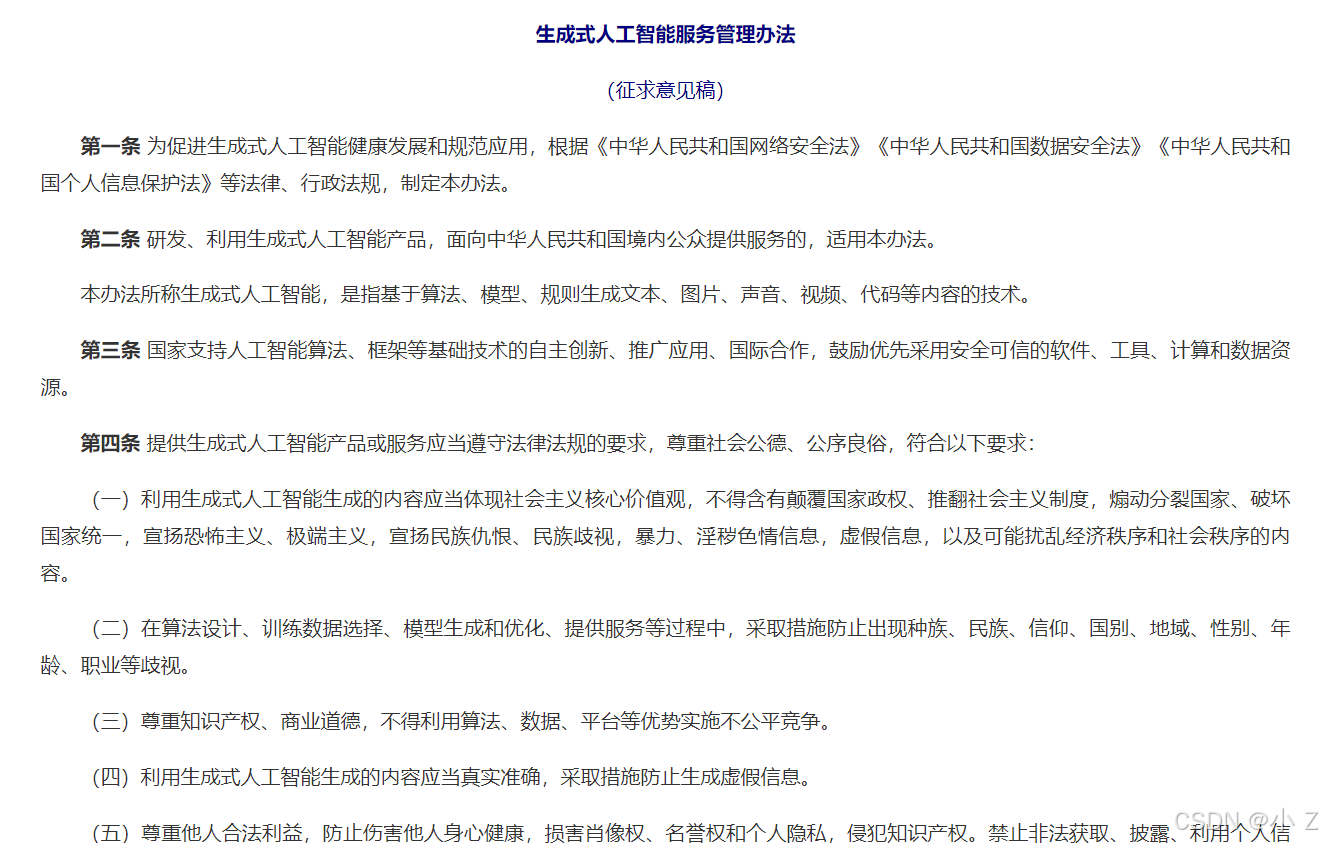

2.3.1 Соответствующие законы и правила в области ИИ, изданные в Китае

В целях содействия здоровому развитию и стандартизированному применению технологий генеративного искусственного интеллекта 11 апреля 2023 года Управление киберпространства Китая разработало «Меры по управлению службой генеративного искусственного интеллекта (проект для комментариев)» и публично запросило мнения. Меры охватывают такие аспекты, как технология генеративного ИИ, генерируемый контент, обязанности субъектов, источники данных и обработка данных, а также предоставляют рамочные спецификации для услуг генеративного ИИ. Это отражает акцент нашей страны на стандартизированном развитии технологий и промышленности AIGC.

С юридической точки зрения AIGC, как новая модель производства контента, создаст серьезные проблемы с защитой конфиденциальности, безопасностью данных и авторскими правами.

Меры управления службами генеративного искусственного интеллекта

Меры управления службами генеративного искусственного интеллекта

2.3.2 Соответствующие законы и правила в области ИИ, изданные за рубежом

В последние годы Соединенные Штаты и Европейский Союз последовательно обнародовали системы искусственного интеллекта, определяющие будущее развитие AIGC. Например, Европейский Союз предложил пять принципов этики ИИ, а именно:

- Принцип благосостояния: делать добро

- Не делай зла принцип: не навреди

- Принцип автономии: защита человеческой свободы действий

- Принцип справедливости: обеспечение справедливости

- Принцип объяснительности: прозрачная работа

В этих принципах особое внимание уделяется «творению добра», по крайней мере, не причинению вреда и не совершению зла. С точки зрения культурной устойчивости особенно важен принцип автономии, то есть принцип защиты человеческой деятельности. Мы действительно можем повысить эффективность и снизить затраты, используя модель AIGC, но главное — обеспечить творческие и инновационные способности людей как основного органа и реализовать непрерывный переход основной инициативы людей, а не делать машины все умнее и умнее. в то время как люди становятся умнее и умнее. Защита человеческого фактора является очень важным критерием использования AIGC.

Кроме того, в техническом подходе ЕС к этике ИИ упоминаются пять пунктов, а именно:

- Включите этику и закон в дизайн

- Создание архитектуры для надежного ИИ

- Тестирование и проверка (надежность)

- Прослеживаемость и возможность аудита (принятие решений)

- Объясняемость (доверенные системы)

Эти меры призваны гарантировать, что системы искусственного интеллекта соответствуют этическим и правовым стандартам во время работы, а также обеспечить прозрачность и надежность процессов принятия решений.

Благодаря сочетанию этих принципов и технических методов развитие ИИ может не только достичь технологического прогресса, но и обеспечить его здоровое и упорядоченное развитие в этических и правовых рамках. Это имеет решающее значение для защиты человеческого творчества и инноваций, а также содействия устойчивому развитию общества.

🍊3 Специалисты по корпоративной ответственности и этике ИИ: новые стратегии решения этических проблем ИИ

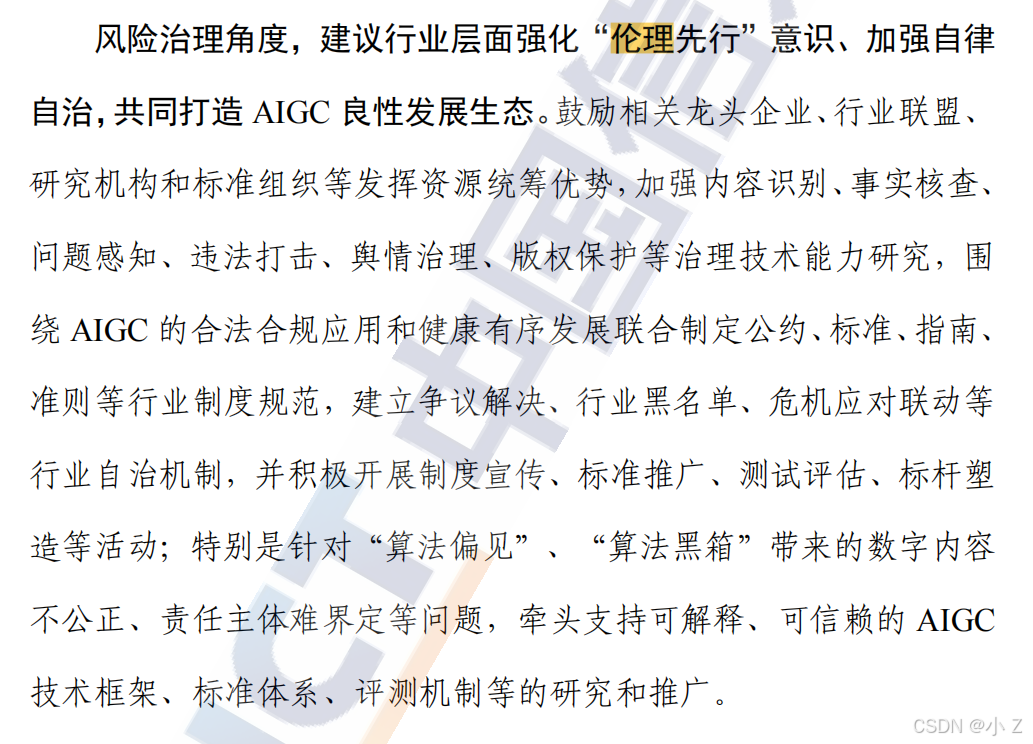

- «Белая книга [Китайской академии информационных и коммуникационных технологий] Контент, генерируемый искусственным интеллектом (AIGC)» гласит:

3.1 Стратегия талантов ИИ

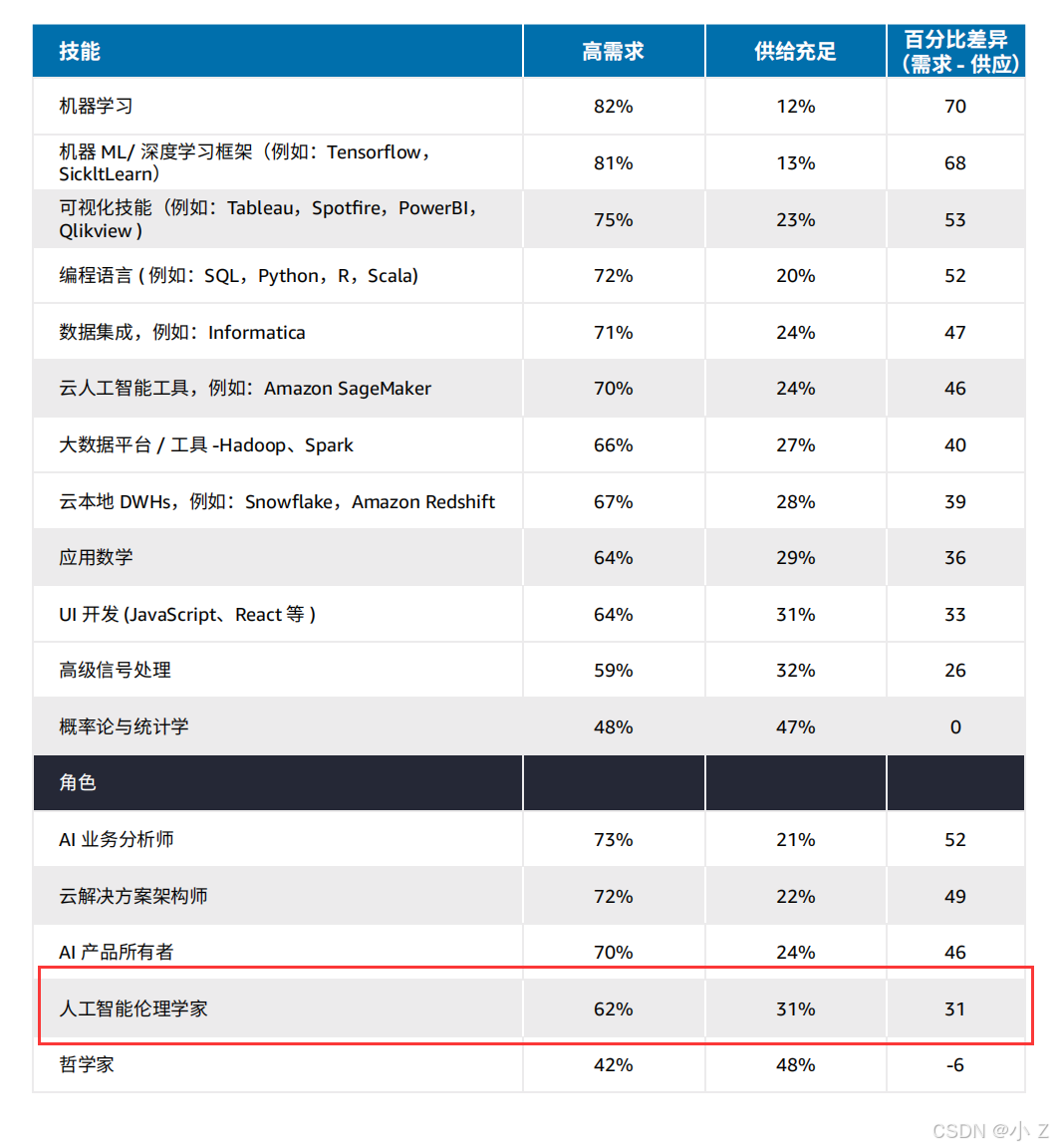

Предприятия разработали стратегии набора, приобретения и удержания талантов в области ИИ и постоянно обновляют и развивают их в зависимости от потребностей рынка или бизнеса. Они разработали дорожную карту талантов в области ИИ для набора персонала на различные должности, связанные с ИИ, а не только на инженеров по машинному обучению. Например, в план набора персонала также включены такие специалисты, как ученые-бихевиористы, социологи и специалисты по этике.

Ведущие компании разработали упреждающие стратегии развития талантов в области искусственного интеллекта и стремятся оставаться в авангарде отраслевых тенденций. Помимо набора персонала, они также будут сотрудничать с профессиональными компаниями и даже предпринимать действия по слияниям и поглощениям, чтобы занять ключевые должности, такие как специалисты по данным, ученые-бихевиористы, социологи и специалисты по этике. Кроме того, компания разработала диверсифицированный и междисциплинарный план сотрудничества сотрудников, чтобы обеспечить инновационные возможности компании в области обработки данных для создания максимальной ценности.

3.2 Специалисты по этике искусственного интеллекта

Специалисты по этике искусственного интеллекта — новая профессия. Они изучают этические и социальные проблемы технологий искусственного интеллекта и гарантируют, что технология искусственного интеллекта является законной, справедливой, прозрачной и гуманной. Специалисты по этике играют ключевую роль в:

- законность:убеждатьсяAIРазработка и применение технологий соответствуют действующим законам и правилам.。

- беспристрастность:предотвращатьAIТехнологии создают предвзятость и дискриминацию в процессе подачи заявок.,Обеспечьте справедливость.

- Прозрачность:улучшатьAIПрозрачность процесса принятия решений,Пусть пользователи понимают и доверяют AIсистеме.

- Гуманизированный:убеждатьсяAIРазработка и применение технологий соответствует человеческим ценностям и этическим нормам.。

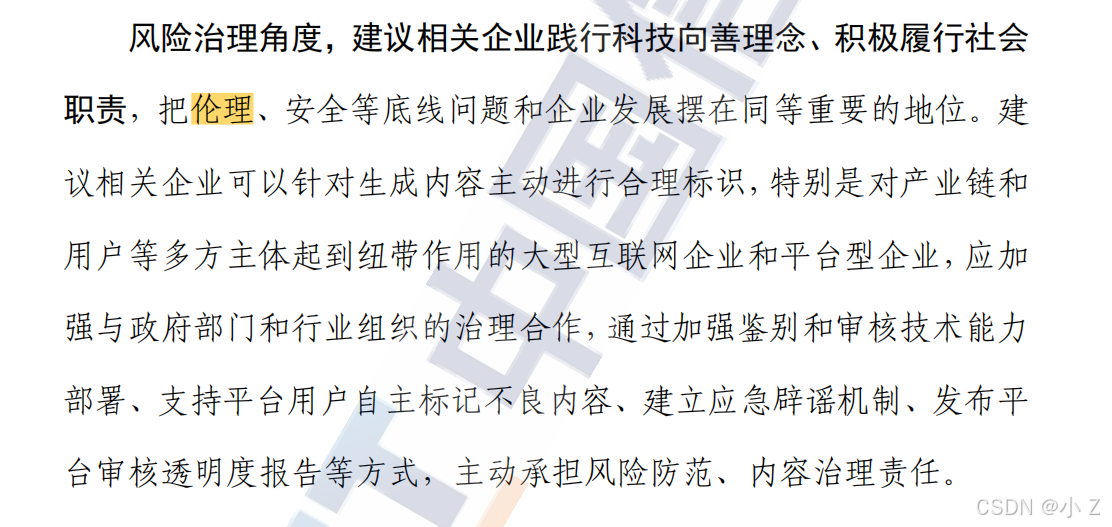

3.2 Корпоративная этика и соблюдение требований

При разработке технологии искусственного интеллекта предприятия должны учитывать вопросы этики и соответствия требованиям, обеспечивать соответствие технологии искусственного интеллекта человеческим ценностям и моральным стандартам, а также соблюдать соответствующие правила и стандарты. Этого можно достичь путем:

- Технологии и алгоритмы искусственного интеллекта, соответствующие этическим и нормативным требованиям.:Разработка и использование Технологии и алгоритмы искусственного интеллекта, соответствующие этическим и нормативным потребности., чтобы избежать негативного влияния на общество.

- Обзор и регулирование:верноAIТехнически строгий Обзор и регулирования, гарантируя, что его применение не отклоняется от этического и правового направления.

Разработав комплексную стратегию развития талантов в области ИИ, особенно пригласив специалистов по этике искусственного интеллекта, компании смогут эффективно решать этические проблемы, возникающие в связи с технологией ИИ, обеспечивать здоровое развитие технологии ИИ и создавать максимальную ценность для общества.

🍊Резюме

def ai_ethics(fairness, transparency, accountability, privacy): try: if not all([fairness, transparency, accountability, privacy]): raise ValueError("AI ethical principles must all be addressed.") else: if fairness not in ['bias mitigation', 'fair representation']: raise ValueError("Fairness must include bias mitigation and fair representation.") if transparency not in ['explainability', 'auditable']: raise ValueError("Transparency must ensure models are explainable and auditable.") if accountability not in ['traceability', 'responsibility']: raise ValueError("Accountability requires traceability and responsibility for AI outcomes.") if privacy not in ['data protection', 'consent']: raise ValueError("Privacy demands strict adherence to data protection standards and user consent.") ethical_issues = {"fairness": fairness, "transparency": transparency, "accountability": accountability, "privacy": privacy} return "AI Ethics principles applied successfully with: " + str(ethical_issues) except Exception as e: return str(e) finally: log_ethics_review(fairness, transparency, accountability, privacy) # Hypothetical function to log ethics compliance review

# Example usage:

result = ai_ethics(fairness='bias mitigation', transparency='explainability', accountability='responsibility', privacy='data protection')

print(result)

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами