Интересная функция потерь: статья, подробно объясняющая важность объектности в Yolov5

**Функция потерь по-разному обрабатывает разные ящики, а механизм распознавания лучшего ящика от всех остальных является основой потери YOLO. **Использование потери достоверности отдельного объекта для обработки оценок работает лучше, чем рассмотрение достоверности вероятности класса как оценки. Рассмотрение вероятности класса как оценки достоверности при обнаружении цели SSD значительно хуже, чем модель Yolo с достоверностью.

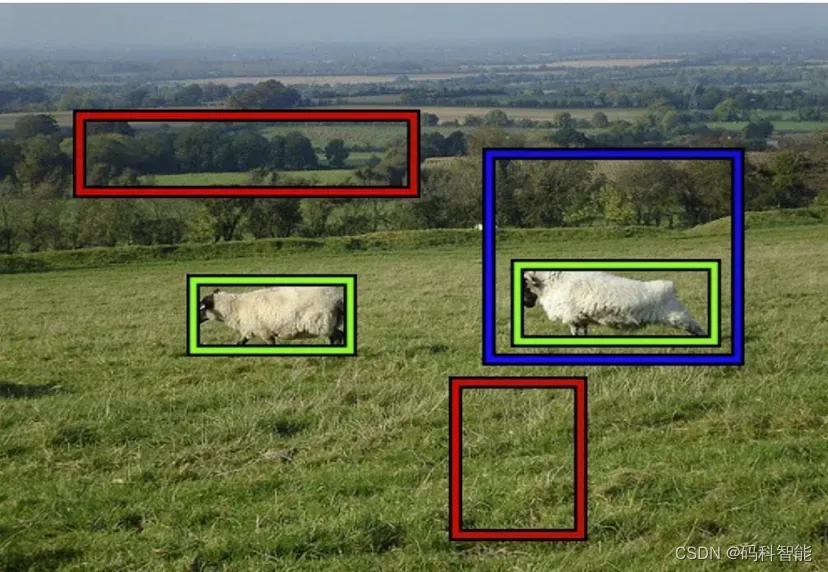

Например, на изображении выше мы ожидаем, что красная рамка будет иметь низкую объективность, синяя рамка — среднюю объективность, а зеленая рамка — высокую объективность. Это связано с тем, что зеленая рамка «плотно» прилегает к нашему объекту, синяя рамка прилегает свободно, а красная рамка вообще не содержит никаких объектов.

Состав функции потерь Yolov5

Лучшие блоки сами по себе несут потерю ограничивающего прямоугольника (из-за не совсем идеального соответствия объекту) и потерю классификации (из-за неправильной классификации), что приводит к тому, что сетевые параметры, связанные с этими блоками, улучшают положение и классификацию блока, в то время как эти коробки также Все остальные неоптимальные коробки вместе участвуют в потере доверия.

Три условия проигрыша Yolov5:

- Потеря классификации (cls_loss): Определите, может ли Модель точно идентифицировать объект на изображении и отнести его к правильной категории.

- Потеря ограничивающей рамки (box_loss): используется для измерения разницы между прогнозируемой ограничивающей рамкой Модели и истинной ограничивающей рамкой.

- Потеря уверенности (obj_loss): насколько прогнозируемая ограничивающая рамка закрывает ограничивающую рамку.

Зачем нам нужна потеря предметности?

Для каждого прогноза ограничивающей рамки существует связанное с ним значение прогноза, называемое «объектностью». Термин потери объектности учит сеть, как прогнозировать правильный IoU, в то время как потеря координат учит сеть, как лучше прогнозировать ограничивающие рамки (в конечном итоге подталкивая IoU к 1,0).

```Достоверность категории = оценка категории * потеря объектности``

Во время вывода мы обычно прогнозируем несколько ограничивающих рамок с разным покрытием для каждого объекта. Мы хотим, чтобы алгоритм постобработки выбирал ограничивающую рамку, которая наиболее точно покрывает объект. Мы также хотим выбрать ограничивающие рамки, которые обеспечивают правильное предсказание класса объекта. Как алгоритм узнает, какую ограничивающую рамку выбрать?

Во-первых, предметность Расскажите, насколько хорошее покрытие коробки,поэтому имеет очень маленькийobjectness(<0.005)Ограничивающая рамка будет удалена,Даже в модуль NMS не попадает. Это помогает устранить около 90% ограничивающих рамок.

Во-вторых, NMS выполняется отдельно для каждой категории, поэтому баллы по категориям масштабируются в соответствии с объектностью ограничивающих рамок для значимого сравнения. Если у нас есть две ограничивающие рамки с высоким перекрытием, первая имеет объектность 0,9 и вероятность 0,8 для людей (взвешенная оценка 0,72), а вторая имеет объектность 0,5 и вероятность 0,8 для людей (взвешенная оценка 0,8). 0.40) ), то первая ограничивающая рамка будет сохранена, а вторая ограничивающая рамка будет отброшена в NMS, поскольку объектность первой ограничивающей рамки делает ее более достоверной.

Почему во время обучения к «лучшим ограничивающим рамкам» следует относиться по-разному?

Представьте себе профессора со следующей стратегией преподавания: на первом задании она ищет студентов, которые хорошо справились с заданием, и усердно работает над проверкой и оценкой их заданий, чтобы они преуспели в предмете. Чтобы сосредоточиться, она не стала бы оценивать работу отстающих учеников. Вместо этого она даст им шанс преуспеть в следующем задании.

С одной стороны, мы хотим, чтобы обученная модель эффективно сходилась. Сети богаты параметрами, и над каждым параметром достаточно работы, поэтому не нужно спешить с оптимизацией всех параметров сразу. Лучше воспользоваться относительным успехом некоторых ограничивающих рамок и подталкивать их только для успешного захвата объектов этого типа.

С другой стороны, мы хотим, чтобы все ограничивающие рамки теряли объектность, потому что мы хотим, чтобы все ограничивающие рамки научились оценивать, хорошие они или плохие, потому что последующая NMS требует этого веса.

Вопросы, которые можно использовать в качестве практических интервью

Учитывая важность утраты предметности, мы думаем над вопросом:

- Если мы изменим вес объектности (self.hyp['obj']) во время обучения, должны ли мы просто перемножить показатель объектности и показатель cls во время обнаружения?

- Если да, то что произойдет, если мы установим «self.hyp['obj']=0»? При этом показатель объективности не будет контролироваться во время обучения.

- Почему потеря объектности зависит от размера изображения? Он страдает от крайнего дисбаланса между положительными и отрицательными образцами. Когда изображение увеличивается, количество объектов в нем остается прежним, поэтому дисбаланс увеличивается (усугубляется). Упущенная выгода будет компенсирована пропорционально.

исходный код потери объектности

# Objectness

# iou.detach() Градиент IOU не будет обновлен iou не является параметром обратного распространения ошибки Таким образом, нет необходимости обратного распространения информации о градиенте.

# iou.shape = [1659]

iou = iou.detach().clamp(0).type(tobj.dtype)

# прямо здесь iou Проведите еще одну оптимизацию: когда положительный образец появится в нескольких GT Ситуация такая же grid Есть два в gt (Плотные объекты схожей формы)

# There maybe several GTs match the same anchor when calculate ComputeLoss in the scene with dense targets

if self.sort_obj_iou:

# https://github.com/ultralytics/yolov5/issues/3605

# There maybe several GTs match the same anchor when calculate ComputeLoss in the scene with dense targets

j = iou.argsort()

# Если то же самое grid Появляются двое GT Затем после сортировки каждого grid в score_iou Это гарантированно будет самым большим

# (Маленькие будут покрыты Поскольку координаты одной сетки должны быть одинаковыми) то в хронологическом порядке, Последний всегда самый большой iou рассчитать loss

b, a, gj, gi, iou = b[j], a[j], gj[j], gi[j], iou[j]

# Прогнозная информация имеет доверие Однако реальная информация о кадре не имеет уровня достоверности. Поэтому нам нужно искусственно задать стандартный уровень достоверности.

# self.gr — это ты ratio [0, 1] Чем больше self.gr, тем ближе к вам уверенность. Чем меньше self.gr, тем уровень достоверности ближе к 1 (искусственное увеличение сложности обучения)

if self.gr < 1:

iou = (1.0 - self.gr) + self.gr * iou

tobj[b, a, gj, gi] = iou # iou ratioЕсли вы считаете, что это хорошо, поставьте звездочку: https://github.com/315386775/DeepLearing-Interview-Awesome-2024

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами