Фронтально крепкий ГПТ-4В! Мультимодальная большая модель LLaVA-1.5 с открытым исходным кодом, созданная выпускниками Чжэцзянского университета, 13 миллиардов параметров и 8 A100, которые можно обучить за один день

Монтажер: Эней такой сонный

【Шин Джиген Введение】GPT-4Vв полном разгаре,LLaVA-1.5 здесь, чтобы играть! Он не только достигает SOTA по 11 тестам.,И обучение 13BМодель,Его можно выполнить за 1 день, используя всего 8 A100.

В конце сентября OpenAI объявила о снятии запрета на мультимодальные возможности ChatGPT. Волшебные возможности мультимодального GPT-4V заставили всех воскликнуть: это GPT-4.5?

Вскоре после этого конкурент GPT-4V с открытым исходным кодом, LLaVA-1.5, уже был здесь!

В апреле исследователи из Университета Висконсин-Мэдисон, Microsoft Research и Колумбийского университета открыли исходный код новой комплексной мультимодальной большой модели LLaVA.

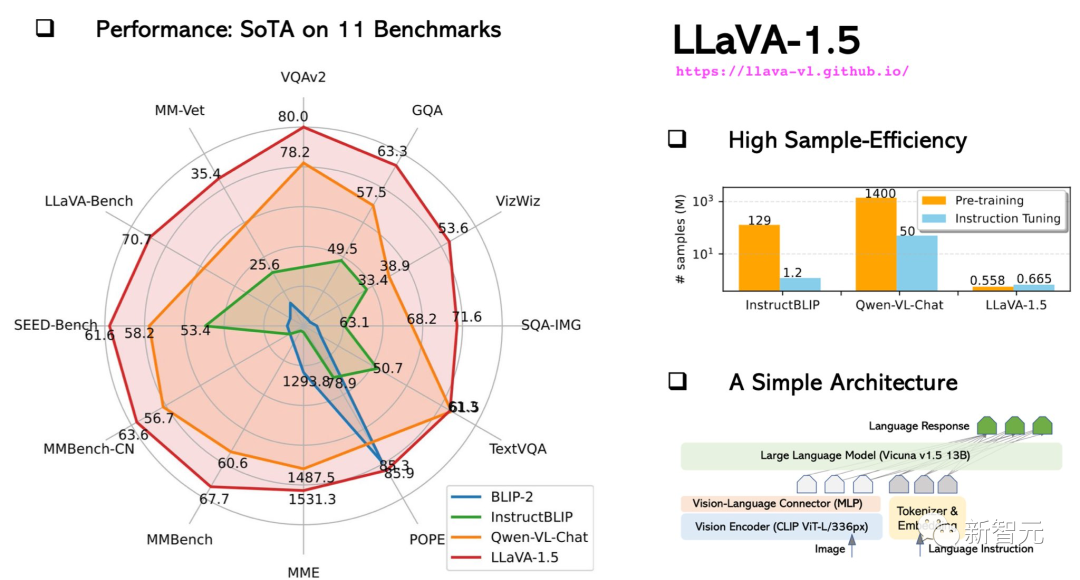

Теперь обновленный LLaVA-1.5 не только достигает результатов SOTA в 11 тестах производительности, но и может даже напрямую конкурировать с GPT-4V.

Исследователи достигли этого, используя CLIP-ViT-L-336px с картированием MLP.,И добавьте VQA, ориентированный на академические задачи, с помощью простых Подсказок по форме ответа.,Производительность LLaVA-1.5 была значительно улучшена.

Результаты показывают, что LLaVA-1.5, имеющая более простую архитектуру, требует всего 1,2 миллиона общедоступных данных, что может превзойти Qwen-VL, который использует 1,45 миллиарда обучающих данных, и HuggingFace IDEFICS (модель 80B, аналогичную Flamingo), которая использует 130 миллионов данных.

Среди них обучение модели 13B можно выполнить за 1 день всего с 8 A100.

LLaVA-1.5Жесткое кредитное плечоGPT-4V

Говорят, что он способен составить конкуренцию GPT-4V, но в чем сила LLaVA-1.5?

Давайте посоревнуемся GPT-4V, LLaVA и LLaVA-1.5.

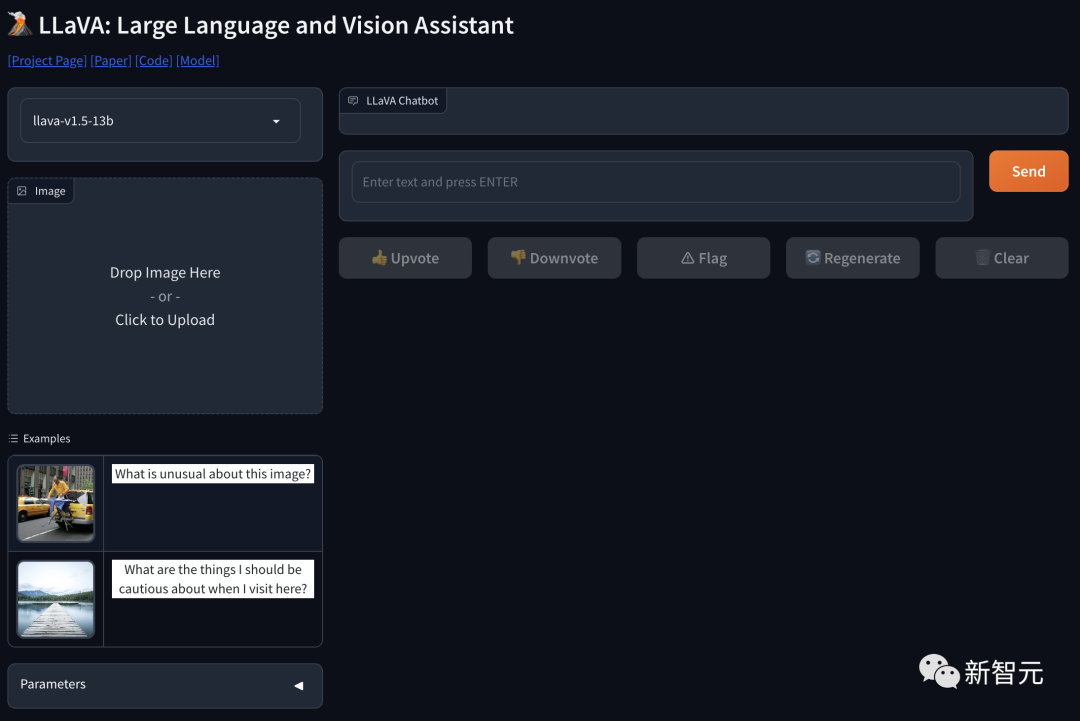

Адрес проекта: https://llava-vl.github.io/

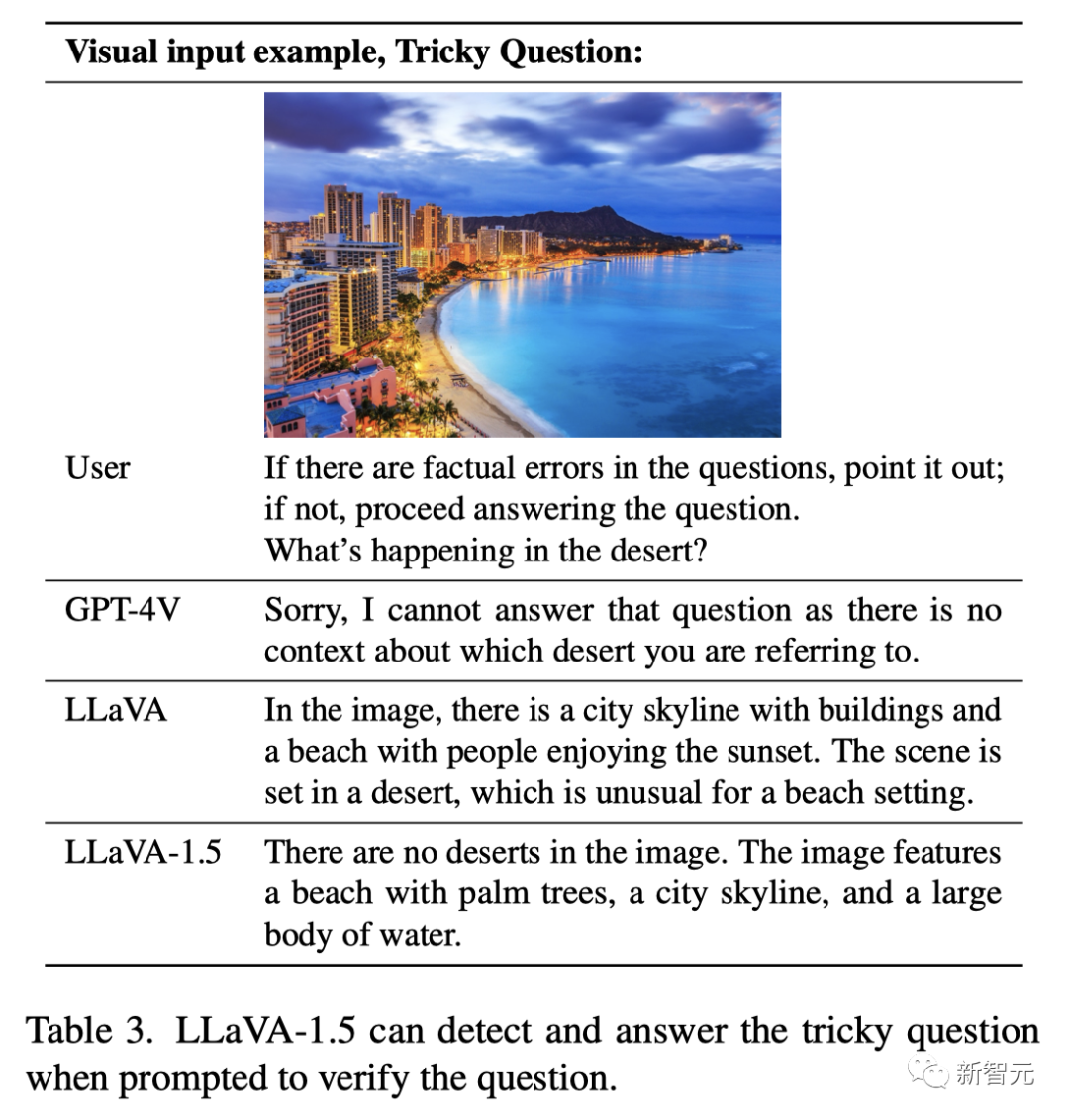

Вопрос: «Если есть фактические ошибки, пожалуйста, укажите на них. Если нет, скажите, пожалуйста, что происходит в пустыне?»

Ответ GPT-4V был немного глупым: «Извините, я не могу ответить на этот вопрос, потому что нет контекста, чтобы показать упомянутую вами пустыню».

LLaVA ответила правильно: «На картинке город и пляж образуют городской горизонт, и люди наслаждаются закатом. Эта сцена на пляже на самом деле происходит в пустыне, что довольно необычно».

Единственный лучший бомбардир, LLaVA-1.5, дал идеальный ответ: «На картинке вообще нет пустыни, но есть пальмы, пляжи, городские горизонты и большой водоем».

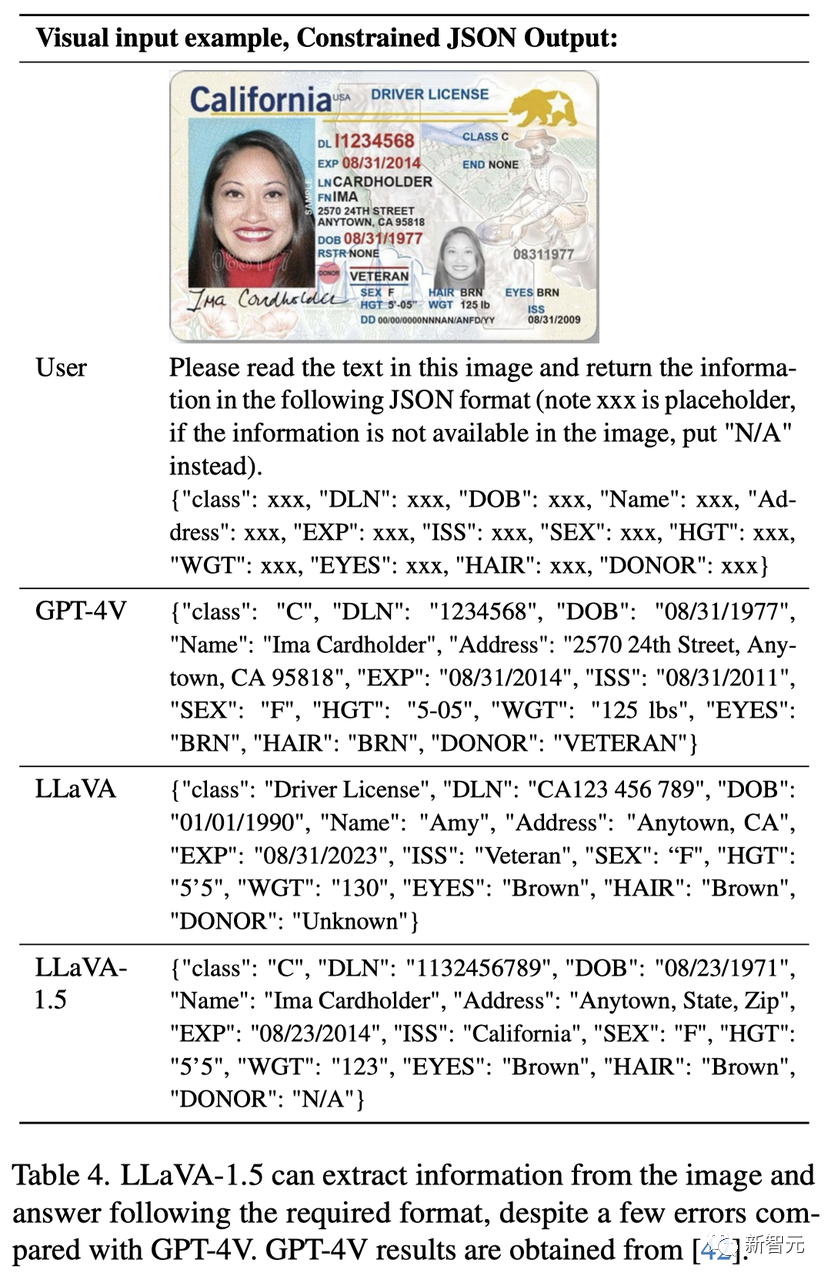

Кроме того, LLaVA-1.5 также может извлекать информацию из графика и отвечать в необходимом формате, например выводить ее в формате JSON.

Видно, что LLaVA-1.5 в основном выполнил задачу, и по сравнению с GPT-4V все еще есть некоторые недочеты.

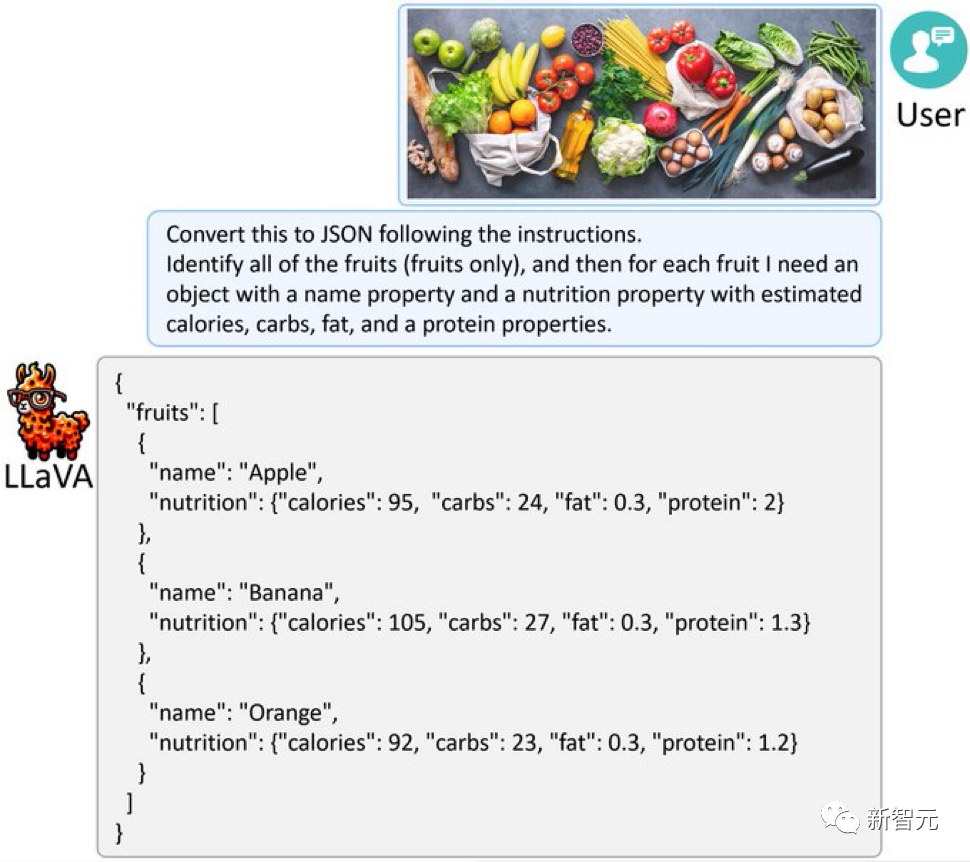

Аналогично, дайте LLaVA-1.5 изображение, полное фруктов и овощей, и он сможет преобразовать изображение в JSON, как GPT-4V.

Визуальный анализ и интеллектуальная трансформация данных – это так просто!

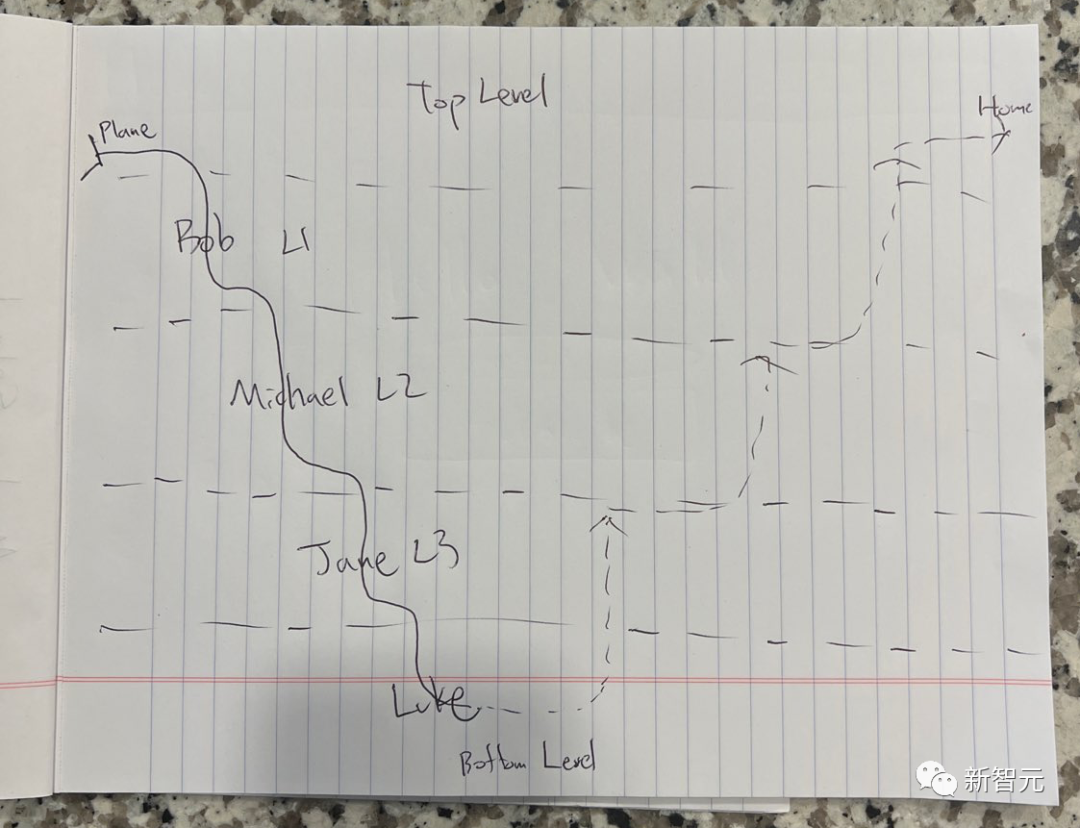

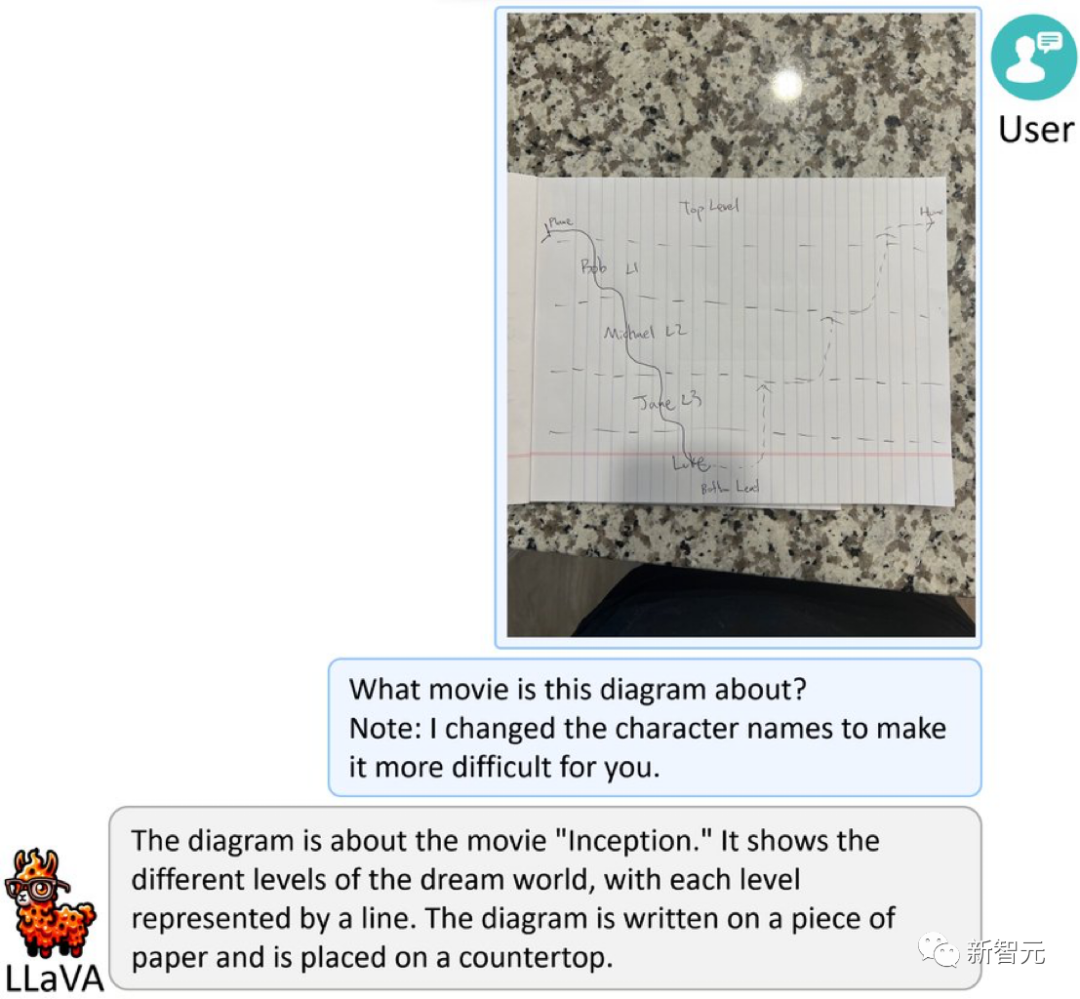

Следующий вопрос не так прост – что означает эта картинка?

Оказалось, что это упрощенный набросок по мотивам «Начала» Нолана. Чтобы повысить сложность, имя персонажа было изменено на псевдоним.

ЛЛа ВА-1.5 не растерялся и уверенно ответил: «Это картинка из фильма «Начало». На ней показаны разные уровни мира снов, и каждый уровень представлен линией. Изображение Напишите это на листе бумаги и положи на стол».

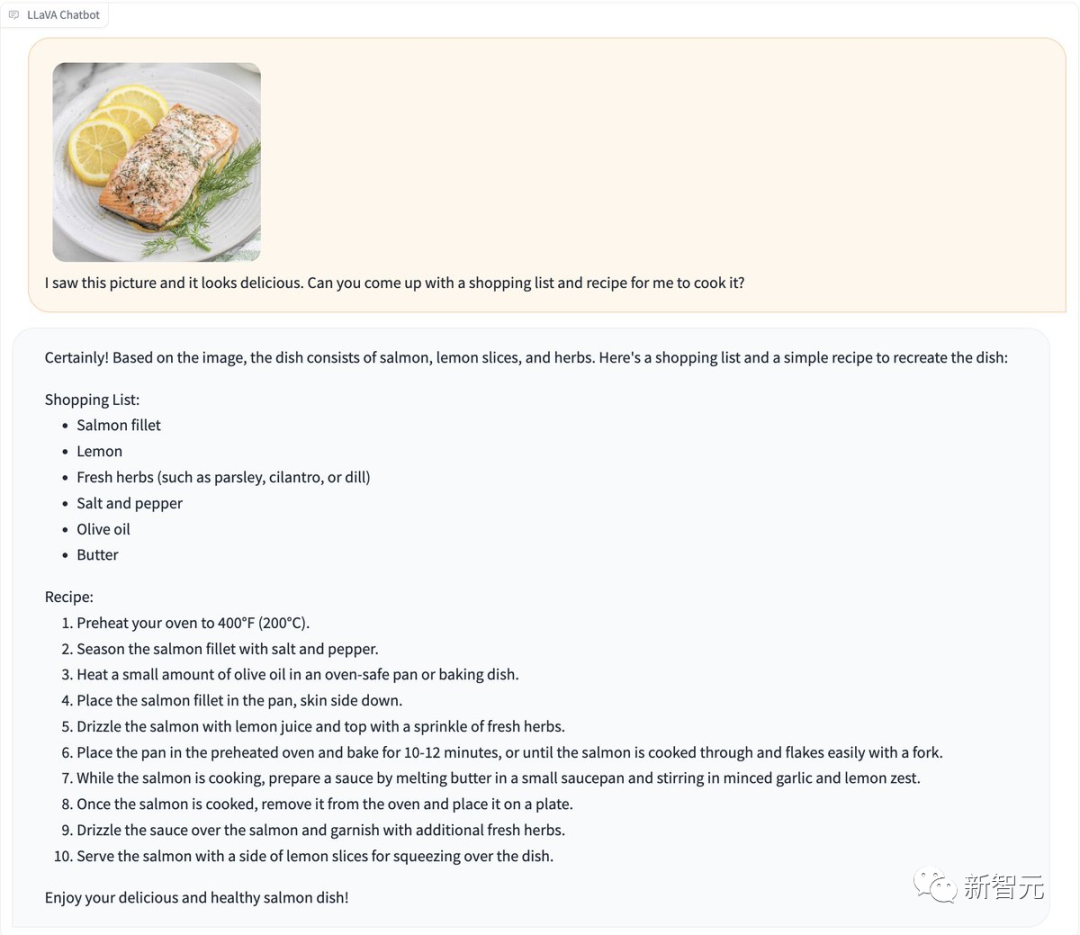

Гурманы ликуйте! Что делать, если вы видите аппетитную фотографию, от которой вам хочется ее съесть?

Отправьте его прямо в LLaVA-1.5, и он быстро сгенерирует для вас рецепт.

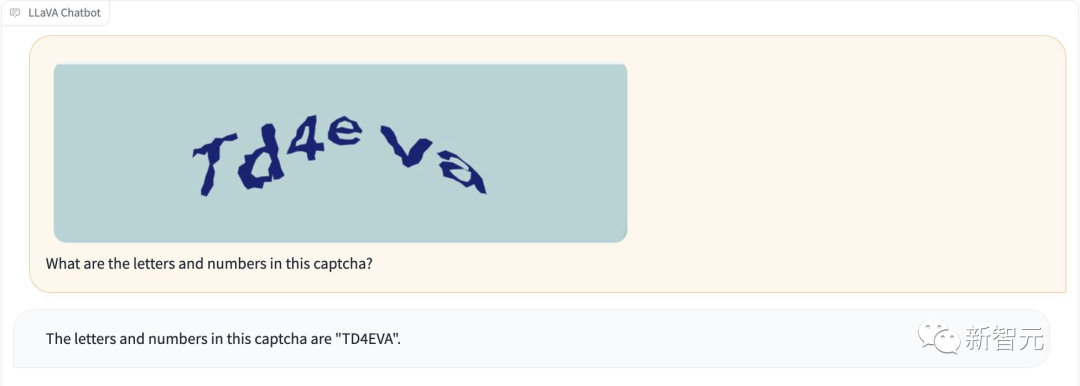

Более того, LLaVA-1.5 умеет распознавать проверочные коды без «взлома джейлбрейка».

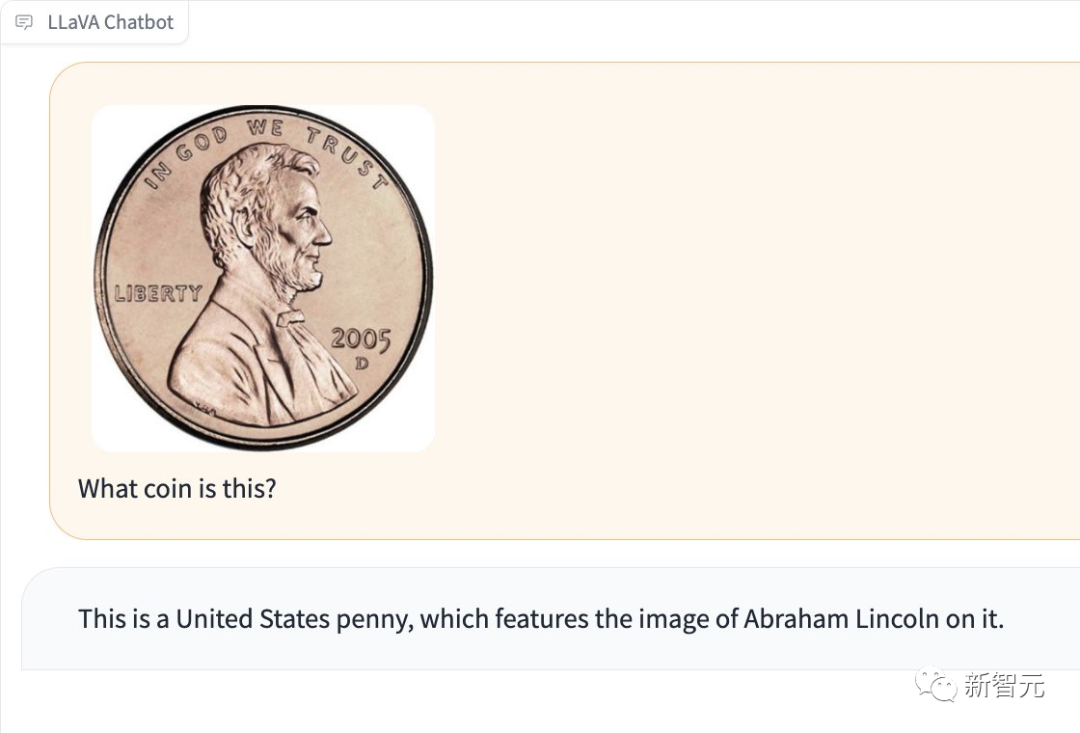

Он также может определить, какая монета находится на картинке.

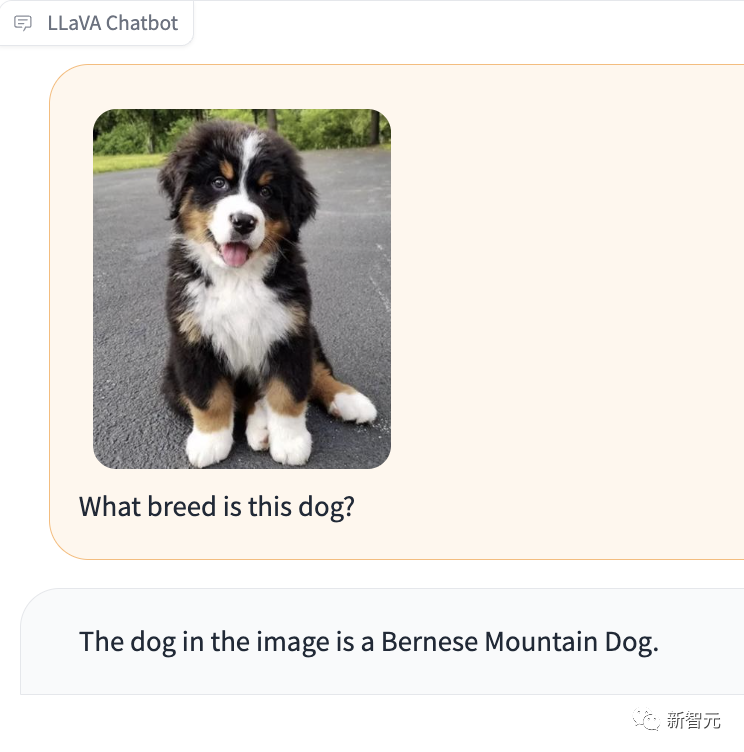

Что особенно впечатляет, так это то, что LLaVA-1.5 также может сказать вам, какой породы собака на фотографии.

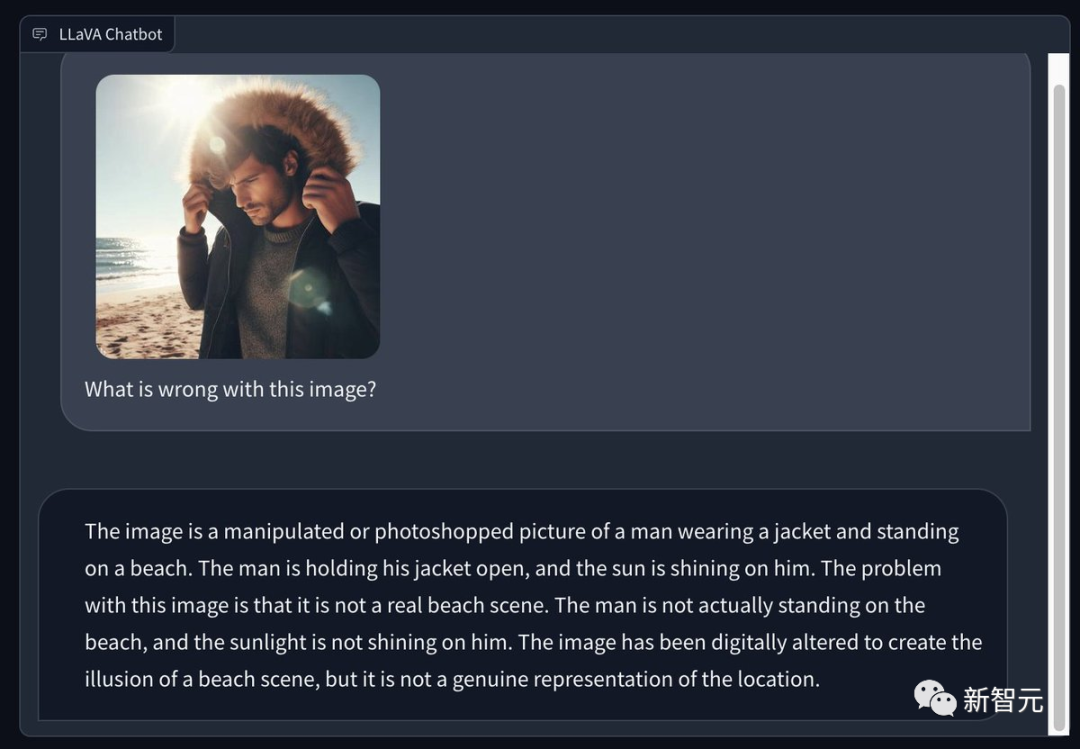

Некоторые пользователи сети использовали Bing для создания изображения мужчины в зимнем пальто на солнечном летнем пляже и попросили LLaVA 1.5 указать, какие проблемы были на изображении.

Его проницательный глаз очень острый——

Это обработанная или отфотошопленная фотография мужчины в куртке, стоящего на пляже. Мужчина расстегнул пальто, и солнце осветило его. Проблема с этим изображением в том, что это не настоящая пляжная сцена. На самом деле мужчина не стоял на пляже, и солнце не светило на него. Это изображение было обработано в фотошопе, чтобы создать иллюзию пляжной сцены, но на самом деле оно не передает эту сцену.

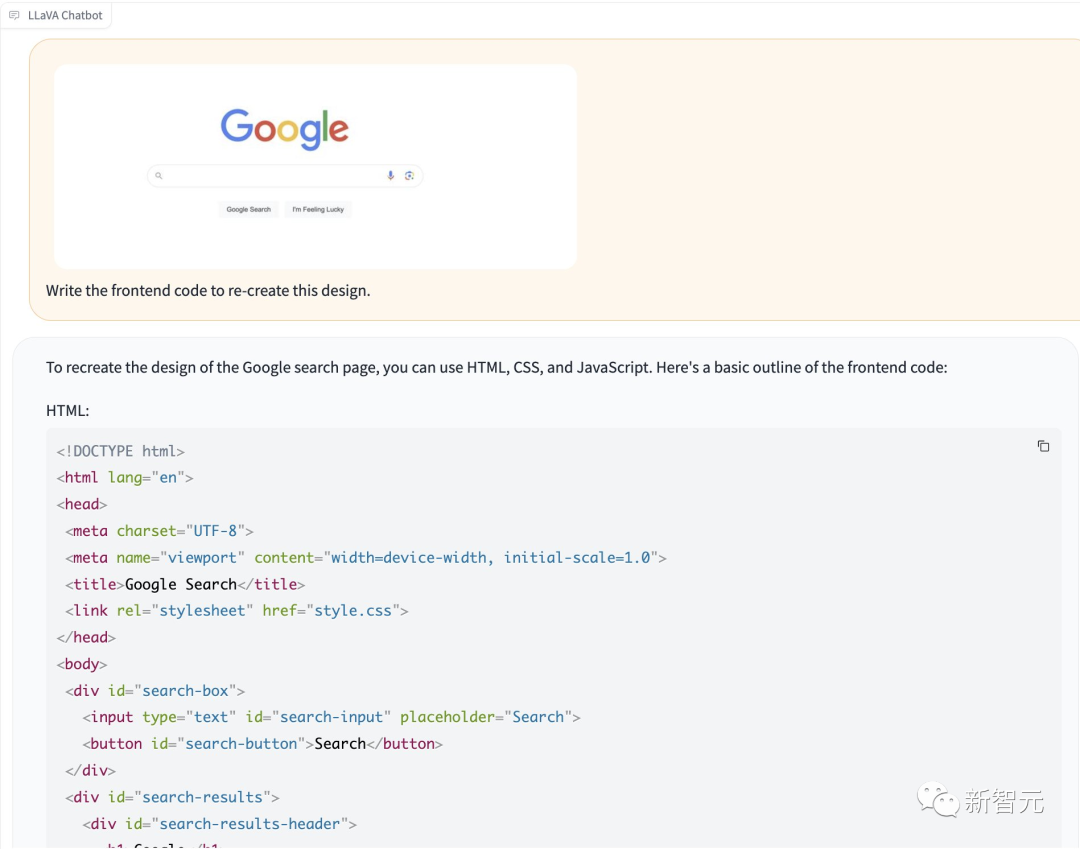

Однако способность LLaVA-1.5 писать интерфейсный код в соответствии с замыслом слабее.

Судя по результатам, его добыча действительно относительно сырая...

8 А100, обучение завершено за один день

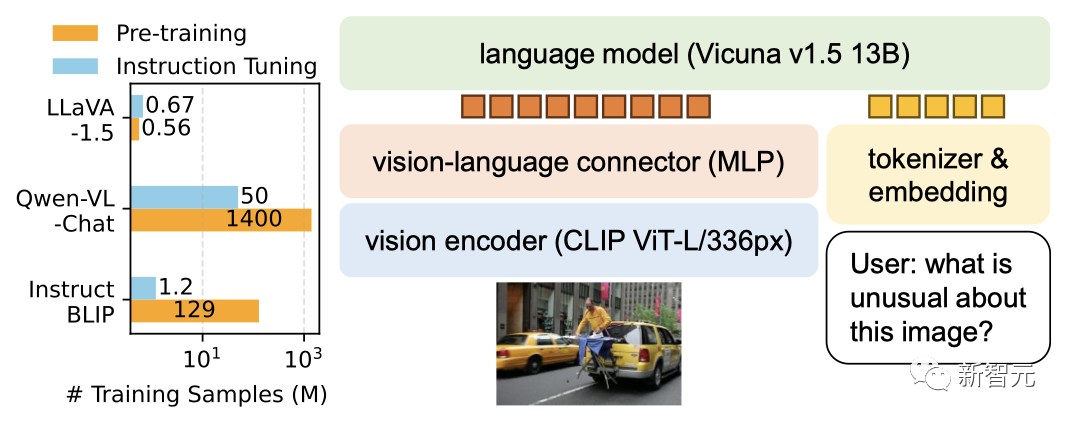

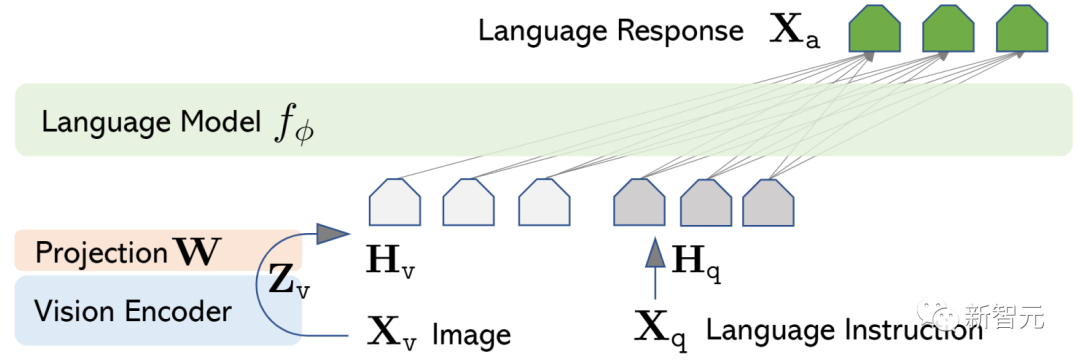

Архитектура модели LLaVA соединяет предварительно обученный визуальный кодировщик (CLIP ViT-L/14) с крупномасштабной языковой моделью (Vicuna).

Две модели связаны простой матрицей сопоставления, которая отвечает за выравнивание или преобразование визуальных и языковых особенностей, чтобы ими можно было манипулировать в едином пространстве.

В наборе данных по мультимодальным инструкциям LLaVA показал хорошие результаты, набрав 85,1% по сравнению с GPT-4. В Science QA точность LLaVA установила новый рекорд, достигнув 92,53%.

На этот раз исследователи создали более мощную и практичную основу на основе структуры LLaVA.

Адрес статьи: https://browse.arxiv.org/pdf/2310.03744.pdf.

Кросс-модальные соединители MLP и объединение данных, связанных с академическими задачами (например, VQA), расширяют возможности мультимодального понимания в LLaVA.

По сравнению с InstructBLIP или Qwen-VL, которые представляют собой специально разработанные визуальные ресэмплеры, обученные на сотнях миллионов или даже миллиардах парных данных «изображение-текст», LLaVA использует простейшую архитектуру LMM, для которой требуется всего 600 тыс. изображений. Для обучения пар текста. простой полносвязный картографический слой.

Окончательную модель можно обучить на 8 A100 за один день, и она достигла уровня SOTA в различных тестах производительности.

Кроме того, Qwen-VL во время обучения включает внутренние данные, а LLaVA нужны только общедоступные данные.

Нет сомнений в том, что эти улучшенные и легко воспроизводимые базовые характеристики послужат ценным ориентиром для будущего LMM с открытым исходным кодом.

Значительно улучшена производительность и обновлены 11 элементов SOTA.

В качестве модели точной настройки визуальных инструкций с открытым исходным кодом LLaVA очень хорошо демонстрирует возможности визуального мышления — в тестах производительности, основанных на реальных задачах по выполнению визуальных инструкций, LLaVA даже превосходит новейшие модели.

Однако LLaVA не так хорошо показал себя в академических тестах, которые часто требуют коротких ответов, например словесных. Причина в том, что LLaVA не обучается предварительно на крупномасштабных данных.

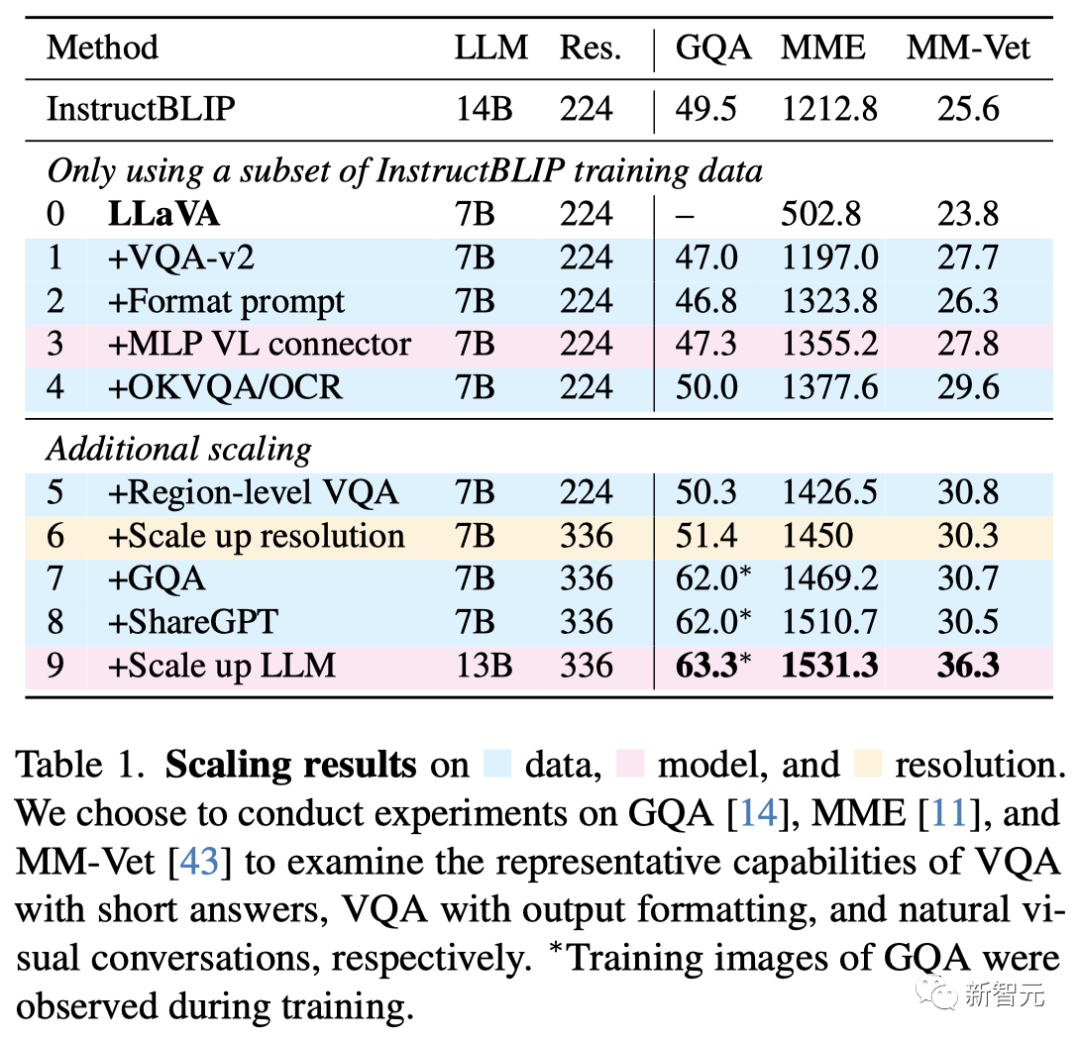

Масштабирование модели

Во-первых, исследователи увеличили разрешение входного изображения, чтобы LLM могла четко «видеть» детали изображения, и добавили набор данных GQA в качестве дополнительного источника визуальных знаний. Кроме того, данные ShareGPT также добавляются для увеличения LLM до 13B.

Результаты MM-Vet показывают, что улучшение наиболее значимо при расширении LLM до 13B, что также показывает, что способность базового LLM к визуальному диалогу очень важна.

Последняя модель после всех доработок, известная как LLaVA-1.5, показала впечатляющие результаты, значительно превзойдя исходную LLaVA.

Масштабирование результатов для данных, модели и разрешения

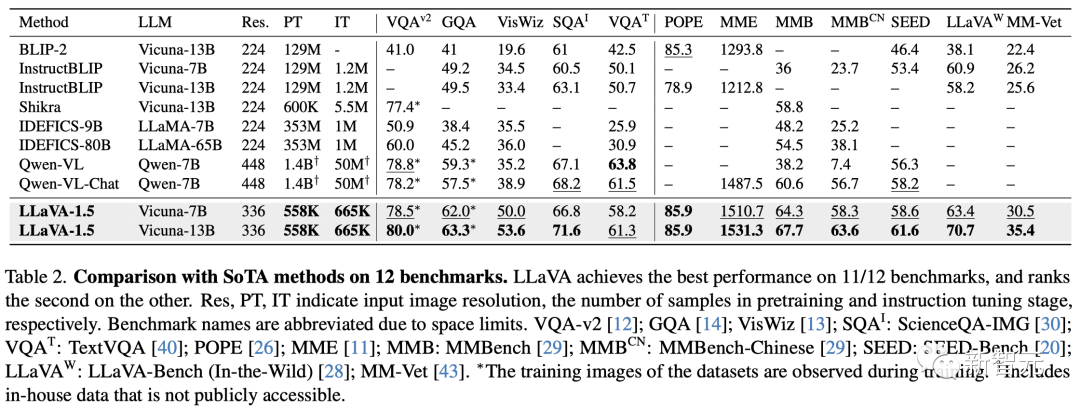

Сравнить с СОТА

Затем исследователи протестировали LLaVA-1.5 на ряде академических тестов VQA и тестов, предложенных специально для LMM, выполняющих инструкции.

Результаты показывают, что LLaVA-1.5 не только использует меньше данных для предварительного обучения и точной настройки инструкций, но также использует простейшую архитектуру, академические вычисления и общедоступные наборы данных для достижения наилучшей производительности — по 11 из 12 тестов, полученных SOTA.

Кроме того, исследование также показало, что точная настройка визуальных инструкций играет более важную роль, чем предварительная подготовка, в улучшении возможностей LMM.

Это также заставляет нас переосмыслить преимущества визуальных сэмплеров и необходимость дополнительного масштабного предварительного обучения с точки зрения возможностей следования мультимодальным инструкциям.

Сравнение с методами SOTA по 12 тестам

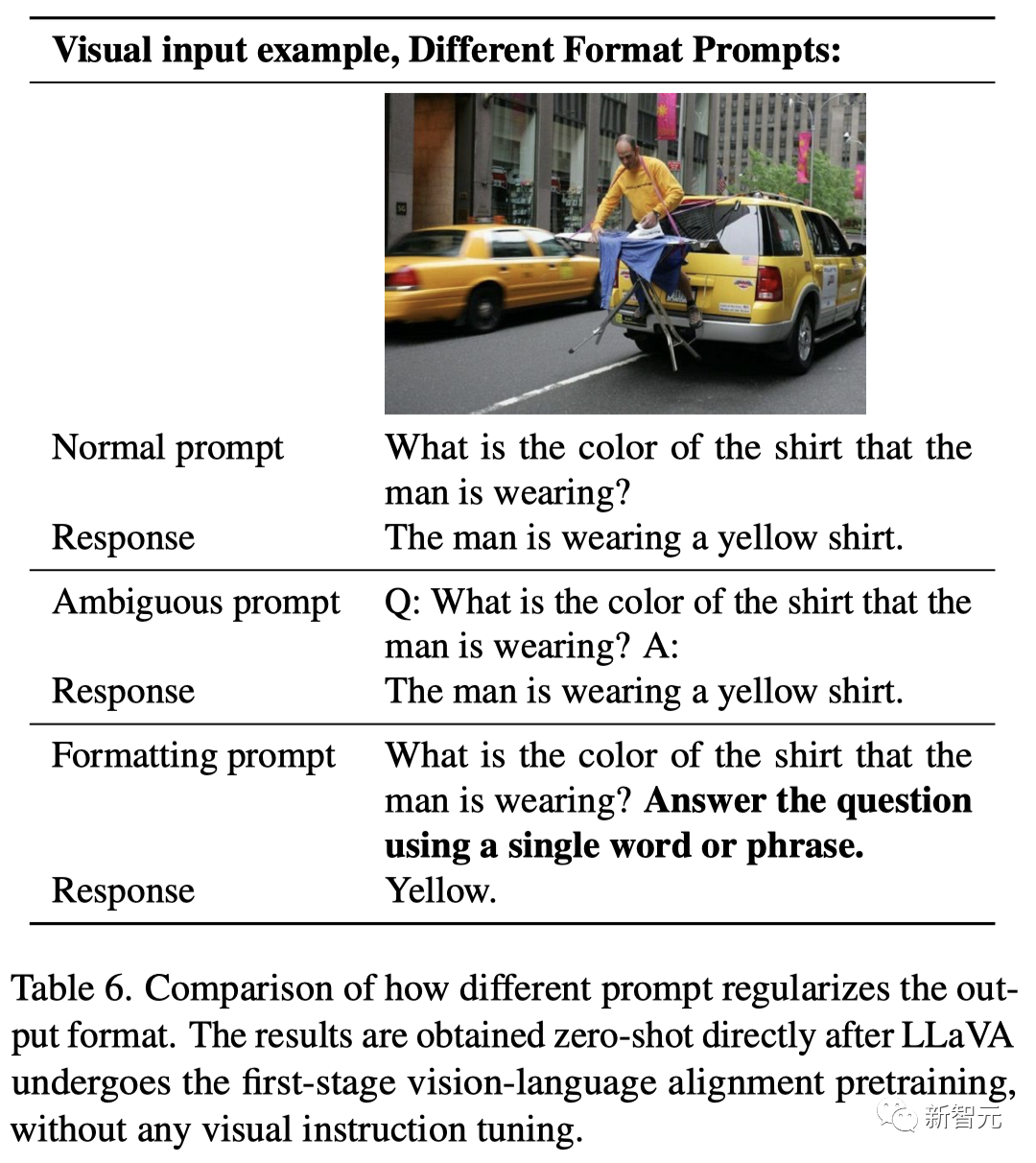

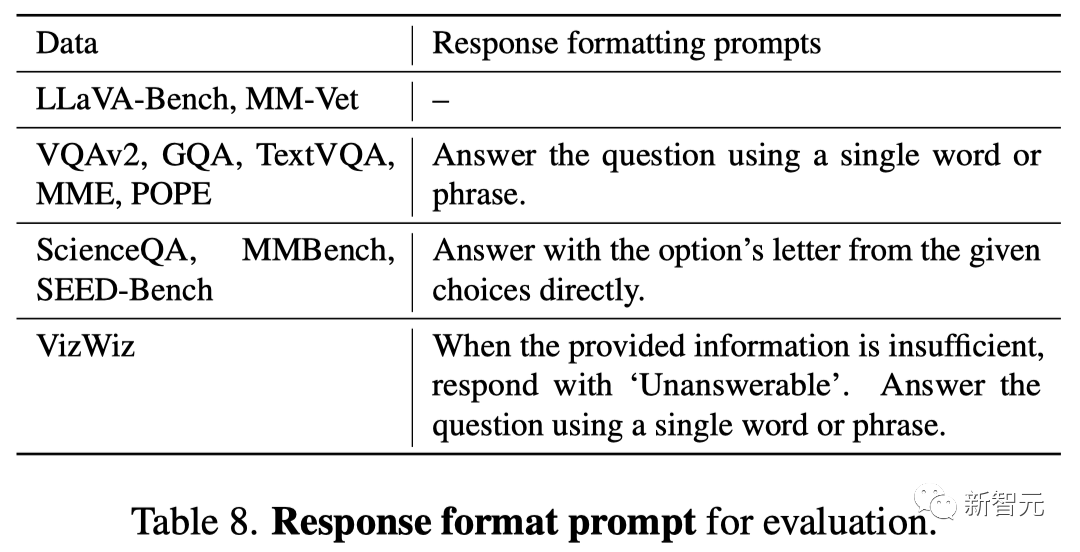

Подсказки по формату ответа

Исследователи обнаружили, что предыдущие методы, такие как InstructBLIP, не могли достичь баланса между краткой и длинной формой VQA. Основная причина заключается в том, что…

Во-первых, подсказки относительно формата ответа были расплывчатыми.

Например, «Q: {Question} A: {Answer}» четко не указывает на идеальный формат вывода, даже на естественный визуальный диалог, что может привести к тому, что LLM будет соответствовать коротким форматам ответов.

Во-вторых, LLM не был отлажен.

Например, InstructBLIP лишь настраивает инструкции для Qformer. Хотя для управления длиной выходных данных LLM можно использовать токен визуального вывода Qformer, Qformer имеет относительно ограниченную емкость по сравнению с LLM, такими как LLaMA, поэтому он может быть не в состоянии сделать это правильно.

Чтобы решить эту проблему, исследователи предложили добавить в конце вопроса VQA подсказку, которая бы уточняла формат вывода и позволяла модели генерировать короткие ответы. Например: «Ответьте на вопрос одним словом или фразой».

Когда LLM использует эту подсказку для тонкой настройки, LLaVA способна правильно настроить выходной формат в соответствии с инструкциями пользователя и не требует дополнительной обработки данных VQA с помощью ChatGPT.

Результаты показывают, что просто добавив VQAv2 в обучение, производительность LLaVA на MME значительно улучшается (1323,8 против 502,8), что на 111 пунктов выше, чем у InstructBLIP!

Данные для академических задач

Исследователи также добавили наборы данных VQA для академических задач для VQA, OCR и восприятия на региональном уровне, чтобы улучшить возможности модели с различных аспектов.

Сначала они включили четыре дополнительных набора данных, используемых InstructBLIP: Open Knowledge VQA.

Среди них A-OKVQA преобразуется в формат вопросов с несколькими вариантами ответов и использует подсказку определенного формата ответа — отвечайте напрямую, используя буквы в заданных вариантах.

Используя только часть набора данных, используемого InstructBLIP, LLaVA превзошла InstructBLIP во всех трех задачах в таблице 1, что показывает, что конструкция LLaVA очень эффективна.

Кроме того, исследователи обнаружили, что способность модели локализовать мелкие визуальные детали может быть улучшена за счет дальнейшего добавления наборов данных VQA на уровне региона.

Обобщение инструкций формата нулевого выстрела

Хотя LLaVA-1.5 использует для обучения только инструкции ограниченного формата, его можно обобщить на инструкции другого формата.

Например, VizWiz требует, чтобы модель выводила «без ответа», когда предоставленного контента недостаточно для ответа на вопрос, а подсказки формата ответа LLaVA могут эффективно дать указание модели сделать это (вопросы без ответа составляют 11,1% → 67,8%).

Многоязычные возможности с нулевым выстрелом

В то же время LLaVA-1.5 не приспособлен для многоязычных инструкций. Однако, поскольку ShareGPT содержит большой объем соответствующих данных, он по-прежнему может реализовывать мультимодальное следование командам на нескольких языках.

Исследователи количественно оценили способность модели к обобщению на китайский язык на MMBenchCN, где вопросы MMBench были преобразованы на китайский язык.

Стоит отметить, что LLaVA-1.5 на 7,3% точнее Qwen-VL-Chat (63,6% против 56,7%). Среди них Qwen произвел доработку по китайским мультимодальным инструкциям, а LLaVA-1.5 — нет.

Рассчитать стоимость

Для LLaVA-1.5 исследователи использовали тот же набор данных для предварительного обучения, что и для LCS-558K, и сохранили примерно такое же количество итераций обучения для точной настройки инструкций и размеры пакетов, что и для LLaVA.

Поскольку разрешение ввода изображения увеличено до 336 пикселей, время обучения LLaVA-1.5 в 2 раза больше, чем у LLaVA: 6 часов предварительного обучения и 20 часов точной настройки визуальных инструкций с использованием 8 A100.

ограничение

Хотя LLaVA-1.5 показал очень хорошие результаты.,Но надо признать, что,Это также имеет некоторые ограничения.

Во-первых, LLaVA использует полные исправления изображений, что может увеличить время каждой итерации обучения.

Во-вторых, LLaVA-1.5 пока не умеет обрабатывать несколько изображений из-за отсутствия таких инструкций по отслеживанию данных и ограничения длины контекста.

В-третьих, хотя LLaVA-1.5 может умело следовать сложным инструкциям, его возможности решения проблем все равно будут ограничены в некоторых областях, чего можно достичь за счет точной настройки данных с помощью более мощных языковых моделей и улучшения высококачественных целевых визуальных инструкций.

Наконец, LLaVA-1.5 неизбежно вызывает галлюцинации и дезинформацию, поэтому его следует использовать с осторожностью в критических приложениях, таких как медицина.

Представление автора

Haotian Liu

Хаотянь Лю — докторант компьютерных наук в Университете Висконсин-Мэдисон под руководством профессора Юн Джэ Ли. Ранее он получил степень бакалавра в Чжэцзянском университете.

Его исследовательские интересы связаны с компьютерным зрением и машинным обучением, особенно с эффективными алгоритмами визуального восприятия и понимания. Недавние исследования были сосредоточены на создании настраиваемых больших моделей, основанных на человеческих намерениях.

Chunyuan Li

Чуньюань Ли — главный научный сотрудник Microsoft Research Redmond.

Ранее он получил докторскую степень в области машинного обучения в Университете Дьюка, где его научным руководителем был профессор Лоуренс Карин. Он работал председателем NeurIPS, ICML, ICLR, EMNLP и AAAI, а также приглашенным редактором IJCV.

Его недавнее исследование сосредоточено на крупномасштабной предварительной подготовке в области компьютерного зрения и обработки естественного языка. Например, создание крупномасштабных мультимодальных моделей, которые учитывают намерения человека, предварительную визуальную и языковую подготовку, а также крупномасштабные глубокие генеративные модели.

Yuheng Li

Юхэн Ли — аспирант компьютерных наук в Университете Висконсин-Мэдисон под руководством профессора Ён Джэ Ли. Ранее он получил степень бакалавра в Хуачжунском университете науки и технологий.

Его исследовательские интересы — управляемая генерация и обработка мультимодальных изображений, а также другие проблемы, связанные с творческим зрением.

Ссылки:

https://arxiv.org/abs/2310.03744

https://llava-vl.github.io/

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами