Эффект замечательный! Практическая реализация архитектуры чистого трансформатора для прогнозирования цен на электроэнергию

Прогнозирование цен на электроэнергию играет жизненно важную роль в современных энергосистемах. Технология прогнозирования цен на электроэнергию (EPF) за последние годы достигла значительного прогресса, при этом ведущую роль играют последние разработки в области машинного обучения и искусственного интеллекта. Но в области прогнозирования цен на электроэнергию (EPF) воспроизводимость всегда была серьезной проблемой. Во многих исследованиях использовались уникальные и закрытые наборы данных, а их методы проверялись на слишком коротких и ограниченных выборках рынка, что затрудняло оценку эффективности новых алгоритмов прогнозирования.

недавно,Иностранный исследователь опубликовал на arxiv новую статью: бумага,предложилНовый метод прогнозирования цен на электроэнергию (EPF) на основе чистой модели трансформатора。В отличие от других методов,Этот метод не объединяет рекуррентные нейронные сети с механизмами внимания.,Это демонстрирует, что одного уровня внимания достаточно, чтобы уловить временные закономерности. В статье также было проведено справедливое сравнение Модели с использованием набора инструментов EPF с открытым исходным кодом.,и предоставляет код для повышения воспроизводимости и прозрачности исследований EPF. Результаты экспериментов показывают,Модель трансформатора превосходит традиционные методы,Предоставление перспективных решений для надежной и устойчивой работы энергосистемы.

Название статьи:A Transformer approach for Electricity Price Forecasting

Бумажный адрес:https://arxiv.org/abs/2403.16108

Исходный код бумаги:https://github.com/osllogon/epf-transformers

модельный подход

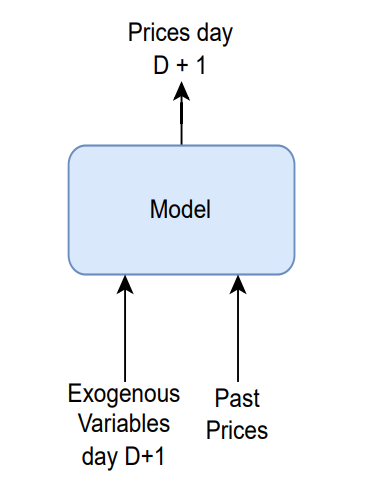

Целью Прогноза цен на электроэнергию (EPF), предложенного автором, может быть Подвести итогдля:На основе экзогенных переменных в день D+1, прошлых цен и экзогенных переменных спрогнозируйте цену на электроэнергию в течение 24 часов в день D+1.

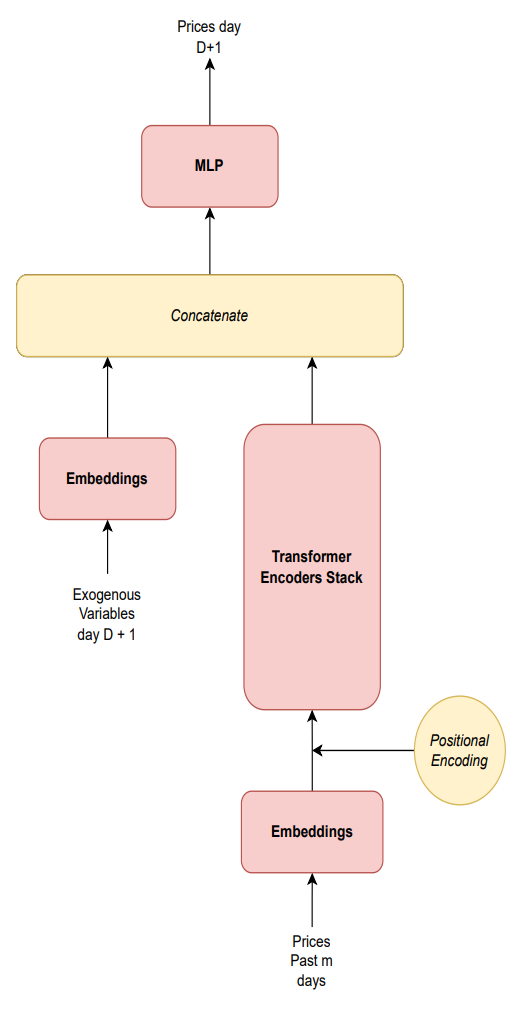

Рис. 1. Структура моделирования, предложенная автором

Эта модель прогнозирования цен на электроэнергию представляет собой чистую модель Transformer, особенно похожую на кодировщик Transformer в BERT или ViT. Благодаря этой структуре Transformer может улавливать временные закономерности и больше фокусироваться на долгосрочных тенденциях при составлении прогнозов, что имеет преимущества перед другими временными моделями, такими как LSTM. В области обработки естественного языка было доказано, что Transformer не забывает предыдущую информацию при обработке длинных последовательностей.

Автор считает, что мы должны установить прямую связь между экзогенными переменными и ценами и позволить модели Трансформер отвечать за динамику цен. Поэтому в качестве исторической информации в модель включены только прошлые цены.

Модель будет иметь два входа: Нет.

значение экзогенной переменной дня и прошлого

Цена за сутки. Общая структура показана на рисунке 1. Тогда диапазон, используемый для прошлых цен, будет равен

, включая эти два дня. этот

День будет гиперпараметром модели, называемым длиной последовательности, который необходимо оптимизировать.

Рисунок 2. Структура модели.

Основная архитектура модели содержит два основных потока данных, по одному для каждого входа. Результаты каждого потока затем объединяются и используются в качестве входных данных для многомерного многослойного перцептрона (MLP) для прогнозирования цены следующего дня.

Давайте поговорим об архитектуре этой модели подробнее.

С одной стороны, поток обработки экзогенных переменных в день D+1 завершается через уровень внедрения. С другой стороны, прежде всего

Прошлые цены вводятся на уровень внедрения. Затем выходные данные объединяются с позиционным кодированием, и результат передается в набор кодеров Transformer для учета временной динамики.

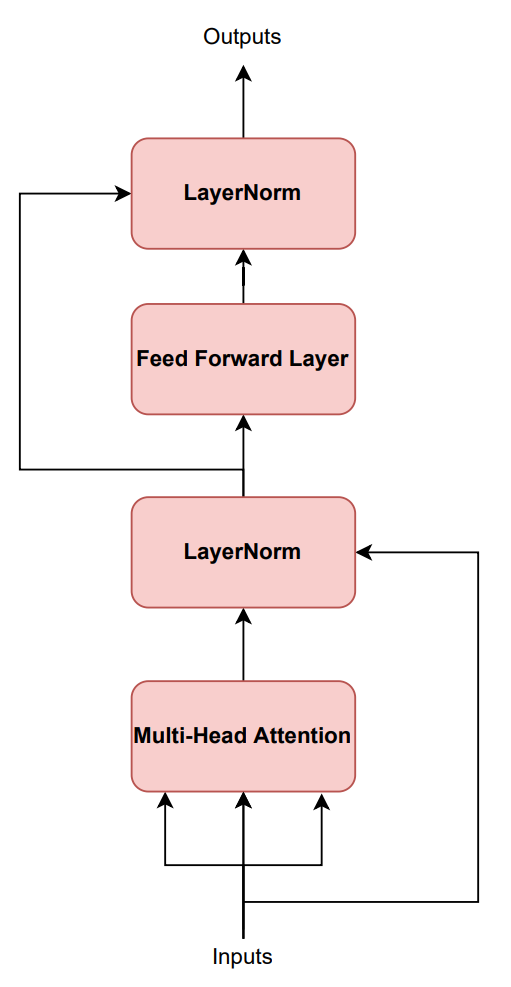

Рисунок 3. Структура преобразовательного энкодера.

Структура кодера Transformer показана на рисунке 3. Входные размеры первого кодера в стеке:

(где n — гиперпараметр выходной размерности слоя внедрения), а входные размерности остальных кодеров равны

, это связано с существованием слоя прямой связи. Выходные размеры стека Transformer:

, где h — скрытый размер слоя прямой связи. Наконец, только это

Последний элемент выходной последовательности дня объединяется с выходными данными потока экзогенных переменных для получения окончательного прогноза.

Как упоминалось ранее, выходные данные двух разных потоков будут объединены и переданы в многослойный перцептрон (MLP), входная размерность которого равна

. Выходом многослойного перцептрона будет

Окончательный прогноз 24-часовой цены за день (т. е. 24-мерный выходной слой).

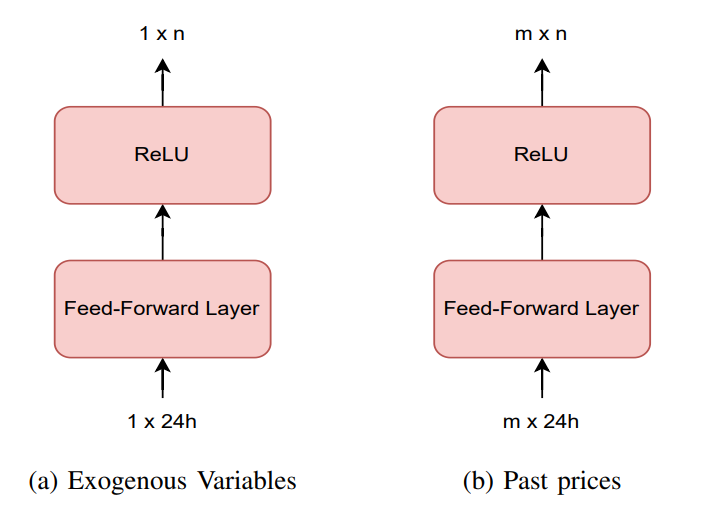

Два слоя внедрения, определенные для предварительной обработки входных данных, представляют собой отображение данных в пространство более высокой размерности, включая уровень прямой связи и функцию активации ReLU. Эти слои преобразуют ежедневные 24-значные векторы в векторы более высокого порядка, как показано на рисунке 4 ниже.

Рис. 4. Слой внедрения

Таким образом, модель в основном содержит четыре структуры: два типа слоев внедрения, набор кодеров-трансформеров и многослойный перцептрон для окончательного прогнозирования.

Экспериментальный эффект

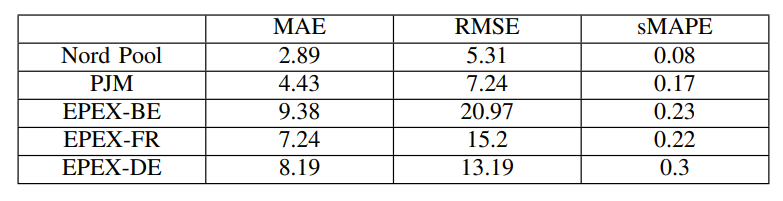

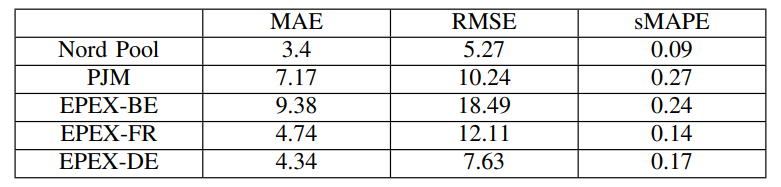

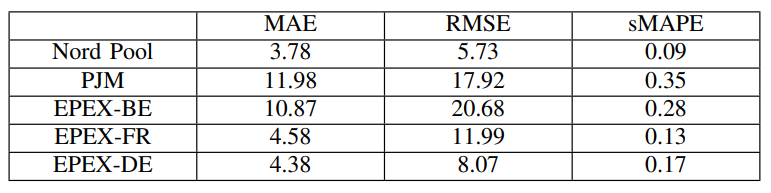

В таблицах 1, 2 и 3 показаны результаты собственной модели Naive, DNN, перенормированной с использованием всех прошлых данных, и модели DNN, перенормированной с использованием только прошлогодних данных соответственно. Можно заметить, что в некоторых случаях модель DNN дает лучшие результаты, а в других случаях модель Naive работает лучше, чем ансамбль DNN. Это может быть связано с тем, что модели DNN необходимо делать долгосрочные тестовые прогнозы без повторного обучения.

Таблица 1. Результаты тестирования наивной модели

Таблица 2. Результаты тестирования ансамблевой модели DNN, перенормированные с использованием всех прошлых значений

Таблица 3. Результаты тестирования ансамблевой модели DNN, перенормированные с использованием прошлогодних значений

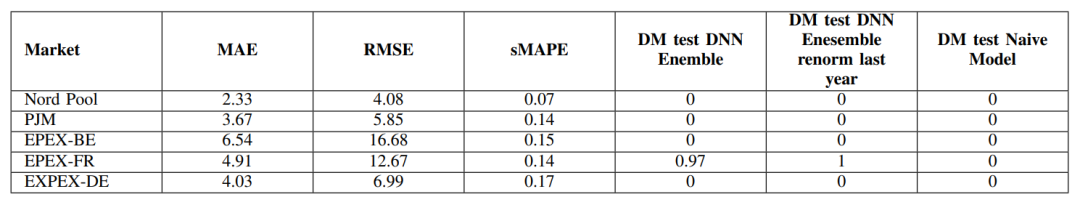

Результат предложенной модели трансформатора в виде таблицы показано 4. также,Авторы также представляют результаты теста DM в сравнении с другими тестами Модель. В четырех из пяти эпизодов данных,TransformerМодель Результаты значительно лучше, чемForecasting day-ahead electricity prices: A review of state-of-the-art algorithms, best practices and an open-access benchmarkцелое предложение Модель(DMТестовое значение ниже, чем0.05)。в то же время,во всех выпусках данных,Результаты Трансформаторной модели также значительно лучше, чем у Наивной модели. Эти результаты демонстрируют эффективность добавления Transformer Архитектура к временным рядам цен.

Таблица 4. Результаты испытаний модели трансформатора и значение DM p.

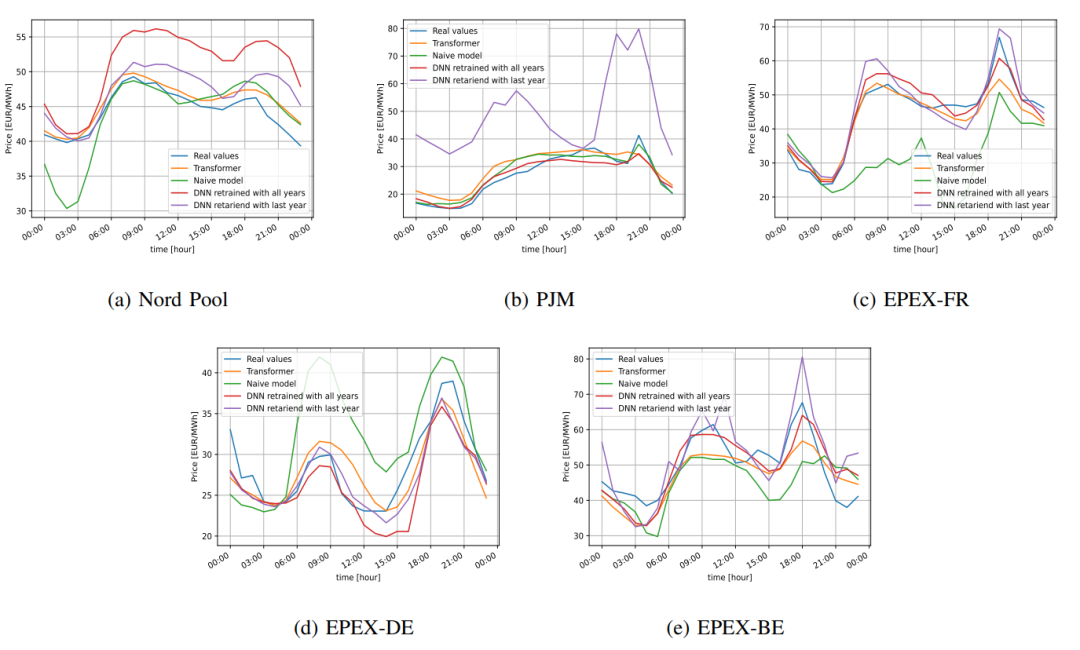

На рисунке 4 показан пример ежедневных прогнозов для каждого набора данных. Можно заметить, что модель, предложенная авторами, более последовательна, чем другие модели, предсказывая точные прогнозы в каждом примере, даже если в некоторых случаях это не лучший прогноз.

Рисунок 5 Пример прогноза на определенный день

Подвести итог

Хотя Трансформер используется в предсказаниях в других областях.,Однако убедительных данных о его эффективности по сравнению с другими методами прогнозирования цен на электроэнергию недостаточно. В этой статье предлагается модель прогнозирования на основе трансформатора.,и вбумагаForecasting day-ahead electricity prices: A review of state-of-the-art algorithms, best practices and an open-access benchmark Предложенная структура была протестирована. Результаты показывают, что модель в большинстве случаев демонстрирует значительные преимущества и достигает самых современных результатов на четырех из пяти наборов данных. Видно, что архитектура Transformer может обеспечить хорошие результаты прогнозирования цен на электроэнергию.

Что касается будущей работы, есть несколько направлений исследований, которые стоит продолжать изучать. Например, авторы упомянутой выше статьи утверждают, что LSTM может быть более точным, чем DNN, но доказательств недостаточно. Возможным будущим исследованием будет сравнение LSTM и Transformer. Следует отметить, что предложенная в данной статье модель не является ансамблевой. Ансамблевые модели Transformer могут работать лучше, но это выходит за рамки данной статьи и заслуживает изучения в смежной области. Еще одна будущая работа будет заключаться в изучении того, как одновременно учитывать прошлые значения экзогенных переменных в архитектуре Transformer.

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами