Добавляя комплексные аудиовизуальные возможности к большим языковым моделям, Академия DAMO открывает исходный код Video-LLaMA.

Колонна «Машинное сердце»

Редакция «Машинное сердце»

Видео играет все более важную роль в современных социальных сетях, а интернет-культура Douyin, Kuaishou, Bilibili и т. д. стали популярными платформами для сотен миллионов пользователей. Пользователи делятся своими жизненными моментами, творческими работами, интересными моментами и другим контентом вокруг видео, чтобы взаимодействовать и общаться с другими.

В последнее время большие языковые модели продемонстрировали впечатляющие возможности. Можем ли мы оснастить большие модели «глазами» и «ушами», чтобы они могли понимать видео и взаимодействовать с пользователями?

Исходя из этой проблемы, исследователи Академии ДАМО предложили Видео-LLaMA — большую модель с комплексными аудиовизуальными возможностями. Video-LLaMA может воспринимать и понимать видео- и аудиосигналы в видеороликах, а также понимать инструкции ввода пользователя для выполнения ряда сложных задач на основе аудио и видео, таких как описание аудио/видео, письмо, вопросы и ответы и т. д. В настоящее время документы, коды и интерактивные демонстрации открыты. Кроме того, на домашней странице проекта Video-LLaMA исследовательская группа также предоставляет китайскую версию модели, чтобы сделать работу китайских пользователей более удобной.

- Ссылка на документ: https://arxiv.org/abs/2306.02858.

- Адрес кода: https://github.com/DAMO-NLP-SG/Video-LLaMA

- Демо-адрес:

- Modelscope: https://modelscope.cn/studios/damo/video-llama/summary

- Huggingface: https://huggingface.co/spaces/DAMO-NLP-SG/Video-LLaMA

- Пример адреса входного файла:

- https://github.com/DAMO-NLP-SG/Video-LLaMA/tree/main/examples

Дизайн модели

Video-LLaMA использует принципы модульного дизайна для сопоставления визуальной и аудиомодальной информации в видео с входным пространством большой языковой модели, чтобы обеспечить возможность следовать кросс-модальным инструкциям. В отличие от предыдущих крупных модельных исследований (MiNIGPT4, LLaVA), которые были сосредоточены на понимании статических изображений, Video-LLaMA сталкивается с двумя проблемами в понимании видео: захват динамических изменений сцены в зрении и интеграция аудиовизуальных сигналов.

Чтобы фиксировать динамические изменения сцены в видео, Video-LLaMA представляет подключаемую ветвь визуального языка. Эта ветвь сначала использует предварительно обученный кодер изображения в BLIP-2 для получения отдельных характеристик каждого кадра изображения, а затем объединяет их с соответствующим внедрением позиции кадра. Все функции изображения отправляются в Video Q-Former и Video Q. -Former будет агрегировать представления изображений на уровне кадров и генерировать синтетические видеопредставления фиксированной длины. Наконец, линейный слой используется для выравнивания представления видео с пространством внедрения большой языковой модели.

Что касается звуковых сигналов в видео, то Видео-LLaMA для обработки использует аудиоязыковую ветвь. Сначала из исходного видео равномерно выбираются несколько двухсекундных аудиоклипов, и каждый клип преобразуется в 128-мерную мел-спектрограмму. Затем мощный ImageBind используется в качестве аудиокодера для индивидуального извлечения особенностей каждого звукового клипа. После добавления обучаемых позиционных вложений Audio Q-Former объединяет функции сегмента в целом и генерирует аудио функции фиксированной длины. Как и в случае с ветвью визуального языка, в конечном итоге используется линейный уровень для согласования звукового представления с пространством внедрения большой языковой модели.

Чтобы снизить затраты на обучение, Video-LLaMA замораживает предварительно обученный кодер изображения/аудио и обновляет только следующие параметры в визуальной и аудиоветвях: Q-Former видео/аудио, уровень кодирования положения и линейный слой (как показано на рисунке). 1 шоу).

Чтобы изучить взаимосвязь между изображением и текстом, авторы сначала предварительно обучают ветвь зрения, используя крупномасштабный набор видеотекстовых данных (WebVid-2M) и набор данных изображения и текста (CC-595K). После этого авторы использовали наборы данных команд изображения из MiniGPT-4, LLaVA и наборы данных видеокоманд из Video-Chat для точной настройки и достижения лучших возможностей отслеживания кросс-модальных команд.

Что касается изучения отношений выравнивания аудио-текста, из-за отсутствия крупномасштабных высококачественных аудио-текстовых данных авторы приняли обходную стратегию для достижения этой цели. Во-первых, цель изучаемых параметров в аудиолингвистической ветви можно понимать как согласование вывода аудиокодера с пространством внедрения LLM. Аудиокодер ImageBind обладает очень мощной возможностью мультимодального выравнивания, которая может выравнивать вложения различных модальностей в общее пространство. Таким образом, авторы используют данные визуального текста для обучения ветви аудиоязыка, выравнивая общее пространство встраивания ImageBind с пространством встраивания текста LLM, тем самым достигая аудиомодальности для выравнивания пространства встраивания текста LLM. Таким умным способом Video-LLaMA может продемонстрировать способность понимать звук во время вывода, даже если он никогда не обучался на аудиоданных.

Пример отображения

Авторы показывают несколько примеров диалогов Video-LLaMA, основанных на видео/аудио/изображениях.

(1) Следующие два примера демонстрируют комплексные возможности аудиовизуального восприятия Video-LLaMA. Разговоры в примерах вращаются вокруг аудио-видео. В примере 2 на экране отображается только исполнитель, но звук — это аплодисменты и аплодисменты аудитории. Если модель может принимать только визуальные сигналы, она не сможет сделать вывод о положительной реакции аудитории. в аудиозаписи нет звука музыкальных инструментов. Но на картинке есть саксофон. Если модель может воспринимать только слуховые сигналы, она не будет знать, что игрок играл на саксофоне.

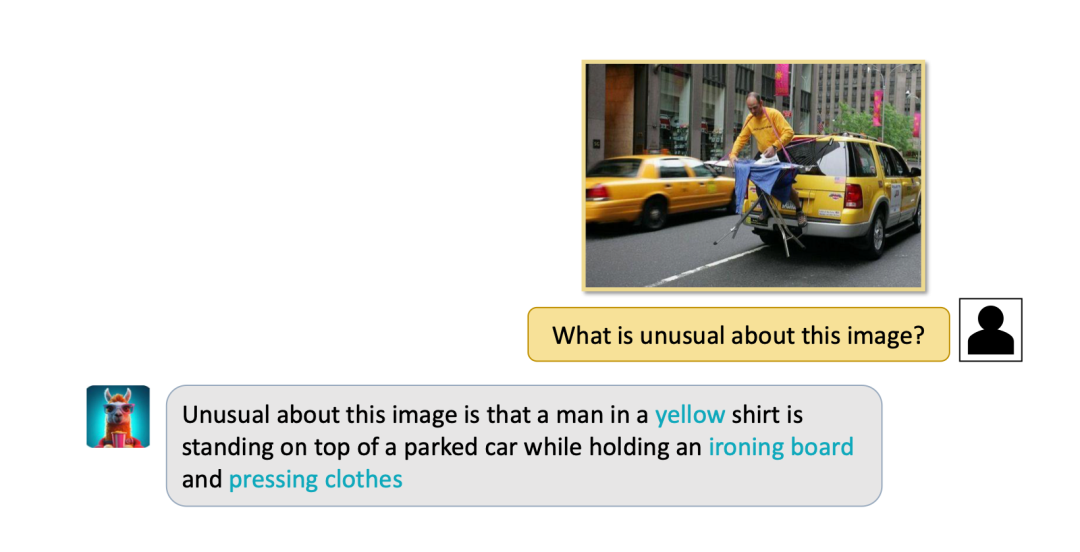

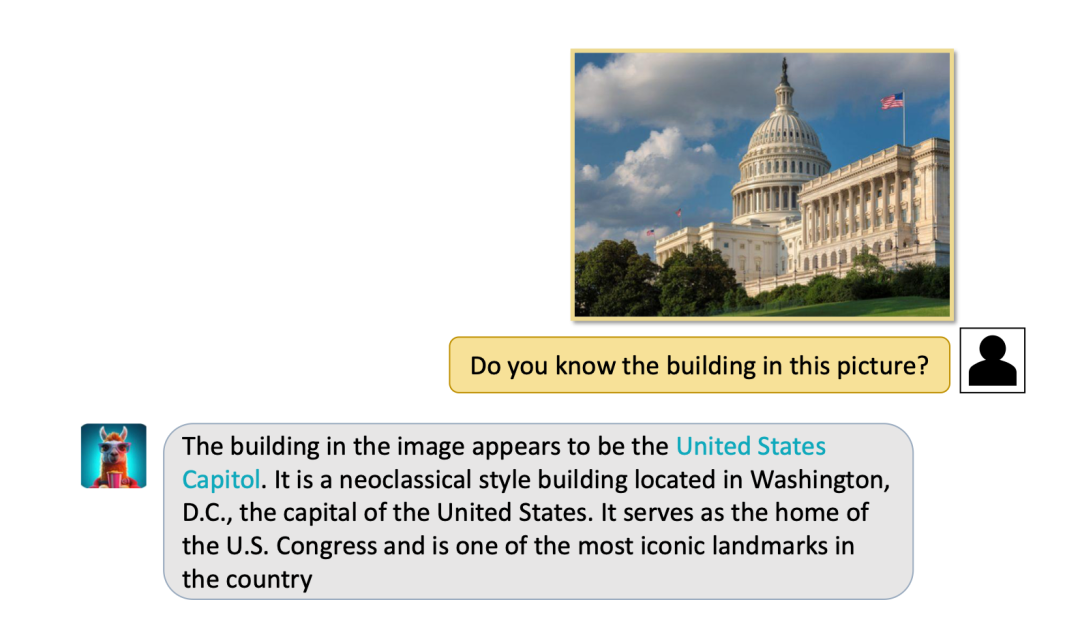

(2) Video-LLaMA также обладает сильными возможностями восприятия статических изображений и может выполнять такие задачи, как описание изображения, а также вопросы и ответы.

(3) Удивительно, но Video-LLaMA может успешно идентифицировать известные достопримечательности и людей, а также задавать здравые вопросы и ответы. Например, видео-LLaMA ниже успешно идентифицировало Белый дом и представило ситуацию в Белом доме. Другой пример, введя неподвижное фото Лонг Ма и Джона Сноу (персонажей классического фильма и телесериала «Игра престолов»), VIdeo-LLaMA может не только успешно идентифицировать их, но и рассказать об их отношениях, что постоянно обсуждается. редактируется и портится.

(4) Видео-лама также может фиксировать на видео динамические события, такие как движения бу и направление лодки.

Подвести итог

В настоящее время понимание аудио и видео по-прежнему остается очень сложной исследовательской проблемой, которая еще не имеет зрелого решения. Хотя Video-LLaMA продемонстрировал впечатляющие возможности, автор также упомянул, что у него есть некоторые ограничения.

(1) Ограниченные возможности восприятия: визуальные и слуховые возможности Video-LLaMA все еще относительно рудиментарны, и идентифицировать сложную визуальную и звуковую информацию все еще сложно. Частично причина в том, что качество и размер наборов данных недостаточно хороши. Исследовательская группа активно создает высококачественный набор данных для выравнивания аудио-видео-текста, чтобы улучшить перцептивные возможности модели.

(2) Сложность обработки длинных видеороликов. Длинные видеоролики (например, фильмы и телепередачи) содержат большой объем информации, что требует высоких умственных способностей и вычислительных ресурсов для модели.

(3) Проблема галлюцинаций, присущая языковым моделям, все еще существует в Video-LLaMA.

В целом Video-LLaMA, как крупная модель с комплексными аудиовизуальными возможностями, добилась впечатляющих результатов в области понимания аудио и видео. Поскольку исследователи продолжают усердно работать, вышеупомянутые проблемы будут преодолеваться одна за другой, что сделает модель понимания аудио и видео имеющей широкую практическую ценность.

© THE END

Пожалуйста, свяжитесь с этим общедоступным аккаунтом, чтобы получить разрешение на перепечатку.

Публикуйте статьи или ищите освещение: content@jiqizhixin.com

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами