Cohere выпускает Command R+: поддержка китайского языка, 104 миллиарда параметров, производительность, сравнимая с GPT-4, ведущие RAG и инструментальные приложения

Предисловие

5 апреля известная AI-компания Cohere официально выпустила новую модель большого языка (LLM) — Command R+. Модель имеет 104 миллиарда параметров и добилась революционного прогресса в поддержке нескольких языков, возможностях расширенной генерации (RAG) и инструментальных приложениях. Ее производительность даже сравнима с GPT-4 от OpenAI.

- HuggingfaceЗагрузка модели: huggingface.co/CohereForAI…

- Бесплатная ускоренная загрузка модели быстрой станции AI:aifasthub.com/models/Cohe…

Производительность сравнима с GPT-4

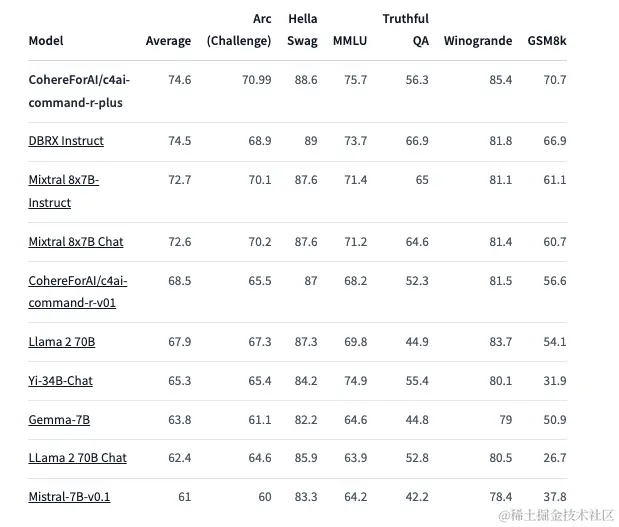

Стоит отметить, что производительность Command R+ в многочисленных оценках не только превосходит основные отраслевые модели с открытым исходным кодом, но по некоторым показателям даже сравнима с GPT-4.

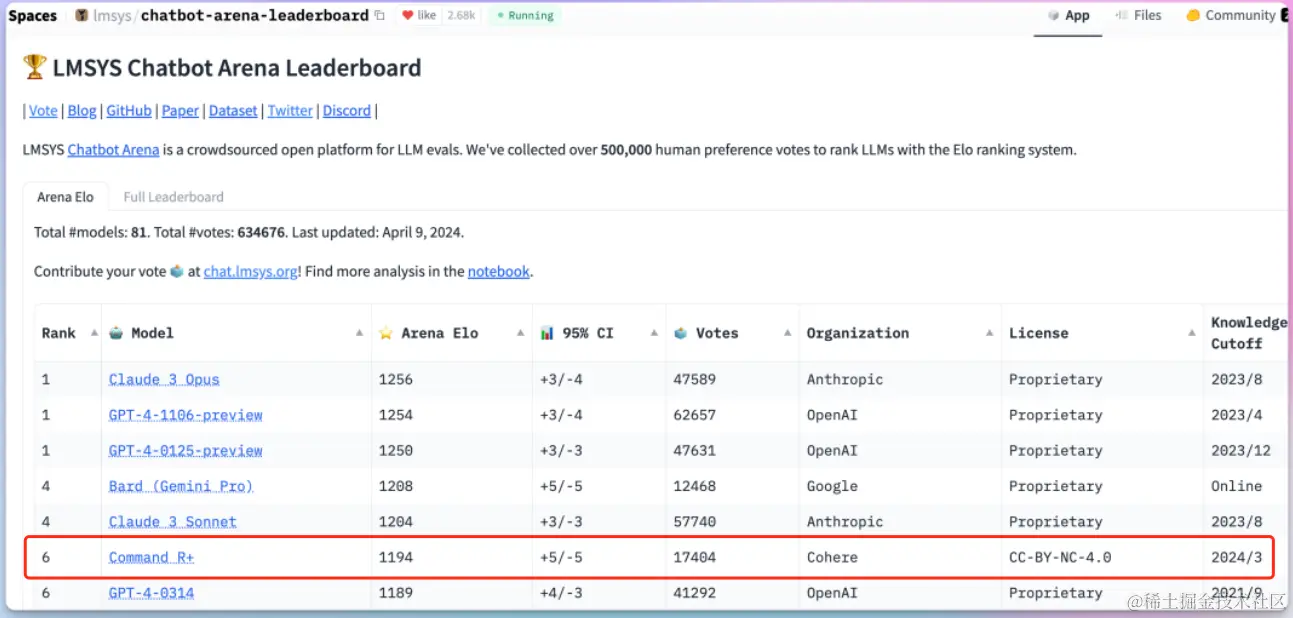

В рейтинге LMSys Chatbot Arena Command R+ занимает 6-е место, опережая GPT-4-0314. Это означает, что эта модель не только превосходит другие крупные модели с точки зрения многоязычной обработки и приложений RAG, но также может конкурировать с лучшими продуктами отрасли с точки зрения производительности диалоговой системы.

104 миллиарда параметров, поддержка 10 языков, включая китайский

С точки зрения масштаба параметров, Command R+, несомненно, является в настоящее время одним из крупнейших LLM с открытым исходным кодом, в общей сложности насчитывающим 104 миллиарда параметров. Это дает ему исключительные способности к обучению и рассуждению при решении сложных задач. Стоит еще отметить, что Command R+ поддерживает не только английский, но и 10 языков, включая французский, немецкий, испанский, итальянский, португальский (Бразилия), японский, корейский, арабский и упрощенный китайский. Это, несомненно, значительно повышает применимость модели в глобальном масштабе.

Возможности оптимизированного поиска дополнений (RAG)

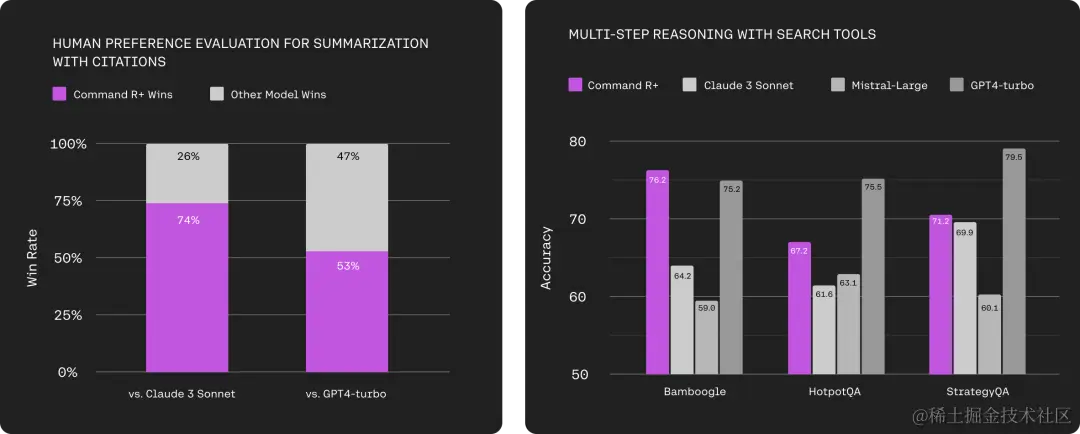

Являясь флагманской моделью Cohere, Command R+ была полностью оптимизирована и обновлена с точки зрения возможностей расширенного поиска (RAG). RAG в настоящее время является одной из наиболее важных технологий для крупномасштабных языковых моделей. Она позволяет модели извлекать соответствующий контент из внешних источников знаний на основе заданной контекстной информации и интегрировать ее в сгенерированный ответ. Это не только значительно повышает точность ответа, но и эффективно смягчает проблему «иллюзии» модели.

У Command R+ производительность модуля RAG не только близка к GPT-4, но и превосходит ее по некоторым показателям. Например, модель может более точно предсказать, какие результаты поиска являются наиболее релевантными, и встроить их в виде цитат в сгенерированные ответы, что еще больше повысит достоверность ответов.

Кроме того, Command R+ поддерживает различные режимы ответов RAG. Пользователи могут выбрать «режим точного цитирования» или «режим быстрого цитирования» в соответствии с конкретными потребностями. Первый сначала будет прогнозировать соответствующие документы, затем генерировать ответы и вставлять ссылки, а второй будет напрямую генерировать ответы со ссылками, стремясь генерировать меньше токенов.

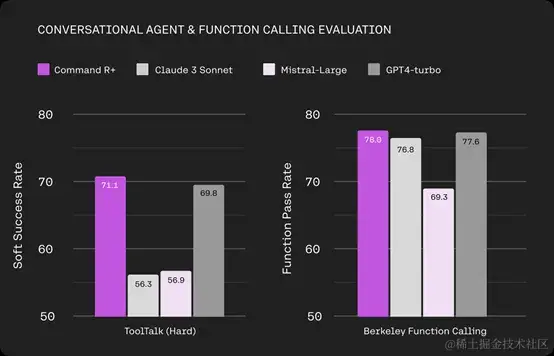

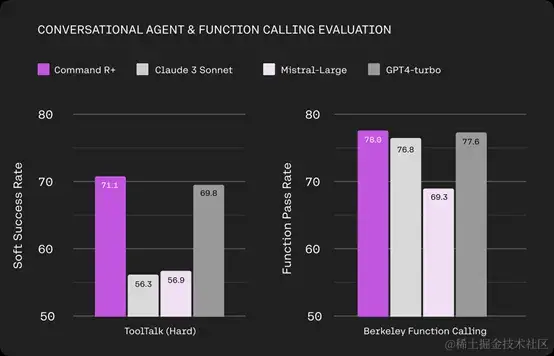

Возможности многоэтапного использования инструмента

Помимо RAG, Command R+ также добился серьезных прорывов в использовании инструментов. Эта модель может не только вызывать различные внешние инструменты, такие как поисковые системы, API, базы данных и т. д., но также поддерживает использование многоэтапных инструментов и может объединять несколько инструментов в несколько этапов для выполнения сложных задач. Это позволяет Command R+ не только понимать и генерировать текст, но и действовать как основной механизм вывода, принимая решения и автоматизируя сложные задачи, для решения которых требуется интеллект. Гомес рассказал, что Command R+ может самостоятельно исправлять ошибки, даже если при использовании инструмента обнаруживается ошибка или сбой, и может повторять попытки несколько раз, пока задача не будет завершена, что чрезвычайно важно в практических приложениях.

Кроме того, модель имеет встроенный расширенный сегментатор слов, который хорошо работает при обработке неанглоязычных текстов. Он имеет очевидные преимущества перед другими моделями на рынке с точки зрения стоимости сжатия до 57%.

Подвести итог

В целом, Command R+, выпущенный Cohere, несомненно, является темной лошадкой в текущей области LLM с открытым исходным кодом. Эта сверхбольшая модель со 104 миллиардами параметров не только далеко опережает по техническим показателям, но и делает инновационные попытки удовлетворения потребностей уровня предприятия, что заслуживает внимания отрасли.

Загрузка модели

HuggingfaceЗагрузка модели

Бесплатная ускоренная загрузка модели быстрой станции AI

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами