Что такое протокол TTPoE Tesla?

Вместо использования традиционного протокола TCP компания Tesla разработала новый протокол передачи данных Ethernet с потерями для своего суперкомпьютера Dojo: Транспортный протокол Tesla через Ethernet (TTPoE).

Этот протокол разработан для суперкомпьютеров искусственного интеллекта, чтобы обеспечить передачу данных по сетевым архитектурам масштаба Exa.

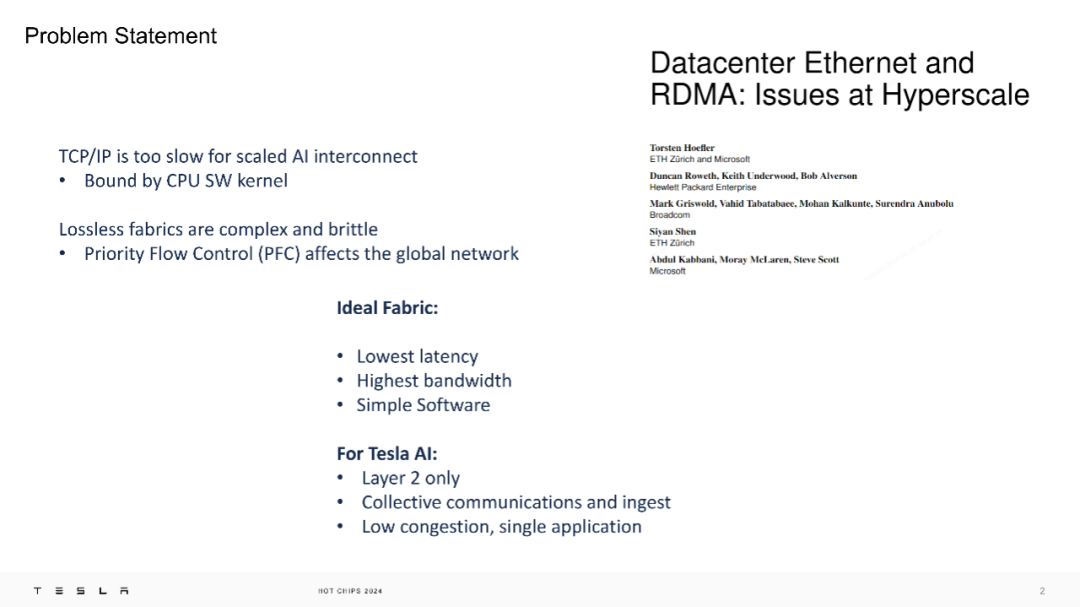

По сравнению с традиционным протоколом TCP/IP, TTPoE реализуется на аппаратном уровне для решения проблемы задержки соединения AI. Он обеспечивает меньшую задержку и более высокую пропускную способность за счет упрощенной конструкции программного и аппаратного обеспечения.

Причина в том, что Tesla считает, что протокол TCP/IP слишком медленный, а RDMA (удаленный прямой доступ к памяти) с использованием PFC (управление приоритетным потоком) может обеспечить сеть без потерь, но это повлияет на производительность сети.

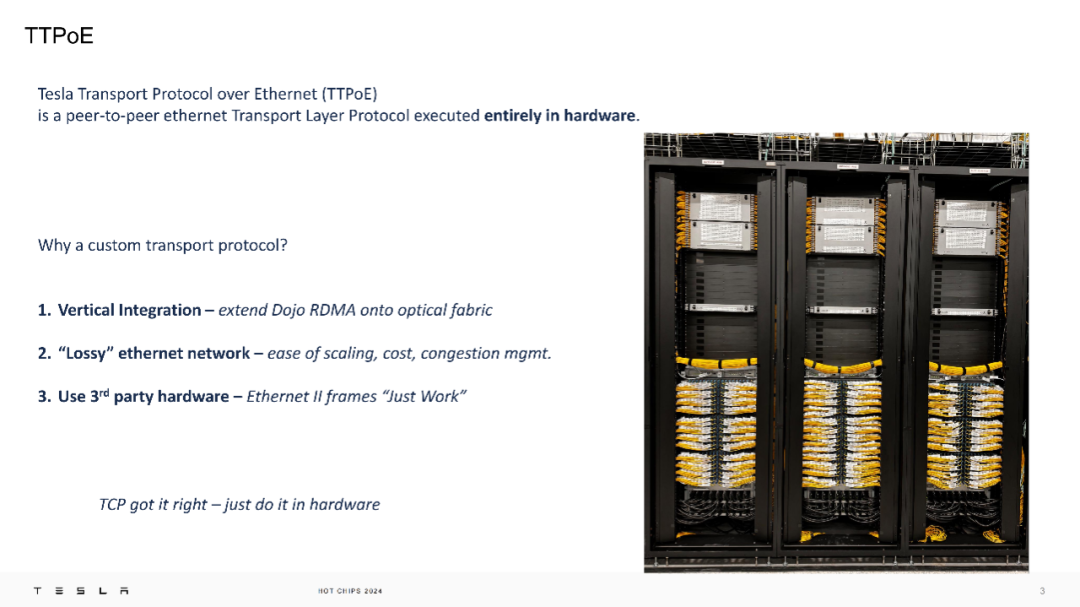

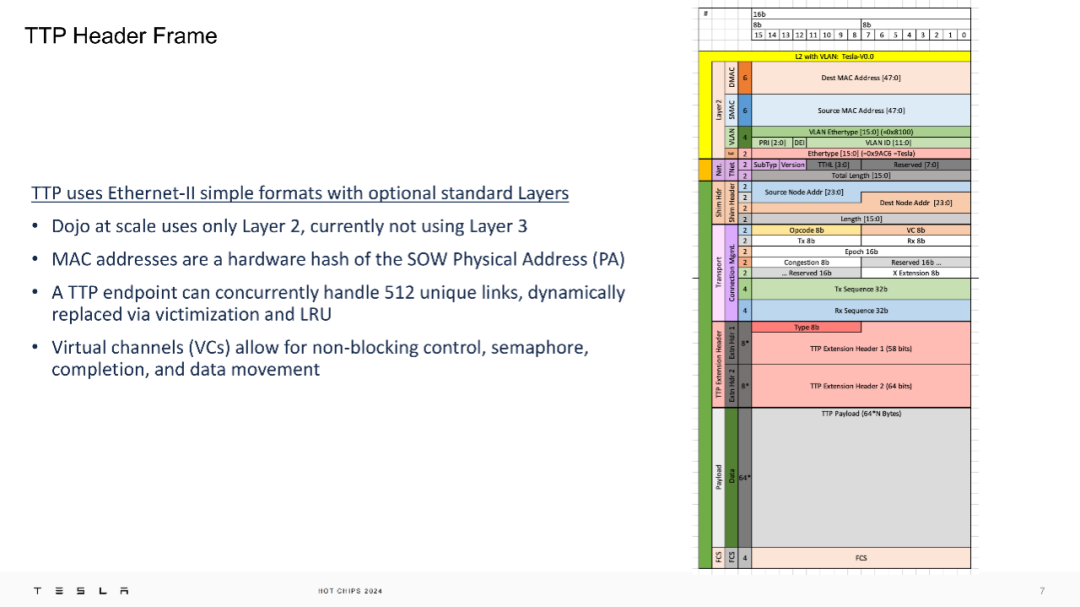

В следующем введении указывается, что TTPoE — это протокол транспортного уровня «точка-точка», реализованный на аппаратном уровне. Его преимущество состоит в том, что Tesla не требует использования специальных коммутаторов, поскольку он в основном использует передачу второго уровня ( канальный уровень).

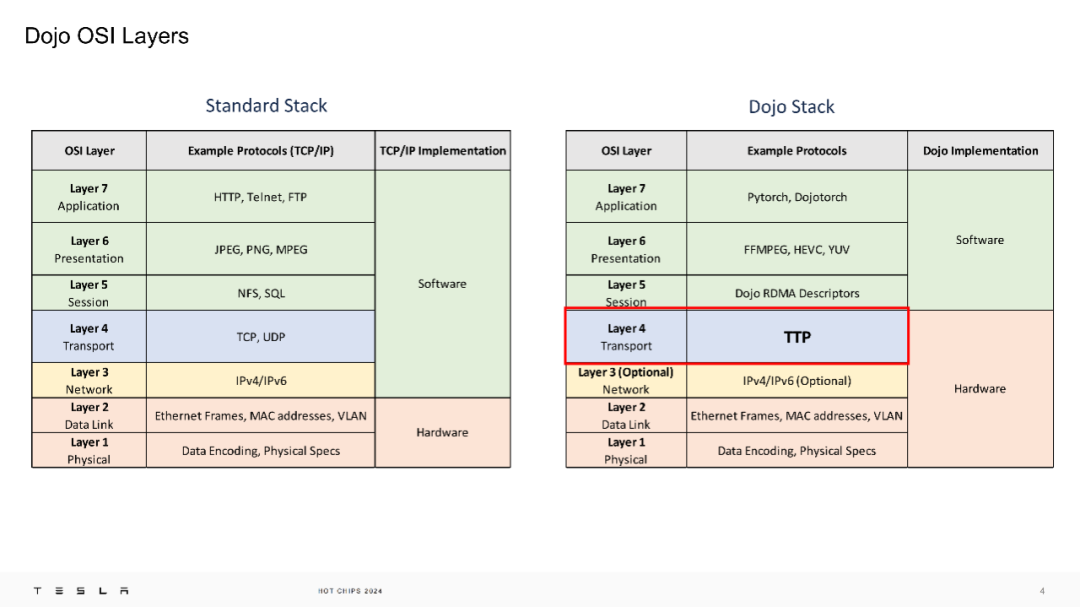

То есть в модели OSI Dojo Тесла заменил традиционный транспортный уровень на TTPoE.

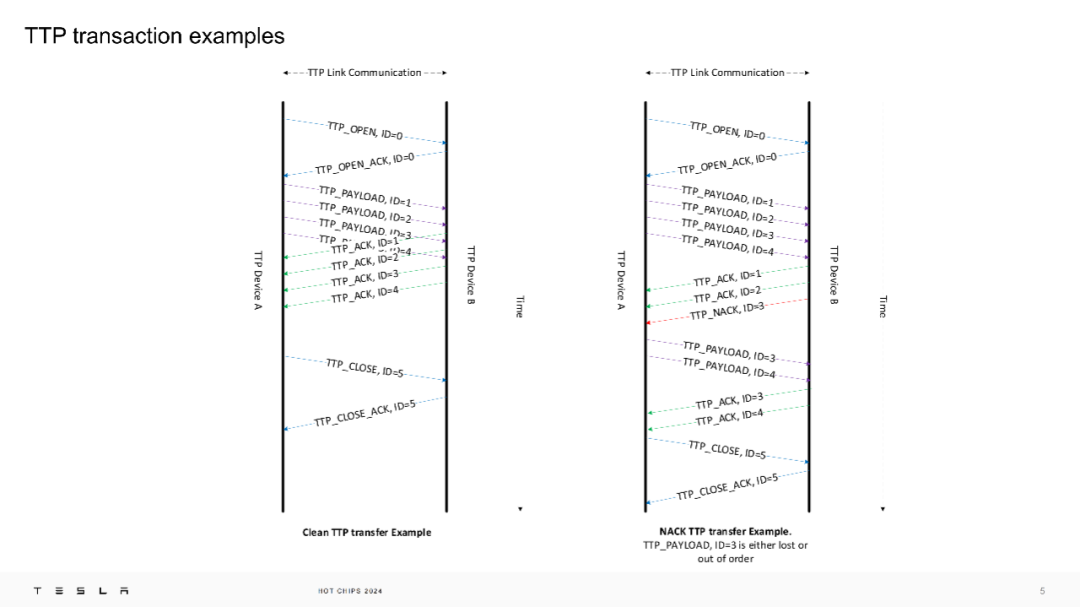

По ссылке TTP мы можем увидеть пример преобразования протокола TTP.

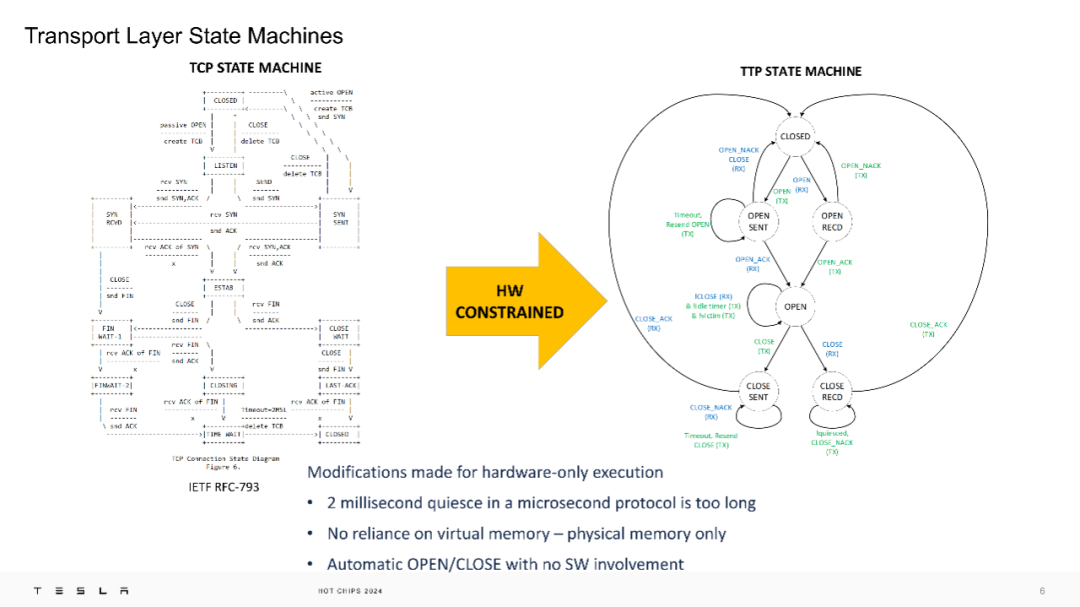

В фильме ниже Тесла показывает сравнение между конечным автоматом TCP и конечным автоматом TTP: конечный автомат транспортного уровня TTPoE оптимизирован для аппаратного выполнения, например, исходное время молчания в 2 мс сокращено для адаптации к требованиям протокола на микросекундном уровне. , и избегает зависимости от виртуальной памяти и использует только физическую память.

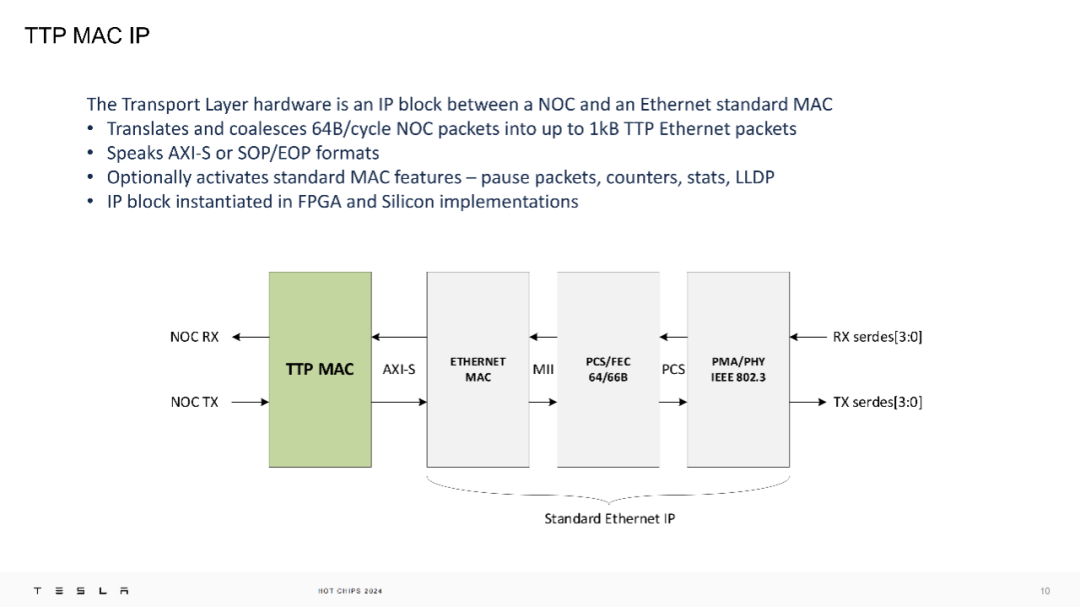

На физическом уровне TTPoE использует простой формат Ethernet-II и работает только на уровне 2, без участия сети уровня 3. Каждое оборудование транспортного уровня суперкомпьютера Dojo представляет собой IP-модуль, расположенный между сетевым чипом (NOC) и стандартным Ethernet MAC.

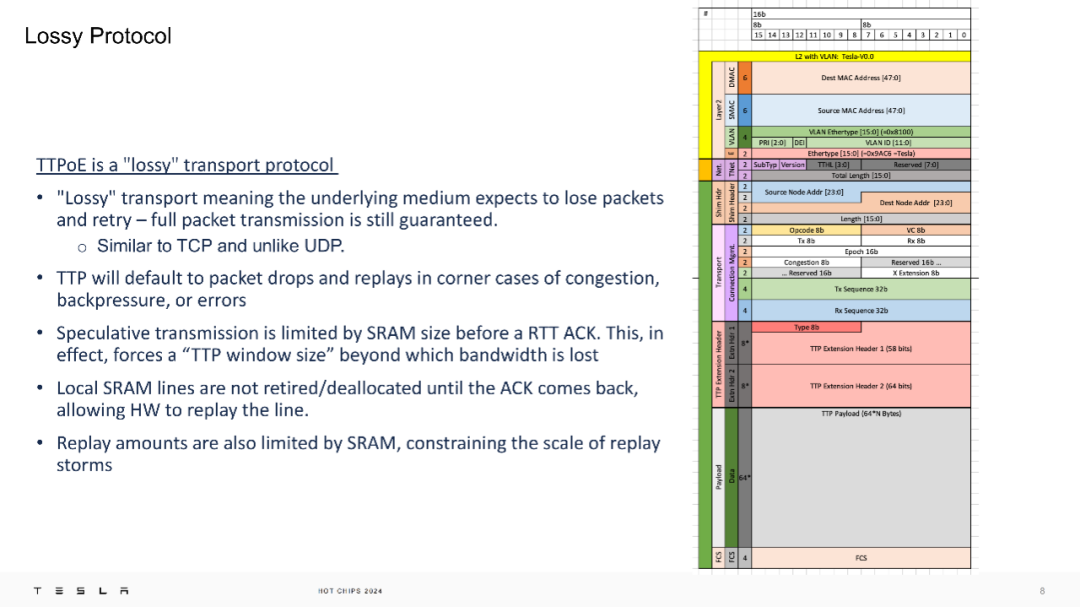

Протокол TTPoE по своей природе является «с потерями», то есть он ожидает потери пакетов и их повторной передачи в случае перегрузки сети, противодавления или ошибок, но при этом гарантирует полную доставку пакетов. Эта конструкция больше похожа на TCP, чем на UDP, и эффективно управляет использованием полосы пропускания, ограничивая объем спекулятивной передачи до получения подтверждения (ACK).

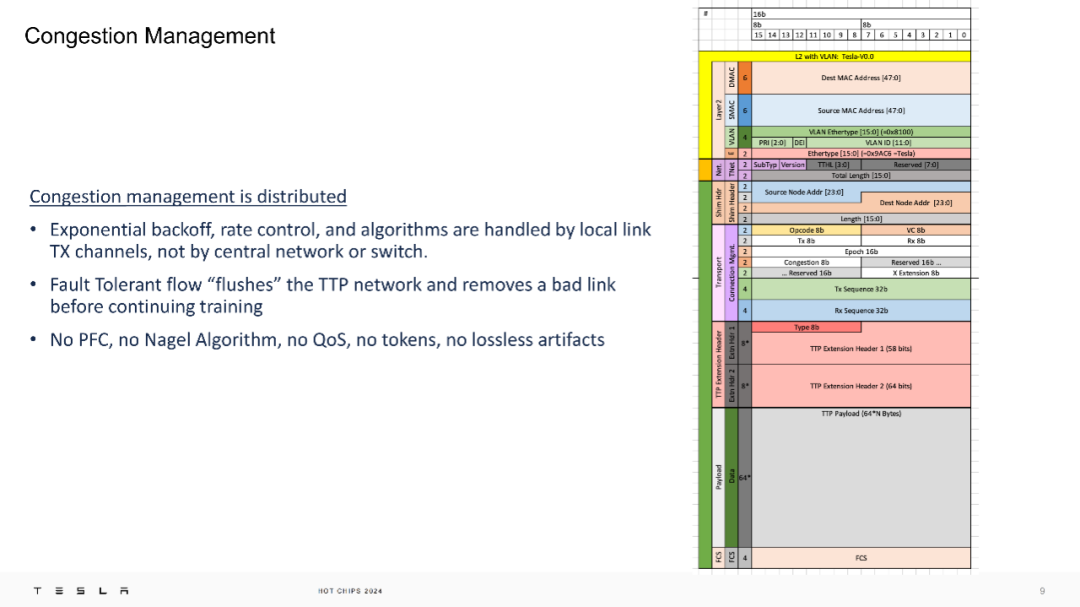

Кроме того, управление перегрузкой TTPoE распределяется и обрабатывается каналом передачи локального канала, а не контролируется центральной сетью или коммутатором. Такая конструкция снижает сложность и уязвимость сети, позволяя избежать зависимости от сетевых механизмов без потерь, таких как управление приоритетным потоком (PFC) и алгоритм Нагеля.

Tesla утверждает, что TTP поддерживает качество обслуживания (QoS), но в настоящее время эта функция отключена.

Tesla интегрировала IP-блоки TTP в FPGA и кремниевые чипы, которые предназначены для быстрой передачи пакетов по проводу.

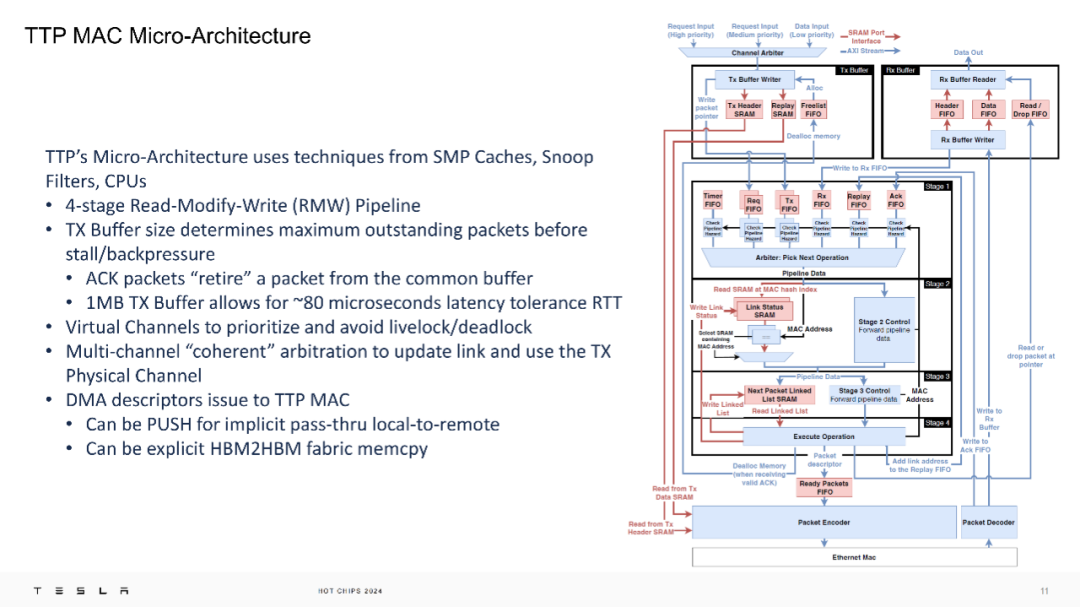

На уровне микроархитектуры конструкция микроархитектуры TTP уникальна и очень похожа на кэш L3. Она использует технологии, аналогичные SMP-кэшу, отслеживающему фильтру и ЦП, а также имеет 4-ступенчатую модификацию чтения и записи (RMW). Буфер отправки размером 1 МБ обеспечивает двустороннюю задержку примерно 80 микросекунд, а виртуальные каналы используются для определения приоритетов и предотвращения блокировки/взаимной блокировки. Буфер отправки размером 1 МБ упоминается в текущем поколении, но, вероятно, изменится в новом поколении.

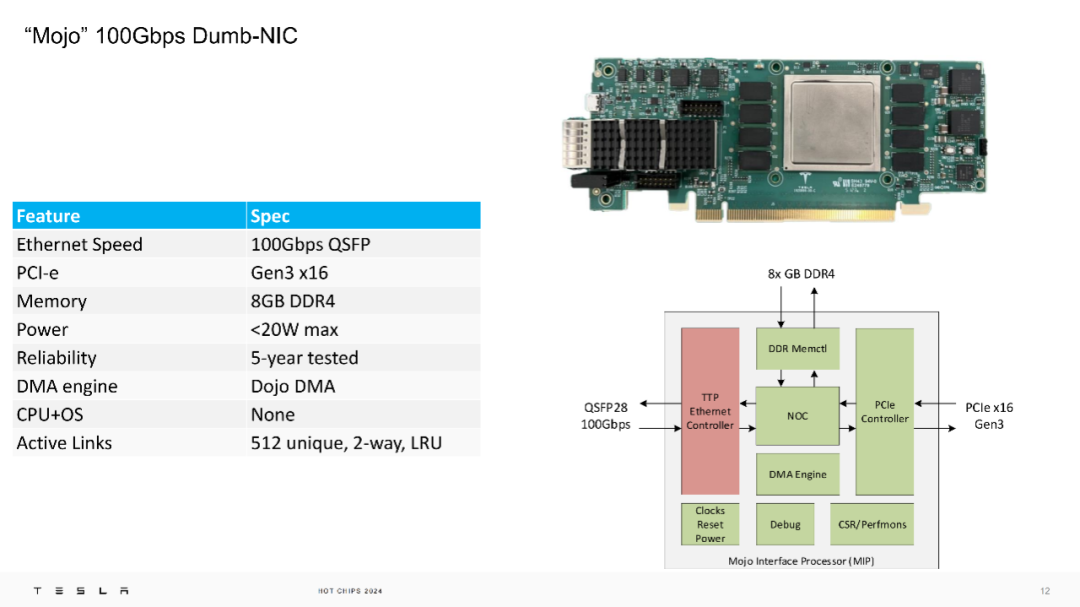

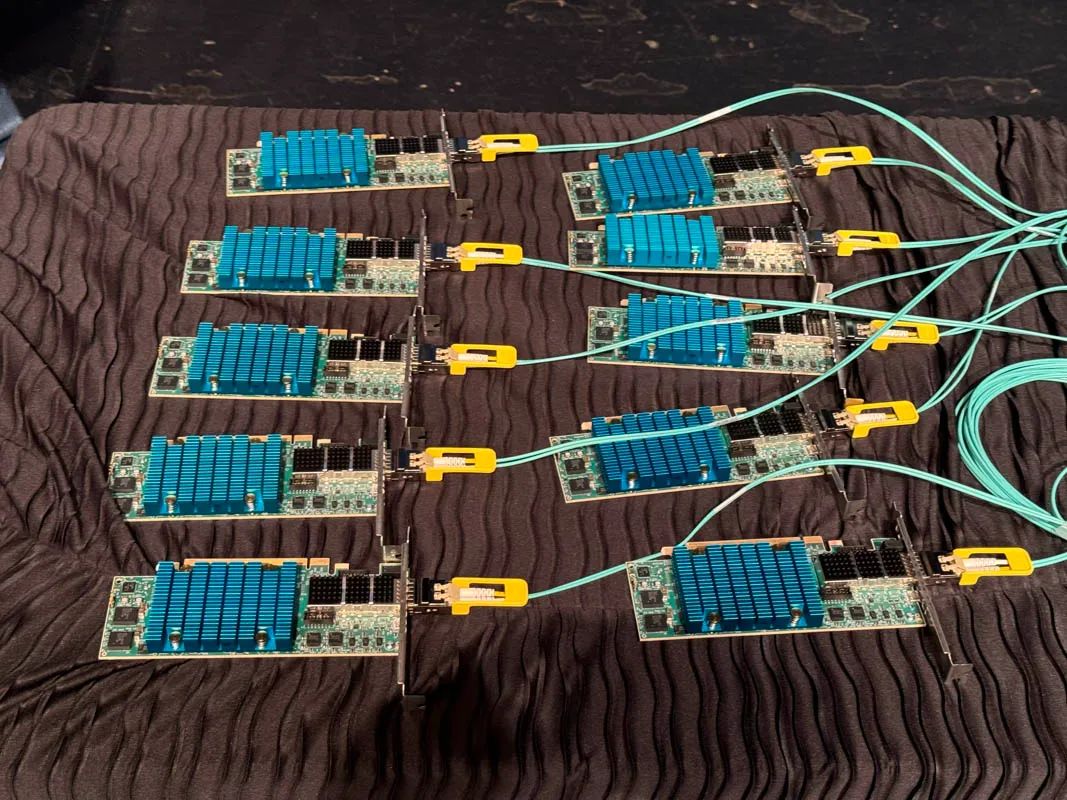

Tesla продемонстрировала свою сетевую карту Mojo со скоростью 100 Гбит/с, «тупую» сетевую карту со скоростью Ethernet 100 Гбит/с, интерфейсом PCI-e Gen3 x16, 8 ГБ памяти DDR4 и энергопотреблением менее 20 Вт. Он также включает в себя механизм Dojo DMA и поддерживает 512 уникальных двунаправленных активных каналов LRU.

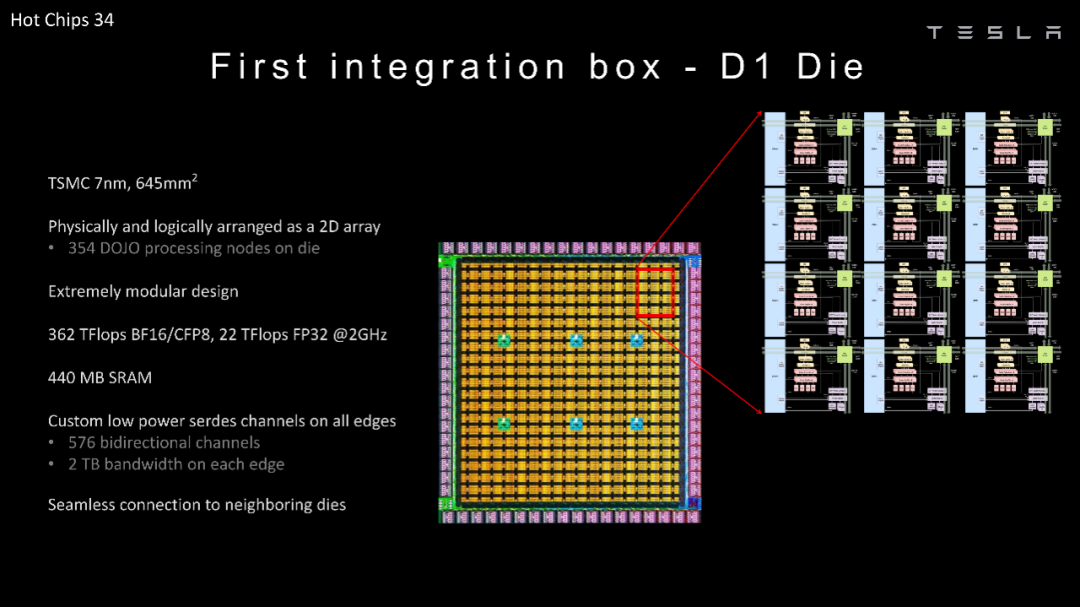

На конференции Tesla рассказала о выпуске чипа D1 в 2022 году.

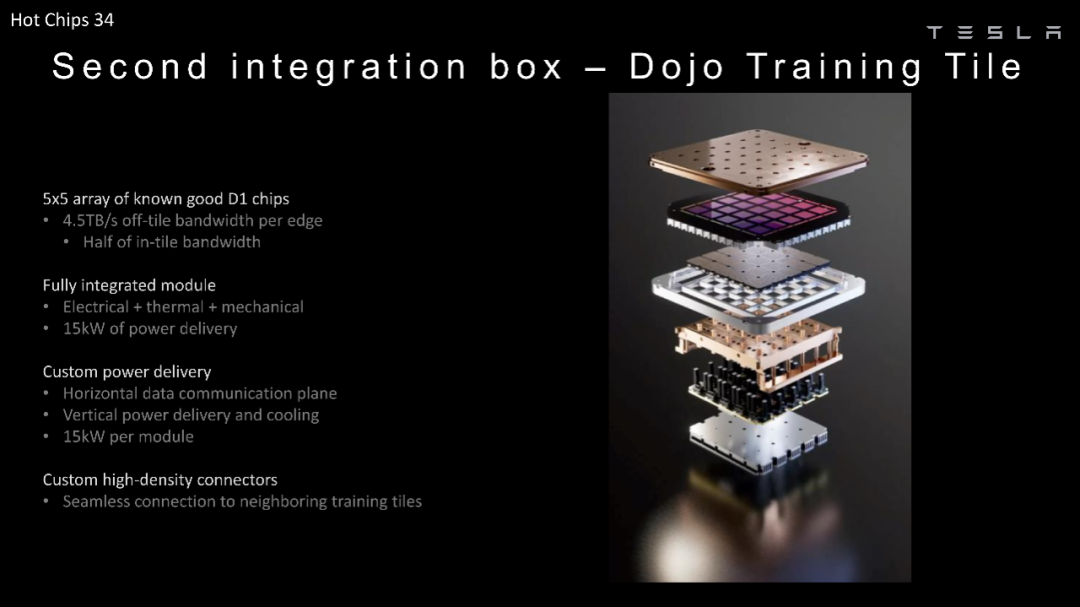

На изображении ниже показан корпус микросхемы D1 для массива 5×5.

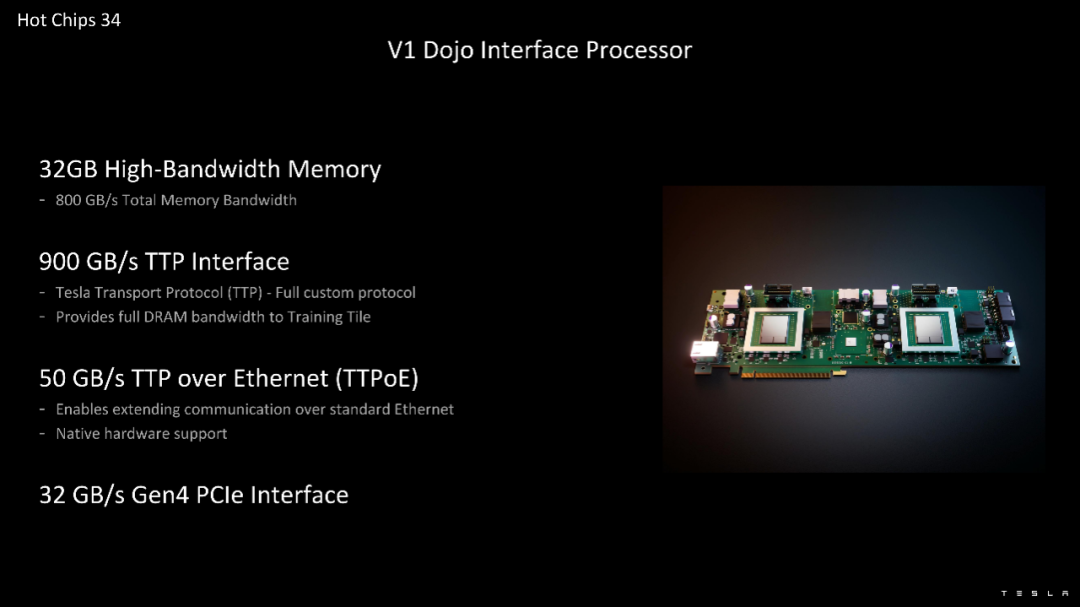

Интерфейсный процессор Dojo включает 32 ГБ памяти с высокой пропускной способностью, обеспечивающей общую пропускную способность памяти 800 ГБ/с и интерфейс TTP 900 ГБ/с. Интерфейс TTP со скоростью 900 ГБ/с является внутренним, а TTPoE инкапсулируется в кадры Ethernet.

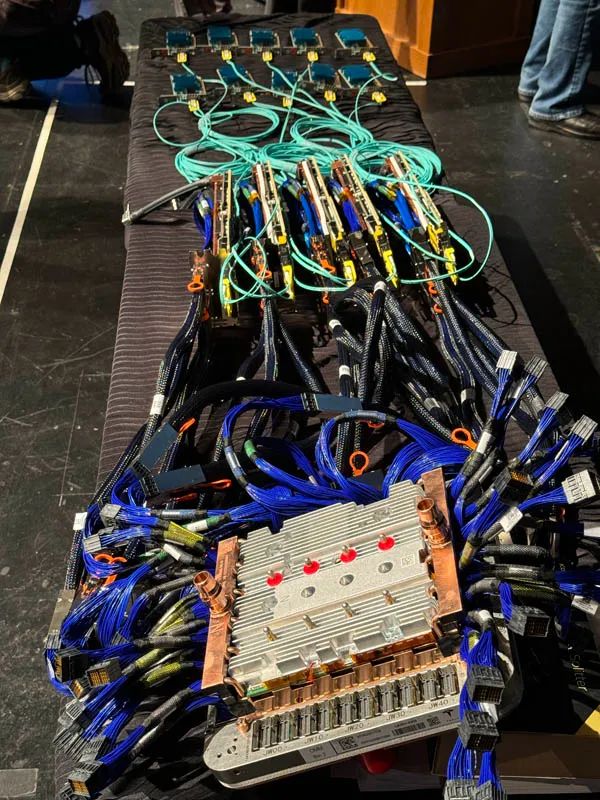

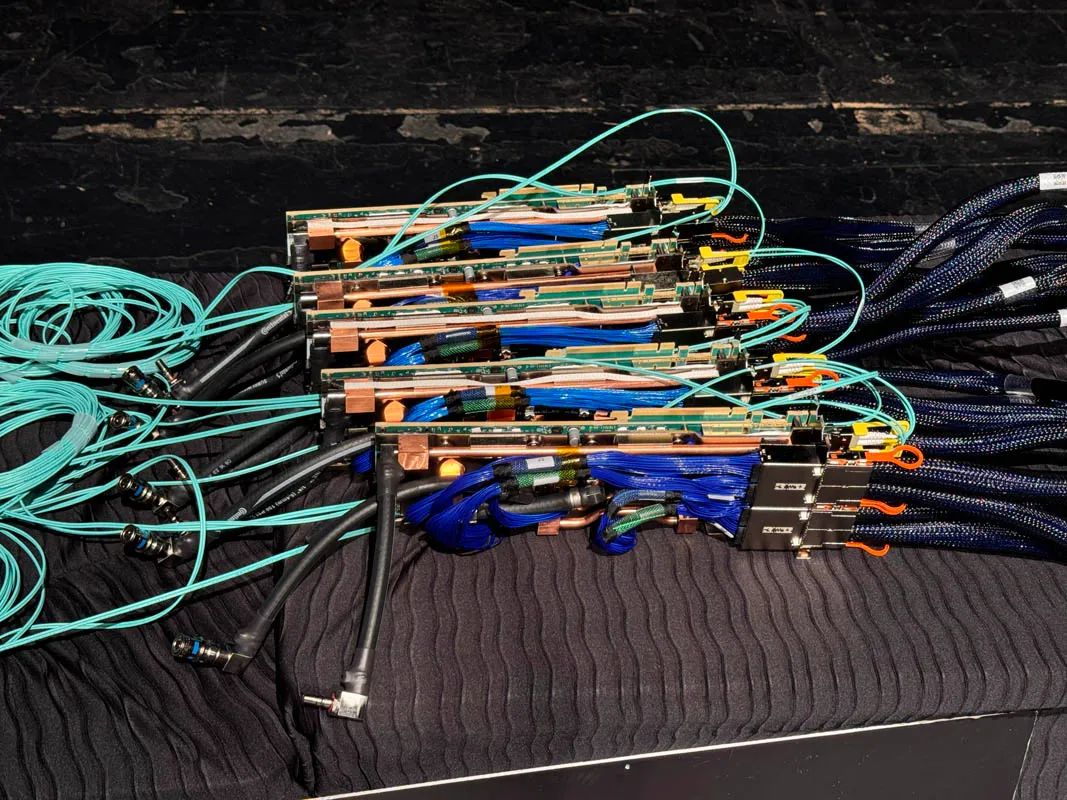

Далее Тесла продемонстрировал, как подключено Додзё. Интерфейсная плата Tesla 100G NIC to V1 Dojo с Dojo.

Начните с собранного массива микросхем D1, подключенного кабелями SerDes к интерфейсной карте.

Они пойдут на интерфейсные карты.

Эти интерфейсные карты затем впоследствии подключаются к недорогим сетевым картам 100G.

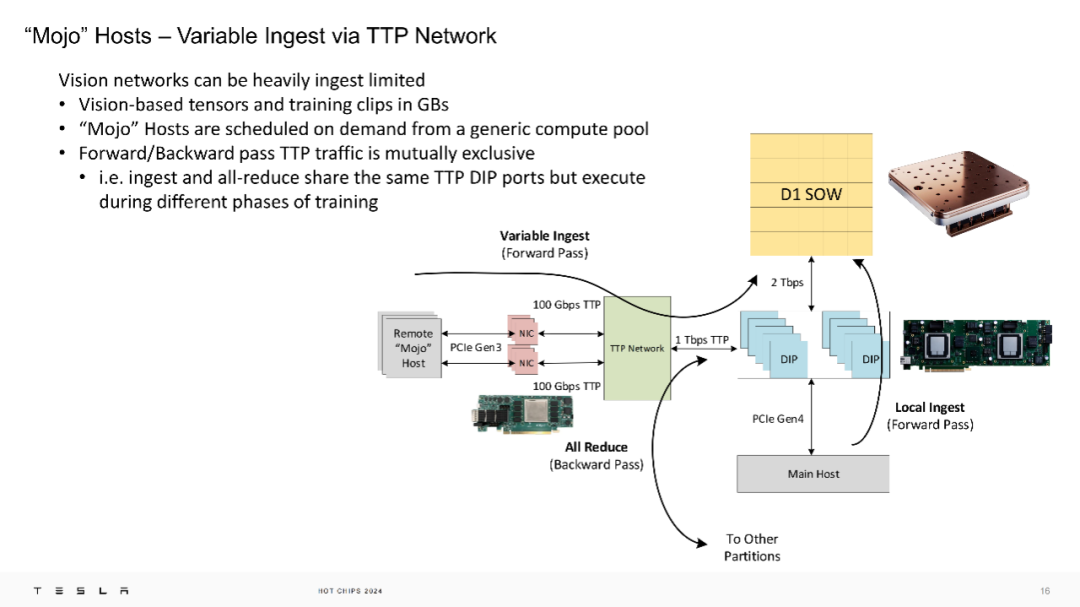

В сети TTP Tesla хост «Mojo» работает с приемом переменных данных. Сети машинного зрения могут быть ограничены приемом данных, поскольку тензоры на основе машинного зрения и фрагменты обучения могут измеряться в ГБ. Хосты «Mojo» планируются из общего пула вычислений в зависимости от спроса. Трафик TTP для прямых/обратных проходов не зависит друг от друга, т. е. операции приема данных и общего сокращения используют один и тот же порт TTP DIP, но выполняются на разных этапах обучения.

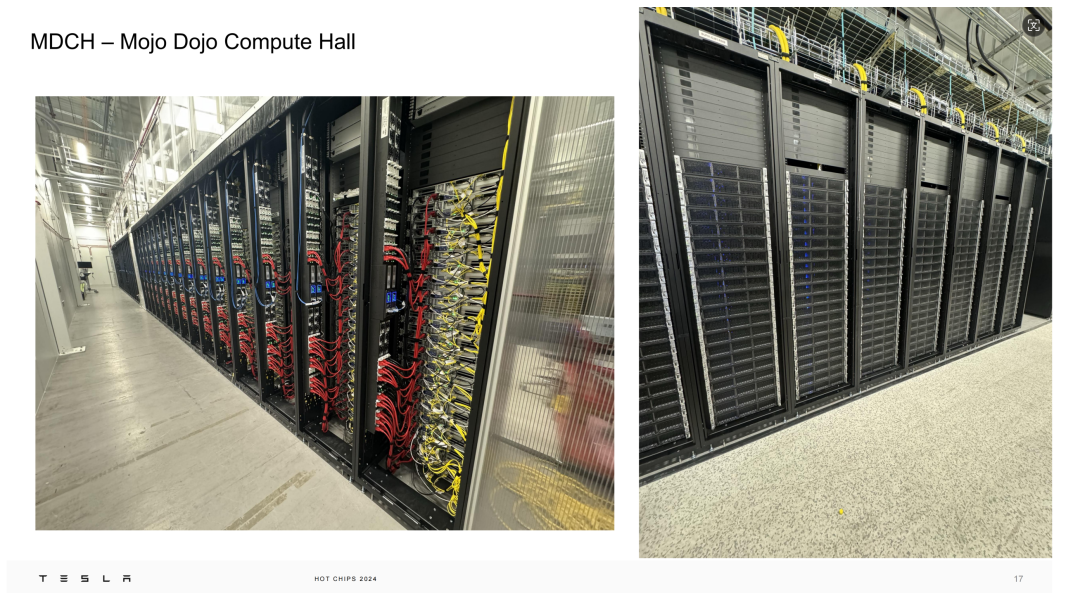

На фильме ниже показан вычислительный зал Mojo Dojo в Нью-Йорке. Мы видим, что вычислительный узел высотой 2U не имеет передних 2,5-дюймовых накопителей.

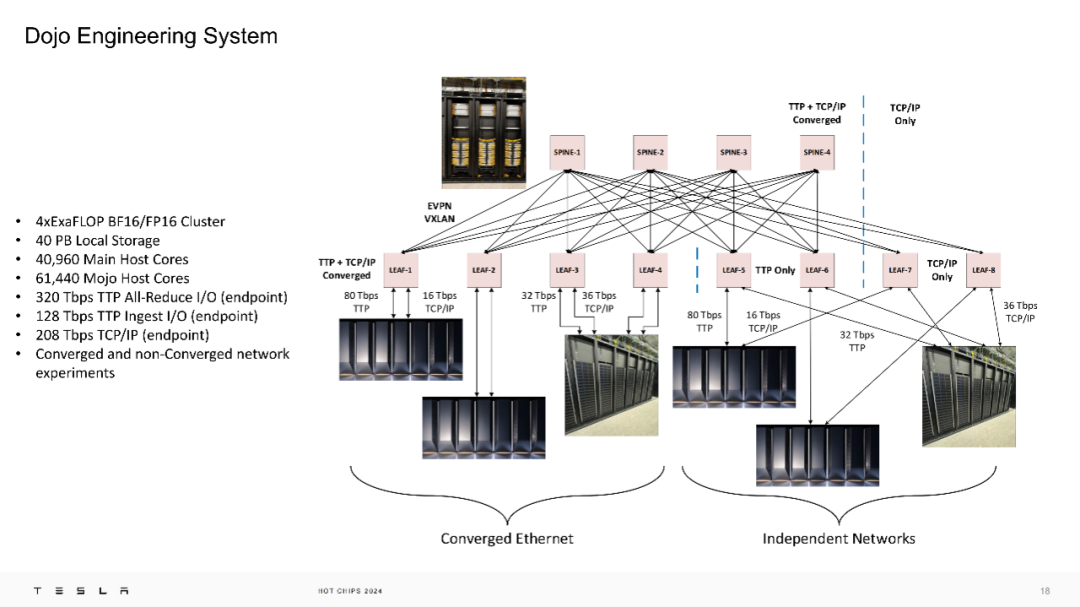

Это система с 4 ExaFLOP, оснащенная 40 ПБ локального хранилища, а также достаточной пропускной способностью и вычислительной мощностью. Наличие инженерной системы 4EF (BF16/FP16) тоже просто потрясающе.

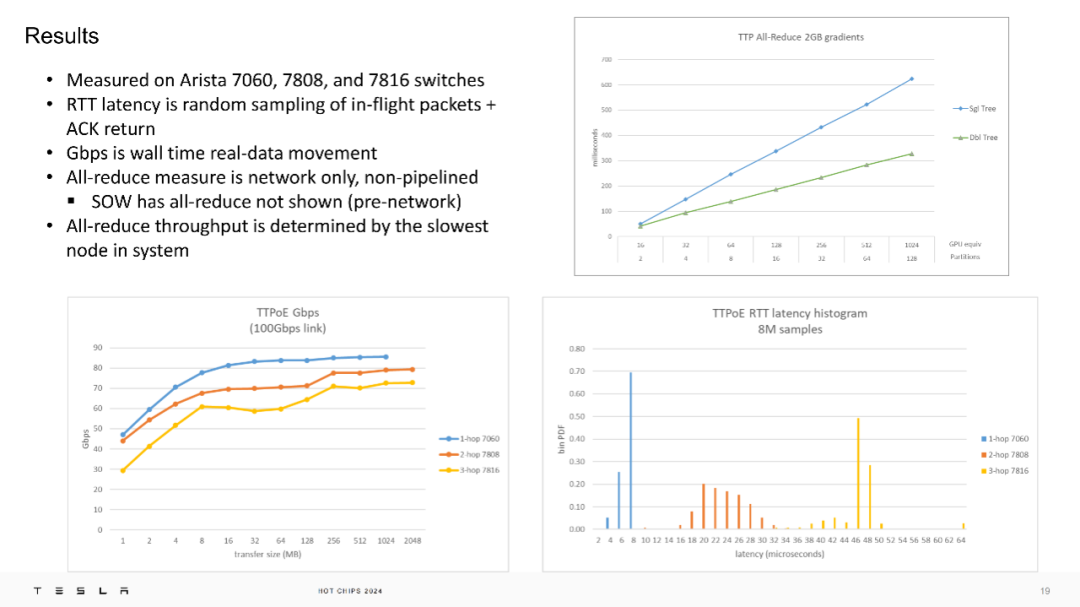

В ходе реальных испытаний TTPoE был измерен на коммутаторах Arista 7060, 7808 и 7816 и показал низкую задержку в обоих направлениях и высокую пропускную способность.

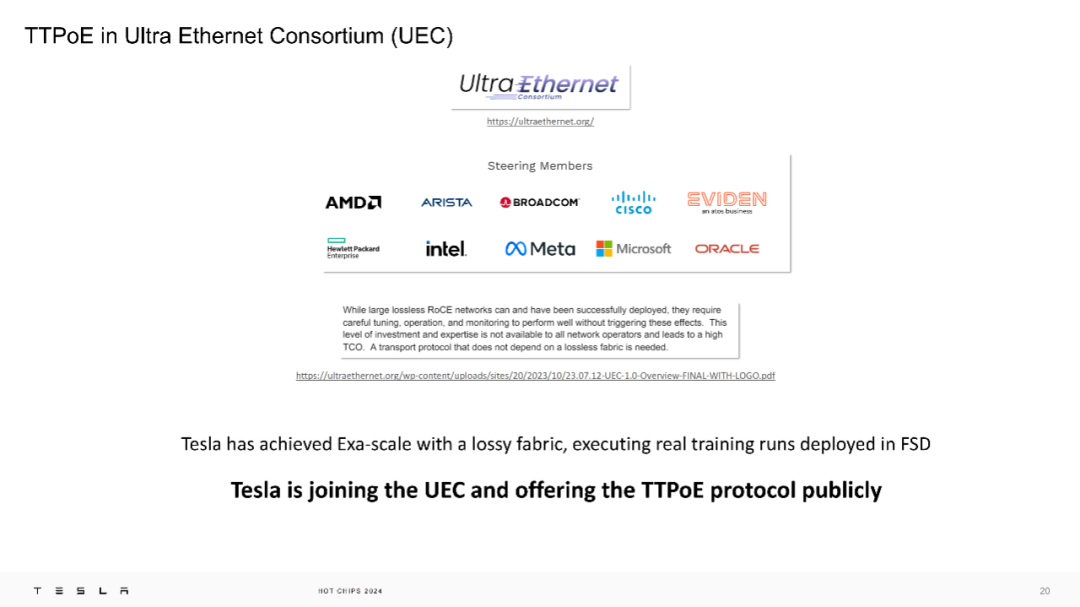

Tesla присоединилась к Консорциуму Ultra Ethernet (UEC) и сделала протокол TTPoE общедоступным для поддержки более широкого круга сетевых операторов.

Tesla благодарит: изобретателя TTPoE, команду развертывания сети, команду разработчиков микросхем, команду систем и инфраструктуры, команду программного обеспечения и драйверов, команду исправлений Linux, команду SDN, команду DevOps, команду QA, техническую команду DC, команду цепочки поставок и вклад все стажеры TTP/Mojo.

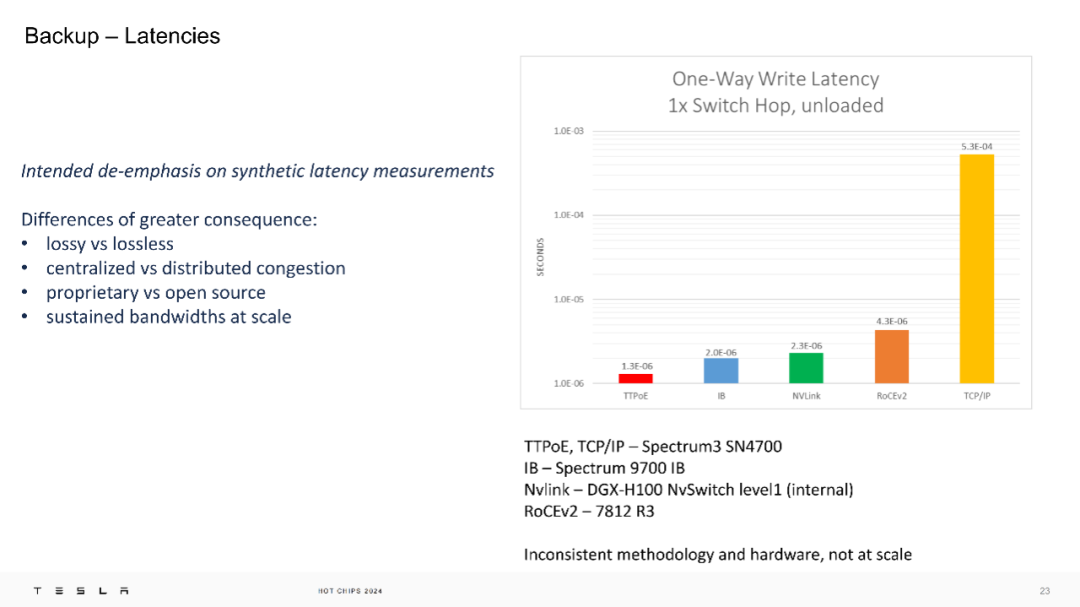

Наконец, что касается производительности сети, Тесла считает, что следует уделять меньше внимания синтетическим измерениям задержек, поскольку такие измерения часто не полностью отражают производительность реальной сети. Более значимые различия включают сети с потерями и без потерь; централизованный и распределенный подходы к борьбе с перегрузкой сети, а также собственные технологии и технологии с открытым исходным кодом;

Кроме того, представлены измерения задержки односторонней записи для 1 перехода подкачки без нагрузки, предоставляющие данные о задержке для нескольких различных технологий. В частности, задержка TTPoE составляет 1,0E-05 с, InfiniBand (IB) — 2,0E-06 с, NVLink — 2,3E-06 с, RoCEv2 — 4,3E-06 с, а TCP/IP имеет самую высокую задержку — 5,3E-04 с.

Тесла пришел к выводу, что производительность их системы достигла микросекундного уровня.

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами