[Бабушка знает, как это читать] Учебное пособие по развертыванию и использованию большой модели LLama2 с открытым исходным кодом и эффектами диалога модели.

1. Напишите впереди

Буквально 19 июля MetaAI открыла исходный код большой модели LLama2. Ян Ле Кун, главный научный сотрудник Meta и лауреат премии Тьюринга, заявил в Твиттере, что шаг Meta может изменить конкурентную среду в индустрии больших моделей. В одночасье ландшафт больших моделей снова резко изменился.

2.Что такое LLama2?

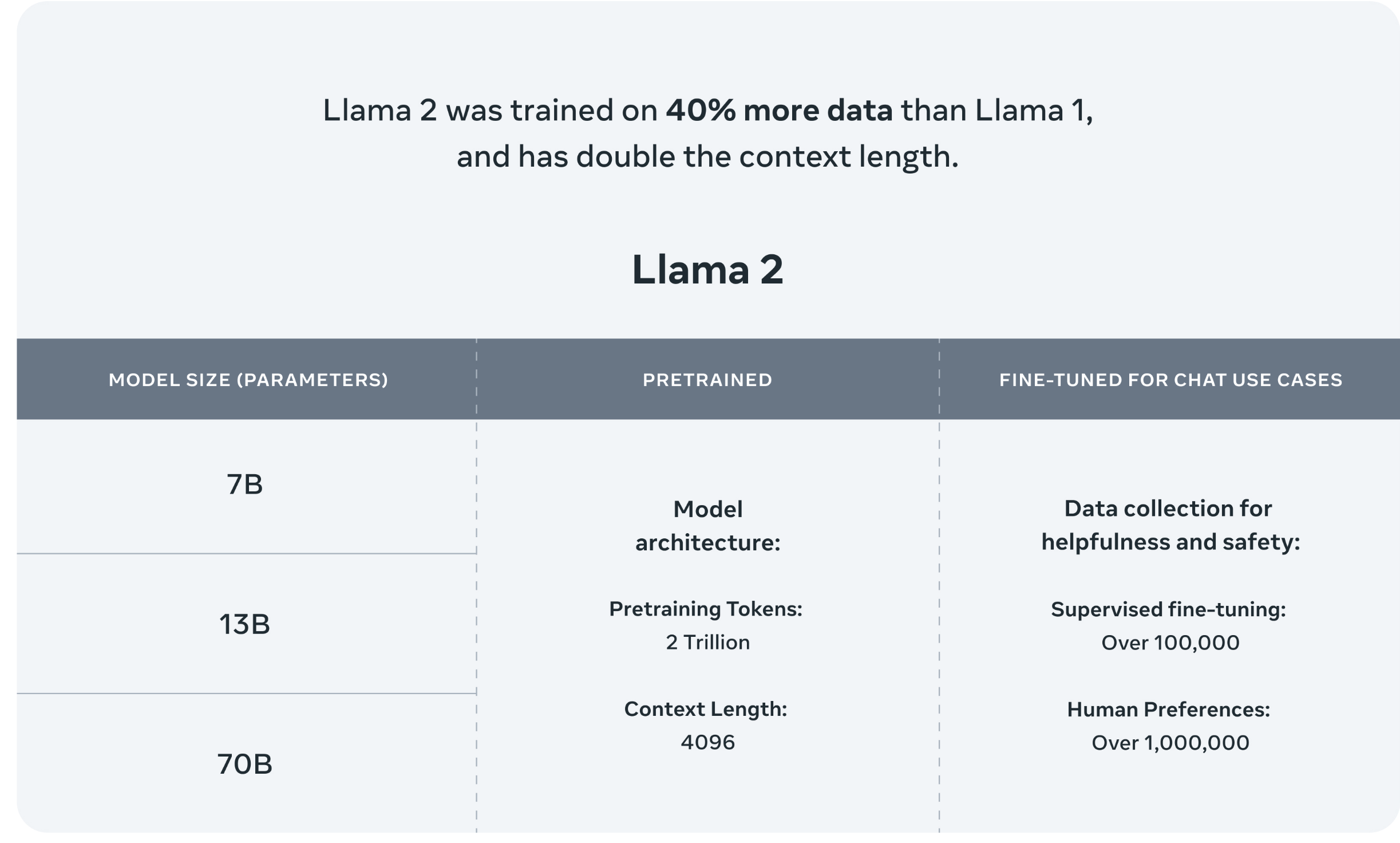

На официальном сайте Llama имеется описание Llama2, модели большого языка с открытым исходным кодом нового поколения, которую можно бесплатно использовать для академических исследований или коммерческих целей.

Текущая модель имеет три спецификации: 7B, 13B и 70B. На этапе предварительного обучения используется 2 триллиона токенов, на этапе SFT используется более 100 000 данных, а данные о предпочтениях человека превышают 1 миллион.

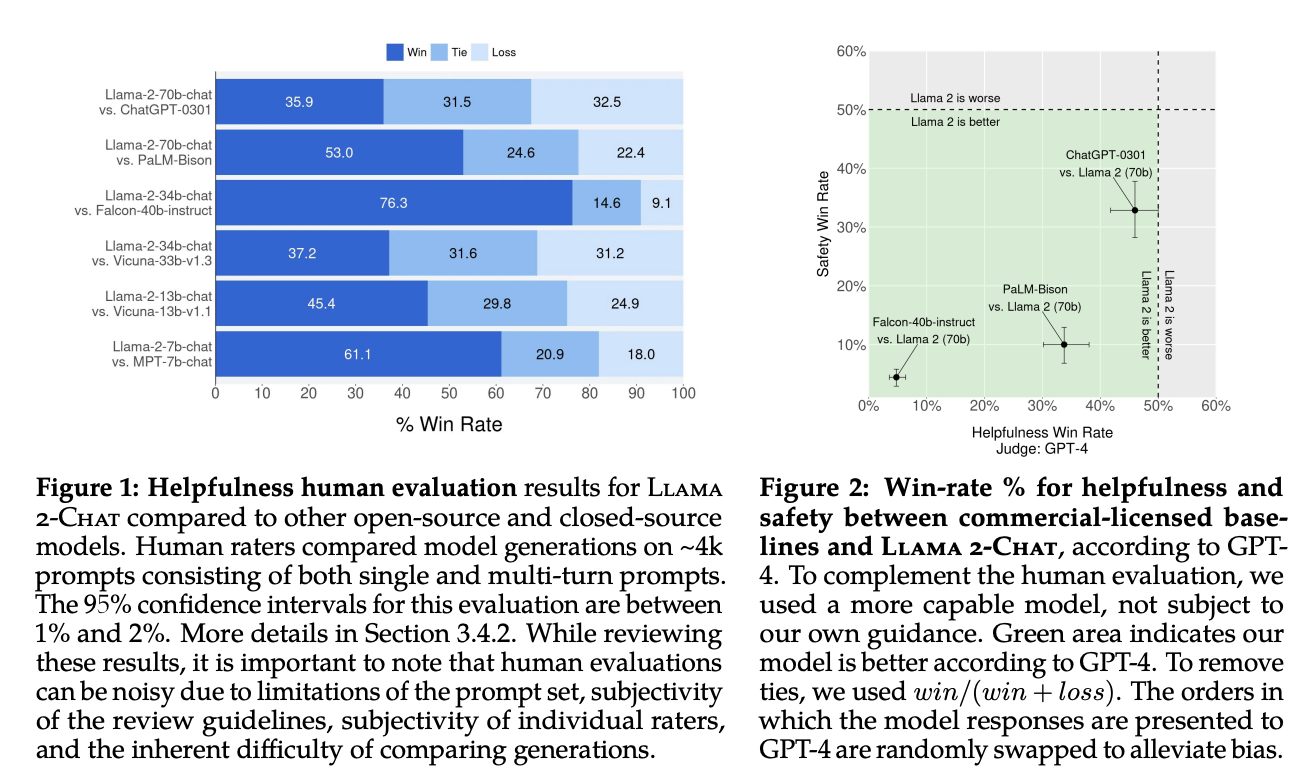

Кроме того, в статье упоминается сравнение эффектов моделей Llama2 и ChatGPT, которые всех больше всего волнуют.

По сравнению с GPT-4 результаты оценки Llama2 лучше. Зеленая часть указывает на то, что доля Llama2 лучше, чем у GPT4.

Хотя на долю китайцев приходится всего 0,13%,Но в будущем будет большой толчок к предварительному обучению расширенному списку китайских слов.&Модель точной настройки данных домена была выпущена китайцами.。Он открыт всего несколько дней,На GIthub уже есть крупные китайские модели на базе Llama2. . .

3. Развертывание и использование

Не буду вдаваться в технические подробности LLama2, вы можете убедиться сами. Далее я научу вас самостоятельно играть с диалоговой моделью LLama2.

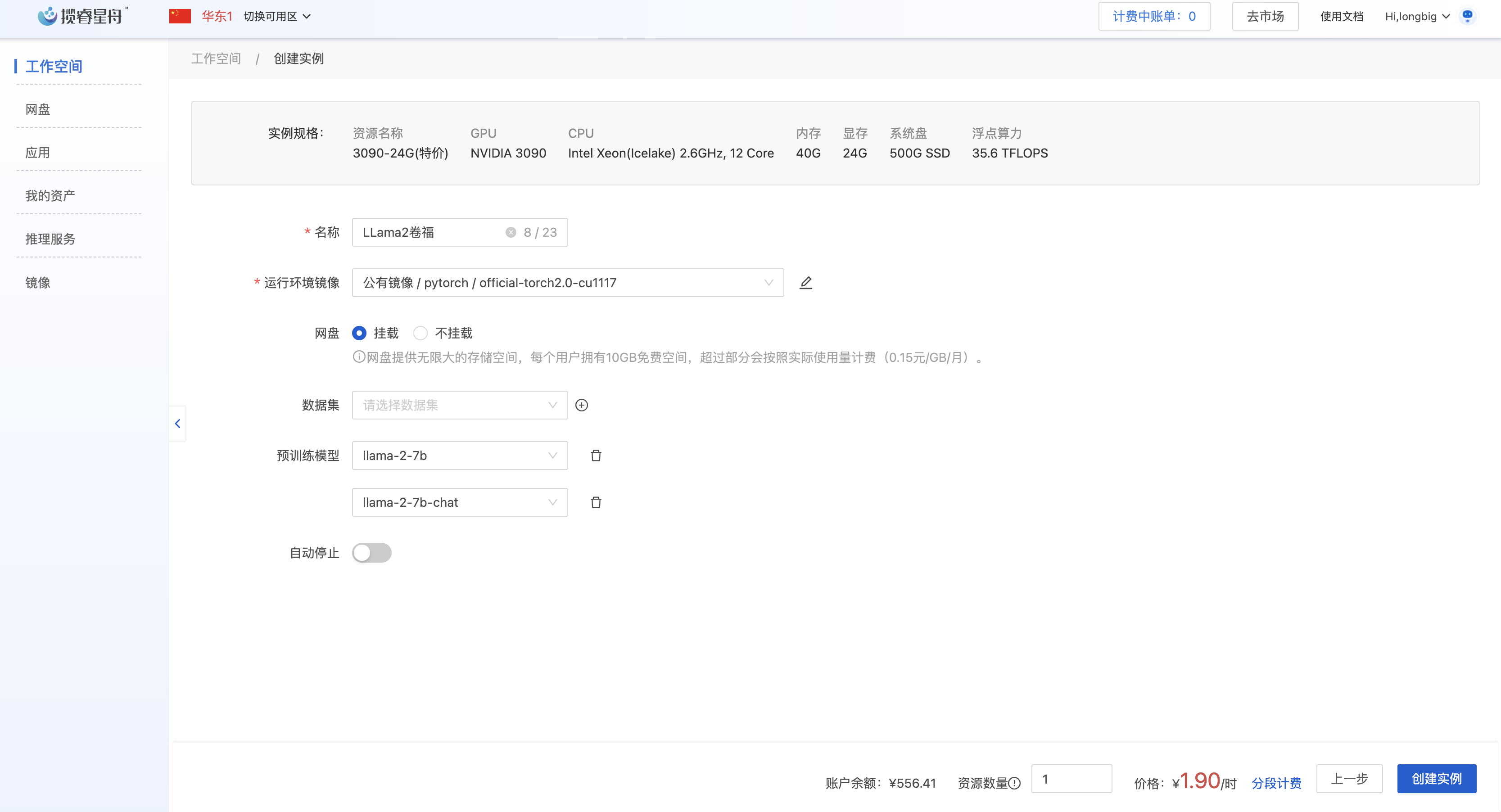

У большинства людей нет локальных вычислительных мощностей графического процессора, поэтому мы предпочитаем развернуть и использовать их на облачном сервере. Здесь я использую сервер графического процессора платформы Lanrui Xingzhou (дешевый и простой в использовании, 3090 стоит всего 1,9 доллара в час, а файл модели предварительно установлен на платформе, его не нужно загружать снова)

Новые пользователи также получат 2 часа вычислительной мощности 3090.,Не забудьте закодировать4104

3.1 Создайте новое пространство

Авторизоваться:https://www.lanrui-ai.com/console/workspace

Создайте рабочую область и смонтируйте общедоступный образ в образе рабочей среды: pytorch:official-torch2.0-cu1117. Выберите предварительно обученные модели: lama-2-7b и llama-2-7b-chat. Затем создайте экземпляр

3.2 Скачать код

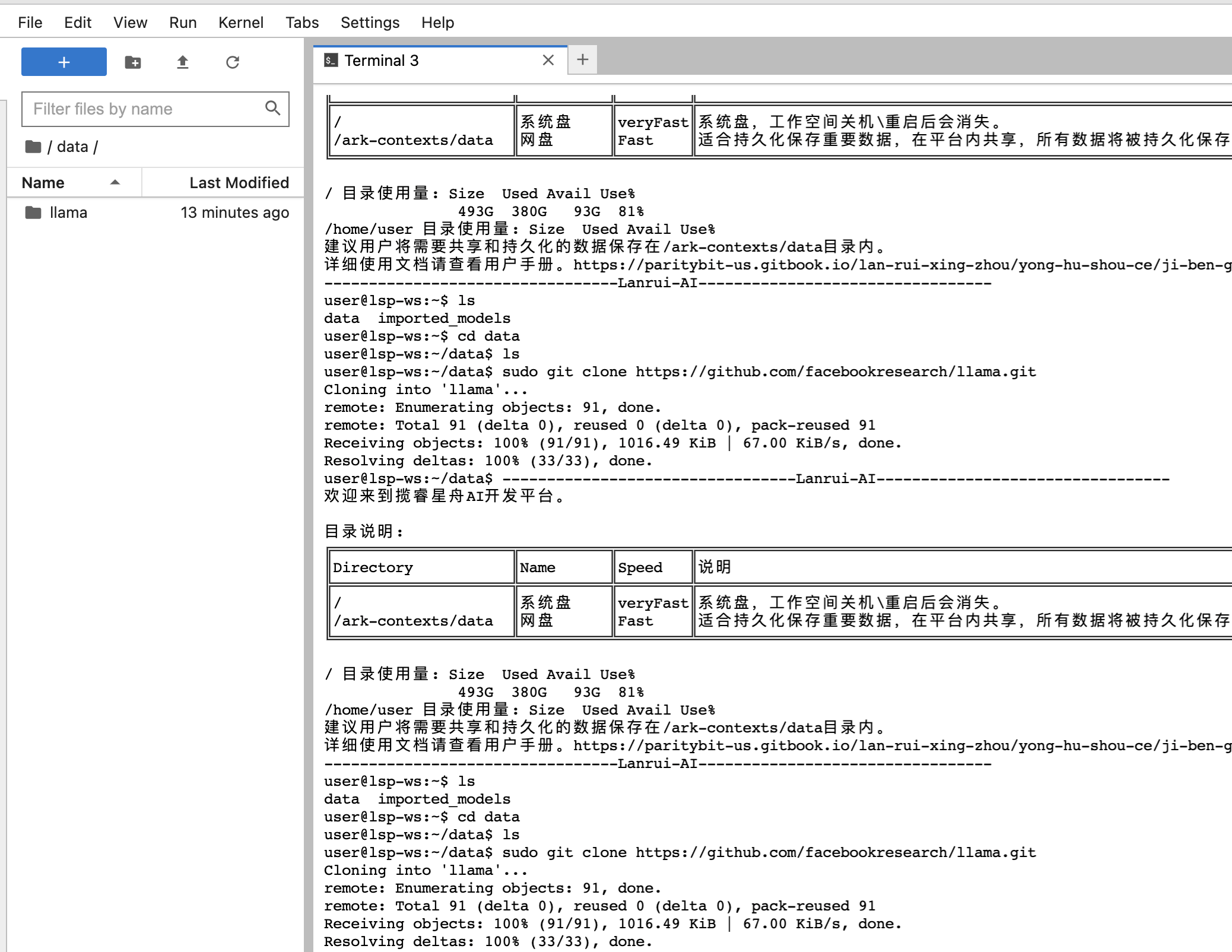

После создания экземпляра,Войдите на сервер с помощью jupyterLab.,Создать новый терминал,а затем введитеdataв каталоге

cd dataСкачать код

Выполните следующую команду, чтобы получить код ламы с Github.

sudo git clone https://github.com/facebookresearch/llama.gitПосле завершения загрузки,будет еще одинllamaОглавление

3.3 Запуск сценария

ВходитьllamaОглавление

cd llamaУстановить зависимости

sudo pip install -e .Проверьте возможности завершения текста модели Лама-2-7б.

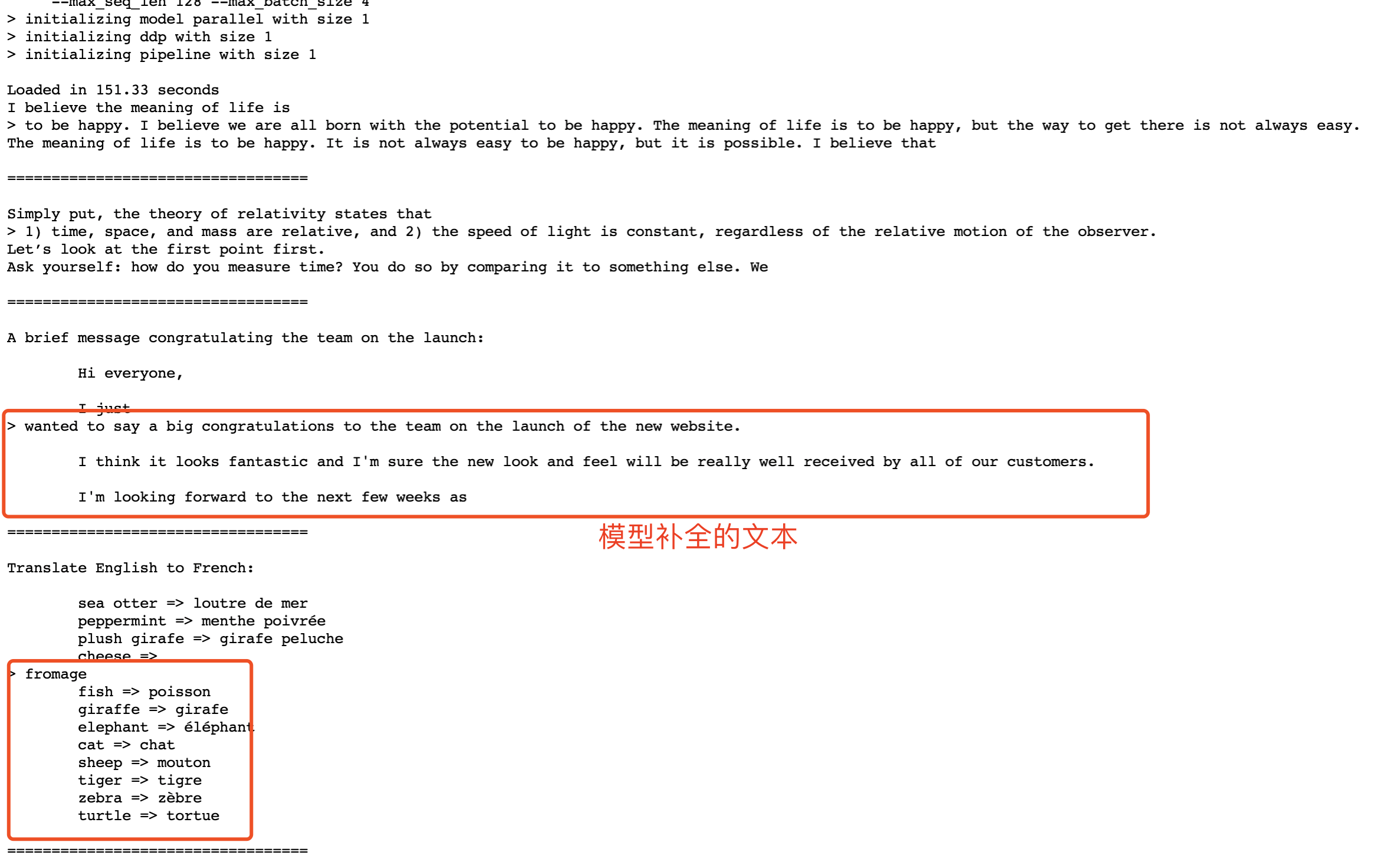

Выполнение командной строки:

torchrun --nproc_per_node 1 example_text_completion.py \

--ckpt_dir ../../imported_models/llama-2-7b/Llama-2-7b \

--tokenizer_path ../../imported_models/llama-2-7b/Llama-2-7b/tokenizer.model \

--max_seq_len 128 --max_batch_size 4Пример эффекта завершения текста:

В приведенном выше примере нужно написать абзац в скрипте Python и позволить модели завершить следующее содержимое.

Проверьте разговорные возможности модели Лама-2-7б

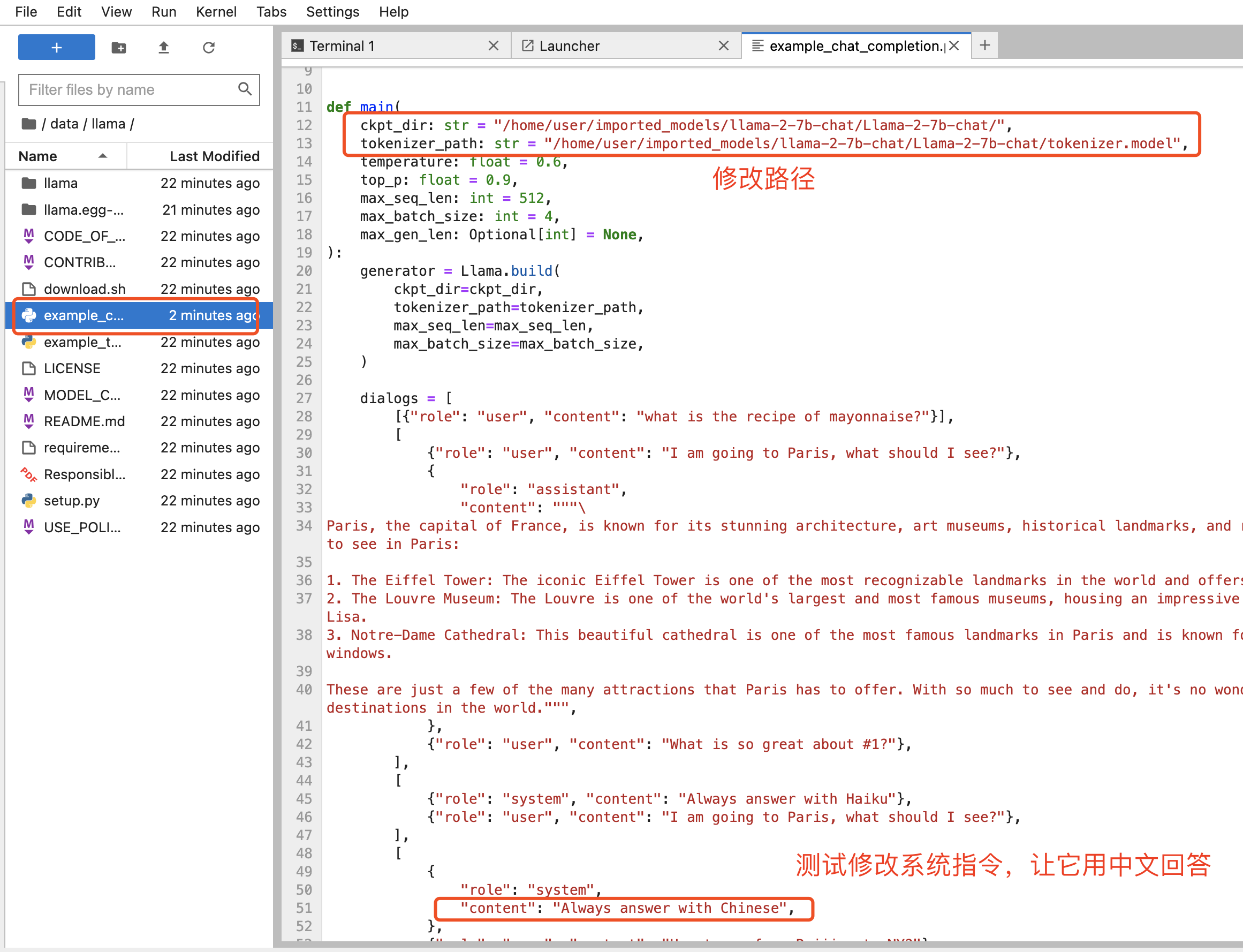

Измените права доступа к каталогу llama на 777.,Изменить еще разexample_chat_completion.pyв файлеckpt_dirиtokenizer_pathпуть для твоегоllama-2-7b-chatАбсолютный путь модели

// 1. Измените права доступа к каталогу, чтобы они были доступны для записи.

chmod 777 llama

//2. Измените параметры в файле example_chat_completion.py.

ckpt_dir: str = "/home/user/imported_models/llama-2-7b-chat/Llama-2-7b-chat/",

tokenizer_path: str = "/home/user/imported_models/llama-2-7b-chat/Llama-2-7b-chat/tokenizer.model"

//3. Запуск сценария разговора.

torchrun --nproc_per_node 1 example_chat_completion.py

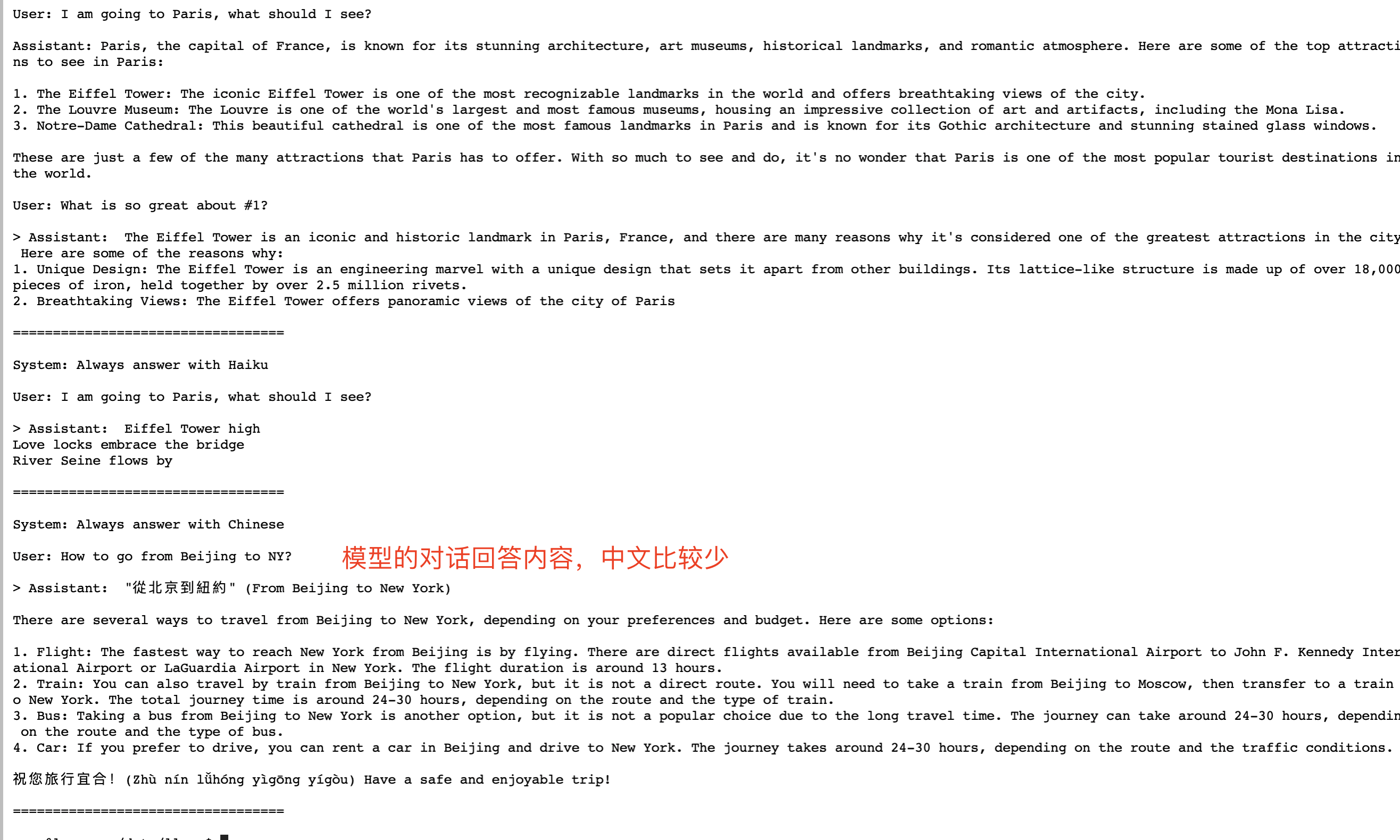

Здесь я изменяю подсказку для ответа на китайском языке. После выполнения сценария диалога эффект диалога следующий:

torchrun --nproc_per_node 1 example_chat_completion.py

Примечание. В настоящее время у нас нет официального интерфейса пользовательского интерфейса или кода сценария API, и нет возможности взаимодействовать друг с другом. Если у вас есть друзья, знающие Python, вы можете добавить интерфейс пользовательского интерфейса самостоятельно. оставить сообщение для обсуждения.

4. Загрузите больше моделей

llamaЕсть в кодеdownload.shСкрипт позволяет загружать другие модели,Но URL-адрес, необходимый для загрузки, необходимо получить самостоятельно. Шаги загрузки следующие:

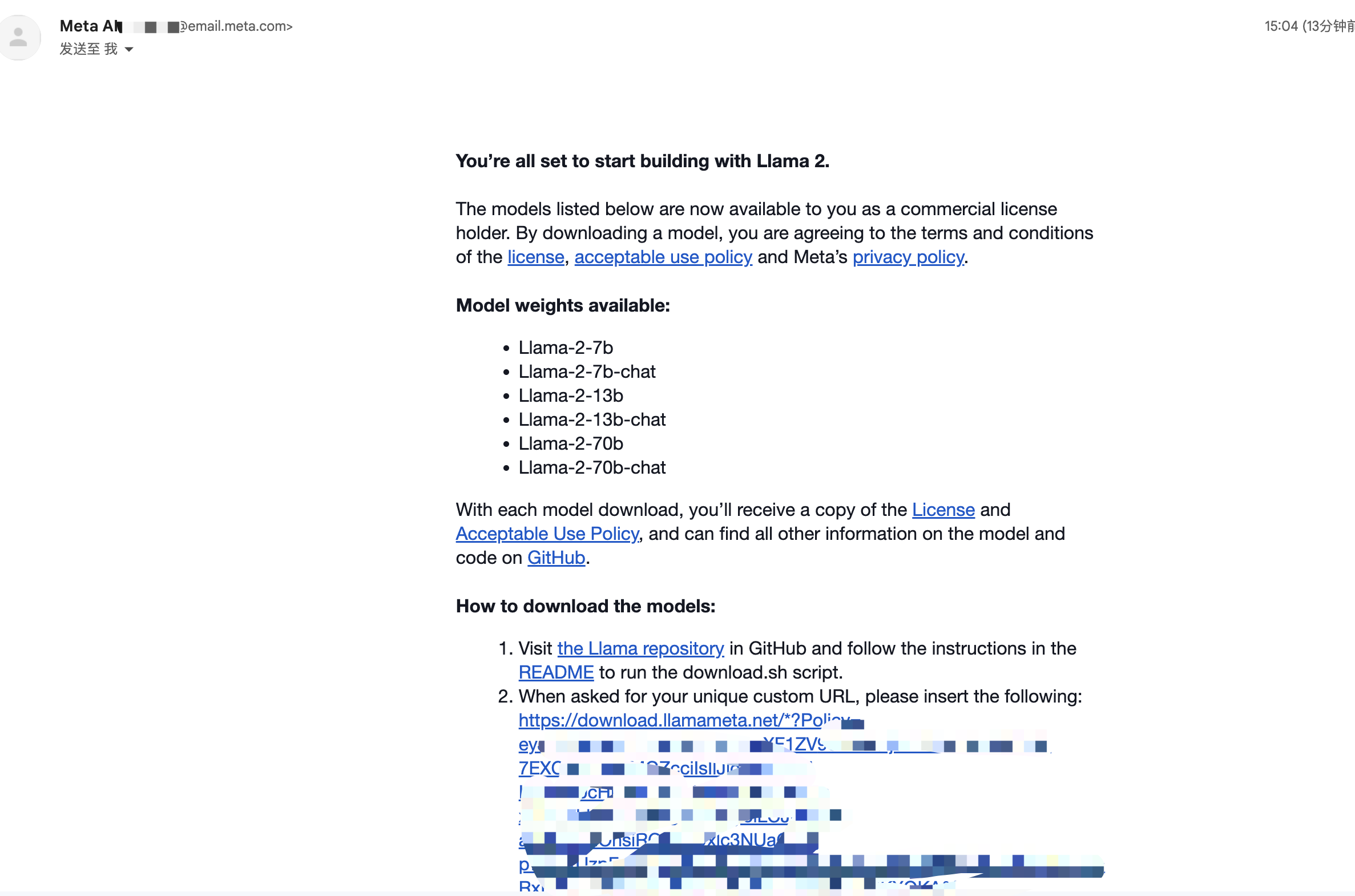

1. Получите URL-адрес загрузки с веб-сайта Meta AI.

MetaAIСкачать адрес страницы модели:https://ai.meta.com/llama/#download-the-model

После нажатия кнопки «Загрузить» вас попросят ввести некоторую информацию и адрес электронной почты. После отправки на ваш адрес электронной почты будет отправлен URL-адрес загрузки. Обратите внимание, что это ваша собственная ссылка для скачивания.

На рисунке ниже представлена ссылка для скачивания модели, полученная в почтовом ящике Сяоцзюаня.

2. Загрузите модель

Выполнение командной строки на сервере

sudo bash download.shЗатем следуйте инструкциям, чтобы вставить URL-адрес загрузки и выбрать модель для загрузки.

Подвести итог

Что касается использования отечественных больших моделей, поскольку становится все больше и больше коммерческих моделей с открытым исходным кодом, отечественные большие модели определенно снова откроют возможности для развития.

Создать оригинальную статью непросто. Пожалуйста, делайте репосты, ставьте лайки и подписывайтесь.

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами