Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

1. Введение в обнаружение препятствий

Различные сценарии приложений для обнаружения целей имеют разные трудности обнаружения, например, небольшие цели, несколько масштабов и сложный фон. Затененные объекты по-прежнему являются проблемой, с которой сталкиваются самые совершенные детекторы объектов. В этой статье делается попытка решить трудности обнаружения, вызванные взаимным перекрытием тестируемых целей. Для перекрытия лица используется метод, называемый. SEAM Модуль внимания и введена потеря отталкивания для решения этой проблемы.,введено разделениеи Модуль повышения внимания для улучшенияNeckОтзывчивость закрытых граней после выходной части слоя。

1.1 Separated and Enhancement Attention Module (SEAM)

То есть перекрытие между разными лицами и перекрытие лиц другими объектами. Первое делает точность обнаружения более точной. NMS Порог очень чувствителен, что приводит к пропущенным обнаружениям. Авторы используют потерю отталкивания для обнаружения лиц, что наказывает блоки прогнозирования за перемещение к другим реальным целям и требует, чтобы каждый блок прогнозирования держался подальше от других блоков прогнозирования с другими указанными целями, чтобы результаты обнаружения были правильными. NMS Не слишком чувствителен. Последнее приводит к исчезновению особенностей и неточному позиционированию, поэтому проектируется модуль внимания. SEAM улучшить изучение черт лица.

1.2 MultiSEAM

Основным методом решения многомасштабной проблемы является построение пирамиды, объединяющей многомасштабные черты лица. Например, в YOLOv5 середина,FPN слитый P3、P4 и P5 характеристики слоя. Но для небольших целей,Информация легко теряется после нескольких слоев свертки.,Сохраняется мало информации о пикселях,даже на мелководьеP3То же самое касается слоев。поэтому,Улучшение разрешения карт объектов, несомненно, полезно для обнаружения небольших целей.

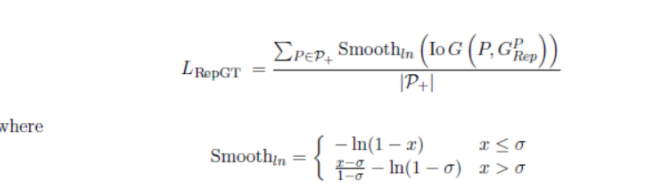

1.3Потеря отклонения с учетом окклюзии

RepGT Loss Функция состоит в том, чтобы сделать текущую ограничивающую рамку как можно дальше от окружающей среды.ground truth box。 где-то здесьground truth boxозначает, кромеbounding boxВне самого объекта, который будет возвращен,с человеческим лицомIoUСамая большая лицевая этикетка。

2.YoloV8 добавляет механизмы внимания SEAM и MultiSEAM.

2.1 SEAM、MultiSEAMПрисоединяйтесь Присоединяйтесьmodules.pyсередина:

Основной код:

class SEAM(nn.Module):

def __init__(self, c1, c2, n, reduction=16):

super(SEAM, self).__init__()

if c1 != c2:

c2 = c1

self.DCovN = nn.Sequential(

# nn.Conv2d(c1, c2, kernel_size=3, stride=1, padding=1, groups=c1),

# nn.GELU(),

# nn.BatchNorm2d(c2),

*[nn.Sequential(

Residual(nn.Sequential(

nn.Conv2d(in_channels=c2, out_channels=c2, kernel_size=3, stride=1, padding=1, groups=c2),

nn.GELU(),

nn.BatchNorm2d(c2)

)),

nn.Conv2d(in_channels=c2, out_channels=c2, kernel_size=1, stride=1, padding=0, groups=1),

nn.GELU(),

nn.BatchNorm2d(c2)

) for i in range(n)]

)

self.avg_pool = torch.nn.AdaptiveAvgPool2d(1)

self.fc = nn.Sequential(

nn.Linear(c2, c2 // reduction, bias=False),

nn.ReLU(inplace=True),

nn.Linear(c2 // reduction, c2, bias=False),

nn.Sigmoid()

)

self._initialize_weights()

# self.initialize_layer(self.avg_pool)

self.initialize_layer(self.fc)

def forward(self, x):

b, c, _, _ = x.size()

y = self.DCovN(x)

y = self.avg_pool(y).view(b, c)

y = self.fc(y).view(b, c, 1, 1)

y = torch.exp(y)

return x * y.expand_as(x)

def _initialize_weights(self):

for m in self.modules():

if isinstance(m, nn.Conv2d):

nn.init.xavier_uniform_(m.weight, gain=1)

elif isinstance(m, nn.BatchNorm2d):

nn.init.constant_(m.weight, 1)

nn.init.constant_(m.bias, 0)

def initialize_layer(self, layer):

if isinstance(layer, (nn.Conv2d, nn.Linear)):

torch.nn.init.normal_(layer.weight, mean=0., std=0.001)

if layer.bias is not None:

torch.nn.init.constant_(layer.bias, 0)

def DcovN(c1, c2, depth, kernel_size=3, patch_size=3):

dcovn = nn.Sequential(

nn.Conv2d(c1, c2, kernel_size=patch_size, stride=patch_size),

nn.SiLU(),

nn.BatchNorm2d(c2),

*[nn.Sequential(

Residual(nn.Sequential(

nn.Conv2d(in_channels=c2, out_channels=c2, kernel_size=kernel_size, stride=1, padding=1, groups=c2),

nn.SiLU(),

nn.BatchNorm2d(c2)

)),

nn.Conv2d(in_channels=c2, out_channels=c2, kernel_size=1, stride=1, padding=0, groups=1),

nn.SiLU(),

nn.BatchNorm2d(c2)

) for i in range(depth)]

)

return dcovn

class MultiSEAM(nn.Module):

def __init__(self, c1, c2, depth, kernel_size=3, patch_size=[3, 5, 7], reduction=16):

super(MultiSEAM, self).__init__()

if c1 != c2:

c2 = c1

self.DCovN0 = DcovN(c1, c2, depth, kernel_size=kernel_size, patch_size=patch_size[0])

self.DCovN1 = DcovN(c1, c2, depth, kernel_size=kernel_size, patch_size=patch_size[1])

self.DCovN2 = DcovN(c1, c2, depth, kernel_size=kernel_size, patch_size=patch_size[2])

self.avg_pool = torch.nn.AdaptiveAvgPool2d(1)

self.fc = nn.Sequential(

nn.Linear(c2, c2 // reduction, bias=False),

nn.ReLU(inplace=True),

nn.Linear(c2 // reduction, c2, bias=False),

nn.Sigmoid()

)

def forward(self, x):

b, c, _, _ = x.size()

y0 = self.DCovN0(x)

y1 = self.DCovN1(x)

y2 = self.DCovN2(x)

y0 = self.avg_pool(y0).view(b, c)

y1 = self.avg_pool(y1).view(b, c)

y2 = self.avg_pool(y2).view(b, c)

y4 = self.avg_pool(x).view(b, c)

y = (y0 + y1 + y2 + y4) / 4

y = self.fc(y).view(b, c, 1, 1)

y = torch.exp(y)

return x * y.expand_as(x)

от CSDN AI маленький монстр http://cv2023.blog.csdn.net

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами